Connect, le service de centre d’appel d’Amazon Web Services, profite d’une salve de mises à jour à l’occasion de la conférence Re:Invent du fournisseur. Avec notamment la possibilité de contacter proactivement les clients via l’assistant GenAI Amazon Q et de créer des agents.

Amazon Web Services a mis à jour son service de centre de contact Connect pour aider les entreprises à offrir une meilleure expérience client de bout en bout, a annoncé la société lors de sa conférence Re:Invent 2024 (2-6 décembre). Les dernières mises à jour de ce service, présenté pour la première fois en 2017, comprennent la possibilité de joindre les clients de manière proactive pour les campagnes sortantes et des capacités IA via l’assistant Amazon Q. Le premier point est conçu pour aider les entreprises à résoudre les problèmes des clients avant même qu’ils ne surviennent.

Selon AWS, la plupart des entreprises ne sont pas en mesure de répondre aux besoins de leurs clients de cette manière, car leurs données sont fragmentées dans des systèmes disparates, notamment des bases de données distinctes, telles que celles gérées pour les achats, les tickets d’assistance et les interactions en ligne. Pour résoudre le problème des données cloisonnées, Connect crée une vue unifiée de chaque client que les entreprises peuvent utiliser pour anticiper les problèmes et pour mener des campagnes d’appels sortants, explique l’entreprise. Les vues unifiées sont également associées à des recommandations poussées par la GenAI, appelées « recommandations intelligentes », qui sont conçues pour aider les responsables de campagnes à concevoir leurs programmes de sensibilisation. Connect fournit ce type de recommandations après une analyse des données historiques en temps réel.

Des agents IA et des garde-fous au rendez-vous

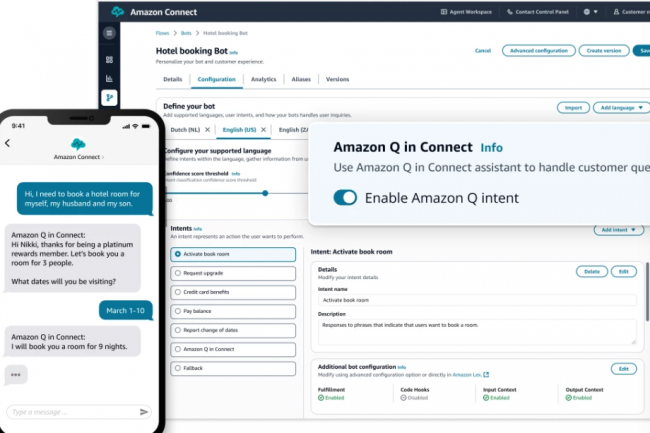

AWS a indiqué avoir mis à jour Q dans Connect pour créer des expériences de libre-service « automatisées et dynamiques ». Cela signifie essentiellement que les entreprises pourront utiliser cette fonction pour créer un chatbot virtuel ou une « expérience de bot vocal » pour les clients, à l’instar des agents ou des chatbots développés via la plateforme Agentforce de Salesforce ou les bots autonomes de Microsoft. En arrière-plan, ces agents combinent le prompt de l’utilisateur avec des informations contextuelles et des données historiques pour formuler une réponse dans les limites fixées par l’entreprise. S’il ne parvient pas à résoudre le problème, il transfère la conversation à l’agent du centre d’appel, a expliqué AWS dans un communiqué. Afin d’améliorer la sécurité de ces bots, AWS a ajouté des garde-fous personnalisables en matière d’IA qui, selon lui, « fourniront aux entreprises des contrôles solides sur les réponses générées par l’IA sans qu’il soit nécessaire de procéder à une ingénierie approfondie ».

Les garde-fous peuvent être utilisés par les entreprises pour bloquer les sujets indésirables en self-service, filtrer les contenus nuisibles et inappropriés en fonction de leurs politiques d’IA responsable, expurger les informations sensibles pour protéger la vie privée des clients et vérifier les réponses des modèles à l’aide de vérifications contextuelles, a expliqué AWS. En outre, Q in Connect offrira également des informations aux responsables des centres de contact qui aideront à former davantage le personnel sur les plateaux. La possibilité de contacter les clients de manière proactive et les mises à jour d’Amazon Q ont été mises à la disposition de tous, a déclaré l’entreprise, ajoutant que Connect gère 10 millions d’interactions par jour pour le compte de dizaines de milliers de clients.

Les accords signés par OpenAI et Anthropic avec l’Institut américain de sécurité de l’IA dépendant du NIST prévoient une validation amont des dernières versions de ChatGPT et de Claude avant publication. Un moyen de s’assurer de la sécurité de ces LLM et de s’engager aussi sur l’évaluation des capacités et des méthodes d’atténuation des risques.

Les fournisseurs de grands modèles de langage (LLM) OpenAI et Anthropic ont signé des accords individuels avec l’institut américain de sécurité de l’IA (US AI Safety Institute) rattaché au NIST (institut national des normes et de la technologie du ministère du commerce américain. Objectif : collaborer à la recherche sur la sécurité de l’IA, qui comprend des tests et des évaluations. Dans le cadre de ces accords, les deux sociétés vont partager leurs derniers modèles avec l’institut avant qu’ils ne soient mis à la disposition du public pour des contrôles de sécurité. « Grâce à ces accords, nous sommes impatients de commencer nos collaborations techniques avec Anthropic et OpenAI pour faire progresser la science de la sécurité de l’IA », a déclaré Elizabeth Kelly, directrice de l’Institut américain de sécurité de l’IA, dans un communiqué.

Les accords prévoient une recherche collaborative sur la manière d’évaluer les capacités et les risques pour la sécurité, ainsi que sur les méthodes permettant d’atténuer ces risques. Ces accords interviennent près d’un an après que le président américain Joe Biden a adopté un décret visant à mettre en place une série complète de normes, de mesures de protection de la sécurité et de la vie privée et de mesures de surveillance pour le développement et l’utilisation de l’intelligence artificielle. Début juillet le NIST a publié un logiciel libre appelé Dioptra disponible sur GitHub pour les développeurs afin de déterminer le type d’attaques qui rendraient un modèle d’intelligence artificielle moins performant. Outre Dioptra, le NIST a également publié plusieurs documents visant à promouvoir la sécurité et les normes en matière d’IA, conformément au décret. Ces documents comprennent la première version de ses lignes directrices pour le développement de modèles de base, intitulées Managing Misuse Risk for Dual-Use Foundation Models, et deux documents d’orientation qui serviront de ressources complémentaires au cadre de gestion des risques de l’IA (AI RMF) et au cadre de développement de logiciels sécurisés (SSDF) du NIST, destinés à aider les développeurs à gérer les risques de la GenAI.

Une approche de sécurité de l’IA au diapason du Royaume-Uni

Les accords avec les fournisseurs de LLM comprennent également une clause qui permettra à l’institut de sécurité américain de fournir un retour d’information aux deux entreprises sur les améliorations potentielles à apporter à leurs modèles en matière de sécurité, en collaboration avec leurs partenaires de l’institut de sécurité de l’IA du Royaume-Uni. Au début du mois d’avril, les États-Unis et le Royaume-Uni ont signé un accord visant à tester les LLM de sécurité qui sous-tendent les systèmes d’IA. L’accord – ou protocole d’accord – a été signé à Washington par Gina Raimondo, secrétaire au commerce des États-Unis, et Michelle Donelan, secrétaire à la technologie du Royaume-Uni, et la collaboration entre les instituts de sécurité de l’IA découle directement de cet accord.

Les accords signés par OpenAI et Anthropic interviennent au moment où le projet de loi californien sur la sécurité de l’intelligence artificielle entre dans sa phase finale de transformation en loi. Celui-ci pourrait établir la réglementation la plus stricte du pays en matière d’IA et ouvrir la voie à d’autres similaires dans l’ensemble du pays. Le projet de loi, intitulé « Safe and Secure Innovation for Frontier Artificial Intelligence Models Act » (SB 1047), propose des tests rigoureux et des mesures de responsabilisation pour les développeurs d’IA, en particulier ceux qui créent des modèles complexes et de grande envergure. S’il est adopté, le projet de loi obligera les entreprises d’IA à tester la sécurité de leurs systèmes avant de les mettre à la disposition du public. Au début du mois, l’OpenAI s’est opposée au projet de loi pendant au moins cinq jours avant de s’engager à le soutenir la semaine dernière.

Le NIST a par ailleurs pris d’autres mesures, notamment la formation d’un groupe consultatif sur la sécurité de l’IA en février dernier, qui comprend des créateurs d’IA, des utilisateurs et des universitaires, afin de mettre en place des garde-fous pour l’utilisation et le développement de l’IA. Le groupe consultatif, baptisé US AI Safety Institute Consortium (AISIC), a été chargé d’élaborer des lignes directrices concernant les systèmes d’IA en équipe restreinte, l’évaluation de la capacité de l’IA, la gestion des risques, la garantie de la sûreté et de la sécurité, et le filigrane des contenus générés par l’IA. Plusieurs grandes entreprises technologiques, dont OpenAI, Meta, Google, Microsoft, Amazon, Intel et Nvidia, ont rejoint le consortium afin de garantir le développement sûr de l’IA.