L’éditeur a présenté les prochaines fonctionnalités présentes dans la mise à jour d’Agentforce. Salesforce continue à enrichir sa plateforme de création et de gestion d’agents IA avec une orientation ITSM, génération de prospects et une fonctions analytique.

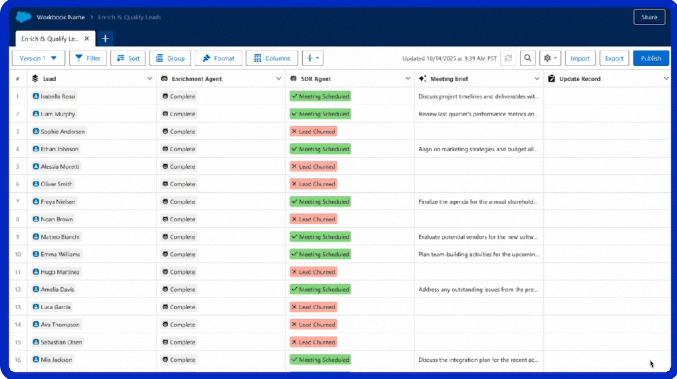

Présenté l’année dernière lors de Dreamforce, Agentforce devrait encore être au cœur de l’évènement annuel de Salesforce qui se déroule à San Francisco du 14 au 18 octobre. L’éditeur de CRM en mode SaaS vient de lever le voile sur certaines fonctions de l’outil pour créer et gérer des agents IA. L’une d’entre elles se nomme Agentforce Grid et se présente avec une interface de type tableur pour relier les données CRM, les invites d’IA, les actions et les agents. Elle peut servir pour effectuer des mises à jour en masse, générer des informations et tester des conversations d’IA multiples.

Agentgrid se présente sous forme de tableur re regroupe plusieurs données de différentes sources. (Crédit Photo: Salesforce)

Une autre mise à jour concerne Agentforce pour les services IT. Pour faciliter la tâches des équipes IT, l’outil propose une intégration avec Slack, un portail pour les employés, ainsi que la détection des incidents et l’analyse des causes. « Avec cette mise à jour, Salesforce se trouve en concurrence directe avec ServiceNow dans la gestion des services IT », a déclaré AS Yamohiadeen, directeur des pratiques IT chez Everest Group. Un avis partagé par Charlie Dai, analyste principal chez Forrester estimant que « l’expansion d’Agentforce dans l’ITSM et de la gestion centralisée des agents remet directement en cause le cœur de métier de ServiceNow. »

Automatisation de la génération de prospects

Transformer les visiteurs du site web en prospects commerciaux est l’objectif d’une autre fonctionnalité, judicieusement baptisée Agentforce for Sales : Lead Generation. « L’agent interagit avec les visiteurs du site web pour leur poser des questions et y répondre, voire prendre des rendez-vous avec des commerciaux sans l’intervention d’un agent humain », a expliqué Salesforce. Dans le domaine du e-commerce, l’éditeur a déclaré qu’Agentforce proposait un service de de commandes personnelles basé sur des agents pour les plateformes en ligne, avec des liens vers son Data Cloud de façon à offrir une hyper-personnalisation. Parmi les autres améliorations apportées au pipeline de ventes, on peut citer l’aide apportée aux commerciaux pour rédiger des courriels de suivi, planifier des réunions et déclencher des tâches personnalisées.

Agentforce for financial services se dote d’un outil de recouvrement de créances. (Crédit Photo: Salesforce)

De son côté, Agentforce for Financial Services comprend désormais Collections Assistance, un outil d’automatisation pour le recouvrement de créances. « L’outil automatise l’ensemble du processus de communication avec les clients en orchestrant les contacts, en répondant aux questions et en garantissant les engagements de paiement », a précisé Salesforce dans un communiqué, ajoutant que cela pourrait éviter aux spécialistes du recouvrement de créances d’avoir à négocier des règlements complexes et à gérer des cas sensibles.

Une fonction analytique pré-configurée pour Tableau Next

Parmi les autres fonctionnalités, on peut encore citer des mises à jour pour l’analyse, la sécurité et les cas d’usage du e-commerce. Tableau Next contient désormais une fonction analytique préconfigurée appelée Data Pro, que l’on peut intégrer à un agent via Agentforce pour réduire les interventions manuelles nécessaires à la modélisation sémantique des données. « Une fois intégrée à un agent, cette capacité réduit les obstacles techniques, permet à davantage d’utilisateurs de créer des informations fiables et exploitables, et rend l’analyse accessible en libre-service à l’ensemble de l’entreprise », a indiqué Charlie Dai de Forrester. Les entreprises cherchent des solutions d’analyse en libre-service que des employés sans expertise technique peuvent utiliser pour explorer et interpréter les données sans l’aide des développeurs, ce qui libère les talents de cette charge et permet de générer des informations commerciales plus rapidement.

Tableau Next peut intervenir dans les conversations Slack. (Crédit Photo: Salesforce)

Concernant la cybersécurité, Agentforce peut à présent aider les administrateurs IT à enquêter sur les menaces en résumant et en analysant l’activité des utilisateurs. M. Yamohiadeen d’Everest estime que les ajouts en rapport avec l’IA dans la prochaine version d’Agentforce sont intéressants, car « ensemble, ils améliorent la couverture de l’automatisation, la vitesse de résolution et le temps nécessaire pour obtenir des informations, tout en préservant le contrôle ».

Le NIST a publié un outil nommé Dioptra à destination des développeurs pour déterminer l’exposition des modèles d’IA à des attaques. L’organisme présente aussi des lignes directrices sur la protection de la GenAI.

La sécurité des systèmes d’IA devient de plus en plus importante au fur et à mesure de leur déploiement. Dans ce cadre, le NIST (National Institute of Standards and Technology) du ministère américain du Commerce apporte sa pierre à l’édifice en présentant un outil open source nommé Dioptra et de la documentation. « Tester les effets des attaques adverses sur les modèles d’apprentissage machine est l’un des objectifs de Dioptra », a déclaré le NIST dans un communiqué, ajoutant que « ce logiciel était destiné à aider les développeurs d’IA et les clients à savoir comment leur application d’IA pouvait résister à différentes attaques ». La solution, téléchargeable gratuitement, « peut aussi aider les développeurs de systèmes d’IA à quantifier la perte de performance d’un modèle et savoir ainsi à quelle fréquence et dans quelles circonstances le système échouerait », a expliqué l’organisme. La publication de Dioptra répond au décret adopté en 2023 par le président Biden, qui demandait au NIST d’apporter son aide dans les tests de modèles.

Outre cette solution et conformément au décret, le NIST a également publié plusieurs documents visant à promouvoir la sécurité et les normes de l’IA. L’un de ces documents, intitulé « Managing Misuse Risk for Dual-Use Foundation Models » est la première version publique des lignes directrices pour le développement de modèles de fondation. Le document décrit les pratiques que les développeurs peuvent adopter lors de la conception et de l’élaboration de leur modèle afin d’éviter qu’il ne soit utilisé à mauvais escient pour nuire délibérément à des personnes, à la sécurité publique et à la sécurité nationale. Le projet propose sept approches clés pour atténuer les risques d’utilisation abusive des modèles, ainsi que des recommandations sur la manière de les mettre en œuvre et de faire preuve de transparence à ce sujet. « Ensemble, ces pratiques peuvent contribuer à empêcher les modèles de nuire via des activités comme le développement d’armes biologiques, la réalisation d’opérations cybernétiques offensives et la production de matériel pédopornographique et d’images intimes sans consentement », a déclaré le NIST, ajoutant qu’il acceptait les commentaires sur le projet jusqu’au 9 septembre.

Des annexes sur la sécurité de l’IA générative

Les autres publications comprennent deux directives du NIST appelées respectivement « AI Risk Management Framework (AI RMF) » et Secure Software Development Framework (SSDF), qui serviront de ressources complémentaires pour la gestion des risques de l’IA et le développement de logiciels sécurisés et dont l’objectif est d’aider les développeurs à gérer les risques de l’IA générative. L’un des deux documents, intitulé AI RMF Generative AI Profile, fournit une liste de 12 risques provisoires liés à l’IA générative et propose aux développeurs près de 200 mesures pour les gérer. Parmi ces risques figurent un accès plus facile à la mise en œuvre d’attaques de cybersécurité, la production de fausses informations et de désinformation, de discours haineux et autres contenus nuisibles, et les hallucinations des systèmes d’IA générative. « La seconde directive, intitulée Secure Software Development Practices for Generative AI and Dual-Use Foundation Models, est complémentaire de la directive Secure Software Development Framework (SSDF) », a indiqué l’organisme. « Alors que le SSDF s’intéresse de manière générale aux pratiques de codage des logiciels, le document d’accompagnement élargit le SSDF en partie pour traiter la question d’un modèle compromis par des données d’entraînement malveillantes qui affectent négativement les performances du système d’IA », a expliqué le NIST.

Dans le cadre de son plan visant à garantir la sécurité de l’IA, le NIST a aussi proposé une initiative distincte qui autorise les parties prenantes américaines de collaborer avec d’autres pays à l’élaboration de normes en matière d’IA. En novembre de l’année dernière, la Chine et les États-Unis ont convenu de collaborer avec au moins 25 autres pays pour atténuer les risques liés à la progression de l’IA. Les deux pays, ainsi que plusieurs autres, dont l’UE, l’Inde, l’Allemagne et la France, ont signé, en novembre 2023, un accord, baptisé « Déclaration de Bletchley », lors du sommet sur la sécurité de l’IA « UK AI Safety Summit », afin de définir une ligne de conduite commune pour superviser l’évolution de l’IA et veiller à ce que la technologie progresse en toute sécurité.

Le gouvernement chinois a validé une quarantaine de modèle d’IA pour une usage public au cours des six derniers mois. Une manière de montrer aux Etats-Unis l’inefficacité des restrictions imposées à la Chine.

La Chine accélère dans le domaine de l’IA et en particulier sur les modèles d’IA. Selon le journal étatique Securities Times, le pays a déjà approuvé pas moins de 40 LLM à usage public au cours des six derniers mois. Depuis le mois d’août dernier, Pékin a décidé de valider par lot ces modèles. Récemment, les autorités ont retenu 14 modèles dont ceux de Xiaomi, 4Paradigm et 01.AI.

Le premier lot a validé les LLM d’Alibaba, Baidu et ByteDance. Les deuxièmes et troisième tranches ont été attribuées en novembre et décembre. L’an dernier, les instituts de recherche publics chinois ont indiqué que les entreprises IT avaient lancé 79 grands modèles de langage (LLM). Le gouvernement chinois n’a pas révélé le nombre réel d’autorisations d’IA qu’il a accordées à ce jour. Ce chiffre est d’autant plus important que la Chine est engagée dans une bataille pour la suprématie dans le secteur technologique avec les États-Unis, qui a vu les deux pays déployer des stratégies visant à contrecarrer les progrès de l’autre.

Les Etats-Unis montent leur surveillance

L’information sur les LLM chinois arrive à un moment où les États-Unis préparent un décret pour surveiller les modèles d’IA formés sur les fournisseurs de services cloud, comme Microsoft, Google et AWS, afin de prendre des mesures supplémentaires pour faire face à « l’urgence nationale en ce qui concerne les activités cybermalveillantes importantes ». Cependant, l’an dernier, lors de l’UK AI Safety Summit, le sommet britannique sur la sécurité de l’IA, les deux pays ont signé la Déclaration de Bletchley, un accord de coopération entre plusieurs pays, dont les États-Unis et la Chine, pour mener une réflexion commune sur l’évolution de l’IA et garantir que la technologie progresse en toute sécurité.

À l’instar du mécanisme d’approbation de l’IA mis en place par Pékin, le président américain Joe Biden a publié en octobre de l’année dernière un décret établissant des règles claires et des mesures de surveillance afin de garantir que l’IA reste sous contrôle, tout en lui ouvrant des voies de développement.

Selon Microsoft, le regroupement de produits existants comme Synapse et Power BI, au sein du service Fabric, offrira aux entreprises de combiner les charges de travail tout en réduisant leurs frais, la complexité et les coûts d’intégration IT.

A l’occasion de son évènement Build, Microsoft a annoncé le regroupement de ses produits existants d’entreposage de données, de veille stratégique et d’analyse de données dans une offre unique. Selon les analystes, l’offre, baptisée Fabric, pourrait aider les entreprises à combiner les charges de travail tout en réduisant leurs frais, la complexité et les coûts d’intégration IT. Selon Sanjeev Mohan, analyste principal chez SanjMo, le lancement de la plateforme d’analyse de données unifiée Fabric est peut-être une manière de répondre à la prolifération massive de produits dans la pile de données des entreprises. « Microsoft a compris que ses clients voulaient réduire leurs frais généraux et s’affranchir de la complexité de l’intégration. Ce n’est pas que les clients ne dépensent pas, mais ils cherchent une meilleure valeur pour leur investissement IT », a déclaré le consultant, ajoutant que si Fabric peut fournir de bons résultats, cette stratégie pourrait s’avérer payante pour le fournisseur de services de cloud public. « Outre une réduction de la complexité de l’IT, l’offre pourrait également contribuer à réduire les coûts », a ajouté l’analyste. « Une solution intégrée devrait coûter moins cher qu’un ensemble de solutions premium spécialisées. La solution Fabric pré-intégrée réduit aussi les coûts d’intégration et demande moins d’apprentissage et de compétences pour utiliser les différents outils ».

Microsoft affirme aussi qu’avec Fabric, il est plus simple d’acheter et de gérer les ressources. « Les clients peuvent acheter un seul pool de calcul qui alimente toutes les charges de travail Fabric. Les capacités de calcul universelles réduisent considérablement les coûts, car toute capacité de calcul inutilisée dans une charge de travail peut être utilisée par n’importe quelle autre charge de travail », a expliqué l’entreprise dans un communiqué. Selon Boris Evelson, analyste principal chez Forrester, les données brutes, qu’elles soient transactionnelles, opérationnelles ou autres, doivent passer par des étapes comme la collecte, l’ingestion, l’extraction, le déplacement, l’intégration, le nettoyage, la modélisation et le catalogage avant d’être transformées en informations utiles. « Généralement, certaines des technologies qui prennent en charge chacune de ces étapes proviennent de différents fournisseurs et les professionnels des données ou de l’analyse doivent consacrer du temps à l’intégration », a déclaré M. Evelson, ajoutant que si Fabric ne supprime pas complètement l’étape de l’intégration des composants, elle réduit le temps et les efforts d’intégration, et permet aux utilisateurs des données et de l’analytique de se concentrer davantage sur la résolution de problèmes et sur la recherche d’opportunités commerciales.

Sept services et outils principaux

Selon le fournisseur, l’architecture unifiée de Fabric offre une expérience SaaS (Software-as-a-Service) qui aide les développeurs à extraire des informations à partir de données brutes et à les présenter aux utilisateurs métiers. « La nouvelle suite analytique comprend sept modules et outils principaux, notamment des connecteurs de données, des outils d’ingénierie des données, des flux de travail pour la science des données et des outils analytiques, entre autres choses », a ajouté l’entreprise. « Le module Data Factory, actuellement en preview public, fournit plus de 150 connecteurs à des sources de données dans le cloud et sur site, avec la possibilité d’utiliser le glisser-déposer pour la transformation des données et d’orchestrer des pipelines de données », a encore déclaré l’entreprise. Microsoft a également intégré le module Synapse Data Engineering qui facilite la création de modèles dans Apache Spark. « Fabric comprend également Synapse Data Science, un workflow de bout en bout pour les scientifiques des données pour construire des modèles d’IA sophistiqués, et Synapse Data Warehousing, qui combine des outils de lakehouse et d’entreposage de données avec la possibilité d’exécuter SQL sur des formats de données ouverts », a par ailleurs déclaré l’entreprise. Les deux sont disponibles en aperçu public. « De même, le module Synapse Real-Time Analytics, également en aperçu public offre aux développeurs de travailler avec des données en continu et d’analyser de grands volumes de données semi-structurées », a indiqué Microsoft. Le fournisseur a aussi intégré un module Power BI dans Fabric pour aider les analystes et les utilisateurs professionnels à générer des informations à partir des données avec l’appui d’outils basés sur l’IA.

L’expérience Power BI est aussi profondément intégrée dans Microsoft 365. Pour Hyoun Park, analyste principal chez Amalgam Insights, « l’ajout de Power BI à Fabric comble un certain nombre de lacunes qui rendaient Power BI moins adapté aux entreprises par rapport à des plateformes analytiques comme Qlik, Tibco ou SAS ». Fabric sera livré avec un module Data Activator destiné à la détection et à la surveillance en temps réel des données. « Le module pourra déclencher des notifications et des actions quand il trouvera des modèles spécifiques dans les données », a expliqué l’entreprise, ajoutant que Data Activator était actuellement disponible en aperçu privé. Toujours selon Microsoft, il est possible de tester les sept modules sur le portail de l’entreprise.

Azure OpenAI ajouté à Fabric, et bientôt Copilot

Microsoft a annoncé l’ajout du service Azure OpenAI à Fabric et l’intégration prochaine de Copilot, alimenté par GPT, à la plateforme analytique. « Avec l’intégration de Copilot à Microsoft Fabric, les utilisateurs pourront utiliser le langage conversationnel pour créer des flux de données et des pipelines de données, générer du code et des fonctions entières, construire des modèles d’apprentissage machine ou visualiser les résultats », a déclaré l’entreprise. « L’ajout du service Azure OpenAI et de Copilot accélérera considérablement le travail effectué par les professionnels des données dans Azure en supprimant bon nombre de barrières entre les solutions », a déclaré Bradley Shimmin, analyste en chef chez Omdia.

« Cela devrait également accélérer l’adoption des modèles fondamentaux de Microsoft et très probablement de tout le portefeuille d’outils d’apprentissage machine de l’entreprise », a ajouté M. Shimmin. Sanjeev Mohan, l’analyste principal de SanjMo, pense aussi que cette décision témoigne de l’effort continu de Microsoft pour intégrer les API des grands modèles de langage d’OpenAI à l’ensemble de son portefeuille. « Les entreprises peuvent aussi combiner les grands modèles de langage du service Azure OpenAI avec leurs propres données pour créer leurs propres expériences de langage conversationnel », a déclaré Microsoft, ajoutant que Copilot n’a pas été formé sur les données d’un tenant de l’entreprise.

Prise en charge de OneLake et adoption du format Delta de Databricks

Selon Microsoft, à l’instar des données des applications 365, stockées dans OneDrive, toutes les données et charges de travail de Fabric sont stockées dans un lac de données SaaS et multi-cloud appelé OneLake. « Les données sont organisées dans un hub de données et automatiquement indexées pour la découverte, le partage, la gouvernance et la conformité. Il s’agit d’un système de stockage unique et unifié pour tous les développeurs, où la découverte et le partage des données sont faciles, avec des paramètres de politique et de sécurité appliqués de manière centralisée », a déclaré l’entreprise dans un communiqué. « Cela évite les silos de données liés au fait que les différents développeurs provisionnent et configurent leurs propres comptes de stockage isolés », a encore expliqué Microsoft, ajoutant que « OneLake propose aux entreprises de virtualiser le stockage du datalake dans ADLS Gen2, AWS S3, et Google Storage ».

Selon M. Evelson de Forrester, avec OneLake, les entreprises pourront créer plus facilement leur propre mini-lac de données en quelques minutes plutôt qu’en quelques jours ou semaines. « Certes, il faudra encore du temps pour que ce lac de données soit prêt pour les applications critiques, mais le prototypage, les PoC et le développement agile seront plus commodes », a déclaré l’analyste. En outre, Fabric traite Delta au-dessus des fichiers Parquet comme un format de données natif qui est la valeur par défaut pour toutes les charges de travail. « Cet engagement profond en faveur d’un format de données ouvert commun signifie que les clients n’ont besoin de charger les données qu’une seule fois dans le lac de données et que toutes les charges de travail peuvent fonctionner sur les mêmes données, sans avoir à les ingérer séparément », a déclaré l’entreprise. « Autrement dit, OneLake prend en charge les données structurées de n’importe quel format et les données non structurées », a-t-elle ajouté.

Boris Evelson estime que l’adoption du format open source pourrait représenter un énorme gain de temps, d’efforts et d’espace de stockage. « Même si OneLake n’est pas lui-même open source, la structure des données est basée sur un format de données open source appelé Parquet, optimisé pour l’analyse. Cela signifie qu’un lac de données, un entrepôt de données et une plateforme de BI (dans ce cas, Power BI) utiliseront exactement le même format et, surtout, la même instance/version des données », a déclaré Boris Evelson. De plus, Microsoft a déclaré qu’elle prévoyait d’introduire un modèle de sécurité universel pour le Fabric géré dans OneLake afin d’aider les entreprises à gérer la sécurité des données à travers différents moteurs de données, modules ou outils. « Ce modèle garantira que tous les moteurs ou modules de données appliquent le modèle de sécurité quand ils traitent des requêtes ou d’autres tâches », a indiqué l’entreprise.

Une capitalisation qui ne va pas de soi

Selon les analystes, le lancement de Microsoft Fabric pourrait avoir un impact sur son adoption et sa popularité. « Si chaque entreprise utilisatrice d’Office 365 reçoit une copie de Fabric, tout comme elle reçoit actuellement une copie de Power BI avec la licence E5 Office 365, elle aura le même effet viral que Power BI », a déclaré Boris Evelson. Cependant, Doug Henschen, analyste principal chez Constellation Research pense qu’il ne faut pas s’empresser de miser sur un succès immédiat de Fabric. « Nous devons garder à l’esprit que tout ce qui a été annoncé est encore en aperçu et que jusqu’à présent, la réussite de Microsoft dans des domaines comme l’entreposage de données reste mitigée.

« Plus récemment, Azure Synapse n’a pas été adoptée massivement ni acclamé par les clients comme plateforme de stockage de données », a aussi déclaré M. Henschen, ajoutant que les entreprises ne changent généralement pas rapidement de plateforme de données. Selon les analystes, Microsoft Fabric peut être comparé à Google DataPlex, SAP DataSphere et IBM Data Fabric.

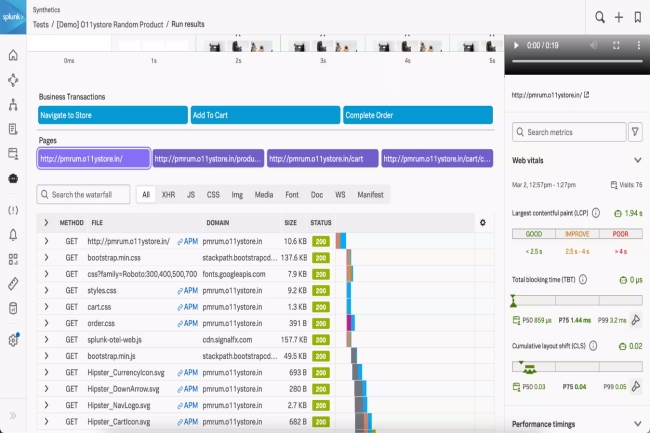

Afin d’identifier plus efficacement les menaces et les incidents, Splunk ajoute des fonctions de sécurité et d’observabilité à Mission Control et à son Observability Cloud.

Selon Splunk, l’ajout de fonctions à Observability Cloud et à Mission Control vise à identifier plus efficacement les menaces et les incidents. Concernant le premier service, qui offre déjà de la surveillance de l’infrastructure (AIops), de la performance applicative (APM), les dernières fonctionnalités aideront les équipes IT opérationnelles et de développement à dépanner plus rapidement et avec une visibilité accrue, « l’idée étant d’offrir une approche unifiée de la réponse aux incidents », comme l’a déclaré l’entreprise.

Quant à la solution APM, en plus de sa fonction Incident Intelligence, qui propose aux équipes de diagnostiquer, remédier et restaurer les services plus rapidement, « il bénéficiera désormais de capacités d’auto-détection basées sur le machine learning pour limiter les interventions manuelles et améliorer la précision des alertes », a déclaré la firme. Enfin, l’ajout de l’explorateur de réseau IM Network Explorer offre aux équipes de surveiller et d’évaluer la santé de leur réseau cloud. « Les entreprises pourront résoudre tous les problèmes de santé du cloud à l’aide d’IM Network Explorer », a déclaré l’entreprise, ajoutant que toutes ces fonctionnalités étaient généralement disponibles.

Des fonctions de sécurité améliorées

Outre ces fonctions d’observabilité, l’entreprise a indiqué qu’elle améliorait son offre de sécurité baptisée Mission Control, laquelle combine l’offre d’analyse de la sécurité Enterprise Security, et l’outil d’automatisation et d’orchestration SOAR. « La version améliorée de Mission Control permet aux SOC (Security Operations Center) de détecter, d’enquêter et de répondre aux menaces à partir d’une surface de travail moderne et unifiée », a déclaré Splunk dans un communiqué.

« La version améliorée de Mission Control est accessible aux clients de Enterprise Security Cloud en fonction des exigences techniques et régionales », a précisé le fournisseur. Ce dernier a également déclaré qu’il mettait Edge Processor à la disposition de ses clients. « La solution de traitement de flux de données Edge Processor fonctionne à la périphérie du réseau. Les entreprises peuvent l’utiliser pour filtrer, masquer et transformer leurs données à proximité de leur source avant d’acheminer les données traitées vers des environnements externes », a expliqué l’entreprise dans un billet de blog.

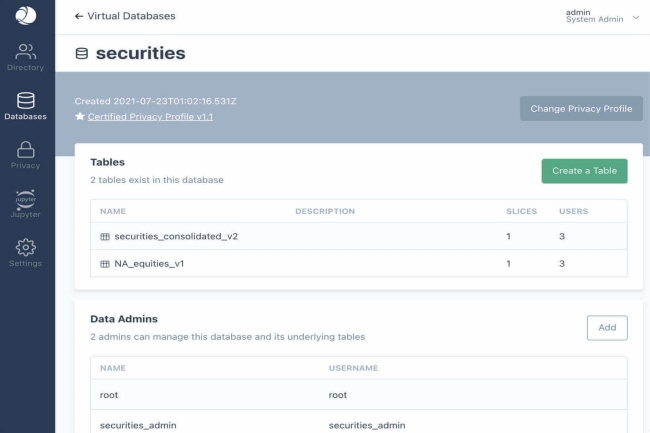

En rachetant Leapyear pour un montant non communiqué, Snowflake étoffe son portefeuille de solutions de partage de données sécurisées ou de data clean room.

Le début de l’année est prolifique pour Snowflake en matière d’acquisitions. Après Myst et Snowconvert, c’est au tour de LeapYear de tomber dans l’escarcelle du spécialiste du datawarehouse cloud. Ce dernier l’a annoncé sur son blog pour un montant non dévoilé. Basée à San Francisco, LeapYear Technologies, a été fondée en 2014 par Christopher Hockenbrocht, Colton Jang et Ishaan Nerurkar. À ce jour, la société a levé 53,2 millions de dollars de financement. Parmi les investisseurs de l’entreprise figurent des sociétés de capital-risque comme Bain Capital et Lightspeed.

LeapYear opère sur un marché en pleine croissance, les data clean room. Il s’agit d’environnement qui offre à plusieurs entreprises de partager des données de manière sécurisée et anonyme. Ces lieux sont neutres et donnent la possibilité d’analyser des ensembles de données sensibles. « Afin de poursuivre notre mission de mobilisation des données du monde entier – y compris certaines données parmi les plus sensibles – Snowflake fait part de son intention d’acquérir LeapYear, une plateforme de confidentialité différentielle, et d’intégrer l’équipe et la technologie de LeapYear à Snowflake pour aider nos clients à exploiter des données auparavant interdites », a déclaré Carl Perry, directeur de la gestion des produits chez Snowflake, dans le blog.

La confidentialité différentielle pour un partage sécurisé des données

La confidentialité différentielle désigne des techniques pour garantir une analyse utile tout en protégeant les valeurs des données identifiables. « Grâce à l’ajout de la plateforme de confidentialité différentielle de LeapYear, Snowflake pourra étendre ses offres Global Clean Room », a encore écrit Carl Perry. La demande en Data Clean Room résulte des réglementations sur la confidentialité des données comme le RGPD de l’Union européenne.

Une autre raison de la popularité croissante des Data Clean Room, c’est qu’ils donnent aux entreprises la possibilité d’analyser de grands volumes de données agrégées. « Les leaders des secteurs des médias et de la publicité, comme Disney, NBCUniversal, Acxiom, OpenAP et Roku utilisent les Global Data Clean Rooms de Snowflake pour offrir davantage de possibilités de collaboration sûres et vérifiables entre les entreprises », a ajouté Carl Perry. « Cette technologie a également apporté d’autres possibilités de collaboration à des entreprises de secteurs comme la vente au détail et les biens de consommation emballés », a ajouté le responsable. Selon les données de Transparency Market Research, la taille du marché des Data Clean Room s’élevait à 4,4 milliards de dollars à la fin de l’année 2021. Plusieurs autres entreprises, dont AWS, Microsoft, Google et Databricks, offrent aussi des capacités de Data Clean Room.