La déclaration de Bletchley, signée lors du AI Safety Summit constituera une ligne de pensée commune afin de superviser l’évolution de l’IA et de garantir que la technologie progresse en toute sécurité.

La Chine et les États-Unis ont accepté de collaborer avec au moins 25 autres pays pour atténuer les risques liés à la progression de l’IA. Les deux pays, ainsi que plusieurs autres, dont l’Allemagne, la France, l’Inde ainsi que l’UE ont signé un accord, baptisé « Bletchley declaration », lors du sommet britannique sur la sécurité de l’IA, afin d’établir une ligne de conduite commune pour superviser l’évolution de l’IA et veiller à ce que la technologie progresse en toute sécurité. L’accord porte le nom d’un lieu à Londres – Bletchley Park – qui a abrité l’équipe dirigée par Alan Turing pour déchiffrer les codes de la machine Enigma pendant la seconde guerre mondiale.

Le sommet au cours duquel l’accord a été signé s’est déroulé en présence de plusieurs dirigeants politiques et des CEO d’entreprises technologiques, dont Elon Musk et le CEO d’OpenAI, Sam Altman. La déclaration de Bletchley invite les pays membres signataires à adopter deux grandes approches pour contrôler les risques de guerre nucléaire, chimique ou biologique découlant de l’IA. « Nous sommes particulièrement préoccupés par ces risques dans des domaines tels que la cybersécurité et la biotechnologie, ainsi que dans les cas où les systèmes d’IA les plus poussés peuvent amplifier des risques tels que la désinformation. Les capacités les plus importantes de ces modèles d’IA peuvent entraîner des dommages graves, voire catastrophiques, délibérés ou involontaires », souligne l’accord.

Deux approches pour endiguer les risques liés à l’IA

La première approche consiste à identifier les risques de sécurité liés à l’IA qui suscitent des préoccupations communes, puis à les comprendre avec des données scientifiques et factuelles. Une fois cette compréhension acquise, les pays membres évalueront l’évolution des capacités de l’IA et mesurer son impact sur la société dans son ensemble, selon l’accord.

La deuxième approche consiste à élaborer des politiques fondées sur les risques dans les pays membres afin de garantir la sécurité. A noter que ces politiques peuvent varier en fonction des circonstances nationales et des cadres juridiques applicables. « Cette deuxième approche comprend, outre une transparence accrue de la part des acteurs privés qui développent des capacités d’IA de pointe, des mesures d’évaluation appropriées, des outils pour tester la sécurité, ainsi que le développement de capacités et de recherches scientifiques pertinentes dans le secteur public », peut-on lire dans l’accord.

Les États-Unis ont pris de l’avance en matière de régulation de l’IA

Au début du mois de mai, des centaines de dirigeants de l’industrie technologique, d’universitaires et d’autres personnalités ont signé une lettre ouverte avertissant que l’évolution de l’IA pourrait conduire à un phénomène d’extinction et déclarant que le contrôle de cette technologie devrait être une priorité mondiale absolue.

Cette semaine, OpenAI, à l’origine de ChatGPT, a déclaré qu’il préparait une équipe pour empêcher ce que l’entreprise appelle les modèles d’IA d’avant-garde de déclencher une guerre nucléaire et d’autres menaces. L’administration du président américain Joe Biden a également publié cette semaine un décret attendu depuis longtemps, qui définit des règles claires et des mesures de contrôle pour veiller à ce que l’IA soit maîtrisée, tout en lui offrant la possibilité de se développer.

Les bénéfices d’IBM au troisième trimestre ont été dopés par l’intérêt des entreprises pour l’IA générative, ce qui a entraîné une hausse de ses revenus en matière de logiciels et de conseil.

« Dans l’ensemble, nous pensons que les vents favorables l’emportent sur les vents contraires et que les dépenses technologiques continueront à dépasser le PIB. Au cours du trimestre écoulé, nous avons enregistré une bonne croissance du chiffre d’affaires dans les domaines des logiciels et du conseil », a déclaré Arvind Krishna, CEO d’IBM, lors d’une conférence téléphonique sur les résultats. « Les clients adoptent de plus en plus notre plateforme d’IA et de données Watsonx ainsi que nos solutions de cloud hybride pour débloquer la productivité et l’efficacité opérationnelle. Cela contribue à stimuler une croissance solide dans nos activités de logiciels et de conseil. Par conséquent, nous restons confiants dans nos prévisions de croissance du chiffre d’affaires et du flux de trésorerie disponible pour l’ensemble de l’année », a ajouté Arvind Krishna.

Le chiffre d’affaires total d’IBM pour ce troisième trimestre a augmenté de 4,6 % en glissement annuel pour atteindre 14,8 milliards de dollars. Les revenus provenant des données et de l’IA ont augmenté de 6 % en glissement annuel. Au cours du trimestre qui s’est achevé en septembre, IBM a fait plusieurs gros paris sur l’IA générative après avoir constaté la demande de ses clients, a fait savoir Arvind Krishna lors du point financier. « Le travail que nous effectuons fait apparaître des modèles clairs en termes de cas d’utilisation de l’IA en entreprise. Sur la base des nombreux retours d’expérience et des essais réalisés à ce jour, trois d’entre eux sont arrivés en tête : la modernisation du code, le service à la clientèle et le travail numérique. Tous ces domaines sont pertinents et apportent des avantages commerciaux tangibles », indique le CEO, ajoutant que l’entreprise a lancé des produits pour répondre à ces cas d’utilisation au cours des trois derniers mois.

De gros paris sur l’IA générative

Ces produits comprennent Granite – un modèle de fondation de plusieurs milliards de paramètres sur Watsonx.ai – qui excelle à la fois dans le langage et le code, et Watsonx Code Assistant, qui comprend l’Assistant pour les systèmes Z. L’entreprise prévoit également de lancer Watsonx.governance avant la fin de l’année. Ce produit est conçu pour fournir les outils de gouvernance dont les entreprises ont besoin pour atténuer les risques et garantir la conformité tout au long du cycle de vie de l’IA. La gouvernance de l’IA générative, selon Arvind Krishna, est une question clé pour les entreprises qui s’inquiètent des ramifications juridiques et de la sécurité des données de l’utilisation de cette technologie pour générer des résultats. Toutefois, le CEO indique que l’entreprise fournira une couverture d’indemnisation pour soutenir tous ses grands modèles de langage. Cela signifie que Big Blue garantira les données qu’elle a utilisées pour former ces modèles. D’autres grands fournisseurs de technologie, dont Microsoft et Adobe, ont également commencé à fournir des garanties similaires pour leurs grands modèles linguistiques.

IBM a déclaré avoir plus de 20 000 consultants en données et en IA et un centre d’excellence pour l’IA générative, visant à aider les entreprises à naviguer dans le paysage de l’IA – de l’élaboration d’une stratégie à la compréhension de la façon dont l’IA peut être utilisée, en passant par le déploiement de l’IA de manière responsable. « Ces consultants fournissent également un retour d’information précieux en temps réel aux autres équipes de produits », affirme Arvind Krishna, ajoutant que l’intérêt pour l’IA générative devrait également alimenter la croissance de ses activités de conseil.

Le cloud hybride, Red Hat et Apptio stimulent la croissance des logiciels

Le cloud hybride, l’automatisation et l’IA ont été les principaux contributeurs à la croissance du chiffre d’affaires des services logiciels pour le trimestre rapporté. « Les clients s’engagent dans notre approche de cloud hybride, avec des réservations annuelles en hausse de 14 % au cours du trimestre. Cela inclut une croissance à deux chiffres pour RHEL, OpenShift et Ansible, partiellement compensée par des vents contraires dans les services basés sur la consommation », a déclaré Jim Kavanaugh, directeur financier d’IBM, lors de l’appel.

La croissance d’AIops et de la gestion, selon Jim Kavanaugh, a été menée par de « bonnes performances » dans Instana, Turbonomic et maintenant Apptio (acquisition réalisée en juin dernier), alors que les entreprises cherchent à optimiser les résultats commerciaux et à stimuler la productivité. Les activités liées aux données et à l’IA ont été soutenues par la croissance dans des domaines tels que la fabrication de données et les exigences en matière de service à la clientèle, a déclaré la société, ajoutant que les entreprises se préparaient à déployer des solutions d’IA générative. Cependant, le chiffre d’affaires des logiciels de sécurité a diminué de 3 % en glissement annuel, car les activités de services de sécurité gérés ont ralenti.

Google a déclaré que les conversations ayant eu lieu avec Bard avaient été accidentellement indexées. Véritable erreur ou rattrapage de communication : le fait est que l’annonce a eu lieu juste après qu’un consultant en référencement se soit rendu sur Twitter pour signaler le problème.

Google, propriété d’Alphabet, s’efforce d’empêcher que les conversations des utilisateurs avec son assistant d’IA générative Bard soient indexées sur sa plateforme de recherche ou qu’elles apparaissent dans les résultats. « Bard permet aux utilisateurs de partager des conversations, s’ils le souhaitent. Nous n’avons pas non plus l’intention de faire en sorte que ces conversations partagées soient indexées par Search. Nous travaillons actuellement à bloquer leur indexation », a indiqué le compte Search Liaison de Google sur Twitter.

La firme répondait ici à un consultant en référencement SEO qui avait signalé sur Twitter que les conversations des utilisateurs avec Bard étaient indexées sur Google Search. L’assistant à base d’IA générative, qui a été ouvert aux inscriptions publiques en mars, a reçu une mise à jour ce mois-ci qui propose aux utilisateurs de partager leurs conversations avec l’assistant via une fonction de partage de liens publics. Selon le message publié sur Twitter, cette fonction pourrait être à l’origine de l’indexation des conversations sur Search. Cependant, toute discussion avec Bard qui n’a pas été partagée publiquement n’est pas indexée, selon Peter J. Liu, chercheur à Google Deep Mind. « Cela ne concerne que les conversations explicitement partagées. Vos conversations ne sont pas publiques par défaut », a indiqué Peter J. Liu sur Twitter.

Haha 😂 Google started to index share conversation URLs of Bard 😹 don’t share any personal info with Bard in conversation, it will get indexed and may be someone will arrive on that conversation from search and see your info 😳Also Bard’s conversation URLs are ranking as… pic.twitter.com/SKGXJD9KEJ

— Gagan Ghotra (@gaganghotra_) September 26, 2023

Une fuite qui pourrait faire douter plus d’un utilisateur

Bien que les commentaires du chercheur puissent apporter un peu de répit aux utilisateurs d’IA générative, l’avis ou l’avertissement de Google Bard sur le partage des conversations pourrait en induire plus d’un en erreur. L’avertissement de Bard, qui a été publié via une image sur Twitter par le fondateur de Datasette, Simon Willison, se lit comme suit : « Permettez à toute personne possédant le lien de voir ce que vous avez sélectionné. Vous pouvez supprimer les liens dans vos liens publics. N’oubliez pas que vous avez accepté les conditions d’utilisation de Google et les conditions d’utilisation supplémentaires de l’IA générative ».

De nombreux utilisateurs peuvent par ailleurs penser que les personnes avec lesquelles ils partagent leur lien de conversation pourront le voir plutôt que le moteur de recherche de Google ne le scanne. Par ailleurs, Simon Willison a suggéré dans un autre tweet que la fuite accidentelle de conversations ne se produirait pas avec le ChatGPT de Microsoft, qui compte d’ailleurs plus d’utilisateurs, en raison de la présence d’une ligne de code supplémentaire – =”robots” content=”noindex,nofollow” – qui exclut les conversations des résultats de recherche. Bien que Google ait déclaré travailler sur une solution pour mettre fin à l’indexation accidentelle, la page d’historique des mises à jour de Bard, dont la dernière mise à jour date du 27 septembre, ne présente aucune entrée qui se concentre ou parle de ce problème.

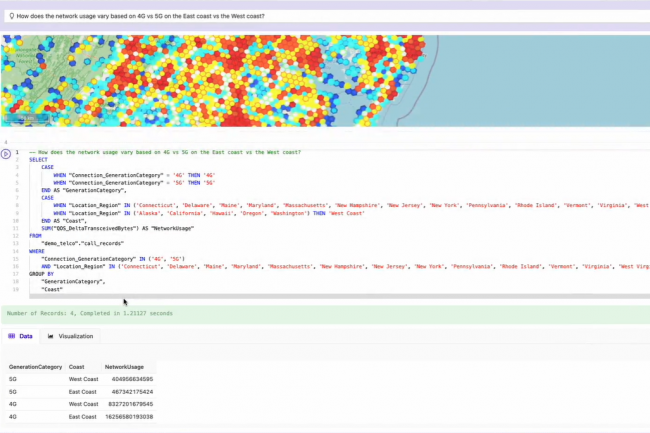

Invoquant des problèmes de sécurité et de confidentialité, Kinetica dévoile son propre LLM pour les requêtes SQL, le tout à partir d’invites en langage naturel dans sa base de données relationnelle. L’entreprise précise s’adresser à des clients sensibles à la sécurité, notamment les organisations de défense du gouvernement américain.

Décidément, l’actualité est aux LLM. Invoquant les problèmes de confidentialité et de sécurité que posent les grands modèles de langage publics, Kinetica ajoute à sa base de données relationnelle un modèle LLM développé par ses soins pour générer des requêtes SQL à partir d’invites en langage naturel pour le traitement analytique en ligne (OLAP) et en temps réel. La société, qui tire plus de la moitié de son chiffre d’affaires d’organisations de défense américaines telles que le NORAD et l’armée de l’air, affirme que le LLM natif est plus sûr, qu’il est adapté à la syntaxe du système de gestion de la base de données et qu’il opère dans le périmètre du réseau du client.

Avec la publication de son LLM, Kinetica rejoint les rangs de tous les principaux fournisseurs de LLM ou de services d’IA générative – y compris IBM, AWS, Oracle, Microsoft, Google et Salesforce – qui affirment qu’ils conservent les données d’entreprise à l’intérieur de leurs conteneurs ou serveurs respectifs. Ces fournisseurs affirment également que les données des clients ne sont pas utilisées pour former de grands modèles de langage. En mai, Kinetica, qui propose sa base de données sous différentes formes (hébergée, SaaS et sur site), a déclaré qu’elle intégrerait ChatGPT d’OpenAI pour permettre aux développeurs d’utiliser le traitement du langage naturel pour effectuer des requêtes SQL. En outre, la société a déclaré qu’elle travaillait à ajouter d’autres modèles à ses offres de bases de données, y compris NeMo de Nvidia.

Pas de coût supplémentaire annoncé pour les clients

Le LLM de Kinetica donne également aux utilisateurs professionnels la possibilité de gérer d’autres tâches telles que les requêtes sur les graphiques de séries temporelles et les requêtes spatiales pour une meilleure prise de décision, a déclaré l’entreprise dans un communiqué. L’entreprise précise qu’il est immédiatement disponible pour les clients dans un environnement conteneurisé et sécurisé, sur site ou dans le cloud, sans aucun coût supplémentaire.

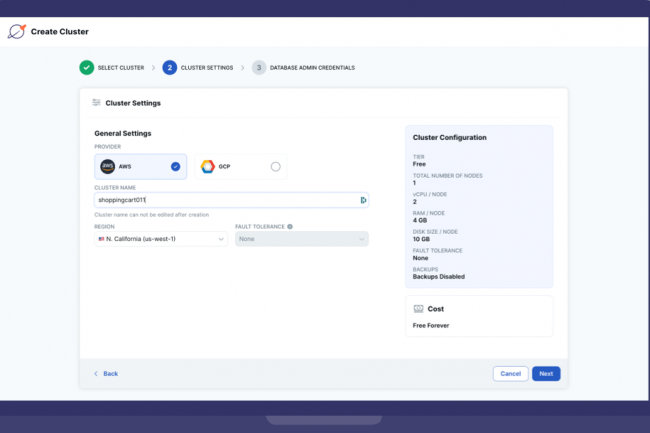

Les dernières mises à jour de la version gérée de la base de données SQL distribuée open source de Yugabyte incluent le support d’AWS PrivateLink, une observabilité améliorée et une évolutivité plus rapide.

Yugabyte a annoncé lundi qu’elle ajoutait une interface de ligne de commande (CLI) ainsi que d’autres fonctions à la version managée de sa base de données SQL distribuée open source, baptisée YugabyteDB Managed. Selon l’éditeur, cette CLI offre aux développeurs les avantages de l’automatisation tout en écrivant du code sans avoir besoin d’acquérir des compétences supplémentaires. « Les développeurs de tous niveaux peuvent facilement créer et gérer des clusters à partir de leur terminal ou de leur environnement de développement intégré (IDE) et utiliser l’ensemble des outils les plus avancés disponibles pour optimiser les performances de la base de données et faire progresser l’entreprise », a déclaré Karthik Ranganathan, directeur technique et cofondateur de Yugabyte, dans un communiqué.

Cela signifie que les développeurs peuvent créer et gérer des clusters hébergés dans YugabyteDB Managed à partir de leur IDE ou de leur terminal sans avoir besoin de compétences en matière d’API REST ou de Terraform (solution d’infrastructure as a code), a ajouté le dirigeant. En outre, cette CLI managée peut automatiser les tâches répétitives et dispose d’une fonction d’auto-complétion qui facilite la découverte de nouvelles fonctionnalités pour les développeurs, les administrateurs de bases de données et les ingénieurs DevOps, a déclaré l’entreprise. L’entreprise ajoute que la CLI est également compatible avec de multiples plateformes telles que Mac, Windows et Linux. La version Windows peut être téléchargée depuis GitHub.

Des fonctions d’observabilité injectées dans la dernière version

La dernière mise à jour de YugabyteDB Managed propose également des fonctions d’observabilité améliorées, l’entreprise ayant ajouté plus de 125 métriques SQL et de couche de stockage. « Grâce à ces mesures, les entreprises obtiendront des informations encore plus approfondies sur les performances de leur base de données, ce qui facilitera l’identification et la résolution rapide des problèmes de performance », a écrit la société dans un billet de blog. L’interface utilisateur basée sur le cloud pour l’observabilité à l’intérieur de YugabyteDB Managed comprend des options supplémentaires en termes de visualisation pour réorganiser les mesures pour un tableau de bord personnalisé et des infobulles synchronisées dans les graphiques pour faciliter le dépannage, a ajouté l’éditeur.

En outre, il a ajouté la prise en charge d’AWS PrivateLink, un service qui fournit une connectivité privée entre les clouds privés virtuels, les services AWS pris en charge et les réseaux sur site. « Cette fonctionnalité, qui est maintenant en private preview, est disponible pour les clusters dédiés créés dans YugabyteDB Managed sur AWS, comme alternative au peering VPC, pour un accès sécurisé à vos bases de données sur un réseau privé ». La prise en charge de PrivateLink offre également un accès plus sécurisé aux bases de données d’une entreprise, ajoute-t-elle. Les entreprises qui utilisent déjà YugabyteDB peuvent obtenir un essai gratuit de YugbyteDB Managed avec toutes les fonctions sur demande.

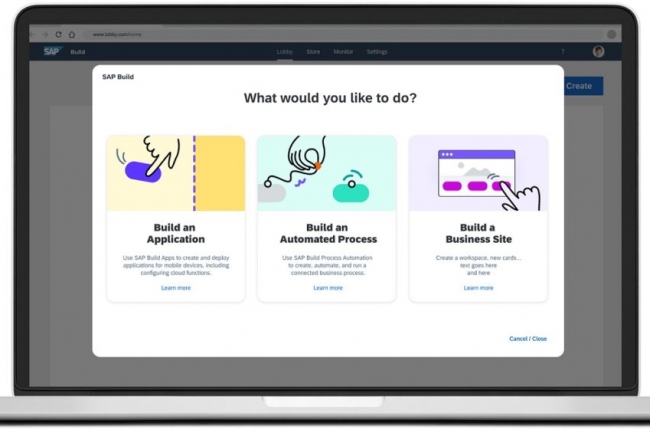

L’éditeur allemand SAP prévoit d’introduire prochainement une fonction de gouvernance sur Build. Les équipes IT pourront surveiller l’utilisation, les performances et l’accès aux données des applications développées sur sa plateforme.

SAP ajoutera bientôt une fonction de gouvernance pour les applications développées sur sa plateforme low-code / no-code Build. Une décision qui, selon les analystes, arrive tard dans le jeu pour SAP, car il existe déjà des outils de gouvernance bien établis sur le marché. Ce service donne les moyens aux équipes informatiques de contrôler les applications développées sur sa plateforme low-code, car elles seront accessibles à de nombreux autres utilisateurs dans l’entreprise, a déclaré Bharat Sandhu, vice-président senior de l’IA et de la plateforme de développement d’applications chez SAP.

« Lorsque les applications affectent un grand nombre de personnes, alors il y a une couche de gouvernance pour s’assurer que les équipes IT peuvent surveiller les utilisateurs et la performance entre autres choses », a ajouté Bharat Sandhu, citant l’importance de travailler avec des données critiques, généralement stockées dans le cloud SAP, mais ne donnant pas de calendrier exact sur la sortie de la fonction. Build offre actuellement un plan de contrôle des données pour les équipes IT afin de gérer l’exposition des données SAP critiques via les API, y compris la lecture, l’écriture ou l’accès aux deux, car les entreprises ne veulent pas que n’importe qui accède aux données critiques et les modifie, selon M. Sandhu.

Construire pour se concentrer sur les clients SAP

« Depuis que nous avons lancé Build à la mi-novembre de l’année dernière, il a connu une adoption phénoménale, à la fois par nos clients qui l’utilisent et par ceux qui en apprennent davantage à son sujet », observe le dirigeant. Plus de 72 000 utilisateurs actifs quotidiens se sont formés à Build via le portail d’apprentissage de SAP, a déclaré l’entreprise, sans divulguer de chiffres précis sur l’adoption. La plateforme low-code est toutefois en retrait par rapport à ses rivales – dont Appian, Google Appsheet, Mendix, Pegasystems et Outsystems – en termes de fonctions de contrôle et de gouvernance, selon les experts.

« Dans la liste des produits de classe entreprise pour les plateformes low-code, SAP est un peu à la traîne en ce qui concerne le contrôle du plan de données ou les fonctions de gouvernance en général. Il s’agit d’une capacité essentielle pour l’adoption et l’utilisation à grande échelle du low-code dans une entreprise, tout en gardant les données métiers critiques sûres, sécurisées et accessibles uniquement aux personnes autorisées », a déclaré Dion Hinchcliffe, analyste principal chez Constellation Research. « L’adoption de Build pour le marché SAP pourrait être élevée, probablement à deux chiffres ou moins », indique-t-il, ajoutant que la plateforme pourrait gagner des parts de marché en dehors du marché SAP en temps voulu en raison de la popularité de l’entreprise, mais qu’il s’agit encore d’une inconnue à l’heure actuelle. En outre, la part de marché de Build sur le marché du low-code est assez faible étant donné que cette stratégie de l’éditeur n’en est qu’à ses débuts, selon John Bratincevic, analyste principal chez Forrester.

L’Inde est le pays qui adopte le plus rapidement Build

En termes d’adoption et de demande de Build, l’Inde, les États-Unis, l’Allemagne et la Chine connaissent une forte croissance, selon M. Sandhu. Le premier devrait connaître une forte croissance, car certains grands intégrateurs affirment que cette technologie est essentielle pour stimuler leur propre offre de développeurs. Un moyen de former des non-développeurs à l’utilisation de ces plateformes, a déclaré M. Bratincevic.

« Nous avons également constaté que les développeurs indiens qui soutiennent les grands intégrateurs s’inscrivent en masse à la version gratuite des plateformes low-code pour se former et obtenir des certifications. Cela pourrait être un facteur dans l’affirmation de SAP, en particulier si les partenaires intégrateurs de SAP se préparent à soutenir Build », poursuit M. Bratincevic.

Un marché estimé à 21 Md $ d’ici 2026

D’une manière générale, le marché des plates-formes low-code et no-code devrait poursuivre sa croissance, selon les experts. Il devrait ainsi atteindre 21 milliards de dollars d’ici 2026, selon une analyse d’IDC. « Il est stimulé par la pénurie mondiale de développeurs à temps plein », a déclaré Michèle Rosen, directrice de recherche chez IDC.

« Cette situation devrait se poursuivre tout au long de la décennie, créant un marché solide pour les technologies qui augmentent la productivité des développeurs ou élargissent le pool potentiel de développeurs », affirme Michèle Rosen, citant le développement cloud-natif comme l’un des principaux accélérateurs de la demande pour les plateformes low-code. Dans une certaine mesure, Bharat Sandhu de SAP approuve l’analyse de Michèle Rosen et a déclaré que les développeurs professionnels utilisaient également des plateformes low-code et no-code en raison de leur retard dans les cycles de développement d’applications.

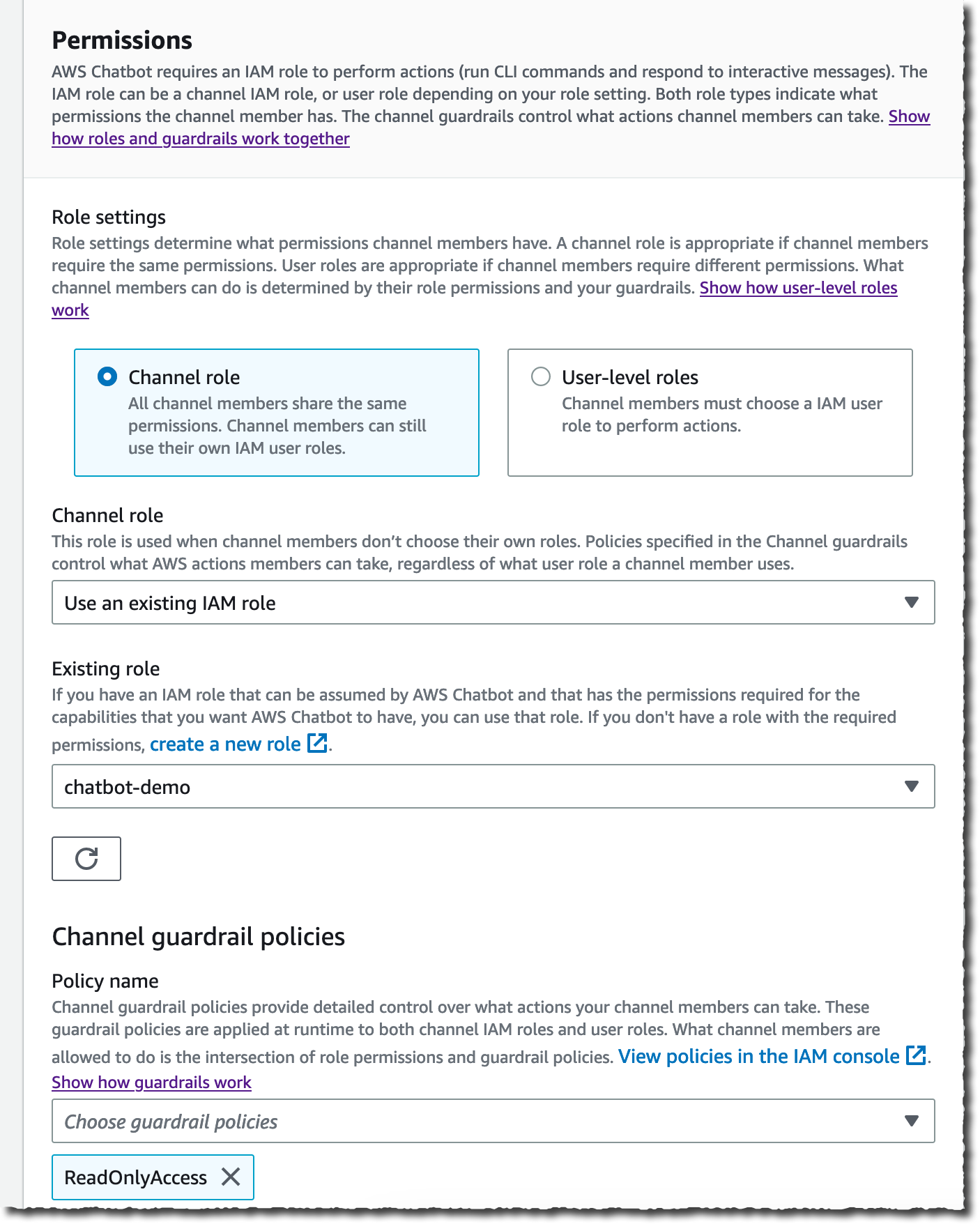

L’intégration du chatbot AWS dans Teams de Microsoft est un réel plus pour utilisateurs de l’entreprise. Ces derniers peuvent recevoir des notifications sur des événements tels que les risques de sécurité et l’état de santé du système à partir de Teams, et exécuter des lignes de commande pour lancer des notebook afin de résoudre les problèmes.

Amazon Web Services (AWS) a intégré son chatbot dans Microsoft Teams pour donner aux utilisateurs professionnels les moyens d’interagir avec leurs ressources AWS depuis l’application de chat. AWS Chatbot, qui a été présenté pour la première fois en 2019 et rendu disponible pour tous en 2020, est un service qui offre aux équipes de développement et IT des entreprises de recevoir des notifications sur leurs ressources d’infrastructure AWS depuis une application de productivité ou de chat telle que Slack. « Lorsque vous utilisez AWS Chatbot for Microsoft Teams ou d’autres plateformes de chat, vous recevez des notifications des services AWS directement dans vos canaux de discussion, et vous pouvez agir sur votre infrastructure en tapant des commandes sans avoir à passer à un autre outil », écrit Sébastien Stormacq, principal developer advocate chez AWS, dans un billet de blog.

L’interaction avec l’infrastructure et les ressources AWS est rendue possible grâce à l’intégration de l’application de chat avec des services de la firme tels que CloudWatch et Simple Notification Service (SNS). Le premier est un service utilisé pour collecter, et visualiser en temps réel des logs, des métriques et des données d’événements dans des tableaux de bord automatisés. Le second est un service de notification push entre les systèmes distribués, les microservices, les applications serverless et les points de terminaison d’AWS. Les applications incluses dans SNS sont Simple Queue Service (SQS), Kinesis Data Firehose, Lambda et d’autres endpoints HTTPS, précise l’entreprise. L’intégration du service EventBridge à SNS donne également au chatbot les moyens pour envoyer des informations relatives aux événements aux applications de chat prises en charge.

Une disponibilité en quelques clics pour les équipes Teams

Avec le chatbot d’AWS, les équipes IT peuvent par ailleurs exécuter des notebooks via l’interface de ligne de commandes pour résoudre des problèmes. Les commandes longues que les utilisateurs ont tendance à oublier peuvent être stockées en créant des alias dans le canal AWS Chatbot dans Teams et d’autres applications, a déclaré l’entreprise. Pour rappel, les notebooks sont des référentiels qui hébergent les codes exécutables des programmes.

Pour ajouter AWS Chatbot à Teams, les entreprises doivent ajouter le bot à l’équipe ou au groupe concerné dans l’application. Ensuite, l’URL de l’équipe peut être utilisée pour configurer le chatbot depuis AWS Management Console ou Cloud Development Kit. Les entreprises doivent attribuer des autorisations de gestion des identités et des accès sur ce que les membres du canal peuvent faire dans ce canal et associer des sujets SNS pour recevoir des notifications, précise Sébastien Stormacq dans le post.

Pour atténuer le risque qu’une autre personne de votre équipe accorde accidentellement plus que les privilèges nécessaires au canal ou aux rôles de niveau utilisateur, vous pouvez également inclure des stratégies de “garde-corps de canal”, indique Sébastien Stormacq dans son post. (Crédit : AWS)

Au moment du lancement en 2020, AWS Chatbot était pris en charge sur Slack et Chime. Parmi les autres services sur lesquels le chatbot peut envoyer des notifications, citons les services Health, Budgets et Security Hub d’AWS ainsi GuardDuty, CloudWatch et CloudFormation.

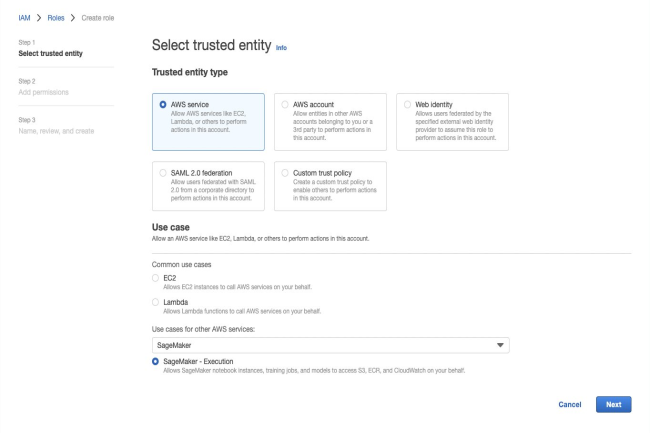

À l’occasion de la conférence re:Invent 2022, AWS a mis à jour son service géré d’apprentissage automatique pour y inclure des fonctionnalités de notebook et de gouvernance.

Profitant de re:Invent 2022, Amazon Web Services a ajouté mercredi des capacités supplémentaires à son service d’apprentissage automatique géré SageMaker, conçues pour améliorer les attributs de gouvernance au sein du service et ajouter des capacités supplémentaires à ses notebooks. Dans le contexte d’Amazon SageMaker, les notebooks sont des instances de calcul qui exécutent l’application Jupyter Notebook. Selon AWS, ces améliorations permettront aux entreprises d’étendre la gouvernance à l’ensemble du cycle de vie de leurs modèles de machine learning (ML). À mesure que le nombre de modèles de ML augmente, il peut devenir difficile pour les entreprises de gérer la tâche consistant à définir des contrôles d’accès à privilèges et à établir des processus de gouvernance pour documenter les informations sur les modèles, telles que les ensembles de données d’entrée, les informations sur l’environnement d’entrainement, la description de l’utilisation du modèle et l’évaluation des risques.

Les équipes d’ingénierie des données et d’apprentissage automatique utilisent actuellement des feuilles de calcul ou des listes ad hoc pour naviguer dans les politiques d’accès nécessaires à tous les processus concernés. Cela peut devenir complexe à mesure que la taille des équipes d’apprentissage automatique augmente au sein d’une entreprise, a indiqué AWS dans un communiqué. Un autre défi consiste à surveiller les modèles déployés pour détecter les biais et s’assurer qu’ils fonctionnent comme prévu, a indiqué l’entreprise.

Role Manager et Model Cards viennent booster SageMaker

Pour relever ces défis, la firme a ajouté Role Manager afin de faciliter le contrôle d’accès et la définition des autorisations pour les utilisateurs par les administrateurs. Grâce à cet outil, les administrateurs peuvent sélectionner et modifier des modèles préétablis en fonction des différents rôles et responsabilités des utilisateurs. L’outil crée ensuite automatiquement des politiques d’accès avec les permissions nécessaires en quelques minutes, a déclaré la société. AWS a également ajouté un second outil à SageMaker, appelé Model Cards, pour aider les équipes de datascientist à abandonner la tenue manuelle des dossiers.

L’outil fournit un emplacement unique pour stocker les informations sur les modèles dans la console AWS et il peut remplir automatiquement les détails de l’entraînement comme les ensembles de données d’entrée, l’environnement de formation et les résultats de la formation directement dans Amazon SageMaker Model Cards, a déclaré la société. « Les praticiens peuvent également inclure des informations supplémentaires à l’aide d’un questionnaire auto-guidé pour documenter les informations du modèle (par exemple, les objectifs de performance, l’évaluation des risques), les résultats de la formation et de l’évaluation (par exemple, les mesures de biais ou de précision), et les observations pour référence future afin d’améliorer encore la gouvernance et de soutenir l’utilisation responsable du ML », a déclaré le fournisseur de services cloud.

Un tableau de bord dédié

En outre, la société a ajouté Model Dashboard pour fournir une interface unique dans SageMaker pour suivre les modèles d’apprentissage automatique. À partir du tableau de bord, les entreprises peuvent également utiliser les intégrations intégrées avec SageMaker Model Monitor (capacité de surveillance de la dérive des modèles et des données) et SageMaker Clarify (capacité de détection des biais ML), a déclaré la société, ajoutant que la visibilité de bout en bout aidera à rationaliser la gouvernance de l’apprentissage automatique.

Le Notebook de SageMaker Studio monte en gamme

Outre l’ajout de fonctions de gouvernance à SageMaker, AWS a apporté des améliorations à Studio Notebook pour aider les équipes data sciences à collaborer et à préparer les données plus rapidement au sein du notebook. Une fonctionnalité de préparation des données dans SageMaker Studio Notebook aidera désormais les équipes de science des données à identifier les erreurs dans les ensembles de données et à les corriger depuis l’intérieur du notebook. Cette fonctionnalité permet aux data scientists d’examiner visuellement les caractéristiques des données et de remédier aux problèmes de qualité des données, a déclaré la société, ajoutant que l’outil génère automatiquement des graphiques pour aider les utilisateurs à identifier les problèmes de qualité des données et suggère des transformations de données pour aider à résoudre les problèmes courants.

Pour rappel, AWS a lancé SageMaker Studio en 2019, qu’elle décrit comme « le premier environnement de développement (IDE) entièrement intégré pour la science des données et l’apprentissage automatique (ML) ». Cet IDE donne accès à des Notebooks Jupyter entièrement gérés qui s’intègrent à des outils spécialement conçus pour effectuer toutes les étapes de ML, de la préparation des données à la formation et au débogage des modèles, au suivi des expériences, ou encore au déploiement et à la surveillance des modèles et à la gestion des pipelines. « Une fois que le praticien a sélectionné une transformation de données, SageMaker Studio Notebook génère le code correspondant dans le notebook afin qu’il puisse être appliqué de manière répétée à chaque fois que le notebook est exécuté », a déclaré la société.

Afin de faciliter la collaboration entre les équipes de datascientist, AWS introduit également un espace de travail au sein de SageMaker où les experts peuvent lire, modifier et exécuter des notebooks ensemble en temps réel, a indiqué la société. Parmi les autres fonctionnalités de SageMaker Studio Notebook, citons la conversion automatique du code des notebooks en tâches prêtes pour la production et la validation automatisée des modèles de ML à l’aide de demandes d’inférence en temps réel. En outre, le fournisseur a déclaré qu’il ajoutait des fonctionnalités géospatiales à SageMaker pour permettre aux entreprises d’accroître son utilisation ou son rôle dans la formation des modèles d’apprentissage automatique. L’objectif est de « simplifier le processus de création, de formation et de déploiement de modèles avec des données géospatiales ». Le service n’en est pour l’instant qu’à ses débuts, la prise en charge d’Amazon SageMaker pour le ML géospatial étant uniquement disponible en preview dans la région USA Ouest (Oregon).