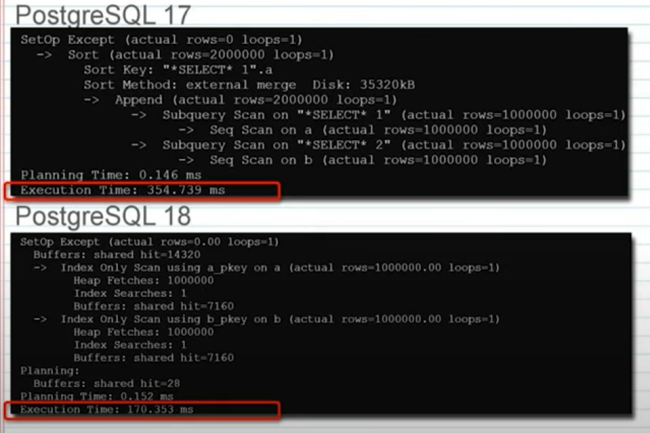

Prévue pour la fin du mois, la dernière version de la célèbre base de données open source ajoute des capacités pour des transactions plus rapides. Mais PostgreSQL 18 ne dispose pas des fonctionnalités dédiées aux charges de travail hybride et aux agents IA.

L’arrivée prochaine de PostgreSQL 18 divise les experts quant à son contenu. En effet, la dernière version de la base de données open source introduit des fonctionnalités qui améliorent les performances avec des gains significatif pour les charges de traitement transactionnel en ligne (OLTP). Mais elle fait l’impasse sur deux thèmes très tendances : le support des charges de travail hybride mêlant transactionnel et analytique (OLAP), et les agents IA. PostgreSQL est devenue une base de données incontournable…

Il vous reste 93% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

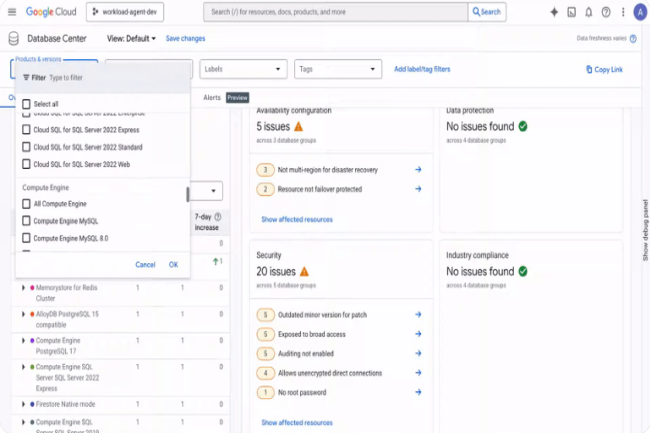

Dans la dernière mise à jour de Database Center, Google Cloud propose de surveiller les VM exécutant les bases de données auto-gérées. Elle comprend aussi d’autres fonctionnalités pour les alertes ou la comparaison historique du parc.

Lancé pour tous en mai dernier, Database Center évolue. En effet, l’offre de gestion des parcs de base de données de Google Cloud s’étoffe de plusieurs fonctionnalités supplémentaires. La plus notable est celle qui propose la surveillance des machines virtuelles Compute Engine exécutant des bases de données autogérées. Ce système offre plus de flexibilité, d’évolutivité et de rentabilité que le matériel dédié. Jusque-là, les entreprises pouvaient utiliser Database Center pour surveiller uniquement les bases de données gérées par Google, notamment Spanner, AlloyDB et Bigtable. Mais les entreprises voulaient aussi pouvoir surveiller leurs bases de données autogérées afin d’avoir une vue d’ensemble complète de toutes leurs bases déployées.

« Cette vue holistique est capable d’identifier les failles de sécurité critiques, d’améliorer la posture de sécurité et de simplifier la conformité », a déclaré Charlie Dai, vice-président et analyste principal chez Forrester. « Concernant les failles de sécurité, il peut s’agir de versions mineures obsolètes, de plage d’accès IP trop large, de bases de données sans mot de passe root et sans audit activé », ont écrit dans un blog Kiran Shenoy, responsable produit senior et Apoorv Shrivastava, responsable produit bases de données au sein de Google Cloud. Cette fonctionnalité est actuellement en préversion et les entreprises doivent s’inscrire pour y avoir accès en avant-première.

Alertes, comparaison d’historique de parcs et une pointe de Gemini

Database Center s’enrichit également d’autres capacités, comme des alertes pour les ressources supplémentaires et pour signaler des problèmes concernant toutes les bases de données, ainsi que des fonctionnalités de langage naturel optimisées par Gemini pour la gestion du parc au niveau des dossiers, et une comparaison historique du parc sur une période pouvant aller jusqu’à 30 jours. Selon le fournisseur de cloud, grâce à ces fonctionnalités, les utilisateurs pourront créer des alertes personnalisées lorsque des ressources de base de données sont provisionnées, recevoir des notifications par e-mail, Slack et via les messages Google Chat pour tout type de problème détecté par Database Center. « La surveillance devient ainsi proactive et il est possible de prendre des mesures immédiates pour appliquer les politiques de gouvernance, prévenir les dérives de configuration et atténuer les risques avant qu’ils n’aient un impact sur les applications », a fait valoir Charlie Dai.

Afin de simplifier la surveillance à grande échelle, Google a ajouté des éléments linguistiques basées sur Gemini à Database Center au niveau des dossiers. « Cela signifie que l’on peut désormais avoir des conversations contextuelles sur ses bases de données dans un dossier spécifique, ce qui facilite leur gestion et leur dépannage, en particulier dans les environnements organisationnels vastes et complexes », explique le blog de Google Cloud. Quant à la capacité de comparaison historique du parc sur 30 jours, elle peut servir aux entreprises pour la planification des capacités et l’analyse de l’état du parc de bases de données. Auparavant, Google proposait une comparaison historique sur sept jours pour l’inventaire et les problèmes liés aux bases de données. Dorénavant, trois options sont disponibles : 1 jour, 7 jours et 30 jours. « Les entreprises ou les administrateurs de bases de données peuvent utiliser la fonctionnalité de comparaison de parcs pour obtenir une vue détaillée du dernier inventaire des bases de données et identifier les problèmes opérationnels et de sécurité apparus au cours de la période sélectionnée », ont ajouté les deux responsables de Google Cloud. « Ces fonctionnalités devraient aider les administrateurs de bases de données des entreprises à prendre des décisions fondées sur les données pour optimiser leur parc », a avancé Charlie Dai. Google n’a pas précisé si ces fonctionnalités supplémentaires étaient déjà disponibles pour les utilisateurs.

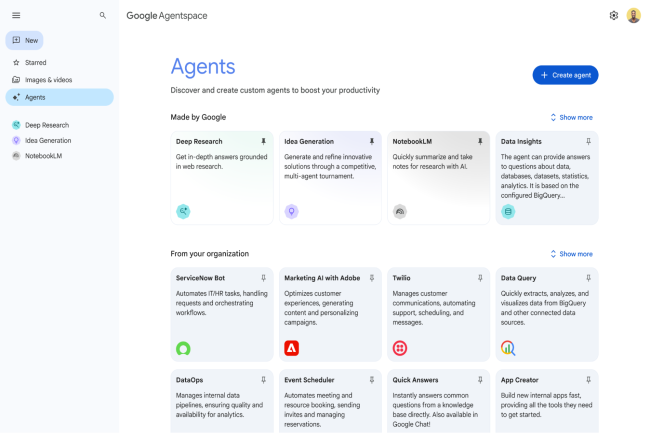

Dorénavant géré par la Fondation Linux, le protocole open source Agent2Agent passe en version 0.3. Cette dernière introduit le support gRPC, une sécurité renforcée et des fonctions axées développeurs.

Google Cloud reste un des principaux contributeurs du protocole Agent2Agent (A2A) qu’il avait présenté à Next en avril 2025. Il vient d’annoncer la version 0.3 du projet open source désormais chapeauté par la Fondation Linux. La dernière itération propose plusieurs évolutions et améliorations sur le plan fonctionnel et sécurité. En premier lieu, le fournisseur de cloud a annoncé le support du gRPC, un framework open source développé par la firme de Mountain View. Il vise à assurer la communication entre applications via des appels distants.

Cet outil a la particularité de pouvoir fonctionner de manière très performante, même lorsque les applications se trouvent sur des machines différentes ou sont écrites dans des langages différents. « Les performances élevées du gRPC et la prise en charge de plusieurs langages de programmation en font un outil adapté aux applications complexes et distribuées », a déclaré Stephanie Walter, analyste chez Hyperframe Research. De plus, selon Dion Hinchcliffe, analyste chez The Futurum Group, les capacités de faible latence et de haut débit du framework lorsqu’il est intégré à l’A2A le rendront plus adaptable à l’orchestration multi-agents en temps réel. « Pour les entreprises, le support du gRPC donne la capacité aux agents d’interopérer via un protocole largement adopté et indépendant du langage qui simplifie l’intégration avec les microservices et les architectures cloud natives existantes », a fait remarquer Dion Hinchcliffe.

Des cartes d’identités sécurisées des agents

Pour stimuler encore un peu plus l’adoption de son protocole par les entreprises, Google a introduit dans A2A une capacité de signature des cartes de sécurité. « Celle-ci est essentielle pour les développeurs et les grandes entreprises, en particulier les entreprises du Fortune 500, car elles ne déploieront pas d’agents qui ne peuvent pas prouver leur identité de manière cryptographique », a rappelé Paul Chada, cofondateur de DoozerAI, une plateforme de travailleurs numériques alimentés par des agents.

De la même manière, Stéphanie Walters pense que « cette capacité de sécurité va aider les entreprises à s’assurer de la bonne application des politiques appropriées de contrôle d’accès et d’exécution. Ainsi, elles se protégeront contre une attaque qui pourrait nuire à la réputation, exposer des secrets commerciaux ou avoir un impact négatif sur le résultat net ». Elle ajoute que « les développeurs peuvent aussi utiliser cette fonctionnalité pour s’assurer que tout agent, en particulier ceux qui ne sont pas écrits par l’entreprise, provient d’une source fiable ».

Intégration de l’A2A dans l’Agent Development Kit

L’analyste estime par ailleurs que l’intégration par Google d’A2A à son framework open source Agent Development Kit (ADK) pour la création d’agents va accélérer l’intégration et la composabilité des agents pour les entreprises utilisant ADK. « Essentiellement, Google intègre la prise en charge du protocole A2A directement dans ADK, de sorte que les agents construits avec cet outil bénéficient automatiquement des capacités de communication A2A. C’est un peu comme si l’intégration de Slack se faisait directement dans le framework de développement sans avoir besoin d’effectuer un travail d’intégration distinct », a expliqué M. Chada de Doozer.

Le fournisseur a également étendu la prise en charge côté client dans le SDK Python intégré à son kit de développement d’agents. « Cette extension donnera aux développeurs la capacité de créer et de gérer plus facilement des agents A2A à l’aide de Python », a fait remarquer Dion Hinchcliffe. « Pour les entreprises, ce support va fluidifier le développement, car les équipes pourront construire, tester et déployer des flux de travail agentiques plus rapidement tout en restant dans leur chaîne d’outils d’IA existante », poursuit l’analyste. Afin de stimuler la diffusion de l’A2A, Google autorise désormais à ses partenaires de vendre des agents supportés par l’A2A sur sa place de marché AI Agents Marketplace. Il est donc possible d’évaluer les systèmes d’agents qui prennent en charge l’A2A par l’intermédiaire du service d’évaluation Vertex GenAI Evaluation Service.

A2A ou MCP ?

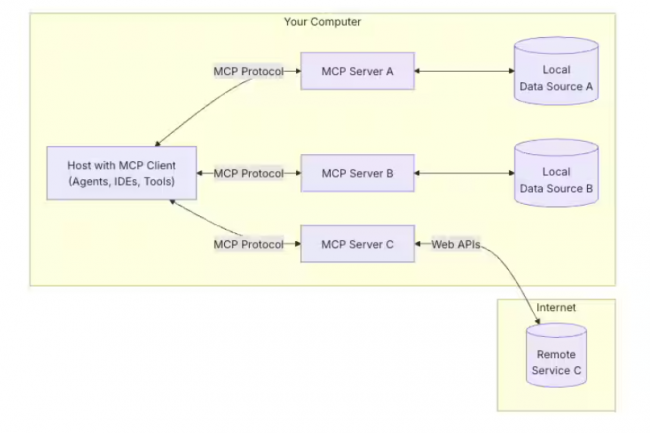

En ce qui concerne les deux protocoles open source qui promettent aux agents de communiquer entre eux, les experts affirment que le Model Context Protocol (MCP) a une longueur d’avance sur l’A2A. « D’après ce que l’on observe dans la communauté des développeurs, le MCP a le vent en poupe en termes de facilité d’utilisation et il est très bien adopté par la communauté », observe Paul Chada. Selon Dion Hinchcliffe, MCP le bénéficie également d’un soutien plus large de la part des fournisseurs et il est plus neutre sur le plan de l’écosystème. Google fait valoir qu’actuellement au moins 150 partenaires l’aident à construire, codifier et adopter l’A2A comme protocole standard pour les agents IA. Cependant, les deux spécialistes sont divisés sur les cas d’usage qui conviennent à chaque protocole. De son côté, M. Hinchcliffe pense que l’A2A est plus adapté aux écosystèmes d’agents liés à la pile de Google, et que le MCP s’adresse plus aux environnements hétérogènes et multifournisseurs dans lesquels les entreprises ont besoin d’interopérabilité entre différents modèles et fournisseurs.

Pour sa part, Paul Chada note que le MCP excelle dans les scénarios d’intégration d’outils à agent unique, tandis que l’A2A cible l’orchestration multi-agents dont les entreprises ont réellement besoin. « Le MCP est plus réputé auprès des développeurs, mais l’A2A dispose des partenariats d’entreprise qui comptent pour les déploiements à grande échelle. La question est de savoir si les utilisateurs veulent la simplicité ou les fonctionnalités d’entreprise », glisse-t-il. Par contre, les deux experts s’accordent à dire que l’A2A est plus sûr que le MCP. « L’A2A offre actuellement des primitives de sécurité intégrées plus robustes : des cartes de sécurité signées et le réseau zero trust de Google. Il est donc plus facile pour les entreprises de mettre en place des interactions sécurisées avec les agents. La sécurité du MCP est plus flexible, mais nécessite une mise en œuvre minutieuse entre les fournisseurs, ce qui peut introduire des écarts », conclut Dion Hinchcliffe.

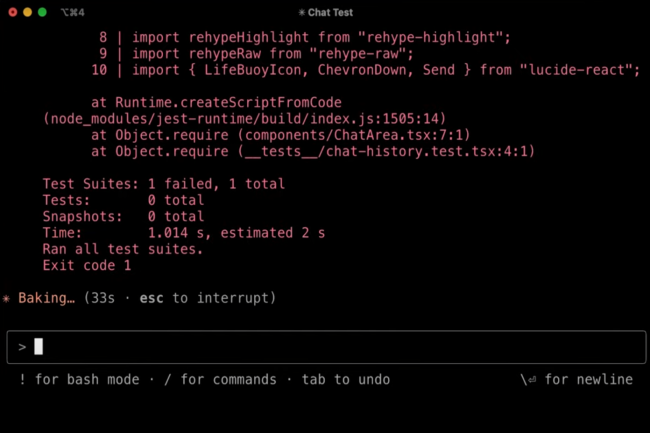

Plusieurs analystes conseillent aux responsables IT de bien évaluer l’usage des IDE agentiques. En effet, la volatilité des prix, la latence et les problèmes de sécurité doivent inciter à la prudence.

Si l’IA générative a apporté des gains de productivité dans le développement, l’arrivée des environnements de développement intégré (IDE) pilotés par l’intelligence artificielle suscite quelques interrogations parmi les analystes. Ces derniers recommandent aux entreprises de ne pas de se précipiter pour les adopter. Pour justifier cette prudence, ils mettent en avant les changements imprévisibles dans les modèles d’utilisation et de tarification, la fiabilité et la…

Il vous reste 95% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

Grâce à son support natif des bases de données maison, le serveur MCP d’Oracle permettra aux développeurs de créer des agents d’intelligence artificielle capables d’interroger, de raisonner et de générer des informations de manière autonome sans couches d’intégration personnalisées.

Le serveur Model Context Protocol (MCP) lancé par Oracle doit aider les entreprises à créer des applications agentiques capables d’interroger, d’extraire et de raisonner de manière autonome sur les données d’entreprise stockées dans les bases de données de l’éditeur et de générer des résultats plus sensibles au contexte. Le serveur MCP a été intégré dans les principaux outils de développement d’Oracle, si bien que la base de données Database est disponible…

Il vous reste 91% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

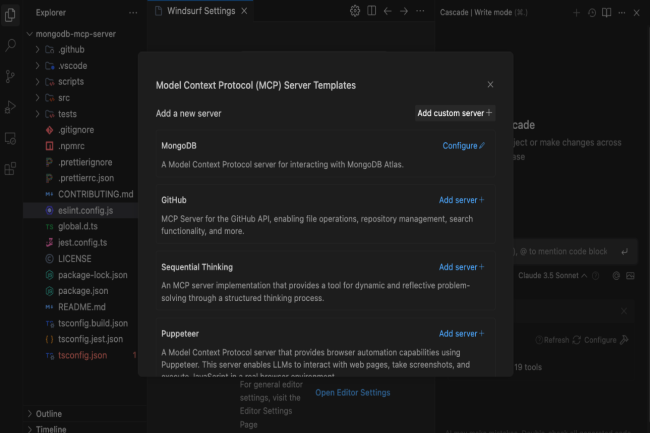

Petit à petit le Model Context Protocol promu par Anthropic est adopté par une majorité d’acteurs IT. Dernier en date, MongoDB vient de l’ajouter à ses bases de données pour aider les développeurs à créer des agents IA.

Au fur et à mesure que les éditeurs se tournent vers les agents IA, le model context protocol (MCP) devient incontournable. Le spécialiste des bases de données MongoDB vient d’annoncer le support de ce protocole promu par Anthropic. MCP est un protocole ouvert qui propose de connecter facilement des agents IA à des référentiels de contenu, des outils métiers et des IDE. Les développeurs peuvent ainsi connecter les agents à des LLM pour le raisonnement, fournir des données contextuelles et des outils pour…

Il vous reste 93% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

Les attaques par injection d’invites et la violation des droits d’auteur sont deux domaines dans lesquels l’IA est souvent défaillante, au point que Microsoft propose des outils pour aider les entreprises à atténuer ces risques dans leurs applications d’IA.

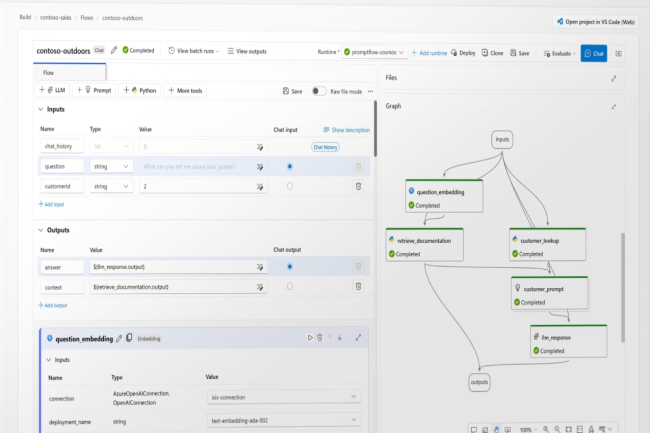

Après l’euphorie, la réalité commence à s’imposer sur les capacités de l’IA générative : sans protections appropriées, les grands modèles de langage (LLM) peuvent se montrer terriblement naïfs et partager beaucoup trop facilement ce qu’ils savent. Or de tels comportements exposent les applications construites à partir de ces modèles, et les entreprises qui les utilisent, à des risques de piratage et à des poursuites pour violation des droits d’auteur. Pour atténuer certains de ces risques, Microsoft a ajouté des outils de sécurité à sa plateforme de création d’applications, Azure AI Studio. L’idée est d’aider les entreprises à savoir comment leurs grands modèles de langage (LLM) réagissent aux attaques indirectes par injection d’invites et à vérifier s’ils incluent des informations protégées dans leurs réponses.

Détecter les attaques par injection d’invites

Les attaques par injection indirecte d’invites, également connues sous le nom de XPIA (Indirect Prompt Injection Attacks), ciblent la source de données d’ancrage du LLM. Ces attaques sont de plus en plus populaires auprès des pirates qui cherchent à corrompre la source de données pour transmettre des instructions malveillantes cachées au modèle afin de contourner ses garde-fous de sécurité. L’outil de Microsoft, Azure AI Evaluate, est accessible via l’interface Azure AI Studio ou via le SDK Azure AI Evaluation. Il « sert à simuler des attaques par injection indirecte sur leur modèle ou application d’IA générative et à mesurer la fréquence à laquelle ils ne parviennent pas à détecter et à détourner certaines attaques, par exemple l’intrusion de contenu manipulé ou la collecte d’informations », a écrit Minsoo Thigpen, cheffe de produit senior à la division Azure AI de Microsoft, dans un article de blog.

« Si les développeurs estiment que leurs modèles ne parviennent pas à stopper les attaques indirectes par injection d’invites, ils peuvent soit ajuster les sources de données d’ancrage, soit appliquer d’autres mesures d’atténuation avant de recommencer l’évaluation pour vérifier si leur modèle ou leur application peuvent être déployés en production en toute sécurité », a expliqué Minsoo Thigpen. Une autre fonctionnalité appelée Prompt Shields aide les développeurs à détecter et à bloquer ou atténuer toute attaque provenant d’invites d’utilisateurs. « Elle peut être activée via le service Azure Content Safety AI Service de Microsoft », a-t-elle ajouté. Prompt Shields cherche à bloquer les invites qui peuvent conduire à des résultats d’IA dangereux. Il peut également identifier les attaques de documents lorsque du contenu nuisible est intégré dans des documents fournis par l’utilisateur. L’outil Azure AI Evaluate et le SDK correspondant sont actuellement disponibles en aperçu.

La gestion du contenu protégé

Mais le SDK d’évaluation Azure AI a aussi une autre fonction : il peut tester la fréquence à laquelle les LLM qui sous-tendent les applications génèrent des réponses contenant ce que le fournisseur appelle du « matériel protégé », ou plus exactement du matériel interdit, car la catégorie comprend des textes protégés par le droit d’auteur dont l’entreprise ne détient probablement pas les droits, comme des paroles de chansons, des recettes et des articles. « Pour le vérifier, les résultats du LLM sont comparés à un index de contenus textuels de tiers maintenu sur GitHub », a indiqué la responsable. « Les utilisateurs peuvent regarder l’évaluation en détails afin de mieux comprendre comment leur application répond à ces invites d’utilisateur et les risques associés », ajoute-t-elle. Deux API sont fournies : l’une pour signaler la sortie de textes protégés par le droit d’auteur, et l’autre pour signaler la sortie de code protégé, y compris les bibliothèques logicielles, le code source, les algorithmes et d’autres éléments liés à la programmation. Un aperçu de la fonctionnalité de test est également accessible via l’interface d’Azure AI Studio.

D’autres fonctionnalités mises à jour du SDK Azure AI Evaluation, également en avant-première, comprennent de nouvelles évaluations de la qualité, ainsi qu’un générateur de données synthétiques et un simulateur pour les tâches non contradictoires. Ces évaluations de la qualité, qui seront aussi incluses dans l’interface Azure AI Studio en octobre, sont basées sur des mesures mathématiques populaires qui devraient aider les développeurs à vérifier si un LLM génère des résultats textuels qui respectent la qualité. « Ces mesures, à savoir ROUGE (Recall-Oriented Understudy for Gisting Evaluation), BLEU (Bilingual Evaluation Understudy), GLEU (Google-BLEU) et METEOR (Metric for Evaluation of Translation with Explicit Ordering) vérifient la précision, le rappel et l’exactitude grammaticale », a rappelé Minsoo Thigpen. Le générateur de données synthétiques et le simulateur de tâches non contradictoires devraient aider les développeurs à vérifier si leur LLM répond aux normes souhaitées quand l’utilisateur envoie une invite spécifique.

AWS propose des fonctionnalités supplémentaires dans son offre Bedrock pour l’IA. Elle comprend maintenant de l’ancrage contextuel, des connecteurs pour le RAG et des LLM supplémentaires. Le fournisseur propose par ailleurs une App Studio pour créer rapidement des applications de GenAI.

Progressivement, la plateforme de développement d’application d’IA d’AWS s’étoffe. En effet, le fournisseur de cloud enrichit Bedrock avec plusieurs fonctionnalités. Parmi elles, il y a l’ancrage contextuel ou contextual grouding intégré à Guardrails (fonction de protection et de sécurité) « pour atténuer les risques de réponses injustifiées ou hallucinatoires de la part d’une application basée sur un LLM », indique Vasi Philomin, vice-président de l’IA générative chez Amazon. Il ajoute que cette fonction, « utilise les méthodes RAG et de résumé pour détecter les hallucinations dans les réponses du modèle, vérifie si la réponse LLM est basée sur les bonnes données de l’entreprise et qu’elle est bien alignée sur la requête ou l’instruction de l’utilisateur ».

Guardrails en mode autonome

D’autres grands fournisseurs de services cloud comme Google et Microsoft Azure, ont aussi mis en place un système pour évaluer la fiabilité des procédés RAG, comme la cartographie des métriques de génération de réponses. Alors que Microsoft utilise l’API Groundedness Detection pour vérifier si les réponses textuelles des LLM sont fondées sur les documents sources fournis par les utilisateurs, Google a récemment mis à jour les options d’ancrage de Vertex AI en le dotant notamment de fonctionnalités de récupération dynamique et d’un mode haute-fidélité. AWS propose aussi des fonctions d’évaluation et d’observabilité RAG dans Bedrock pouvant mesurer la fidélité, la pertinence de la réponse et la similarité sémantique de la réponse pour apprécier la qualité de la réponse à une requête.

AWS proposera Guardrails pour Amazon Bedrock en tant qu’API distincte utilisable avec les LLM hors de Bedrock. « Suite aux nombreuses demandes d’entreprises clientes qui souhaitent utiliser l’API Guardrails sur des modèles en dehors de Bedrock, celle-ci est disponible de manière autonome », a déclaré Vasi Philomin. La décision d’AWS rappelle la stratégie d’IBM qui, depuis mai dernier, a rendu son produit watsonx.governance accessible via une boîte à outils. Même si cette dernière n’est pas exactement comparable à l’API Guardrails, elle peut servir à créer un référentiel pour les détails de journalisation tout au long du cycle de vie d’un modèle. Ces informations peuvent s’avérer utiles pour évaluer la validité du choix d’un modèle ou pour déterminer quelle partie prenante a été impliquée dans le cycle de vie du modèle.

Plus de connecteurs RAG et de LLM

Les autres mises à jour du service d’IA générative concernent l’ajout de connecteurs RAG à Bedrock pour étendre les possibilités d’ancrage des modèles dans une plus grande variété de sources de données. « En plus d’Amazon S3, les développeurs peuvent désormais utiliser des connecteurs pour Salesforce, Confluence et SharePoint pour RAG », a constaté Vasi Philomin, en précisant que le connecteur SharePoint était actuellement en avant-première. AWS a également annoncé qu’il était à présent possible d’affiner Claude 3 Haiku d’Anthropic à l’intérieur de Bedrock. « À ce jour, cette option, aussi en avant-première, n’est disponible chez aucun autre fournisseur de services cloud et elle est très recherchée par les entreprises clientes », a fait valoir le dirigeant.

D’autres mises à jour incluent la disponibilité générale de la recherche vectorielle pour Amazon MemoryDB et des capacités supplémentaires pour Agents for Bedrock. « Dorénavant, les agents peuvent conserver la mémoire à travers de multiples interactions pour se souvenir de l’endroit où s’est arrêté l’utilisateur la dernière fois et fournir de meilleures recommandations basées sur les interactions précédentes », a expliqué Vasi Philomin, ajoutant que les agents pouvait désormais interpréter le code pour s’attaquer à des cas d’usage complexes axés sur les données, comme l’analyse et la visualisation de données, le traitement de texte, la résolution d’équations et les problèmes d’optimisation.

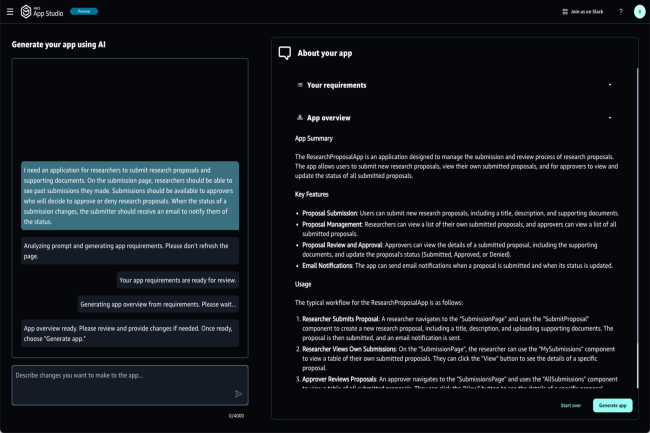

App Studio crée des applications de GenAI d’un simple prompt

AWS a aussi présenté le service managé App Studio basé sur l’IA générative qui propose aux utilisateurs de créer et de déployer des applications à l’aide d’invites en langage naturel. « Avec App Studio, un utilisateur décrit simplement l’application qu’il veut, ce qu’il veut qu’elle fasse, et les sources de données avec lesquelles il veut s’intégrer, et App Studio construit une application en quelques minutes, alors qu’il aurait fallu plusieurs jours à un développeur professionnel pour créer une application similaire à partir de zéro », a déclaré AWS dans un communiqué. « Avec l’assistant d’IA générative d’App Studio, il n’est plus nécessaire d’apprendre à utiliser les outils low-code », a encore affirmé l’entreprise. Amazon App Studio pourrait rivaliser avec des offres concurrentes comme Vertex AI Studio de Google et Copilot Studio de Microsoft.

AWS a aussi annoncé la disponibilité générale de Q Apps, une fonctionnalité de Q Business présentée lors de la conférence AWS re:Invent 2023. « Avec Q Apps, les entreprises peuvent passer en quelques secondes d’une conversation à une application générative alimentée par l’IA et basée sur les données de leur entreprise. Les utilisateurs décrivent simplement l’application qu’ils souhaitent dans une invite et Q la génère instantanément », a rappelé AWS. Le fournisseur a aussi indiqué que Q proposerait aux utilisateurs de générer une application à partir d’une conversation existante.

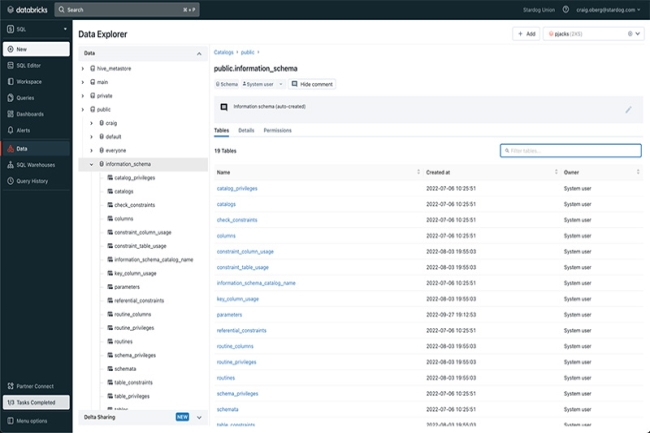

Databricks passe son catalogue de données Unity sous licence open source Apache 2.0. Une décision qui intervient quelques jours après la présentation par Snowflake d’une offre similaire baptisée Polaris.

La concurrence est forte dans le domaine des catalogues de données, un enjeu essentiel à l’heure de l’IA très consommatrice de data. Et dans cette bataille, deux acteurs se démarquent Databricks et Snowflake. Ce dernier a, il y a quelques jours, dévoilé son offre open source Polaris. Databricks vient de réagir en annonçant lui aussi l’ouverture de son catalogue Unity. Disponible depuis juin 2022 et actualisé avec les capacités d’Okera, il était jusqu’à maintenant accessible en mode fermé en comprenant un contrôle d’accès centralisé, un audit, un lignage et des capacités de découverte de données à travers les espaces de travail de Databricks.

Petite différence entre les deux frères ennemis, Snowflake proposera son catalogue en open source seulement dans 3 mois, alors que l’ouverture d’Unity est disponible dès à présent. « En ouvrant le code d’Unity avant Polaris, Databricks veut se positionner comme premier fournisseur à ouvrir son catalogue de données », observe Hyoun Park, analyste en chef chez Amalgam Insights.

Une ouverture pour éviter le verrouillage

Le catalogue Unity est donc accessible en open source sous licence Apache 2.0, ainsi que toutes ses API. Introduite par l’Apache Software Foundation en 2004, cette licence accorde aux utilisateurs de modifier et de distribuer du code gratuitement. Une fois ouvert, le catalogue fournira aux utilisateurs une interface universelle qui prend en charge les données dans n’importe quel format et environnement de calcul. « Il sera notamment possible de lire des tableaux avec les clients Delta Lake, Apache Iceberg et Apache Hudi via Delta Lake UniForm », a déclaré Databricks. « La version open source prend également en charge le catalogue REST d’Iceberg et les normes d’interface Hive Metastore (HMS) », a ajouté le fournisseur. En outre, Unity Catalog continuera à fournir une gouvernance unifiée pour les actifs d’IA, tels que les modèles d’apprentissage machine (ML) et les outils d’IA générative.

Selon Stewart Bond, vice-président de la recherche d’IDC, l’ouverture des API donne un accès ouvert aux informations sur les données conservées dans l’environnement Databricks. « C’est un moyen de soutenir significativement l’unification des données afin que les consommateurs de données, les ingénieurs et les dirigeants n’aient pas besoin d’utiliser plusieurs outils pour découvrir, gérer et gouverner toutes les données dans une entreprise », a expliqué le consultant. Selon Steven Dickens, responsable des pratiques de clouds hybrides chez The Futurum Group, « cette approche unifiée évite tout verrouillage des fournisseurs et laisse les entreprises choisir les meilleurs outils et plateformes pour leurs besoins tout en assurant une gouvernance et une sécurité cohérentes dans l’ensemble de leur patrimoine de données ».

Un mouvement d’entraînement

L’ouverture du catalogue Unity, qui fait suite à la décision de Snowflake de livrer son catalogue Polaris dans les trois mois, est considérée par les analystes comme une course à l’ouverture et à la conquête des utilisateurs. Selon M. Dickens de Futurum, cette ouverture représente un défi de taille pour des concurrents comme Snowflake, Teradata et Dremio. « L’accent mis sur l’interopérabilité et l’engagement open source permet à Databricks de répondre à un plus large éventail de besoins des clients, en réduisant les frictions liées à la compatibilité des formats de données », a-t-il déclaré. « Teradata et Dremio, bien que forts dans leurs niches respectives, n’ont pas démontré le même niveau d’intégration et d’outils complets pour la gouvernance des données et de l’IA », a ajouté l’analyste.

Cependant, Stewart Bond d’IDC fait remarquer que le succès du catalogue Unity, désormais ouvert, dépendra de la quantité de métadonnées sur les données stockées dans les plateformes concurrentes qui seront mises à la disposition des processus externes. « Unity est encore un catalogue très technique. Le fait de le rendre open source peut accélérer les innovations en matière d’expérience utilisateur au niveau de l’entreprise et rendre Unity plus compétitif », a estimé le consultant.

A l’occasion de son évènement .Next, Google Cloud a présenté plusieurs évolution au sein de son architecture Distributed Cloud. Recherche à base d’IA, sandbox, intégration d’Apigee et serveur orienté IA sont au programme.

L’IA était au cœur de la conférence .Next de Google et ce sujet a infusé les différentes annonces de la société. Même l’environnement Google Distributed Cloud (GDC) a évolué en conséquence. Pour rappel, cette offre s’adresse essentiellement aux clients qui ont des besoins spécifiques en matière de souveraineté des données, de latence ou de traitement local des données. Commercialisée en mars 2023, « elle comprend le matériel, les logiciels, le plan de contrôle local et les outils nécessaires pour déployer, exploiter, mettre à l’échelle et sécuriser un cloud géré complet », expliquait alors la firme.

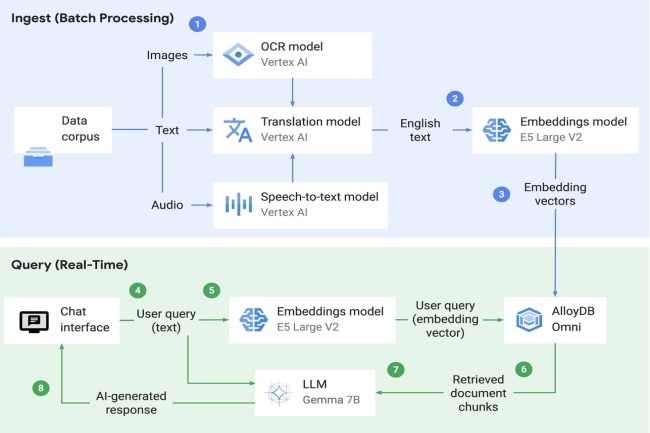

Recherche à base d’IA et sandbox

Lors de l’évènement, Google Cloud a présenté plusieurs fonctionnalités au sein de GDC dont une fonction de recherche alimentée par l’IA pour récupérer et analyser des données sur site ou en edge. Sous le capot, la recherche IA utilise le modèle Gemma 7B, Vertex AI pour le service LLM, et une API pré-entraînée (speech-to-text, traduction et reconnaissance optique de caractères) pour l’ingestion de données. « Elle prend également en charge l’extension AlloyDB Omni pgvector pour les entreprises qui déploient une base de données vectorielle au sein de GDC », a indiqué le fournisseur. La recherche IA sera disponible en avant-première au cours du deuxième trimestre de cette année.

Parmi les autres mises à jour de Distributed Cloud, on peut citer un environnement sandbox. « Le bac à sable ajouté à Google Distributed Cloud offre une expérience managée qui peut aider les développeurs d’applications à créer et à tester des services conçus pour GDC dans un environnement Google Cloud, sans avoir à naviguer dans l’isolation (air gap) et le matériel physique », a expliqué le fournisseur, ajoutant que les développeurs pouvaient utiliser les services GDC, y compris les machines virtuelles, les conteneurs, les bases de données et Vertex AI. Google a également rendu le stockage de Distributed Cloud plus flexible, de sorte que les entreprises pourront augmenter leur stockage indépendamment du calcul. « Elles pourront ainsi mieux supporter les grosses charges de travail analytiques et d’IA », a déclaré l’entreprise, en précisant qu’il y avait aussi des options pour le stockage de blocs, de fichiers et d’objets.

Une infrastructure orientée IA et intégration d’Apigee

Par ailleurs, Distributed Cloud aura désormais accès à des racks spécialement optimisés pour l’IA et les charges de travail de calcul général. « Ces infrastructures offrent plus de flexibilité dans le choix de nœuds optimisés pour le réseau ou le stockage dans le cadre d’un déploiement », a indiqué le fournisseur. De plus, grâce au partenariat entre Google et Nvidia, les entreprises pourront accéder à un nouveau serveur pour Google Distributed Cloud équipé d’un accélérateur GPU Nvidia L4 Tensor Core économe en énergie. « Il est possible de déployer un seul serveur en tant qu’appliance autonome pour les cas d’usage où la haute disponibilité n’est pas nécessaire. Cette offre vient s’ajouter à nos serveurs optimisés pour l’IA avec des GPU Nvidia H100 Tensor Core pour accélérer l’innovation en matière d’IA sur site », a précisé l’entreprise dans un communiqué.

Pour ce qui est de la capacité de résilience, les améliorations concernent le mode déconnecté avec un support de 7 jours, une suite de fonctionnalités de gestion hors ligne pour aider à assurer que les déploiements, les charges de travail sont accessibles en état de fonctionnement pendant qu’ils sont déconnectés. Enfin, Google prendra en charge Apigee, son offre de gestion des API, sur Distributed Cloud.

- 1

- 2