Un générateur de requêtes a été ajouté par Google à Log Analytics pour créer rapidement des demandes SQL complexes afin de surveiller et de régler des problèmes de workloads cloud. Une initiative qui permet au fournisseur de rester dans la course face à Microsoft Azure Monitor Logs et AWS CloudWatch Logs mais aussi les spécialistes en observabilité cloud comme Datadog, New Relic et Sumo Logic.

Les entreprises s’appuient souvent sur des indicateurs sur l’état de santé de leurs charges de travail dans le cloud, leur niveau de sécurité ou encore leurs coûts. Pour répondre à ces besoins, Google propose Log Analytics, un outil qui fait partie de son service Cloud Logging donnant accès à ce type d’informations en utilisant SQL comme langage de requête. Cependant, l’écriture de code SQL complexe nécessaire pour générer ces données peut s’avérer fastidieux et chronophage et la plupart des équipes spécialisées en maintenance et optimisation système et de sécurité n’en seraient pas satisfaits selon des analystes.

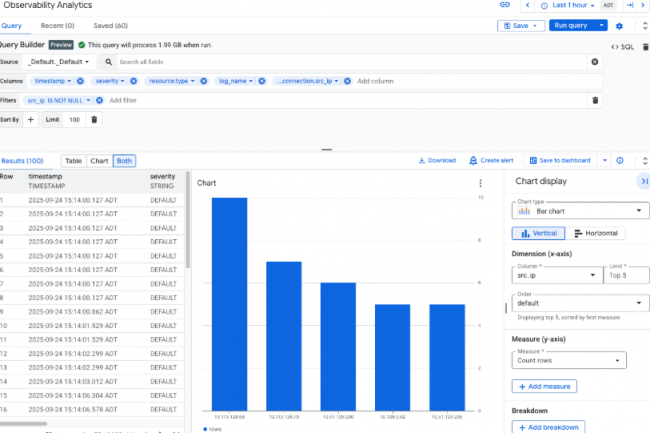

Le fournisseur apporte une solution en dotant Log Analytics d’un query builder. « Le générateur de requêtes résout un important goulot d’étranglement SQL en transformant l’analyse des journaux, qui était une tâche fastidieuse, en une fonctionnalité en temps réel et self-service qui convient aux développeurs, équipes DevOps et ingénieurs spécialisés en maintenance et optimisation système. Cela permet un gain de temps considérable, réduisant la durée des investigations habituelles de plusieurs heures à quelques minutes », explique Bradley Shimmin, responsable des données, de l’analyse et de l’infrastructure chez The Futurum Group. Stephanie Walter, responsable de l’activité IA chez HyperFrame Research, appuie les propos de M. Shimmin en soulignant que le générateur de requêtes résume la complexité du langage SQL dans une interface visuelle intuitive afin d’améliorer la productivité et de réduire les erreurs, devrait être un soulagement pour les opérateurs qui se noient dans la syntaxe SQL. « Pour le triage quotidien, un générateur visuel qui émet des requêtes valides améliore véritablement la qualité de vie et réduit les erreurs de copier-coller », explique Mme Walter.

Les opérations d’agrégation pas prises en charge

Parmi les principales fonctionnalités de ce query builder, citons la possibilité d’effectuer des recherches dans tous les champs à l’aide d’une seule chaîne ou d’un seul message d’erreur, la prévisualisation du schéma de journalisation avec des clés et des valeurs JSON déduites, des suggestions de valeurs intelligentes pour les champs et les filtres, la gestion automatique des JSON, la prévisualisation SQL en temps réel, ainsi que la visualisation et l’enregistrement du tableau de bord en un seul clic.

Dans sa documentation, Google recommande d’utiliser le nouveau générateur de requêtes pour générer des tendances et des informations sur les charges de travail dans le cloud. L’outil est désormais disponible pour tous. Pour le dépannage, Google recommande d’utiliser Logs Explorer, une autre interface accessible via Google Cloud Console, qui utilise un langage de requête distinct. Toutefois, il avertit que Logs Explorer ne prend pas en charge les opérations d’agrégation, telles que le comptage du nombre d’entrées de journaux contenant un motif spécifique, et que les requêtes similaires doivent être effectuées via Log Analytics. Google a déclaré qu’il ne facturerait pas les requêtes visant à analyser les journaux. Toutefois, le transfert ou le routage des journaux vers un autre service Google, tel que BigQuery, à des fins d’analyse ou de stockage supplémentaires, entraînera des frais.

Combler l’écart avec ses concurrents

Les fournisseurs de services cloud concurrents, tels que Microsoft et AWS, proposent également un moyen d’analyser les journaux des charges de travail cloud via Azure Monitor Logs et AWS CloudWatch Logs, et les analystes affirment que Google est en train de rattraper son retard en matière de générateur de requêtes. « Azure Monitor dispose d’un mode visuel pour composer KQL, le langage utilisé par Microsoft pour interroger les journaux. AWS CloudWatch Logs propose également une approche basée sur un éditeur avec des outils de visualisation. L’ajout de Google apporte une interface utilisateur comparable », poursuit Mme Walter. Selon cette analyste Google rattrape son retard en matière de convivialité par rapport aux fournisseurs d’observabilité cloud établis depuis des années.

« Datadog, New Relic et Sumo Logic proposent depuis longtemps des générateurs intuitifs et des expériences de requête guidées. La récente fonctionnalité de Google ne les dépasse pas. Elle comble un écart », a-t-il déclaré. Cependant, Mme Walter souligné que les entreprises ayant déjà investi dans la pile de données de Google trouveront l’intégration du générateur de requêtes utile. De son côté, M. Shimmin estime que Google est susceptible d’intégrer le générateur de requêtes aux capacités de Gemini en matière de conversion du langage naturel en SQL, ce qui sera utile pour les utilisateurs.

L’observabilité de l’IA agentique en point de mire

Selon les analystes, des outils tels que le générateur de requêtes dans Log Analytics deviendront bientôt indispensables pour les entreprises, car les charges de travail liées à l’IA, en particulier l’IA agentielle, continuent de croître.

Microsoft et AWS proposent déjà des assistants basés sur l’IA générative, tels que Q et Copilot, pour leurs offres individuelles, afin de permettre aux utilisateurs non techniques ou semi-techniques d’utiliser plus facilement le langage naturel pour générer des informations à partir des journaux. « Les charges de travail liées à l’IA agentique sont des boîtes noires qui génèrent des données de journaux massives et multidimensionnelles, et les équipes d’IA qui les développent ne sont souvent pas des experts en SQL, mais elles sont désormais tenues de dépanner leurs propres systèmes », a déclaré M. Shimmin, soulignant l’importance de disposer d’un outil d’analyse de journaux simplifié.

En mettant la main sur la plateforme d’observabilité de TruEra, Snowflake fournir à ses clients des capacités d’évaluation et de contrôle pour les applications basées sur les LLM et les modèles d’apprentissage automatique.

Spécialisée dans les entrepôts de données basés sur le cloud (data store), Snowflake, a racheté l’un des principaux actifs de la start-up TruEra. Basée à Redwood, celle-ci est spécialisée dans le suivi et la gestion du cycle de vie des applications et services basés sur l’apprentissage automatique et les grands modèles de langage (LLM). Le montant de l’opération n’a pas été précisé. “Snowflake acquiert la plateforme d’observabilité TruEra AI, qui fournit des capacités de pointe pour évaluer et surveiller les applications LLM et les modèles d’apprentissage automatique en production”, a déclaré l’éditeur dans un communiqué. La plateforme d’observabilité de l’IA de TruEra est une offre managée qui peut être déployée en SaaS aussi bien sur un cloud privé, public ou hybride. A noter que TruEra propose également une offre self-service, baptisée TruLens, qui ne ferait pas partie de l’accord signé avec Snowflake.

Parmi les fonctions clés de la plateforme d’observabilité de TruEra, figurent l’explicabilité, l’analyse de la qualité, et la gouvernance des modèles, les workflows d’exécution mais aussi les comparaisons et la sélection des modèles ainsi que la surveillance continue de signalement des incidents. Selon Snowflake, ces offres permettent d’évaluer la qualité des entrées, des sorties et des résultats intermédiaires des applications basées sur les LLM, y compris l’hallucination, le biais ou la toxicité. Un dernier domaine sur lequel se positionne aussi la start-up Patronus AI qui vient d’ailleurs de lever 17 M$. “Cela accélère l’évaluation des expériences pour une grande variété de cas d’utilisation, y compris la réponse aux questions, le résumé, les applications basées sur la génération augmentée par la recherche (RAG apps) et les applications basées sur les agents”, poursuit l’éditeur. En outre, la plateforme a également la capacité de fournir des informations détaillées et exploitables pour améliorer la performance et la précision des modèles d’apprentissage automatique en révélant les anomalies dans les métriques du modèle et en fournissant une analyse spécifique de la cause première pour un débogage rapide.

Lutter contre Amazon Bedrock, Google Vertex AI et Microsoft Azure AI

Alors que Snowflake affirme que l’acquisition de Observability Platform viendra s’ajouter aux fonctionnalités existantes de gouvernance de l’IA au sein de son offre AI Data Cloud, cette décision pourrait être considérée comme un effort de l’éditeur pour aligner ses capacités sur celles d’AWS Bedrock, de Google Vertex AI et de Microsoft Azure AI. Car leur point commun est en effet d’apporter des capacités d’évaluation, de gestion du cycle de vie et de surveillance des LLM. Snowflake a commencé à s’orienter vers la GenAI l’année dernière en présentant Snowpark Container Services en juin 2023, puis Cortex en novembre 2023.

Snowpark Container Services, conçu pour supporter des charges de travail plus diverses dont des LLM, à la Data Cloud Platform, agit comme un pivot connectant les données d’entreprise stockées dans Snowflake avec de nombreuses sources. A savoir des LLM, des interfaces d’entraînement de modèle, des frameworks de gouvernance de modèle, des applications tierces d’augmentation des données, des modèles d’apprentissage automatique, des API sans compter le framework applicatif natif de Snowflake. D’autre part, Cortex est un service entièrement serverless et managé au sein du Data Cloud qui fournit aux entreprises les éléments de base pour utiliser les LLM et l’IA sans nécessiter d’expertise dans la gestion d’une infrastructure complexe basée sur les GPU. En début d’année, la firme de San Mateo a présenté en avant-première son grand modèle de langage open source Arctic pour affronter les modèles Llama 3 de Meta, la famille de modèles Mistral, Grok-1 de xAI et DBRX de Databricks. Arctic, accessible via Cortex, est destiné aux tâches d’entreprise telles que la génération SQL, la génération de code et le suivi des instructions.

Les trois co-fondateurs de TruEra rejoignent Snowflake

Suite à la transaction avec TruEra, au moins 37 de ses employés vont rejoindre Snowflake, y compris ses trois cofondateurs : son président et directeur scientifique Anupam Datta, son CTO Shayak Sen, et son CEO Will Uppington. TruEra, qui a levé environ 43 M$ depuis sa création, est soutenue notamment par Menlo Ventures, Greylock Partners, Wing Venture Captial, Harpoon Ventures, HPE et Conversion Captial. La jeune pousse a démarré ses activités après six années de recherche pendant qu’Anupam Datt et Shayak étaient à l’université Carnegie Mellon. L’entreprise possède quatre bureaux en Inde, à Singapour, au Royaume-Uni et aux États-Unis. Ce rachat a été effectué quelques jours après l’annonce de l’échec du rachat de Reka AI par Snowflake en vue d’intégrer davantage de LLM dans ses services et ses offres. Selon Bloomberg, le spécialiste du data store avait proposé environ 1 Md$ pour cette acquisition. Les deux sociétés avaient pourtant un atome crochu, car Snowflake Ventures était aussi investisseur dans cette start-up fondée par des chercheurs de Meta et de Google.