Dans une lettre ouverte signée par les membres de Digital Europe, le groupe avertit qu’une réglementation excessive de l’industrie de l’IA pourrait avoir un impact négatif sur la capacité de l’UE à devenir un leader mondial dans ce domaine.

Digital Europe, un groupe de lobbying représentant les industries IT à travers le continent, a publié une déclaration commune avant les dernières semaines de négociation de la réglementation européenne sur l’IA, avertissant qu’une réglementation excessive pourrait paralyser l’innovation et pousser les start-ups à quitter le continent. L’argument principal du groupe est que l’IA Act va au-delà de son champ d’application initial et devrait plutôt se concentrer sur les cas d’utilisation à haut risque, plutôt que de viser des technologies spécifiques. Digital Europe a également prévenu que la charge financière que la loi pourrait imposer aux entreprises souhaitant mettre sur le marché des produits basés sur l’IA pourrait rendre l’exploitation en dehors de l’UE non viable pour les petites entreprises.

« Pour que l’Europe devienne une puissance numérique mondiale, nous avons besoin d’entreprises capables de mener l’innovation en matière d’IA en utilisant également des modèles de fondation et le GPAI (General-purpose AI) », peut-on lire dans la déclaration. « En tant que représentants de l’industrie numérique européenne, nous voyons une énorme opportunité dans les modèles de base, et de nouveaux acteurs innovants émergent dans cet espace, dont beaucoup sont nés ici en Europe. Ne les obligeons pas à disparaître avant qu’ils n’aient eu la chance de se développer, ou ne les forçons pas à partir ». La lettre a été signée par 32 membres de Digital Europe (incuant Michel Combot, délégué général de Numeum) et présente quatre recommandations qui, selon les signataires, permettraient à la loi de trouver l’équilibre nécessaire entre la réglementation et l’innovation.

Il s’agit notamment de veiller à ce que l’approche fondée sur le risque reste au cœur du règlement sur l’IA, de mieux aligner le cadre sur la législation existante en matière de sécurité des produits et d’ignorer les demandes visant à ce que la réglementation s’attaque aux questions de droit d’auteur. « Le cadre global de protection et d’application des droits d’auteur de l’UE contient déjà des dispositions qui peuvent aider à résoudre les problèmes de droits d’auteur liés à l’IA, tels que l’exemption pour l’exploration de texte et de données et l’exemption correspondante », peut-on lire dans la déclaration.

Des craintes de surrèglementation ont déjà été exprimées par le passé

Ce n’est pas la première fois que l’AI Act européen fait l’objet de critiques de la part de dirigeants de l’industrie qui s’inquiètent de la portée de la législation et de son potentiel à surréglementer l’industrie. En juin dernier, 163 cadres éminents représentant certaines des plus grandes entreprises technologiques et commerciales d’Europe, dont Airbus, ARM, Capgemini, Schneider Electric et Siemens, ont signé une lettre ouverte exhortant l’UE à adopter une approche plus souple en matière de réglementation de l’IA, craignant que le projet de loi sur l’IA ne rende le continent moins compétitif dans ce domaine en plein essor. « Vouloir ancrer la réglementation de l’IA générative dans la loi et procéder à une logique de conformité rigide est une approche aussi bureaucratique qu’inefficace pour remplir son objectif », indique la lettre. « Dans un contexte où nous en savons très peu sur les risques réels, le modèle commercial ou les applications de l’IA générative, le droit européen devrait se limiter à énoncer de grands principes dans le cadre d’une approche fondée sur les risques ». Bien que la loi sur l’IA ait été approuvée par le Parlement européen en juin, elle doit être ratifiée par chaque pays de l’UE avant d’avoir force de loi.

Si les pays s’accordent largement sur les exigences en matière d’étiquetage et sur les mesures de protection contre les contenus générés par l’IA, les propositions d’interdiction de la surveillance biométrique dans les lieux publics et des systèmes dits de “notation sociale”, qui classent les personnes en fonction de leur comportement social, de leur statut socio-économique et de leurs caractéristiques personnelles, ont suscité des réactions négatives. Lorsque la loi sur l’IA sera finalement adoptée, le non-respect de ses dispositions entraînera des sanctions pouvant aller jusqu’à 21,8 millions de dollars (20 millions d’euros) ou 4 % du chiffre d’affaires mondial.

La firme de Redmond cherche à améliorer l’engagement et la productivité des employés. Elle mise donc beaucoup sur son offre AI Copilot qu’elle intègre dès à présent à ses deux plateformes Viva et Glint.

Un mois après avoir dévoilé Microsoft 365 Copilot, la firme de Redmond a annoncé aujourd’hui Copilot pour Microsoft Viva, aidant les utilisateurs à tirer parti de l’IA de nouvelle génération pour stimuler la productivité et améliorer les résultats de l’entreprise. Microsoft 365 Copilot est une technologie d’IA générative basée sur GPT-4, un modèle de langage créé par OpenAI et qui constitue la base du célèbre chatbot ChatGPT. Le mois dernier, la firme a donc annoncé un chatbot Copilot pour automatiser diverses tâches dans plusieurs applications Microsoft Office, comme le résumé des principaux points de discussion dans une discussion Teams ou l’ajout de contenu pertinent à une présentation PowerPoint sur la base de documents précédemment créés par un utilisateur.

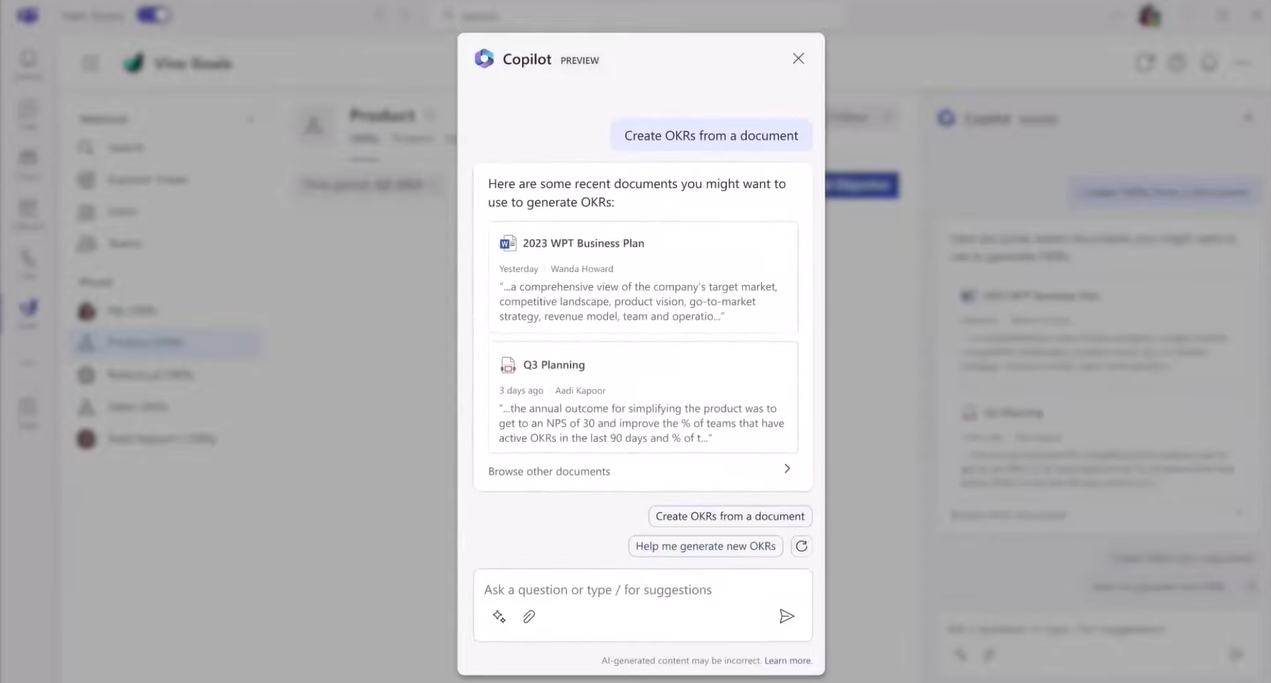

Microsoft Viva est une plateforme d’expérience employé lancée par Microsoft en février 2021, qui fournit une « passerelle » numérique aux employés afin qu’ils accèdent à des informations pertinentes, à l’apprentissage, à l’analyse et à la connaissance au sein de leur organisation. Copilot in Viva s’appuie sur le système Copilot de Microsoft 365 et combine la puissance de grands modèles linguistiques avec les données des applications Microsoft Graph et Viva, notamment Goals, Engage, Learning, Topics et Answers. Cette intégration dans Viva Goals contribuera à simplifier à la fois la définition et la gestion des objectifs, en suggérant des projets d’objectifs et de résultats clés (OKR) basés sur des documents Word existants, tels que des business plans annuels ou des documents de stratégie produit. Une fois créés, Copilot résume l’état des OKR, identifie les obstacles et suggère les prochaines étapes.

En quelques clics, Copilot peut créer des OKR à partir d’un document, comme ici un business plan pour 2023 ou un planning pour le troisième trimestre. (Crédit : Microsoft)

Copilot analyse l’engagement et évalue le sentiment

Dans Viva Engage, les dirigeants pourront envoyer des messages à Copilot, à partir desquels la technologie pourra créer des messages. Copilot sera également en mesure de proposer des suggestions pour aider à personnaliser les messages, y compris la possibilité d’ajuster le ton et la longueur ou d’inclure des images pertinentes, en plus d’analyser les mesures d’engagement, d’évaluer le sentiment et de recommander des réponses.

Copilot in Viva Learning peut suggérer des collections d’apprentissage adaptées à des rôles spécifiques ou à des besoins de formation, tandis qu’avec Copilot in Viva Topics, les employés peuvent utiliser le langage naturel pour en savoir plus sur des sujets importants et voir les questions et les projets connexes.

Enfin, Copilot in Answers aide les utilisateurs à construire des questions spécifiques tout en extrayant les sujets clés pour aider à les catégoriser et à faire apparaître les références, les ressources et les experts appropriés qui peuvent être cités dans la réponse. Microsoft a déclaré que Copilot dans Viva commencera à être déployé chez les clients dans le courant de l’année.

Introduction de Glint dans la suite de produits Viva

Outre Copilot dans Viva, Microsoft a également annoncé que Viva Glint rejoindrait officiellement la suite Viva de l’entreprise en juillet. Glint, une ancienne filiale de LinkedIn, se décrit comme une plateforme de réussite humaine qui utilise l’IA pour fournir aux entreprises une meilleure compréhension de leur santé organisationnelle globale et pour mettre en évidence les risques, les opportunités et les recommandations en temps réel. Copilot sera également intégré à Glint à une date ultérieure non précisée. La firme de Redmond a affirmé que l’outil sera capable de résumer et d’analyser des milliers de commentaires d’employés, ce qui permettra aux dirigeants d’explorer plus facilement les commentaires et de poser des questions par le biais de l’IA en langage naturel.

Des outils comme Copilot et Viva ont le potentiel de transformer complètement la façon dont le travail est effectué, a déclaré Jared Spataro, vice-président des applications de travail moderne et d’entreprise chez Microsoft, lors du Microsoft Viva Summit jeudi. « Nous reconnaissons que nous avons la responsabilité de fournir cette technologie de la bonne manière et la sécurité, la conformité et l’IA responsable ne sont pas une réflexion après coup, elles sont une partie fondamentale du système Copilot », a-t-il déclaré, ajoutant que chaque fonctionnalité de Copilot a passé des contrôles de confidentialité, a été testée par des experts et est surveillée en temps réel. M. Spataro a également précisé que les grands modèles linguistiques de Copilot ne sont jamais formés sur les données d’une entreprise. « Copilot ne sera pas toujours parfait, mais nous avons mis en place des mesures d’atténuation pour remédier rapidement et efficacement aux inexactitudes, aux préjugés et aux abus en intégrant Copilot à Viva », conclut-il.

Cisco va proposer une version de Webex pour les activités liées à la sécurité et à la défense. Le futur système fournira une couche supplémentaire de sécurité du réseau et du traitement des données pour ces entreprises.

S’appuyant sur sa gamme de produits Webex, Cisco prévoit d’offrir un système de collaboration dans le cloud en mode “isolé” (air gap) aux entreprises travaillant dans le domaine de la sécurité nationale et de la Défense aux États-Unis. L’équipementier élargit ainsi les offres sécurisées qu’il propose déjà aux industries soumises aux exigences de sécurité du gouvernement américain.

À partir de 2024, ce système Webex – Air-Gapped Trusted Cloud – offrira une couche de sécurité supplémentaire aux équipes qui collaborent par l’intermédiaire de l’outil de visioconférence, a déclaré Cisco. La partie “air gap” se comprend comme une mesure de sécurité qui consiste à isoler un ordinateur ou un réseau et à l’empêcher d’établir une connexion externe. Par exemple, un ordinateur isolé ne peut pas se connecter à l’internet public ou à d’autres réseaux de communication afin de garantir une sécurité totale des informations qu’il contient.

Répondre aux normes de sécurité les plus exigeantes

Jusqu’à présent, le gouvernement américain évalue la sécurité pour autoriser des produits et services cloud à ce domaine sensible. Il s’agit notamment de déploiements de cloud spécifiques, qui sont isolés des réseaux publics et exploités sur le sol américain par du personnel local disposant d’habilitations de sécurité pour traiter des données sensibles.

Avec le système à venir, Cisco affirme que les futurs outils Webex répondront aux normes de sécurité exigées par les agences américaines impliquées dans la sécurité et la défense nationales, sans compromettre l’expérience des utilisateurs. « Nous avons ajouté à notre solution de collaboration Webex des contrôles de sécurité et des capacités opérationnelles supplémentaires exigés par le gouvernement afin qu’elle puisse être déployée dans un environnement déconnecté de l’Internet public », a déclaré Jeetu Patel, vice-président exécutif et directeur général de la sécurité et de la collaboration chez Cisco. « Cette approche nous permet d’offrir une expérience moderne à la communauté de la sécurité nationale et de la défense ».

Être en accord avec les standards de FedRAMP

En outre, Cisco a réaffirmé son engagement à fournir des solutions sur site pour la collaboration de niveau secret défense- y compris les appels, la messagerie, les réunions et le partage de fichiers – en alignant sa sécurité de niveau entreprise sur les exigences définies par FedRAMP, le Federal Risk and Authorization Management Program, qui fournit une approche standardisée des autorisations de sécurité pour les offres de services dans le cloud. L’entreprise a également déclaré que tous les systèmes de collaboration entièrement conformes pour le gouvernement prendront en compte les réglementations locales, les exigences de conformité et les contrôles de sécurité pour les communautés gouvernementales individuelles.

Ce produit est conçu spécifiquement pour les entreprises travaillant sur des projets de sécurité nationale et de défense et ne sera donc pas disponible pour les clients en dehors de ce secteur, a déclaré Jeetu Patel, ajoutant que les prestataires du secteur de la défense peuvent choisir de l’utiliser lorsqu’ils travaillent sur des contrats gouvernementaux qui exigent le niveau de sécurité fourni par le produit. « Bien que cette annonce soit spécifique à la sécurité nationale et à la défense, nous continuerons à innover en développant des solutions de collaboration personnalisées et entièrement conformes à toutes les activités du gouvernement », peut-on lire dans un billet de blog.

Cisco va proposer une version de Webex pour les activités liées à la sécurité et à la défense. Le futur système fournira une couche supplémentaire de sécurité du réseau et du traitement des données pour ces entreprises.

S’appuyant sur sa gamme de produits Webex, Cisco prévoit d’offrir un système de collaboration dans le cloud en mode “isolé” (air gap) aux entreprises travaillant dans le domaine de la sécurité nationale et de la Défense aux États-Unis. L’équipementier élargit ainsi les offres sécurisées qu’il propose déjà aux industries soumises aux exigences de sécurité du gouvernement américain.

À partir de 2024, ce système Webex – Air-Gapped Trusted Cloud – offrira une couche de sécurité supplémentaire aux équipes qui collaborent par l’intermédiaire de l’outil de visioconférence, a déclaré Cisco. La partie “air gap” se comprend comme une mesure de sécurité qui consiste à isoler un ordinateur ou un réseau et à l’empêcher d’établir une connexion externe. Par exemple, un ordinateur isolé ne peut pas se connecter à l’internet public ou à d’autres réseaux de communication afin de garantir une sécurité totale des informations qu’il contient.

Répondre aux normes de sécurité les plus exigeantes

Jusqu’à présent, le gouvernement américain évalue la sécurité pour autoriser des produits et services cloud à ce domaine sensible. Il s’agit notamment de déploiements de cloud spécifiques, qui sont isolés des réseaux publics et exploités sur le sol américain par du personnel local disposant d’habilitations de sécurité pour traiter des données sensibles.

Avec le système à venir, Cisco affirme que les futurs outils Webex répondront aux normes de sécurité exigées par les agences américaines impliquées dans la sécurité et la défense nationales, sans compromettre l’expérience des utilisateurs. « Nous avons ajouté à notre solution de collaboration Webex des contrôles de sécurité et des capacités opérationnelles supplémentaires exigés par le gouvernement afin qu’elle puisse être déployée dans un environnement déconnecté de l’Internet public », a déclaré Jeetu Patel, vice-président exécutif et directeur général de la sécurité et de la collaboration chez Cisco. « Cette approche nous permet d’offrir une expérience moderne à la communauté de la sécurité nationale et de la défense ».

Être en accord avec les standards de FedRAMP

En outre, Cisco a réaffirmé son engagement à fournir des solutions sur site pour la collaboration de niveau secret défense- y compris les appels, la messagerie, les réunions et le partage de fichiers – en alignant sa sécurité de niveau entreprise sur les exigences définies par FedRAMP, le Federal Risk and Authorization Management Program, qui fournit une approche standardisée des autorisations de sécurité pour les offres de services dans le cloud. L’entreprise a également déclaré que tous les systèmes de collaboration entièrement conformes pour le gouvernement prendront en compte les réglementations locales, les exigences de conformité et les contrôles de sécurité pour les communautés gouvernementales individuelles.

Ce produit est conçu spécifiquement pour les entreprises travaillant sur des projets de sécurité nationale et de défense et ne sera donc pas disponible pour les clients en dehors de ce secteur, a déclaré Jeetu Patel, ajoutant que les prestataires du secteur de la défense peuvent choisir de l’utiliser lorsqu’ils travaillent sur des contrats gouvernementaux qui exigent le niveau de sécurité fourni par le produit. « Bien que cette annonce soit spécifique à la sécurité nationale et à la défense, nous continuerons à innover en développant des solutions de collaboration personnalisées et entièrement conformes à toutes les activités du gouvernement », peut-on lire dans un billet de blog.

Alors que l’IA générative continue d’ébranler l’industrie technologique, les gouvernements du monde entier commencent à envisager une réglementation afin de lutter contre son potentiel d’aide à la criminalité et de promotion des préjugés.

Si les États-Unis et la Chine sont de féroces rivaux commerciaux dans le domaine des technologies, ils semblent partager un nouveau point commun : les préoccupations relatives à la responsabilité et à l’éventuelle utilisation abusive de l’IA. Mardi, les gouvernements des deux pays ont annoncé des réglementations relatives au développement de l’IA. La National Telecommunications and Information Administration (NTIA), une branche du ministère américain du commerce, a lancé un appel public officiel à contribution sur les politiques qui devraient façonner un écosystème de responsabilité en matière d’IA. Il s’agit notamment d’interrogations relatives à l’accès aux données, à la mesure de la responsabilité et à la manière dont les approches de l’IA pourraient varier dans différents secteurs d’activité, tels que l’emploi ou la santé.

Les commentaires écrits en réponse à la demande doivent être fournis à la NTIA avant le 10 juin 2023, soit 60 jours à compter de la date de publication dans le registre fédéral. Cette nouvelle intervient le jour même où la Cyberspace Administration of China (CAC) a dévoilé un certain nombre de projets de mesures pour la gestion des services d’IA générative, notamment en rendant les fournisseurs responsables de la validité des données utilisées pour former les outils d’IA générative. La CAC a déclaré que les fournisseurs devraient être responsables de la validité des données utilisées pour former les outils d’IA et que des mesures devraient être prises pour prévenir la discrimination lors de la conception des algorithmes et des ensembles de données de formation, selon un article de Reuters. Les entreprises devront également soumettre des évaluations de sécurité au gouvernement avant de lancer leurs outils d’IA au public.

Réglementation de l’IA contre innovation

Si des contenus inappropriés sont générés par leurs plateformes, les entreprises devront mettre à jour la technologie dans les trois mois afin d’empêcher que des contenus similaires soient à nouveau générés, selon le projet de règles. En cas de non-respect de ces règles, les fournisseurs se verront infliger des amendes, leurs services seront suspendus ou ils feront l’objet d’une enquête pénale. Tout contenu élaboré par l’IA générative doit être conforme aux valeurs socialistes fondamentales du pays, a déclaré la CAC. Les géants chinois de la technologie ont bien avancé dans le développement de l’IA. L’annonce de la CAC a été faite le jour même où Alibaba Cloud a annoncé un modèle de langage étendu, appelé Tongyi Qianwen, qu’il va déployer en tant qu’interface de type ChatGPT pour toutes ses applications commerciales. Le mois dernier, un autre géant chinois des services internet et de l’IA, Baidu, a annoncé une variante au ChatGPT en langue chinoise, Ernie bot.

Si le gouvernement chinois a établi un ensemble clair de lignes directrices réglementaires, d’autres gouvernements dans le monde adoptent une approche différente. Le mois dernier, le gouvernement britannique a déclaré que pour « éviter une législation trop lourde qui pourrait étouffer l’innovation », il avait choisi de ne pas confier la responsabilité de la gouvernance de l’IA à un nouveau régulateur unique, appelant plutôt les régulateurs existants à proposer leurs propres approches qui conviennent le mieux à la façon dont l’IA est utilisée dans leurs secteurs. Toutefois, cette orientation a été critiquée par certains, les experts du secteur faisant valoir que les cadres existants pourraient ne pas être en mesure de réglementer efficacement l’IA en raison de la nature complexe et multicouche de certains outils d’IA, ce qui signifie que la confusion entre les différents régimes sera inévitable.

Par ailleurs, l’autorité britannique de régulation des données a adressé un avertissement aux entreprises technologiques concernant la protection des informations personnelles lors du développement et du déploiement d’IA génératifs en tant que LLM, tandis que l’autorité italienne de régulation de la confidentialité des données a interdit ChatGPT en raison d’allégations de violations de la vie privée. Un groupe de 1 100 leaders technologiques et scientifiques a également appelé à une pause de six mois dans le développement de systèmes plus puissants que le modèle GPT-4 récemment lancé par OpenAI.

L’erreur, base de l’apprentissage

Lorsqu’il s’agit d’innovation technologique et de réglementation, la plupart des gouvernements et des législateurs suivent généralement un certain chemin naturel, a déclaré Frank Buytendijk, analyste chez Gartner. « Lorsqu’une nouvelle technologie est mise sur le marché, nous apprenons à l’utiliser de manière responsable en commettant des erreurs », a-t-il déclaré. « C’est ce que nous faisons actuellement avec l’IA ». Selon cet analyste, la réglementation commence à émerger – permettant aux développeurs, aux utilisateurs et aux systèmes juridiques d’apprendre l’utilisation responsable par l’interprétation de la loi et de la jurisprudence – suivie de la phase finale, où les technologies intégrant l’utilisation responsable. « Nous apprenons ce qu’est l’utilisation responsable grâce à ces meilleures pratiques intégrées, il s’agit donc d’un processus », a déclaré M. Buytendijk.