A l’occasion de son IT Symposium/Xpo qui s’est tenu à Orlando en Floride (20-23 octobre), le Gartner a présenté les 10 principales tendances technologiques pour l’année à venir. Supercalculateurs IA, systèmes multi-agents et confidential computing en font partie.

Sans surprise, l’IA a occupé le devant de la scène du Gartner IT Symposium/Xpo qui s’est tenu cette semaine (20 au 23 octobre) à Orlando, en Floride, où, comme chaque année, le cabinet d’études présente les principales tendances technologiques qui façonneront l’IT d’entreprise au cours de l’année à venir. « Les entreprises ont besoin d’un responsable dédié à l’IA », a déclaré Daryl Plummer, vice-président analyste émérite, directeur de la recherche, Gartner Fellow et principal intervenant de la conférence. « 2026 sera une année charnière pour les leaders technologiques, car les perturbations, les innovations et les risques se développent à une vitesse sans précédent », a avancé Gene Alvarez, vice-président analyste émérite chez du cabinet. « Les principales tendances technologiques stratégiques identifiées pour 2026 sont étroitement liées et reflètent les réalités d’un monde hyperconnecté et alimenté par l’IA, dans lequel les entreprises doivent favoriser l’innovation responsable, l’excellence opérationnelle et la confiance numérique », a-t-il souligné. « Mais le rythme est différent : plus d’innovations ont émergé cette année comme jamais auparavant », a ajouté Tori Paulman, vice-présidente analyste du Gartner.

Zoom sur les principales tendances technologiques stratégiques pour 2026 :

Des supercalculateurs d’IA

D’ici à 2028, plus de 40 % des grandes entreprisesdevraient adopter des architectures IT hybrides dans leurs processus métier critiques, contre 8 % actuellement. « Les supercalculateurs d’IA intègrent des CPU, des GPU, des ASIC dédiés à l’IA, des paradigmes informatiques neuromorphiques et alternatifs, pour que les entreprises puissent orchestrer des charges de travail complexes tout en atteignant de nouveaux niveaux de performance, d’efficacité et d’innovation. Ces systèmes combinent des processeurs puissants, une mémoire massive, du matériel spécialisé et des logiciels d’orchestration pour traiter des charges de travail gourmandes en données dans des domaines comme l’apprentissage machine, la simulation et l’analyse », a déclaré le Gartner.

Des modèles de langage spécifiques à un domaine

Plus de la moitié des modèles de GenAI utilisés par les entreprises seront spécifiques à un domaine d’ici 3 ans. Les modèles de langage spécifiques à un domaine (Domain-Specific Language Models, DSLM) comblent une lacune des grands modèles de langage génériques en offrant une plus grande précision, des coûts réduits et une meilleure conformité. « Les DSLM sont des modèles de langage formés ou affinés à partir de données spécialisées pour un secteur, une fonction ou un processus particulier. Contrairement aux modèles généralistes, les DSLM offrent une précision, une fiabilité et une conformité accrues pour répondre aux besoins spécifiques des entreprises », a souligné l’expert en prévisions. « Les agents d’IA non liés aux DSLM peuvent interpréter le contexte spécifique à un secteur pour prendre des décisions pertinentes, même dans des scénarios inconnus, et excellent en termes de précision, d’explicabilité et de prise de décision », a affirmé Mme Paulman. La société estime que les dépenses mondiales des utilisateurs finaux en modèles d’IA générative devraient atteindre 14,2 milliards de dollars en 2025 et que les dépenses des utilisateurs finaux en modèles d’IA générative spécialisés, qui incluent les DSLM, devraient atteindre 1,1 milliard de dollars cette année.

Des plateformes de sécurité basées sur l’IA

A horizon 2028, plus de 50 % des entreprises utiliseront des plateformes de sécurité basées sur l’IA pour protéger leurs investissements dans l’IA. « Les plateformes de sécurité basées sur l’IA offrent un moyen unifié de sécuriser les applications d’IA tierces et personnalisées. Elles centralisent la visibilité, appliquent les politiques d’usage et protègent contre les risques spécifiques à l’IA, comme l’injection de prompts, les fuites de données et les actions malveillantes des agents. Ces plateformes aident les DSI à appliquer les politiques relatives à l’usage, à surveiller l’activité de l’intelligence artificielle et à mettre en place des garde-fous cohérents pour l’ensemble de l’IA », selon Gartner. « La popularité des agents d’IA personnalisés introduit de nouvelles surfaces d’attaque et de nouveaux risques qui exigent des entreprises qu’elles adoptent des pratiques de développement et de sécurité d’exécution sécurisées […] Les actions des agents d’IA étant basées sur un modèle probabiliste, elles sont, par nature, moins prévisibles, ce qui complique la gestion des risques. Pour tirer parti des avantages des agents d’IA tout en écartant les incertitudes ».

Des plateformes de développement IA native

D’ici à 2030, les plateformes de développement IA natives permettront à 80 % des entreprises de transformer leurs grandes équipes d’ingénieurs logiciels en équipes plus petites et plus agiles, augmentées par l’IA. Les plateformes de développement IA natives utilisent la GenAI pour créer des logiciels plus rapidement et plus facilement qu’auparavant. Les entreprises peuvent constituer de petites équipes associées à l’IA pour créer davantage d’applications avec le même nombre de développeurs qu’aujourd’hui. Selon le cabinet, les entreprises leaders créent de petites équipes dédiées aux plateformes afin que des experts non techniques puissent produire eux-mêmes des logiciels, avec des garde-fous de sécurité et de gouvernance

Informatique confidentielle

Plus de 75 % des opérations traitées dans des infrastructures non fiables seraient sécurisées lors de leur utilisation d’ici 2029 grâce au confidential computing. « L’informatique confidentielle change la façon dont les entreprises traitent les données sensibles. En isolant les charges de travail dans des environnements d’exécution de confiance (Trusted Execution Environments, TEE) basés sur du matériel, elle préserve la confidentialité du contenu et des charges de travail, même vis-à-vis des propriétaires d’infrastructures, des fournisseurs de cloud ou de toute personne ayant un accès physique au matériel », a expliqué Gartner. « Ces environnements sont particulièrement utiles pour les secteurs réglementés et les opérations mondiales confrontés à des risques géopolitiques et de conformité, ainsi que pour la collaboration entre concurrents. »

Cybersécurité préventive

D’ici à 2030, les solutions de cybersécurité préventive représenteront la moitié de toutes les dépenses de sécurité, contre moins de 5 % en 2024, les DSI passant d’une défense réactive à une protection proactive. D’après le prévisionniste, les technologies de cybersécurité préventive utilisent l’intelligence artificielle (IA) et l’apprentissage machine (ML) avancés pour anticiper et neutraliser les menaces avant qu’elles ne se concrétisent. Elles comprennent des fonctionnalités de renseignement prédictif sur les menaces, de fraude avancée et de défense automatisée des cibles mobiles. La cybersécurité préventive suscite beaucoup d’intérêt, car les entreprises sont confrontées à une augmentation exponentielle des menaces visant les réseaux, les données et les systèmes connectés. « La cybersécurité préventive consiste à agir avant que les attaquants ne frappent, en utilisant des SecOps alimentés par l’IA, le déni programmatique et la tromperie », a encore déclaré Mme Paulman. « C’est un monde où la prédiction est synonyme de protection. » Les solutions de cybersécurité préventive devraient remplacer de plus en plus les solutions autonomes de détection et de réponse comme approche privilégiée pour se défendre contre les cybermenaces. « La cybersécurité préventive sera bientôt la nouvelle norme pour toutes les entités opérant sur, dans ou à travers les différentes couches interconnectées du réseau mondial de surface d’attaque (Global Attack Surface Grid, GASG) », a souligné Carl Manion, Managing Vice-Président chez Gartner, dans un rapport récent.

Provenance numérique

A échéance 2029 ceux qui n’auront pas suffisamment investi dans les capacités de provenance numérique s’exposeront à des risques de sanctions pouvant atteindre des milliards de dollars. « Parce que les entreprises s’appuient de plus en plus sur des logiciels tiers, du code open source et du contenu généré par l’IA, la vérification de la provenance numérique est devenue essentielle. La provenance numérique désigne la capacité à vérifier l’origine, la propriété et l’intégrité des logiciels, des données, des médias et des processus. De nouveaux outils comme les nomenclatures logicielles (Software Bill of Materials, SBoM), les bases de données d’attestation et le tatouage numérique offrent aux entreprises les moyens de valider et de suivre les actifs numériques tout au long de la chaîne d’approvisionnement », a rappelé Gartner.

Géopatriation

D’ici à 2030, plus de 75 % des entreprises européennes et moyen-orientales déplaceront leurs charges de travail virtuelles dans des solutions capables de réduire les risques géopolitiques, contre moins de 5 % en 2025. D’après la définition de Gartner, la géopatriation consiste à transférer les données et les applications d’une entreprise hors des clouds publics mondiaux vers des options locales, notamment des clouds souverains, des fournisseurs de cloud régionaux ou les propres centres de données d’une entreprise en raison d’un risque géopolitique identifié. Autrefois limitée aux banques et aux gouvernements, la souveraineté du cloud touche désormais un large éventail d’entreprises à mesure que l’instabilité mondiale s’accroît.

Systèmes multi-agents

L’expert en conjonctures définit les systèmes multi-agents (Multiagent Systems, MAS) comme des ensembles d’agents d’IA qui interagissent pour atteindre des objectifs complexes individuels ou communs. Les agents peuvent être fournis dans un environnement unique ou développés et déployés indépendamment dans des environnements distribués. « L’adoption de systèmes multi-agents est un moyen pratique pour les entreprises d’automatiser des processus métier complexes, d’améliorer les compétences des équipes et de faire collaborer autrement les humains et les agents d’IA », a expliqué M. Alvarez. « Des agents modulaires et spécialisés peuvent améliorer l’efficacité, accélérer la livraison et réduire les risques en réutilisant des solutions éprouvées dans tous les workflows. Cette approche facilite également la mise à l’échelle des opérations et l’adaptation rapide à l’évolution des besoins. »

IA physique

« L’IA physique apporte l’intelligence dans le monde réel en alimentant des machines et des appareils qui détectent, décident et agissent, comme les robots, les drones et les équipements intelligents. Elle apporte des gains mesurables dans les secteurs où l’automatisation, l’adaptabilité et la sécurité sont des priorités », selon le cabinet d’études. « À mesure que son adoption se généralise, les entreprises ont besoin de nouvelles compétences qui font le lien entre l’IT, l’OT et l’ingénierie. Cette évolution crée des opportunités de perfectionnement et de collaboration, mais peut également susciter des inquiétudes sur le plan de l’emploi et nécessiter une gestion minutieuse du changement. »

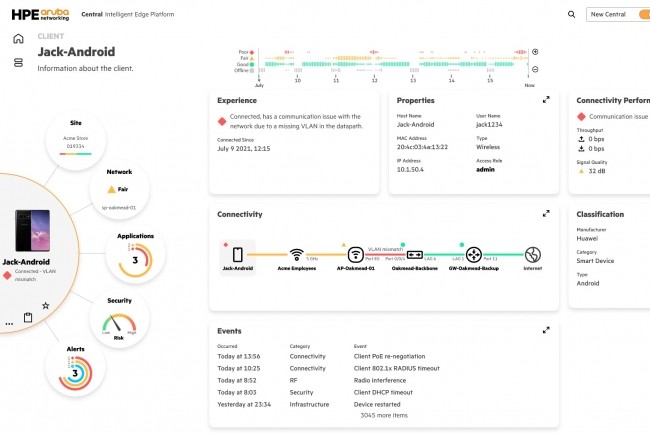

Les plateformes HPE Aruba Networking bénéficient de contrôles d’accès plus stricts, de capacités de confiance zéro et de mises à jour de la défense DDoS.

Afin de protéger plus efficacement l’accès aux ressources de l’entreprise, HPE Aruba Networking renforce la coordination entre les équipes de sécurité et de réseau. Plusieurs mises à jour ont été annoncées à cet effet par le fournisseur lors de la RSA Conference 2025, organisée du 28 avril au 1er mai. C’est le cas notamment d’un gestionnaire de politiques pour le contrôle d’accès au réseau (network access control ou NAC), d’une intégration plus étroite entre Central et OpsRamp, ainsi que de composants de sécurité pour ses offres SD-WAN et SSE. « L’équipe réseau et l’équipe sécurité considèrent de plus en plus le réseau comme un système de sécurité, et nous continuons à construire une couverture dans le réseau pour soutenir le reste de l’écosystème de sécurité », a déclaré Larry Lunetta, vice-président de l’IA, de la sécurité et du marketing des produits réseau chez le fournisseur texan. HPE Aruba dispose d’une plateforme de sécurité, d’une plateforme d’IA et d’une plateforme de services réseau, le tout étant intégré dans GreenLake, « « C’est selon nous une capacité unique qui nous différencie des autres fournisseurs de réseaux », a estimé M. Lunetta.

Gestion des politiques améliorée et intégration d’OpsRamp

HPE Aruba étend ses capacités NAC grâce à l’ajout d’un gestionnaire de politiques appelé Central Network Access Control à sa plateforme de gestion de réseau phare. « Ce gestionnaire permet de mettre en place des politiques d’accès précises, comme une application par rôle, par rôle au niveau du sous-réseau et par rôle au niveau du rôle, sur l’ensemble du réseau et d’appliquer des politiques plus détaillées depuis la périphérie jusqu’au cloud », a expliqué M. Lunetta. La fonctionnalité d’accès est désormais intégrée dans le flux du réseau. Lors de la mise en ligne d’un commutateur ou d’une passerelle, les politiques prédéfinies pour les utilisateurs, les appareils et les applications sont automatiquement mises en œuvre sur cet appareil. « Aucune commande CLI manuelle ou étape supplémentaire n’est requise de la part de l’administrateur du réseau », a précisé M. Lunetta.

« En fait, ce gestionnaire de politiques inaugure la nouvelle génération du système ClearPass NAC de HPE Aruba », a-t-il indiqué. « ClearPass est toujours présent et constitue toujours une partie importante du portefeuille », a ajouté M. Lunetta. « Mais les nouvelles fonctionnalités sont des outils de politique basés sur le cloud qui étendent les principes de confiance zéro à l’ensemble de la plateforme et considèrent chaque utilisateur, appareil et application comme non fiables jusqu’à ce qu’ils soient authentifiés », a-t-il poursuivi. Les clients peuvent propager les politiques dans l’ensemble de l’infrastructure du réseau pour une application cohérente, de la périphérie au cloud.

De plus, HPE Aruba a renforcé l’intégration entre Central et OpsRamp, la technologie achetée en 2023 par le fournisseurpour gérer les environnements hybrides et multicloud. OpsRamp surveille des éléments comme des commutateurs tiers, des points d’accès, des pare-feux et des routeurs. Une intégration plus étroite élargit la capacité à surveiller nativement les appareils tiers de fournisseurs tels que Cisco, Arista et Juniper Networks. « Par ailleurs, les nouvelles capacités de profilage, de classification et d’évaluation des risques des applications dans HPE Aruba Networking Central permettront aux entreprises d’établir des politiques d’accès aux applications basées sur les préférences en matière de risques », selon le fournisseur.

Mises à jour de EdgeConnect SD-WAN et SSE

Le fournisseur ajoute également une protection contre les dénis de service distribués (DDoS) à ses appliances SD-WAN EdgeConnect. « Nous tirons parti de l’analyse comportementale basée sur l’apprentissage machibe pour établir des lignes de référence du trafic et détecter automatiquement les anomalies pouvant révéler une attaque DDoS », a dit M. Lunetta. « En cas de détection d’une attaque DDoS potentielle, nous proposons une série d’options de remédiation directement au sein de l’appliance SD-WAN, en réduisant la bande passante pour la connexion affectée ou en la bloquant complètement », a encore expliqué M. Lunetta. L’idée est de créer une couche d’autodéfense intelligente directement à la périphérie du réseau. « Par ailleurs, l’offre Private Edge basée sur la confiance zéro de HPE Aruba est désormais disponible au sein de EdgeConnect SD-WAN et peut être activée avec une licence SSE ZTNA sans frais supplémentaires ni installation additionnelle par les opérateurs », a fait savoir le fournisseur. « Avec ZTNA Private Edge, les entreprises peuvent mettre en œuvre des politiques de confiance zéro localement, qui reflètent celles définies dans le cloud, et fournissent un accès sécurisé cohérent aux ressources », a fait valoir l’entreprise. HPE Aruba a également enrichi son offre SSE avec le support du maillage à haute disponibilité. « La connectivité maillée achemine le trafic par le chemin le plus rapide possible, en fournissant des chemins de données alternatifs sécurisés et une gestion automatique des pannes pour réduire les temps d’arrêt et connecter les appareils en toute sécurité sans nécessiter l’intervention des services IT de l’entreprise », a rappelé le fournisseur.

Extension de GreenLake

En ce qui concerne la sécurité du cloud, M. Lunetta a dit que l’entreprise avait doté son offre gérée Private Cloud Enterprise d’un disjoncteur numérique ou « kill switch » pour se déconnecter temporairement de l’Internet public en cas de menaces sur le réseau et isoler les données, les opérations et l’infrastructure critiques. « Si une menace de sécurité est détectée dans le cloud, l’équipe de sécurité peut couper la connexion entre le cloud et l’infrastructure sur site jusqu’à ce que la menace soit résolue », a-t-il indiqué. « Les charges de travail et l’infrastructure derrière la coupure continuent de fonctionner jusqu’à ce que la connexion soit rétablie avec le cloud », a précisé M. Lunetta. « Enfin, il est désormais possible d’exécuter Private Cloud Enterprise en tant que système air-gap sur site sans connexion à un réseau externe », a ajouté M. Lunetta. Selon le fournisseur, « contrairement aux offres de cloud public, Private Cloud Enterprise avec gestion air-gap est fourni par le personnel HPE habilité à la sécurité et permet de fonctionner en mode air-gap indéfiniment sans validation vers une plateforme cloud externe. »

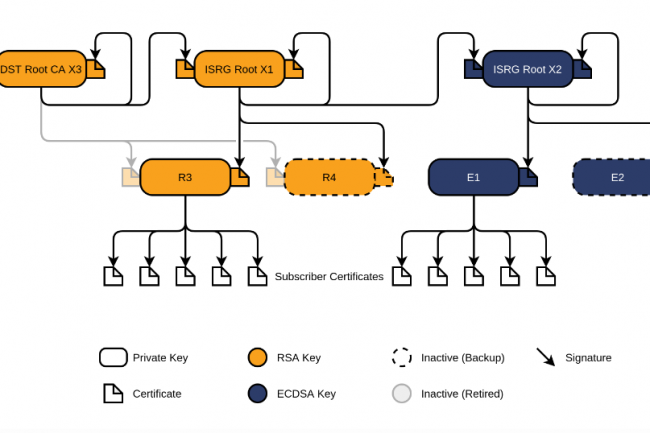

Si le soutien d’une fondation est important, ce qui compte le plus c’est d’apporter une solution technologique solide à un problème reconnu. Une recette dont a manifestement pu bénéficier l’autorité de certification Let’s Encrypt dépendant de l’Internet Security Research Group.

Dans le domaine des logiciels en général et de l’open source en particulier, le taux de réussite des fondations est très variable. Dans certains cas, l’absence de soutien de la part des fournisseurs de cloud est flagrante, comme avec l’Open Enterprise Linux Association et d’OpenTofu, alors que dans d’autres tel que Kubernetes, la communauté est soutenue par sa fondation. En fait, les fondations peuvent contribuer à encourager la communauté, mais elles ne sont pas en elles-mêmes une garantie de succès. C’est la raison pour laquelle Let’s Encrypt et l’Internet Security Research Group (ISRG) sont si fascinants.

Les motifs de leur réussite n’ont rien d’évident, et pourtant, dix ans plus tard, Let’s Encrypt de l’ISRG a délivré plus d’un milliard de certificats pour sécuriser plus de 360 millions de sites web. Il est également probable que Prosimmo (projet de sécurisation de la mémoire) et Divvi Up (système de mesure préservant la vie privée), suivront ce modèle. Même si de nombreuses autres fondations ne parviennent pas à remporter des victoires similaires, ce qui a été un peu le cas d’OpenStack. La question est de savoir pourquoi. Pourquoi Let’s Encrypt a réussi, et quelles leçons peuvent en tirer d’autres organisations à but non lucratif ou projets open source ?

10 ans de sécurisation de l’internet

L’une des principales raisons du succès de Let’s Encrypt est qu’il a résolu un problème de taille. Au moment de la création de Let’s Enrypt, à peine 28 % des chargements de pages étaient sécurisés sur le web. « Il y avait beaucoup d’autres options disponibles, comme le TLS et le SSL, mais elles n’étaient pas largement utilisées », a rappelé Sarah Gran, vice-présidente des communications de l’ISRG. « Pour faire réellement progresser la sécurité du web, il fallait que cela change et que cela corresponde davantage au rythme de la croissance et de la dépendance à l’égard de l’Internet qu’expérimentaient chaque jour les utilisateurs », a-t-elle ajouté. Let’s Encrypt n’a pas essayé de changer les choses avec des messages d’intérêt public. Elle s’est concentrée sur l’automatisation et la simplification du processus d’obtention des certificats. Plus les développeurs pouvaient adopter et appliquer facilement des certificats à leurs sites web, plus ils étaient susceptibles de les utiliser. Comme l’a affirmé Steve O’Grady de RedMonk, « la facilité d’utilisation l’emporte sur tout le reste pour les développeurs ».

Par ailleurs, le fait que l’Internet Security Research Group et son initiative Let’s Encrypt n’aient pas eu pour objectif de concurrencer les autorités de certification commerciales a également joué un rôle. « Nous ne sommes pas là pour jouer les héros », a expliqué Sarah Gran. « Tout ce que nous essayons de faire, c’est de résoudre un problème. En travaillant avec des fournisseurs de certificats propriétaires, Let’s Encrypt pouvait se concentrer sur la résolution du problème de la sécurité de l’Internet, sans chercher à s’en attribuer le mérite », a-t-elle ajouté. Quand j’ai demandé à Sarah Gran quel était, selon elle, le secret de la réussite de l’ISRG avec Let’s Encrypt, celle-ci n’a pas hésité : « Nous savons ce que nous faisons bien et nous nous y tenons. Et ce que nous faisons bien, c’est nous attaquer à des problèmes d’infrastructure technique difficiles », en particulier en ce qui concerne la sécurité de l’Internet, à laquelle l’ISRG s’attaque sous l’angle de l’automatisation, de l’efficacité et de l’échelle. L’Internet Security Research Group se concentre sur la résolution de problèmes discrets, d’où ce succès retentissant avec Let’s Encrypt. Cette même orientation axée sur les fondations devrait aussi contribuer au succès de Prossimo et de Divvi Up.

Des secrets de réussite efficaces

Il est clair que l’approche de l’ISRG a fonctionné, lui permettant de travailler avec des entreprises « concurrentes » sans être compétitive. Cependant, il est important de noter que les fondations ne sont pas indispensables à la réussite d’un projet logiciel. Dans le monde des autorités de certification, Comodo et Digicert prospèrent aux côtés de Let’s Encrypt. En dehors du domaine de la sécurité de l’Internet, c’est à peu près la même chose. Il serait difficile d’affirmer que HashiCorp, MongoDB, Elastic, etc. ne sont pas très populaires et ne connaissent pas le succès commercial qui va avec. On ne peut pas dire non plus que l’introduction d’une fondation sur un marché garantit qu’elle fera mieux que les produits d’un seul fournisseur. À propos de HashiCorp, alors même que le projet OpenTofu était lancé avec l’idée de fournir un fork open source de Terraform, soutenu par la fondation HashiCorp, le CEO de la Fondation Linux, Jim Zemlin, m’avait dit qu’il pensait que « Terraform et OpenTofu allaient réussir pour des raisons différentes ». Selon lui, Terraform réussira parce qu’il s’agit d’un excellent logiciel soutenu par une entreprise crédible. Il pense également qu’OpenTofu prendra une grande part du marché : « Personne ne veut investir d’importantes ressources d’ingénierie dans un projet qui n’est pas détenu de manière neutre ou qui est détenu et contrôlé par une seule entité commerciale. Cela conduira à un « meilleur investissement » dans OpenTofu ». Même si les entreprises qui contribuent aujourd’hui à OpenTofu sont relativement petites, Jim Zemlin pense que « la dépendance des fournisseurs en aval à l’égard du code développé par OpenTofu créera un écosystème plus large, car davantage de fournisseurs réinvestiront pour améliorer leurs produits en aval ».

Les projets menés par les fondations semblent donc voués à l’échec avec le temps. Mais pourquoi dans ce cas Kubernetes a-t-il réussi alors qu’OpenStack a échoué, alors même que les deux sont portées par de fortes communautés soutenues par des fondations ? Selon Jim Zemlin, « il s’avère que les conteneurs Kubernetes apportaient la bonne abstraction pour les charges de travail du cloud et pas les VM OpenStack ». La technologie est importante. Aucune fondation ne peut aller à l’encontre du fait qu’il faut aussi être en phase avec les choix technologiques particuliers des clients.

La sécurité de la mémoire en question

Ce qui nous ramène à l’ISRG et à sa mission. Tout comme il l’avait fait en 2015 pour la sécurité des sites web, l’Internet Security Research Group constate aujourd’hui que la sécurité de la mémoire pose un problème tout aussi important. Comme le dit Sarah Gran, « après examen de notre infrastructure et des diverses infrastructures dont dépend l’Internet, nous avons constaté qu’une grande partie est écrite en C et en C++ », avec tous les problèmes de sécurité de la mémoire, de bogues et de vulnérabilités que cela implique. Pourquoi est-ce un problème aujourd’hui ? Après tout, cela fait longtemps que ces langages sont problématiques. Sarah Gran reconnaît que Microsoft et Google ont admis que la grande majorité de leurs vulnérabilités provenaient de problèmes de sécurité de la mémoire, ce qui a mis en évidence le fait que la sécurité de la mémoire était un problème important, qui pouvait être résolu par des langages comme Rust. Le succès sera-t-il comparable à celui de Let’s Encrypt ? Difficile de l’affirmer, mais s’il s’avère dans ce cas particulier qu’une technologie claire comme Rust peut résoudre ce problème, alors ce succès devient beaucoup plus probable. Qu’il s’agisse d’une fondation à but non lucratif ou d’une entreprise à but lucratif, le fait de se concentrer sur la résolution d’un problème client, et, avec un peu de chance, être aussi en phase avec les choix technologiques du client, semblent plus que jamais de bonnes garanties de réussite.