Selon une étude de Capital One, les décideurs sont persuadés que leurs données sont prêtes pour l’IA, mais la réalité du terrain voit leurs équipes IT passer des heures à mettre les data en forme et finalement passer à côté d’opportunités réelles d’automatisation.

Les chefs d’entreprise peuvent être convaincus que les données de leur entreprise sont prêtes pour l’IA, mais ce n’est pas du tout le point de vue des équipes informatiques qui passent souvent des heures chaque jour à mettre en forme ces data. Près de neuf chefs d’entreprise sur 10 interrogés dans une récente enquête de Capital One sur l’état de préparation à l’IA, affirment que les écosystèmes de données de leur entreprise sont prêts pour le déploiement de systèmes d’IA à grande échelle. Un point de vue en décalage total avec celui des équipes informatiques. 84 % des informaticiens, data scientists, data architects et des data analysts interrogés passent au moins une heure par jour à résoudre des problèmes liés aux données, plutôt que de travailler sur l’exploitation concrète de l’IA. 70% d’entre eux y passent même entre une et quatre heures quotidiennes et 14 %, plus de quatre heures.Un malentendu profondL’enquête met ainsi en évidence un « malentendu profond chez de nombreux décideurs concernant le travail nécessaire sur les data pour déployer la plupart des outils d’IA », comme le précise John Armstrong, directeur technique de Worldly, une plateforme d’analyse des données pour la supply chain durable. « Ils ont l’impression qu’il suffit de jeter des données à manger à l’IA et que cela résoudra tous les problèmes. Un des rôles des experts techniques est bel et bien d’éduquer les décideurs sur ce qu’il est possible ou non de faire pour atteindre son objectif. » Les conséquences de cette perception erronée et persistante sont énormes, selon lui. « Si l’organisation data d’une entreprise n’est pas préparée, elle pourrait dépenser littéralement des millions de dollars pour une solution inadéquate et en sortir de mauvais résultats ».Pour Justice Erolin, CTO de la société de service Bairesdev, il suffit parfois de projets pilotes réussis ou de la démonstration d’un algorithme performant pour donner de faux espoirs aux dirigeants. « Or, une vision holistique du sujet raconterait une tout autre histoire ! ». Un des clients de Bairesdev aurait ainsi eu la surprise de consacrer 30% d’un projet d’IA à intégrer ses systèmes existants. De façon générale, lorsque les équipes data ou IT doivent quotidiennement s’atteler durant des heures à réparer les données, il s’agit souvent d’un signe d’impréparation de la data de l’organisation aux exigences de l’IA. Les entreprises prêtes à passer l’IA devraient d’ailleurs au moins automatiser en partie la gestion des données, et ne pas employer leurs experts data pour le maintien opérationnel de l’IA et le nettoyage des données.Le problème de l’existantPour Rupert Brown, CTO et fondateur d’Evidology Systems, un fournisseur de solutions de conformité, les systèmes existants qui ne collectent et ne stockent qu’une quantité limitée de données font partie du problème. Certaines entreprises exploitent des logiciels et des middleware anciens qui ne sont pas conçus pour collecter, transmettre et stocker des données de manière adéquate pour alimenter les modèles d’IA modernes. « Dans le futur proche, la non-qualité des données va encore limiter l’intérêt de l’IA, ajoute Rupert Brown. Les systèmes existants qui fonctionnent avec des champs de taille limitée par exemple, ou des numéros de compte également limités, qui doivent être recyclés, sont toujours répandus dans l’industrie, ce qui engendre des corrections que l’IA ne peut pas comprendre. »Éduquer les parties prenantesPour pallier ce décalage entre une confiance trop élevée des dirigeants dans la préparation des données et le travail quotidien nécessaire des équipes IT pour maintenir la data, il est essentiel d’éduquer les parties prenantes non techniques aux réalités et aux défis de la mise en oeuvre de l’IA. « Lorsque les dirigeants comprennent les vrais enjeux de l’IA et le temps que les équipes techniques consacrent à y répondre, ils sont davantage susceptibles d’investir dans des pratiques data robustes et d’aligner les attentes des uns et des autres », estime Justice Erolin.Pour Terren Peterson, vice-président de l’ingénierie des données chez Capital One, le succès de la GenAI pourrait bien aider à engager ce type de démarches. « L’hygiène, la qualité et la sécurité des données sont autant de sujets dont nous parlons depuis 20 ans, explique-t-il. Mais aujourd’hui, le succès de l’IA et du machine learning pourrait bien attirer davantage l’attention sur ces éléments fondamentaux de la gestion de données ! Et la révolution de la GenIA pourrait aider à comprendre que la qualité des données est cruciale. Même si ces sujets sont longtemps restés au fin fond des ordres du jour des DSI, ils vont désormais devenir prioritaires. »De petits prototypesAlors que de nombreux chefs d’entreprise se passionnent aujourd’hui pour le déploiement de la GenAI, John Armstrong de Wordly recommande aux responsables informatiques de se concentrer sur les cas d’usage, plutôt que sur des technologies d’IA spécifiques. Dans certains cas, les technologies les plus anciennes, telles que le machine learning ou les réseaux neuronaux, seront plus adaptées et beaucoup moins chères pour l’objectif envisagé. « La GenAI utilise d’énormes quantités d’énergie par rapport à d’autres outils d’IA », note-t-il par ailleurs. Pour lui, les DSI devraient aussi plutôt lancer de petits prototypes pour trouver les meilleurs cas d’usage de l’IA pour leurs organisations, tout en sachant que certaines expériences ne fonctionneront pas. « L’expérimentation n’a pas besoin d’être gigantesque, mais elle suffira à familiariser l’entreprise avec l’IA », poursuit-il.

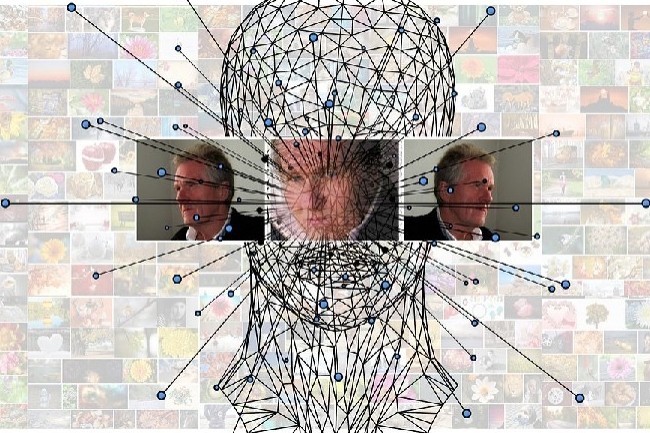

Après les personnalités de la politique et du spectacle, les deepfakes ciblent désormais aussi les responsables d’entreprise. Les hackers se font passer pour ces derniers, y compris au sein de visioconférences, afin d’extorquer des fonds aux organisations.

Selon une enquête menée par le cabinet de conseil Deloitte, près de 15 % des dirigeants affirment que des cybercriminels ont ciblé leurs données financières ou comptables à l’aide de deepfakes au moins une fois au cours de l’année écoulée. 11 % confirment même avoir été victimes de plusieurs escroqueries de ce type. Ces techniques de falsification par l’IA d’images, de sons, de vidéos ou de tout type de données ont longtemps été un cauchemar réservé aux personnalités de la politique ou du spectacle. Les réponses à l’enquête Deloitte confirment qu’elles ciblent désormais aussi les entreprises.Outre le risque cyber, la situation implique aussi des risques financiers. Elle ne concerne ainsi pas que les DSI et les RSSI, mais aussi la direction des risques. L’agence de notation Moody’s a d’ailleurs publié au printemps une mise en garde spécifique le confirmant. Le rapport détaille quelques tentatives d’escroquerie par deepfake, y compris de faux appels vidéo, qui ont visé le secteur financier au cours des deux dernières années. « Les deepfakes peuvent être utilisés pour créer des vidéos frauduleuses de responsables dans des banques, de dirigeants d’entreprises ou de fonctionnaires afin de rediriger des transactions financières ou d’effectuer des paiements frauduleux », précise le document. Des versions beaucoup plus sophistiquées et variées que les bonnes vieilles fraudes téléphoniques au président.Un nouveau champs des possibles pour les piratesL’enquête de Deloitte a été conduite auprès de plus de 1 100 dirigeants d’entreprises lors d’un webinaire en mai sur la confiance dans l’IA générative. Environ la moitié de ceux qui n’ont pas répondu avoir constaté d’attaque par deepfake, disent soit ne pas se sentir concernés, soit ne pas savoir si leur organisation a été ciblée. Il se peut ainsi que toutes les organisations réellement ciblées ne se déclarent pas, comme le précise Michael Bondar, global enterprise trust leader chez Deloitte, car les escroqueries par deepfake sur les données financières restent encore relativement récentes. « Lorsque de tels incidents se produisent, les organisations sont peu enclines à s’en vanter, ajoute-t-il. En réalité, nous parlons d’une toute nouvelle étendue de nouvelles possibilités ».Plus de la moitié des personnes interrogées s’attendent à ce que le nombre d’escroqueries financières par deepfake augmente au cours de l’année à venir. Pour lutter contre ce phénomène, pour l’instant, elles se contentent de communiquer avec leurs employés, de leur proposer des formations, de déployer de nouvelles politiques de protection ou de nouvelles technologies. Mais environ 10 % affirment que leur entreprise ne fait rien et près d’un tiers ne sait pas ce qu’elle met en place ou ne se sent pas concerné.Des deepfakes sophistiqués et documentés« Les deepfake d’appels vocaux sont de plus en plus courants, mais la visioconférence est désormais aussi concernée », comme le précise Mike Weil, digital forensics leader et managing director de Deloitte Financial Advisory Services. La version deepfake de la fraude au président. « Cela fait passer l’ingénierie sociale à un niveau supérieur. D’une part, vous parlez avec cette personne, mais d’autre part, elle détient beaucoup d’informations dont vous pensez qu’elle est la seule à les connaître. Les pirates sont ainsi capables d’interagir avec vous d’une manière qui semble tout à fait légitime ».« Il s’agit d’attaques hautement coordonnées et sophistiquées, préparées en amont avec de la collecte de renseignements sur votre organisation ou vos clients, poursuit Mike Weil. Ce ne sont pas des attaques aléatoires. Elles ciblent au contraire spécifiquement les points faibles au sein de l’organisation. Et l’objectif est d’en tirer de grosses sommes d’argent ».De faux participants en visioconférencePour Deloitte, pour se protéger contre ces attaques par deepfake, il faut assez classiquement éduquer et former les employés, et s’assurer que la direction suit scrupuleusement les processus internes pour le transfert de grosses sommes d’argent, par exemple. Sans oublier les exercices internes pour vérifier si les employés peuvent tomber dans ce type de piège.Quant aux solutions de détection de deepfakes, leurs éditeurs utilisent aussi l’IA pour contrer les méthodes des hackers.Une classique course aux armements dans ce domaine au croisement de la cybersécurité et de l’IA. Pour Kevin Surace, CTO d’Appvance, fournisseur d’outils de test de logiciels alimentés par l’IA, « n’importe qui aujourd’hui peut créer un message vocal deepfake sans aucune compétence ». Mais il insiste sur l’augmentation de la fréquence des appels vocaux interactifs deepfake et même d’interventions de faux participants dans des appels vidéo, même si cela nécessite davantage de connaissances techniques. Des méthodes en forte croissance qui devraient, selon lui, exploser d’ici à la fin 2025.