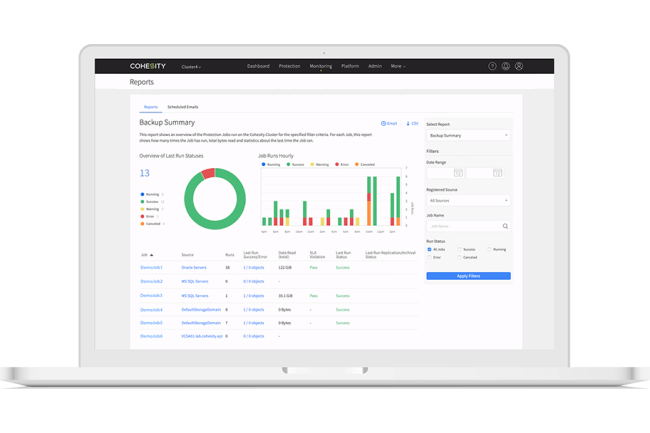

Cohesity plonge lui aussi dans le bain des IA génératives en testant le chatbot d’OpenAI dans son offre. Il pourra être sollicité pour identifier des problèmes de sécurité comme des accès inhabituels aux données ou des comportement anormaux.

L’entreprise de sauvegarde et de gestion des données en mode cloud Cohesity a annoncé son intention de proposer un chatbot basé sur Azure OpenAI (intégrant lui-même notamment sur ChatGPT). L’agent servira d’outil d’analyse de la sécurité et d’assistant pour les entreprises. Cette annonce s’inscrit dans un renforcement global du partenariat avec Microsoft et une intégration plus poussée avec les offres Active Directory, Sentinel et Purview.

ChatGPT, un analyste de niveau 1

Concernant le chatbot, il doit faciliter à la fois l’analyse rapide de la sécurité et les tâches des utilisateurs finaux. Greg Statton, directeur de l’ingénierie avant-vente chez Cohesity, a présenté comme premier cas d’usage une console de sécurité avec quelques irrégularités potentielles affichées. En utilisant des requêtes en langage naturel, le système a pu identifier les utilisateurs accédant aux systèmes de sauvegarde à partir d’adresses IP inhabituelles, et décrire un comportement anormal dans les données de journal.

« Comme nous le savons tous, les ransomwares s’attaquent non seulement aux données, mais aussi aux sauvegardes », a expliqué le dirigeant. « J’ai donc pensé qu’il serait intéressant de prendre ces données de flux de log en direct sur les personnes qui accèdent au système de sauvegarde et sur ce qu’elles font, et de les synthétiser en un résumé très clair », a-t-il déclaré. L’idée est que l’agent basé sur Azure OpenAI, se serve des informations du SIEM en tant qu’ensemble principal de données. Ce cas d’usage est similaire à celui présenté ensuite par Greg Statton, d’un cabinet d’avocats utilisant l’IA pour rechercher dans les affaires précédentes celles qui impliquent des types particuliers de clients ou de questions juridiques. « Grâce à cette IA générative, on peut trouver exactement les fichiers dont on a besoin dans Cohesity », a-t-il déclaré. « Il s’agit donc d’aller chercher dans ces données hautement indexées les paragraphes clés qui correspondent à la question posée », a-t-il encore expliqué.

Une plus grande intégration avec des solutions Microsoft

La mise à disposition de ces fonctionnalités pour l’utilisateur final, dans le domaine de la sécurité, se fera par l’intermédiaire de Microsoft. Cohesity a annoncé que son offre de sauvegarde DataProtect en tant que service s’intégrerait désormais à la solution Sentinel SIEM de la firme de Redmond pour une réaction plus rapide aux alertes de ransomware et au suivi des incidents. De même, la plateforme de classification des données de Cohesity sera liée au portail de conformité Purview pour la confidentialité et la découverte des données. « OpenAI est un formidable atout pour la productivité en termes de rapidité d’obtention des réponses », a déclaré Sanjay Poonen, CEO de Cohesity.

« Il ne s’agit pas seulement de poser des questions sur des sujets importants, mais aussi d’interroger les données », a ajouté le CEO. Cohesity a indiqué que ces récentes fonctionnalités n’étaient pas encore généralement disponibles et n’a pas précisé de date de sortie. Sanjay Poonen a indiqué qu’il s’agissait d’un projet de recherche interne que l’entreprise s’efforce de transformer en produit fonctionnel. Selon lui, sa finalisation devrait prendre quelques mois ou quelques trimestres.

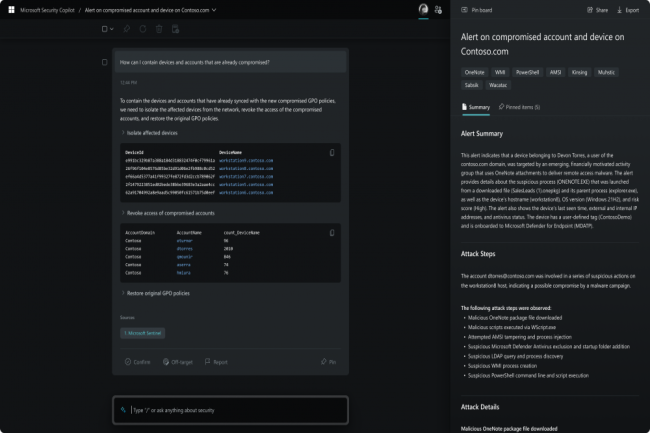

Microsoft poursuit l’intégration de ChatGPT dans ses produits avec cette fois-ci un focus sur la cybersécurité. Il vient de présenter Security Copilot, un assistant basé sur le modèle GPT-4 d’OpenAI.

Après Teams, la suite Microsoft365, c’est au tour des solutions de sécurité de la firme d’être infusée à l’IA générative d’OpenAI. Elle vient de lever le voile sur Security Copilot qui propose une multitude de fonctions et d’analyse. Son interface est similaire à celle de ChatGPT et peut répondre à des questions sur la sécurité IT de manière naturelle. Mais le plus impressionnant est l’intégration étroite avec les différents services de sécurité de Microsoft, notamment Defender, Sentinel, Entra, Purview, Priva et Intune.

Copilot peut interpréter les données de l’ensemble de ces services et fournir des explications automatisées et approfondies (y compris des visualisations), et suggérer aussi des solutions. De plus, le système pourra prendre des mesures contre certains types de menaces, par exemple en supprimant les messages électroniques dont le contenu malveillant a été identifié lors d’une analyse précédente. Microsoft prévoit d’étendre les capacités Security Copilot au-delà de ses propres produits, mais le fournisseur n’a pas donné d’autres détails à ce sujet, ni dans sa communication, ni dans le billet de blog officiel sur le service. Microsoft a également fait remarquer qu’en tant que produit d’IA générative, Security Copilot ne donnera pas des réponses correctes à 100 % et qu’il aura besoin d’un entraînement supplémentaire et des apports des premiers utilisateurs pour atteindre son plein potentiel.

Les données cyber pour l’entraînement de l’IA, un sujet délicat

Selon les experts en IA, même s’il n’est pas aussi novateur que Microsoft l’a présenté, Security Copilot est un système puissant. Selon Avivah Litan, vice-présidente et analyste chez Gartner, cela fait des années qu’IBM dispose de capacités similaires via Watson AI. « L’IA de Copilot est plus rapide et meilleure, mais la fonctionnalité est la même », a-t-elle déclaré. « C’est une offre intéressante, mais elle ne résout pas les problèmes que rencontrent les utilisateurs avec l’IA générative. Indépendamment de ces problèmes, dont le plus important est l’incapacité reconnue de Security Copilot à fournir des informations précises dans tous les cas, les avantages potentiels du système sont toujours impressionnants », a déclaré pour sa part Chris Kissel, vice-président de la recherche d’IDC. « Le grand avantage est qu’il est possible d’automatiser un bien plus grand nombre de choses », a-t-il déclaré. « L’idée qu’un ChatGPT puisse écrire quelque chose de manière dynamique et que l’analyse puisse le juger dans son contexte, dans la même couche, est convaincante », a-t-il ajouté.

Les deux analystes se sont toutefois montrés quelque peu sceptiques quant à la politique de Microsoft en matière de partage des données, en particulier que les données privées ne seront pas utilisées pour entraîner les modèles d’IA fondamentaux et que toutes les informations relatives aux utilisateurs resteront sous leur contrôle. Le problème, selon eux, est que les données relatives aux incidents sont essentielles pour former des modèles d’IA comme celui utilisé pour Security Copilot, et que l’entreprise n’a pas donné beaucoup d’indications sur la manière dont ces données seront traitées. « C’est une préoccupation », a déclaré M. Kissel. « Si l’on essaye de faire quelque chose qui implique, par exemple, un élément spécifique de la propriété intellectuelle, y a-t-il des garanties que ces données seront maintenues en place ? », a-t-il demandé. « Comment savoir si les données sont réellement protégées s’ils ne fournissent pas les outils nécessaires pour les examiner », a ajouté Avivah Litan. Pour l’instant, Microsoft n’a pas annoncé de date de disponibilité pour Security Copilot, mais le fournisseur a déclaré qu’il partagerait bientôt plus d’information à ce sujet.

Selon le cabinet d’audit et de conseil KPMG, les Américains sont préoccupés du traitement de leurs données personnelles par les entreprises. Et ils pensent que les cadres dirigeants ne sont peut-être pas suffisamment conscients de cet état de fait.

D’après un rapport publié hier par le cabinet d’experts-comptables KPMG auquel a eu accès notre confrère CSO, la grande majorité des Américains sont très préoccupés par la sécurité de leurs données personnelles. Et beaucoup estiment que les entreprises américaines n’arrangent pas les choses en intensifiant la collecte de ces données. Près de 92 % des répondants à l’enquête du cabinet de conseil se disent assez préoccupés par la manière dont sont traitées les données personnelles qu’ils fournissent aux entreprises, et près de neuf personnes sur dix ont déclaré que les entreprises devraient être plus transparentes et fournir plus de détails sur la manière dont elles traitent les données personnelles qu’elles collectent. « Les consommateurs voudraient avoir plus confiance, mais aussi plus de contrôle sur l’usage et la collecte de leurs données », ont écrit les auteurs du rapport. « Les entreprises qui fournissent des informations claires sur l’usage des données qu’elles collectent peuvent espérer améliorer le niveau de confiance des consommateurs », ont-ils ajouté.

Cette année, la préoccupation des consommateurs a augmenté, notamment en ce qui concerne les pratiques en matière de partage de données, par exemple pour la demande d’adhésion à un programme de récompenses et même pour l’utilisation d’un WiFi public. Comparativement au rapport de l’année précédente, les préoccupations relatives à ces pratiques ont augmenté respectivement de quatre et neuf points de pourcentage. Même si ce niveau de préoccupation n’a pas eu d’effet sur les comportements – selon les données de KPMG, les utilisateurs adoptent constamment des comportements en ligne qu’ils considèrent néanmoins comme risqués – les inquiétudes des consommateurs quant à la sécurité de leurs données restent élevées.

Une augmentation des données récoltées pendant la pandémie

Toujours selon ce rapport, les entreprises elles-mêmes sont très confiantes dans leurs projets de collecte et d’utilisation des données des consommateurs pour les trois prochaines années, 97 % des chefs d’entreprise se disant satisfaits de leurs dispositions dans ce domaine. Les entreprises ont également déclaré, à une forte majorité, avoir augmenté le volume de leur collecte de données au cours des années de pandémie. Mais seules 49 % d’entre elles déclarent fournir des informations claires sur la manière dont les données des consommateurs sont utilisées, et 45 % fournissent des rapports sur les violations en temps voulu.

Selon les auteurs du rapport de KPMG, cet écart s’explique en partie par un déficit d’information – les cadres supérieurs peuvent ne pas comprendre pleinement les enjeux de la confidentialité des données et leurs implications. Même si de nombreux dirigeants se disent confiants dans la manière dont ils traitent les informations des consommateurs, la transparence globale n’a pas beaucoup augmenté, et les dépenses consacrées par exemple à la formation des employés sur la protection des données ont chuté de manière vertigineuse au cours de l’année dernière. Une tendance que les auteurs du rapport appellent à inverser. « On pourrait imaginer qu’avec l’augmentation des préoccupations et des responsabilités potentielles en matière de violations de données, de sécurité des données et d’utilisation réelle des données, les entreprises consacreraient plus de ressources à la formation, or ce n’est pas le cas », ont-ils écrit. « Cela ne peut pas durer, surtout quand on constate que trois quarts des entreprises collectent plus de données personnelles que l’année dernière. Un déficit de formation peut augmenter le risque du programme de collecte de données ».

- 1

- 2