Confrontés à une pénurie de talents dans le domaine de la technologie, de nombreux dirigeants d’entreprise considèrent les applications d’IA générative telles que ChatGPT comme un moyen de combler cette lacune en prenant en charge des tâches normalement confiées à des employés. Une façon de remodeler le marché de l’emploi dans un secteur en tension.

Selon une étude de Kaspersky Research parue en octobre dernier, l’intelligence artificielle générative est susceptible de jouer un rôle essentiel pour remédier aux pénuries de compétences sur le marché actuel. Selon cette étude, 40 % des 2 000 cadres de haut niveau interrogés prévoient d’utiliser des outils d’IA générative tels que ChatGPT pour combler les pénuries de compétences critiques par l’automatisation des tâches. L’étude, basée en Europe, a révélé que cette technologie est fermement inscrite à l’ordre du jour des entreprises, 95 % des personnes interrogées discutant régulièrement des moyens de maximiser la valeur de la technologie au niveau le plus élevé, même si 91 % d’entre elles ont admis ne pas vraiment savoir comment elle fonctionne.

« Si l’on souhaite déléguer des activités et des fonctions critiques à l’IA générative, il est essentiel que les cadres supérieurs acquièrent d’abord une meilleure compréhension des processus de gestion des données, notamment des données qui peuvent ou ne peuvent pas être utilisées pour former ces systèmes », a déclaré David Emm, chercheur principal en sécurité chez Kaspersky. L’étude révèle que la GenAI présente un obstacle beaucoup moins important que la recherche de nouveaux employés, ce qui est attrayant pour les cadres supérieurs qui cherchent à résoudre des problèmes métiers critiques. Plus d’un quart des personnes interrogées ont toutefois qualifié la genAI de mode, la comparant à l’application Threads récemment lancée par Meta, un concurrent prometteur de X/Twitter. « Ces dirigeants ont déclaré qu’ils pensaient que l’IA générative n’était qu’une nouvelle mode [qui] s’imposait rapidement et disparaissait tout aussi vite », indique l’étude de Kaspersky.

Les dangers liés à l’IA persistent

Malgré cela, 49 % des personnes interrogées pensent que les employés automatisent déjà des tâches quotidiennes telles que la création de contenu pour les courriels. Bien que l’IA générative promette des avantages business évidents, l’éducation est essentielle et la collaboration avec des experts en cybersécurité et en risque est nécessaire pour aider à établir un environnement dans lequel la technologie peut être utilisée en toute sécurité et de manière productive, selon David Emm. Les obstacles à l’adoption de l’IA persistent. Il s’agit notamment des coûts élevés, du retour sur investissement incertain, de la nécessité d’améliorer les compétences de l’ensemble du personnel et de l’exposition potentielle des données sensibles de l’entreprise à une technologie d’automatisation peu familière.

Cependant, peu d’entreprises ont mis en place des mesures de protection appropriées pour se prémunir contre certains des défauts les plus connus de la genAI, tels que les hallucinations, l’exposition des données de l’entreprise et les erreurs de données. Selon Kaspersky, la plupart des organisations s’exposent aux risques reconnus de l’utilisation de la genAI. Par exemple, seuls 22 % des cadres dirigeants ont discuté de la mise en place de règles pour réglementer l’utilisation de la genAI dans leur organisation – même s’ils la considèrent comme un moyen de combler le déficit de compétences.

La mise en place de politiques, d’une sécurité et de garde-fous nécessaire

Le vice-président senior et DSI de Cisco, Fletcher Previn, dont l’équipe travaille à l’intégration de l’IA dans les systèmes et produits dorsaux, a déclaré qu’il était essentiel de mettre en place les politiques, la sécurité et les garde-fous juridiques pour pouvoir « adopter en toute sécurité les capacités d’IA que d’autres fournisseurs intègrent aux outils d’autres personnes ». « Vous pouvez imaginer que tous les fournisseurs de SaaS…, tout le monde est sur la même longueur d’onde », a déclaré Fletcher Previn lors d’une récente interview. « Mais sommes-nous prêts à profiter de ce voyage d’une manière qui soit compatible avec nos politiques d’IA responsable ? »

Les conclusions de Kaspersky indiquent que, malgré les inquiétudes liées à l’utilisation d’informations propriétaires sensibles utilisées pour alimenter les outils d’IA générative, la moitié des cadres interrogés prévoient d’automatiser les tâches banales des travailleurs, et 44 % d’entre eux prévoient de l’intégrer dans leurs propres routines pour accélérer les tâches administratives.

Au-delà des compétences, l’IA générative remplacera-t-elle les salariés ?

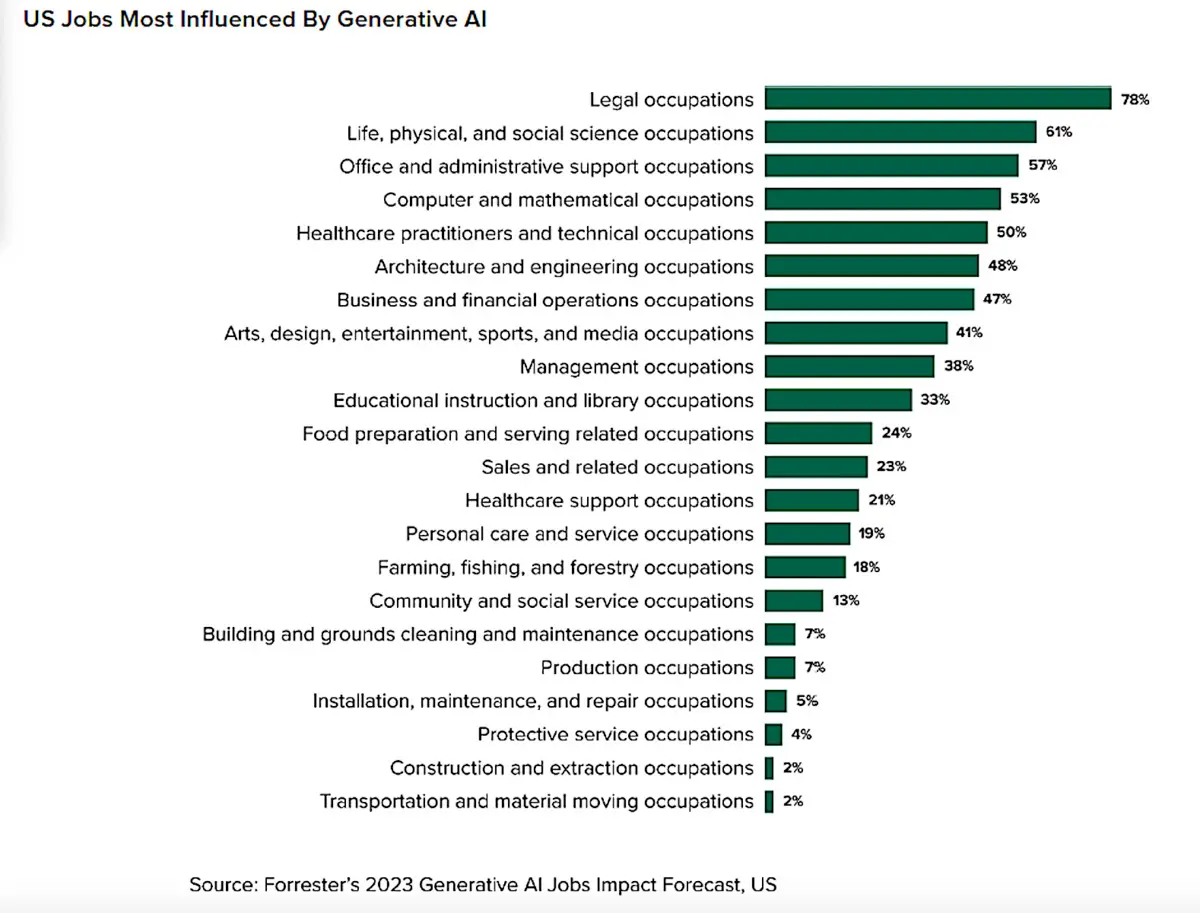

La GenAI influencera 4,5 fois plus d’emplois qu’elle n’en remplacera, selon le Generative AI Jobs Impact Forecast 2023 de Forrester Research. La technologie représentera également près de 30 % des emplois perdus à cause de l’automatisation d’ici 2030. « En termes de nombre d’emplois, nous prévoyons que l’IA générative remplacera 90 000 emplois en 2023, pour atteindre 2,4 millions d’ici 2030 », indique l’étude. Si 2,4 millions d’emplois remplacés par la genAI semblent élevés, Forrester note que l’automatisation et l’IA dans leur ensemble ne remplaceront que 4,9 % des emplois américains d’ici 2030. Et les pertes d’emplois au cours des deux prochaines années resteront modestes jusqu’à ce que les questions relatives aux droits de propriété intellectuelle, aux droits d’auteur, au plagiat, aux taux de rafraîchissement des modèles, à la partialité des modèles, à l’éthique et à la fiabilité des réponses des modèles soient résolues, a déclaré le cabinet d’études.

« Nous avons prévu les impacts futurs de l’IA générative et avons constaté une influence significative – c’est-à-dire que l’IA générative remodèlera le fonctionnement de nombreux emplois et la manière dont le travail est effectué. Mais les pertes d’emplois seront moins importantes que ce à quoi beaucoup s’attendent, et l’influence dépassera de loin la cannibalisation des emplois », a déclaré un porte-parole de Forrester. Cela ne signifie pas que les travailleurs n’y prêtent pas attention. Selon Forrester, 36 % des travailleurs mondiaux employés à temps plein ou à temps partiel craignent de perdre leur emploi à cause de l’automatisation au cours des dix prochaines années. « Nous suivons l’impact de l’IA sur l’emploi depuis près de dix ans, en analysant l’impact de l’IA et de l’automatisation sur l’avenir de l’emploi. Mais l’IA générative a suscité un tout nouveau cycle de conversations urgentes autour de cette question », a déclaré le cabinet d’études et de conseil. Il cite par ailleurs les prévisions exagérées de certains chercheurs qui annonçent une perturbation massive de l’emploi à la suite de l’arrivée des outils d’IA générative. Goldman Sachs, par exemple, a publié une étude au début de l’année indiquant que « les changements dans les flux de travail déclenchés par [l’IA générative] pourraient exposer l’équivalent de 300 millions d’emplois à temps plein à l’automatisation ».

Emplois les plus impactés par l’IA générative. (Crédit : Forrester)

Les compétences en IA générative se multiplient dans les métiers

Il n’est pas surprenant que le nombre d’offres d’emploi comportant des termes ou des compétences en IA générative ait monté en flèche au cours de l’année écoulée, ce qui signifie que les entreprises sont avides d’employés possédant des compétences spécifiques. Au début de l’année 2023, seulement 0,003 % des offres d’emploi mentionnaient des termes liés à l’IA générative. Ce chiffre est passé à 0,06 % à la fin du mois d’octobre, soit une multiplication par 20, selon Indeed. « Nous devrons attendre pour voir les effets à long terme de l’IA générative, mais il est clair dès à présent que les emplois liés à ce domaine sont en plein essor. Bien sûr, seulement 6 offres d’emploi sur 10 000 signifient que les emplois en IA générative ne sont pas très courants, même s’ils se développent rapidement », indique le rapport d’Indeed.

Évaluation des compétences de l’IA générative. (Crédit : Indeed)

Le marché de l’emploi peut évoluer rapidement, ce qui s’est déjà produit par le passé. Par exemple, selon une étude de l’économiste David Autor, jusqu’à 60 % des travailleurs d’aujourd’hui occupent des postes qui n’existaient pas en 1940. « Cela signifie que plus de 85 % de la croissance de l’emploi au cours des 80 dernières années s’explique par la création de postes grâce à la technologie », a déclaré Goldman Sachs. « L’étude de Goldman Sachs estime le marché total des logiciels d’IA générative à 150 milliards de dollars, contre 685 milliards de dollars pour l’industrie mondiale du logiciel ». L’IA est déjà utilisée pour aider les développeurs et les ingénieurs à créer toutes sortes de logiciels.

Fletcher Previn, de Cisco, a déclaré que l’un des rôles qu’il ne s’attendait pas à voir l’IA toucher était celui de développeur de logiciels, qu’il assimile à une forme d’art exigeant des capacités créatives uniques. ChatGPT, cependant, s’est avéré capable de créer du code qui traite de l’hygiène et de la sécurité des données de l’entreprise et peut réutiliser le code pour créer des applications. Une étude de Microsoft a montré que l’outil GitHub Copilot, alimenté par ChatGPT, peut aider les développeurs à coder jusqu’à 55 % plus rapidement – et plus de la moitié de tout le code enregistré dans GitHub aujourd’hui a été aidé par l’IA dans son développement. Selon Thomas Dohmke, PDG de GitHub, ce chiffre devrait atteindre 80 % de l’ensemble du code enregistré dans GitHub au cours des cinq prochaines années.

Les 5 principales compétences professionnelles en matière de développement de logiciels et leur évaluation par l’IA générative. (Crédit : Indeed)

La Gen IA pour aider à coder chez Cisco

« C’est très intéressant, car historiquement, il n’y avait aucun moyen de comprimer les délais de développement des logiciels », a déclaré Fletcher Previn lors d’une précédente interview. « Maintenant, il s’avère que vous pouvez obtenir une accélération significative de la vitesse en aidant les développeurs avec des choses comme Copilot pour la lecture du code, l’hygiène du code, la sécurité, les commentaires ; c’est vraiment bon pour ces choses-là ». La capacité de GenAI à développer ou à concevoir des logiciels a également modifié le système informatique interne de Cisco et sa stratégie externe en matière de produits.

Depuis novembre dernier, le département informatique de l’entreprise a développé une « stratégie plus complète » en termes d’IA en tant qu’infrastructure fondamentale. En interne, cela signifie utiliser l’IA pour trouver des améliorations de la productivité, y compris dans des domaines tels que les fonctions automatisées du service d’assistance. En externe, Cisco réfléchit désormais à la manière d’« intégrer l’IA dans chaque portefeuille de produits et d’augmenter l’ensemble du patrimoine numérique que nous gérons dans le cadre de l’informatique numérique ».

Le président Joe Biden devrait annoncer des règles imposant aux agences gouvernementales d’évaluer de manière plus approfondie les outils d’IA afin de s’assurer qu’ils sont sûrs et qu’ils n’exposent pas d’informations sensibles. En parallèle, le gouvernement devrait également assouplir les politiques d’immigration pour les travailleurs technophiles.

Après avoir critiqué les efforts déployés pour encadrer l’intelligence artificielle générative (genAI), jugés trop vagues et inefficaces, l’administration Biden devrait annoncer d’autres règles plus restrictives concernant l’utilisation de cette technologie par les fonctionnaires fédéraux, relevant donc du gouvernement. Le décret, qui devrait être dévoilé lundi, modifierait également les normes d’immigration afin de permettre un plus grand afflux de travailleurs du secteur technologique et d’accélérer ainsi les efforts de développement des États-Unis. Mardi soir, la Maison Blanche a envoyé des invitations pour un événement intitulé « Safe, Secure, and Trustworthy Artificial Intelligence », organisé lundi par le président Joseph Biden, selon The Washington Post.

L’IA générative, qui progresse à une vitesse fulgurante et suscite l’inquiétude des experts du secteur, a incité Joe Biden à publier des « orientations » en mai dernier. La vice-présidente Kamala Harris a également rencontré les CEO de Google, de Microsoft et d’OpenAI – le créateur du populaire chatbot ChatGPT – pour discuter des problèmes potentiels de l’IA générative, notamment en matière de sécurité, de protection de la vie privée et de contrôle. Avant même le lancement du ChatGPT en novembre 2022, l’administration avait dévoilé un projet de « charte des droits de l’IA » ainsi qu’un cadre de gestion des risques liés à l’IA. Elle a également proposé une feuille de route pour la création d’une ressource nationale de recherche sur l’IA.

Un décret pour renforcer les moyens en matière de cybersécurité

Le décret devrait renforcer les défenses nationales en matière de cybersécurité en exigeant que les grands modèles de langage (LLM) – le fondement de l’IA générative – fassent l’objet d’une évaluation avant de pouvoir être utilisés par les agences gouvernementales américaines. Ces agences comprennent le ministère de la défense, le ministère de l’énergie et les agences de renseignement, selon The Washington Post. Ces règles viendront renforcer l’engagement volontaire pris par 15 entreprises de développement de l’IA de faire le nécessaire pour garantir une évaluation des systèmes d’IA générative qui soit compatible avec une utilisation responsable. « Je crains que nous n’ayons pas de très bons antécédents dans ce domaine ; l’exemple de Facebook en est la preuve », a déclaré Tom Siebel, CEO du fournisseur d’applications d’IA d’entreprise C3 AI et fondateur de Siebel Systems, à un auditoire lors de la conférence EmTech du MIT en mai dernier. « J’aimerais croire que l’autorégulation fonctionnerait, mais le pouvoir corrompt, et le pouvoir absolu corrompt totalement ».

Bien que l’IA générative offre des avantages considérables grâce à sa capacité à automatiser des tâches et à créer des réponses textuelles sophistiquées, des images, des vidéos et même des codes logiciels, la technologie est également connue pour ses dérapages – une anomalie connue sous le nom d’hallucinations. « Les hallucinations se produisent parce que les LLM, dans leur forme la plus classique, n’ont pas de représentation interne du monde », explique Jonathan Siddharth, CEO de Turing, une entreprise de Palo Alto, en Californie, qui utilise l’IA pour trouver, embaucher et intégrer des ingénieurs en logiciel à distance. « Il n’y a pas de notion de fait. Ils prédisent le mot suivant sur la base de ce qu’ils ont vu jusqu’à présent – il s’agit d’une estimation statistique ».

Un risque d’exposition de données sensibles

L’IA générative peut également exposer de manière inattendue des données sensibles ou personnellement identifiables. Au niveau le plus élémentaire, les outils peuvent rassembler et analyser des quantités massives de données provenant d’Internet, d’entreprises et même de sources gouvernementales afin d’offrir un contenu plus précis et plus approfondi aux utilisateurs. L’inconvénient est que les informations recueillies par l’IA ne sont pas nécessairement stockées en toute sécurité. Les applications et les réseaux d’IA peuvent rendre ces informations sensibles vulnérables à l’exploitation des données par des tiers. Les smartphones et les voitures auto-conduites, par exemple, suivent la localisation des utilisateurs et leurs habitudes de conduite. Si ce logiciel de suivi est censé aider la technologie à mieux comprendre les habitudes pour servir plus efficacement les utilisateurs, il recueille également des informations personnelles dans le cadre d’ensembles de données volumineuses utilisés pour entraîner les modèles d’IA.

Pour les entreprises qui développent l’IA, le décret pourrait nécessiter une révision de la façon dont elles abordent leurs pratiques, selon Adnan Masood, architecte en chef de l’IA chez UST, une société de services de transformation numérique. Les nouvelles règles peuvent également entraîner une augmentation des coûts opérationnels dans un premier temps. « Toutefois, l’alignement sur les normes nationales pourrait également rationaliser les processus d’approvisionnement fédéraux pour leurs produits et favoriser la confiance des consommateurs privés », indique Adnan Masood. « En fin de compte, si la réglementation est nécessaire pour atténuer les risques de l’IA, elle doit être délicatement équilibrée avec le maintien d’un environnement propice à l’innovation ». Il poursuit : « Si nous faisons trop pencher la balance vers une surveillance restrictive, en particulier dans le domaine de la recherche, du développement et des initiatives de sources ouvertes, nous risquons d’étouffer l’innovation et de céder du terrain à des juridictions plus indulgentes à l’échelle mondiale », avant d’ajouter que « la clé réside dans l’élaboration de réglementations qui protègent les intérêts publics et nationaux tout en alimentant les moteurs de la créativité et du progrès dans le secteur de l’IA ».

Une réglementation pour lutter contre les biais intégrés

Adnan Masood a déclaré que la réglementation à venir de la Maison Blanche était « attendue depuis longtemps, et qu’il s’agit d’une bonne étape [à] un moment critique de l’approche du gouvernement américain pour exploiter et contenir la technologie de l’IA ». Il a ainsi déclaré : « J’ai des réserves quant à l’extension de la portée de la réglementation aux domaines de la recherche et du développement […] La nature de la recherche sur l’IA exige un niveau d’ouverture et d’examen collectif qui peut être étouffé par une réglementation excessive. Je m’oppose en particulier à toute contrainte susceptible d’entraver les initiatives d’IA à code source ouvert, qui ont été la force motrice de la plupart des innovations dans ce domaine. Ces plateformes collaboratives permettent d’identifier et de corriger rapidement les failles des modèles d’IA, renforçant ainsi leur fiabilité et leur sécurité ».

Cette technologie est également vulnérable aux biais intégrés, tels que les applications d’embauche assistées par l’IA qui ont tendance à choisir des hommes plutôt que des femmes, ou des candidats blancs plutôt que des minorités. Et comme les outils d’IA générative parviennent de mieux en mieux à imiter le langage naturel, les images et les vidéos, il sera bientôt impossible de discerner les faux résultats des vrais ; cela incite les entreprises à mettre en place des « garde-fous » contre les pires résultats, qu’il s’agisse d’efforts accidentels ou intentionnels de la part d’acteurs malveillants. Les efforts déployés par les États-Unis pour contrôler l’IA font suite à ceux déployés par les pays européens pour s’assurer que la technologie ne génère pas de contenu contraire aux lois de l’UE, notamment la pornographie enfantine ou, dans certains pays de l’UE, la négation de l’Holocauste. L’Italie a carrément interdit la poursuite du développement de ChatGPT pour des raisons de protection de la vie privée, après que l’application de traitement du langage naturel a été victime d’une violation de données impliquant des conversations d’utilisateurs et des informations de paiement.

L’UE, pionnière en matière de réglementation

Le règlement sur l’intelligence artificielle (AI Act) de l’Union européenne est la première du genre à être adoptée par un ensemble de pays occidentaux. La législation proposée s’appuie fortement sur les règles existantes, telles que le règlement général sur la protection des données (RGPD), la loi sur les services numériques et la loi sur les marchés numériques. La loi sur l’IA a été proposée à l’origine par la Commission européenne en avril 2021. Les États et les municipalités envisagent d’imposer leurs propres restrictions à l’utilisation de robots basés sur l’IA pour trouver, sélectionner, interviewer et embaucher des candidats à l’emploi, en raison de problèmes de confidentialité et de partialité. Certains États ont déjà adopté des lois. La Maison-Blanche devrait également s’appuyer sur l’Institut national des normes et de la technologie pour renforcer les lignes directrices de l’industrie en matière de test et d’évaluation des systèmes d’IA – des dispositions qui s’appuieraient sur les engagements volontaires en matière de sûreté, de sécurité et de confiance que l’administration Biden a obtenus de 15 grandes entreprises technologiques cette année en matière d’IA.

L’initiative de Joe Biden est d’autant plus importante que l’IA générative connaît un essor continu, qui se traduit par des capacités sans précédent en matière de création de contenu, de « deepfakes » et, potentiellement, de nouvelles formes de cybermenaces, affirme Adnan Masood. « Ce paysage montre clairement que le rôle du gouvernement n’est pas seulement celui d’un régulateur, mais aussi celui d’un facilitateur et d’un consommateur de la technologie de l’IA », ajoute-t-il. « En imposant des évaluations fédérales de l’IA et en soulignant son rôle dans la cybersécurité, le gouvernement américain reconnaît la double nature de l’IA, à la fois comme un atout stratégique et comme un risque potentiel ». Adnan Masood a déclaré être un fervent défenseur d’une approche nuancée de la réglementation de l’IA, car il est essentiel de superviser le déploiement des produits d’IA pour s’assurer qu’ils respectent les normes de sécurité et d’éthique. « Par exemple, les modèles d’IA avancés utilisés dans les soins de santé ou les véhicules autonomes doivent être soumis à des tests rigoureux et à des contrôles de conformité pour protéger le bien-être du public », conclut-il.

Le géant de la recherche Google a dévoilé six fonctionnalités supplémentaires de son navigateur Chrome pour les entreprises. Au programme : des outils de sécurité, mais aussi de surveillance et de reporting.

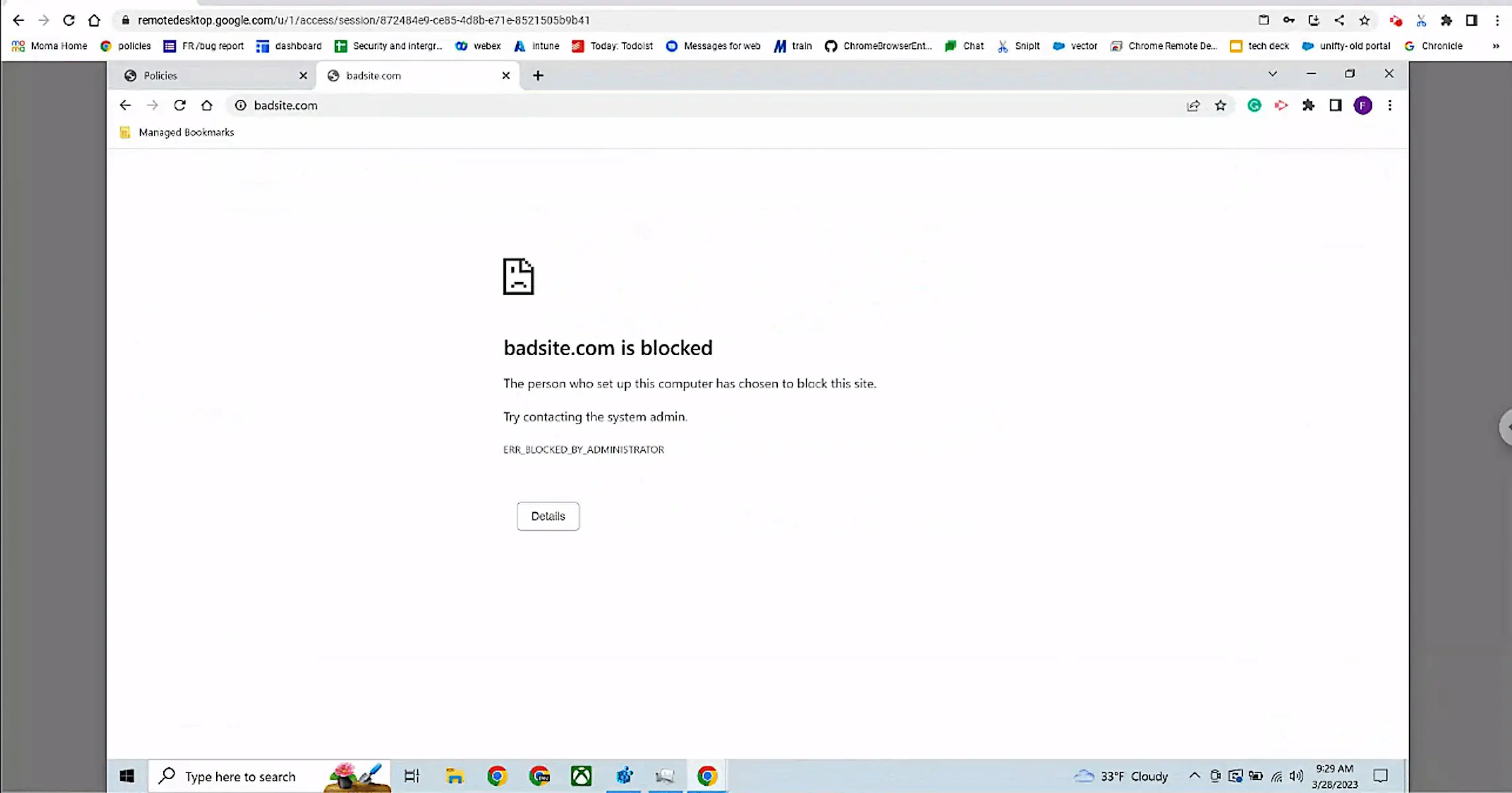

Google a déployé plusieurs fonctions supplémentaires pour les utilisateurs professionnels de son navigateur Chrome, notamment la prévention des pertes de données (DLP), des protections contre les logiciels malveillants et le phishing, ainsi que la possibilité d’activer un accès zero trust au moteur de recherche. Au total, Google a mis en avant six fonctions pour Chrome, dont trois sont spécifiques aux capacités DLP existantes du navigateur. Une fonction « context-aware », qui s’adresse aux administrateurs d’entreprise, leur donne les moyens de personnaliser les règles DLP en fonction du niveau de sécurité du terminal utilisé. Par exemple, ils peuvent autoriser les utilisateurs à télécharger des documents sensibles s’ils y accèdent à partir d’un système à jour d’un point de vue sécurité ou si un logiciel de protection est bien installé dessus.

Cette fonction contextuelle empêchera les utilisateurs de télécharger des documents sensibles sur des terminaux personnels ou d’entreprise qui ne répond pas à des critères de sécurité déterminés. Le filtrage d’URL est une autre fonction de DLP qui pourra aussi bloquer ou avertir les employés lorsqu’ils visitent des sites web ou des catégories de sites web qui ne respectent pas les règles d’usage de l’entreprise.

La fonction de filtrage d’URL de Google permet de bloquer ou d’avertir les employés des sites Web qui enfreignent les règles de l’entreprise. (Crédit : Google)

« Vous pouvez également restreindre l’accès, par exemple en empêchant les utilisateurs de visiter des sites de partage de fichiers populaires, tout en autorisant le partage de fichiers via le site de partage de fichiers de votre entreprise », explique Google dans un billet de blog.

Les extensions de navigateur pour prévenir tout risque

La firme a également annoncé deux extensions supplémentaires pour évaluer les risques dans Chrome. Les extensions de navigateur peuvent être dangereuses pour les utilisateurs en faisant accepter des autorisations qui ne sont pas conformes aux règles de l’entreprise. Selon Google, les outils CRXcavator et Spin.AI Risk Assessment de Chrome peuvent les évaluer pour minimiser les risques associés. « Nous rendons les scores des extensions via ces deux plateformes disponibles directement dans Chrome Browser Cloud Management, afin que les équipes de sécurité puissent avoir une vue d’ensemble des scores de risque des extensions utilisées dans leur environnement de navigation », a déclaré Google dans son annonce.

En mettant en œuvre un DLP avancé et en obtenant plus de visibilité sur la sécurité des extensions et les événements de sécurité critiques, les entreprises peuvent identifier les menaces et les vulnérabilités potentielles avant qu’elles ne soient exploitées, réduire le risque de perte de données et adopter une approche plus proactive de la cybersécurité. L’éditeur a également ajouté deux add-on de notifications d’événements de sécurité disponibles pour installation sur Chrome. Le premier, dédié à son installation, alerte les équipes informatiques et de sécurité afin de suivre leur usage. La seconde extension alerte ces mêmes équipes lorsqu’un navigateur se bloque sur un terminal, ce qui peut les aider à mener leurs investigations.

Les dernières fonctionnalités de sécurité de Google Chrome. (Crédit : Google)

Plus de services de sécurité dans les navigateurs d’entreprise

« L’impact est important car le navigateur représente un nouveau vecteur de sécurité pour les entreprises », a déclaré Dan Ayoub, analyste principal au Gartner. « Il étend les services de sécurité à l’edge pour résoudre de nombreux problèmes concrets que les solutions existantes peuvent avoir aujourd’hui, comme la fourniture d’un accès à partir d’appareils non gérés ». Le cabinet d’études américain s’attend à ce qu’un nombre croissant de services de sécurité soient fournis par le biais de navigateurs d’entreprise et d’extensions au cours du reste de la décennie, selon le cabinet d’études Gartner.

« Cela créera à terme une expérience de travail hybride transparente où les navigateurs deviendront la plateforme principale par laquelle les logiciels de productivité et de sécurité des employés seront fournis aux systèmes gérés et non gérés », affirme-t-il. Michael Suby, vice-président de la recherche pour le service de sécurité et de confiance d’IDC, a indiqué de son côté que le ciblage des cyberattaques par Google est approprié, car les navigateurs sont aussi vulnérables que n’importe quelle application située au-dessus du système d’exploitation. Toutefois, les fonctionnalités supplémentaires risquent de poser un problème à de nombreuses sociétés.

La multiplication des outils de sécurité, bonne ou mauvaise idée ?

Il existe déjà des navigateurs tiers spécialement conçus pour les entreprises et dotés de fonctions de sécurité similaires à celles annoncées par Chrome. Par exemple, Island.io et Talon Cyber Security sont deux des navigateurs d’entreprise les plus populaires. « Comment fusionner ce qu’ils me donnent avec ce que j’ai déjà ? » a déclaré M. Suby. En outre, de nombreuses applications d’entreprise intègrent déjà des fonctions de sécurité. « Il s’agit d’ajouter un autre outil de politique qui doit être géré. C’est bien beau d’avoir ces nouvelles fonctionnalités dans Chrome, et en soi, elles peuvent être intuitives à utiliser, mais elles ne font que s’ajouter à ce que vous avez déjà », a déclaré M. Suby. « Cela ne veut pas dire qu’elles ne sont pas utiles, mais j’ai maintenant quelque chose de plus à gérer ».

Qui va gérer et contrôler ces fonctionnalités et décider lesquelles l’entreprise doit utiliser ? « Est-ce que je gère les politiques de sécurité sur les applications ? Dans quel environnement dois-je appliquer les politiques ? », interroge M. Suby. Un autre problème est qu’il n’existe actuellement aucune entreprise tierce qui teste de manière indépendante les capacités de sécurité des navigateurs. Certes on trouve des logiciels antivirus tels que AV-Comparatives et d’évaluation de la protection des endpoints telles que Mitre Engenuity, mais aucun pour sécuriser les navigateurs, a déclaré M. Suby. « C’est une bonne direction que prend [Google], il n’y a rien de mal à cela » poursuit-il avant de conclure : « Ils voient un problème et essaient d’aider les entreprises à le résoudre. Mais ce faisant, nous avons créé une série de problèmes sous-jacents ».

Après s’être vu infliger une amende de plus de 200 millions de dollars l’année dernière pour des infractions similaires, Morgan Stanley a commencé à pénaliser les employés qui utilisent des applications de messagerie personnelles dans le cadre professionnel. Une posture difficile à tenir dans le temps observe un expert.

La banque d’investissement Morgan Stanley a sanctionné certains de ses employés par des sanctions dépassant le million de dollars pour avoir enfreint les règles de conformité en utilisant WhatsApp et iMessage pour des communications professionnelles. Selon un article du Financial Times, les sanctions ont été infligées sous la forme d’une réduction des primes précédentes ou des salaires futurs. Si ces punitions peuvent sembler salées, Morgan Stanley elle-même a dû payer des millions de dollars d’amendes pour des violations antérieures de la SEC liées à l’utilisation d’applications de messagerie grand public à des fins professionnelles. En septembre dernier, le régulateur américain a infligé des amendes d’un montant total de 1,8 milliard de dollars à de grandes banques et sociétés de courtage pour l’utilisation par leurs employés d’applications de messagerie privée pour discuter de leur travail et pour ne pas avoir toujours sauvegardé ces messages. Les peines comprennent 1,1 milliard de dollars évalués par la SEC et une amende de 710 millions de dollars de la Commodity Futures Trading Commission (CFTC).

Morgan Stanley fait partie de la douzaine de sociétés de services financiers condamnées et a dû payer plus de 200 millions de dollars. En 2020, la firme a subi un incident de sécurité provoqué par deux cadres de la division matière première qui utilisaient des applications de messagerie personnelle. Ils ont été licenciés pour faute. Dans l’affaire jugée en septembre 2022, la banque a choisi de sanctionner financièrement les fautifs allant de quelques milliers de dollars à plus d’un million de dollars par personne. Les pénalités étaient basées sur un système de points qui prend en compte des facteurs tels que le nombre de messages envoyés, l’ancienneté du banquier et le fait qu’il ait reçu ou non des avertissements préalables, ont déclaré des personnes au courant de l’affaire, selon plusieurs articles.

Les employés utilisent ce qui est le plus pratique

Shiran Weitzman, CEO de Shield, éditeur de sécurité sur mobile, a déclaré que l’imposition d’interdictions sur des applications de communication populaires telles que WhatsApp et iMessage était une solution temporaire. Les employés vont finir par utiliser ce qui est le plus populaire et le plus pratique. La série de pénalités infligées l’année dernière aux services financiers par les autorités de réglementation pour utilisation abusive des plateformes de messagerie a été un coup de semonce – une déclaration selon laquelle le secteur devait faire le ménage et « mettre de l’ordre dans la maison », a-t-il ajouté. Le problème, cependant, c’est que le secteur bancaire et d’autres entreprises offrant des services commerciaux très personnalisés voient souvent les employés adopter simplement les plateformes de communication les plus pratiques.

« Les exigences pour WhatsApp ou iMessage sont similaires à celles de n’importe quel canal de communication utilisé par une banque – email, Slack, Microsoft Teams, Zoom, peu importe. Toute personne communiquant au nom de la banque […] doit être surveillée », a déclaré Shiran Weitzman. « Avec les technologies d’aujourd’hui, c’est faisable. Pourquoi ne l’ont-ils pas fait, c’est une autre question. J’ai mes suppositions ». Il poursuit : « Ce n’est pas une question de technologie, […] c’est très difficile pour eux de [changer]. Ce sont de grandes organisations et chaque fois qu’elles doivent appliquer une nouvelle technologie ou une contrainte, elles doivent le faire à un niveau mondial ».

Allier technologie et sécurité pour la bonne santé des affaires

Pendant la pandémie, les banquiers contraints de travailler à distance se sont mis à l’aise en utilisant les plateformes de messagerie grand public les plus populaires, car leurs clients s’en servaient également. Elles étaient tout simplement plus pratiques et, à l’époque, les sociétés de services financiers ont relâché leur surveillance sur ces services. Selon M. Weitzman, les banques doivent s’efforcer d’activer les meilleurs outils avec des logiciels de sécurité et de surveillance, qui utilisent des API pour suivre les communications et signaler les communications suspectes tout en préservant la confidentialité des conversations.

Bien que cela soit possible, interdire aux employés d’utiliser les dernières technologies de communication n’est pas propice à la bonne marche des affaires. « WhatsApp et iMessage, c’est de l’anticipation », a déclaré Shiran Weitzman. « Vous devez être en mesure d’enregistrer les communications. Et, l’employé doit être informé et donner son consentement. Mais je pense qu’il faudra du temps pour que ce message parvienne aux [entreprises de services financiers], et je crains qu’il y ait des amendes supplémentaires avant que cela ne se produise ».