Le service NS1 Connect proposé par IBM peut prendre des décisions dynamiques sur l’endroit où envoyer des requêtes Internet pour assurer les meilleures connexions dans des environnements réseau complexes et distribués.

Lancé par IBM, le service NS1 Connect basé sur le DNS doit permettre aux clients de contrôler en toute sécurité la connectivité entre les environnements multicloud distribués. NS1 Connect est l’un des premiers produits résultant de l’acquisition par IBM du spécialiste du DNS NS1 en début d’année. Le service, dont la disponibilité est annoncée pour le 17 octobre, promet d’aider les entreprises à établir la meilleure connexion entre les clouds et les utilisateurs finaux, le but étant de fournir des applications optimisées en termes de performance, de coût, de sécurité et de disponibilité. La technologie de pilotage du trafic, au cœur de l’offre NS1 Connect, distribue intelligemment le trafic DNS sur le réseau. Le DNS est souvent décrit comme l’annuaire téléphonique d’Internet, travaillant en arrière-plan pour faire correspondre les noms des sites web que les utilisateurs tapent dans une boîte de recherche avec l’adresse IP associée. « Les services DNS avancés de NS1 Connect peuvent prendre des décisions dynamiques quant à l’endroit où envoyer une requête Internet, en fonction de la disponibilité, des performances, de l’heure et de nombreux autres calculs », a expliqué dans un blog Andrew Coward, directeur général des réseaux SDN chez IBM.

« Les règles les plus courantes de pilotage du trafic consistent à éviter les points d’extrémité indisponibles, surchargés ou peu performants », a écrit IBM dans une note d’information sur le service. « NS1 propose un ensemble de contrôles de base pour suivre l’état de fonctionnement d’un point d’extrémité. Éventuellement, il est possible d’utiliser l’une des intégrations de service de monitoring pour obtenir des données collectées par des systèmes de contrôle de tierces parties sur la plate-forme NS1 afin d’informer le pilotage du trafic », a déclaré IBM. « Si cela est inclus dans le compte NS1 du client, ce dernier peut configurer des applications et des tâches basées sur le RUM (Real User Monitoring) pour obtenir des métriques de disponibilité et de performance en temps réel à partir de sources de données partagées ou privées vers la plate-forme NS1 afin d’optimiser l’équilibrage de la charge sur des réseaux complexes et mondiaux », a encore expliqué big blue.

Suivi granulaire des performances DNS

Les clients peuvent configurer le système pour saisir des données provenant de divers systèmes de gestion tiers, comme Cisco ThousandEyes et AppDynamics, Datadog, Amazon Web Services (AWS), Rackspace, CloudWatch et Catchpoint. « Indépendamment de l’origine du trafic de ses clients dans le monde – Boston, San Paulo, Tokyo, Nairobi, Paris – la réponse du DNS pour savoir où acheminer ce trafic peut être différente et peut varier en fonction des réseaux de diffusion de contenu (Content Delivery Network, CDN) occupés, du montant payé pour le transit et du niveau d’équilibre du trafic que l’on essaye d’atteindre », a écrit M. Coward. Les clients de NS1 Connect obtiennent également des rapports DNS sur les requêtes par seconde (Queries per Second, QPS) et la distribution globale du trafic. Ils peuvent servir à détecter les baisses ou les hausses soudaines du trafic DNS et à comparer le trafic des domaines entre les réseaux. Une fonction appelée NS1 DNS Insights utilise ce qu’IBM appelle des flux de données légers pour fournir une vue granulaire des performances, des tendances et des anomalies. « Les clients disposent ainsi des informations nécessaires pour améliorer les performances et la sécurité du système tout en réduisant les coûts d’exploitation », a déclaré IBM. Le système supporte les extensions de sécurité DNS (DNS Security Extensions, DNSSEC), qui authentifient les consultations de noms de domaine et contribuent à la protection contre le détournement de DNS.

Enterprise Management Associates (EMA) a récemment constaté que le détournement de DNS, également connu sous le nom de redirection DNS, est l’un des problèmes de sécurité DNS les plus épineux pour les services IT des entreprises. Le détournement de DNS consiste à intercepter les requêtes DNS des appareils clients afin que les tentatives de connexion aboutissent à la mauvaise adresse IP. Les pirates y parviennent souvent en infectant les clients avec des logiciels malveillants de façon à diriger les requêtes vers un serveur DNS malveillant, ou en piratant un serveur DNS légitime et en détournant les requêtes à une échelle plus massive. « Ce dernier modus operandi peut avoir un impact étendu, d’où l’importance pour les entreprises de protéger l’infrastructure DNS contre les pirates », selon EMA. « Au-delà de la gestion des DNS, les administrateurs de comptes peuvent gérer les utilisateurs, les équipes et les clés API afin de garantir des niveaux d’accès appropriés en fonction du rôle ou de la fonction de l’utilisateur », a déclaré IBM. Big blue n’est pas le seul à se positionner sur ce marché, un acteur français comme EfficientIP propose depuis longtemps des solutions pour sécuriser et maitriser ses DNS.

Une solution taillée pour le cloud hybride

Outre NS1 Connect, IBM développe un paquet SaaS pour aider les entreprises à mettre en réseau des environnements hétérogènes de manière sécurisée, y compris des ressources edge, sur site et multicloud. Selon M. Coward, « le service SaaS IBM Hybrid Cloud Mesh implemente un environnement virtualisé de couche Layer 3-7 pour mettre rapidement en place une connectivité sécurisée entre les utilisateurs, les applications et les données sur plusieurs sites et environnements distribués. « Hybrid Cloud Mesh déploie des passerelles dans les clouds – y compris sur site, sur AWS ou les clouds d’autres fournisseurs, et sur des points de transit, si nécessaire – pour prendre en charge l’infrastructure, puis il construit une couche Layer 3-7 maillée sécurisée pour délivrer des applications », a encore déclaré M. Coward. « Au niveau de l’application, les développeurs sont exposés à la couche Layer 7, et les équipes réseau voient les activités des couches Layer 3 et Layer 4 », a ajouté M. Coward. L’offre Hybrid Cloud Mesh est disponible en test pour quelques entreprises avant une disponibilité générale prévue d’ici à la fin de l’année.

Selon l’entité X-Force d’IBM, la principale cause de compromission du cloud est liée à l’utilisation inappropriée d’informations d’identification, d’où la nécessité pour les équipes IT de renforcer leurs pratiques de gestion des identifiants.

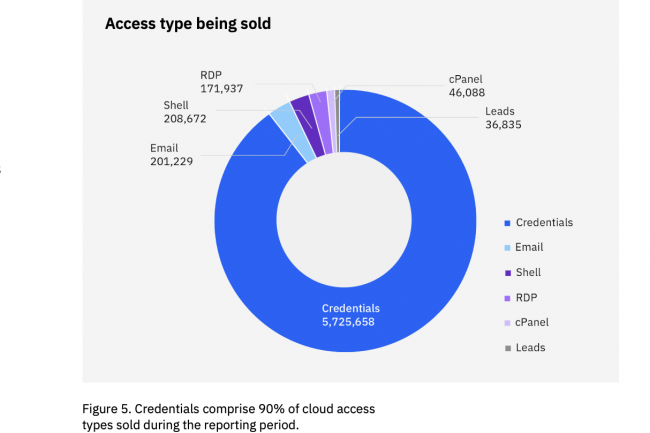

Alors que la connectivité aux ressources basées sur le cloud se développe, les cybercriminels utilisent des identifiants valides, mais compromis, pour accéder aux ressources de l’entreprise à un rythme alarmant. C’est l’une des principales conclusions du IBM X-Force Cloud Threat Landscape Report, qui fait également état d’une augmentation de 200 % (environ 3 900 vulnérabilités) des Vulnérabilités et Expositions Communes (Common Vulnerabilities and Exposures, CVE) au cours de l’année écoulée. « Plus de 35 % des incidents de sécurité liés au cloud résultent de l’utilisation par les attaquants d’informations d’identification valides et compromises », a écrit Chris Caridi, analyste stratégique des cybermenaces chez IBM X-Force, dans un blog consacré au rapport. « Les identifiants représentent près de 90 % des actifs vendus sur les places de marché du dark web, à un prix moyen de 10 dollars par annonce, soit l’équivalent d’une douzaine de donuts, c’est dire leur popularité auprès des cybercriminels ».

L’accès des utilisateurs à des environnements multicloud et à leurs ressources à partir de la périphérie, de succursales ou d’un réseau distant étant de plus en plus répandu, il est clair que les entreprises doivent revoir à la baisse les privilèges d’accès que les services IT accordent à ces utilisateurs. De fait, dans 33 % des engagements impliquant des environnements cloud, X-Force a trouvé des informations d’identification en texte clair sur les terminaux des utilisateurs. « Très souvent, nous avons trouvé des identifiants de comptes de service stockés sur les terminaux des utilisateurs, et beaucoup d’entre eux avaient des privilèges excessifs, c’est-à-dire qu’ils disposaient de plus d’autorisations qu’ils n’en ont besoin pour effectuer leur travail ou leur tâche », indique le rapport. « Les informations d’identification compromises sont à l’origine de plus d’un tiers des incidents liés au cloud observés par l’équipe X-Force, ce qui suggère que les entreprises doivent trouver un équilibre entre les besoins d’accès des utilisateurs et les risques de sécurité », indique encore l’étude.

Détournement de bande passante

« Une fois qu’ils ont réussi, les cybercriminels peuvent profiter de cet accès pour mener à bien leur objectif final, par exemple, déployer des mineurs de cryptomonnaies, des ransomwares et d’autres types de logiciels malveillants », a déclaré X-Force. « Des solutions de protection des identités alimentées par l’IA peuvent aider les entreprises à identifier les anomalies comportementales en profondeur et à vérifier l’identité des utilisateurs », indique par ailleurs le rapport. Parmi les autres vecteurs d’attaque courants figurent l’exploitation d’applications utilisées par le public et les liens de phishing/spear phishing, qui représentent chacun environ 14 % des incidents auxquels l’équipe de X-Force a répondu. « Les identifiants Microsoft Outlook Cloud mentionnés plus de 5 millions de fois sur les places de marché illicites sont de loin le type d’accès le plus populaire vendu sur ces plateformes », a déclaré M. Caridi. « L’exploitation des vulnérabilités dans les applications qui servent d’interface avec le public représente un vecteur d’accès éprouvé pour les acteurs de la menace, dans les environnements cloud comme dans les environnements sur site », indique encore le rapport. « Les applications cloud sont généralement plus difficiles à gérer pour les entreprises en raison du nombre croissant d’applications et de services utilisés dans un environnement moderne, cloud ou cloud hybride », indique à ce sujet le rapport. « Si elles ne sont pas mises en œuvre correctement, on peut facilement négliger une application obsolète fonctionnant dans le cloud ou pire, ignorer que l’application est en cours d’utilisation ».

Voici quelques-unes des autres conclusions du rapport :

– L’équipe X-Force a constaté que des cyberpirates parvenaient à installer des proxyware – un outil légitime de segmentation du réseau – à l’insu des victimes, afin de revendre la bande passante des ordinateurs de ces victimes. Les recherches suggèrent qu’une campagne de proxyjacking pourrait rapporter aux acteurs de la menace environ 9,60 dollars par 24 heures et par adresse IP, et que son déploiement par Log4j pourrait rapporter 220 000 dollars par mois. En outre, le proxyjacking peut entraîner des frais importants pour les victimes de la part des fournisseurs de services cloud, en raison de l’augmentation de ce trafic web hors de contrôle.

– Près de 60 % des vulnérabilités récemment divulguées pourraient, si elles sont exploitées, permettre aux attaquants d’obtenir des informations ou un accès ou des privilèges pour se déplacer latéralement dans le réseau. Que ce soit pour fournir aux cyberpirates des informations sur la configuration des environnements ou un moyen de s’authentifier sans autorisation pour obtenir des permissions supplémentaires, il est essentiel pour les entreprises de savoir quels risques sont prioritaires, en particulier quand elles disposent de ressources limitées.

– L’outil d’administration à distance Chaos Remote Administrative Tool (Trojan.Linux.CHAOSRAT) est déployé en tant qu’outil d’accès à distance (Remote Access Tool, RAT). Les fonctions de RAT Chaos comprennent le téléchargement, le chargement et la suppression de fichiers en mode reverse shell, des captures d’écran, la collecte d’informations sur le système d’exploitation, l’arrêt et le redémarrage de l’hôte, ainsi que l’ouverture d’URL. Ce RAT témoigne de la sophistication et de l’évolution des acteurs des menace basées sur le cloud.

Miser sur le zero trust

Suite à ces découvertes, les chercheurs de X-Force ont fait un certain nombre de suggestions. Par exemple, ils pensent que les clients devraient utiliser des technologies de sécurité zero trust, y compris la mise en œuvre de l’authentification multifactorielle (MFA) et le principe du moindre privilège. « Cette stratégie est particulièrement importante pour les clouds privés qui peuvent interagir régulièrement avec d’autres actifs sur site », indique le rapport. « Il faut moderniser la gestion des identités et des accès (IAM) pour réduire la dépendance à l’égard des combinaisons de noms d’utilisateur et de mots de passe et lutter contre le vol d’identifiants par des acteurs de la menace », ont-ils encore suggéré. Ces derniers ont également recommandé d’utiliser des capacités basées sur l’IA pour examiner de plus près les identités et les comportements numériques, vérifier leur légitimité et fournir une authentification plus intelligente. Le rapport sur le paysage des menaces est basé sur des données recueillies par X-Force threat intelligence, des tests de pénétration, des engagements de réponse aux incidents, Red Hat Insights et des données fournies par le contributeur du rapport Cybersixgill entre juin 2022 et juin 2023.

Le module Secure Application de Cisco étend les capacités de sécurité de sa plateforme d’observabilité Full Stack Observability (FSO) du fournisseur.

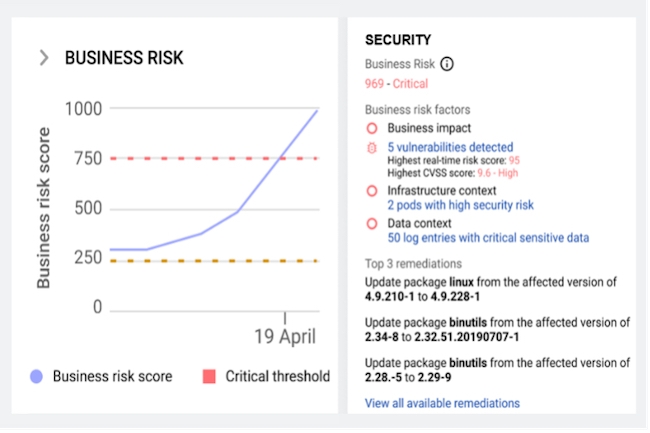

Disponible dès maintenant au sein de la plateforme d’observabilité de Cisco, le module Secure Application vent aider les entreprises à évaluer les risques de menaces et à protéger leurs ressources basées sur le cloud. La solution Full Stack Observability (FSO) de l’équipementier sert à corréler les données provenant des applications, du réseau, de l’infrastructure, de la sécurité et du cloud afin de permettre aux clients de repérer plus facilement les anomalies, d’anticiper et de résoudre les problèmes de performance et d’améliorer l’atténuation des menaces à partir des métriques, des événements, des journaux et des traces. « Via la plateforme, les entreprises peuvent consolider leurs outils, collecter des données à partir de n’importe quelle source, corréler les informations et effectuer une analyse pilotée par l’IA pour prédire et prévenir les problèmes », avait déclaré Cisco en juin lors du lancement de FSO.

Secure Application combine des données provenant de sources multiples pour générer un score de risque métier pour les applications ou les services susceptibles d’être exploités et attaqués. Le module est capable d’évaluer la gravité des vulnérabilités et de donner la priorité à celles qui sont les plus urgentes. Comme l’a expliqué Carlos Pereira, architecte en chef du groupe Strategy, Incubation and Applications de Cisco, le module rassemble des données provenant du Kenna Risk Meter, des informations détaillées sur les transactions commerciales provenant d’AppDynamics, des informations détaillées sur les API provenant de son logiciel Panoptica et des données de renseignement sur les menaces provenant de Talos, la branche de recherche sur la sécurité de la firme de San José. Secure Application travaille ensuite avec Cloud Native Application Observability, un autre module de FSO axé sur la gestion de la performance des applications, pour aider les clients à s’assurer que les applications agissent conformément aux attentes de l’utilisateur final. « Cloud Native Application Observability informe sur la santé et l’état des applications à l’intérieur d’éléments natifs du cloud tels que les conteneurs, les microservices, les outils d’orchestration comme Kubernetes », a déclaré M. Pereira.

Mieux protéger les applications dans les clouds

« L’idée est d’aider les entreprises à sécuriser plus efficacement les applications natives du cloud en se basant sur l’analyse des vulnérabilités en temps réel et l’observabilité des risques métiers », a encore déclaré M. Pereira. « Cisco ajoute un contexte métier aux résultats de sécurité et rassemble les données de performance des applications avec les renseignements de sécurité provenant des produits de sécurité de l’équipementier. Cela permet aux équipes de localiser, d’évaluer et de hiérarchiser rapidement les risques et de remédier aux problèmes de sécurité en fonction de l’impact potentiel sur l’entreprise », a ajouté l’architecte en chef. « Cisco Secure Application aide les entreprises à faire travailler ensemble les équipes chargées des applications et de la sécurité pour sécuriser le développement et les déploiements d’applications modernes. Les équipes disposent d’une visibilité élargie et d’informations intelligentes pour hiérarchiser et répondre en temps réel aux risques de sécurité ayant un impact sur le chiffre d’affaires et pour réduire les profils de risque organisationnels globaux », a déclaré M. Pereira.

Protéger la sécurité des applications est une priorité croissante du multicloud. IDC a récemment prédit que le marché de la protection et de la disponibilité des applications passera de 2,5 milliards de dollars en 2021 à 5,7 milliards de dollars en 2026. « La composante applicative de l’architecture de sécurité moderne a été négligée dans les frameworks de sécurité modernes », a écrit IDC dans ses prévisions les plus récentes sur le marché mondial de la protection et de la disponibilité des applications. « La confiance zéro se concentre sur les applications internes, tandis que les solutions de détection et de réponse étendues (Extended Detection and Response, XDR) exploitent la télémétrie des menaces des applications web. Pour les fournisseurs de solutions de protection et de disponibilité des applications, la stratégie d’intégration dans ces frameworks permettra d’accroître la valeur ajoutée pour les clients grâce à l’amélioration du temps de détection », a encore écrit IDC. Toujours selon le cabinet d’études, l’état moderne de la cybersécurité se concentre sur une large visibilité combinée à des analyses avancées pour détecter les menaces. Les identités, les terminaux, les réseaux, les appareils et les données ont tous un rôle à jouer. « Ces sources sont des points de contrôle pour la détection et la prévention des menaces, tout en apportant la télémétrie et les informations clés nécessaires pour détecter les attaques furtives ou avancées », a précisé le cabinet d’études américain.

Outre Secure Application et Cloud Native Application Observability, la plateforme FSO de Cisco comprend plusieurs autres modules dont :

– Cost Insights : ce module fournit une visibilité et des informations sur les coûts au niveau de l’application, parallèlement aux mesures de performance.

– Application Resource Optimizer : ce module fournit une visibilité sur l’utilisation des ressources de la charge de travail dans le cloud.

– Business risk observability for cloud environments : construit sur la plateforme FSO et Secure Application, il aide les entreprises à sécuriser les applications natives du cloud en se basant sur l’analyse des vulnérabilités en temps réel et l’observabilité des risques.

– AIOps : ce module offre un aperçu des données relatives à l’infrastructure, au réseau, aux incidents et à la performance d’une application commerciale.

La plateforme FSO s’intègre également à divers systèmes tiers, dont :

– Cloudfarix vSphere Observability and Data Modernization : cette solution surveille les données vSphere et les met en corrélation avec Kubernetes et les données d’infrastructure pour générer des aperçus et recommander des actions à travers l’infrastructure et la pile d’applications conteneurisées.

– Evolutio Fintech : cette application de technologie financière permet aux clients d’obtenir des informations commerciales en surveillant les indicateurs clés de performances basés sur des données telles que les paiements et les autorisations de cartes de crédit.

– Kanari Capacity Planner and Forecaster : cet outil offre une visibilité sur les séries chronologiques de données associées à la planification des capacités et aux événements prévus, ainsi que sur les facteurs de risque déterminés par des algorithmes prédictifs de ML.

L’offre FortiSASE s’enrichit de capacités de surveillance des applications et des outils pour gérer en toute sécurité les réseaux LAN sans fil et les appareils IoT.

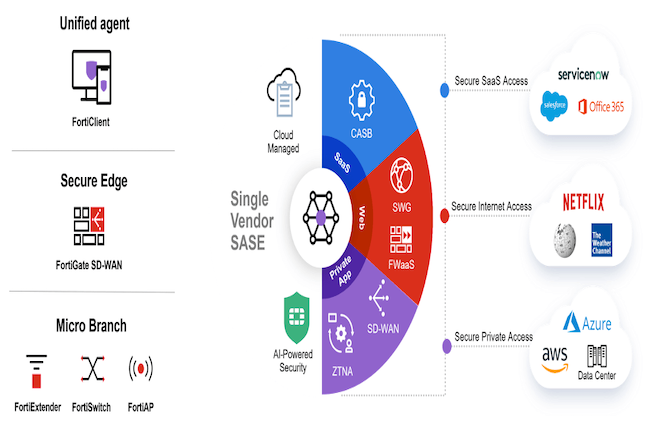

L’équipementier Fortinet fait encore évoluer son offre FortiSASE en la dotant du support des microbranches, en étendant les protections des réseaux LAN sans fil et en renforçant ses capacités de prévention de pertes de données (Data Loss Prevention, DLP) et de surveillance des utilisateurs finaux. La plateforme Secure Access Service Edge (SASE) du fournisseur comprend un SD-WAN, une passerelle web sécurisée (Secure Web Gateway, SWG), un pare-feu en tant que service (Firewall as a service, FaaS), un courtier en sécurité d’accès au cloud (Cloud Access Security Broker, CASB), et un accès réseau zero trust (Zero Trust Network Access, ZTNA), le tout fonctionnant au-dessus du système d’exploitation FortiOS maison. L’ensemble peut être géré de manière centralisée via le logiciel FortiManager de l’entreprise, qui définit les politiques de réseau et de sécurité pour l’ensemble des produits Fortinet. Lors de la dernière mise à jour SASE, Fortinet avait déclaré qu’il intégrerait son portefeuille LAN sans fil ainsi que la prise en charge d’une myriade d’appareils IoT. « L’idée est que les clients puissent gérer le WLAN, l’IoT et tous les autres composants SASE, tels que le SD-WAN, en toute sécurité à partir d’un seul et même endroit », avait déclaré Nirav Shah, vice-président des produits et des solutions chez Fortinet. « Désormais, nos milliers de points d’accès sans fil FortiAP déployés aujourd’hui dans le monde entier peuvent être complètement intégrés dans notre pile de sécurité dans le cloud », a-t-il ajouté.

« Les améliorations apportées au WLAN et à l’IoT sont conformes à notre projet d’extension de FortiSASE aux microbranches, qui ne disposent souvent pas de produits de sécurité avancés ou de personnel pour protéger ces ressources », a ajouté M. Shah. « Les entreprises qui possèdent de nombreuses microbranches, comme les établissements de santé, les commerces de détail, les banques et les sites de production, peuvent envoyer le trafic WLAN et IoT des microbranches vers les points de présence SASE de Fortinet pour une inspection de sécurité », a ajouté M. Shah. « Les protections de niveau entreprise, comme le sandboxing, la prévention des intrusions, le filtrage des URL, les pare-feu, l’inspection du trafic, sont étendues aux microbranches sans que les entreprises aient besoin d’ajouter d’appareils ou de services supplémentaires », a encore expliqué Nirav Shah. Outre l’extension des microbranches, le fournisseur a ajouté le support SASE à son offre FortiGuard DLP. « Toutes les entreprises se doivent de protéger leurs données sensibles, surtout à l’heure où tant de ressources sont distribuées », a déclaré le vice-président des produits et des solutions de Fortinet. « Le service DLP permet de s’assurer qu’un utilisateur distant ne transmet pas, par inadvertance ou par malveillance, des données clés de l’entreprise. Le service DLP inclut désormais davantage de données nominatives, de types de fichiers et d’applications SaaS, et de techniques avancées de mise en correspondance des données afin d’éviter les fuites de données involontaires », a indiqué M. Shah.

Surveillance des outils SaaS

Pour s’assurer que les applications distribuées des utilisateurs finaux se comportent correctement, Fortinet a ajouté la surveillance des solutions SaaS (Digital Experience Monitoring, DEM) à son offre SASE. « Grâce au DEM, les clients peuvent surveiller les performances des applications SaaS, y compris WebEx, Office365 et Dropbox », a précisé M. Shah. « Le DEM étant pris en charge au sein de notre réseau cloud, les clients peuvent facilement voir les applications connectées. Ainsi, en cas de problème particulier, les entreprises peuvent rapidement le localiser et le résoudre », a ajouté M. Shah. À l’instar de Cisco, Cato, Versa, VMware, Palo Alto et d’autres, avec lesquels Fortinet est en concurrence sur le dynamique marché du SASE à fournisseur unique, le fournisseur cherche aussi à renforcer son offre SASE avec des options de sécurité importantes pour les entreprises clientes. Toutes ces fonctionnalités de FortiSASE devraient être disponibles en septembre.

Détection améliorée des malwares, microsegmentation et IA générative viennent compléter l’offre de Versa Networks pour protéger les ressources de l’entreprise.

Versa Networks renforce les fonctions IA de gestion de la sécurité de son offre SASE (Secure Access Service Edge) intégrée avec de la détection améliorée des logiciels malveillants pour protéger contre les menaces avancées (Advanced Threat Protection, ATP), de la microsegmentation du réseau et une protection basée sur l’IA générative afin d’aider les clients à mieux détecter et à atténuer rapidement les menaces pouvant affecter leurs services et applications en réseau. L’offre SASE intégrée de Versa inclut un SD WAN, un firewall de nouvelle génération et un pare-feu d’application web, des capacités de prévention des intrusions, le support zero-trust et la prévention de la perte de données (DLP).

La plateforme Versa SASE fonctionne en intégrant des données télémétriques provenant de divers produits réseau de Versa, que ce soit le WAN Edge, le Cloud, le Campus, les sites distants, les utilisateurs et les appareils, dans un lac de données unifié. VersaAI puise ensuite dans ce lac de données pour y extraire des informations d’IA/ML. « Notre avantage réside dans notre capacité à former et à corréler les données à travers une vaste télémétrie unifiée de sécurité et de réseau », a déclaré Kumar Mehta, fondateur et directeur du développement de Versa Networks dans un communiqué. « Grâce à notre base étendue de déploiement SASE, les données de télémétrie sont exploitées pour affiner les grands modèles de langage (LLM) afin de renforcer la sécurité en temps réel avec un degré élevé de précision et d’automatisation, et d’optimiser les opérations et les performances du réseau », a ajouté le fondateur.

Prévention des pertes de données grâce à l’IA

À cette fin, l’entreprise a doté son offre SASE de capacités IA/ML de détection améliorée de logiciels malveillants pour protéger contre les menaces avancées. L’idée est de mettre en place ce que Versa appelle une IA/ML à plusieurs étapes qui examine le trafic en temps réel pour trouver des fichiers et des extraits de code afin d’identifier les logiciels malveillants. De plus, désormais, Versa AI peut utiliser l’User and Entity Behavior Analytics (UEBA) de la plateforme pour évaluer le comportement de l’utilisateur et isoler les menaces potentielles en microsegments en temps réel. « Les menaces potentielles sont identifiées au plus près de l’hôte, ce qui limite le rayon d’action d’une éventuelle attaque à l’intérieur du périmètre de l’entreprise », a déclaré le fournisseur.

Autre nouveauté : une prévention des pertes de données soutenue par l’IA. Cette capacité fait appel à de grands modèles de langage (LLM) pour effectuer une analyse contextuelle plus fine et améliorer la reconnaissance des motifs afin d’identifier les données sensibles. « L’idée est de protéger les entreprises contre les fuites d’informations propriétaires, y compris le code source et les informations personnelles identifiables (Personal Identifiable Information, PII) dans les fenêtres d’invite, les documents et les images », a déclaré Versa. Une autre caractéristique essentielle de VersaAI est son chatbot en langage naturel, Verbo, et son noyau d’apprentissage automatique appelé VANI. « Versa a ajouté à ces fonctionnalités une fonction Predictive Traffic Steering que les clients peuvent utiliser pour ajuster de manière préventive les chemins de trafic en temps réel afin d’éviter les problèmes de dégradation ou d’accessibilité, et maintenir les accords de niveau de service (SLA) des applications et du réseau », a encore déclaré le fournisseur.

Mieux contrôler l’usage de ChatGPT

Désormais, VersaAI permet aussi aux clients de définir une politique pour empêcher le téléchargement de données sensibles dans des outils d’IA générative comme ChatGPT. « Si ChatGPT offre des avantages en termes de productivité, il présente des risques, notamment de fuites de données potentielles en raison de son entraînement sur de vastes ensembles de données », a écrit Sridhar Iyer, directeur ML/AI chez Versa Networks, dans un blog sur la sécurisation de l’IA générative. « Comme d’autres outils SaaS, ChatGPT est vulnérable aux abus d’identification et aux accès involontaires. De plus, il pose des problèmes de confidentialité, car les utilisateurs peuvent involontairement partager des informations sensibles », a ajouté M. Iyer. « Les contrôles de données peuvent empêcher l’accès non autorisé ou involontaire à des données sensibles. Les entreprises doivent également s’assurer qu’elles disposent d’une bonne visibilité sur l’activité de l’IA générative, notamment en surveillant régulièrement les journaux et les événements du système afin de suivre les interactions et d’identifier rapidement les activités malveillantes », a encore écrit M. Iyer.

Comme les autres fournisseurs du marché des SASE intégrés, à fournisseur unique, parmi lesquels on trouve Cisco, Aruba de HPE, Fortinet, Palo Alto et d’autres, Versa cherche à renforcer son offre SASE et à rester en tête de ce marché en fort développement avec des options de sécurité utiles pour les clients d’entreprise. Selon Gartner, la tendance au SASE à fournisseur unique est en pleine croissance et d’ici à 2025, le nombre de fournisseurs proposant des offres SASE à fournisseur unique généralement disponibles augmentera de plus de 50 % par rapport à la mi-2023 et d’ici à 2026, 60 % des nouveaux achats de SD-WAN feront partie d’une offre SASE à fournisseur unique, contre 15 % en 2023.

Pour renforcer les environnements de réseaux d’entreprise et de cloud hybride, Aruba Networks améliore sa plateforme de sécurité, en la dotant notamment des fonctions zero trust et de sandboxing.

Les améliorations apportées par Aruba Networks à sa plateforme de sécurité, notamment des fonctions zero trust et de sandboxing, promettent de renforcer la sécurité des environnements de cloud hybride et de réseaux d’entreprise. La filiale réseau de Hewlett Packard Enterprise (HPE) a également évoqué les progrès réalisés dans l’intégration de la technologie de sécurité issue du rachat d’Axis Security en mars dernier à sa plateforme SSE (Security Service Edge) et à ses offres SD-WAN et SASE (Secure Access Services Edge). Certaines de ces fonctionnalités et orientations feront l’objet de démonstrations et de discussions dans le cadre l’événement Black Hat 2023 organisé cette semaine (5 au 10 août) à Las Vegas auquel participe Aruba. L’évènement porte sur tout ce qui touche à la sécurité, y compris l’IA, l’automatisation et les questions liées à l’intelligence des menaces.

Les dirigeants de l’équipementier indiquent que, dans le domaine de la sécurité, les fonctionnalités développées en priorité par le fournisseur visent à étendre les services de protection des entreprises clientes au-delà du datacenter, afin d’englober le travail hybride, les ressources edge, les succursales, et les autres appareils se connectant au réseau. « Certaines des initiatives clés ont pour but de sécuriser le travail hybride et de faire en sorte que l’Internet est sûr, grâce à un moteur de politique qui offre aux clients la bonne visibilité et le bon contrôle pour rendre ces environnements très sûrs, dans la mesure où l’essentiel du travail se passe en dehors du réseau de l’entreprise », a déclaré Chris Hines, vice-président de la stratégie pour l’équipe Axis Security, désormais intégrée à Aruba. « L’autre objectif est de rapprocher les technologies de mise en réseau et de sécurité, car c’est ce que nous constatons chez tous nos clients », a-t-il ajouté.

Intégration de la technologie SSE d’Axis

« Un nouveau gestionnaire de politiques centralisé qui gérera et contrôlera l’ensemble du système de sécurité et de réseau de l’entreprise fait partie des technologies présentées en avant-première par Aruba », a déclaré Larry Lunetta, vice-président du marketing de portefeuille d’Aruba. Ce gestionnaire pourrait être étendu aux offres EdgeConnect SD-WAN, SD-Branch et Microbranch d’Aruba, ainsi qu’à la plateforme Aruba SSE en cours de développement, et il pourrait être centré sur la plateforme de gestion de politiques ClearPass d’Aruba et sur sa plateforme de gestion centrale, Aruba Central. « Nous proposerons progressivement une politique de sécurité unique qui s’appliquera à l’ensemble de l’infrastructure, pas seulement câblée ou sans fil, pas uniquement à la périphérie, mais aussi de la périphérie au cloud, quelles que soient les modalités de connexion de l’utilisateur et l’endroit où il se trouve », a encore déclaré M. Lunetta.

Concernant le SASE/SSE, Aruba intègre activement la technologie SSE d’Axis à ses offres SD-WAN et SASE. « Dans le domaine du SASE, Aruba s’oriente vers un package unique, tout compris, pour rivaliser dans l’arène dite du SASE à fournisseur unique, laquelle rassemble les technologies de réseau et de sécurité pour offrir aux clients le contrôle basé sur les rôles dont ils ont besoin pour protéger les utilisateurs partout dans le monde », a déclaré Aruba. L’idée est de permettre aux entreprises clientes d’acheter un package SASE auprès d’un seul fournisseur plutôt que de mélanger et d’assortir des éléments provenant de plusieurs fournisseurs. Selon Gartner, la tendance au SASE à fournisseur unique est en pleine croissance et, d’ici à 2025, un tiers des nouveaux déploiements SASE sera basé sur une offre SASE à fournisseur unique, contre 10 % en 2022. « D’ici à 2025, 65 % des entreprises auront consolidé les composants SASE individuels chez un ou deux fournisseurs SASE explicitement partenaires, contre 15 % en 2021 », prédit le cabinet d’études.

Support attendu du ZTNA

Aruba souhaite également jouer un rôle important sur le marché du Security Service Edge (SSE). Selon Gartner, le SSE combine plusieurs fonctions de sécurité clés, notamment un courtier de sécurité d’accès au cloud (Cloud-Access Security Broker, CASB), une passerelle web sécurisée (Secure Web Gateway, SWG), un accès réseau de confiance zéro (Zero-Trust Network Access, ZTNA) et un pare-feu de nouvelle génération (Next-generation firewall, NGFW), dans un service basé sur le cloud afin de rationaliser la gestion. « D’ici à 2026, 85 % des entreprises qui voudront s’équiper d’un CASB, d’une passerelle web sécurisée SWG ou d’un ZTNA, opteront davantage pour une solution convergente et moins pour des offres de fournisseurs distincts », a encore prédit Gartner.

« L’une des premières nouveautés que l’entreprise apportera au paquet SSE concerne le support de l’accès réseau zéro confiance (ZTNA) déployé localement, c’est-à-dire des capacités locales de confiance zéro qui n’obligent pas le trafic à passer par le cloud pour accéder aux ressources du datacenter et du cloud privé », a expliqué M. Hines. « Nous créons un edge local dans l’environnement du client, en fait, une machine virtuelle légère qui gère le trafic, de sorte que si l’utilisateur travaille à distance, la politique ne lui permet d’accéder qu’aux applications spécifiques définies par l’entreprise », a déclaré M. Hines. « Quand on travaille à domicile, il n’est pas toujours judicieux de se connecter à Internet. Avec le broker, les utilisateurs locaux peuvent se connecter très rapidement aux applications on-premise », a-t-il ajouté.

Lutter plus efficacement contre les ransomwares

Une autre fonctionnalité du SSE est destinée à renforcer la protection contre des menaces du genre malwares ou ransomwares. « Avec la fonction de bac à sable développée par Aruba, les entreprises pourront tester des fichiers suspects dans un environnement virtuel sûr et détruire les fichiers malveillants avant qu’ils ne causent des dommages », a déclaré M. Hines. « De plus, l’équipe d’Axis développe une solution pour bloquer les sites web à risque avec une fonction de blocage basée sur la réputation qui utilise des outils d’intelligence artificielle pour recueillir des informations pratiques et empêcher l’utilisateur d’accéder à ces applications », a encore déclaré M. Hines.

Fondée par Cisco, Juniper, Fortinet, Intel, AT&T et Verizon, pour ne citer que ceux-là, la Network Resilience Coalition encouragera les entreprises à corriger les systèmes, à combler les lacunes et à préparer des défenses pour les routeurs et les commutateurs.

À travers la Network Resilience Coalition, les piliers de l’industrie des réseaux veulent aider les entreprises, les fournisseurs de services et les opérateurs de télécommunications à lutter contre les ennemis cyber. L’objectif de cette coalition qui comprend AT&T, Broadcom, BT Group, Cisco, Fortinet, Intel, Juniper Networks, Lumen Technologies, Palo Alto Networks, Verizon et VMware, est de proposer des techniques ouvertes et collaboratives afin d’améliorer la sécurité du matériel et des logiciels réseau dans l’ensemble de l’industrie. La coalition a été réunie sous l’égide du Center for Cybersecurity Policy & Law, une organisation à but non lucratif qui se consacre à l’amélioration de la sécurité des réseaux, des appareils et des infrastructures critiques. Déjà engagée dans une vaste mission de sécurité, l’organisation souhaite que le groupe Resilience se concentre pour l’instant sur les routeurs, les commutateurs et les pare-feux les plus anciens, ceux qui ne bénéficient peut-être plus de support, qui n’ont pas reçu de correctifs de sécurité par négligence ou ceux en fin de vie qui n’ont pas été remplacés.

« Aujourd’hui, les acteurs malveillants, y compris les États-nations et les groupes criminels, arrivent trop facilement à trouver des vulnérabilités, à exécuter des codes à distance et à trouver des produits en fin de vie qui ne sont plus entretenus », a déclaré Éric Goldstein, directeur exécutif adjoint pour la cybersécurité de l’Agence américaine de cybersécurité et de sécurité des infrastructures (Cybersecurity and Infrastructure Security Agency, CISA). Ces produits peuvent offrir « un accès facile aux réseaux critiques qu’ils cherchent à atteindre. C’est table ouverte, pourrait-on dire ! », a déclaré M. Goldstein. « Nous voulons trouver un moyen de faciliter et de simplifier la mise à niveau vers les versions prises en charge et de réduire la fréquence de ces vulnérabilités que nos adversaires exploitent à grande échelle », a ajouté M. Goldstein.

Une recherche permanente

« La Network Resilience Coalition passera les prochains mois à rechercher et à inventorier les principaux problèmes que ses membres constatent dans l’ensemble du secteur, puis, d’ici à la fin de l’année, elle précisera ses domaines d’intervention », a indiqué le groupe. « Le groupe se consacrera en priorité à trouver des méthodes adaptées à tous les secteurs industriels pour relever les défis auxquels sont confrontées les entreprises en matière de mise à jour de logiciels et de matériel, mais aussi d’application régulière de correctifs, tout en encourageant les entreprises à améliorer la visibilité de leurs réseaux afin de mieux atténuer les cyber-risques », a encore déclaré le groupe.

« L’un des objectifs de la coalition est de discuter de cas d’usages nuancés pour comprendre ce que les fournisseurs peuvent changer », a déclaré Brad Arkin, vice-président senior et responsable de la sécurité et de la confiance chez Cisco Security. « Nous déployons beaucoup d’efforts pour atténuer les problèmes, mais cela ne donne pas les résultats dont nous avons besoin », a encore déclaré M. Arkin. « Des attaques parviennent toujours à exploiter avec succès des vulnérabilités pour lesquelles il existe des correctifs qui ne sont pas appliqués, ou résultant de mauvaises configurations. Parfois, certains clients ne sont pas en mesure d’appliquer les correctifs en temps voulu pour des raisons liées à leur contexte opérationnel. Parfois, il n’est pas aussi facile de gérer ces dispositifs. Prévenir de la disponibilité d’un correctif ne met pas fin au problème. Il est résolu quand le dispositif est corrigé ou s’il est retiré du réseau parce qu’il est en fin de vie », a déclaré Derrick Scholl, directeur de la réponse aux incidents de sécurité chez Juniper, qui se réjouit de l’occasion qui lui est donnée « d’améliorer l’éducation et les connaissances sur ce sujet ».

Des failles difficiles à corriger en production

La gestion des vulnérabilités est un défi permanent pour les grandes entreprises. Un rapport récent sur l’état de la gestion des vulnérabilités dans le DevSecOps a révélé que plus de la moitié des 634 praticiens de l’IT et de la sécurité informatique avaient plus de 100 000 vulnérabilités en attente de traitement. En outre, 54 % d’entre eux ont déclaré pouvoir corriger moins de 50 % de ces vulnérabilités, et la plupart des personnes interrogées (78 %) ont déclaré qu’il leur fallait plus de trois semaines pour corriger les vulnérabilités à haut risque dans leur environnement. Pour tenter de résorber ces énormes retards, des efforts coûteux et chronophages sont déployés, tant du côté de la production que du côté du développement des applications logicielles.

Selon une enquête menée par le Ponemon Institue et sponsorisée par Rezilion, 77 % des personnes interrogées déclarent qu’il faut plus de 21 minutes pour détecter, hiérarchiser et remédier à une seule vulnérabilité en production. Les principales raisons invoquées pour expliquer le défaut de résolution des problèmes sont l’incapacité à établir des priorités (47 %), le manque d’outils efficaces (43 %), le manque de ressources (38 %) et le manque d’informations sur les risques susceptibles d’exploiter les vulnérabilités (45 %). Et en cas de violation, le coût pour les entreprises augmente aussi. Selon le rapport annuel d’IBM Security sur le coût d’une violation de données « Cost of a Data Breach », le coût moyen mondial d’une violation de données a atteint 4,45 millions de dollars en 2023, soit une augmentation de 15 % au cours des trois dernières années. Au cours de cette même période, les coûts de détection et d’escalade ont bondi de 42 %. « Outre qu’elle représente la part la plus élevée des coûts de violation, cette augmentation montre aussi que les enquêtes sur les violations sont beaucoup plus complexes », a déclaré IBM.

La stratégie API First de Cisco donne la priorité au développement des API et garantit la compatibilité ascendante.

En mettant l’accent sur les avancées en matière d’API et en s’engageant à développer une plus grande communauté de développeurs, Cisco manifeste encore une fois sa volonté de devenir un acteur majeur du logiciel. Selon le fournisseur, une entreprise moyenne utilise 1 935 applications, soit 15 % de plus qu’il y a cinq ans. Et chacune de ces applications est accessible via des dizaines d’API provenant de fournisseurs, de développeurs et de sources internes. « Nous effectuons 8 milliards d’appels d’API par mois, contre 20 millions à la fin de 2018, c’est dire si l’adoption est importante ! », a déclaré Anne Gentle, responsable de l’expérience des développeurs chez l’équipementier de San Jose. Annoncée l’an dernier, la stratégie API First de Cisco donne la priorité au développement d’API dans tous les produits Cisco afin de garantir une communication efficace entre les applications, les services et les systèmes. « API First signifie que l’API est traitée comme un produit, avec une garantie de qualité pour les entreprises qui doivent avoir la certitude qu’elles pourront construire quelque chose de solide sur cette base », a déclaré Mme Gentle. « Incontestablement, les API sont l’avenir », a-t-elle ajouté.

La rétrocompatibilité est un autre élément clé de la stratégie API First. Les entreprises doivent être sûres que les API de Cisco continueront à fonctionner avec chaque version de logiciel. Selon Alicia Lorenzetti, leader mondial de l’écosystème et du marché chez Cisco Meraki, les processus de conception, de documentation et de support pour les API stratégiques de Cisco sont construits autour de la rétrocompatibilité, et cela inclut l’implementation de journaux des modifications, de délais de notification appropriés pour tout changement d’API, d’avis de dépréciation et de versions d’API. « Les développeurs veulent qu’une API dure des années, afin de continuer à écrire du code et que le code continue à fonctionner. Nous nous engageons à ne pas changer cette API particulière, et si nous le faisons, nous les en informerons et nous leur fournirons une alternatve », a encore déclaré Mme Lorenzetti. « L’idée est de créer un produit sur lequel les clients et les développeurs pourront compter dans la durée et sur lequel ils pourront bâtir leur entreprise », a-t-elle ajouté.

Support d’API Insight

Dans un premier temps, Cisco a promis une rétrocompatibilité pour plusieurs de ses offres principales, notamment l’API Meraki Dashboard, l’API Identity Service Engine (ISE), l’API Nexus Cloud, l’API SecureX Threat Response, les API Cloud Security Open, l’API Partner Experience (PX) Cloud et l’API Webex. Une compatibilité descendante est prévue pour ThousandEyes API, Spaces API, AppDynamics Cloud API, DNA Center API, NSO Northbound API, Crosswork CNC API, et SD-WAN (vManage) API. « Les clients peuvent trouver les API et la documentation pour les différentes lignes de produits sur le site developer.cisco.com », a indiqué Grace Francisco, vice-présidente des relations avec les développeurs, de la stratégie et de l’expérience chez Cisco, dans un blog sur API Insights.

Un autre aspect de l’effort de Cisco en faveur de l’API concerne le support au projet open source API Insights. « API Insights permet aux développeurs d’évaluer les problèmes techniques, l’exhaustivité de la documentation et les problèmes de qualité des API avant leur mise en production », a expliqué Anne Gentle. Le projet promeut la spécification OpenAPI (OAS), un format de description ouvert et neutre pour les API REST, régi par la Fondation Linux, qui permet aux applications métiers de partager des informations avec des applications internes ou tierces sur Internet. « Avec API Insights, les entreprises et les développeurs peuvent suivre et améliorer la qualité des API de manière cohérente, avec un niveau de détail et de transparence impossible à atteindre avec des processus manuels », a indiqué Cisco. « Grâce aux informations fournies par API Insights pendant qu’ils travaillent, les développeurs peuvent voir rapidement si leurs API répondent aux normes de qualité et de sécurité de leur entreprise. Ils peuvent aussi facilement voir l’historique des versions, les journaux des modifications, la compatibilité ascendante, les changements de rupture entre les versions, et plus encore », a aussi écrit Grace Francisco, dans le blog sur API Insights. « Ce langage commun, établi par API Insights entre développeurs et DevSecOps pour mettre en évidence les faiblesses des API, rend la collaboration plus efficace entre les équipes, et casse les silos traditionnels qui ralentissent souvent la productivité et le temps de résolution des problèmes quand ils surviennent », a encore déclaré Mme Francisco.

Des outils pour compléter Kubernetes

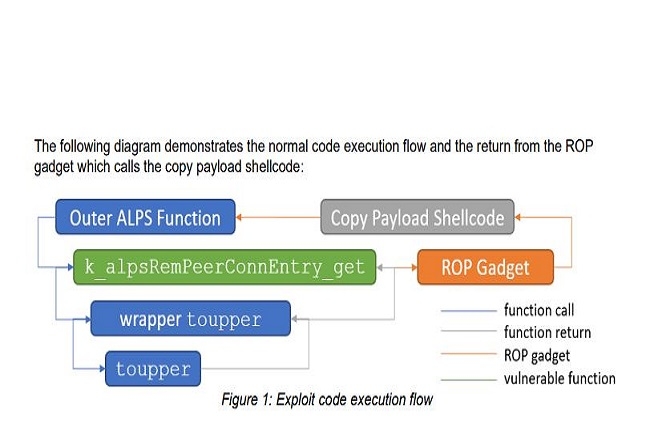

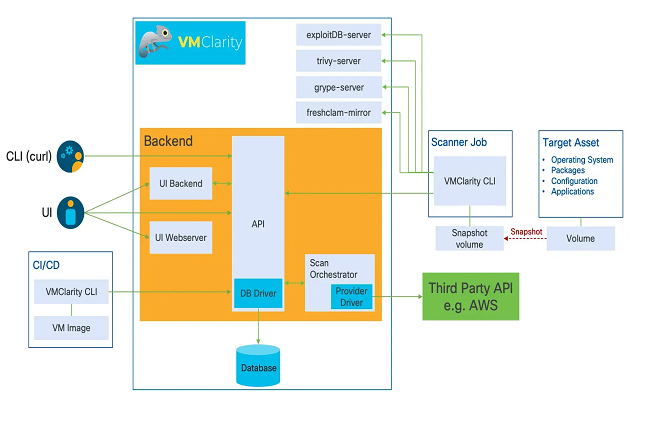

Cisco soutient aussi le développement des API par le biais du projet OpenClarity, une suite d’outils API open source pour la sécurité et l’observabilité des environnements Cloud natifs. Le projet OpenClarity comprend VMClarity, récemment annoncé, qui permet aux développeurs de s’attaquer aux vulnérabilités liées à l’utilisation de machines virtuelles dans les environnements natifs du cloud. « VMClarity fournit une détection et une gestion sans agent des nomenclatures logicielles (Software bill of materials, SBOM), et parce qu’il est sans agent, la sécurité et l’observabilité cloud-native sur les machines virtuelles sont améliorées sans écrire ou modifier de code », a déclaré Cisco. Les autres suites du projet OpenClarity comprennent APIClarity, un outil de visibilité open source et cloud natif pour les API qui utilise un framework de maillage de services pour capturer et analyser le trafic API et identifier les risques potentiels ; et KubeClarity, qui se concentre sur la visibilité et la vulnérabilité des environnements basés sur Kubernetes.

Cisco est impliqué dans d’autres projets axés sur le développement des API, notamment :

– Nasp : ce projet fournit des capacités de type service mesh à des points d’extrémité non-cloud et à des environnements cloud plus petits. Léger, basé sur une bibliothèque et open source, ce service mesh étendu peut exécuter des applications sur des appareils de périphérie, des VM héritées et des clients mobiles dans le service mesh de Kubernetes.

– Media Streaming Mesh : ce projet open source exécute plus efficacement des applications multimédias en temps réel dans des environnements Kubernetes natifs.

– APIx Manager : intégré dans les environnements de développement intégrés, il aide les développeurs à améliorer la qualité et la sécurité des API dès le début du cycle de développement.

Incontournable OpenTelemetry pour l’observai lité

« Le framework d’observabilité OpenTelemetry (OTEL) a aussi un impact sur la manière dont sont développées les nouvelles applications », a déclaré Anne Gentle. Sous les auspices de la Cloud Native Foundation, la technologie OpenTelemetry est développée par des contributeurs d’AWS, Azure, Cisco, F5, Google Cloud et VMware, entre autres. Le groupe définit OpenTelemetry comme un ensemble d’outils, d’API et de SDK utilisés pour instrumenter, générer, collecter et exporter des données de télémétrie afin d’analyser les performances et le comportement des logiciels. « On peut voir ses données et son équipement, et OTEL rend ces informations accessibles. Et quand on combine toutes ces données, elles deviennent exploitables pour les entreprises », a déclaré Mme Gentle. Selon les analystes, beaucoup de fournisseurs ont envie de créer de bonnes API et de bons programmes de développement. « Concernant les efforts de Cisco en matière d’API et de programmes de développement, l’objectif est d’encourager les développeurs à tirer parti de ce que fait Cisco et à s’en inspirer pour vendre davantage de produits Cisco », a déclaré pour sa part Tom Nolle, président de CIMI Corp. (Dans un blog, M. Nolle a récemment évoqué les défis auxquels sont confrontés les fournisseurs pour utiliser les API et encourager le développement de logiciels).

« Si un tiers développe quelque chose pour des API qui améliore la vente de produits d’un fournisseur, c’est gagnant-gagnant parce que ça ne lui coûte rien », a déclaré M. Nolle. « Les logiciels sont beaucoup plus faciles à différencier que le matériel ; toutes les fonctions utiles des réseaux sont créées par des logiciels », a-t-il ajouté. « Le défi consiste à mettre en place un programme qui en vaille la peine », a encore déclaré M. Nolle. « Cisco est un acteur important, et c’est une aide incontestable. Mais beaucoup de développeurs cherchent à travailler avec Cisco, et plus il y a de développeurs, moins il y a de chances qu’un développeur donné attire l’attention qu’il mérite. Les développeurs travaillant pour des fournisseurs s’inquiètent souvent aussi du fait que le fournisseur décide d’introduire sa propre fonction/son propre produit si la demande est suffisamment forte. Les programmes de développement d’un fournisseur ne sont pas un facteur déterminant dans le choix du fournisseur, mais ils peuvent être considérés comme un avantage », a ajouté Tom Nolle. « Les clients ne disent pas que les programmes de développement sont un critère primordial dans le choix du fournisseur, mais ils bénéficient de ces programmes. Les opérateurs (telcos) apprécient les bonnes API et les bons programmes, car ils voudraient souvent être eux-mêmes des ‘développeurs’ », a encore déclaré M. Nolle.

Selon Aruba Networks, à mesure que les rôles des équipes réseau évoluent, elles devront adopter l’IA et traiter la mise en réseau avec la sécurité.

Lors de la conférence clients Atmosphere organisée du 23 au 28 avril à Las Vegas, la sécurité, l’IA et le réseau en tant que service (Network-as-a-service, NaaS) étaient au cœur des préoccupations des dirigeants d’Aruba Networks. « Il y a dix ans, le principal travail des opérateurs de réseaux consistait à s’assurer que la connectivité était fiable et ils considéraient que la sécurité en dehors de leur périmètre n’était pas leur problème », a déclaré David Hughes, vice-président senior et directeur des produits et de la technologie chez Aruba. « Aujourd’hui, la notion de périmètres a disparu, le réseau s’est étendu et désormais, l’équipe chargée de la mise en réseau doit s’assurer que la connectivité est sécurisée dès le départ. Il n’est plus possible de la fixer quelque part, elle doit être intégrée au réseau », a encore déclaré M. Hughes. Aruba a pris plusieurs mesures pour renforcer sa stratégie de sécurité intégrée au réseau. Par exemple, le fournisseur a récemment acheté et intégré Axis Security et sa plateforme SSE (Security Service Edge) aux offres SD-WAN et SASE d’Aruba. « Cette offre SASE, dite de fournisseur unique, rassemble les technologies réseau et de sécurité et offre aux entreprises le contrôle basé sur les rôles dont elles ont besoin pour protéger les personnes qui accèdent aux applications, partout dans le monde et depuis n’importe où », a ajouté M. Hughes.

Le datacenter est un autre domaine sur lequel se concentre Aruba. L’entreprise a intégré la sécurité à son commutateur CX 10000, un boîtier de datacenter L2/3 de type top-of-rack. Celui-ci comprend une unité de traitement des données (Data processing unit, DPU) programmable intégrée qui prend en charge les services logiciels L4-L7 avec état, notamment le pare-feu, le DDoS, le chiffrement, la traduction d’adresses réseau (Network Address Translation, NAT), l’équilibrage de charge, la télémétrie réseau et l’automatisation, qui peuvent être appliqués pour protéger des charges de travail largement distribuées. « Auparavant, dans le datacenter, les opérateurs ne se préoccupaient que du trafic nord-sud et de mettre en place un pare-feu pour contrôler ce qui entrait et sortait, mais les choses ont changé », a expliqué M. Hughes. « Les entreprises veulent mettre en place un contrôle et une segmentation beaucoup plus stricts pour le trafic est-ouest. Ainsi, celles qui ont un tas de conteneurs veulent vraiment limiter fortement leur accès aux ressources du datacenter. Pouvoir segmenter et sécuriser ce trafic est une exigence importante et le CX 10000 fait le job efficacement », a ajouté M. Hughes.

Une remédiation de plus en plus automatisée

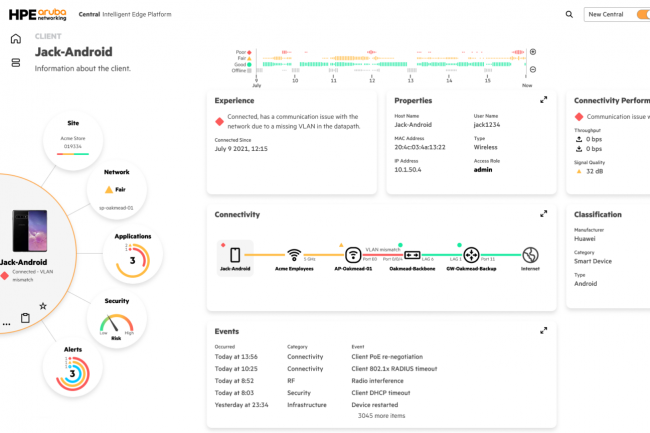

L’IA a également occupé une place importante dans les discussions de la conférence Atmosphere, en partie parce que le fournisseur a amélioré sa plateforme de gestion Aruba Central avec des fonctions d’Intelligence Artificielle pour les Opérations informatiques (AIOps) et d’autres fonctions de visibilité. Par exemple, l’entreprise a ajouté une interface plus visuelle et des indicateurs d’assurance intelligents qui alertent les administrateurs sur les problèmes de réseau et de périphérique en temps réel. Les indicateurs résultent de la corrélation des données d’accès, de LAN, de services, de WAN et d’applications pour améliorer la visibilité et les capacités de reporting. Des fonctionnalités AIOps permettent aussi aux opérateurs de découvrir plus rapidement les problèmes et de les résoudre. « Avec la quantité de données que l’on peut désormais collecter sur le réseau et sur l’expérience utilisateur, il est possible de mieux les utiliser pour alimenter les modèles d’IA et aider les clients à identifier des groupes d’erreur et, dans certains cas, ces éléments peuvent indiquer à l’opérateur comment adapter ou modifier certaines choses pour obtenir de meilleurs résultats », a déclaré M. Hughes. « Ce que nous constatons, c’est que les clients sont de plus en plus à l’aise avec le système qui fournit une remédiation automatisée ou des opérations en boucle fermée », a-t-il ajouté. « Les nombreux data scientists d’Aruba travaillent en permanence avec les données collectées par le système et tentent de déterminer quelles informations pourraient bénéficier d’une meilleure automatisation. Comment aider nos clients à trouver l’aiguille dans la botte de foin », a encore déclaré M. Hughes. Ce dernier a également parlé de l’IA générative, ChatGBT. « Il est évident que ce type de traitement du langage naturel est important. Nous utilisons donc le traitement du langage naturel dans notre barre de requête principale, de sorte que si quelqu’un veut faire quelque chose, il peut le demander en langage clair », a expliqué M. Hughes. « La capacité de traiter des dossiers d’assistance, de réduire le nombre de tickets d’incident et d’alimenter ces interfaces en langage naturel, va également changer la donne à l’avenir », a aussi déclaré M. Hughes.

Autre domaine qui, selon lui, devrait connaître une croissance substantielle cette année : l’utilisation du réseau en tant que service (NaaS). Dans un blog publié au début de l’année, M. Hughes a écrit que, d’ici la fin de l’année 2023, il s’attendait à ce que 20 % des entreprises aient adopté une stratégie NaaS. « Cela permettrait aux services IT d’accélérer la modernisation du réseau tout en respectant les contraintes de budget, de ressources informatiques et de calendrier », a écrit M. Hughes. Aruba a également profité de la conférence Atmosphere pour présenter Agile NaaS, qui rationalise le processus de sélection des composants d’infrastructure réseau disponibles par l’intermédiaire du service afin de mieux répondre aux besoins commerciaux des clients. L’idée d’Agile NaaS est d’inclure des outils de conception et de développement que les clients peuvent utiliser pour planifier un projet de réseau en amont, puis d’offrir une gamme de modèles d’acquisition, de déploiement et de gestion pour le mettre en place. « Concernant le NaaS, nos clients veulent de la flexibilité et de l’agilité, et pas de formule unique », a déclaré M. Hughes. « Il y a des situations où le client veut payer d’avance, mais aimerait que quelqu’un le gère pour lui, ou un autre qui veut payer au fur et à mesure, mais qui veut tout contrôler très étroitement lui-même. Notre approche consiste à fournir une boîte à outils à nos clients et à nos partenaires pour qu’ils puissent choisir les éléments qu’ils veulent pour construire leur service NaaS », a déclaré M. Hughes.

CloudVision Guardian for Network Identity d’Arista recourt à l’IA pour implémenter, dépanner et appliquer les politiques NAC de contrôle d’accès au réseau.

Le service en mode SaaS déployé par Arista Networks vient aider les entreprises à améliorer le contrôle d’accès au réseau (Network Access Control, NAC). Appelé CloudVision Guardian for Network Identity (CV-AGNI), ce service exploite la télémétrie en temps réel des produits réseau de l’équipementier, qu’il combine avec les données de sa plateforme de gestion CloudVision et de l’IA pour évaluer les informations et mettre en œuvre des politiques de sécurité. Selon Pramod Badjate, vice-président et directeur général du groupe Cognitive Campus d’Arista, le service peut également intégrer de nouveaux équipements, authentifier les utilisateurs existants, segmenter les matériels sur le réseau ou contribuer à résoudre les problèmes à partir d’un système basé sur le cloud.

« Historiquement, le système d’authentification de l’entreprise se trouve dans un système sur site, comme Active Directory, associé à du matériel ou à une série de machines virtuelles, et les modifications apportées à ce système nécessitent beaucoup de travail manuel. De plus, il est très coûteux de le faire évoluer, et il est difficile d’en réduire l’échelle. Par exemple, pour une très petite entreprise, le coût du NAC est presque prohibitif du fait de l’échelle initiale de déploiement de la solution », a expliqué M. Badjate. « Mais comme l’authentification des applications cloud augmente, nous pensons qu’il est logique de mettre en place un NAC à partir d’un système cloud basé sur l’IA, rapide à mettre à jour », a encore déclaré M. Badjate.

Dépannage assisté via un tchat

Selon lui, le service CV-AGNI peut faire gagner jusqu’à 75 % en temps de déploiement des politiques. Le fournisseur de Menlo Park a implémenté dans CV-AGNI un système d’IA générative en langage naturel appelé Autonomous Virtual Assist (AVA), qui utilise les ensembles de données d’Arista et de tiers dans l’architecture NetDL de l’équipementier pour prendre en charge le service. « Le service Ask AVA propose une interface de type tchat pour la configuration, le dépannage et l’analyse des politiques de sécurité de l’entreprise et de l’intégration des appareils », a expliqué M. Badjate. « Un cas typique de dépannage est celui de l’utilisateur qui ne parvient pas à se connecter. Pour comprendre ce qui se passe, il suffit de poser la question « Pourquoi Bob n’arrive-t-il pas à se connecter ? » et le système identifie tous les composants pertinents ou les politiques liées à cette personne et propose un motif pour lequel il n’arriverait pas à se connecter », a déclaré M. Badjate.

« Arista prévoit d’étendre les capacités d’Autonomous Virtual Assist », a écrit Jayshree Ullal, le CEO d’Arista, dans un blog consacré à l’annonce. « À l’avenir, AVA étendra ces capacités basées sur l’IA à d’autres paramètres, y compris les détections d’anomalies », a-t-il ajouté. Dans sa première itération, AGNI s’intègre à des produits tiers, notamment les systèmes de gestion des points d’extrémité Medigate de Claroty, CrowdStrike XDR, et Palo Alto Cortex XDR ; les systèmes de gestion des identités Okta, Google Workspace, Microsoft Azure, Ping Identity et OneLogin ; le système de gestion de terminaux mobiles Microsoft Intune ; le système de gestion des informations et des événements de sécurité (SIEM) JAMF Splunk. L’abonnement au logiciel AGNI sera assorti d’une licence pour un maximum de trois appareils par utilisateur et sera disponible au cours du deuxième trimestre.