GitHub greffe à sa plateforme CI/CD automatisée le réseau privé Azure pour améliorer la sécurité et des runners hébergés sur GPU pour l’apprentissage machine.

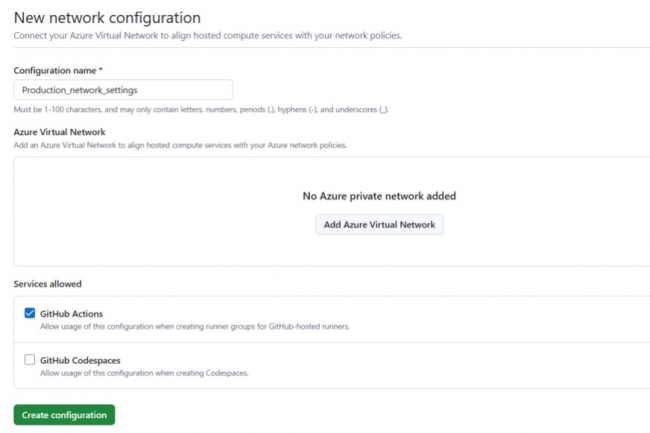

Destinée aux clients professionnels, la plateforme CI/CD automatisée Github Actions de GitHub voit sa sécurité renforcée et s’enrichit de runners améliorés par GPU pour l’apprentissage machine. Les mises à jour du parc de runners hébergés pour Actions ont été annoncées le 2 avril. Pour renforcer la sécurité, GitHub Actions propose désormais le réseau privé Azure pour les runners hébergés par GitHub. Cette fonctionnalité combine le calcul dans le cloud avec un accès sécurisé et le contrôle de la sécurité du réseau, ce qui évite des tâches de maintenance de l’infrastructure. Les runners hébergés pour tous les principaux systèmes d’exploitation sont destinés à faciliter la construction et le test d’un projet, avec la possibilité de l’exécuter directement sur une machine virtuelle ou un conteneur.

Avec les runners hébergés sur GPU pour l’apprentissage machine, désormais en bêta publique, les équipes travaillant avec de grands modèles de langage (LLM) ou nécessitant des cartes graphiques GPU pour le développement de jeux peuvent dorénavant exécuter des processus d’automatisation et de CI/CD sur les GitHub Actions. Cette fonctionnalité prend également en charge les tests d’application, la mise à l’échelle automatique et la mise en réseau privée. GitHub a aussi élargi sa flotte de runners hébergés avec deux runners vCPU Linux et quatre runners vCPU Windows. Les projets peuvent être exécutés sur une machine virtuelle ou dans un conteneur. À noter que les runners hébergés sur les puces Apple M1 sont aussi disponibles.

Ces mises à jour interviennent alors que la plateforme GitHub Actions fête ses cinq ans, avec 22 000 Actions disponibles sur le GitHub Marketplace. « Les runners hébergés maximisent le temps de codage des développeurs en évitant les tâches associées à la gestion de l’infrastructure », a déclaré GitHub. Pour les administrateurs devops, les runners hébergés réduisent le temps et les coûts nécessaires à la maintenance de l’infrastructure informatique pour l’automatisation du cycle de vie des logiciels.

L’entreprise de sécurité des développeurs met en garde sur le fait que Copilot et d’autres assistants de codage alimentés par l’IA peuvent reproduire des vulnérabilités de sécurité déjà présentes dans la base de code de l’utilisateur.

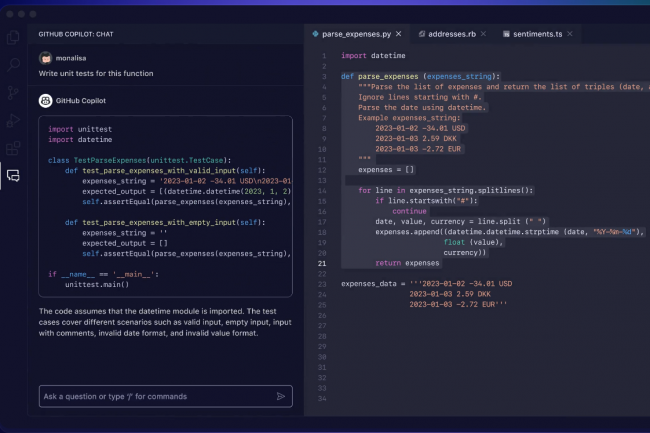

« GitHub Copilot, l’assistant de codage de GitHub alimenté par l’IA, peut suggérer du code non sécurisé quand la base de code existante de l’utilisateur contient des problèmes de sécurité », a alerté l’éditeur Snyk. « GitHub Copilot peut reproduire les problèmes de sécurité existants dans le code », a déclaré Snyk dans un article de blog publié le 22 février. « Cela signifie que la dette de sécurité existante dans un projet peut faire que les développeurs dont le code est mal sécurisé, livrent un code encore moins sûr quand ils utilisent Copilot », a ajouté l’entreprise. Cependant, la probabilité pour GitHub Copilot de suggérer du code non sécurisé dans des projets sans problèmes de sécurité, est moins élevée, car le contexte de code dont s’inspire l’assistant est moins incertain.

« Les assistants de codage basés sur l’IA générative comme GitHub Copilot, Amazon CodeWhisperer et ChatGPT représentent un progrès considérable en termes de productivité et d’efficacité du code », a déclaré Snyk. Mais ces outils ne comprennent pas la sémantique du code et ne peuvent donc pas juger de sa qualité. GitHub Copilot génère des extraits de code en se basant sur des modèles et des structures qu’il a appris à partir d’un vaste référentiel de code existant. « Si cette approche présente des avantages, elle peut aussi présenter un inconvénient flagrant dans le contexte de la sécurité », a ajouté Snyk.

40 vulnérabilités en moyenne dans un logiciel commercial

Les suggestions de code de Copilot peuvent reproduire par inadvertance les vulnérabilités de sécurité existantes et les mauvaises pratiques présentes dans les fichiers voisins. Pour atténuer ce report des problèmes de sécurité existants dans le code généré par les assistants d’IA, Snyk conseille aux développeurs les choses suivantes :

– de procéder à des examens manuels du code. Les équipes de sécurité doivent mettre en place un garde-fou SAST (Security Application Security Testing), y compris des politiques.

– de respecter les directives de codage sécurisé. Les équipes de sécurité doivent former et sensibiliser les équipes de développement, hiérarchiser et trier les problèmes en attente par équipe. Les équipes de direction devraient imposer des garde-fous de sécurité.

Les données de Snyk indiquent qu’un projet logiciel commercial normal comporte en moyenne 40 vulnérabilités dans le code de première partie, et que près d’un tiers de ces vulnérabilités sont de haute gravité. « Les outils de génération d’IA peuvent tout à fait dupliquer le code en utilisant ces vulnérabilités comme contexte », a insisté Snyk. Les problèmes les plus courants constatés par Snyk dans les projets commerciaux sont les scripts intersites XSS, les vulnérabilité Path Traversal, l’injection SQL et les secrets et informations d’identification codés en dur. GitHub n’a pas pu être joint hier en fin d’après-midi pour répondre aux commentaires de Snyk sur GitHub Copilot.