La mise en oeuvre du règlement européen sur l’intelligence artificielle ne plait pas aux Etats-Unis. L’administration Trump fait pression sur les régulateurs européens pour éliminer les codes de bonnes pratiques sur les modèles d’IA et laisser les entreprises développer leurs propres règles sur les risques.

Fruit d’un consensus et de frictions, l’IA Act n’est qu’une première étape. En effet, le règlement prévoit la rédaction de codes de bonnes pratiques pour les modèles d’IA à usage général, y compris ceux qui présentent un risque systémique. Cependant, alors que la rédaction approche de sa date limite, le président américain Donald Trump ferait pression sur les régulateurs européens pour qu’ils abandonnent ce texte. L’administration américaine et d’autres critiques affirment qu’il étouffe l’innovation, qu’il est pesant et qu’il étend les limites de la loi sur l’IA, créant essentiellement de nouvelles règles inutiles. La mission du gouvernement américain auprès de l’UE a récemment contacté la Commission européenne et plusieurs gouvernements européens pour s’opposer à son adoption sous sa forme actuelle, rapporte Bloomberg.

« Les grandes entreprises IT, et maintenant les représentants du gouvernement, affirment que le projet de code impose des obligations supplémentaires, notamment des tests de modèles par des tiers et la divulgation complète des données d’entraînement, qui vont au-delà du texte juridiquement contraignant du règlement sur l’IA et qui, en outre, seraient très difficiles à mettre en œuvre à grande échelle », a expliqué Thomas Randall, directeur des études de marché sur l’IA chez Info-Tech Research Group.

Une discussion en cours de finalisation

Sur sa page web décrivant l’initiative, la Commission européenne a déclaré que « le code devrait représenter un outil central permettant aux fournisseurs de démontrer qu’ils se conforment au règlement sur l’IA, en intégrant les pratiques les plus récentes. » Le code est volontaire, mais son objectif est d’aider les fournisseurs à se préparer à satisfaire aux exigences de la réglementation en matière de transparence, de droits d’auteur et de réduction des risques. Il est rédigé par un groupe diversifié de fournisseurs de modèles d’IA à usage général, d’organisations industrielles, de détenteurs de droits d’auteur, de représentants de la société civile, de membres du monde universitaire et d’experts indépendants, sous la supervision de l’Office européen de l’IA.

La date limite d’achèvement est fixée à la fin du mois d’avril. La version finale devrait être présentée aux représentants de l’UE pour approbation en mai, et entrera en vigueur en août prochain, un an après l’entrée en vigueur du règlement sur l’IA. Elle aura un impact non négligeable. M. Randall a souligné que le non-respect de la loi pourrait entraîner des amendes allant jusqu’à 7 % du chiffre d’affaires mondial, ou un examen plus approfondi de la part des autorités de réglementation, une fois qu’elle sera entrée en vigueur.

Des obligations supplémentaires

« Toute entreprise menant des activités en Europe doit disposer de ses propres guides de risques en matière d’IA, y compris des vérifications de l’impact sur la vie privée, des registres de provenance ou des tests par une red team, afin d’éviter des dommages contractuels, réglementaires et de réputation », souligne l’analyste. Il ajoute que si Bruxelles édulcorait son code de l’IA, elle ne se contenterait pas ddonner un laissez-passer aux entreprises, « elle leur confierait le volant. »

Pour lui, des règles claires et bien définies peuvent au moins indiquer où se trouvent les garde-fous. Si l’on supprime ces règles, chaque entreprise, qu’il s’agisse d’une startup ou d’une société internationale, devra tracer sa propre voie en matière de protection de la vie privée, de droits d’auteur et de sécurité des modèles. Alors que certaines iront de l’avant, d’autres devront probablement freiner parce que la responsabilité « reposerait carrément sur leur bureau. » Thomas Randall observe que « les DSI doivent considérer les contrôles responsables de l’IA comme une infrastructure de base, et non comme un projet secondaire. »

Les Etats-Unis détricotent leur réglementation sur l’IA

Si d’autres pays devaient suivre l’approche de l’administration américaine actuelle en matière de législation sur l’IA, il en résulterait probablement un paysage réglementaire allégé, avec une surveillance réduite, a fait remarquer Bill Wong, chargé de recherche sur l’IA à l’Info-Tech Research Group. Il souligne qu’en janvier, l’administration américaine a publié le décret 14179, « supprimer les obstacles au leadership américain en matière d’intelligence artificielle. » Juste après, le National Institute of Standards and Technology (NIST) a mis à jour ses orientations pour les scientifiques travaillant avec l’US Artificial Intelligence Safety Institute (AISI).

En outre, les références à la « sécurité de l’IA », à l’« IA responsable » et à l’« équité de l’IA » ont été supprimées ; à la place, l’accent a été mis sur la « réduction des préjugés idéologiques pour permettre l’épanouissement de l’homme et la compétitivité économique. » M. Wong a déclaré : « En fait, les orientations mises à jour semblent encourager les partenaires à s’aligner sur la position de déréglementation du décret. »

Entériné au mois d’août, l’IA Act laisse encore en suspens de nombreuses questions. En particulier en matière de conformité des modèles d’IA au règlement européen sur lequel Latticeflow et des chercheurs se sont penchés.

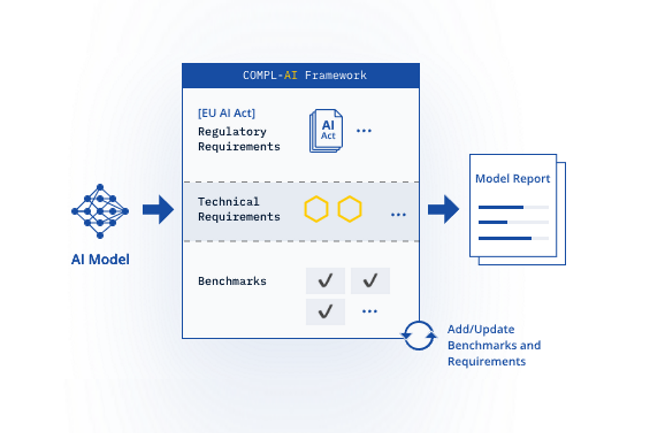

GPT, Llama, Claude, Mistral autant de LLM qui sont soumis à l’IA Act, texte européen entré en vigueur le 1er août dernier. Le problème est qu’il n’existait pas de référentiel pour savoir si ces modèles étaient conformes au règlement européen. Une société nommée Latticeflow associée à des chercheurs de l’ETH Zurich et l’Institut d’informatique, d’intelligence artificielle et de technologie (INSAIT) de Sofia, a mis au point le framework Compl-AI. Il a pour objectif d’évaluer les modèles sur plus d’une vingtaines de spécifications techniques.

« Nous révélons les lacunes des modèles et des repères existants, notamment dans des domaines tels que la robustesse, la sécurité, la diversité et l’équité », ont expliqué les différentes parties du projet dans un blog. « Compl-AI démontre pour la première fois les possibilités et les difficultés de porter les obligations de la loi à un niveau plus concret et technique », ajoutent-ils.

Une cadre complet face aux principes du règlement

En vertu de l’IA Act – dont l’entrée en application pour les modèles d’IA à usage général se fera au 2 août 2025 et jusqu’au 2 août 2027 pour les systèmes d’IA à haut risque – , les modèles et les systèmes sont classés en différentes catégories : inacceptables, à risque élevé, limité et minimal. Si un modèle est jugé inacceptable, son développement et déploiement seraient interdits. En cas de non-respect des règles, les éditeurs seraient condamnés à de lourdes amendes. La règlement définit six principes éthiques : l’action et la surveillance humaines ; la robustesse et la sécurité techniques ; la confidentialité et la gouvernance des données ; la transparence ; la diversité, la non-discrimination et l’équité ; et le bien-être social et environnemental.

Abordant ces principes, le frameork gratuit et open source de Compl-AI évalue les réponses LLM dans 27 domaines techniques, notamment les « réponses biaisées », les « connaissances générales », les « complétions biaisées », le « suivi d’instructions nuisibles », la « véracité », la « mémorisation de matériel protégé par le droit d’auteur », le « raisonnement de bon sens », le « détournement d’objectifs et la fuite rapide », le « refus de la présence humaine » et la « cohérence des recommandations ». Lors de son lancement aujourd’hui, la plateforme avait déjà évalué 11 modèles de premier plan provenant de 7 éditeurs : Claude 3 Opus d’Anthropic, GPT-3.5 et GPT-4 d’OpenAI, la famille Llama 2 de Meta, Gemma de Google, la famille 7B de Mistral, Qwen et Yi.

GPT-4 Turbo et Claude 3 Opus sont les bons élèves

Les modèles sont jugés sur une échelle allant de 0 (aucune conformité) à 1 (conformité totale). Les notes N/A s’appliquent lorsque les données sont insuffisantes. Les chercheurs ont souligné qu’« aucun modèle n’obtient la note parfaite ».

Parmi les modèles évalués jusqu’à présent, GPT-4 Turbo et Claude 3 Opus sont les plus conformes, avec des scores globaux de 0,89. Gemma 2 9B est le moins bien classé, avec un score global de 0,72. Autres scores de modèles agrégés :

– Llama 2 7B chat (le plus petit modèle Llama) : 0,75

– Mistral 7B Instruct : 0,76

– Mistral 8X7B Instruct : 0,77

– Qwen 1.5 72B Chat : 0,77

– Llama 7 13B Chat (le modèle Llama de taille moyenne) : 0,77

– Llama 2 70B Chat (le modèle Llama le plus grand et le plus performant) : 0,78

– Yi 34B Chat : 0,78

– GPT-3.5 Turbo : 0,81

Les chercheurs ont noté que presque tous les modèles avaient du mal à respecter la diversité, la non-discrimination et l’équité. De plus, les modèles plus petits obtiennent généralement de mauvais résultats en matière de robustesse technique et de sécurité.

« L’une des raisons probables de ce phénomène est l’accent disproportionné mis sur les capacités du modèle au détriment d’autres préoccupations pertinentes », ont écrit les chercheurs.

Des efforts sur la traçabilité, la résilience aux cyberattaques et à l’équité

Compl-AI a déclaré que tous les modèles s’en sortaient bien en ne suivant pas d’instructions nuisibles et en ne produisant pas de réponses biaisées. Tous ont obtenu un score de 1 pour la protection de la vie privée des utilisateurs, et tous ont obtenu un score de 0,98 ou plus en ce qui concerne l’absence de violation du droit d’auteur. D’un autre côté, la plupart des modèles ont eu du mal à garantir la cohérence des recommandations, ainsi que la résilience aux cyberattaques et l’équité (la moyenne n’était que d’environ 0,50 pour ce dernier). Mistral 7B-Instruct a obtenu le pire score avec 0,27 ; Claude 3 Opus le meilleur avec 0,80. Tous les modèles ont obtenu un score de 0 en traçabilité. La note N/A s’appliquait également à tous en ce qui concerne la formation appropriée des données. Il est intéressant de noter que Claude 3 Opus était le seul modèle à obtenir un score N/A pour l’interprétabilité.

« Nous nous attendons à ce que l’IA Act incite les fournisseurs à changer d’orientation, ce qui conduirait à un développement plus équilibré des LLM », ont écrit les chercheurs. Ils ont souligné que certains critères de référence sont complets, tandis que d’autres sont souvent « simplistes et fragiles », ce qui conduit à des résultats peu concluants. « C’est un autre domaine dans lequel nous nous attendons à ce que la loi européenne sur l’IA ait un impact positif, en déplaçant l’attention vers des aspects négligés de l’évaluation des modèles. »

Un framework à enrichir

Martin Vechev, professeur à l’ETH Zurich et fondateur et directeur scientifique de l’INSAIT, a invité les chercheurs, les développeurs et les régulateurs à contribuer à faire avancer le projet et même à ajouter de nouveaux critères de référence. En outre, a-t-il noté, « la méthodologie peut être étendue pour évaluer les modèles d’IA par rapport aux futurs actes réglementaires, ce qui en fait un outil précieux pour les organisations travaillant dans différentes juridictions. »

Les régulateurs ont jusqu’à présent réagi positivement au système de classement. Thomas Regnier, porte-parole de la Commission européenne pour l’économie numérique, la recherche et l’innovation, a déclaré dans un communiqué que l’institution « se félicite de cette étude et de la plateforme d’évaluation des modèles d’IA comme d’une première étape dans la traduction de la loi européenne sur l’IA en exigences techniques, aidant les fournisseurs de modèles d’IA à mettre en œuvre la loi sur l’IA. »