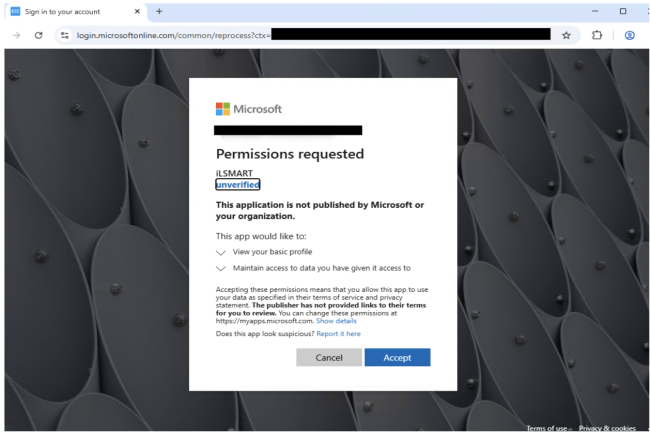

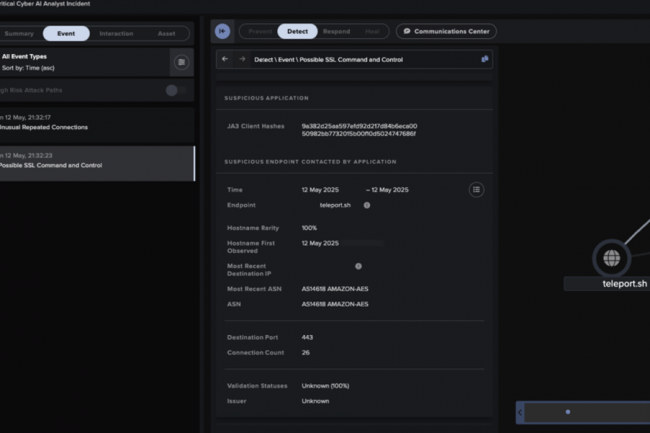

Les cybercriminels trompent les utilisateurs à travers de fausses applications Microsoft OAuth pour accéder à des comptes Office 365, One Drive, Outlook… Un moyen de contourner les systèmes d’authentification multifacteur.

Les experts de Proofpoint ont découvert un moyen astucieux de la part des cybercriminels pour voler des identifiants. « Le groupe identifié crée de fausses applications Microsoft OAuth (SharePoint ou Docusign) et des redirections vers des URL malveillantes pour ses opérations de phishing visant à au vol d’informations d’identification » explique le fournisseur dans un blog. Il ajoute, « la campagne utilise ces applications comme un leurre et une passerelle pour mener d’autres activités, principalement pour obtenir l’accès à des comptes Microsoft 365 via le phishing MFA ».

Les applications OAuth utilisent la plateforme d’identité de la firme de Redmond (Azure AD/ Entra ID) pour demander l’autorisation d’accéder à des données dans des services comme Microsoft 365, OneDrive, Outlook, Teams ou SharePoint au nom d’un utilisateur.

Un moyen de contourner le MFA

Selon Proofpoint, les applications usurpées utilisaient des noms, des logos et des messages d’autorisation convaincants pour inciter les utilisateurs à approuver l’accès, sans déclencher d’alarme. Lorsqu’une victime cliquait sur « accepter », elle était redirigée par captcha vers une fausse page de connexion Microsoft. L’étape captcha sert de moyen anti-bot pour empêcher les scanners automatisés de repérer l’attaque. En arrière-plan, des kits de phishing comme Tycoon ou ODx capturent à la fois les identifiants de connexion et les jetons de session, utilisés ensuite par les attaquants pour contourner le MFA et obtenir un accès permanent aux comptes Microsoft 365.

« Les campagnes de phishing s’appuient sur des kits de phishing de type AiTM (attacker-in-the-middle) à authentification multifactorielle (MFA) comme Tycoon », ont ajouté les chercheurs. « Ce type d’attaque pourrait être utilisé pour la collecte d’informations, le déplacement latéral, l’installation de malware ou pour mener d’autres campagnes de phishing à partir de comptes compromis », ont-ils précisé. Cette méthode est particulièrement dangereuse, car les jetons OAuth peuvent survivre aux réinitialisations de mot de passe. Même si un utilisateur compromis change son mot de passe, les attaquants peuvent toujours utiliser les autorisations accordées pour accéder aux courriels, aux fichiers et à d’autres services cloud jusqu’à ce que le jeton OAuth soit révoqué. Selon Proofpoint, la campagne a abusé de plus de 50 marques de confiance, y compris des entreprises comme RingCentral, SharePoint, Adobe et DocuSign.

Des mesures de Microsoft pour réduire la menace

Dans le cadre de cette campagne, des milliers de messages malveillants ont été envoyés à partir de comptes professionnels compromis, chacun usurpant l’identité d’entreprises bien connues. Certains leurres demandaient des autorisations d’apparence anodine comme « voir votre profil » et « maintenir l’accès aux données auxquelles vous avez donné accès ». Proofpoint a signalé les applications incriminées à Microsoft au début de l’année 2025, notant que les prochaines modifications des paramètres par défaut de Microsoft 365, annoncées par l’éditeur en juin 2025, devraient limiter considérablement la capacité des attaquants à abuser de l’accès aux applications tierces. Les actualisations ont commencé à être déployées à la mi-juillet et devraient être terminées en août 2025. Microsoft n’a pas répondu immédiatement à la demande de commentaires.

Proofpoint recommande de mettre en œuvre des mesures efficaces de prévention des compromissions de messagerie, de bloquer les accès non autorisés dans les environnements cloud et d’isoler les liens potentiellement malveillants dans les courriels pour garder une longueur d’avance sur la campagne. De plus, la sensibilisation des utilisateurs aux risques de sécurité de Microsoft 365 et le renforcement de l’authentification à l’aide de clés de sécurité physiques basées sur FIDO pourraient s’avérer utiles. Les identifiants d’application Microsoft OAuth malveillants et les empreintes digitales Tycoon observés dans la campagne ont également été partagés afin d’établir une détection.

L’autorité américaine en charge de la cybersécurité vient de publier une plateforme open source nommée Thorium. Elle vise à rationaliser l’analyse des fichiers et des malwares à grande échelle.

Comme son homologue français (l’Anssi), la CISA n’hésite pas à mettre en avant des outils open source pour améliorer la sécurité des entreprises. En l’espèce, l’agence en partenariat avec Sandia National Laboratories vient de publier Thorium, une plateforme d’analyses des malwares et des fichiers collectés sur un incident. Elle apporte une aide aux équipes de sécurité d’une entreprise ou des enquêteurs. L’outil propose une automatisation évolutive des fichiers et…

Il vous reste 91% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

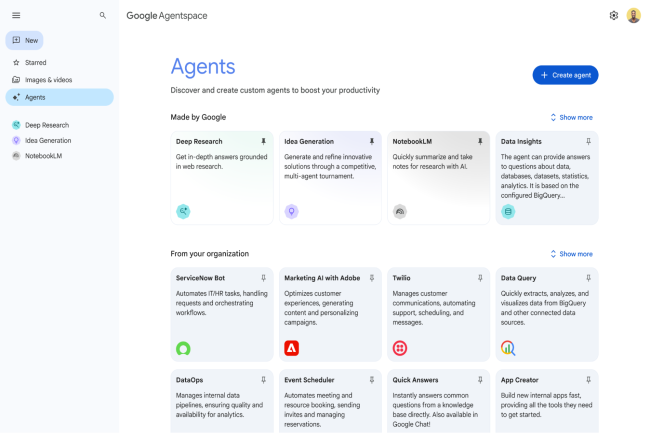

Dans le calendrier de mise en oeuvre de l’IA Act, le 2 août 2025 marque la mise en place de certaines règles pour les systèmes d’IA à usage général. Une réglementation qui suscite toujours un rejet de la part de l’administration Trump ou de Meta. De son côté, Google a décidé de signe le code de bonnes pratiques lié à l’IA Act, tout en alertant sur les risques pour l’innovation.

Le débat reste toujours vif sur l’IA Act. Ce règlement européen sur l’intelligence artificielle voté en 2024 vient en effet de franchir une étape en ce début du mois d’août. A cette date, plusieurs dispositions rentrent en vigueur notamment la gouvernance des systèmes d’IA à usage général (GPAI), des sanctions en cas de non-respect et les mécanismes de contrôle par des autorités désignées (Cnil, autorité de la concurrence,…). Le texte impose des interdictions ou des conditions spécifiques selon une classification des systèmes d’IA en fonction des risques : inacceptable, élevé, limité ou minimal.

Le calendrier est progressif selon le type de système régulé s’étalant de 2026 (pour les IA utilisées dans la biométrie, les infrastructures critiques, l’éducation, l’emploi ou la justice) jusqu’à 2027 (pour les IA à haut risque intégrées dans les jouets, les dispositifs médicaux, les machines). A noter que le non-respect des obligations entraîne des sanctions pouvant aller jusqu’à 35 M€ d’amende ou 7% du chiffre d’affaires annuel mondial pour les entreprises.

Des effets encore discrets sur le terrain

Certaines mesures ont déjà été appliquées, comme l’interdiction des systèmes à risque jugé inacceptable ou la création de l’Office européen de l’IA, mais leur impact reste pour l’instant limité. De même, la date du 2 août ne bouleverse pas l’écosystème de l’IA, car aucun cas médiatique majeur n’a encore émergé. Mais selon Víctor Rodríguez, maître de conférences à l’Université polytechnique de Madrid, « les effets devraient bientôt se faire sentir ». De son côté, Roger Segarra, associé au département informatique et propriété intellectuelle chez Osborne Clarke, observe déjà des impacts concrets. « Certaines pratiques interdites, comme l’utilisation par les administrations de systèmes d’identification biométrique à distance en temps réel à des fins de surveillance, ont eu un effet dissuasif dès leur annonce, avant même leur entrée en vigueur », explique-t-il. Pour autant, « la mise en conformité des PME crée un climat de tension liées aux contraintes administratives et financières, ainsi qu’au manque de directives claires », poursuit-il.

Pour Arnau Roca, associé directeur d’Overstand Intelligence, cabinet spécialisé dans le conseil en IA, « la première année a montré que le développement rapide de l’IA dépasse la capacité législative à la réguler efficacement ». La Commission européenne ambitionne de faire de l’IA Act un équivalent du RGPD pour l’IA, mais l’« effet Bruxelles », qui avait permis d’imposer des standards européens à l’échelle mondiale, peine à se reproduire. La réélection de Donald Trump et les positions divergentes des entreprises IT nourrissent les incertitudes.

Google joue la carte de la conformité

Dans ce contexte, Google a choisi de se conformer au code de conduite volontaire mis en place par l’Union européenne pour encadrer les IA à « risque systémique », une catégorie qui englobe les LLM développés par OpenAI, Meta, Anthropic ou Google lui-même. Les entreprises concernées disposent d’un délai de deux ans pour se mettre pleinement en conformité. Selon Tulika Sheel, vice-présidente au cabinet d’analyse Kadence International, cet engagement pourrait devenir un levier concurrentiel. « La pression augmente sur les acteurs de l’IA. Adopter des pratiques responsables offre une opportunité de se différencier, de gagner en réputation et de répondre aux attentes croissantes des entreprises et des utilisateurs finaux », explique-t-elle.

Pour autant, Google reste prudent. Dans un billet de blog, Kent Walker, président des affaires mondiales du groupe, alerte sur les risques liés à ce cadre réglementaire : « L’IA Act pourrait freiner l’innovation en Europe, en raison notamment d’incompatibilités avec le droit d’auteur, de délais d’approbation trop longs ou d’exigences risquant d’exposer des secrets industriels. »

Des contestations américaines et européennes fortes

Cette position contraste avec celle de l’administration Trump, qui, il y a quelques mois, appelait à abandonner les codes de bonne conduite sur l’IA, privilégiant une régulation légère confiée aux entreprises afin de favoriser l’innovation. Meta, de son côté, refuse d’adhérer au cadre européen, qu’il juge inadapté à une technologie encore en construction. Selon la firme américaine, l’approche réglementaire de Bruxelles est prématurée et pourrait nuire au développement de l’IA. A noter qu’au début juillet, plusieurs patrons européens avaient plaidé pour un report de la mise en œuvre de l’IA Act, sans succès.

Le marché des réseaux SDN continue de croître, mais pas tout à fait comme le souhaiteraient certains fournisseurs. La co-existence avec des technologies héritées ou modernes comme l’edge et la 5G privée persiste. Par ailleurs, la demande d’automatisation avec l’IA est forte, mais peu saute le pas.

Selon le rapport « 2025 Provider Lens Network Software-defined Solutions and Services » d’Information Services Group (ISG), le marché est relativement mature et les déploiements SD-WAN sont désormais presque omniprésents dans les grandes entreprises. Les petites et moyennes entreprises sont également de plus en plus nombreuses à l’adopter. Par contre, le remplacement complet des réseaux existants n’a pas décollé. Pour son étude qui couvre les solutions SD-WAN aux Etats-Unis, le cabinet d’analyse a évalué 36 fournisseurs dans quatre domaines clés : les services SD-WAN gérés, le conseil en transformation, les technologies edge et le Secure Access Service Edge (SASE).

L’étude révèle plusieurs résultats critiques qui remettent en cause les idées reçues sur les déploiements SD-WAN :

– Même les entreprises numériquement matures évitent les remplacements complets d’infrastructure au profit de transitions progressives.

– L’automatisation pilotée par l’IA apporte des avantages mesurables, mais la gestion entièrement autonome du réseau demeure au stade de projet.

– Les stratégies d’adoption du SASE varient considérablement selon la géographie et la taille de l’entreprise.

– L’edge computing et la 5G privée sont passés du concept à la mise en œuvre pratique dans les environnements industriels.

« La plus grande surprise de cette enquête concerne la forte demande de capacités d’automatisation en temps réel, pilotées par l’IA, dans les déploiements de réseaux SD-WAN », a déclaré Yash Jethani Pradeep, senior manager et analyste principal chez ISG. « Cela montre que de nombreuses entreprises ne se contentent pas de solutions de base, mais recherchent des fonctionnalités avancées qui améliorent l’efficacité opérationnelle et les processus de prise de décision. »

Des transitions majoritairement par étapes

Le rapport de l’ISG fait état de deux approches principales de déploiement SD-WAN parmi les entreprises. Beaucoup superposent les SD-WAN à l’infrastructure existante, améliorant ainsi les performances et l’évolutivité au fil du temps. D’autres remplacent complètement les réseaux existants après avoir testé les accords de niveau de service SD-WAN par rapport aux exigences fonctionnelles et métiers. Cependant, malgré le positionnement agressif des fournisseurs autour de la refonte complète de l’infrastructure, le rapport de l’ISG montre que les approches superposées deviennent dominantes. Même les entreprises les plus avancées technologiquement adoptent une approche plus prudente des déploiements SD-WAN.

« Honnêtement, même les entreprises numériquement matures favorisent des transitions contrôlées et progressives en raison de la complexité opérationnelle, des contrats hérités intégrés et des frictions liées à la conformité », a déclaré M. Pradeep. « La réalité est que, malgré le battage médiatique des fournisseurs de solutions cloud native ou zero trust, les entreprises ne se laissent pas séduire par le ‘rip-and-replace’ ». M. Pradeep ajoute que l’ISG constate une certaine lassitude du changement dans les entreprises. Les préoccupations relatives à la migration des applications, à la complexité du cloud et à la préparation à la cybersécurité tendent à dominer les conversations. D’un autre côté, il note que les entreprises plus petites et plus agiles préfèrent les remplacements complets.

Malgré l’IA, la supervision humaine reste nécessaire

L’étude de l’ISG a révélé une demande importante de la part des entreprises pour des capacités d’intelligence artificielle dans les déploiements SD-WAN. Cependant, la réalité diffère considérablement des promesses de réseaux entièrement autonomes faites par les fournisseurs.

L’étude montre que les principales entreprises déploient l’IA pour des cas d’usage spécifiques :

– Les réseaux auto-réparateur et le zero touch provisioning

– La classification du trafic et l’optimisation dynamique des chemins.

– Des capacités de basculement proactif.

– La gestion du tri et des alertes.

Cependant, l’étude révèle également d’importantes limitations dans les capacités actuelles de l’IA. « Nous n’avons pas trouvé d’exemple de réglage autonome du réseau WAN avec Copilot et il faut toujours un humain dans la boucle », a expliqué M. Pradeep. « L’application des accords de qualité de service (SLA) pilotée par l’IA, qui permettrait de corréler la télémétrie entre les réseaux, les applications, l’identité, etc, n’est pas non plus visible dans les faits. »

Des déploiements edge et 5G privée en cours

L’étude montre également que des implémentations de l’edge computing et de l’intégration de la 5G privée avec l’infrastructure SD-WAN sont en cours. « La 5G privée existe comme lien SD-WAN dans les entrepôts, les ports et les usines pour des applications à faible latence et à haute fiabilité au-delà des uCPE habituels et des boîtiers SASE déployés sur des magasins avec un repli 5G et une télémétrie en temps réel », a indiqué M. Pradeep. L’ISG s’attend à des capacités d’intégration accrues dans de multiples technologies. « L’ingénierie LEO (Low Earth Orbit) avec Starlink, Kuiper et WiFi 6/7 pourrait augmenter au cours des une à trois prochaines années grâce au travail effectué sur la micro-segmentation, les API ouvertes pour la gestion de la charge de travail et l’intégration SASE en temps réel », a-t-il ajouté.

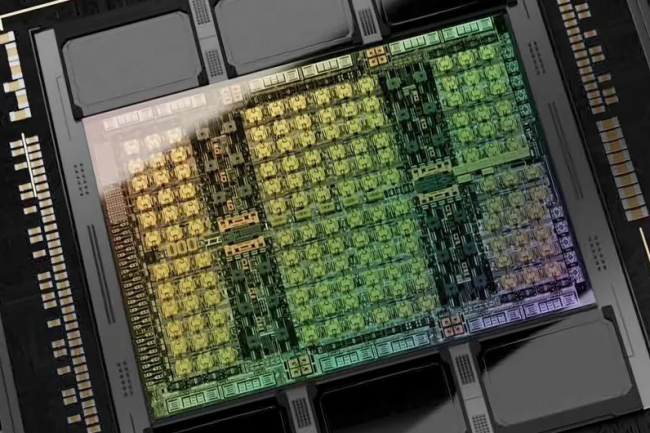

Après la convocation de responsables de NVidia par les autorités réglementaires chinoises à propos de présumées failles de sécurité dans le GPU H20 pour l’IA, Pékin intensifie sa pression sur le fournisseur.

C’est par la voie des réseaux sociaux WeChat et Sina Weibo que les autorités chinoises ont interpellé Nvidia à propos de l’existence de portes dérobées au sein de l’accélérateur H20 pour l’IA Ces dernières ont de nouveau pu être acheminées en Chine après la levée de l’interdiction d’exportation par l’administration Trump. Malgré les démentis de Nvidia sur les problèmes sécurité, les réseaux sociaux soulignent que « l’entreprise ne peut apaiser les inquiétudes des utilisateurs chinois et restaurer la confiance du marché qu’en fournissant des preuves de sécurité convaincantes, comme exigé lors de la convocation ».

L’escalade a commencé jeudi dernier lorsque l’Administration chinoise du cyberespace, la China’s Cyberspace Administration (CAC), a convoqué des représentants de Nvidia pour aborder les « graves problèmes de sécurité » liés aux capacités potentielles de suivi et d’arrêt à distance intégrées dans les puces H20. Elle a demandé des explications et des documents sur d’éventuels risques de sécurité relatifs aux portes dérobées présumées. « La cybersécurité est d’une importance capitale pour nous. Nvidia n’a pas de « portes dérobées » dans ses puces qui permettraient à quiconque d’y accéder ou de les contrôler à distance », a déclaré un porte-parole de la société.

La traçabilité des puces exportées au centre du débat

Parmi les scénarios d’exploitation potentielle des vulnérabilités des puces, le Quotidien du Peuple évoque un « véhicule à énergie électrique perdant soudainement de la puissance sur l’autoroute, ou l’écran noir pendant une opération chirurgicale d’un patient à distance ou l’arrêt soudain de la fonction de paiement par téléphone mobile à la caisse d’un supermarché ». Le media s’alarme du fait que « le risque de sécurité lié aux vulnérabilités et aux portes dérobées de ces puces pourrait entrainer des situations « cauchemardesques » à tout moment ». L’enquête de sécurité déclenchée par Pékin est directement lié à de récentes propositions législatives américaines exigeant que les puces d’IA avancées soient équipées de systèmes de localisation obligatoires.

Présenté le 8 mai 2025 par le sénateur Tom Cotton, le Chip Security Act est destiné à « empêcher les puces américaines avancées de tomber entre les mains d’adversaires tels que la Chine ». S’il était voté, il imposerait, dans les six mois suivant son entrée en vigueur, de soumettre les puces avancées à un contrôle des exportations en les équipant de mécanismes de vérification de localisation, et obligerait les exportateurs à signaler au Bureau de l’industrie et de la sécurité (BIS) tout détournement ou altération des produits. La déclaration des autorités chinoises fait référence aux « demandes des législateurs américains visant à ajouter des fonctionnalités de suivi aux puces avancées » et précise que « selon les experts américains en IA, les technologies de contrôle à distance liées aux puces de Nvidia ont atteint leur maturité ».

Les démentis de Nvidia, insuffisants pour la Chine

Le Quotidien du Peuple revient sur une déclaration de Nvidia où l’entreprise rappelle que « la cybersécurité est d’une importance capitale » pour elle et affirme que « ses puces n’ont pas de portes dérobées qui permettraient à quiconque d’y accéder ou de les contrôler à distance ». Cependant, le média d’État qualifie cette réponse d’insuffisante, soulignant que seules des « preuves de sécurité convaincantes » garantiraient le retour de la confiance. Le spécialiste des accélérateurs IA est sous pression pour trouver un équilibre entre les exigences de sécurité américaines et les demandes du marché chinois.

Lors de l’annonce de la reprise des exportations, le secrétaire américain au Commerce, Howard Lutnick, avait décrit l’accélérateur H20 comme le « quatrième meilleur » processeur de Nvidia. « Nous ne leur vendons pas nos meilleurs produits, ni nos deuxièmes meilleurs produits, ni même nos troisièmes meilleurs produits. » Le GPU H20 fait partie de la gamme de produits développés spécifiquement par Nvidia pour le marché chinois afin de répondre aux restrictions commerciales américaines. Le H20 est une version réduite de la puce Hopper, moins performante, mais avec une puissance de traitement suffisante.

Difficultés d’approvisionnement en puces

Cette confrontation met en évidence les tensions qui pèsent sur les chaînes d’approvisionnement en semi-conducteurs, essentielles au déploiement de l’IA dans les entreprises. Le Quotidien du Peuple a souligné que « la cybersécurité a non seulement un impact sur notre vie quotidienne, mais qu’elle est également vitale pour les entreprises et directement liée à la sécurité nationale ». Pour les responsables IT des entreprises, ce différend souligne la complexité de l’approvisionnement mondial en puces d’IA dans un contexte de tensions géopolitiques accrues.

Les entreprises opérant dans plusieurs régions pourraient avoir à réévaluer leurs stratégies d’approvisionnement en semi-conducteurs, car les exigences américaines en matière de suivi et les préoccupations chinoises en matière de sécurité redéfinissent la dynamique du marché. L’industrie des semi-conducteurs doit développer à la fois des produits qui satisfont aux exigences de contrôle des exportations américaines et aux normes de sécurité chinoises, un exercice d’équilibre qui pourrait avoir un impact sur les marchés mondiaux de l’IA.

130 Md$ de pertes dans le secteur des semi-conducteurs

Ce différend s’inscrit dans le contexte d’une concurrence technologique croissante entre les États-Unis et la Chine, qui remodèle les chaînes d’approvisionnement mondiales en semi-conducteurs. En octobre 2022, l’administration Biden avait mis en place des contrôles à l’exportation très stricts visant l’accès de la Chine aux semi-conducteurs de pointe, et ces restrictions ont été renforcées en octobre 2023 et décembre 2024. Selon le Center for Strategic and International Studies, l’annonce des contrôles à l’exportation en octobre 2022 a entraîné une perte de 130 milliards de dollars de capitalisation boursière pour les entreprises américaines de semi-conducteurs concernées.

La Chine a réagi en créant un fonds d’investissement de 47,5 milliards de dollars dans les semi-conducteurs en mai 2024, son troisième fonds de ce type au cours de la dernière décennie. Sous la seconde administration Trump, les droits de douane américains moyens sur les exportations chinoises ont atteint 54,9 % en août 2025, couvrant tous les produits. La Chine a riposté en imposant des droits de douane moyens de 32,6 % sur les exportations américaines. Le lancement en janvier 2025 par la start-up chinoise DeepSeek de modèles d’IA avancés rivalisant avec ceux d’entreprises américaines telles qu’OpenAI montre que malgré les restrictions, la Chine continue à innover. Nvidia n’a pas immédiatement répondu à une demande de commentaire.

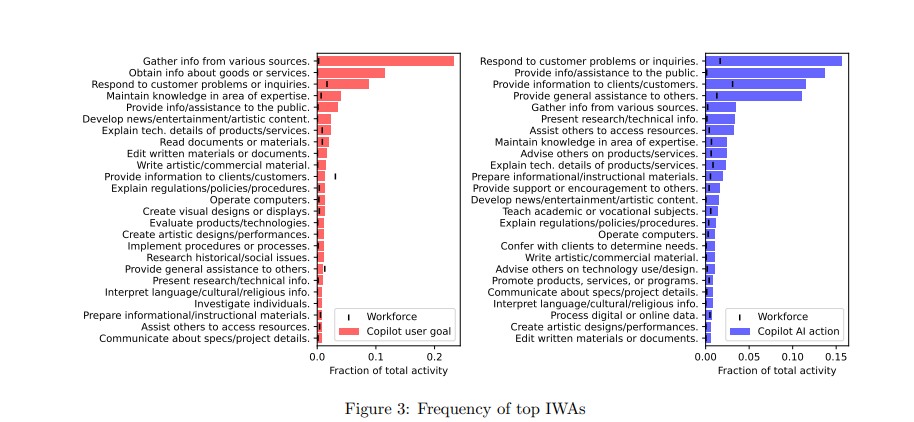

Selon une étude de Microsoft Research basée sur l’utilisation de l’outil de GenAI Copilot, l’automatisation générée par l’IA pourrait transformer les emplois IT en modifiant les missions des professionnels en poste plutôt qu’en les détruisant.

Les avis sont mitigés quant aux effets de l’IA sur les emplois informatiques. Après la Fondation Linux, c’est au tour de Microsoft Research de publier une étude sur l’utilisation de son outil Copilot et sur les professions IT qui seront les plus impactées par cette technologie. Le rapport « Mesurer les implications professionnelles de l’IA générative » a étudié les effets du chatbot Copilot intégré à Microsoft 365, au navigateur Edge et au moteur de recherche Bing. Elle suggère que l’IA entraînera la disparition de certains emplois IT mais qu’il est tout aussi probable qu’elle modifiera la façon dont les informaticiens exercent leur métier plutôt que de les rendre inutiles. Dans ce but, une analyse a porté sur 200 000 conversations anonymes entre des utilisateurs américains de Copilot via une recherche sur Bing en 2024, ainsi que sur 100 000 interactions issues de la base de données de retours utilisateurs de Copilot.

À partir de ces données, les équipes de l’éditeur ont calculé l’usage de l’outil de GenAI dans un large éventail de postes, en reliant cette utilisation à l’efficacité de l’application pour réaliser des tâches spécifiques. Comme on pouvait s’y attendre, les métiers IT ont obtenu de bons résultats en termes d’applicabilité de l’IA. Autrement dit, la technologie peut être utilisée pour de nombreuses tâches informatiques déjà réalisées. Cependant, d’importantes réserves s’imposent. En effet, l’étude n’a porté que sur les données de Copilot, consultées via la recherche Bing. D’autres LLM auraient pu avoir un impact plus ou moins important.

Des missions IT mal identifiées

De même, analyser les professions en les décomposant par activités individuelles ne donne qu’une vision partielle de ce qu’implique un emploi. Dans l’IT, des professions diverses supposent des compétences et des actions qui ne sont pas explicitement mentionnées dans une description de poste. La question de l’usage de Copilot mérite également d’être soulignée. Cet outil étant principalement utilisé par l’ensemble des salariés, il nous renseigne peu sur l’impact de l’IA sur le codage, le support informatique ou la cybersécurité, autant de domaines qui pourraient être fortement impactés par des outils plus spécialisés.

Top 25 des objectifs et des tâches réalisées avec l’agent IA Copilot.(Source :Microsoft Research)

Ce qui n’est pas clair, c’est si l’automatisation d’un poste le rend obsolète. Le rapport de Microsoft Research cite l’exemple intéressant de l’avènement des distributeurs automatiques de billets dans les années 1970, qui aurait dû réduire les besoins dans les guichets. En réalité, le nombre d’employés chargé de traiter les dépôts et les sorties de caisse a augmenté à mesure que les banques ouvraient davantage d’agences. Ces emplois ont alors effectué des tâches bancaires plus complexes, allant au-delà du simple traitement des billets.

Des professions IT appelées à évoluer

« Il est tentant de penser que les professions qui recoupent fortement des activités réalisées par l’IA seront automatisées et subiront donc des pertes d’emplois ou de salaires, tandis que les métiers assistés par l’IA verront leurs effectifs augmenter et leurs salaires augmenter. Cé serait une erreur, car nos données n’incluent pas les impacts métiers en aval des nouvelles technologies, qui sont très difficiles à prévoir et souvent contre-intuitifs. », suggère également l’étude. L’automatisation va plutôt réduire les besoins sur une tâche spécifique, permettant ainsi aux employés de se consacrer sur des missions totalement différentes. Cela sous-entend que les postes ne sont pas créés puis supprimés simplement. Les entreprises qui les emploient évoluent constamment pour répondre à des pressions autres que de simples calculs de coûts.

Les missions les plus assistées avec l’IA et celles qui sont les plus performantes. (Source : Microsoft Research)

« Ce phénomène n’est pas nouveau : la majorité des emplois actuels relèvent de professions apparues au cours des 100 dernières années avec les nouvelles technologies », souligne le rapport. Il est possible que l’IA connaisse un scénario similaire, tout comme la cybersécurité, jusqu’alors marginale sur le marché du travail, qui est devenue incontournable ces dernières années. L’étude annuelle d’ISC2 sur la main-d’œuvre en cybersécurité fait désormais régulièrement état d’importantes pénuries de compétences. Celles-ci sont dus à une demande non satisfaite sur les savoir-faire requis et au nombre insuffisant en salariés qualifiés.

C’est ce qui se passe dans divers secteurs informatiques depuis toujours. On peut donc affirmer que l’IA ne réduira pas tant la demande qu’elle ne modifiera les compétences requises. La capacité d’automatiser les tâches ne sera pas l’ennemi des emplois IT, mais elle sera au contraire essentielle à leur avenir.

Dorénavant géré par la Fondation Linux, le protocole open source Agent2Agent passe en version 0.3. Cette dernière introduit le support gRPC, une sécurité renforcée et des fonctions axées développeurs.

Google Cloud reste un des principaux contributeurs du protocole Agent2Agent (A2A) qu’il avait présenté à Next en avril 2025. Il vient d’annoncer la version 0.3 du projet open source désormais chapeauté par la Fondation Linux. La dernière itération propose plusieurs évolutions et améliorations sur le plan fonctionnel et sécurité. En premier lieu, le fournisseur de cloud a annoncé le support du gRPC, un framework open source développé par la firme de Mountain View. Il vise à assurer la communication entre applications via des appels distants.

Cet outil a la particularité de pouvoir fonctionner de manière très performante, même lorsque les applications se trouvent sur des machines différentes ou sont écrites dans des langages différents. « Les performances élevées du gRPC et la prise en charge de plusieurs langages de programmation en font un outil adapté aux applications complexes et distribuées », a déclaré Stephanie Walter, analyste chez Hyperframe Research. De plus, selon Dion Hinchcliffe, analyste chez The Futurum Group, les capacités de faible latence et de haut débit du framework lorsqu’il est intégré à l’A2A le rendront plus adaptable à l’orchestration multi-agents en temps réel. « Pour les entreprises, le support du gRPC donne la capacité aux agents d’interopérer via un protocole largement adopté et indépendant du langage qui simplifie l’intégration avec les microservices et les architectures cloud natives existantes », a fait remarquer Dion Hinchcliffe.

Des cartes d’identités sécurisées des agents

Pour stimuler encore un peu plus l’adoption de son protocole par les entreprises, Google a introduit dans A2A une capacité de signature des cartes de sécurité. « Celle-ci est essentielle pour les développeurs et les grandes entreprises, en particulier les entreprises du Fortune 500, car elles ne déploieront pas d’agents qui ne peuvent pas prouver leur identité de manière cryptographique », a rappelé Paul Chada, cofondateur de DoozerAI, une plateforme de travailleurs numériques alimentés par des agents.

De la même manière, Stéphanie Walters pense que « cette capacité de sécurité va aider les entreprises à s’assurer de la bonne application des politiques appropriées de contrôle d’accès et d’exécution. Ainsi, elles se protégeront contre une attaque qui pourrait nuire à la réputation, exposer des secrets commerciaux ou avoir un impact négatif sur le résultat net ». Elle ajoute que « les développeurs peuvent aussi utiliser cette fonctionnalité pour s’assurer que tout agent, en particulier ceux qui ne sont pas écrits par l’entreprise, provient d’une source fiable ».

Intégration de l’A2A dans l’Agent Development Kit

L’analyste estime par ailleurs que l’intégration par Google d’A2A à son framework open source Agent Development Kit (ADK) pour la création d’agents va accélérer l’intégration et la composabilité des agents pour les entreprises utilisant ADK. « Essentiellement, Google intègre la prise en charge du protocole A2A directement dans ADK, de sorte que les agents construits avec cet outil bénéficient automatiquement des capacités de communication A2A. C’est un peu comme si l’intégration de Slack se faisait directement dans le framework de développement sans avoir besoin d’effectuer un travail d’intégration distinct », a expliqué M. Chada de Doozer.

Le fournisseur a également étendu la prise en charge côté client dans le SDK Python intégré à son kit de développement d’agents. « Cette extension donnera aux développeurs la capacité de créer et de gérer plus facilement des agents A2A à l’aide de Python », a fait remarquer Dion Hinchcliffe. « Pour les entreprises, ce support va fluidifier le développement, car les équipes pourront construire, tester et déployer des flux de travail agentiques plus rapidement tout en restant dans leur chaîne d’outils d’IA existante », poursuit l’analyste. Afin de stimuler la diffusion de l’A2A, Google autorise désormais à ses partenaires de vendre des agents supportés par l’A2A sur sa place de marché AI Agents Marketplace. Il est donc possible d’évaluer les systèmes d’agents qui prennent en charge l’A2A par l’intermédiaire du service d’évaluation Vertex GenAI Evaluation Service.

A2A ou MCP ?

En ce qui concerne les deux protocoles open source qui promettent aux agents de communiquer entre eux, les experts affirment que le Model Context Protocol (MCP) a une longueur d’avance sur l’A2A. « D’après ce que l’on observe dans la communauté des développeurs, le MCP a le vent en poupe en termes de facilité d’utilisation et il est très bien adopté par la communauté », observe Paul Chada. Selon Dion Hinchcliffe, MCP le bénéficie également d’un soutien plus large de la part des fournisseurs et il est plus neutre sur le plan de l’écosystème. Google fait valoir qu’actuellement au moins 150 partenaires l’aident à construire, codifier et adopter l’A2A comme protocole standard pour les agents IA. Cependant, les deux spécialistes sont divisés sur les cas d’usage qui conviennent à chaque protocole. De son côté, M. Hinchcliffe pense que l’A2A est plus adapté aux écosystèmes d’agents liés à la pile de Google, et que le MCP s’adresse plus aux environnements hétérogènes et multifournisseurs dans lesquels les entreprises ont besoin d’interopérabilité entre différents modèles et fournisseurs.

Pour sa part, Paul Chada note que le MCP excelle dans les scénarios d’intégration d’outils à agent unique, tandis que l’A2A cible l’orchestration multi-agents dont les entreprises ont réellement besoin. « Le MCP est plus réputé auprès des développeurs, mais l’A2A dispose des partenariats d’entreprise qui comptent pour les déploiements à grande échelle. La question est de savoir si les utilisateurs veulent la simplicité ou les fonctionnalités d’entreprise », glisse-t-il. Par contre, les deux experts s’accordent à dire que l’A2A est plus sûr que le MCP. « L’A2A offre actuellement des primitives de sécurité intégrées plus robustes : des cartes de sécurité signées et le réseau zero trust de Google. Il est donc plus facile pour les entreprises de mettre en place des interactions sécurisées avec les agents. La sécurité du MCP est plus flexible, mais nécessite une mise en œuvre minutieuse entre les fournisseurs, ce qui peut introduire des écarts », conclut Dion Hinchcliffe.

Des chercheurs montrent comment des attaquants exploitent les versions d’essai gratuites des EDR pour désactiver d’autres EDR existants. Une technique qui fonctionne même si la protection anti-falsification est activée.

Les cybercriminels ont trouvé un moyen pour le moins original pour désactiver un outil de détection des menaces (EDR). Ils se servent d’autre EDR explique les experts en sécurité Ezra Woods et Mike Manrod. Baptisé « violence EDR contre EDR », cette attaque s’appuie sur l’usage des versions d’essai gratuites des outils pour s’en prendre à d’autres. « Il s’avère que l’un des moyens de désactiver l’EDR est d’en proposer une version d’essai gratuite », rapportent-ils dans une étude.

Cette technique exploite un postulat fondamental en cybersécurité : la fiabilité des outils de sécurité officiels. Selon les chercheurs, les attaquants s’inscrivent à des essais gratuits d’EDR, les installent sur des systèmes compromis avec des privilèges d’administrateur local, puis configurent le logiciel de sécurité contrôlé par l’attaquant pour bloquer les outils de protection existants. Lors de leurs tests, les spécialistes ont constaté que Secure Endpoint de Cisco pouvait désactiver Falcon de CrowdStrike et Elastic Defend sans générer d’alertes ni de télémétrie depuis les systèmes ciblés. Les terminaux compromis semblaient simplement se déconnecter, sans indiquer aux équipes de sécurité que leur protection avait été délibérément sabotée. « Ceci est réalisé en supprimant les exclusions, puis en ajoutant le hachage de l’antivirus/EDR existant comme application bloquée », expliquent-ils dans leur analyse.

Au-delà du simple sabotage

L’étude a révélé des capacités qui vont bien au-delà de la simple perturbation de l’EDR. Ainsi dans le cas d’Eset, les spécialistes ont pu installer une instance contrôlée par eux en détournant l’agent d’installation de l’outil officiel. Par ailleurs, « certains produits EDR présentent des fonctionnalités similaires à celles des outils de surveillance et de gestion à distance (RMM) avec un large potentiel d’abus », observent-ils. Dans des cas extrêmes impliquant Eset, ils ont découvert la possibilité de contrôler le chiffrement intégral du disque via l’interface compromise.

De même, l’attaque contourne les fonctions de protection anti-falsification spécialement conçues pour empêcher les modifications non autorisées des outils de sécurité. « Ce vecteur est intéressant car il peut désactiver au moins certains produits, même si cette fonctionnalité est activée », ont expliqué les chercheurs. Ils ajoutent que si l’attaque nécessite des privilèges d’administrateur local, elle représente une approche moins complexe que les techniques d’évasion EDR traditionnelles telles que les attaques BYOVD (Bring Your Own Vulnerable Driver) ou le décrochage de DLL

Une détection difficile et des recommandations

Cet abus EDR montre une évolution de l’exploitation des outils officiels dans le panorama des menaces. Un rapport de Crowdstrike 2025 observe une hausse de 70% de ce type d’attaque d’une année sur l’autre. Un constat partagé par l’expert en cybersécurité connu sous le pseudonyme BushidoToken qui a publié sur X des articles sur des cybercriminels abusant activement de certains EDR. Il s’est interrogé sur l’opportunité de créer une sous-catégorie MITRE ATT&CK. Mais comme l’indiquent Ezra Woods et Mike Manrod, « ces outils sont officiels, fiables et disposent d’un certificat valide. Ils sont donc moins susceptibles d’être détectés ». Un défi pour les équipes de sécurité, car les méthodes traditionnelles de détection peuvent échouer. « Aucune activité malveillante évidente n’est générée pendant le processus de désactivation, et les systèmes semblent simplement se déconnecter plutôt que de montrer des signes clairs de compromission », soulignent les experts. Cela crée un angle mort dangereux pour les SOC (security operation center) qui s’appuient sur la télémétrie des terminaux pour surveiller leurs environnements. Quand un agent EDR cesse de signaler des incidents, il peut s’agir de plusieurs choses : un arrêt du système, un problème de connectivité ou cette nouvelle forme d’attaque.

Les deux chercheurs ont formulé des recommandations aux entreprises cherchant à se défendre contre cette menace en déployant des solutions de contrôle des applications. Elles sont capables de bloquer les installations non autorisées de logiciel de sécurité et d’appliquer des « indicateurs d’attaque » personnalisés pour détecter les mises en place suspectes d’EDR. En complément, « des pare-feu applicatifs et des passerelles web sécurisées peuvent contribuer à bloquer l’accès aux portails non autorisés des fournisseurs de sécurité » ont-ils ajouté. Enfin, ils ont livré des instructions détaillées aux équipes de sécurité pour tester ce vecteur d’attaque dans leurs propres environnements avec quelques consignes : effectuer des tests contrôlés sur des systèmes isolés, surveiller les failles de détection dans les outils de sécurité existants et analyser les chronologies et les indicateurs d’attaques.

Le groupe de criminels par rançongiciel Scattered Spider change son mode opératoire en poussant les utilisateurs à réinitialiser les mots de passe et à transférer les jetons MFA vers des terminaux qu’ils contrôlent.

Dans le viseur du FBI et de plusieurs agences de cybersécurité mondiales, le cybergang Scattered Spider (aussi appelé Ocktopus, Octo Tempest, Scattered Swine et UNC3944) qui vise les instances ESXi recourt à d’autres tactiques pour piéger davantage de victimes. De nombreux gouvernements à travers le monde ont alerté sur le fait que ce groupe se fait passer par des employés pour tromper les services de support informatique des entreprises. Le but ? Les pousser à réinitialiser leurs mots de passe et transférer…

Il vous reste 98% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

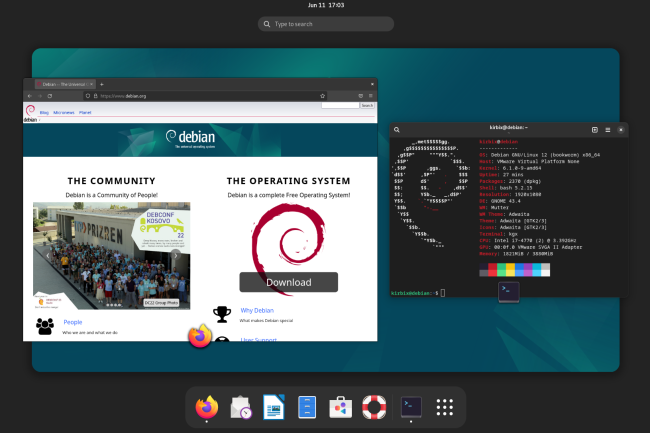

Debian anticipe les problèmes liés au bug de l’année 2038 sur les systèmes Unix. La version 13 de la distribution change le stockage des dates et des heures en variable de 64 bits. Un démarche qui a nécessité un travail ardu des équipes qui restent néanmoins vigilantes pour le futur.

Connu sous le nom « Epochalypse Unix », le bug de l’année 2038 commence à être pris au sérieux par les éditeurs de distribution Linux. En l’occurrence Debian anticipe le problème en mettant à jour son horloge en stockant l’heure dans des variables 64 bits au lieu de 32 bits actuellement. Cette évolution sera disponible le 9 août prochain dans la version 13, nommée « Trixie » de Debian.

Ce bug aussi appelé Y2K38 s’apparente à celui de l’an 2000. Les horloges Unix (et Linux) comptent le temps en secondes à partir du 1er janvier 1970, surnommé l’Époque Unix. Certains systèmes stockent ce nombre dans un entier signé de 32 bits qui attendra sa limite le 19 janvier 2038 à 03h14 et 7s (UTC). La seconde suivante provoquera un retour dans le passé pour afficher la date du 13 décembre 1901 à 20h45 et 52s. Ce dérèglement risque d’entraîner des problèmes pour certains applicatifs et même des protocoles réseaux. Il peut toucher des systèmes de contrôle d’usine et de surveillance des bâtiments aux routeurs et caméras de sécurité qui fonctionnent sur des OS embarqués souvent une distribution Linux en 32 bits.

Une transition ardue et sous surveillance

Une des solutions pour éviter ce risque est de remplacer le stockage des dates par des variables 64 bits au lieu de 32 bits. Elle accorde un répit confortable de plus de 292 milliards d’années. Mais pour les mainteneurs de Debian, cette tâche s’est révélée ardue. En effet, il a été nécessaire de travailler sur 6 500 paquets et en une seule fois, car cela impliquait également une modification de l’interface binaire d’application (ABI). Cette dernière agit entre deux composants logiciels pour gérer l’allocation des registres et l’agencement de la mémoire.

Les équipes de Debian estiment que le travail est maintenant terminé ou du moins aussi fini qu’il peut l’être pour le moment. Afin d’assurer la compatibilité avec les binaires x86, l’éditeur conserve les dates sur les systèmes i386 en 32 bits, tout en étudiant d’autres options si la demande pour des dates 64 bits sur ces systèmes est suffisante. La vigilance est donc de mise même si le danger semble lointain. « Cela ne devrait pas arriver avant au moins 13 ans, mais de nombreux systèmes susceptibles d’être concernés ont déjà été livrés. Et nous ne voulons pas aggraver la situation », glisse Debian dans un message. Il ajoute que « la plupart des calculs, notamment ceux utilisant Debian ou ses dérivés, sont désormais réalisés sur du matériel 64 bits, où ce problème ne se pose pas. Cependant, de nombreux calculs 32 bits, plus coûteux, sont encore disponibles et sont encore livrés sur des terminaux (automobile, IoT, téléviseurs, routeurs, contrôle d’usine, surveillance/contrôle de bâtiments, téléphones Android bon marché, etc.), dont une partie fonctionne probablement sous Debian ou ses dérivés ». L’éditeur se déclare préoccupé « par l’architecture armhf, car c’est celle 32 bits la plus susceptible d’être encore largement utilisée dans les nouveaux systèmes au cours de la prochaine décennie ».