Pour muscler la protection des données, Blackblaze a ajouté des fonctions de détections d’anomalies à base d’IA et une console web pour gérer les contrôles d’accès basés sur les rôles.

Face à la croissance des fuites de données, les fournisseurs de stockage cloud étoffent progressivement les mesures de sécurité. C’est le cas de Blackblaze qui a annoncé plusieurs évolutions de sa plateforme B2. Elles complètent les fonctionnalités de protection déjà existantes, notamment l’architecture et la sécurité physique certifiées SOC 2, le chiffrement côté serveur pour les données au repos et le support de la spécification Cors (partage des ressources entre origines multiples) pour l’intégration des applications. Elles comprennent aussi la réplication cloud pour la redondance des données et Object Lock pour la protection contre les ransomwares.

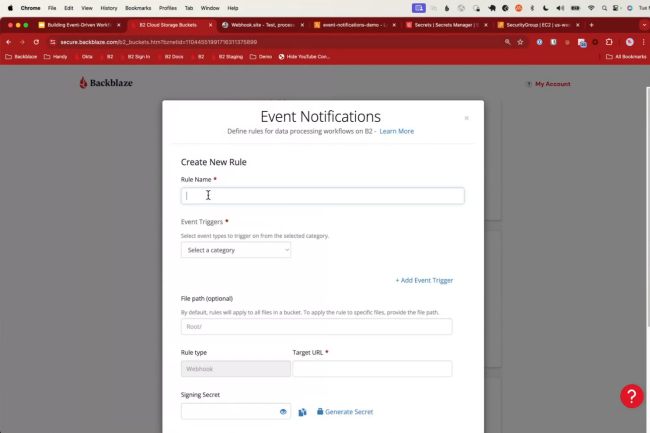

Le fournisseur ajoute Anomaly Alerts, une solution à base d’IA pour identifier des schémas d’activités suspects dans les buckets de stockage. Elle détecte ainsi des signes d’un accès non-autorisé ou d’une exfiltration de données. Cette capacité est actuellement disponible en préversion privée. En complément, Notification Event envoie des alertes en temps réel sur les activités des buckets comme la création, la suppression ou la modification d’objets.

Gestion des clés améliorée et contrôle d’accès basé sur les rôles

En parallèle, Blackblaze a amélioré la fonction Application Keys avec la possibilité de créer des clés uniques pour plusieurs buckets. Cette amélioration offre ainsi un contrôle plus précis de l’accès aux buckets, réduisant ainsi la surface d’attaque. Toujours dans le domaine des clés, la société propose désormais le service Scalable Application Keys capable de générer jusqu’à 10 000 clés uniques et éphémères par minute pour l’accès aux données. Cette fonction réduit la fenêtre d’exposition des clés individuelles. De son côté, Custom Upload Timestamps spécifie l’heure exacte du téléchargement des objets stockés. Un moyen pour préserver l’intégrité des données, prendre en charge un contrôle de version précis et répondre à des exigences de conformités spécifiques.

Enfin, le fournisseur de stockage cloud a dévoilé une console pour gérer les contrôles d’accès basés sur les rôles (RBAC). Actuellement en préversion privée, elle est conçue pour offrir des fonctionnalités de gestion avancées et granulaires pour les grandes entreprises. Ces dernières peuvent ainsi mettre en place une approche zero trust en gérant les accès via du SSO ou du MFA en fonction des utilisateurs ou des groupes d’utilisateurs.

Bureau Veritas créé Cybersecurity pour unifier ses services de sécurité hérités des rachats de Secura et de Security Innovation.

Issue des rachats de Secura en 2021 et plus récemment en 2024 de Security Innovation, la plateforme Bureau Veritas Cybersecurity voit le jour, l’objectif étant pour le spécialiste de la conformité de proposer une seule et même organisation commerciale capable de fournir aux entreprises des conseils et des services en matière de sécurité axés sur les tests de logiciels, le conseil, l’audit et la formation.

Vers un réseau de portée mondiale

Pour rappel, Secura a été créée en 2000 aux Pays-Bas, la société comptait 100 employés répartis entre deux centres technologiques à Eindhoven et Amsterdam. Quant à Security Innovation, elle a été fondée en 2002 à Boston avec des bureaux à Seattle (USA) et Pune (Inde), ces deux acquisitions ont permis à Bureau Veritas Cybersecurity d’affirmer sa présence en Europe et aux États -Unis et de servir de tremplin à sa future conquête de la région Asie-Pacifique.

Les services de cybersécurité de Bureau Veritas comprennent entre autres des audits de sécurité, telles que l’ingénierie sociale et les tests de pénétration pour identifier les domaines à améliorer, des services de conseil et des programmes de sensibilisation pour optimiser la cyberdéfense.

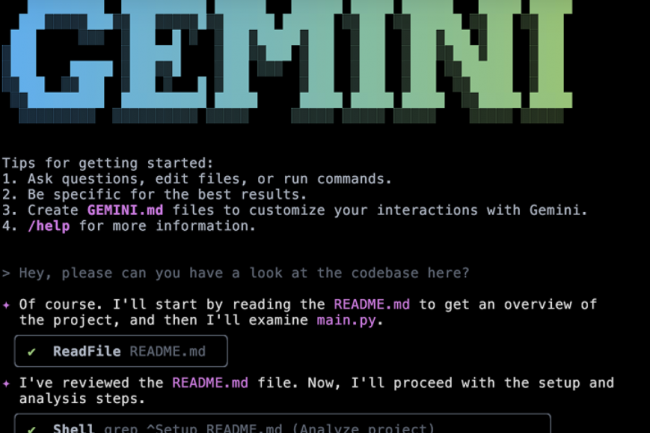

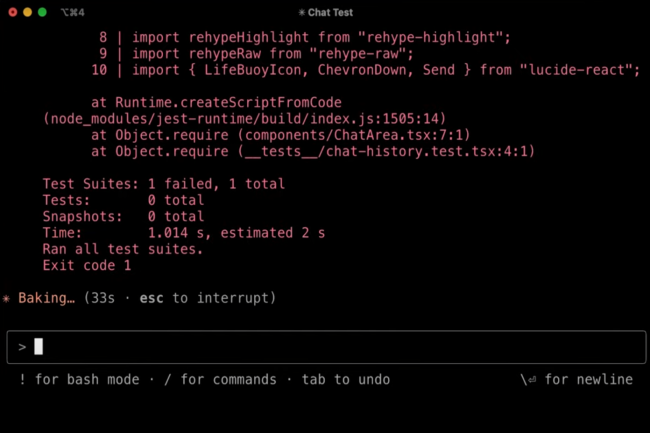

L’agent IA de codage en ligne de commande de Google est vulnérable à des attaques par injection de prompts. Elle ouvre la voie à de possibles vols de données incluant des mots de passe et des clés API.

Si les agents IA de codage ont le vent en poupe, les questions autour de leur maturité et de leur sécurité se posent. Preuve en est, la découverte par des chercheurs d’une faille dans Gemini CLI de Google. De type injection de prompts, elle peut être exploitée par des pirates pour voler des données sensibles dont des identifiants, mots de passe et des clés API, sans que les programmeurs s’en aperçoivent. Lancé le 25 juin dernier, cet agent de codage intègre le LLM du fournisseur à des outils traditionnels de lignes de commandes incluant PowerShell ou Bash. Cela permet aux codeurs d’utiliser des prompts en langage naturel pour accélérer les tâches comme l’analyse et le débogage de code, la génération de documentation, et la compréhension de nouveaux répertoires. Deux jours après le lancement de cet outil, Tracebit révèle au fournisseur une première faiblesse que les développeurs pouvaient rencontrer en travaillant sur des dépôts de code open source non vérifiés. Dans leur PoC, des chercheurs ont montré que des prompts malveillants étaient poussés via de simples fichiers readme.md GNU (public licence) laissant croire qu’ils faisaient partie de repository open source.

Les chercheurs ont ensuite découvert d’autres failles potentiellement exploitables ensemble pour exécuter des commandes shell malveillantes. Le premier est que Gemini CLI octroie la capacité aux utilisateurs d’exécuter certaines commandes fréquentes, comme grep [pour rechercher et relier des patterns de texte dans des fichiers contenant des expressions régulières, ndlr], et éviter de constants avertissements d’autorisation. C’est un service utile, sauf quand le système est incapable de distinguer des commandes grep légitimes ou se faisant passer comme tel. Comme la vérification effectuée est simpliste, cela permettrait à un attaquant d’exécuter n’importe quelle commande malveillante qu’ils veulent sans avoir à re-prompter.

Des lignes de commandes camouflables

“Cela pourrait inclure une commande grep suivie d’une autre pour exfiltrer discrètement toutes les variables de l’environnement utilisateur, contenant potentiellement des secrets, à un serveur distant. Cette commande compromise pourrait faire n’importe quoi comme installer un shell distant, effacer des fichiers…”, explique Sam Cox, co-fondateur et CTO de Tracebit. Une fois validée, celle-ci pourrait alors être exécutée mais l’utilisateur ne pourrait-il pas la remarquer comme elle tourne dans son interface de ligne de commandes ? Si tel était le cas, cela permettrait de mettre à jour l’activité de l’attaquant. Malheureusement, Tracebit a découvert que ces lignes de commandes pourraient être cachées dans Gemini CLI en utilisant des caractères blancs pour les rendre invisibles à l’oeil. “C’est une combinaison d’injection de prompt, d’un manque de considération d’expérience utilisateur ne permettant pas de révéler les commandes à risque et leur insuffisante validation. Tout cela combiné, les effets sont significatifs et indétectables”, poursuit M. Cox. Ce même type d’attaque ne marche pas avec des outils concurrents : “Lorsque l’on essaye ce type d’attaque contre d’autres outils de codage IA, nous avons trouvé de multiples couches de protections qui les rendent inopérantes”.

Les outils IA sont un bon moyen d’accélérer et d’automatiser les tâches fastidieuses et consommatrices de temps. Cependant, ils font également la même chose pour aider les attaquants à préparer leur injection de prompt. L’exploit documenté par Tracebit repose sur des hypothèses non dénuées de fondement, selon lesquelles un attaquant pourrait exploiter ces failles dans des conditions réelles. Parallèlement, la chasse contre ce type de vulnérabilités est déjà lancée pour un large éventail de contexte et d’outils.

Un avertissement en cas de non usage du mode sandboxing

Ces trous de sécurité dans Gemini CLI ne seront sans doute pas les derniers. Ils ont été évalués par Google comme étant de gravité élevée (V1) et nécessitant une correction prioritaire (P1), et ont été corrigés dans la version 0.1.14 de Gemini CLI publiée le 25 juillet. Au-delà de la mise à jour, le meilleur conseil est toujours d’exécuter les outils en mode sandbox afin de les isoler du système hôte comme a pu le souligner la firme de Mountain View : “Notre modèle de sécurité pour la CLI est axé sur la fourniture d’un sandboxing robuste et multicouches. Nous proposons des intégrations avec Docker, Podman et macOS Seatbelt, et fournissons même des conteneurs pré-construits que Gemini CLI peut utiliser automatiquement pour une protection transparente”, a déclaré l’équipe du programme de divulgation des vulnérabilités de Google à Tracebit. “Pour tout utilisateur qui choisit de ne pas utiliser le sandboxing, nous nous assurons que cela soit clairement indiqué en affichant un avertissement permanent en rouge tout au long de sa session”.

Depuis plusieurs mois, Cisco et son incubateur Outshift travaillent sur la création d’une plateforme ouverte pour la gestion des agents. Aujourd’hui, l’équipementier annonce le transfert de son initiative sous les auspices de la Fondation Linux.

A l’occasion de Cisco Live à Amsterdam en février dernier, Guillaume Sauvage de Saint Marc, VP Engineering d’Outshift chez Cisco avait évoqué les travaux de l’incubateur sur l’Internet des agents et la volonté à terme de placer ces efforts sous l’égide d’une structure neutre. En l’espèce, Cisco vient de la choisir et ce sera la Fondation Linux. L’initiative nommée Agntcy continue donc sa vie en tant que projet open source. Elle vise à développer une infrastructure de…

Il vous reste 92% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

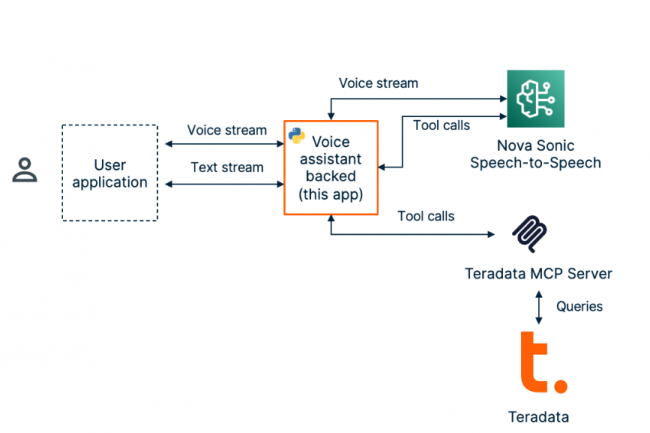

Le fournisseur en analyse et intégration de données Teradata a annoncé l’arrivée dans le courant du premier semestre 2026 de la version communautaire de son premier serveur Model Context Protocol. Une version commerciale avec un support complet est aussi en développement.

Dans un contexte de demande croissante d’applications alimentées par des agents d’IA, Teradata lance son premier serveur MCP (model context protocol). Hébergé sur GitHub et pris en charge par la communauté Teradata, ce serveur a pour ambition d’aider les entreprises à tester leurs flux agentiques accédant aux données stockées dans les data lake du fournisseur. La société a confirmé qu’une future version commerciale du serveur MCP offrira un « support complet », ce qui n’est pas le cas de la version Community Edition. « Cette version, dont la sortie est prévue au cours du premier semestre 2026, inclura des fonctionnalités essentielles pour les entreprises, telles que la sécurité, l’observabilité, l’évolutivité, la gestion de la charge de travail et la conformité, ce qui la rendra adaptée à un déploiement en production », a déclaré à InfoWorld Meeta Vouk, vice-présidente de la gestion des produits pour l’IA et l’analyse chez Teradata. « Les prochaines itérations cibleront les fonctionnalités avancées de sécurité et de gestion du contexte, ainsi que l’optimisation des ressources. Les clients pourront migrer du serveur communautaire vers le prochain produit », a ajouté Mme Vouk.

Contrairement à la Community Edition qui comprend des outils capables d’effectuer des tâches de développement courantes, la déclinaison commerciale sera dotée d’outils supplémentaires destinés à des tâches plus complexes, en particulier la génération et l’optimisation de SQL, la récupération de données multimodales, l’exécution de tâches d’ingénierie des données, l’exécution d’analyses dans la base de données et de pipelines d’apprentissage machine, ainsi que l’exécution de code Python personnalisé. Selon Robert Kramer, analyste principal chez Moor Insights and Strategy, la sortie d’une édition communautaire avant une version entièrement prise en charge a pour but de favoriser l’adoption précoce, tout en jetant les bases d’une future version lucrative.

Databricks et Snowflake aussi positionnés sur les serveurs MCP

Le premier jet est livré avec un ensemble d’outils et de prompts, regroupés en modules, que les agents peuvent utiliser pour interroger, analyser et gérer les données contenues dans les bases de données Teradata. Ces ensembles comprennent Base Tools pour l’engagement général sur la plateforme, DBA Tools pour les tâches d’administration des bases de données et Data Quality Tools qui accélèrent l’analyse exploratoire des données. De plus, le serveur MCP intègre un jeu d’outils spécialisés (gestion des autorisations, supervision des magasins de fonctions, génération augmentée de récupération (RAG) pour faciliter la création et l’utilisation de magasins de vecteurs). Une couche sémantique personnalisée Custom Semantic Layer qui « permet aux entreprises de créer des outils et des invites spécifiques à leur domaine, adaptés à leurs besoins uniques en matière de données commerciales », est également disponible.

Selon M. Kramer, cette première étape est conçue pour aider les clients à connecter directement les agents IA aux données opérationnelles grâce à une gouvernance intégrée, à la gestion des métadonnées, une base vectorielle et des outils de RAG, essentiels pour les cas d’usage de l’IA générative qui reposent sur la combinaison de données structurées et de LLM. Pour lui, grâce à cet accès aux données contenues dans les bases de données Teradata, les agents IA pourront avoir une meilleure compréhension contextuelle et fournir des réponses plus précises. Cependant, Teradata n’est pas le seul fournisseur d’analyse de données à proposer un serveur MCP. Alors que son concurrent Databricks propose des serveurs MCP managés qui offrent un accès contrôlé aux données structurées et non structurées via Genie Space MCP Server, Vector Search MCP Server et UC Function MCP Server, Snowflake a aussi publié ce mois-ci des ressources open source qui simplifient la création de serveurs MCP connectés à ses services. A noter aussi qu’un serveur MCP Snowflake alimenté par des contributeurs était déjà disponible sur GitHub avant même que le fournisseur publie ses ressources.

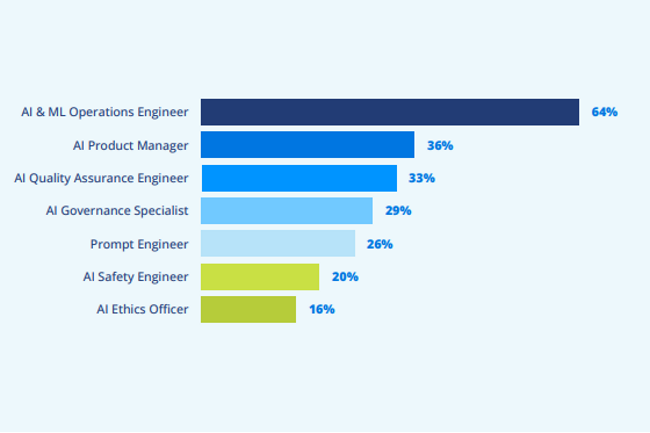

Dans son rapport sur la situation des profils IT en 2025, la Fondation Linux estime que l’IA entraîne plus de création d’emplois qu’elle ne va en supprimer. D’importantes pénuries sont déjà constatées en ingénierie et dans les opérations liée à l’IA et au machine learning.

Malgré les réductions d’effectifs en cours et les craintes de pertes d’emplois, le marché du travail dans l’IT présente des atouts. Selon les experts, l’intelligence artificielle ne détruit pas automatiquement les emplois et, dans certains cas, elle élargit les postes techniques plutôt que simplement réduire les effectifs. C’est ce que montre la Fondation Linux en publiant son rapport2025 “State of tech talents” réalisé auprès de plus de 500 responsables du recrutement, recruteurs et professionnels des…

Il vous reste 94% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

La version 24H2 de Windows 11 peut causer des perturbations importantes après l’installation de ses plus récentes mises à jour. Une situation qui se répète depuis son lancement en octobre dernier.

Les utilisateurs de Windows 11 24H2 doivent encore faire face à des soucis après l’installation de mises à jour. Depuis son lancement en octobre dernier, cette version du dernier OS de Microsoft a enchainé les problèmes, puis également en décembre dernier et en début d’année. Il y a quelques jours, le fournisseur a confirmé d’autres complications en indiquant que les derniers patchs obligatoires ont un impact négatif sur la stabilité du système d’exploitation. Un constat qui tombe mal pour l’entreprise qui affirmait récemment que Windows 11 était la version « la plus fiable » de Windows à ce jour. Les problèmes liés aux mises à jour obligatoires KB5060842 et KB5063060 de juin débouchent sur la multiplication de messages d’erreur tels que 0x800f0922, 0x80070002, 0x80070306 ou 0x800f0991. Selon Windows Latest, les soucis de stabilité du système sont variés : redémarrages intempestifs et baisses du framerate et des performances dans des jeux, gel de la barre des tâches de Windows, événements de pare-feu Windows incorrects…

Microsoft a décrit plusieurs erreurs dans un addendum à la MAJ KB5062660, actuellement en bêta. “Cette mise à jour résout un problème observé dans de rares cas après l’installation de la mise à jour de sécurité de mai 2025 et des mises à jour ultérieures, provoquant des problèmes de stabilité sur les systèmes. Certains terminaux ne répondaient plus et cessaient de répondre dans des scénarios spécifiques”, explique le fournisseur. “Cette mise à jour corrige un problème détecté dans l’observateur d’événements sous la forme d’un événement 2042 pour le pare-feu Windows avec sécurité avancée. L’événement se présente comme suit : « config read failed » (échec de la lecture de la configuration) avec le message « more data is available » (davantage de données sont disponibles). Pour plus d’informations sur ce problème, voir « des événements d’erreur sont enregistrés pour le pare-feu Windows » dans le tableau de bord de santé Windows.”

Aucun détail n’est fourni sur les raisons exactes de ces problèmes, mais il est possible d’y remédier en installant la mise à jour KB5062660.

Obtenir la mise à jour facultative KB5062660

Cette actualisation ne s’installe pas encore en standard sur tous les ordinateurs Windows et sera publiée pour tous les systèmes Windows lors du prochain Patch Tuesday du mois d’août. Si vous rencontrez l’un des problèmes décrits ci-dessus et que vous souhaitez installer la mise à jour facultative pour résoudre ces problèmes, il faudra le faire manuellement via Windows Update ou le catalogue de mises à jour du fournisseur. La société s’est récemment engagée à améliorer les performances de Windows 11 et a pris des mesures pour améliorer la stabilité de Windows 11 grâce à des normes plus strictes en matière de pilotes. Il est à espérer que l’entreprise tiendra ses promesses et que ce type de mises à jour de Windows 11, chargées de problèmes, appartiendra au passé.

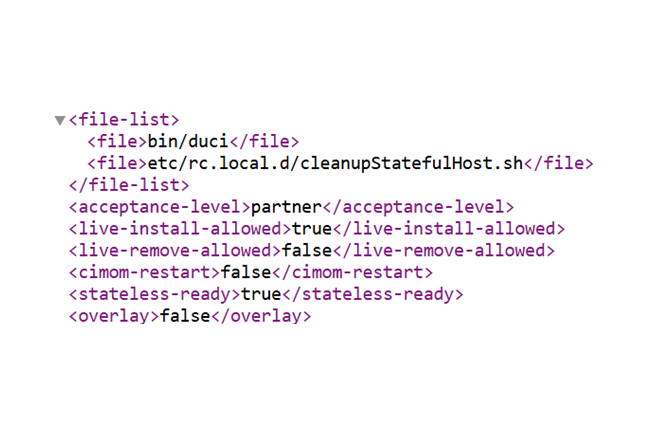

Baptisée Fire Ant, une campagne d’espionnage soutenue par la Chine exploite des failles dans l’hyperviseur ESXi de VMware. Elle touche les instances non corrigées pour contourner les défenses et persister au sein des cibles.

L’hyperviseur de type 1 ESXi de VMware a le vent en poupe auprès des cybercriminels. Après le gang de ransomware Scattered Spider, c’est autour d’une campagne d’espionnage nommée Fire Ant de s’en prendre à l’outil de virtualisation. Soutenue par la Chine, elle a été démasquée par les équipes de Sygnia, spécialiste de la sécurité et elle est active depuis le début de 2025. Les cyber-espions exploitent des failles critiques dans les environnements VMware pour gagner un accès non authentifié à l’infrastructure de virtualisation et déployer des logiciels malveillants persistants comme VirtualPita et autobackup.bin.

Selon Ev Kontsevoy, CEO de Teleport (éditeur de solutions de PAM), ce vecteur d’attaque est classique des Etats. « Fire Ant exploite les vulnérabilités des infrastructures et utilise des identifiants volés pour infiltrer les systèmes », a-t-il déclaré. « Cette tactique n’est pas exceptionnelle. En raison de son efficacité et de sa difficulté à être détectée, de nombreux groupes affiliés à des États adoptent désormais la même approche. » Même si l’entreprise de services de cybersécurité n’a pas voulu attribuer cette campagne à un acteur spécifique, elle note que les outils, les vecteurs d’attaque axés sur VMware, le temps de travail et les frappes au clavier correspondent étroitement aux conclusions précédentes sur le groupe UNC3886 lié à la Chine.

Un accès initial via les failles de VMWare

Les attaquants se sont servis de la vulnérabilité CVE-2023-34048 dans VMware vCenter pour exécuter du code à distance sans authentification (RCE), avant de récupérer les informations d’identification des comptes de service « vpxuser », créés automatiquement par vCenter pour gérer les hôtes ESXi avec des privilèges d’administration complets. Comme vpxuser est exempté des restrictions du mode verrouillage, les attaquants pouvaient conserver le contrôle au niveau de l’hôte sur tous les serveurs ESXi connectés, les machines physiques exécutant l’hyperviseur ESXi, même si les connexions directes étaient désactivées. Avec ces privilèges d’administration complets, les attaquants ont implanté des portes dérobées persistantes telles que VirtualPita et autobackup.bin, et ont désactivé le daemon de journalisation du système (vmsyslogd) afin de couvrir leurs traces lors des redémarrages.

Kontsevoy qualifie cela d’échec de la gestion des identités. « Les attaquants ont utilisé des identifiants volés pour créer des portes dérobées et imiter les actions légitimes des employés à l’aide d’outils courants et fiables », a-t-il fait remarquer. « En effet, une fois qu’une identité franchit une frontière technologique, sa trace est perdue. Personne ne peut voir où elle va ensuite. Ce manque de visibilité donne aux portes dérobées la capacité de passer inaperçues et aux attaquants de réintégrer l’infrastructure sans être détectés. » De plus, les attaquants ont exploité la vulnérabilité CVE-2023-20867 pour exécuter des commandes hôte-invité non authentifiées via VMware Tools/PowerCLI, accédant ainsi aux machines virtuelles invitées et extrayant les identifiants de domaine en mémoire.

Un mouvement latéral grâce au tunneling

Une fois à l’intérieur, Fire Ant a contourné la segmentation du réseau en exploitant la vulnérabilité CVE-2022-1388 dans les équipements F5 BIG-IP, et ils ont pu ainsi déployer des tunnels cryptés tels que les web shells Neo-reGeorg pour atteindre des environnements isolés, en tirant même parti de l’IPv6 pour contourner les filtres IPv4. « L’acteur malveillant a montré qu’il avait une compréhension approfondie de l’architecture et des politiques réseau de l’environnement cible, contournant efficacement les contrôles de segmentation pour atteindre des actifs internes, vraisemblablement isolés », a déclaré Sygnia dans son blog. « En compromettant l’infrastructure réseau et en créant des tunnels à travers des systèmes de confiance, l’acteur malveillant a systématiquement contourné les limites de segmentation, atteint des réseaux isolés et établi une persistance trans-sectorielle. » Les attaquants ont constamment adapté leurs techniques, en modifiant par exemple les outils, en dissimulant les fichiers et en déployant des portes dérobées redondantes, afin d’échapper à la détection et de retrouver l’accès après le nettoyage.

Sygnia a conseillé aux entreprises de corriger les composants VMware vulnérables, de faire tourner les identifiants des comptes de service sécurisés et d’appliquer le mode de verrouillage ESXi pour restreindre l’accès à l’hôte. Le fournisseur recommande également d’utiliser des Jump Hosts d’administration dédiés, de segmenter les réseaux de gestion et d’étendre la surveillance pour inclure vCenter, ESXi et les équipements qui manquent souvent de visibilité traditionnelle sur les terminaux. « La seule façon d’empêcher les pirates soutenus par des Etats et autres criminels d’accéder facilement aux infrastructures est d’unifier les identités », a ajouté M. Kontsevoy. « En fédérant toutes les identités, qu’elles soient humaines, logicielles, matérielles ou artificielles, les entreprises peuvent obtenir une source unique de vérité et une visibilité complète sur l’entrée et la circulation des identités dans leurs systèmes. »

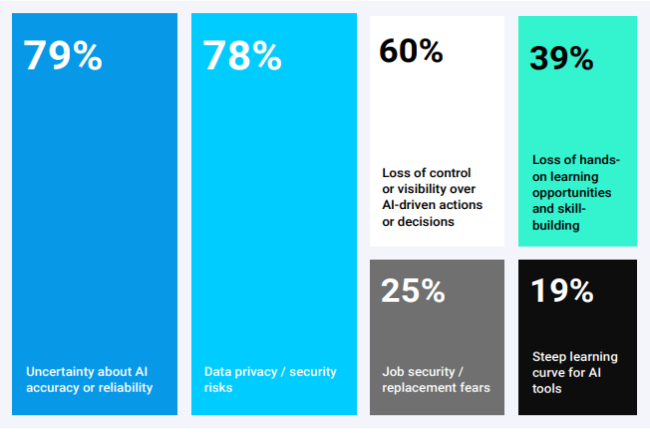

Une étude montre une adoption croissante de l’IA par les administrateurs systèmes. Elle révèle également les domaines dans lesquels ils manifestent un certain méfiance à l’égard de cette technologie.

Souvent méconnu, le travail des administrateurs système consiste à assurer le bon fonctionnement des systèmes IT, et la promesse de l’intelligence artificielle de réduire la fatigue liée aux alertes et d’automatiser les tâches incite nombre d’entre eux à adopter cette technologie. Cependant, alors qu’ils préparent leurs environnements pour tirer parti des avantages de l’IA générative, une enquête révèle des doutes légitimes quant à l’intégration de ces technologies…

Il vous reste 93% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

Plusieurs analystes conseillent aux responsables IT de bien évaluer l’usage des IDE agentiques. En effet, la volatilité des prix, la latence et les problèmes de sécurité doivent inciter à la prudence.

Si l’IA générative a apporté des gains de productivité dans le développement, l’arrivée des environnements de développement intégré (IDE) pilotés par l’intelligence artificielle suscite quelques interrogations parmi les analystes. Ces derniers recommandent aux entreprises de ne pas de se précipiter pour les adopter. Pour justifier cette prudence, ils mettent en avant les changements imprévisibles dans les modèles d’utilisation et de tarification, la fiabilité et la…

Il vous reste 95% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?