Selon Hubert Guillaud, les algorithmes affectent profondément les organismes sociaux en introduisant des logiques de contrôle, de précarisation et de discrimination, tout en se présentant sous le masque de la neutralité et de l’efficacité.

Dans son essai paru en avril dernier, Hubert Guillaud dénonce avec force la mainmise algorithmique sur nos services publics. “Les algorithmes contre la société” dissèque méthodiquement les rouages d’une transformation numérique qui, loin d’améliorer notre quotidien, renforce les injustices systémiques. L’auteur nous plonge dans un monde où le fait social est réduit à des suites de calculs impitoyables : CAF automatisée traquant les plus précaires, France Travail déshumanisé, Parcoursup écrasant les aspirations des jeunes sous le poids des moyennes. Guillaud démontre, preuves à l’appui, que ces systèmes prétendument neutres reproduisent et amplifient les inégalités existantes.La force de l’essai réside dans sa capacité à traduire des mécanismes techniques complexes en enjeux politiques concrets. Selon l’auteur, la traduction du fait social en combinaison de chiffres masque en réalité un projet politique où l’optimisation remplace la délibération démocratique.

Particulièrement éclairante l’analyse des fouets numériques qui, sous prétexte d’efficacité, exercent un contrôle toujours plus étroit sur les travailleurs et les citoyens. Le journaliste y voit même une dérive potentiellement fascisante quand ces outils servent à normaliser des comportements et à punir les écarts. Loin du fatalisme technologique, Hubert Guillaud propose des pistes concrètes pour calculer autrement, en réintroduisant transparence et participation citoyenne. Un essai bienvenu qui nous rappelle que la technique n’est jamais neutre et que nos choix numériques sont d’abord des choix de société.

Les algorithmes contre la société, Hubert Guillaud, Editions La Fabrique, 176 pages, 14 euros

Cherchant à consolider son avance, OpenAI lance un dernier modèle couplé à une stratégie de prix audacieuse. Mais selon les analystes les entreprises doivent relever les défis de l’intégration et de la gouvernance pour en exploiter tout le potentiel.

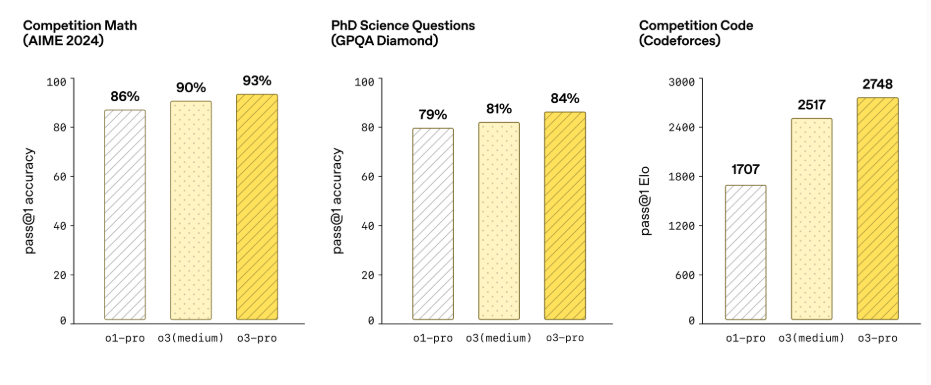

Le modèle d’IA o3-pro dévoilé par OpenAI est à ce jour le plus avancé. Il surpasse ses concurrents sur des critères clés et remplace o1-pro. o3-pro est désormais disponible pour les utilisateurs de ChatGPT Pro et Team, ainsi que par API, et il sera accessible aux entreprises et au secteur de l’éducation à partir de la semaine prochaine. Selon les notes de mise à jour de l’entreprise, son modèle excelle en mathématiques, en sciences et en codage, établissant une nouvelle norme pour les capacités d’IA. Parallèlement à ce lancement, OpenAI a annoncé une baisse de prix de 80 % pour son modèle o3, ramenant les tarifs de 10$ et 40 $ par million de jetons d’entrée/sortie à 2$ et 8 $ respectivement. Le CEO Sam Altman a confirmé la mise à jour sur X. « Les utilisateurs seront satisfaits de la tarification o3-pro pour la performance », a-t-il posté. Cette tarification agressive remet directement en cause la dynamique antérieure du marché, où Gemini 2.5 Pro de Google, qui coûte entre 1,25$ et 2,5$ pour les entrées et entre 10 et 15 dollars pour les sorties, avait une longueur d’avance en termes de coût pour des niveaux de performance comparables.

Les implications stratégiques vont toutefois au-delà de l’aspect économique. « Ce mouvement aura un impact sur le marché », a déclaré Amandeep Singh, directeur associé du QKS Group. « Il ne s’agit pas de pure compétition, mais d’un verrouillage de l’écosystème. OpenAI abaisse les barrières à l’entrée, de sorte que les entreprises se standardisent sur sa pile, un peu comme AWS l’a fait à ses débuts », a-t-il ajouté. Manish Ranjan, directeur de recherche chez IDC, estime que cette évolution change la donne pour les startups et les PME, car elle leur permet d’adapter leurs prototypes de genAI à des déploiements à l’échelle de l’entreprise. « Cela réduit considérablement le coût d’entrée tout en maintenant les performances et l’agilité », a expliqué M. Ranjan, en précisant que de nombreuses entreprises réserveront encore o1-pro aux charges de travail à fort enjeu pour lesquelles la latence et la fiabilité restent essentielles.

Attrait pour les entreprises et frictions de mise en œuvre

Les premiers tests montrent que o3-pro surpasse Gemini 2.5 Pro de Google dans les tests mathématiques AIME 2024 et Claude 4 Opus d’Anthropic dans les tests scientifiques GPQA Diamond. Les évaluateurs l’ont jugé meilleur de sa catégorie pour les sciences, l’éducation, la programmation, les affaires et l’écriture. Ses capacités avancées, notamment la recherche sur le web, l’analyse de fichiers et le raisonnement visuel, permettent d’obtenir des résultats fiables dans des tâches complexes telles que la physique et le codage, selon le billet de blog de l’entreprise. Malgré la tarification agressive d’OpenAI, les entreprises de taille moyenne pourraient avoir du mal à en tirer profit. « La baisse des prix ouvre la porte, mais elle ne construit pas le couloir », a commenté M. Singh. « L’accès à un modèle bon marché ne garantit pas un déploiement évolutif. Les véritables goulets d’étranglement sont l’orchestration, la conformité et la gouvernance. »

Performances comparées des modèles d’OpenAI o3-pro par rapport à o1-pro et o3. (crédit : OpenAI)

M. Singh estime également que sans politiques d’IA centralisées, les CSO risquent des angles morts de gouvernance, notamment en matière d’injection rapide ou d’exposition des données. Il fait remarquer que, comme o3-pro partage le framework de sécurité d’o3, les flux de travail conformes à SOC 2 sont essentiels pour les secteurs réglementés. Il a aussi mis en garde contre la « prolifération des prototypes », une prolifération de projets expérimentaux de genAI qui n’atteignent jamais la production en raison de lacunes dans la préparation des données, dans les compétences en IA ou dans les outils d’évaluation. Sans une couche d’abstraction gérée de type « GenAI-as-a-Platform », de nombreuses entreprises risquent de rester à la traîne, malgré des coûts moins élevés. Selon M. Ranjan, o3-pro offre aux entreprises plus de valeur pour moins, mais seulement si elles s’adaptent à certaines limitations telles que l’absence de chats temporaires, de génération d’images ou de prise en charge de Canvas.

Orchestration, auditabilité et plateformes indépendantes des modèles

Avec trois millions d’utilisateurs professionnels d’o3 et une augmentation de 50 % du nombre d’entreprises depuis février 2025, les prix et les performances d’OpenAI sont indéniablement convaincants. Cependant, les priorités en matière d’approvisionnement évoluent vers l’orchestration, l’auditabilité et les plateformes agnostiques. « Les clients n’achètent pas seulement un modèle, ils investissent dans l’adaptabilité et la conformité », a souligné M. Singh. Le coût total de possession dépend désormais de l’infrastructure qui entoure le modèle, et pas seulement de la tarification des jetons. Si M. Ranjan pense qu’OpenAI va s’emparer d’une plus grande part de marché, il conseille aux DSI de mélanger les modèles, y compris les options open-source pour avoir encore plus de flexibilité. M. Singh est d’accord avec cette recommandation, ajoutant qu’en l’absence d’une gouvernance solide, les entreprises risquent de s’exposer et de se retrouver dans une situation de verrouillage.

Quant à OpenAI, le fournisseur a laissé entrevoir davantage d’innovations, avec un modèle de poids ouvert dont la présentation a été retardée plus tard cet été. « L’attente sera récompensée, car notre équipe de recherche a fait quelque chose d’extraordinaire », a par ailleurs laissé entendre Sam Altman. Pour l’instant, OpenAI mise sur la performance, la tarification et les outils de développement pour maintenir son avance. « o3-pro et la baisse des prix marquent un point d’inflexion », a conclu M. Singh. « L’avantage concurrentiel dépendra de plus en plus de la gouvernance, de l’orchestration et de l’expertise du domaine, et pas seulement de la qualité du modèle ». Alors que les entreprises évaluent les coûts, la vitesse et l’intégration, la dernière initiative d’OpenAI marque une nouvelle phase dans la course qui forgera l’avenir de l’IA.

La 9ème édition du salon Vivatech a ouvert ses portes avec l’IA comme thématique forte. Des annonces du président Macron autour du partenariat entre Mistral et Nvidia pour la création d’un datacenter IA en France aux start-ups oeuvrant dans différents domaines (cybersécurité, industriel, médical,…), l’évènement était dense.

Tout l’écosystème du numérique s’est donné rendez-vous à la Porte de Versailles à Paris pour le salon Vivatech. Une édition regroupant pas moins de 14 000 exposants (start-ups, grandes entreprises, administrations, représentations étrangères,…) et inauguré par Clara Chappaz, ministre déléguée à l’IA et au numérique. Elle a rappelé que « la France est une puissance d’innovation, et nous devons soutenir la création…

Il vous reste 93% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

L’Inria et le club de data scientists Datacraft dévoilent une enquête sur le shadow IA. Une pratique certes courante dans les entreprises mais pour laquelle il existe des solutions. Explications.

En mars 2025, 37% des utilisateurs interrogées qui utilisent des IA génératives dans le cadre professionnel (soit 17% de l’échantillon) n’en ont pas informé leur hiérarchie. C’est ce qui ressort de l’enquête qualitative menée par l’Inria et le club de data scientists Datacraft auprès de 14 grandes entreprises dont Airbus, l’Assurance Maladie, le CHU de Montpellier ou encore le Crédit Agricole.« Les collaborateurs s’emparent de l’IA générative, pour reformuler des mails, structurer des présentations, produire des textes, traduire, faire de la veille, approfondir des idées… Ils le font en dehors de tout cadre officiel, souvent sans en parler à leur hiérarchie, dans une logique de bricolage », déclare à ce titre Yann Ferguson, docteur en sociologie à l’Inria et auteur de l’enquête. Mais, pour lui, l’idée n’est pas de condamner l’IA mais d’en encadrer les usages. Preuve en est, 65% des étudiants interrogés estiment que la présence des IA génératives fait partie des principaux critères de choix de leur future entreprise.Minimiser les risquesCe phénomène du shadow IA est prégnant dans les entreprises et toutes sont concernées à l’image du Crédit Agricole : « Dès 2022, nous nous sommes aperçus de l’engouement autour de l’IA, en revanche le shadow IA n’a eu qu’assez peu d’incidence nous concernant puisque nous avions anticipé en encadrant les usages. Nous avons ainsi mis en place des mesures de protection et des espaces d’expérimentation, par exemple via des bacs à sable autour d’Azure et d’Open AI. Bien sûr, il faut être réaliste, nous minimisons les risques, mais nous ne les annihilons pas », souligne Aldrick Zappellini, chief data & AI officer au sein du Crédit Agricole, lors d’une table ronde organisée lors de la présentation des résultats de l’étude.Un avis que partage aussi Antoine Jacoutot, CTO de Believe, une entreprise de musique numérique française qui possède plusieurs marques de distribution et des labels (TuneCore, Groove Attack, etc.) : « ça va très vite, les usages de l’IA se développent rapidement dans notre métier. Nous nous sommes rendu compte que certains de nos collaborateurs avaient acheté des licences GPT et exploitaient des solutions pour leurs usages professionnels ».Si l’usage de la GenAI fait d’abord gagner à ses utilisateurs de la productivité et de la créativité comme le confirme l’étude, il présente des risques, comme l’a rappelé Yann Ferguson, preuve à l’appui. Un prompt sur 12 contient des données sensibles, des données clients ou encore des données sur les employés.Préconisations pour sortir du shadow IADans ce contexte, il faut trouver les bonnes solutions pour sortir du shadow IA, l’étude de l’Inria préconise donc plusieurs étapes. Déjà, il faut reconnaître l’ampleur du phénomène et à partir de là, une trajectoire en plusieurs temps peut s’initier : le pilotage tout d’abord, en nommant les usages, en formulant un diagnostic partagé, en posant les premiers garde-fous avec les directions métiers ; le partage ensuite, en instaurant par exemple des espaces d’échange entre pairs ; la sécurité, enfin, en mettant à disposition des outils validés ou encore en définissant un cadre légal.Tout cela nécessite de cartographier les usages réels, d’identifier les gestes professionnels émergents et de comprendre les arbitrages opérés entre vitesse, rigueur, autonomie ou conformité. De même, il faut établir un cadre de confiance suffisamment clair pour sécuriser, suffisamment souple pour évoluer. Enfin, la formation se doit d’être holistique en articulant maîtrise technique et lucidité critique. En effet, selon Yann Ferguson, les compétences liées à la GenAI excèdent largement les aspects techniques, il s’agit aussi de comprendre les limites des modèles, de développer une capacité à évaluer la qualité des sorties produites et à exercer un jugement professionnel sur ce qui peut ou non être délégué.D’ailleurs, Nicolas Blanc, secrétaire national à la transition économique au sein de la CFE-CGC qui intervenait lors de la même table ronde, invite les entreprises à mettre en place le plus rapidement une gouvernance autour de l’IA pour encadrer tous ces aspects.

La percée dans la correction d’erreurs annoncée par IBM pourrait déboucher sur un ordinateur quantique à grande échelle et tolérant aux pannes d’ici à 2029.

IBM a annoncé hier une avancée significative dans l’architecture de l’informatique quantique, en résolvant les obstacles scientifiques à la correction d’erreurs. L’entreprise estime qu’elle est désormais sur la bonne voie pour construire le premier ordinateur quantique évolutif à correction d’erreurs au monde d’ici à 2029. « Nous avons déchiffré le code de la correction d’erreur quantique », a expliqué Jay Gambetta, vice-président d’IBM Quantum, ce lundi lors d’une…

Il vous reste 91% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

Des attaques de plus en plus sophistiquées, l’inévitabilité des failles, une charge de travail écrasante et une responsabilité personnelle engagée : travailler dans la cybersécurité exige d’accepter des contraintes parfois difficiles à vivre.

Une carrière dans la cybersécurité est intéressante à plus d’un titre. La pénurie durable de praticiens du domaine signifie qu’il est toujours possible de trouver un emploi, et l’étroitesse du marché des compétences disponibles permet de bénéficier d’un salaire et d’avantages intéressants.Et le domaine conviendra aux personnes qui s’épanouissent dans un environnement mouvant et sous pression, elles ne connaîtront guère de moment d’ennui dans la sécurité. Et elles travailleront sur une mission qui compte : protéger l’organisation des cyberattaques.D’un autre côté, les pros de la sécurité doivent faire face à de nombreuses difficultés. Voici six parmi les plus ardues et comment les atténuer et y faire face.1. Chaque avancée technologique sera utilisée contre vousLes technologies de l’information sont une discipline qui repose largement sur des avancées rapides. Certaines peuvent contribuer à améliorer votre capacité à sécuriser l’entreprise. Mais chacune pose de nouveaux défis du point de vue de la sécurité, notamment en ce qui concerne la manière dont elles seront utilisées pour attaquer vos systèmes, réseaux et données.L’IA générative, par exemple, peut être utilisée pour renforcer les opérations de sécurité, mais elle s’avère également difficile à sécuriser. En outre, elle permet aux pirates de créer des opérations de phishing plus sophistiquées, des usurpations de voix et des vidéos plus convaincantes (Deepfake) et de monter des attaques multicanales couvrant le courrier électronique, les médias sociaux et les plates-formes de collaboration.87% des professionnels de la sécurité déclarent que leur organisation a été confrontée à une cyberattaque aidée par l’IA au cours de l’année écoulée, selon l’étude 2025 Cybercrime Trends de SoSafe, menée auprès de 600 professionnels de la sécurité. Alors que 91 % des experts en sécurité prévoient une augmentation des menaces liées à l’IA au cours des trois prochaines années, seuls 26 % d’entre eux se disent très confiants dans leur capacité à détecter ces attaques.Comme si cela ne suffisait pas, l’informatique quantique arrive à grands pas, posant de nouveaux risques de sécurité. Chris Dimitriadis, directeur de la stratégie de l’Isaca, association professionnelle internationale dont l’objectif est d’améliorer la gouvernance des systèmes d’information, explique : « compte tenu des récentes avancées quantiques, nous pouvons nous attendre à ce que cette technologie soit présente dans nos plates-formes et processus quotidiens au cours des prochaines années. Cette évolution offrira de grandes possibilités d’innovation dans plusieurs secteurs, mais d’importants risques de cybersécurité se profilent à l’horizon. La cryptographie est présente dans toutes les entreprises, toutes les industries et tous les secteurs, et l’informatique quantique a le potentiel de briser les protocoles cryptographiques que nous utilisons, rendant de multiples services inutiles. »Ce que vous pouvez faire : les organisations doivent commencer à se préparer dès maintenant. Les pirates sont déjà engagés dans des attaques dites « harvest now, decrypt later » dans lesquelles ils volent des données chiffrées pour les décrypter ultérieurement avec l’informatique quantique. Les équipes doivent être formées à l’IA et à l’informatique quantique. Les responsables de la sécurité doivent élaborer et mettre en oeuvre des politiques, déployer des garde-fous et des outils appropriés pour s’assurer que l’organisation est prête à faire face à ces nouveaux types de menaces.2. Vos compétences ne suffisent pas à éviter toute cyberattaqueC’est difficile à avaler, mais si l’on adopte l’approche des « cinq étapes du deuil » en matière de cybersécurité, il est préférable d’atteindre le niveau « acceptation » plutôt que de rester dans le déni, car une grande partie des événements est tout simplement hors de votre contrôle.Une étude (Hybrid Security Trends Report de l’éditeur de solutions de cybersécurité Netwrix) menée auprès de 1 309 professionnels de l’informatique et de la sécurité montre que 79 % des organisations ont subi une cyberattaque au cours des 12 derniers mois, contre 68 % il y a tout juste un an.La compromission des informations d’identification (16 %) et le phishing (15 %) sont les deux principales causes de violation de données identifiées dans l’édition 2024 du rapport d’IBM sur le coût décès fuites d’information, réalisé par l’Institut Ponemon. Ainsi, malgré les formations à la sécurité, les utilisateurs continuent de se faire piéger par des attaques de phishing et de se faire dérober leurs informations d’identification.Une fois qu’un pirate s’est introduit dans votre réseau, il peut agir pendant des mois à votre insu. Ponemon indique qu’il faut en moyenne 292 jours pour identifier et réparer les brèches impliquant des identifiants volés, 261 jours pour identifier et résoudre les attaques de phishing et 257 jours pour les attaques par ingénierie sociale.Ce que vous pouvez faire : Gartner recommande aux responsables de la gestion de la sécurité et des risques de passer d’un état d’esprit de prévention à un état d’esprit de cyber-résilience, qui met l’accent sur la minimisation de l’impact et l’adaptabilité de l’organisation. En d’autres termes, il s’agit de passer d’une mentalité du si, à une mentalité du quand, les incidents étant inévitables.3. La responsabilité d’une faille vous incombera, avec des retombées y compris personnellesComme si le fait d’être victime d’une faille de sécurité ne suffisait pas, les nouvelles règles de la Securities and Exchange Commission (SEC), le gendarme des bourses américaines, placent les RSSI dans le collimateur pour d’éventuelles poursuites pénales. Ces nouvelles règles exigent des entreprises cotées en bourse qu’elles signalent tout incident de cybersécurité important dans un délai de quatre jours ouvrables. Les réglementations européennes, comme NIS2, vont dans le même sens.Deux affaires très médiatisées ont déjà été intentées contre des RSSI. Joe Sullivan, RSSI d’Uber, a été accusé d’obstruction à une enquête de la Federal Trade Commission liée à une violation de données au sein de sa société remontant à 2016. Il a été reconnu coupable et condamné à une mise à l’épreuve en 2023.Toujours en 2023, la SEC a accusé Timothy G. Brown, RSSI de SolarWinds, de fraude et de manquements au contrôle interne liés à la fameuse violation de données de SolarWinds en 2019. Plus récemment, une cour d’appel a rejeté presque tous les chefs d’accusation contre SolarWinds et son RSSI.Mais l’inquiétude demeure chez les RSSI, qui craignent de faire les frais des violations de données dont sont victimes leur organisation. Dans l’enquête Voice of the CISO 2024 de Proofpoint, 66 % des RSSI mondiaux ont déclaré être préoccupés par l’engagement de leur responsabilité personnelle, financière et juridique, contre 62 % en 2023.Ce que vous pouvez faire : Il n’est pas toujours possible de prévenir les violations, mais il est possible de mettre en place un solide plan de détection et de réponse aux incidents. Il existe également des moyens pour les RSSI de se protéger contre la responsabilité personnelle, notamment en faisant appel à leur propre avocat et en faisant pression pour qu’ils soient inclus dans la police d’assurance D&O de leur entreprise. Il est essentiel d’établir des lignes de communication ouvertes avec le conseil d’administration et la direction de l’entreprise, ainsi que de disposer d’un cahier des charges précisant les types d’informations et de documents à fournir pour se conformer à la nouvelle réglementation. Il est également essentiel de réfléchir à la manière dont vous communiquez afin de vous prémunir contre toute responsabilité.4. La pénurie de compétences n’est pas près de disparaîtreLes chiffres bruts issus de l’étude annuelle d’ISC2, une association de professionnels de la cybersécurité, pointent invariablement le déficit de compétences dans le domaine. Cette année, la pénurie de travailleurs a augmenté de 19% pour atteindre 4,8 millions de postes, alors que la taille globale de la main-d’oeuvre spécialisée est restée stable, à 5,8 millions.Plus inquiétant encore que ces chiffres, 90 % des personnes interrogées expliquent rencontrer des déficits de compétences dans leur organisation, et deux tiers d’entre elles (64 %) considèrent que ces manques sont plus graves que les seules pénuries de personnel auxquelles elles sont confrontées. « Il ne s’agit pas seulement des personnes disponibles sur le marché. C’est une question de compétences, et je pense que c’est sur ce sujet qu’il faut se concentrer – mettre les bons ensembles de compétences dans les bonnes fonctions », souligne Jon France, RSSI de l’ISC2.Le déficit de compétences en cyber a augmenté de 8 %, deux organisations sur trois faisant état de lacunes en la matière jugées modérées à critiques, selon le Global Cybersecurity Outlook 2025 du Forum économique mondial. Ce double problème rend les organisations plus vulnérables aux attaques et moins aptes à réagir en cas d’incident.Ce que vous pouvez faire : Cette fois, l’IA peut vous aider. Les organisations peuvent tirer parti de l’IA pour automatiser et optimiser les processus manuels. Il est aussi essentiel de perfectionner le personnel en place. Le recrutement au sein de l’organisation est une autre tactique qui peut s’avérer payante.5. L’assaillant est peut être assis juste à côté de vousC’est une autre pilule difficile à avaler, mais les attaques d’initiés, qu’il s’agisse d’employés qui volent des données pour les revendre ou qui tentent de se venger d’un employeur jugé indélicat, sont en augmentation. Lorsque les professionnels de la sécurité élaborent des stratégies pour garder une longueur d’avance sur les cybercriminels, l’image qui leur vient généralement à l’esprit est celle d’un acteur résidant dans un pays lointain, à la législation peu regardante, et non celle d’une personne se trouvant dans le bureau d’à côté.Or, selon une étude de l’éditeur de solutions de cybersécurité Gurucul, 60 % des organisations ont signalé des attaques d’initiés en 2023, un chiffre qui est monté à 83 % en 2024. Le rapport Ponemon 2025 Cost of Insider Risks Report montre que le coût d’une attaque d’initié s’élève désormais à 17,4 millions de dollars en moyenne, contre 16,2 millions de dollars en 2023.Ce que vous pouvez faire : Voici un autre domaine où l’IA peut être utilisée à bon escient. L’IA et les systèmes de Machine Learning peuvent mener des activités de chasse aux menaces et analyser le comportement humain pour tenter de repérer les activités suspectes afin de prévenir les attaques d’initiés.6. Le burnout continue à vous guetterGartner résume la situation de la manière suivante : « l’évolution constante des menaces et du paysage technologique, la demande croissante des entreprises et les exigences réglementaires, associées à la pénurie endémique de compétences, sont en train de provoquer une ‘tempête parfaite’. En conséquence, le secteur connaît une crise de santé mentale, les responsables de la sécurité et de la gestion des risques et leurs équipes étant de plus en plus souvent victimes d’épuisement professionnel. »Deepti Gopal, analyste au Gartner, ajoute : « les professionnels de la cybersécurité sont confrontés à des niveaux de stress insoutenables. Les RSSI sont sur la défensive, confrontés à une unique alternative : être piratés ou l’éviter. L’impact psychologique de cette situation affecte directement la qualité des décisions et les performances des responsables de la cybersécurité et de leurs équipes. »Le cercle vicieux commence avec un service de cybersécurité en sous-effectif au sein duquel les praticiens doivent travailler de longues heures de manière insoutenable. La fatigue exacerbe le stress préexistant associé au travail, conduisant à l’épuisement professionnel.Les conséquences peuvent être désastreuses : les travailleurs épuisés peuvent omettre des tâches de routine telles que l’installation de correctifs ou ignorer des alertes, entraînant une augmentation du nombre d’attaques. En fait, 39 % des responsables informatiques craignent un incident majeur en raison de la surcharge de travail de leur personnel, selon une enquête récente d’Adaptivist.Ce que vous pouvez faire : Les experts recommandent une approche sur plusieurs fronts consistant à tenter de réduire la surcharge cognitive en simplifiant et en rationalisant les processus, en automatisant autant que possible le travail et en veillant à fournir une formation adéquate et fréquente ainsi qu’une mise à niveau des compétences.En outre, les RH devraient s’impliquer dans la formation à la gestion du stress, les programmes de renforcement de la résilience, les modalités de travail flexible, les programmes de désintoxication numérique et d’autres tactiques conçues pour lutter contre le burnout.Gartner prévoit que d’ici 2027, les RSSI qui investissent dans des programmes de résilience personnelle spécifiques à leur métier verront leur taux d’attrition lié à l’épuisement professionnel diminuer de 50 % par rapport à leurs homologues qui s’en abstiennent.

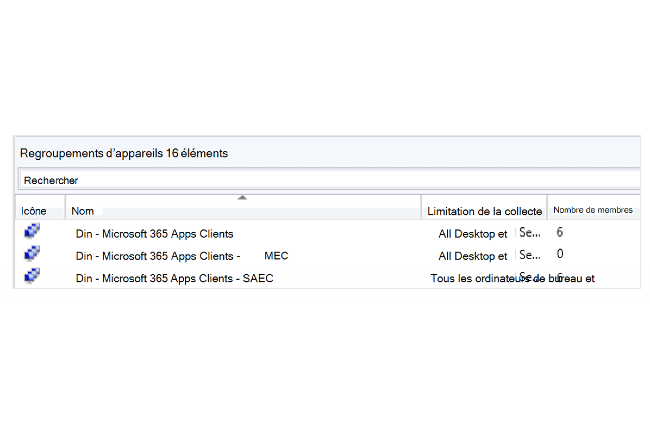

Dans un contexte d’accélération des ajouts liés à l’IA dans sa suite bureautique M365, Microsoft incite les entreprises à adopter des déploiements mensuels et supprime la version preview du canal de mise à jour semestrielle.

Avec l’intégration rapide d’outils d’IA dans Microsoft 365, la société restructure son calendrier de support et de mises à jour. L’éditeur américain incite désormais les entreprises à adopter un rythme de déploiement mensuel afin de mieux suivre les récentes innovations. Jusqu’ici, les administrateurs pouvaient choisir entre plusieurs options : le current channel pour les nouveautés en continu, le monthly enterprise pour des déploiements mensuels, et le semi-annual enterprise pour des mises à jour semestrielles. A ces différents itérations, la firme proposait des versions preview pour tester les mises à jour.

Mais à compter de juillet 2025, Microsoft supprimera le semi-annual enterprise channel en mode preview. Cette préversion donnait aux administrateurs la possibilité d’évaluer en amont les fonctionnalités à venir, plusieurs mois avant leur déploiement officiel. Elle était particulièrement utilisée dans les environnements critiques, comme les banques, les hôpitaux ou les grandes enseignes de distribution, où les interruptions de service sont proscrites. Sur sa page d’assistance, l’éditeur recommande désormais de migrer vers le current channel ou le monthly enterprise channel, qui continuent à offrir un accès anticipé aux nouveautés.

Plus de souplesse pour les mises à jour mensuelles

Autre évolution, les entreprises utilisant le canal mensuel bénéficieront d’une période de restauration étendue. Elles disposeront désormais de deux mois pour revenir en arrière sur une mise à jour, contre un mois auparavant. Cette flexibilité accrue vise à rassurer les DSI, tout en les incitant à adopter un rythme d’actualisation plus soutenu, cohérent avec les cycles rapides d’innovation imposés par l’IA.

Le current channel, qui livre les mises à jour dès qu’elles sont disponibles, reste quant à lui inchangé. Il en va de même pour sa version preview, qui permet aux entreprises les plus réactives de tester les nouveautés en avant-première.

Le canal semestriel recentré sur les usages automatisés

Microsoft réduit par ailleurs la période de support du canal semestriel classique pour les correctifs de sécurité. Celle-ci passe de 14 à 6 mois. Ce coup de rabot confirme le repositionnement de ce canal sur des postes non supervisés, utilisés dans des contextes automatisés (calcul intensif, affichage de contenus, traitement de données), où l’intervention humaine est minimale, voire absente.

Le semi-annual enterprise channel initialement conçu pour offrir un environnement stable avec des mises à jour regroupées en janvier et en juillet, perd ainsi son rôle de canal principal pour les entreprises. L’éditeur entend désormais mettre l’accent sur les canaux les plus agiles, plus à même d’accompagner l’évolution rapide de sa suite bureautique dopée à l’IA.

Une procédure simplifiée pour migrer vers le canal mensuel

Pour accompagner les entreprises dans cette transition, Microsoft propose une procédure claire via un gestionnaire de configuration. Les administrateurs peuvent regrouper dynamiquement les postes selon leur canal actuel ou se servir de l’Office deployment tool pour la migration vers le type de canal choisi. Ce mécanisme n’interrompt pas la productivité, car la bascule ne nécessite pas de redémarrage immédiat ni la fermeture des applications Office.

L’IA, la cybersécurité, la modernisation de l’informatique, les lacunes en matière de compétences et les préoccupations budgétaires restent au coeur des préoccupations des responsables IT. Mais la façon dont ils abordent chacun de ces sujets évolue à mesure que le paysage informatique se transforme.

Ce sont des questions récurrentes qui dominent l’agenda des DSI aujourd’hui : comment stimuler l’innovation tout en assurant des opérations IT sécurisées et modernes ? ; comment réunir les compétences préparant l’avenir ? ; ou encore, comment contenir les coûts malgré leurs fluctuations et le besoin de dégager des moyens pour l’innovation ?Mais alors que la dernière enquête de CIO sur l’état de la DSI identifie les initiatives en matière d’IA, la cybersécurité, les efforts de modernisation et les besoins en compétences comme les principaux sujets à l’agenda des DSI cette année encore, des changements subtils dans la meilleure façon d’aborder ces tâches peuvent être décelés par les questions clés auxquelles les DSI sont confrontés dans chacun de ces domaines. Voici comment ces subtiles inflexions se traduisent sur les priorités des dirigeants IT.1. Comment s’assurer de la valeur de l’IA, sans compromettre la sécurité ?L’époque où l’on se concentrait principalement sur les expérimentations de l’IA et la validation de concepts est révolue. Aujourd’hui, les dirigeants veulent que leurs DSI identifient comment l’IA peut apporter une valeur mesurable à l’organisation, souligne Mark Taylor, PDG de la Society for Information Management (SIM), une association professionnelle à but non lucratif. Selon lui, cela oblige les DSI à se demander « où sont les mises en oeuvre de l’IA à forte valeur ajoutée ».Pour Saby Waraich, DSI du Clackamas Community College, un établissement d’études supérieures situé dans l’Oregon (Etats-Unis), il s’agit de définir ce qui constitue un bon cas d’usage de l’IA et de déterminer la meilleure façon de tirer le maximum de valeur de ces mises en oeuvre. Le DSI, qui est également président de la section SIM de Portland (Oregon), explique que cet objectif l’aide, lui et son équipe, à hiérarchiser les projets d’IA en fonction des retours sur investissement attendus, plutôt que de se fier à l’enthousiasme suscité au sein des équipes.Par exemple, Saby Waraich a récemment intégré des outils d’IA générative dans les processus de cybersécurité du Clackamas Community College. L’IA analyse si les courriels signalés comme suspects sont bien des tentatives d’hameçonnage, alerte le personnel de sécurité sur les résultats et rédige des réponses aux utilisateurs qui ont signalé les messages suspects. Ce n’est peut-être pas un projet tape-à-l’oeil, mais il a donné d’excellents résultats, selon le DSI. Les outils d’IA peuvent réaliser en une dizaine de minutes le travail qui prenait habituellement quelques heures aux employés, ce qui représente un gain de productivité considérable.Selon Tejas Patel, responsable de la stratégie technologique et du conseil pour la zone Asie-Pacifique chez Accenture, les DSI doivent cibler des gains significatifs de ce type-là. Et également réfléchir à la manière dont ils peuvent tirer parti de ces gains. Ainsi, Tejas Patel conseille aux DSI de se poser la question suivante : « Comment faire évoluer l’IA de manière sûre et rapide sans contracter une dette technologique trop importante ? »Les DSI, explique-t-il, doivent rapidement mettre à l’échelle les déploiements d’IA pour s’assurer que leurs organisations restent compétitives, car la technologie évolue si rapidement qu’ils risquent d’être rapidement distancés s’ils ne le font pas. Ils doivent également être attentifs aux outils d’IA qu’ils adoptent pour s’assurer qu’ils sont à même de suivre le rythme de cette évolution. Enfin, ils doivent constamment veiller à la sécurité afin de ne pas introduire des niveaux de risque inacceptables liés à l’exposition des données, que ce soit via des cyberattaques ou par des fuites d’informations violant des réglementations et détruisant la confiance des clients ou employés.Tejas Patel reconnaît que la recherche d’un équilibre entre tous ces éléments constitue un réel défi. « Compte tenu des pressions et des coûts qui s’accumulent, les DSI savent qu’ils doivent être intelligents et plus réfléchis dans leur stratégie d’IA », ajoute-t-il.2. Comment aligner cybersécurité et appétence au risque de l’organisation ?Les DSI, ainsi que les directions générales et membres du conseil d’administration, « réalisent que les piratages et les perturbations causés par des acteurs malveillants sont inévitables », estime Mark Taylor de la SIM. Cette prise de conscience a fait évoluer les programmes de sécurité, qui sont passés de mesures essentiellement défensives à des initiatives qui font évoluer en permanence la capacité de l’organisation à identifier rapidement les brèches, à y réagir et à reprendre ses activités aussi vite que possible après une attaque, ajoute Mark Taylor.L’objectif aujourd’hui est d’assurer la résilience – même si les acteurs malveillants et leurs stratégies d’attaque évoluent. Pour ce faire, les opérations de sécurité doivent être suffisamment souples pour s’adapter à un paysage de la menace en constante évolution et s’aligner sur la tolérance au risque de l’organisation, qui est elle aussi susceptible d’évoluer dans le temps.« Nous nous demandons : “Comment pouvons-nous évoluer en permanence ? Comment nous améliorer ? Comment devenir une organisation plus mature ?” », résume Joshua Bellendir, vice-président senior de l’informatique et DSI de WHSmith North America, la branche nord-américaine de la chaîne de librairies britannique.3. Quelle infrastructure déployer pour s’adapter au rythme de l’entreprise ?Pour Thomas Phelps IV, DSI de Laserfiche (un spécialiste de la gestion de documents, originaire de Californie) et membre du conseil consultatif de l’Institut de recherche SIM, s’assurer que les opérations informatiques répondent au climat métier en évolution rapide est le facteur clé pour déterminer les technologies à remplacer et les nouveaux investissements à réaliser.Le DSI et d’autres responsables informatiques admettent volontiers qu’il n’est pas facile de mettre en place une stack technologique capable de se croître ou se rétracter en fonction des besoins de l’entreprise, et d’évoluer rapidement pour tirer parti d’un paysage technologique en constante évolution.« La modernisation est une cible mouvante, car une fois votre initiative en la matière menée à bien, quelque chose de nouveau peut apparaître, qui sera meilleur et plus automatisé. L’ensemble de l’infrastructure évolue très rapidement », souligne Diane Gutiw, vice-présidente et responsable de la recherche sur l’IA chez CGI, une société de services et de conseil.Il existe des stratégies pour relever ce défi, explique Mark Taylor, de SIM, qui conseille aux DSI de se concentrer sur l’accès aux données lors de l’ajustement de leur stack technologique, car le succès à l’ère de l’IA et de l’automatisation dépend fortement de l’acheminement des données vers l’endroit où elles sont nécessaires. Brian Jackson, directeur de recherche chez Info-Tech Research Group, est du même avis : « Il s’agit de trouver des solutions qui permettent de sortir les données des anciens systèmes et de les placer dans un nouveau schéma où [les entreprises] peuvent les évaluer et les utiliser au sein de systèmes d’IA modernes. »Tejas Patel d’Accenture souligne qu’en agissant ainsi, les DSI seront mieux armés pour « tirer parti de l’automatisation, de l’IA et des agents, avec l’ambition de viser le zéro contact [pour les opérations informatiques] ». La clé d’une infrastructure réactive, explique-t-il, est d’éliminer autant d’efforts manuels que possible. Les opérations automatisées augmentent la réactivité et réduisent les coûts, ce qui permet aux DSI de réorienter les budgets des dépenses opérationnelles vers l’innovation, faisant ainsi de leurs départements une entité moderne. « L’objectif est d’alléger les opérations et de réorienter les ressources vers le développement de nouvelles capacités », insiste Tejas Patel.4. Comment préparer l’équipe aux besoins de demain ?Pour Brian Jackson d’Info-Tech, le succès à long terme des DSI dépend d’abord de l’identification des compétences nécessaires pour devancer la concurrence et de l’élaboration de stratégies de gestion des compétences qui garantissent le recrutement et la formation en préparation des besoins de demain.Thomas Phelps convient qu’une solide stratégie de perfectionnement et de montée en compétences est essentielle pour développer les capacités nécessaires à la croissance de l’entreprise, tandis que Diane Gutiw, de CGI, est un peu plus précise, affirmant qu’il s’agit de s’assurer de disposer des compétences sachant utiliser l’IA pour faire leur travail mieux et plus rapidement.Comme le souligne cette dernière, les recherches montrent que les collaborateurs qui ne savent pas comment utiliser l’IA seront remplacés non pas tant par la technologie elle-même mais par d’autres compétences qui savent comment travailler avec et parallèlement à l’IA. Par conséquent, elle estime que les DSI devraient se demander si eux-mêmes et leurs responsables d’équipe sont prêts à accueillir une main-d’oeuvre hybride, où collaborateurs humains et IA travailleront de façon intégrée.« Les DSI devraient se demander comment modifier ou adapter leurs activités actuelles pour gérer une main-d’oeuvre hybride. À quoi ressemble l’avenir du travail ? Comment gérer cela de manière sûre et responsable tout en tirant parti des gains d’efficacité ? Et comment permettre à mon personnel d’être innovant sans enfreindre la réglementation ? » souligne Diane Gutiw, qui ajoutent que les managers d’aujourd’hui « sont la dernière génération de personnes qui ne gèrent que des humains ».Tejas Patel, d’Accenture, estime, lui aussi, que les DSI devraient chercher à créer « le bon modèle opérationnel au sein de l’organisation afin que les humains et les machines puissent collaborer et générer une valeur croissante ». Et d’ajouter : « Les DSI doivent s’assurer que les gens voient cette évolution comme une opportunité, que l’arrivée de l’IA se traduit par des progressions de carrière et de la croissance. »5. Comment contrôler les coûts pour rediriger les budgets vers l’innovation ?De nombreuses organisations continuent d’investir dans l’informatique, 65 % des personnes interrogées dans le cadre de l’enquête 2025 sur l’état de la DSI déclarant s’attendre à des augmentations de budget IT – avec une augmentation moyenne de 6,9%. Cependant, les DSI déclarent que le coût de gestion et de maintenance de leur stack technologique actuelle a augmenté plus rapidement que les budgets consacrés aux projets et à l’innovation.Brian Jackson, d’Info-Tech, attribue une grande partie de ce choc des prix à la flambée des coûts des services cloud. « Les DSI constatent que les factures sont plus élevées que prévu et envisagent même de rapatrier certaines applications », note-t-il. Selon lui, un pourcentage croissant de DSI adopte une démarche FinOps pour contrôler ces coûts d’exploitation. En outre, les responsables informatiques rationalisent et renégocient les contrats et les services des fournisseurs afin de mieux maîtriser leurs coûts.Il est toutefois important de noter que ce travail ne consiste pas uniquement à réduire les dépenses informatiques, comme cela a pu être le cas par le passé, précise Brian Jackson. Il s’agit plutôt d’aider les DSI à réduire les coûts des tâches à faible valeur ajoutée, telles que la maintenance, afin de redéployer l’argent ainsi économisé pour financer des initiatives de croissance et d’innovation à forte valeur ajoutée.Pour Tejas Patel, les DSI doivent avant tout déterminer l’équilibre optimal entre les dépenses d’exploitation, les dépenses d’investissement, la dette technologique et les dépenses d’innovation. « La question est de savoir où se situe le bon équilibre, quelle est la bonne répartition. C’est ce que les DSI doivent chercher en permanence à déterminer », dit-il.Thomas Phelps se concentre sur cette dynamique et déclare examiner les contrats et les services de ses fournisseurs pour s’assurer « qu’ils contribuent réellement à la croissance de l’entreprise et qu’ils le font d’une manière qui permet de gérer les coûts et d’assurer l’adoption d’outils novateurs par les utilisateurs ». Et se dit attentif à l’affectation des fonds entre gestion/maintenance, projets du quotidien et innovation. Il s’agit de s’assurer que « nous affectons ces dépenses de manière appropriée », indique le DSI.

En levant 200 millions de dollars, la start-up Persona espère s’imposer comme un acteur clé de la vérification d’identité numérique en misant sur ses technologies IA et d’analyse de fraude. La société est désormais valorisée deux milliards de dollars.

A mesure que se multiplient les usages du cloud, portés notamment par l’essor du travail à distance et de l’IA en ligne, le besoin en dispositifs d’authentification fiables s’impose comme un impératif. Un créneau sur lequel se positionne Persona, une start-up spécialisée dans la vérification de l’identité numérique qui a finalisé fin avril une levée de fonds de 200 M$ (série D), à laquelle ont participé BOND, Coatue, Index Ventures ou First Round Capital. Suite à cet apport – dont le fléchage des fonds n’a pas été précisé – l’entreprise est désormais valorisée 2 Md$. Fondée en 2018 à San Francisco, la société compte plus de 3 000 clients, parmi lesquels Instacart, Reddit, Lime, Linkedin, ou encore OpenAI. Ce dernier utilise Persona pour valider 99 % des inscriptions à ses API, en moins de 20 millisecondes, évitant ainsi les détournements malveillants et les abus, tout en assurant une fluidité de son interface et une rapidité d’exécution.

De l’IA pour identifier des documents non conformes

La firme indique se distinguer d’autres solutions de vérification d’identité par une approche modulaire et comportementale et une plateforme cloud capable d’ajuster automatiquement le nombre et le type de vérifications en fonction du niveau de risque détecté. Ainsi, un utilisateur dont le comportement ou les données paraissent suspects (par exemple : adresse IP inhabituelle, navigation erratique) devra suivre un parcours de contrôle renforcé. À cela s’ajoute une intelligence artificielle spécialisée dans l’analyse documentaire, capable d’identifier les documents non conformes, ainsi qu’un système de détection des signaux comportementaux et contextuels.

Par ailleurs le fournisseur utilise un module d’analyse des fraudes permet pour identifier des réseaux de comptes malveillants opérant de manière coordonnée. L’ensemble repose sur une logique de cartographie dynamique des profils utilisateurs, fondée sur le croisement de données internes, d’historiques d’activité, et de signaux externes. « Le véritable obstacle n’est plus de repérer les robots, mais de vérifier qui se cache derrière chaque action et si l’on peut leur faire confiance », assure Rick Song, le CEO de Persona.

Des accusations de collecte de données biométriques sans consentement

A l’heure où l’IA générative est en mesure de fabriquer des identités fictives en un temps record, Persona espère devenir « l’interface de confiance entre le monde virtuel et le monde réel », en garantissant que chaque action numérique émane d’un utilisateur légitime. D’ici 2026–2027, l’entreprise prévoit ainsi de renforcer l’intégration de ses outils auprès des services d’IA (agents autonomes, API, assistants), afin de permettre une validation d’identité en temps réel. Elle entend également nouer d’autres partenariats stratégiques, notamment dans les domaines du cloud et du paiement, afin d’élargir la portée de ses dispositifs de sécurité.

Mais cette dynamique devra aussi composer avec l’évolution attendue de la réglementation sur les données biométriques, susceptible de ralentir ou de redéfinir certaines pratiques du secteur. Et ce d’autant que Persona est confronté à quelques soucis : l’entreprise fait actuellement l’objet de procédures judiciaires aux États-Unis où elle est accusée d’avoir collecté des données biométriques sans le consentement éclairé des personnes concernées. Plusieurs chercheurs et organisations non gouvernementales ont par ailleurs mis en garde contre les risques de biais discriminatoires inhérents aux systèmes de scoring identitaire, particulièrement à l’encontre des « minorités numériques » incluant les personnes sans papiers, les jeunes, et les individus aux profils atypiques.

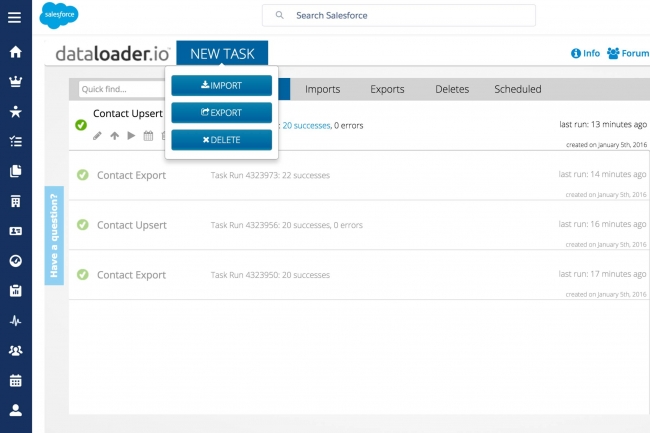

Des pirates sont parvenus à tromper des employés en simulant de faux appels émanant du support informatique et à les convaincre de se connecter sur une version usurpée de la solution Data Loader de Salesforce à des fins d’exfiltration de données.

Dans une campagne active à visée financière, un acteur malveillant a utilisé l’hameçonnage vocal ou vishing, pour compromettre les données organisationnelles des clients de Salesforce et procéder à une extorsion ultérieure. Repéré sous le nom de UNC6040 par Google Threat Intelligence Group (GTIG), ce groupe d’acteurs malveillants cible les employés des filiales anglophones de sociétés multinationales pour les inciter à accorder des accès sensibles ou à partager des…

Il vous reste 91% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?