Fortinet a renforcé sa plateforme d’analyse de sécurité et de gestion des logs FortiAnalyzer en mettant l’accent sur les fonctionnalités de détection des menaces et d’automatisation de la réponse aux incidents. Elle intègre aussi un peu plus l’assistant FortAI.

L’analyseur de logs de sécurité de Fortinet s’étoffe progressivement. En effet, la plateforme s’enrichit de fonctionnalités IA pour rechercher les tendances, les anomalies et les menaces de sécurité potentielles afin d’élaborer des analyses de sécurité, des rapports sur le trafic réseau et des playbooks de réponse aux incidents. Pour mémoire, FortiAnalyzer collecte en toute sécurité les logs des équipements du fournisseur, en particulier ceux des pare-feux FortiGate et des agents de sécurité des points d’extrémité (serveurs, PC,…). Selon Nirav Shah, vice-président senior, produits et solutions, chez Fortinet, la plateforme s’adresse aux entreprises de taille moyenne et aux équipes touchées par la pénurie de compétences en sécurité. « Avec les dernières évolutions de FortiAnalyzer, on n’a plus besoin d’outils SecOps supplémentaires si bien que la plateforme clé en main est idéale pour les opérations de sécurité pilotées par l’IA, aussi bien pour les environnements sur site que dans le cloud », a-t-il encore déclaré dans un communiqué.

Les améliorations apportées à l’outil de surveillance comprennent une intégration plus étroite avec la base de données unifiée du fournisseur pour aider les clients à rassembler les logs de réseau et de sécurité. Elles intègrent par ailleurs des analyses de sécurité et des rapports de conformité de l’ensemble de la Security Fabric de Fortinet au sein d’une vue unique. « Le package comprend des tableaux de bord améliorés pour l’IoT, le centre d’opérations de sécurité (SOC), la sécurité de la messagerie et les points d’extrémité, afin de fournir des informations sur les incidents de haute gravité, les hôtes compromis et les vulnérabilités », a indiqué M. Shah. La prise en charge de FortiGuard Indicator of Compromise (IoC) et d’Outbreak Detection offre aux équipes de sécurité d’identifier et de traiter les vulnérabilités plus rapidement. « Les capacités d’IA intégrées de FortiAnalyzer identifient automatiquement les alertes prioritaires et téléchargent les gestionnaires d’événements, les règles de corrélation et les rapports pertinents pour aider les entreprises à comprendre le contexte d’une attaque, sa chronologie, les technologies affectées et les renseignements sur les menaces connexes », a expliqué M. Shah.

Une intégration plus importante avec FortiAI

Selon Fortinet, le package se combine désormais avec FortiAI, son assistant de genAI, pour mieux prendre en charge l’analyse et la télémétrie afin d’aider les équipes de sécurité à accélérer l’investigation et la réponse aux menaces. « FortiAI identifie les menaces qui nécessitent une analyse à partir des données collectées par FortiAnalyzer, principalement à partir des FortiGates. En automatisant les processus de collecte, d’analyse et de réponse, FortiAI aide les entreprises à détecter les menaces plus rapidement, en minimisant la fatigue des alertes et en réduisant les temps de réponse », a écrit Kimberly Becan, directrice senior des solutions relatives aux opérations de sécurité chez Fortinet, dans un blog sur les capacités de FortiAI et ForitAnalyzer. « L’impact est considérable : Au lieu de passer des heures à filtrer les alertes, les analystes de la sécurité peuvent poser des questions basées sur l’IA du genre « Quelles sont les menaces les plus critiques de ces dernières 24 heures ? » ou encore « Quel malware a contourné les contrôles de sécurité aujourd’hui ? » et recevoir instantanément des informations classées par ordre de priorité », a ajouté la dirigeante. L’assistant IA donne ainsi aux professionnels de la sécurité de mettre en évidence les menaces pertinentes et d’évaluer rapidement leur contexte. « En rationalisant le tri des alertes, les entreprises améliorent leur efficacité, optimisent les ressources IT et minimisent les failles de sécurité », a encore écrit Kimberly Becan.

D’autres fonctionnalités incluent des packs d’automatisation SOC pré-construits pour apporter aux équipes de sécurité les derniers gestionnaires d’événements, des playbooks et des analyseurs de journaux tiers, comme Armis Platform et Microsoft Office 365. « Les équipes de sécurité peuvent ainsi contenir les menaces et y remédier en limitant au minimum l’intervention manuelle », a précisé Nirav Shah. « L’évolution de FortiAnalyzer vers une plateforme SecOps pilotée par l’IA, avec une intégration transparente des dispositifs tiers et des services SOC, ainsi que des intégrations profondes avec la Security Fabric de Fortinet, propose une visibilité unifiée sur leur infrastructure, d’une intelligence des menaces améliorée et d’une réponse aux incidents rationalisée à partir d’une seule et même solution », a ajouté le responsable. Les clients actuels de FortiAnalyzer qui bénéficient des services d’abonnement FortiGuard ont dès à présent accès à ces dernières fonctionnalités et capacités. « Les packs de contenu sont mis à jour régulièrement afin que les entreprises puissent suivre l’évolution des menaces émergentes et étendre la couverture du SOC à mesure de l’évolution des besoins », a aussi indiqué Fortinet.

Malgré ses promesses, l’IA générative se heurte à des difficultés en matière d’adoption. Sa déclinaison sous forme d’agents peut toutefois s’inspirer de la démarche qui a permis le succès du low-code dans certaines entreprises.

L’IA générative ne se résume plus à des chatbots à qui l’on pose des questions. Elle est en passe de devenir un outil à même de réaliser des opérations – l’IA agentique étant l’expression un peu maladroite pour désigner cette approche. Et il devient de plus en plus évident que la GenAI est la plus utile et la plus appréciée des employés lorsqu’elle est personnalisée. De quoi enclencher un cercle vertueux bien connu : les employés qui utilisent le plus fréquemment l’IA générative et qui prennent le temps d’expérimenter ses nouvelles fonctionnalités sont aussi ceux qui en tirent le meilleur parti.Il existe une forte corrélation entre cette évolution et l’obtention d’une formation adéquate, notamment en ce qui concerne l’utilisation de l’IA générative dans le cadre des processus habituels de travail. Selon une étude menée par Microsoft et LinkedIn, les utilisateurs qui affirment que la technologie leur fait gagner 30 minutes par jour sont 37 % plus nombreux parmi la population ayant reçu une formation à l’IA générative.Les utilisateurs de l’IA partagent aussi régulièrement les prompts qu’ils utilisent et d’autres conseils avec leurs collègues. Par exemple, le déploiement réussi de Copilot par Virgin Atlantic a impliqué non seulement la formation, mais aussi la recherche de « champions dans les différents départements pour tirer les principaux enseignements des sessions de formation ciblées et essayer de les diffuser au sein des groupes d’utilisateurs », explique Gary Walker, vice-président de la technologie et de la transformation pour la compagnie aérienne.« Quand quelque chose fonctionne, faites-en un objet social »Ce dernier estime qu’il est important, pour tout déploiement technologique, de créer un climat de sécurité psychologique permettant au personnel d’expérimenter, tout en le récompensant de partager ce qui fonctionne entre collègues. Plutôt que pousser chacun à conserver son expertise. Et de souligne les parallèles avec le low-code. « Lorsque vous trouvez quelque chose qui fonctionne, faites-en un objet social, dit Gary Walker. Partagez-le sur les médias sociaux internes et avec vos pairs, et cela contribuera à amplifier le gain d’efficacité que vous venez de découvrir. »Selon Kjell Carlsson, responsable de la stratégie IA chez Domino Data Lab, éditeur d’une plateforme de MLOps, cette méthode est efficace car nous avons tous tendance à apprendre beaucoup plus rapidement de nos pairs que de la plupart des autres sources d’information.Si cela vous semble familier, c’est parce qu’il s’agit du type d’adoption virale ascendante et communautaire qu’ont connu de nombreuses organisations avec le low-code et de l’automatisation des workflows, où la résolution de leurs problèmes quotidiens a rendu les employés moteurs du partage d’astuces et de techniques avec leurs collègues. Les DSI peuvent s’inspirer des leçons tirées de cette adoption réussie pour tirer le meilleur parti des agents. « Il existe en fait une corrélation entre la préparation à l’adoption du low-code et l’adoption, la préparation et la réussite de l’IA », veut croire John Bratincevic, analyste principal chez Forrester. « Si vous voulez vraiment tirer parti de l’IA et des expérimentations à grande échelle de cette technologie, vous devez l’associer à votre stratégie de développement citizen développeurs. »Gérer les agents façon low-codeL’IA agentique va des simples automatisations de tâches quotidiennes basées sur des prompts de type ‘compléter les blancs’ à des workflows plus autonomes qui détectent des entrées telles que des courriels et déclenchent des processus pour rechercher des informations et rédiger des réponses, voire passent une commande ou réservent une réunion. L’IA générative rend ces automatisations à la fois moins fragiles et plus faciles à créer.À bien des égards, il s’agit d’une progression naturelle, et les plateformes low-code, comme Power Platform de Microsoft, Mendix, Salesforce et Zoho, qui offrent des fonctions d’IA pour simplifier le développement depuis longtemps déjà, ajoutent maintenant des outils de GenAI pour aider les utilisateurs à créer applications et workflows.L’analogie entre les deux domaines concerne aussi la conformité, la gouvernance, la sécurité de des données et les capacités d’audit. Tout comme les applications low-code, les agents d’IA générative ont besoin d’accéder à des sources de données et de se connecter à des applications métier. Les organisations voudront donc y appliquer des politiques de contrôle d’accès et encadrer les actions qui peuvent être entreprises, ainsi que la manière dont les utilisateurs partagent applications et workflows. Comme pour tout autre outil dont la tarification est basée sur la consommation, les équipes IT seront également attentives à monitorer l’utilisation et l’adoption, et les responsables voudront examiner ce que cela apporte à l’entreprise pour évaluer le retour sur investissement.Le low-code a aujourd’hui fait ses preuves. La majorité des entreprises ont des stratégies de citizen développement. John Bratincevic affirme qu’il existe des exemples documentés d’organisations ayant tiré des centaines de millions d’euros de bénéfices de ce type de démarche. « Au cours des cinq ou six dernières années, les services informatiques ont réalisé que, s’ils s’y prenaient bien, le low-code pouvait être un important moteur de changement, ajoute Richard Riley, directeur général du marketing de la plate-forme Power chez Microsoft. Mais une grande puissance nécessite un grand contrôle. » Ce qui passe par des garde-fous pour l’informatique sans sacrifier la flexibilité des utilisateurs métiers.Plus complexe sur l’aspect coûtsRichard Riley admet que les questions de coût peuvent être plus compliquées avec l’IA agentique qu’avec les applications traditionnelles low-code. « Vous pouvez faire tourner l’agent une première fois et il aura besoin de 10 lignes d’une base de données quelque part et utiliser 10 000 jetons. Vous le sollicitez à nouveau et il pourrait utiliser un million de jetons en raison des données qu’il reçoit et des actions qu’il entreprend. Nous devons nous assurer que nous avons des mesures de protection contre ce phénomène, et nous sommes en train de les mettre en place ».Les organisations veulent avoir une visibilité sur ce qui s’est passé afin de pouvoir suivre ce que font les agents, récupérer des données télémétriques afin de pouvoir perfectionner les agents pour qu’ils travaillent d’une manière spécifique, et bénéficier d’une clarté sur les coûts afin de pouvoir appliquer des plafonds. Et si l’IA agentique prend son essor, la DSI souhaitera disposer de processus pour sélectionner les agents les plus utiles ou pour leur ajouter de nouvelles fonctionnalités. « Vous pourrez voir qui a créé des agents, ce qu’ils ont créé, quelle est l’utilisation, qui l’utilise, quelles sont les données qui circulent, explique Richard Riley. Si vous le souhaitez, vous pourrez reprendre l’ensemble, le transformer en une solution managée et contrôlée par le service informatique. Vous devriez aussi pouvoir créer très facilement un agent qui vérifie les autres agents pour s’assurer qu’ils ne font pas la même chose : utiliser l’outil pour contrôler l’outil. »Lancer l’IA agentiquePour tirer parti de l’IA agentique, il faut d’abord que les dirigeants et utilisateurs déterminent où ils peuvent appliquer la technologie et à quelles fins. Ce qui signifie qu’il faut commencer par l’analyse de rentabilité plutôt que par la technologie, note Richard Riley. Là encore, une démarche similaire à celle du low-code.« Cela suit le même schéma que celui des Power Apps. En particulier, dans le domaine des agents, il est facile de prendre toute cette nouvelle technologie et de l’appliquer aux processus et aux problèmes métiers existants. Ce qui certes les améliorer, mais ce ne sera pas le changement radical que les gens attendent de l’IA », dit le responsable de Microsoft. Pour lui, il faudra sortir du cadre existant pour que cette dynamique s’enclenche, en descendant « beaucoup plus près de l’utilisateur final ».Les organisations commenceront probablement par remplacer un processus réalisé par un utilisateur par un processus exécuté par un agent et, au moins dans un premier temps, y adjoindront une vérification par un humain, suggère John Bratincevic. Les vérifications peuvent devenir moins courantes, mais la prochaine étape logique consistera à réorganiser les processus en fonction de ce que font les modèles et les agents. « Pourquoi faut-il trois étapes avec trois personnes dans un workflow humain alors qu’il pourrait n’y avoir qu’une seule étape ? », souligne l’analysteLa connaissance métier fait la différencePour obtenir à la fois ces petites améliorations et les changements plus importants, John Bratincevic affirme que les organisations ont besoin d’expérimentations à grande échelle – et que le low-code est le meilleur moyen d’y parvenir. « La véritable valeur réside dans la création de nouveaux logiciels, même simples, avec l’IA au coeur de ceux-ci, poursuit-il. Et le seul moyen d’y parvenir concrètement passe par le citizen développement sur une approche low-code. Il y a des années de valeur encapsulée dans les LLM et nous devons trouver comment l’exploiter, et la seule façon d’y parvenir est l’expérimentation à grande échelle ».Comme pour le low-code, les utilisateurs métiers sont les experts du domaine qui savent le mieux ce qu’il faut changer. « Ils sont les plus proches des données et des processus opérationnels, souligne Richard Riley. Et dans le monde du low-code, ce sont eux qui ont construit des choses qui ont eu un impact massif sur l’entreprise que les services informatiques n’auraient jamais pu atteindre, parce qu’ils les auraient étudiées et placées à la fin de leur longue liste de choses à faire. »Pour tirer le meilleur parti de l’IA générative avec des techniques plus avancées telles que la création d’agents, il faut une connaissance approfondie du domaine métier, explique John Bratincevic. « C’est le comptable ou la responsable des ressources humaines qui peuvent imaginer ce que l’IA peut faire, et qui peuvent faire de l’ingénierie de prompt et d’autres types de RAG légers pour la faire fonctionner et l’encapsuler dans quelque chose – un processus ou une expérience – qui crée réellement de la valeur », ajoute-t-il. L’analyste dit disposer déjà de nombreux exemples d’applications ‘infusées par l’IA’ construites par des utilisateurs métiers dans une approche low-code, dont beaucoup adoptent une architecture agentique.Préparer les gens à créer des agentsIl y a cette grande entreprise de construction qui utilise une application construite par ses employés pour obtenir davantage de contrats en répondant plus rapidement à des appels d’offres détaillés et techniquement complexes, l’IA générative étant chargée d’ingérer le contenu et de générer la première réponse. Il y a aussi cette grande compagnie d’assurance qui trie les réclamations entrantes avec l’IA générative et les achemine en interne vers l’équipe appropriée bien plus rapidement que les deux heures qu’il fallait pour le faire manuellement. Et il y a ce cabinet juridique qui vend à d’autres cabinets une application SaaS construite avec l’IA générative couvrant le droit dans une catégorie particulièrement obscure. Ou il y a encore cette autre grande compagnie d’assurance qui compte désormais un tiers de toutes ses applications écrites en low-code. « On parle bien d’un tiers de l’ensemble de leur portefeuille d’applications écrit sur mesure sur une plateforme avec des outils low-code par des personnes des domaines métiers en dehors de l’informatique, et beaucoup d’entre elles sont des solutions d’IA », explique John Bratincevic.Il est important de considérer l’IA agentique comme un changement technologique auquel les organisations doivent former leurs salariés, et non comme une mise à jour d’un logiciel existant qu’ils sont censés assimiler par eux-mêmes. Comme l’IA générative en général, « c’est une technologie qui est très intuitive à utiliser pour jouer quelques minutes. Elle l’est beaucoup quand il s’agit de l’intégrer dans votre workflow », souligne Kjell Carlsson de Domino Data Lab.Les employés auront besoin de se perfectionner pour acquérir l’expertise nécessaire. Or, dans le dernier rapport annuel de TalentLMS, 64% des employés souhaitent être formés à l’utilisation des nouveaux outils d’IA, et 49% se plaignent que l’IA progresse plus vite que la formation dispensée par leur entreprise. Là encore, vous pouvez vous appuyer sur des approches familières en low-code, qui devraient contribuer à répondre aux préoccupations et aux réticences de nombreux, en particulier quant à la menace que fait peser l’IA générative sur leur emploi.Renforcer le partage des expériences réussiesL’adoption responsable de l’IA générative implique de laisser les employés partager les avantages de ces outils plutôt que de les laisser considérer cette technologie comme une concurrence. Et les organisations devraient soutenir les employés qui partagent leurs expériences réussies, en indiquant clairement quels domaines sont les plus appropriés et lesquels présentent un risque trop élevé.Il existe des raisons évidentes pour lesquelles les employés qui tirent profit de l’IA générative au quotidien ne partagent pas naturellement leurs succès : les politiques interdisant l’utilisation inappropriée de l’IA générative peuvent les effrayer, ils peuvent s’attendre à être davantage récompensés pour leurs résultats que pour le partage de leurs techniques, et ils peuvent craindre des réductions de coûts ou de se voir confier davantage de travail en raison de l’amélioration de leur productivité avec l’IA générative.Parfois, encore, les utilisateurs de l’IA dans votre organisation peuvent être enthousiastes à l’idée de partager ce qui fonctionne pour eux, mais sans avoir de moyen efficace de le faire. Encore une fois, les mêmes programmes qui ont soutenu l’adoption du low-code – trouver et soutenir des champions, organiser des hackathons et des sessions de partage, développer un centre d’excellence et des équipes fusionnant IT et métiers pour supporter les développements, reconnaître l’expertise des employés avec des augmentations de salaire et des promotions ou encore développer de nouvelles fonctions – donnent des pistes pour accélérer l’adoption de l’IA agentique.Equipes fusion« Une fois que vous avez vérifié la sécurité et les modèles que vous utilisez, et que vous vous êtes assuré que vos données sont prêtes et de les autres fondamentaux, votre approche doit consister à suivre le même plan pour trouver les premiers adoptants, organiser des hackathons et des boot camps, puis étendre l’expérimentation à tous les participants volontaires dans différents métiers, en créant de nouvelles applications dopées à l’IA, les agents étant une des possibilités en la matière », explique John Bratincevic.Les équipes fusionnant IT et métiers sont déjà une réalité. Les données 2023 de Forrester montrent que 62 % des développeurs professionnels effectuent la majeure partie ou la totalité de leur travail en collaboration avec des citizen développeurs. « Les technologues aident les non-technologues en fonction de leurs besoins, explique l’analyste. Ils ajoutent de nouvelles sources de données ou de nouveaux terminaux, ou aident leurs collègues des métiers à étendre leurs connaissances. »Kjell Carlsson suggère de considérer les équipes ‘fusion’ ou les centres d’excellence, qui peuvent fournir des conseils et un support technique ainsi que des évaluations réalistes de ce qui fonctionne et de ce qui ne fonctionne pas, comme un compagnon indispensable de l’IA. « Ne jamais faire de l’IA seul devrait être une loi de l’IA », affirme-t-il.Certaines expériences seront des échecs. Comme l’explique John Bratincevic, « la démocratisation du passage à l’échelle entraîne des désordres et des risques. Les entreprises qui réussissent tendent à gérer ce risque de manière pragmatique. Elles séparent les différents types de risques et disposent d’un espace prédéfini pour mettre les applications en place, ce qui permet d’en atténuer une grande partie ». Encore une fois, on retrouve un bénéfice familier du low-code : exploiter la créativité des employés motivés pour résoudre les problèmes de l’entreprise.

La start-up chinoise Deepseek est dans le collimateur de nombreux pays dont l’Italie en Europe. En France, la CNIL exige des explications sur sa gestion des données alors que plane une éventuelle menace sur la sécurité nationale.

Peu après son lancement, la plateforme suscite des inquiétudes quant à la gestion et au stockage des données personnelles,potentiellement accessibles aux autorités chinoises. Tandis que certains y voient une menace pour la sécurité nationale, d’autres redoutent des fuites d’informations sensibles. Si des pays comme l’Italie, la Corée du Sud ou Taïwan ont déjà coupé son accès, la France adopte une approche plus mesurée. Pour Paul-Olivier Gibert, président de…

Il vous reste 87% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

Palo Alto Networks enjoint les administrateurs de ses pare-feux à bloquer l’accès aux interfaces de gestion sur Internet après la découverte d’une failles dans PAN-OS référencée CVE-2025-0108 activement exploitée.

Les administrateurs de pare-feux de Palo Alto Networks sous sous pression après la découverte la semaine dernière d’une nouvelle faille dans PAN-OS. Ils doivent donc s’assurer que les dispositifs sont entièrement corrigés et que l’interface de gestion est bloquée pour empêcher tout accès à Internet ouvrant la voie à un contournement de l’authentification de connexion dans ce système d’exploitation pour firewalls. Les chercheurs de Greynoise ont confirmé que la vulnérabilité référencée CVE-2025-0108, découverte par des chercheurs d’Assetnote, est toujours exploitée. Palo Alto Networks explique que les administrateurs peuvent « réduire considérablement le risque » d’exploitation en limitant l’accès à l’interface web de gestion aux seules adresses IP internes de confiance, conformément à ses lignes directrices de déploiement des meilleures pratiques recommandées. « Cette limitation garantit que les attaques ne peuvent réussir que si elles obtiennent un accès privilégié via ces adresses IP spécifiées », a déclaré le fournisseur. Les experts en sécurité mettent régulièrement en garde les administrateurs de réseau et les professionnels de l’IT contre les dangers liés à l’exposition des interfaces de gestion des appareils ouvert sur l’Internet. Il est possible de les protéger soit en y accédant via un réseau privé virtuel (VPN), soit en restreignant l’accès aux seules adresses IP internes.

Trouver les équipements à risque

Pour savoir quels actifs nécessitent une remédiation, Palo Alto Networks indique que les administrateurs doivent se rendre dans la section Assets de son portail de support client « Customer Support Portal » et rechercher la section Remédiation requise/Remediation Required. Une liste des dispositifs ayant une interface de gestion orientée vers Internet et marqués « PAN-SA-2024-0015 » s’affichera. Si aucun dispositif n’est répertorié, c’est qu’il n’y a aucun actif avec une interface de gestion orientée vers Internet. À noter que si un profil de gestion a été configuré sur les interfaces avec les portails ou les passerelles GlobalProtect, un dispositif PAN est exposé via l’interface web de gestion, généralement accessible sur le port 4443. Le problème n’affecte pas les logiciels Cloud NGFW ou Prisma Access de Palo Alto Networks. Selon Greynoise, l’exploitation a commencé aux alentours du mardi 11 février. Assetnote a publié une recherche sur la faille le mercredi suivant. Palo Alto Networks a publié son avis le même jour.

Un comportement étrange dans le traitement des chemins d’accès

Assetnote fait remarquer que la vulnérabilité se traduit par un « comportement bizarre de traitement de chemin » dans la partie serveur HTTP Apache de PAN-OS, qui, avec Nginx, traite les requêtes web pour accéder à l’interface de gestion de PAN-OS. La requête web frappe d’abord le proxy inverse Nginx, et si elle est sur un port qui indique qu’elle est destinée à l’interface de gestion, PAN-OS définit plusieurs en-têtes. Le plus important d’entre eux est X-pan AuthCheck. La configuration de Nginx passe ensuite par plusieurs contrôles de localisation et désactive sélectivement le contrôle d’authentification. La requête est ensuite transmise à Apache, qui la renormalise et la traite à nouveau, et applique une règle de réécriture sous certaines conditions. Si le fichier demandé est un fichier PHP, Apache transmettra alors la requête via mod_php FCGI, qui applique l’authentification sur la base de l’en-tête. Le problème est qu’Apache peut traiter le chemin ou les en-têtes différemment de Nginx avant que la demande d’accès ne soit transmise à PHP, de sorte que s’il existe une différence dans le traitement de la demande par Nginx et par Apache, un attaquant pourrait parvenir à contourner l’authentification. Assetnote décrit cela comme un problème d’architecture « assez courant » où l’authentification est appliquée au niveau d’une couche proxy, mais où la requête est ensuite transmise à une deuxième couche avec un comportement différent. « Fondamentalement, ces architectures conduisent à la contrebande d’en-têtes ou Header Smuggling et à la confusion des chemins, ce qui peut entraîner de nombreux bogues avec un potentiel impact.

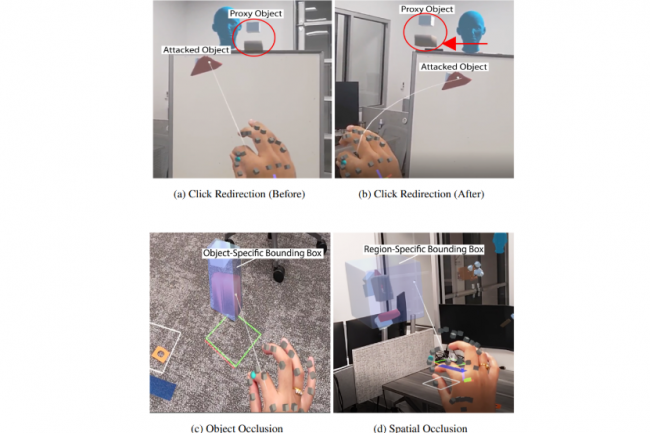

Les systèmes de réalité mixte pourraient être manipulés et mettre en danger les utilisateurs, voire rendre la collaboration difficile selon une recherche menée par Virginia Tech.

Des chercheurs de Virginia Tech ont publié une étude mettant en évidence une série de risques de sécurité qui pourraient compromettre les systèmes de réalité mixte. En particulier des menaces liées à la manipulation d’objets virtuels quand les utilisateurs collaborent via des casques de réalité mixte. Les travaux ont impliqué 20 participants de cet institut polytechnique et universitaire de l’Etat de Virginie, dont la plupart avaient peu ou pas d’expérience avec les casques de…

Il vous reste 90% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

Un rapport récent alerte sur le danger de la désinformation générée par l’intelligence artificielle, pouvant entraîner des retraits massifs de fonds et provoquer une crise financière.

À l’ère de l’intelligence artificielle, une simple rumeur peut suffire à ébranler la confiance des clients et mettre en péril la stabilité d’une banque. Un dernier rapport du cabinet d’analyse britannique Say no to disinfo et de Fenimore Harper indique qu’il existe un risque élevé que la désinformation générée par l’IA puisse provoquer des ruées vers les banques qui pourraient aller jusqu’à faire tomber les institutions financières. Dans ce cadre, une expérience a été menée, consistant à exposer un certain nombre de clients britanniques à des rumeurs générées par l’IA concernant leur banque. Par la suite, un tiers d’entre eux ont déclaré qu’ils étaient “très susceptibles” de retirer leur argent, tandis que 27 % ont affirmé être “assez susceptibles” de le faire. Selon le rapport, dépenser aussi peu que 10 M£ pour diffuser un faux message généré par l’IA suffirait à convaincre des clients de retirer plus de 1 M£ de la banque concernée. Les fausses rumeurs n’ont pas attendues l’IA pour sévir : il y a 5 ans, elles avaient contribué à ébranler Metro Bank qui avait perdu dans l’histoire près du quart de sa clientèle.

Interrogé par Reuters à propos de l’étude, Woody Malouf, responsable de la lutte contre la criminalité financière chez Revolut, a déclaré que la fintech basée à Londres effectue une surveillance en temps réel des menaces émergentes parmi ses clients et dans l’ensemble de l’écosystème. « Même si nous pensons qu’un tel événement est peu probable, il est toujours possible et il est donc essentiel que les institutions financières soient préparées », explique M. Malouf, ajoutant que les plateformes de médias sociaux doivent jouer un rôle plus important dans la lutte contre les menaces. D’autres institutions financières contactées par l’agence de presse, dont NatWest et Barclays, ont refusé de commenter ou n’ont pas répondu.

Des moyens de contrer la désinformation

Selon l’étude, pour mieux anticiper ces risques, les banques doivent renforcer la connaissance de leurs clients en identifiant les groupes les plus vulnérables, en comprenant où ils s’informent, comment ils vérifient les informations et quelles sources ils jugent fiables. Elles doivent également analyser leur réputation afin d’anticiper les attaques en identifiant les failles existantes pouvant être exploitées par des campagnes de désinformation, comme une mauvaise gestion des fraudes. Par ailleurs, la surveillance des acteurs potentiellement à l’origine de ces attaques est essentielle pour détecter à l’avance les tentatives de manipulation. Il est également crucial d’intégrer l’analyse des réseaux sociaux aux systèmes de suivi des retraits bancaires afin d’identifier rapidement l’impact d’une fausse information sur le comportement des clients.

Voulu par Donald Trump pour améliorer l’efficacité et réduire les coûts des agences et de l’administration américaine, le département de l’efficacité gouvernementale n’est selon la Maison Blanche, pas dirigé par Elon Musk. Ce dernier n’a officiellement qu’un simple rôle de conseiller auprès du président.

Les tentatives de remise en cause du pouvoir d’Elon Musk et de son équipe du DOGE (department of governement efficiency) quant à la fermeture des services gouvernementaux se sont heurtées à une complication inattendue : selon la Maison Blanche, l’entrepreneur n’est même pas en charge de l’opération. Cette affirmation surprenante a été faite dans des documents judiciaires déposés lundi par la Maison Blanche. Loin de diriger ce département de l’efficacité gouvernementale, M. Musk est simplement un autre…

Il vous reste 93% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

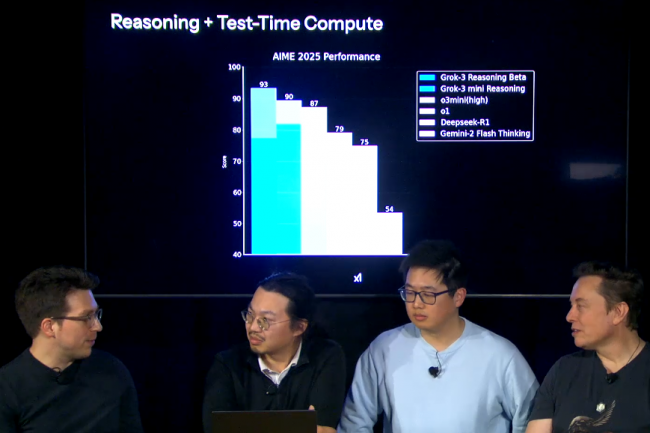

La start-up créée par Elon Musk, xAI, affirme que la dernière version de son LLM Grok 3 surpasse les meilleurs modèles dans les domaines des mathématiques, des sciences et du codage. Un moteur de recherche dopé à l’IA, Deepsearch, a aussi été présenté.

La start-up d’Elon Musk, xAI, a présenté Grok 3, la dernière version de son grand modèle de langage, que le dirigeant décrit comme le système d’IA le plus avancé à ce jour. xAI affirme que Grok 3 surpasse les modèles d’IA rivaux de Google Gemini d’Alphabet, V3 de Deepseek, Claude d’Anthropic et GPT-4o d’OpenAI dans des tests de référence pour les mathématiques, les sciences et le codage. « Il y a environ un mois, le pré-entraînement de Grok 3 a été achevé, et depuis lors, nous avons travaillé dur pour intégrer des capacités de raisonnement dans le modèle Grok 3 actuel », a déclaré l’entreprise lors de son événement de lancement lundi. Selon Elon Musk, Grok 3 a une puissance de calcul plus de dix fois supérieure à celle de son prédécesseur.

xAI a également présenté Deepsearch, un moteur de recherche avancé alimenté par l’IA qui fonctionne comme un chatbot basé sur le raisonnement. En s’appuyant sur ces capacités, l’entreprise prévoit de déployer l’API de Grok-3 dans les semaines à venir, afin d’étendre ses fonctions de raisonnement et de recherche approfondie. Cette initiative témoigne de la volonté de xAI de s’implanter plus largement sur les marchés des entreprises et des développeurs, où les outils d’automatisation et de prise de décision pilotés par l’IA sont très demandés. Grok 3 sera déployé pour les membres X Premium Plus à partir du 18 février, qui bénéficieront d’un accès en avant-première à Deepsearch.

Sécurité et conformité de Deepseek à évaluer par les DSI

« Grok 3 se lance dans une arène férocement concurrentielle aux côtés de ChatGPT et Microsoft Copilot, et son succès dépendra des performances réelles dans la génération de code, l’automatisation et les flux de travail d’IA d’entreprise », a déclaré Abhivyakti Sengar, analyste principal chez Everest Group. « Si xAI tient ses promesses, elle pourrait bouleverser le marché. Cependant, avant que les entreprises n’intègrent Grok 3, les DSI doivent évaluer rigoureusement ses mesures de sécurité et de conformité. » Grok 3 est désormais disponible pour les abonnés Premium Plus sur X. xAI lance également un nouveau niveau d’abonnement, SuperGrok, qui donnera accès à l’application mobile et au site web de Grok. L’entreprise développe également une fonction d’interaction vocale visant à améliorer les expériences d’IA conversationnelle, élargissant ainsi ses capacités au-delà des interactions textuelles.

Le lancement de Grok 3 intervient alors que la concurrence dans le secteur de l’IA s’intensifie, les entreprises se lançant dans une course au développement de modèles plus puissants et plus efficaces. Les analystes du secteur considèrent le lancement de Grok 3 comme un moment charnière dans ce paysage. « Avec Grok 3, nous nous attendons à une accélération significative de l’innovation en matière de R&D dans le domaine de l’IA, car il consolide sa position de leader face à des acteurs établis comme OpenAI et Google », a déclaré Prabhu Ram, vice-président du groupe de recherche sur l’industrie chez Cybermedia Research. « Les capacités avancées de Grok 3 susciteront un intérêt accru de la part des entreprises pour les solutions d’IA, permettant une plus grande efficacité et une prise de décision plus intelligente. »

Une adoption qui pose question

Avec l’expansion de xAI dans le domaine de la recherche et des applications d’IA d’entreprise, la bataille pour la domination de l’IA générative devrait encore s’intensifier. Musk a fondé xAI en 2023 pour rivaliser avec OpenAI (qui a refusé une offre de rachat par Elon Musk à 97,4 Md$), une société qu’il a ouvertement critiquée pour avoir évolué vers un modèle à but lucratif. Avec l’introduction de Grok-3 et le lancement prochain de l’API, xAI se positionne comme un concurrent sérieux sur le marché de l’IA. Toutefois, son succès à long terme dépendra des taux d’adoption, des critères de performance et de sa capacité à répondre aux exigences des entreprises en matière de sécurité et de conformité. « Il sera essentiel de comprendre comment elle traite et stocke les données, de garantir la confidentialité et de s’aligner sur des réglementations telles que le RGPD », a déclaré M. Sengar. « Un audit de sécurité approfondi et une collaboration étroite avec l’équipe de xAI peuvent contribuer à atténuer les risques et à assurer un déploiement sans heurts. »

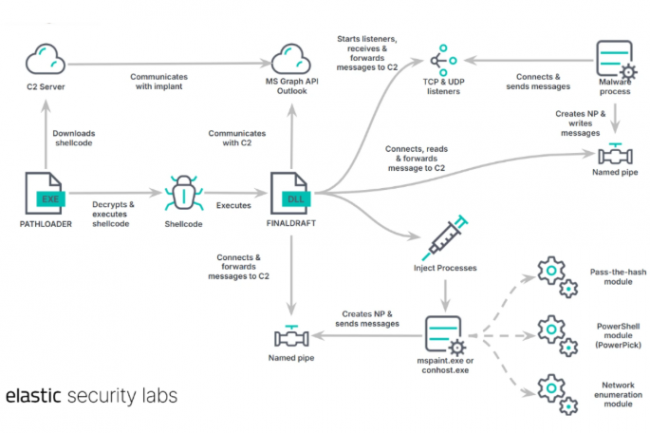

Des chercheurs d’Elastic Security ont identifié une attaque commençant par le vol d’identifiants et se poursuivant par une utilisation compromettante d’Outlook et de l’API graphique de Microsoft pour voler discrètement des données.

Les chercheurs d’Elastic Security mettent en garde les RSSI contre une famille de logiciels malveillants voleurs de données. Le nouveau vecteur d’attaque utilise Microsoft Outlook comme canal de communication en abusant de l’API Graph, et inclut un moyen de contourner les mots de passe hachés. Selon les chercheurs à l’origine de sa découverte, cette méthode a été créée par un groupe anonyme ciblant le ministère des Affaires étrangères d’un pays d’Amérique du Sud, mais est aussi liée à des compromissions observées dans une université d’Asie du Sud-Est et dans les télécommunications de cette région. La campagne se caractérise par un « ensemble d’intrusions novatrices, bien conçues et très performantes », indiquent-ils dans un rapport. La campagne contre le pays sud-américain a peut-être commencé en novembre 2024. C’est à ce moment-là qu’Elastic Security a détecté un groupe restreint d’alertes comportementales au sein du ministère des Affaires étrangères du pays. La manière dont le système informatique a été initialement compromis n’est pas claire, mais le gang a utilisé des tactiques de survie une fois à l’intérieur du système. Ils ont notamment utilisé l’application de gestion des certificats certutil de Windows pour télécharger des fichiers. Le rapport indique que l’espionnage semble être le motif de l’intrusion et qu’il existe des versions Windows et Linux du logiciel malveillant. Par chance, le gang « a commis des erreurs dans la gestion de sa campagne et ses tactiques d’évasion sont incohérentes », note le rapport.

Néanmoins, les RSSI devraient être attentifs aux signes d’attaques utilisant les techniques de ce groupe, car leurs cibles pourraient se répandre et leurs techniques pourraient gagner en sophistication. Un indice signalé aux RSSI par les chercheurs serait immédiatement détectable : après la compromission initiale, le gang a utilisé le plugin Remote shell de Windows Remote Management (WinrsHost.exe), un processus côté client utilisé par Windows Remote Management, pour télécharger des fichiers. Ces fichiers comprennent un exécutable, des fichiers rar, des fichiers ini et des fichiers log. L’exécutable est une version renommée d’un débogueur signé par Windows, CDB.exe.

Des informations d’identification réseau valides aux mains des pirates

Comme l’indique le rapport, l’utilisation abusive de ce binaire a permis aux attaquants d’exécuter un shellcode malveillant livré dans un fichier config.ini sous l’apparence de binaires de confiance. L’utilisation du plugin shell de Windows Remote Management (WRM) « indique que les attaquants possédaient déjà des informations d’identification réseau valides et qu’ils les utilisaient pour un mouvement latéral à partir d’un hôte précédemment compromis dans l’environnement ». Il ajoute que « la manière dont ces informations d’identification ont été obtenues est inconnue ». Johannes Ullrich, doyen de la recherche à l’Institut SANS fait remarquer qu’il « est toujours délicat d’empêcher les mouvements latéraux si un attaquant a obtenu des informations d’identification valides », ajoutant « qu’ils pourraient provenir d’autres brèches (credential stuffing) ou simplement d’enregistreurs de frappe ou de voleurs d’informations qu’ils ont pu déployer au cours de phases antérieures de l’attaque et qui ne sont pas couvertes par le rapport. »

Outre un chargeur et une porte dérobée, les principaux composants du logiciel malveillant utilisé par l’attaquant sont les suivants :

– Pathloader : ce fichier exécutable Windows léger télécharge et exécute un shellcode chiffré hébergé sur un serveur distant. Il utilise des techniques pour éviter une exécution immédiate dans la sandbox de l’entreprise cible. Pour bloquer l’analyse statique, il effectue un hachage de l’API et un chiffrement de la chaîne ;

– FinalDraft : ce logiciel malveillant 64 bits écrit en C++ se concentre sur l’exfiltration de données et d’exécution de code arbitraire dans un espace d’adresse séparé d’un processus (process injection). Il comprend plusieurs modules qui peuvent être injectés par le logiciel malveillant ; leurs résultats sont transmis à un serveur de commande et de contrôle (C2).

Entre autres choses, il recueille initialement des informations sur les serveurs ou les PC compromis, notamment le nom de l’ordinateur, le nom d’utilisateur du compte, les adresses IP internes et externes, ainsi que des détails sur les processus en cours d’exécution. FinalDraft comprend également une boîte à outils « pass-the-hash » similaire à Mimikatz pour traiter les hachages NTLM (New Technology LAN Manager) volés.

Des attaques personnalisées plus efficaces

Pour communiquer, le malware passe, entre autres choses, par le service de messagerie Outlook, qui utilise l’API Microsoft Graph. Cette API permet aux développeurs d’accéder aux ressources hébergées sur les services cloud de Microsoft, y compris Microsoft 365. Bien qu’un jeton de connexion soit nécessaire pour cette API, le logiciel malveillant FinalDraft a la capacité de capturer un jeton de l’API Graph. Selon un rapport de Symantec publié l’année dernière, un nombre croissant d’acteurs de la menace abusent de l’API Graph pour dissimuler des communications. De plus, FinalDraft peut, entre autres, installer un listener TCP après avoir ajouté une règle au pare-feu Windows. Cette règle est supprimée lorsque le serveur s’éteint. Il peut également supprimer des fichiers et empêcher les services IT de les récupérer en écrasant les données par des zéros avant de les supprimer. « C’est un excellent exemple d’utilisation de la technique « living-off-the-land » (LOLBins) à son plein potentiel », a commenté M. Ullrich. « Cela indique que l’adversaire a pris le temps de personnaliser son attaque afin d’atteindre le plus efficacement possible sa cible. Il est vraiment difficile de se défendre contre une attaque de ce type. L’aspect « avancé » de l’APT (Advanced Persistent Threat) est souvent plus visible dans cette préparation que dans les outils utilisés et l’exécution de l’attaque.

À la fin de son rapport, Elastic Security énumère plusieurs règles Yara qu’il a créées et publiées sur GitHub pour mieux se défendre contre le malware. Ces règles permettent de détecter PathLoader et FinalDraft sous Windows, et cette règle détecte FinalDraft sous Linux.

Spécialisée dans la détection avancée des menaces par IA, la start-up israélienne Dream co-fondée par Shalev Hulio ancien CEO de Pegasus, a réalisé un second tour de table de 100 millions de dollars dirigé par Bain Capital Ventures. La société est désormais valorisée à 1,1 Md$.

Ds grandes entreprises américaines comme OpenAI aux start-ups françaises (Alice&Bob), les levées de fonds se multiplient dans le secteur IT. Dernière en date, celle de Dream, jeune pousse israélienne positionnée dans la détection et la neutralisation des cybermenaces dopée à l’IA, s’est distinguée en levant 100 M$ lors d’un second tour de table (serie B). Cette société a été co-fondée en janvier 2023 par Shalev Hulio, connu pour avoir (aux côtés de Sebastian Kurz, ancien chancelier autrichien) co-fondé et dirigé NSO à l’origine du logiciel espion Pegasus, avant de démissionner suite au vaste scandale d’espionnage qui s’était également étendu jusque dans la sphère politique française.

Ce financement a été mené par Bain Capital Ventures, avec la participation d’autres investisseurs comme group 11, Tru Arrow, Tau Capital et Aleph. « L’arrivée d’Enrique Salem [partner Bain Capital Ventures et ex CEO de Symantec, ndlr] et de Shlomo Yanai [ancien CEO de Teva Pharmaceuticals et actuel membre du board de Philip Morris, ndlr] au conseil d’administration renforce les perspectives de croissance de l’entreprise. Leur expertise dans la mise à l’échelle de solutions technologiques avancées sera un atout majeur pour Dream », a souligné la jeune pousse. Cette levée survient après une précédente de 33,6 M$ (serie A) de novembre 2023 précédée par une autre d’amorçage (seed) de 20 M$ en octobre 2022.

130 M$ de revenus en 2024

Dream a développé une technologie (CLM pour cyber language model) capable d’analyser et d’anticiper les cyberattaques en temps réel s’appuyant sur plusieurs grands modèles de langage entraînés sur des attaques passées ainsi qu’un système avancé de détection des anomalies. Avec cette levée de fonds, le fournisseur compte accélérer le développement de son CLM, étendre sa présence sur des marchés supplémentaires (sans donner plus de détails), et étoffer ses équipes. La socété, qui dispose de bureaux à Vienne et Abu Dhabi, indique avoir réalisé sur l’année écoulée un chiffre d’affaires de 130 M$.