Les développeurs en langage Rust ont été alertés d’une faille sérieuse dans la bibliothèque TAR et ses forks. Elle entraîne l’exécution de code à distance.

Des chercheurs de la société Edera ont découvert une vulnérabilité importante dans le langage Rust et plus exactement la bibliothèque async-tar Rust et ses dérivés dont le très utilisé tokio-tar. Baptisée TARmageddon (CVE-2025-62518), elle affiche un score de gravité de 8,1 et « peut conduire à l’exécution de code à distance via des attaques par écrasement de fichiers, telles que le remplacement de fichiers de configuration ou le détournement de backends de compilation », ont alerté les experts dans un rapport. La propagation de l’infection via des applications, également connue sous le nom d’attaque de type supply chain, fait partie des autres impacts possibles.

Selon les chercheurs, la première mesure recommandée consiste à corriger tous les forks actifs, car cette vulnérabilité affecte des projets majeurs et largement utilisés, notamment les projets uv (le gestionnaire de paquets Python d’Astral), testcontainers et wasmCloud. « En raison de la très large utilisation de tokio-tar sous diverses formes, il n’est pas possible de quantifier à l’avance l’ampleur réelle de ce bug dans l’écosystème », ont-ils affirmé. Pour aggraver les choses, les chercheurs avertissent que le fichier tokio-tar, très téléchargé, n’a toujours pas été corrigé, probablement parce qu’il n’est plus maintenu activement. Edera suggère aux développeurs qui s’en servent d’envisager de migrer vers une version activement maintenue, comme astral-tokio-tar version 0.5.6 ou ultérieure, qui a été corrigée. Les responsables IT doivent également analyser leurs applications pour voir si certaines ont été développées en Rust et si elles présentent un risque.

Pourquoi il faut s’en inquiéter

« Les fichiers TAR sont utilisés dans les systèmes Unix et Linux pour regrouper plusieurs répertoires et fichiers dans une archive qui conserve la structure complète du répertoire et les métadonnées des informations d’origine », a expliqué Robert Beggs, directeur de l’entreprise canadienne de réponse aux incidents DigitalDefence. Les archives servent couramment dans les sauvegardes ou pour compresser des logiciels, en particulier pour la distribution de code source. « La manière dont certaines versions des bibliothèques TAR ont été écrites expose à une vulnérabilité potentielle », a-t-il déclaré par courriel, en précisant que « dans le pire des cas, cela permettrait à un pirate d’exécuter un code arbitraire sur un système hôte et de se livrer à des actions malveillantes, par exemple, l’écrasement de fichiers critiques (fichiers de configuration, scripts de compilation) ou l’obtention d’un accès non autorisé au système de fichiers. » L’exploitation pourrait également compromettre tout système qui extrait des fichiers du TAR malveillant. « Cette faille est particulièrement grave car les bibliothèques TAR vulnérables sont souvent présentes dans des applications qui ne font pas l’objet d’une maintenance active et peuvent être oubliées lors de l’application de correctifs ou d’autres mesures visant à atténuer le problème », a-t-il ajouté. Même s’il n’y a pour l’instant aucune exploitation connue de cette vulnérabilité, M. Beggs pense que cela pouvait changer rapidement. « Cette vulnérabilité étant de gravité élevée – 8,1 sur une échelle de 1 à 10 – elle est susceptible d’attirer l’attention des pirates. »

Recommandations

Le spécialiste formule plusieurs recommandation aux responsables en cybersécurité. En premier lieu, il est nécessaire d’auditer le code afin d’identifier les dépendances pour les forks ou les wrappers de tokio-tar et de s’assurer qu’ils sont également corrigés. Par ailleurs, il convient d’examiner l’utilisation des fichiers TAR dans les environnements d’intégration continue/déploiement continu CI/CD ainsi que dans les conteneurs, et de s’assurer qu’ils sont corrigés. De même, il est judicieux d’isoler (sandbox) les archives lors du traitement et d’éviter d’extraire des fichiers TAR provenant de sources non fiables. Une surveillance continue des éventuels exploits ou d’autres vulnérabilités associés à la bibliothèque est conseillée.

Les administrateurs pourraient également être intéressés par cet avis expliquant le problème publié par Astral Security, qui gère astral-tokio-tar. Le bogue a été découvert en juillet et divulgué le même mois aux responsables de toutes les bibliothèques, à la Rust Foundation et à un certain nombre de projets. Il a été convenu que les détails ne seraient pas divulgués avant cette semaine. Étant donné que le fork le plus populaire, tokio-tar, qui cumule plus de 5 millions de téléchargements sur crates.io, ne semble plus faire l’objet d’une maintenance active, Edera a coordonné une divulgation décentralisée à travers la lignée complexe des forks.

Conséquences possibles

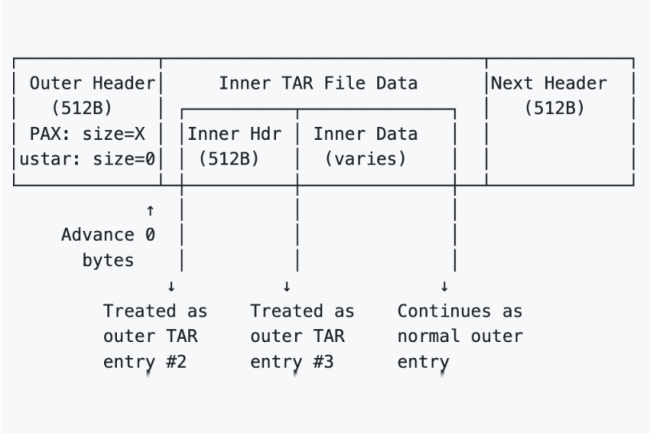

Selon Edera, cette vulnérabilité est un défaut de désynchronisation qui permet à un cybercriminel « d’introduire clandestinement » des entrées d’archive supplémentaires dans les extractions TAR. Elle se produit lors du traitement de fichiers TAR imbriqués qui présentent une incompatibilité spécifique entre leurs en-têtes étendus PAX et leurs en-têtes ustar. La faille provient de la logique incohérente du parseur lors de la détermination des limites des données des fichiers.

Parmi les scénarios d’infection possibles décrits par Edera, on peut citer :

– une attaque contre les gestionnaires de paquets Python utilisant tokio-tar. Un pirate télécharge un paquet malveillant sur le référentiel open source PyPI, à partir duquel les développeurs téléchargent des utilitaires. Le conteneur TAR externe du paquet contient un fichier légitime, mais le TAR interne caché contient un fichier malveillant qui détourne le backend de compilation. Ce TAR interne caché introduit des fichiers inattendus ou écrasés, ce qui compromet l’environnement de test et pollue la chaîne d’approvisionnement ;

– une attaque contre tout système comportant des phases distinctes de « scan/approbation ». Un scanner de sécurité analyse le TAR externe, qui est propre, et approuve son ensemble de fichiers limité. Cependant, le processus d’extraction utilisant la bibliothèque vulnérable extrait des fichiers supplémentaires, non approuvés et non analysés du fichier TAR interne, ce qui entraîne un contournement des contrôles de sécurité et une violation de la politique.

Les développeurs Rust affirment que ce langage crée des applications en mémoire sécurisées, mais selon les chercheurs d’Edera, « la découverte de TARmageddon nous rappelle de manière importante que Rust n’est pas une solution miracle ». Le rapport souligne que « le langage ne supprime pas les erreurs logiques, et cette incohérence d’analyse est fondamentalement un défaut logique. Les développeurs doivent rester vigilants face à toutes les catégories de vulnérabilités, quel que soit le langage utilisé. » Le rapport rappelle également les dangers liés à l’utilisation de bibliothèques open source non maintenues dans le code.

A l’occasion de son IT Symposium/Xpo qui s’est tenu à Orlando en Floride (20-23 octobre), le Gartner a présenté les 10 principales tendances technologiques pour l’année à venir. Supercalculateurs IA, systèmes multi-agents et confidential computing en font partie.

Sans surprise, l’IA a occupé le devant de la scène du Gartner IT Symposium/Xpo qui s’est tenu cette semaine (20 au 23 octobre) à Orlando, en Floride, où, comme chaque année, le cabinet d’études présente les principales tendances technologiques qui façonneront l’IT d’entreprise au cours de l’année à venir. « Les entreprises ont besoin d’un responsable dédié à l’IA », a déclaré Daryl Plummer, vice-président analyste émérite, directeur de la recherche, Gartner Fellow et principal intervenant de la conférence. « 2026 sera une année charnière pour les leaders technologiques, car les perturbations, les innovations et les risques se développent à une vitesse sans précédent », a avancé Gene Alvarez, vice-président analyste émérite chez du cabinet. « Les principales tendances technologiques stratégiques identifiées pour 2026 sont étroitement liées et reflètent les réalités d’un monde hyperconnecté et alimenté par l’IA, dans lequel les entreprises doivent favoriser l’innovation responsable, l’excellence opérationnelle et la confiance numérique », a-t-il souligné. « Mais le rythme est différent : plus d’innovations ont émergé cette année comme jamais auparavant », a ajouté Tori Paulman, vice-présidente analyste du Gartner.

Zoom sur les principales tendances technologiques stratégiques pour 2026 :

Des supercalculateurs d’IA

D’ici à 2028, plus de 40 % des grandes entreprisesdevraient adopter des architectures IT hybrides dans leurs processus métier critiques, contre 8 % actuellement. « Les supercalculateurs d’IA intègrent des CPU, des GPU, des ASIC dédiés à l’IA, des paradigmes informatiques neuromorphiques et alternatifs, pour que les entreprises puissent orchestrer des charges de travail complexes tout en atteignant de nouveaux niveaux de performance, d’efficacité et d’innovation. Ces systèmes combinent des processeurs puissants, une mémoire massive, du matériel spécialisé et des logiciels d’orchestration pour traiter des charges de travail gourmandes en données dans des domaines comme l’apprentissage machine, la simulation et l’analyse », a déclaré le Gartner.

Des modèles de langage spécifiques à un domaine

Plus de la moitié des modèles de GenAI utilisés par les entreprises seront spécifiques à un domaine d’ici 3 ans. Les modèles de langage spécifiques à un domaine (Domain-Specific Language Models, DSLM) comblent une lacune des grands modèles de langage génériques en offrant une plus grande précision, des coûts réduits et une meilleure conformité. « Les DSLM sont des modèles de langage formés ou affinés à partir de données spécialisées pour un secteur, une fonction ou un processus particulier. Contrairement aux modèles généralistes, les DSLM offrent une précision, une fiabilité et une conformité accrues pour répondre aux besoins spécifiques des entreprises », a souligné l’expert en prévisions. « Les agents d’IA non liés aux DSLM peuvent interpréter le contexte spécifique à un secteur pour prendre des décisions pertinentes, même dans des scénarios inconnus, et excellent en termes de précision, d’explicabilité et de prise de décision », a affirmé Mme Paulman. La société estime que les dépenses mondiales des utilisateurs finaux en modèles d’IA générative devraient atteindre 14,2 milliards de dollars en 2025 et que les dépenses des utilisateurs finaux en modèles d’IA générative spécialisés, qui incluent les DSLM, devraient atteindre 1,1 milliard de dollars cette année.

Des plateformes de sécurité basées sur l’IA

A horizon 2028, plus de 50 % des entreprises utiliseront des plateformes de sécurité basées sur l’IA pour protéger leurs investissements dans l’IA. « Les plateformes de sécurité basées sur l’IA offrent un moyen unifié de sécuriser les applications d’IA tierces et personnalisées. Elles centralisent la visibilité, appliquent les politiques d’usage et protègent contre les risques spécifiques à l’IA, comme l’injection de prompts, les fuites de données et les actions malveillantes des agents. Ces plateformes aident les DSI à appliquer les politiques relatives à l’usage, à surveiller l’activité de l’intelligence artificielle et à mettre en place des garde-fous cohérents pour l’ensemble de l’IA », selon Gartner. « La popularité des agents d’IA personnalisés introduit de nouvelles surfaces d’attaque et de nouveaux risques qui exigent des entreprises qu’elles adoptent des pratiques de développement et de sécurité d’exécution sécurisées […] Les actions des agents d’IA étant basées sur un modèle probabiliste, elles sont, par nature, moins prévisibles, ce qui complique la gestion des risques. Pour tirer parti des avantages des agents d’IA tout en écartant les incertitudes ».

Des plateformes de développement IA native

D’ici à 2030, les plateformes de développement IA natives permettront à 80 % des entreprises de transformer leurs grandes équipes d’ingénieurs logiciels en équipes plus petites et plus agiles, augmentées par l’IA. Les plateformes de développement IA natives utilisent la GenAI pour créer des logiciels plus rapidement et plus facilement qu’auparavant. Les entreprises peuvent constituer de petites équipes associées à l’IA pour créer davantage d’applications avec le même nombre de développeurs qu’aujourd’hui. Selon le cabinet, les entreprises leaders créent de petites équipes dédiées aux plateformes afin que des experts non techniques puissent produire eux-mêmes des logiciels, avec des garde-fous de sécurité et de gouvernance

Informatique confidentielle

Plus de 75 % des opérations traitées dans des infrastructures non fiables seraient sécurisées lors de leur utilisation d’ici 2029 grâce au confidential computing. « L’informatique confidentielle change la façon dont les entreprises traitent les données sensibles. En isolant les charges de travail dans des environnements d’exécution de confiance (Trusted Execution Environments, TEE) basés sur du matériel, elle préserve la confidentialité du contenu et des charges de travail, même vis-à-vis des propriétaires d’infrastructures, des fournisseurs de cloud ou de toute personne ayant un accès physique au matériel », a expliqué Gartner. « Ces environnements sont particulièrement utiles pour les secteurs réglementés et les opérations mondiales confrontés à des risques géopolitiques et de conformité, ainsi que pour la collaboration entre concurrents. »

Cybersécurité préventive

D’ici à 2030, les solutions de cybersécurité préventive représenteront la moitié de toutes les dépenses de sécurité, contre moins de 5 % en 2024, les DSI passant d’une défense réactive à une protection proactive. D’après le prévisionniste, les technologies de cybersécurité préventive utilisent l’intelligence artificielle (IA) et l’apprentissage machine (ML) avancés pour anticiper et neutraliser les menaces avant qu’elles ne se concrétisent. Elles comprennent des fonctionnalités de renseignement prédictif sur les menaces, de fraude avancée et de défense automatisée des cibles mobiles. La cybersécurité préventive suscite beaucoup d’intérêt, car les entreprises sont confrontées à une augmentation exponentielle des menaces visant les réseaux, les données et les systèmes connectés. « La cybersécurité préventive consiste à agir avant que les attaquants ne frappent, en utilisant des SecOps alimentés par l’IA, le déni programmatique et la tromperie », a encore déclaré Mme Paulman. « C’est un monde où la prédiction est synonyme de protection. » Les solutions de cybersécurité préventive devraient remplacer de plus en plus les solutions autonomes de détection et de réponse comme approche privilégiée pour se défendre contre les cybermenaces. « La cybersécurité préventive sera bientôt la nouvelle norme pour toutes les entités opérant sur, dans ou à travers les différentes couches interconnectées du réseau mondial de surface d’attaque (Global Attack Surface Grid, GASG) », a souligné Carl Manion, Managing Vice-Président chez Gartner, dans un rapport récent.

Provenance numérique

A échéance 2029 ceux qui n’auront pas suffisamment investi dans les capacités de provenance numérique s’exposeront à des risques de sanctions pouvant atteindre des milliards de dollars. « Parce que les entreprises s’appuient de plus en plus sur des logiciels tiers, du code open source et du contenu généré par l’IA, la vérification de la provenance numérique est devenue essentielle. La provenance numérique désigne la capacité à vérifier l’origine, la propriété et l’intégrité des logiciels, des données, des médias et des processus. De nouveaux outils comme les nomenclatures logicielles (Software Bill of Materials, SBoM), les bases de données d’attestation et le tatouage numérique offrent aux entreprises les moyens de valider et de suivre les actifs numériques tout au long de la chaîne d’approvisionnement », a rappelé Gartner.

Géopatriation

D’ici à 2030, plus de 75 % des entreprises européennes et moyen-orientales déplaceront leurs charges de travail virtuelles dans des solutions capables de réduire les risques géopolitiques, contre moins de 5 % en 2025. D’après la définition de Gartner, la géopatriation consiste à transférer les données et les applications d’une entreprise hors des clouds publics mondiaux vers des options locales, notamment des clouds souverains, des fournisseurs de cloud régionaux ou les propres centres de données d’une entreprise en raison d’un risque géopolitique identifié. Autrefois limitée aux banques et aux gouvernements, la souveraineté du cloud touche désormais un large éventail d’entreprises à mesure que l’instabilité mondiale s’accroît.

Systèmes multi-agents

L’expert en conjonctures définit les systèmes multi-agents (Multiagent Systems, MAS) comme des ensembles d’agents d’IA qui interagissent pour atteindre des objectifs complexes individuels ou communs. Les agents peuvent être fournis dans un environnement unique ou développés et déployés indépendamment dans des environnements distribués. « L’adoption de systèmes multi-agents est un moyen pratique pour les entreprises d’automatiser des processus métier complexes, d’améliorer les compétences des équipes et de faire collaborer autrement les humains et les agents d’IA », a expliqué M. Alvarez. « Des agents modulaires et spécialisés peuvent améliorer l’efficacité, accélérer la livraison et réduire les risques en réutilisant des solutions éprouvées dans tous les workflows. Cette approche facilite également la mise à l’échelle des opérations et l’adaptation rapide à l’évolution des besoins. »

IA physique

« L’IA physique apporte l’intelligence dans le monde réel en alimentant des machines et des appareils qui détectent, décident et agissent, comme les robots, les drones et les équipements intelligents. Elle apporte des gains mesurables dans les secteurs où l’automatisation, l’adaptabilité et la sécurité sont des priorités », selon le cabinet d’études. « À mesure que son adoption se généralise, les entreprises ont besoin de nouvelles compétences qui font le lien entre l’IT, l’OT et l’ingénierie. Cette évolution crée des opportunités de perfectionnement et de collaboration, mais peut également susciter des inquiétudes sur le plan de l’emploi et nécessiter une gestion minutieuse du changement. »

A l’occasion de sa conférence TechXchange, IBM a présenté des mises à jour de watsonX orchestrate et l’assistant IA pour les mainframes. Il a par ailleurs renforcé la sécurité des données avec Guardium Cryptography Manager.

L’IA était au centre des débats lors de la conférence TechXchange d’IBM qui s’est tenue à Atlanta début octobre. La firme a dévoilé des mises à jour de la gamme watsonX et un outil de gestion du chiffrement prêt pour le quantique. En premier lieu, Big Blue propose une actualisation de sa plateforme d’orchestration des agents IA.

Différents outils et agents pré-intégrés

WatsonX Orchestrate propose plus de 500 outils et agents personnalisables en fonction des métiers. IBM…

Il vous reste 93% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

Lancée en 2019 pour remplacer la gestion des cookies tiers et tracer la navigation des internautes, la Privacy Sandbox de Google est définitivement abandonnée. Présentée comme plus respectueuse de la vie privée, elle n’a pas réussi à séduire les annonceurs et diffuseurs de contenus.

Clap de fin pour Privacy Sandbox, la tentative de Google de proposer une alternative aux cookies. La firme de Mountain View a annoncé qu’elle abandonnait 11 de ses technologies, soit la quasi-totalité de celles qui composent cette offre. Anthony Chavez, vice-président de Privacy Sandbox, a déclaré dans un billet de blog que l’équipe avait pris cette décision « après avoir évalué les commentaires de l’écosystème sur leur valeur attendue et en tenant compte du faible niveau d’adoption ». Google a lancé cette initiative en août 2019 afin de permettre aux annonceurs d’obtenir des informations sur les utilisateurs sans utiliser des cookies tiers. Elle a suscité de nombreuses critiques de la part du secteur. Les rêves de Google d’un avenir sans cookies ont pris un coup après que l’Autorité britannique de la concurrence et des marchés a annoncé qu’elle ouvrait une enquête antitrust pour déterminer si le firme de Mountain View abusait de sa position dominante sur le marché des navigateurs. Une démarche qui a été suivie par plusieurs États américains, qui ont chacun engagé leur propre procédure antitrust.

Cette pression juridique a fini par porter ses fruits. En juillet dernier, Google est revenu sur sa position selon laquelle Privacy Sandbox serait la technologie de confidentialité dominante sur Chrome. L’autorité des marchés et de la concurrence britannique (CMA) a réagi avec prudence et a déclaré qu’elle attendait toujours d’autres engagements de la part de la firme. En avril, cette dernière a fait de nouvelles concessions et, à présent, cette initiative semble avoir dissipé toutes les inquiétudes en matière d’antitrust. Cependant, le manque d’adhésion à la Privacy Sandbox a probablement joué un rôle plus important dans son abandon.

Un taux d’adoption faible

Selon Javvad Malik, conseiller principal en sécurité informatique chez KnowBe4, « le faible taux d’adoption est un signal utile et suggère que cela n’a pas apporté suffisamment de valeur mesurable par rapport à la complexité opérationnelle et aux risques. Lorsque les incitations, les outils et la responsabilité ne sont pas alignés, même les technologies préservant la confidentialité ont du mal à être adoptées. » Il a déclaré que, même s’il comprenait pourquoi Google souhaitait trouver une alternative aux cookies, il existait également une exigence technique. « En ce qui concerne l’alternative aux cookies, le fait qu’une solution soit techniquement viable ne signifie pas qu’elle soit adaptable. Les outils doivent être conçus en tenant compte des utilisateurs. Si les API sont trop incohérentes et le retour sur investissement incertain, de nombreuses équipes auront du mal à les adopter.

Les technologies que Google abandonne sont les suivantes : Attribution Reporting API pour Chrome et Android, IP Protection, Protected Audience API pour Chrome et Android, Protected App Signals, On Device Personalization, Related Website Sets, Private Aggregation (incluant Shared Storage), Select URL, SDK Runtime et Topics pour Chrome et Android. Les seules survivantes sont les API Chips et FedCM (qui améliorent la confidentialité et la sécurité des cookies et rationalisent les flux d’identité, ainsi que Private State Tokens (qui permettent la transmission de la confiance en l’authenticité d’un utilisateur d’un contexte à un autre).

L’avenir incertain des technologies Privacy Sandbox déjà déployées

Pour les entreprises ayant déjà mis en œuvre les technologies Privacy Sandbox au sein de leurs propres organisations, aucune précision n’a été apportée concernant une éventuelle continuité de service et support associé. « Nous poursuivrons nos efforts pour améliorer la confidentialité sur Chrome, Android et le Web, mais nous abandonnerons la solution Privacy Sandbox. Nous sommes reconnaissants à tous ceux qui ont contribué à cette initiative et nous continuerons à collaborer avec le secteur pour développer et faire progresser les technologies de plateforme qui contribuent à soutenir un Web sain et prospère », a indiqué un porte-parole de Google.

Il est peu probable que la décision relative à la Privacy Sandbox ait un effet notable sur la domination de Google sur le marché des navigateurs. Selon Statcounter, Chrome détenait 72 % des parts du marché des navigateurs en septembre. Cependant, les tentatives de Google d’imposer les technologies Privacy Sandbox dans les futures normes web sont abandonnées. Comme l’a déclaré M. Malik, « la normalisation est possible, mais uniquement si elle est légitimée par toutes les parties prenantes. Sans l’adhésion générale des navigateurs, des régulateurs et des éditeurs, les normes web risquent de ressembler à des normes propriétaires ».

Avec Data Express Service conçu en collaboration avec Oracle, Riberbed promet de transférer des ensembles de données de l’ordre du pétaoctet 10 fois plus rapidement que les méthodes traditionnelles.

Développée en partenariat avec Oracle, l’offre SaaS Data Express Service, récemment dévoilée par Riverbed, s’attaque au défi du transfert rapide et sécurisé des ensembles de données volumineux. Annoncé lors de l’Oracle CloudWorld 2025 organisé du 13 au 16 octobre au Venetian Conference and Expo Center de Las Vegas, Data Express Service repose sur Oracle Cloud Infrastructure (OCI) et devrait permettrede transférer des données de l’ordre du pétaoctet jusqu’à 10 fois plus rapidement que les solutions actuelles, ce qui, selon Riverbed, réduirait le temps nécessaire au transfert des données de plusieurs mois à quelques jours. « Le transfert de quantités massives de données vers une infrastructure d’IA dédiée peut prendre jusqu’à six semaines, retardant de plusieurs mois la mise en service des projets d’IA », a expliqué Chalan Aras, vice-président senior et directeur général de la division Acceleration de Riverbed. « Les données obsolètes réduisent la précision des modèles et la valeur commerciale, et peuvent faire perdre à une entreprise l’avantage d’être la première sur le marché. »

Le service peut transférer jusqu’à 1 pétaoctet de données par jour, ce qui, selon M. Aras, est jusqu’à 45 % moins coûteux que les autres approches, selon le type de données. « Par exemple, des secteurs comme les services financiers et la santé génèrent entre 1 To et 100 To de données par jour, ce qui pose un défi permanent de gestion des données », a expliqué Riverbed. « Ce service peut aider nos clients à surmonter l’un des principaux obstacles à l’adoption de l’IA : l’acheminement des bonnes données au bon endroit, avec une vitesse et une sécurité inégalées dans le secteur », a affirmé Dave Donatelli, CEO de Riverbed, dans un communiqué. « Nous voulons continuer à aider nos clients à maximiser leur retour sur investissement dans l’IA. »

La sécurité post-quantique en renfort

Selon l’étude mondiale 2025 Global AI Research de Riverbed, 75 % sur les 1 200 entreprises interrogées qui prévoient de mettre en place une stratégie de stockage des données d’IA, 90 % considérent le transfert de données comme essentiel à la réussite de leur IA. L’étude révèle également que seul un projet d’IA sur dix dépasse le stade pilote pour être déployé à l’échelle de l’entreprise, souvent en raison de problèmes de qualité des données et de lenteur du transfert de données. « Les clients cherchent des moyens plus rapides et plus sûrs de transférer des ensembles de données volumineux afin de pouvoir concrétiser leurs initiatives d’IA », a renchéri Sachin Menon, vice-président de l’ingénierie cloud chez Oracle, dans un communiqué. « Grâce au déploiement de Riverbed Data Express Service sur OCI, ils pourront accélérer le retour sur investissement, réduire les coûts et garantir la protection de leurs données. »

M. Aras, de Riverbed, a précisé que le service Data Express utilisait la cryptographie post-quantique (PQC) pour transférer des ensembles de données de l’ordre du pétaoctet via des tunnels VPN sécurisés afin de garantir la protection des données des clients pendant le processus de transfert. Cette technologie repose sur la plateforme d’accélération SteelHead de Riverbed, qui utilise le logiciel RiOS 10. « Grâce à des instances de transfert de données hautement performantes, à la parallélisation des instances et à des configurations réseau adaptées, notre technologie optimisée pour le cloud offre des performances nettement supérieures de récupération, de transfert et d’écriture des données sur le réseau. La conception est adaptée à chaque cloud afin de garantir des performances maximales grâce à des ajustements spécifiques au produit », a indiqué M. Aras. « Le moment est venu de prévenir le « harvest-now, decrypt-later » (collecter maintenant, décrypter plus tard) », a ajouté M. Aras, en référence à la menace de sécurité qui consiste à intercepter et à stocker des données cryptées en vue de leur décryptage ultérieur, lorsque les ordinateurs quantiques seront suffisamment puissants. Le service Riverbed répond à des cas d’usage allant de la formation de modèles d’IA aux opérations d’inférence, en passant par les nouvelles applications d’IA agentique.

Dans un premier temps, Data Express sera déployé sur Oracle Cloud Infrastructure, mais Riverbed a précisé que le service orchestrera le mouvement des données entre AWS, Azure et Google Cloud Platform, ainsi que dans les centres de données sur site. La disponibilité générale de Data Express Service est prévue avant la fin de cette année.

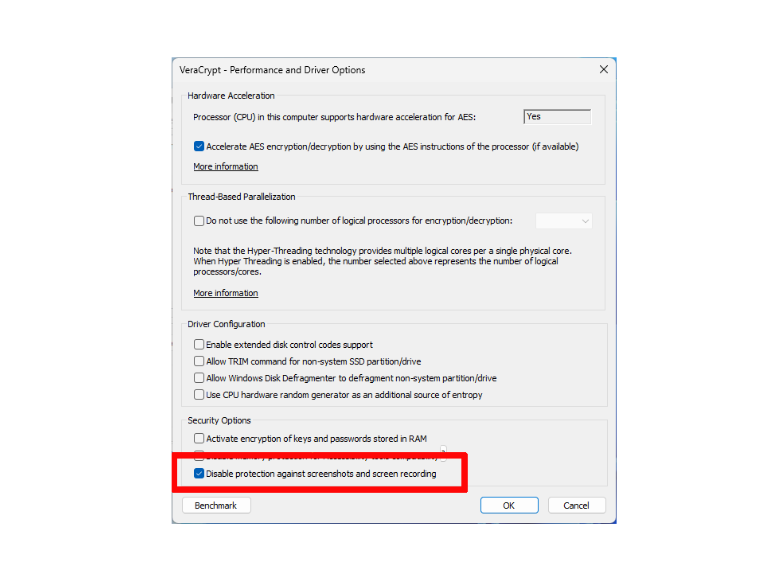

Même si Microsoft a encore amélioré la sécurité de cette fonctionnalité, des inquiétudes subsistent quant à la protection des données. L’utilitaire Veracrypt d’Idrix permet d’éviter tout risque indésirable de capture d’écran.

La fonctionnalité – controversée – Windows Recall prend des captures d’écran du contenu de l’écran des PC Copilot à intervalles réguliers et les enregistre sur le PC local. Les utilisateurs peuvent ainsi rechercher spécifiquement des images, des textes et des sites web qu’ils ont chargés dans le passé. Veracrypt, développé par la société française Idrix, peut empêcher ces captures et renforcer la confidentialité, tout en laissant à l’utilisateur la possibilité de désactiver ce blocage à tout moment.

Les améliorations successives de la sécurité de la fonctionnalité Windows Recall n’ont pas suffi pour rassurer sur la protection des données. En partie à cause de Recall, mais en raison aussi des dangers liés aux programmes de capture d’écran cachés en général, les développeurs du logiciel de chiffrement Veracrypt ont ajouté une nouvelle fonction de protection avec la mise à jour vers la version 1.26.24. Par défaut, cette nouvelle fonctionnalité empêche le logiciel de Microsoft de prendre des captures d’écran. Toute personne ou tout programme qui tente de le faire n’obtiendra qu’une image de l’arrière-plan.

Il est possible de désactiver la protection contre les enregistrements d’écran dans Veracrypt. Attention : le nouveau paramètre ne prend effet qu’après le redémarrage de Windows. (Crédit : Roland Feist)

Si l’on veut une capture d’écran de Veracrypt, il est nécessaire de désactiver au préalable cette protection. Pour ce faire, il faut cliquer sur « Performances et options du pilote » (Performance and Driver Options) dans le menu « Paramètres » et cocher la case de la rubrique « Désactiver la protection contre les captures d’écran et l’enregistrement d’écran » (Disable protection against screenshots and screen recording). Confirmer la mise en garde et la note de redémarrage en cliquant sur OK. Ensuite, fermer la fenêtre avec OK, puis redémarrer Windows et relancer Veracrypt pour la prise en compte des nouveaux paramètres.

Lors de l’événement Goldman Sachs Communacopia + Technology, Zoom et Twilio ont dévoilé des assistants vocaux plus réactifs et naturels, visant à rendre les échanges plus clairs et fluides.

Les assistants vocaux hésitants, les silences gênants et les erreurs de compréhension appartiendront bientôt au passé. C’est du moins la promesse des dirigeants de Zoom et Twilio, convaincus que la voix IA vit enfin sa mue technologique. Lors de la conférence Goldman Sachs Communacopia + Technology (le 8 septembre 2025 à San Francisco), les deux groupes ont évoqué des progrès majeurs qui lèvent peu à peu les freins à son adoption. Chez Twilio, le CEO Khozema Shipchandler observe un changement de perception : les utilisateurs préfèrent désormais échanger avec des agents vocaux dans certains contextes, notamment en santé. « Les conversations gagnent en fluidité. Les silences ou malaises propres aux échanges humains disparaissent », explique-t-il. Autre évolution notable : la latence, longtemps considérée comme un point faible, serait aujourd’hui quasiment effacée. Chez Zoom, le CEO Eric Yuan met lui aussi en avant des progrès importants. L’entreprise a développé AI Companion, un assistant vocal multilingue aux intonations plus naturelles. L’objectif : éliminer les pauses artificielles et renforcer la fluidité des conversations.

Une technologie encore perfectible

Sur le terrain, tout n’est pas encore au point. Plusieurs chaînes de restauration rapide, dont McDonald’s et Taco Bell, ont suspendu leurs tests de commande vocale au drive, l’IA peinant encore à comprendre certains accents ou bruits de fond. Pour Jack Gold, analyste principal chez J. Gold Associates, la difficulté vient de la variabilité du langage : « Même dans une seule langue comme l’anglais, les accents et les intonations diffèrent énormément. »

Malgré ces limites, le potentiel reste immense. Dans la livraison de repas, 35 % des commandes passent encore par téléphone. L’IA vocale pourrait fluidifier ces échanges et accélérer la prise de commande. « Sa capacité est illimitée », estime Khozema Shipchandler. De plus, la voix constitue un moyen naturel pour obtenir des informations, car tout le monde ne maîtrise pas parfaitement la saisie au clavier, note Jack Gold.

Déploiement et sécurité

L’usage de la voix gagne aussi le grand public. De plus en plus d’utilisateurs dialoguent désormais à voix haute avec ChatGPT, signe que la voix devient un mode d’interaction privilégié. « D’ici deux ou trois ans, de nombreuses solutions reposeront sur cette technologie », anticipe Eric Yuan.

Reste à gérer la question sensible de la sécurité. Les risques d’usurpation de voix se multiplient, poussant les acteurs du secteur à développer des systèmes de reconnaissance vocale et de vérification rapide des identités. Zoom collabore d’ailleurs avec des experts en cybersécurité pour encadrer le déploiement de ses IA. Pour Jack Gold, l’évolution est inévitable : « À mesure que les modèles s’enrichiront de meilleures données, les erreurs s’effaceront progressivement. La voix IA entre dans une phase de maturité accélérée. »

Selon une source impliquée dans une intervention survenue en août dernier, un acteur étranger malveillant s’est infiltré dans le Kansas City National Security Campus (KCNSC), un site de fabrication clé du département américain de la sûreté nuclaire. Une intrusion rendue possible par l’exploitation de failles Microsoft SharePoint non corrigées.

Une intrusion sur un site de fabrication d’armes nucléaires américain soulève des questions quant à la nécessité de renforcer les mesures de sécurité informatique et opérationnelle au niveau fédéral. La violation en question – qui remonte – au mois d’août 2025, visait une usine installée sur le Kansas City National Security Campus (KCNSC). Ce dernier produit la grande majorité des composants non nucléaires essentiels pour les armes nucléaires américaines sous l’égide de…

Il vous reste 96% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

Une enquête menée par Akamai montre que 60 % des entreprises réduisent leurs coûts d’assurance cyber grâce à une segmentation très fine de leur réseau.

La segmentation du réseau est une pratique exemplaire en matière de sécurité depuis des décennies, mais pour de nombreuses raisons, tous les déploiements n’ont pas pleinement adopté l’approche de la microsegmentation. Avec des attaques par rançongiciels de plus en plus sophistiquées et des cyberassureurs qui accordent une attention accrue à l’architecture réseau, la microsegmentation passe du statut d’option intéressante à celui d’impératif commercial. Une dernière étude d’Akamai s’est penchée sur la manière dont les entreprises abordent son adoption, les défis liés à sa mise en œuvre et les avantages concrets qu’elles en tirent. Les résultats font ressortir un écart important entre la sensibilisation et la mise en œuvre, mais montrent également des incitations financières et opérationnelles claires pour les équipes réseau disposées à effectuer la transition.

Les principales conclusions de cette étude pour laquelle 1 200 responsables de la sécurité et IT à travers le monde ont été interrogés sont les suivantes :

– 35 % des entreprises ont mis en œuvre la microsegmentation dans leur environnement réseau, alors que 90 % ont adopté une forme de segmentation ;

– Les entreprises dont le chiffre d’affaires dépasse 1 Md$ ont vu le temps de confinement des ransomwares réduit de 33 % après avoir mis en œuvre la microsegmentation ;

– 60 % des entreprises ont bénéficié de primes d’assurance moins élevées grâce à la maturité de leur segmentation ;

– 75 % des assureurs évaluent désormais la posture de segmentation lors de la souscription ;

– Les principaux obstacles à l’adoption demeurent la complexité du réseau (44 %), les lacunes en matière de visibilité (39 %) et la résistance opérationnelle (32 %) ;

– La moitié des entreprises qui n’ont pas encore adopté la microsegmentation prévoient de le faire dans les deux ans, tandis que 68 % des utilisateurs actuels envisagent d’augmenter leurs investissements.

« Je pense que la plus grande surprise dans ces données est l’efficacité de la microsegmentation lorsqu’elle est utilisée comme outil pour contenir les violations », a fait savoir à Network World Garrett Weber, field directeur technique pour la sécurité d’entreprise chez Akamai. « Nous considérons souvent la segmentation comme une solution à configurer une fois pour toutes, mais la microsegmentation, qui place les points de contrôle au niveau des charges de travail elles-mêmes, offre aux entreprises la possibilité de contenir rapidement les violations. »

Pourquoi la segmentation traditionnelle ne suffit pas

La microsegmentation applique des politiques de sécurité au niveau de chaque charge de travail ou application plutôt qu’au niveau du périmètre réseau ou entre de grandes zones réseau. M. Weber a mis au défi les administrateurs réseau qui estiment que leur segmentation nord-sud actuelle est adéquate. « Je les mettrais au défi d’essayer réellement d’évaluer et de comprendre la capacité des attaquants à se déplacer latéralement au sein des segments qu’ils ont créés », a-t-il déclaré. « Ils trouveront sans aucun doute un chemin à partir d’un serveur web, d’un terminal IoT ou d’un système vulnérable qui permettra à un attaquant de se déplacer latéralement et d’accéder à des informations sensibles au sein de l’environnement. » Les données corroborent cette évaluation. Les entreprises qui ont mis en œuvre la microsegmentation ont signalé de multiples avantages au-delà de la limitation des ransomwares. Il s’agit notamment de la protection des actifs critiques (74 %), d’une réponse plus rapide aux incidents (56 %) et d’une protection contre les menaces internes (57 %).

Mythes et idées reçues sur la microsegmentation

Le rapport détaille plusieurs raisons pour lesquelles les entreprises n’ont pas correctement déployé la microsegmentation. La complexité du réseau arrive en tête des obstacles à la mise en œuvre (44 %), mais M. Weber remet en question la légitimité de cet obstacle. « De nombreuses entreprises estiment que leur réseau est trop complexe pour la microsegmentation, mais lorsque nous examinons leur infrastructure et la manière dont les applications sont développées et déployées, nous constatons généralement que les solutions de microsegmentation sont mieux adaptées aux réseaux complexes que les approches de segmentation traditionnelles », explique M. Weber. « On pense souvent à tort que les solutions de microsegmentation dépendent d’une plateforme de virtualisation ou ne peuvent pas prendre en charge divers déploiements cloud ou Kubernetes, mais les solutions de microsegmentation modernes sont conçues pour simplifier la segmentation du réseau dans des environnements complexes. » Une autre idée fausse courante est que la mise en œuvre de telles solutions aura un impact sur les performances des applications et pourrait entraîner des pannes en raison d’une mauvaise création de politiques. « Les solutions de microsegmentation modernes sont conçues pour minimiser les impacts sur les performances et fournir les workflows et les expériences utilisateur appropriés pour mettre en œuvre en toute sécurité des politiques de sécurité à grande échelle », explique M. Weber.

Des bénéfices pour les usages métiers

L’assurance cyber est apparue comme un facteur inattendu favorisant l’adoption de la microsegmentation. Le rapport indique que 85 % des sociétés qui l’utilisent trouvent les rapports d’audit plus faciles à réaliser. Parmi celles-ci, 33 % ont déclaré avoir réduit les coûts liés à l’attestation et à l’assurance. Plus important encore, 74 % estiment qu’une segmentation plus forte augmente les chances d’obtenir l’approbation d’une demande d’indemnisation. Pour les équipes réseau ayant du mal à justifier l’investissement auprès de la direction, l’angle de l’assurance peut offrir des avantages financiers concrets : 60 % des répondants ont déclaré avoir bénéficié de réductions de primes grâce à l’amélioration de leur posture de segmentation. Au-delà des économies réalisées sur les assurances et d’une réponse plus rapide aux ransomwares, M. Weber recommande aux administrateurs réseau de suivre plusieurs indicateurs de performance opérationnelle afin de démontrer la valeur ajoutée continue. La réduction de la surface d’attaque des applications ou des environnements critiques peut fournir une mesure claire de la posture de sécurité. Les équipes doivent également surveiller les ports et les services couramment utilisés à des fins malveillantes, tels que SSH et Remote Desktop. L’objectif est de suivre la part de ce trafic qui est analysée et contrôlée par la politique. Pour les entreprises qui intègrent la microsegmentation dans leurs playbooks SOC, le temps nécessaire à l’identification et au confinement des violations peut offrir une mesure directe de l’amélioration de la réponse aux incidents.

L’IA comme facilitateur d’adoption

En 2025, aucune conversation technologique ne peut être complète sans mentionner l’IA. Pour sa part, Akamai investit dans ce domaine afin d’améliorer l’expérience utilisateur grâce à la microsegmentation. M. Weber a souligné trois domaines spécifiques dans lesquels elle améliore l’expérience en la matière. Premièrement, l’IA peut identifier et étiqueter automatiquement les charges de travail. Pour ce faire, elle analyse les modèles de trafic, les processus en cours d’exécution et d’autres points de données. Cela élimine le travail de classification manuelle. Deuxièmement, l’IA aide à recommander des politiques de sécurité plus rapidement et avec plus de précision que la plupart des administrateurs réseau et des propriétaires d’applications ne peuvent le faire manuellement. Cette capacité aide les organisations à mettre en œuvre des politiques à grande échelle. Troisièmement, le traitement du langage naturel par les assistants IA aide les utilisateurs à exploiter et à comprendre la quantité importante de données collectées par les solutions de microsegmentation. Cela fonctionne quel que soit leur niveau d’expérience avec la plateforme.

Des étapes de mise en œuvre

Selon l’enquête, 50 % des entreprises n’ayant pas encore adopté la microsegmentation prévoient de la mettre en œuvre d’ici deux ans. Pour celles qui souhaitent l’implémenter efficacement, le rapport présente quatre étapes clés :

– S’appuyer sur une visibilité approfondie et continue en cartographiant les charges de travail, les applications et les modèles de trafic en temps réel afin de mettre en évidence les dépendances et les risques avant de concevoir des politiques ;

– Concevoir des politiques au niveau de la charge de travail en appliquant des contrôles précis qui limitent les mouvements latéraux et appliquent les principes du zero trust dans les environnements hybrides et cloud ;

– Simplifier le déploiement grâce à une architecture évolutive en adoptant des solutions intégrant la segmentation dans l’infrastructure existante sans nécessiter une refonte complète du réseau ;

– Renforcer la gouvernance et l’automatisation en alignant la segmentation sur les opérations de sécurité et les objectifs de conformité, en utilisant l’automatisation pour soutenir l’application et accélérer la maturité.

Un correctif de sécurité critique publié dans la mise à jour cumulative d’octobre de Microsoft fait dysfonctionner des environnements de développement dans Windows 11. Les entreprises sont tiraillées entre rollbacks et remise en question du processus d’assurance qualité du fournisseur.

Alors que Windows 10 arrive en fin de vie, les problèmes avec Windows 11 abondent. Dernier exemple en date : une mise à jour a désactivé localhost pour certains développeurs, les empêchant d’accéder aux applications web fonctionnant localement sur leurs machines. La mise à jour cumulative d’octobre 2025 (KB5066835) a corrigé des problèmes de sécurité dans les systèmes d’exploitation Windows, mais semble également avoir bloqué la capacité de l’OS à communiquer avec des processus internes. Localhost permet aux applications et aux services de s’échanger des informations sans utiliser Internet ou un réseau externe. Les programmeurs utilisent cette fonction pour concevoir, tester et déboguer des sites web et des applications localement sur une machine Windows avant de les mettre à la disposition du public. « Pour tous ceux qui développent des logiciels, c’est énorme », a déclaré David Shipley co-fondateur et CEO de Beauceron Security.

Le problème a été largement signalé sur les forums d’assistance de la firme de Redmond ainsi que sur d’autres sites de codeurs tels que Stack Overflow et Stack Exchange. La société a confirmé l’existence du bogue ; une page mise à jour sur l’état de santé des versions Windows décrit le problème et propose des solutions pour y remédier.

Des mesures d’atténuations pour sortir de l’impasse

KB5066835 est une mise à jour cumulative d’octobre 2025 pour les versions 24H2 et 25H2 de Windows 11. Elle a été précédée par une mise à jour préliminaire, KB5065789, publiée le 29 septembre 2025, qui corrigeait des problèmes tels que l’aperçu avant impression dans les navigateurs basés sur Chromium, les délais d’attente des commandes affectant l’audit dans PowerShell Remoting et Windows Remote Management (WinRM), et les messages d’erreur persistants dans la configuration de Windows Hello. Les développeurs ont également signalé quelques problèmes inattendus, notamment des échecs de connexion et des problèmes de protocole HTTP/2 affectant divers outils de développement tels que ASP.NET et Visual Studio.

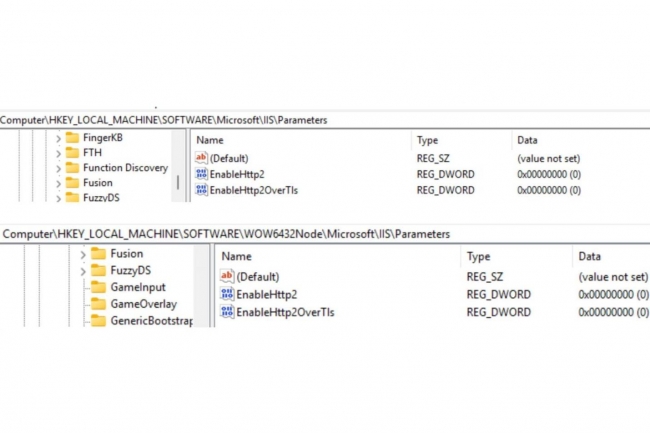

Certains développeurs ont réussi à contourner ces problèmes importants en désinstallant le package KB5066835, en redémarrant leur ordinateur, puis en suspendant les mises à jour Windows afin qu’il ne soit pas réinstallé automatiquement. D’autres, cependant, ont signalé sur des forums en ligne que leurs tentatives de désinstallation du patch KB5066835 avaient échoué et qu’ils avaient dû supprimer à la place le package précédent KB5065789 de septembre. Si aucune de ces tactiques ne fonctionnait, les utilisateurs suggéraient d’ouvrir les fonctionnalités Windows et de désactiver Hyper-V, IIS, le service d’activation des processus Windows et .NET Framework 3.5 et 4.8. L’éditeur a répondu en attribuant le problème à « diverses conditions », notamment la connectivité Internet et le « moment de l’installation de la mise à jour récente et du redémarrage des appareils », et affirme qu’il est possible qu’il ne soit pas observé du tout dans certains environnements.

La solution proposée consiste à utiliser la fonctionnalité Known Issue Rollback pour supprimer les mises à jour incriminées. Ce problème sera résolu automatiquement pour les systèmes grand public et professionnels non managés, et peut être déployé à l’aide d’une stratégie de groupe spéciale dans les entreprises. La société a également suggéré d’essayer les étapes suivantes : Ouvrez « Windows Update » dans l’application « Paramètres Windows ». Cliquez sur « Rechercher les mises à jour » et autorisez l’installation de toutes les mises à jour. Redémarrez l’appareil (même si aucune mise à jour n’a été installée à l’étape précédente). « Nous travaillons à la publication d’une solution à ce problème dans une prochaine mise à jour Windows », a déclaré Microsoft. « Nous vous tiendrons informés dès que nous aurons plus d’informations. »

Des perturbations et des frustrations

« Cela affecte le développement local ainsi que les applications métiers », a écrit un utilisateur sur un forum hébergé par Microsoft. Il a signalé que lorsque la mise à jour est supprimée, « tout fonctionne à nouveau ». La connexion localhost est un élément « fondamental » de Windows sur lequel les développeurs et les entreprises s’appuient discrètement chaque jour, a expliqué Erik Avakian, consultant chez Info-Tech Research Group. « Localhost sert en quelque sorte de colonne vertébrale pour la conception et le test de nombreuses applications modernes. » Lorsque localhost cesse de fonctionner, l’ensemble des environnements de développement d’applications peut être affecté, voire paralysé, entraînant la défaillance des processus et services internes et l’interruption de la communication, a-t-il souligné. Cela signifie que les développeurs ne peuvent plus tester ou exécuter d’applications web localement.

Ce problème empêche les développeurs de réaliser des débugs en local pouvant faire échouer leurs processus de tests automatisés. Dans le même temps, les services informatiques doivent résoudre les problèmes, traiter un afflux de tickets de support, restaurer les correctifs et rechercher des solutions de contournement. « Ce bogue est suffisamment perturbateur pour entraîner des retards, une perte de productivité et de la frustration au sein des équipes », a déclaré M. Avakian. « Tout cela se traduit par une perte financière réelle en termes de temps de travail des utilisateurs et de perturbation des processus métier. »

Des pertes sèches de productivité pour les développeurs

En termes d’impact économique, les développeurs de logiciels ont peut-être perdu chacun entre une demi-journée et une journée, voire plus, à cause de ce problème, a fait remarquer M. Shipley. « Cela s’additionne rapidement », a-t-il déclaré. Il est même allé jusqu’à dire que, selon le nombre de développeurs touchés dans le monde, ce bug pourrait avoir un impact aussi important que la panne généralisée de CrowdStrike en juillet 2024, qui avait interrompu les vols et mis temporairement hors ligne des millions d’entreprises. « Si les gens annulent cette mise à jour, qui comprend des correctifs de sécurité, pour des cibles de grande valeur comme les développeurs, cela crée un risque énorme », a déclaré M. Shipley. « Demander aux développeurs de renoncer aux correctifs automatiques et de revenir à l’ancienne approche consistant à attendre quelques semaines avant d’appliquer les correctifs est beaucoup plus dangereux aujourd’hui, compte tenu de la vitesse à laquelle le développement des vulnérabilités basées sur l’IA fonctionne désormais » a-t-il souligné. « J’aimerais beaucoup voir une analyse rétrospective sur la façon dont ce désastre s’est produit et savoir si un mauvais code ou des tests AI ont joué un rôle dans cette affaire ».

Selon M. Avakian, ce type de problème souligne l’importance du contrôle qualité et des tests approfondis effectués par des fournisseurs et des distributeurs tiers avant la mise sur le marché des mises à jour. Ne pas le faire peut avoir des répercussions importantes en aval et éroder la confiance dans le processus de mise à jour, tout en rendant les équipes plus prudentes en matière de correctifs. « Localhost est vraiment l’un des éléments les plus fondamentaux de la pile réseau Windows », a déclaré M. Avakian. « Un élément aussi fondamental ne devrait pas passer inaperçu lors des tests des mises à jour. » Et de souligner que cette situation rappelle également aux équipes IT qu’il est important de tester d’abord les mises à jour dans des environnements de test, de tester divers processus métier critiques dans toute l’entreprise à chaque itération de mise à jour et de créer des runbooks avec des plans de restauration et des dépendances qui correspondent aux processus métier. « Lorsque ces perturbations se multiplient sur des dizaines ou des centaines de machines de développement, cela peut entraîner un coût élevé en termes de temps, de retards et de coordination des équipes informatiques », prévient M. Avakian.