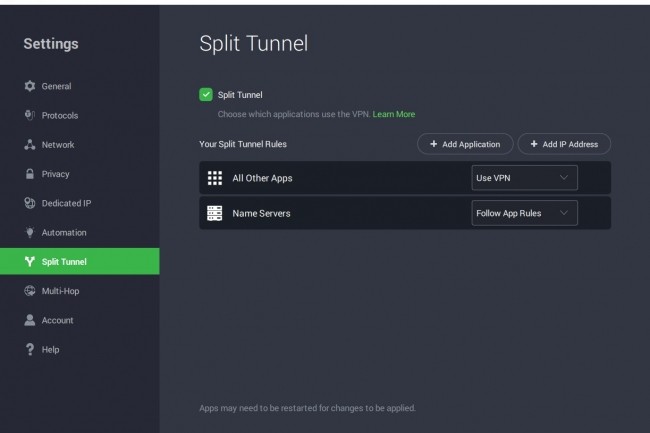

Souvent mise en avant dans les VPN, cette fonction permet à l’utilisateur de choisir quand il veut conserver son anonymat.

Un réseau privé virtuel ou VPN est l’un des meilleurs moyens de renforcer la vie privée en ligne. Non seulement il dissimule l’adresse IP de l’utilisateur et ses activités aux regards indiscrets, mais il crypte également la connexion pour mieux la sécuriser. Malheureusement, le VPN a aussi des inconvénients. En particulier, il ralentit la vitesse d’accès à Internet et limite certaines fonctionnalités locales. Heureusement, une fonction VPN appelée « split tunneling » peut…

Il vous reste 92% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

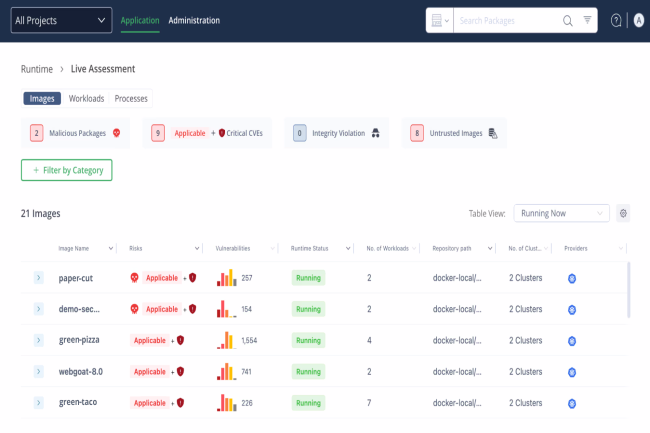

JFrog Runtime Security s’intègre à Artifactory pour identifier la source et le propriétaire des paquets vulnérables et prioriser la remédiation.

Avec l’ajout du composant JFrog Runtime à sa plateforme de sécurité du cycle de développement logiciel et devsecops, JFrog veut sécuriser les applications en production exécutées dans des conteneurs. « Présenté le 10 septembre, Runtime s’intègre à Artifactory pour permettre aux équipes de devops et de sécurité d’identifier facilement la source et le propriétaire d’un paquet vulnérable et de déterminer le moyen le plus rapide et le plus efficace d’atténuer les risques », a expliqué JFrog.

La technologie surveille les clusters Kubernetes, identifie et remédie aux vulnérabilités, et garantit l’intégrité des images en production. Runtime, qui s’appuie sur la plateforme JFrog, offre une visibilité en temps réel sur les vulnérabilités et les risques liés à l’exécution et automatise les contrôles d’intégrité pour garantir que des images fiables sont exécutées en production. Des fonctions de triage et de hiérarchisation accélèrent aussi la remédiation aux vulnérabilités critiques.

Hiérarchiser les risques

Selon l’éditeur, la sécurisation d’une application en cours d’exécution est une tâche complexe. « Les entreprises peuvent avoir du mal à maintenir une visibilité en temps réel sur les vulnérabilités d’exécution, à gérer et à hiérarchiser les risques, et à assurer l’intégrité du déploiement », a avancé JFrog. L’objectif est d’identifier les vulnérabilités et d’y remédier tout en minimisant l’impact sur l’entreprise et en assurant le suivi des composants d’exécution.

Les principales caractéristiques et avantages de JFrog Runtime sont :

– Une visibilité en temps réel des vulnérabilités dans l’environnement d’exécution.

– Une accélération du triage et de la hiérarchisation des incidents de sécurité.

– Une réduction des risques grâce à la gestion de l’exposition.

– Une protection des charges de travail basées sur le cloud, afin de protéger les applications contre les violations de données ou les accès non autorisés.

– Une analyse des clusters Kubernetes.

– Une sensibilisation centralisée aux incidents.

Selon JFrog, les utilisateurs de Runtime peuvent savoir qui a téléchargé un paquet sur Artifactory, son propriétaire, son statut de déploiement et les risques applicables. Ils peuvent identifier les charges de travail affectées dans un environnement et prévoir la solution pour remédier aux vulnérabilités.

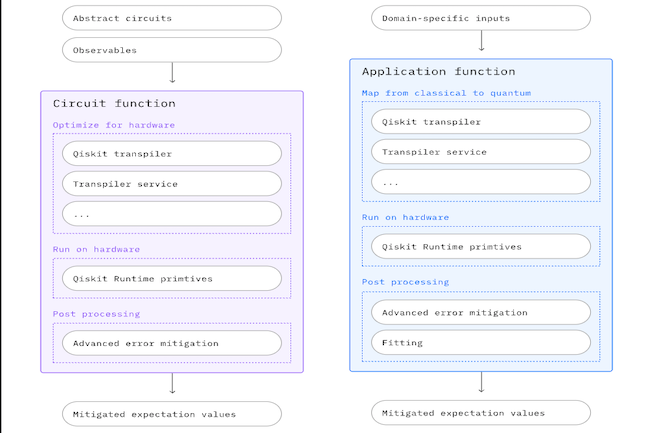

La série de services Quiskit Functions Catalog annoncée hier par IBM vise à rendre l’expérimentation des cas d’usage de l’informatique quantique plus facile aux développeurs d’entreprise.

Même si nous sommes encore à des années de l’ordinateur quantique pratique, l’humeur était à l’optimisme parmi les grands chercheurs, investisseurs et responsables gouvernementaux du monde entier venus la semaine dernière (9 au 11 septembre) à Washington pour participer au troisième congrès annuel Quantum World Congress. Des annonces importantes ont été faites dans les domaines de l’informatique quantique, de la mise en réseau quantique et de l’investissement. IBM, Microsoft et Boeing (voir notre sujet du 11 septembre) avaient tous des annonces importantes à faire, et certains signes indiquent que l’industrie pourrait entrer dans une nouvelle phase de développement.

Percées de l’informatique quantique

« Pendant la majeure partie de l’histoire de l’informatique quantique, la quasi-totalité de la recherche s’est concentrée sur le développement du matériel sous-jacent », a expliqué Jay Gambetta, vice-président chargé de l’initiative quantique d’IBM. Mais l’aspect logiciel est encore plus important lorsqu’il s’agit d’applications d’entreprise réelles. Ainsi, IBM a annoncé ce qui s’apparente à une sorte de magasin d’applications pour les logiciels quantiques. Six fonctions sont aujourd’hui disponibles dans le catalogue de fonctions Quiskit Functions Catalog de big blue et de ses partenaires. Quatre de ces fonctions font abstraction de la gestion des performances et améliorent la correction des erreurs et les performances. Deux rendent inutiles la compréhension des circuits quantiques, l’une dans l’espace d’optimisation et l’autre dans le domaine de la chimie. « C’est un tremplin vers des bibliothèques et un futur magasin d’applications », a ajouté M. Gambetta.

Désormais, les personnes spécialisées dans des domaines d’activité spécifiques peuvent commencer à expérimenter l’informatique quantique sans avoir besoin d’être elles-mêmes des scientifiques quantiques. « Cette accessibilité des domaines quantiques accélère la course à la recherche d’applications utiles ». M. Gambetta a rappelé que depuis 2016, IBM mettait l’informatique quantique à la disposition de ses clients, via le cloud, et que des centaines d’institutions utilisaient sa plateforme. « Nous allons nous concentrer sur la construction de la plateforme et nous voulons que tous les innovateurs et les start-ups s’impliquent dans la découverte d’algorithmes », a-t-il poursuivi. « Jusqu’à cette annonce, je ne pensais pas que c’était vraiment faisable, mais je crois aujourd’hui que nous disposerons de cas d’entreprise dans les prochaines années », a-t-il reconnu.

1000 qubits pour exécuter toutes les tâches

De son côté, Microsoft a aussi affirmé qu’elle disposait de la plateforme d’informatique quantique la plus fiable au monde. « La plateforme Azure Quantum Compute va plus loin que le service Azure Quantum Service et réunit plus de qubits logiques et une informatique quantique plus fiable », a ainsi affirmé Krysta Svore, vice-présidente chez Microsoft chargée du développement quantique avancé. La semaine dernière, lors du Quantum World Congress, Microsoft a annoncé un partenariat avec Continuum pour créer 12 qubits logiques, ce qui, selon Krysta Svore, est le plus grand nombre de qubits logiques jamais enregistré. Quantinuum a fourni le matériel quantique et Microsoft s’est chargé de la correction des erreurs. Certes, ces ordinateurs quantiques sont encore trop petits pour faire ce que ne peuvent pas faire les ordinateurs classiques, mais ils peuvent déjà permettre aux entreprises d’expérimenter des cas d’usage et de tester des algorithmes. « Nous sommes entrés dans l’ère de l’informatique quantique fiable », a-t-elle avancé.

Selon Mme Svore, il faudra environ 100 qubits logiques fiables pour effectuer des calculs scientifiquement utiles, et environ 1 000 qubits logiques pour disposer d’un ordinateur quantique polyvalent capable d’exécuter des tâches qui ne sont pas à la portée des ordinateurs classiques. « Nous avons aussi fait une démonstration – la première au monde – d’un flux de travail hybride intégré entre Azure HPC, les qubits logiques et l’IA », s’est-elle félicitée. C’est une étape importante, car le traitement quantique, comme les GPU, ne remplacera probablement pas des ordinateurs entiers, mais agira plutôt comme un accélérateur, en prenant par exemple en cas de besoin le relais pour résoudre des problèmes autrement insolubles. À l’instar de M. Gambetta d’IBM, Mme Svore estime que l’avantage quantique devrait être atteint avant 2030.

Qubits logiques contre qubits physiques

Ce qui est particulièrement intéressant, c’est que l’ordinateur de 12 qubits annoncé la semaine dernière est trois fois plus grand que les quatre qubits logiques du mois d’avril et, surtout, que le nombre de qubits physiques est passé de 30 à 56. Cela signifie que le nombre de qubits logiques a augmenté beaucoup plus rapidement que le nombre de qubits physiques sous-jacents requis. « Nous constatons une croissance continue du nombre de qubits logiques », a fait remarquer Jennifer Strabley, vice-présidente et directrice générale de Quantinuum. « Les performances des qubits logiques sont meilleures que celles des qubits physiques sous-jacents ». Celle-ci pense également que 2029 sera le point de bascule pour les applications commerciales de l’informatique quantique. Étant donné que l’une de ces applications potentielles consiste à casser le cryptage existant, l’annonce par le NIST de normes de chiffrement à l’épreuve des quanta, en août dernier, ne pouvait pas mieux tomber.

Selon Chirag Dekate, analyste chez Gartner, il est logique que les entreprises qui se concentrent sur la recherche et le développement tirent parti d’une plateforme combinant l’informatique quantique avec l’informatique à haute performance et l’intelligence artificielle. « Pour elle, la question est de savoir si elles veulent innover ou rester sur la touche. La combinaison de l’IA et du calcul haute performance leur permet d’explorer un espace de conception plus large, dans la santé, les services financiers, la fabrication et au-delà. Et elles commencent à identifier les points d’inflexion où l’informatique classique n’apporte plus rien et où l’informatique quantique devient un avantage », a-t-il expliqué. « Les entreprises s’associent à des fournisseurs de plateformes quantiques comme Microsoft, IBM et Amazon », a-t-il ajouté. « Elles mettent la main sur ces systèmes et explorent ce qu’il faut pour développer des applications dans un contexte quantique. C’est un véritable défi, mais il s’agit d’activités réelles auxquelles participent les chercheurs et les entreprises ».

Elargir le périmètre du quantique

Jennifer Addie, experte en investissements quantiques, directrice de l’exploitation du consultant VentureScope et directrice de la stratégie chez MACH37, un programme d’accélération cyber, se réjouit de l’annonce de Microsoft. « Pour ceux qui suivent les évolutions, les progrès sont significatifs et plus rapides que ce à quoi s’attendaient la plupart des gens », a-t-elle fait remarquer. « Pendant longtemps, beaucoup ont pensé que les ordinateurs quantiques étaient encore loin et que les entreprises avaient tout le temps de se préparer. Or, ce moment est plus proche qu’on ne le pense », a-t-elle affirmé. « Et bien que la recherche sur l’informatique quantique soit encore principalement financée par des subventions, la communauté des investisseurs a commencé à parier sur la technologie », a-t-elle poursuivi. « MACH37 s’adresse aux entreprises en phase de démarrage », a-t-elle précisé. « Nous avons investi dans plusieurs entreprises quantiques différentes. Le fait que les start-ups puissent désormais accéder facilement aux ordinateurs quantiques via des plateformes cloud a facilité l’entrée de nouveaux types d’entreprises dans ce domaine, et pas seulement celles qui travaillent sur des questions de physique fondamentale. Certaines travaillent par exemple sur la cybersécurité et d’autres applications de l’informatique quantique ».

L’éditeur de Redmond a confirmé hier qu’il avait enfin corrigé un problème qui empêchait les utilisateurs d’Authenticator d’accéder à leurs comptes, une situation unique pour une application d’authentification.

Après avoir ignoré pendant huit ans les plaintes des utilisateurs concernant une faille de sécurité dans son outil Authenticator, Microsoft a confirmé qu’il avait finalement corrigé ce problème. La faille résulte d’un oubli assez unique dans le processus d’introduction de comptes de l’application Authenticator : en limitant le nombre de champs pris en compte par Authenticator lors de l’ajout de comptes par QR codes, certains utilisateurs qui s’identifiaient par une adresse email pouvaient se voir refuser…

Il vous reste 92% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

Perfectionner sa gestion des risques fournisseurs et recourir à la sauvegarde sous forme de service constituent pour les DSI deux réponses complémentaires pour mieux se protéger contre les incidents impactant les services SaaS.

S’il est une tendance que la panne de CrowdStrike a mise en lumière, c’est que les entreprises dépendent d’un nombre croissant de systèmes interconnectés, dont chacun peut paralyser les opérations en dehors de tout contrôle des DSI. Par conséquent, la supply chain logicielle et la gestion des risques liés aux fournisseurs deviennent des sujets de plus en plus importants pour la direction générale, les organisations cherchant à réduire leur exposition aux pannes et aux problèmes de continuité d’activités des principaux fournisseurs dont elles dépendent.L’un de ces domaines fait l’objet d’une plus grande attention aujourd’hui : la sauvegarde et la récupération des données des services SaaS, que de nombreux DSI ont jusqu’à présent considérées comme acquises, laissant à leurs fournisseurs le soin non seulement de fournir un temps de disponibilité supérieur à cinq neufs, mais aussi d’être les seules entités à sauvegarder et à récupérer les données de leurs services. Ces derniers devant, au fil des ans, de plus en plus vitaux pour les opérations basées sur les données au sein des entreprises.« Nous avons subi les conséquences de l’absence d’un plan de reprise après sinistre solide chez OpCon, l’un de nos fournisseurs de SaaS, lors de la panne de MS Azure Central Region », explique ainsi Gary Jeter, directeur technique de la société financière TruStone Financial. « Les traitements nocturnes ont été considérablement retardés, ce qui a eu un impact important sur notre coopérative de crédit et nos membres. Cela s’est produit le même soir que l’incident CrowdStrike ».Priorité à la sauvegarde des données du SaaSComme de nombreux responsables informatiques, Gary Jeter se préoccupe de plus en plus de la protection contre les incidents liés au SaaS et de leur impact potentiel sur l’activité de l’entreprise. « Bien que nous ne l’ayons pas encore mis en oeuvre, nous allons l’intégrer à nos processus de gestion et de sélection des fournisseurs. Nous prévoyons également d’étendre nos évaluations des risques pour inclure une procédure de reprise après sinistre plus complète des fournisseurs de SaaS. Nous devons déterminer les plateformes dont il nous appartient de nous assurer qu’elles disposent d’une stratégie d’atténuation adéquate. »Le cabinet d’études Gartner prévoit que, d’ici trois ans, plus de 75 % des entreprises feront de la sauvegarde des applications SaaS et des données stockées chez les fournisseurs de SaaS une de leurs priorités, contre 15 % aujourd’hui. La demande croissante de garanties pour les sauvegardes SaaS, jugées essentielles pour la continuité des activités, fait suite à la panne CrowdStrike-Microsoft, qui a eu un impact sur les entreprises dans le monde entier cet été. Elle peut également être vue comme la conséquence de la quantité croissante de données d’entreprise stockées dans des solutions SaaS : selon Gartner, les dépenses des entreprises dans le SaaS devraient augmenter de 20% cette année et l’an prochain, pour atteindre 247,2 Md$ en 2024 et s’approcher des 300 Md$ en 2025.

Se fier aux procédures des seuls fournisseurs SaaS ?

Pour les DSI soucieux de protéger leurs données SaaS, Gartner suggère de commencer par vérifier les conditions de leurs fournisseurs, pour s’assurer que la protection et la récupération des données sont bien intégrées dans la gouvernance des opérations des fournisseurs en question. Et également de vérifier la capacité de leurs fournisseurs SaaS à récupérer les données dans tous les scénarios de panne.« De nombreuses solutions SaaS permettent de sauvegarder les données de leurs clients, mais l’objectif premier n’est pas d’assurer la restauration de ces données à la suite de problèmes liés ou provoqués par le client. La sauvegarde du fournisseur sert à résoudre les problèmes liés à son fonctionnement propre, pas nécessairement ceux en relation avec un client », explique Michael Hoeck, analyste et directeur sénior au sein du cabinet Gartner. « Un principe général des applications SaaS réside dans le partage de la responsabilité sur les données. »Si la société d’analyse de données Mathematica n’a pas été directement touchée par la panne de CrowdStrike, plusieurs de ses fournisseurs SaaS ont été affectés, dont un qui est un système critique pour l’activité de cette entreprise, explique son DSI Akira Bell.Apporter une couche supplémentaire de redondance« Nous n’avons pas commencé à faire nos propres sauvegardes en complément de ce que le fournisseur SaaS est tenu de faire, mais je dirais que c’est une option que nous considérons de plus en plus, dit Akira Bell. Lorsque je regarde nos capacités de récupération, l’un des volets qui me préoccupe de plus en plus, ce sont nos applications SaaS critiques. Dans un scénario de panne affectant notre supply chain, nos tiers peuvent être la cause d’une absence de solution de backup. Une couche supplémentaire de redondance pourrait devenir essentielle ».L’intégration de solutions de sauvegarde as-a-service est nécessaire pour protéger les applications tournant dans le cloud et assurer la continuité opérationnelle, selon Gartner. Bien que certains fournisseurs de SaaS offrent des services de sauvegarde de base à un coût bas ou nul, les DSI explorent des moyens plus complets pour protéger leurs données dans le SaaS et s’assurer qu’ils disposent d’une méthode de reprise après sinistre opérationnelle en cas de défaillance de leurs solutions SaaS, résument les analystes du cabinet.« Tous les SaaS n’ont pas de capacités de sauvegarde pour leur propre produit, et chez beaucoup de ceux qui en ont, ces capacités sont rudimentaires », souligne Johnny Yu, qui dirige la recherche sur les sauvegardes SaaS chez IDC. Microsoft 365, par exemple, sauvegarde nativement les données à un rythme régulier et les utilisateurs peuvent revenir sur ces sauvegardes, mais le mécanisme a des limites. « Par exemple, les utilisateurs ne peuvent pas restaurer des fichiers individuels, des courriels ou des conversations Teams », explique Johnny Yu.« La principale conclusion est que chaque fournisseur de SaaS gère la protection des données de ses clients différemment, et qu’il n’est jamais certain que ces données soient protégées, reprend l’analyste. Les seules garanties sur lesquelles s’engagent les fournisseurs concernent généralement le taux de disponibilité et l’accessibilité de leurs logiciels. »Vendre le backup as-a-service à la directionJohnny Yu, d’IDC, confirme la tendance dessinée par Gartner : les entreprises clientes s’intéressent désormais à des garanties supplémentaires, en particulier celles que propose la sauvegarde as-a-service (ou BaaS pour backup as-a-service), où elles n’ont pas à acheter et gérer leur propre infrastructure de sauvegarde. La plupart des fournisseurs de protection des données vendent une version BaaS de leur produit, y compris Veeam, Commvault et Cohesity, tandis que d’autres comme Druva, Backblaze et Carbonite pourraient être considérés comme des spécialistes du BaaS.Mais attention, pour les DSI, expliquer l’intérêt d’une telle protection ne relève pas d’évidence. Tom Barnett, DSI et Chief Digital Officer chez Baptist Memorial Health Care, à Memphis, comme d’autres responsables informatiques, est confronté à des dirigeants d’entreprise qui demandent : ‘Pourquoi avons-nous besoin d’une sauvegarde si les données sont dans le cloud ?’.« Il s’agit d’une préoccupation mais il est difficile d’obtenir un financement sur ce sujet », souligne le DSI de cet hôpital. « Il faut beaucoup d’éducation et une discussion avec la direction pour aligner le sujet avec la gestion des risques de l’entreprise, en s’appuyant sur les résultats d’audit et en les comparant aux politiques de conservation des données. Tout cela peut s’avérer fastidieux et prendre du temps. »Partir d’une analyse des risquesPatty Patria, DSI du Babson College, qui utilise Microsoft Copilot pour des tâches administratives et des gains d’efficacité pour les étudiants, est convaincue d’avoir trouvé la bonne approche : « tout dépend de l’application SaaS et du niveau de risque lié à ce contenu, ainsi que des exigences réglementaires auxquelles l’organisation doit se conformer. La plupart des applications SaaS sont déjà sauvegardées par le fournisseur et la plupart des DSI n’effectuent pas de sauvegardes supplémentaires, mais il existe des exceptions. »Pour mettre en perspective la dépendance d’organisations comme Babson à l’égard de Microsoft, Johnny Yu d’IDC indique que Microsoft propose, sur son service de BaaS 365 Backup, une période de conservation pouvant aller jusqu’à un an, des points de restauration aussi rapprochés que toutes les 10 minutes (au lieu de toutes les 12 heures) et une restauration granulaire du courrier, des données de contact ou de calendrier, ainsi qu’une poignée d’autres fonctionnalités pour 0,15 dollar par Go et par mois.

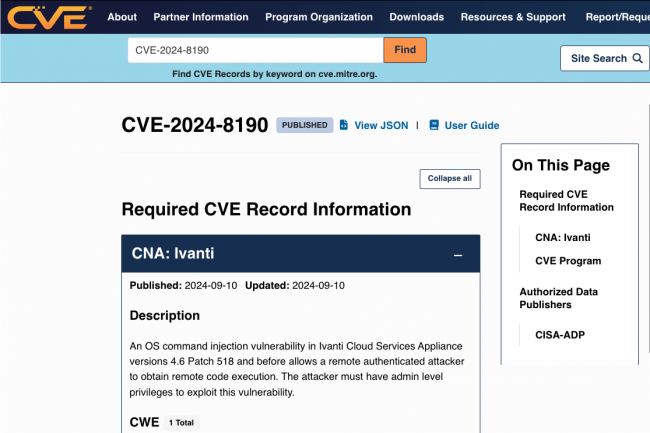

Ivanti confirme que la vulnérabilité d’injection de commande affectant Cloud Service Appliance, qui avait été corrigée par la dernière mise à jour 4.6, est en cours d’exploitation dans les entreprises.

Le fournisseur de solutions de gestion IT Ivanti a confirmé qu’une faille très grave, corrigée la semaine passée dans une ancienne version de Cloud Service Appliance (CSA), a été exploitée lors de cyberattaques. La vulnérabilité a été corrigée dans le cadre de la mise à jour de sécurité de septembre du fournisseur, qui comprenait également des correctifs pour des failles critiques et de haute sévérité dans d’autres produits. « Suite à la…

Il vous reste 92% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

Ascenseurs, onduleurs, bâtiments sont tous désormais équipés en capteurs et logiciels. Regroupés sous le terme operational technology (OT), ils sont de plus en plus vulnérables aux cybermenaces et deviennent ainsi l’affaire des RSSI.

De nombreux responsables sécurité sont encore convaincus qu’ils n’ont pas à évaluer les risques liés aux technologies opérationnelles (OT), parce qu’ils n’en ont pas la charge. Une attitude dépassée qui conduit souvent à des angles morts. Les équipements opérationnels représentent toute une gamme de matériel et de logiciels, au sein des systèmes de gestion des bâtiments, des ascenseurs, du chauffage, de la ventilation, de la climatisation ou des dispositifs de contrôle d’accès.Compte tenu du rapprochement de plus en plus courant entre l’IT et l’OT (operational technology) et de l’importance croissante du nombre de bâtiments intelligents, le risque cyber dans ces domaines est plus important que jamais. D’autant que l’OT, qui restait plutôt protégée, est aujourd’hui de plus en plus vulnérable à cause des capteurs intelligents ou des accès à distance à des fins d’analyse prédictive. En voici quelques exemples concrets.La vulnérabilité d’un thermomètre ou de la climatisationEn 2018, des pirates ont réussi à compromettre un thermomètre intelligent dans l’aquarium d’un casino américain et à accéder au réseau et à la base de données de ce dernier. Avant cela, en 2013, deux chercheurs en sécurité ont démontré de manière spectaculaire que les systèmes de chauffage, de ventilation et de climatisation (CVC) peuvent être attaqués avec des outils tels que HVACKer. Ils ont tout simplement réussi à détourner le CVC de Google Australie et à le pirater. En 2022, ce sont les onduleurs électriques d’un fabricant d’équipements industriels renommé qui ont été affectés par des vulnérabilités critiques. Ces dernières ont permis de pirater et d’endommager les systèmes à distance.Des situations qui soulèvent plusieurs questions pour les RSSI dans la mesure où la protection OT n’est pas leur coeur de métier. Souvent, les entreprises n’attachent pas une grande importance à la sécurisation des ascenseurs ou des systèmes de climatisation. La probabilité plus faible d’attaque doit-elle se traduire par une moindre allocation de ressources à leur protection ? Comment trouver un bon équilibre entre « ne pas s’enliser dans les détails » et « gérer le risque de manière appropriée » pour les RSSI ?Modéliser les menaces et évaluer les risquesPour se préparer, les entreprises doivent d’abord disposer d’une modélisation adéquate des menaces et évaluer les risques associés. L’attention portée à l’OT en matière de risque cyber ne devrait en effet pas être moins importante que celle portée à la supply chain digitale, par exemple, aux environnements de test et développement ou encore au Shadow IT. On atteint l’équilibre lorsque des processus de gouvernance des risques sont en place et que ceux-ci peuvent être gérés de manière optimale. Pour ce faire, il faut d’abord identifier toutes les ressources OT et IoT industriel périphériques. Ensuite, il faut catégoriser l’impact sur l’entreprise, c’est-à-dire analyser en profondeur les vecteurs de menace ainsi que les conséquences potentielles d’une attaque sur les processus, la sécurité, la réputation, les finances et la conformité.

Avec Recorded Future, le fournisseur de solutions de paiement Mastercard a réalisé une acquisition stratégique pour obtenir des renseignements en temps réel et à analyser de vastes quantités de données provenant de l’ensemble du web. Y compris ses zones les plus sombres.

Les cybercriminels étant de plus en plus rusés dans leurs tactiques, les entreprises se tournent de plus en plus vers le renseignement sur les menaces (aka threat intelligence) qui, à l’instar du renseignement militaire sur les menaces, implique la collecte, le traitement et l’analyse de données afin de déterminer les comportements, les motivations et les zones cibles. Pour protéger son énorme réseau mondial et sécuriser l’économie numérique, le géant du paiement Mastercard s’appuie de plus en plus sur cette méthode globale, et a encore renforcé ses efforts avec un dernier accord pour acquérir la société mondiale de renseignement sur les menaces Recorded Future pour 2,65 Md$. « Il s’agit d’une nouvelle étape dans notre démarche de sécurisation de l’écosystème numérique », a déclaré Craig Vosburg, directeur des services de Mastercard, à notre confrère CSO. « Les capacités de renseignement sur les menaces de Recorded Future identifie les intentions et les outils à l’origine d’une attaque, ainsi que les risques associés. Cela offre aux entreprises et aux gouvernements de protéger rapidement leurs opérations et leur infrastructure. »

Recorded Future utilise l’intelligence artificielle pour analyser des milliards de points de données à travers un large éventail de sources afin de fournir une visibilité en temps réel sur les menaces potentielles. L’entreprise compte plus de 1 900 clients dans 75 pays, dont plus de 50 % des entreprises du classement Fortune 100. L’acquisition promet à Mastercard d’étendre ses capacités de renseignement sur les menaces à l’ensemble de son réseau d’institutions financières et de commerçants. Recorded Future, pour sa part, aura accès au vaste réseau du géant du paiement, dont les milliards de points de données l’aideront à optimiser davantage ses modèles basés sur l’IA. Dans plusieurs messages publiés sur X, le CEO de Recorded Future, Christopher Ahlberg, a déclaré que l’entreprise resterait une plateforme de renseignement indépendante et ouverte servant de filiale indépendante de Mastercard.

De l’intelligence en temps réel alimentée par l’IA

« Notre engagement envers vous est plus fort que jamais », a-t-il promis. « Notre capacité d’action va s’accroître. Nous allons repousser les limites de la collecte, de l’analyse, de l’IA, de l’intelligence finie, de tout cela », indique Christopher Ahlberg. L’importance de l’acquisition réside dans la capacité de la société à fournir des renseignements exploitables en temps réel grâce à ses analyses alimentées par l’IA, qui peuvent analyser de vastes quantités de données provenant de l’ensemble du web, y compris du dark web, a expliqué quant à lui Scott Dylan, fondateur chez NexaTech Ventures. Cette technologie permettra à Mastercard d’identifier et d’atténuer les risques avant qu’ils ne se transforment en véritables failles de sécurité. Tout aussi important, le géant du paiement aura une vision plus globale du paysage des menaces, ce qui permettra aux consommateurs et aux entreprises d’être mieux protégés tout au long du processus de paiement.

Selon Brian Wrozek, analyste principal de Forrester spécialisé dans la sécurité et les risques, l’amélioration des capacités de renseignement sur les menaces est constamment une « priorité tactique de sécurité » pour les entreprises, qui achètent en moyenne plus d’une demi-douzaine d’outils de renseignement sur les menaces. « La veille sur les menaces permet aux entreprises de prévenir et d’interrompre les types d’attaques afin de minimiser l’impact sur les clients et de préserver la réputation de leur marque », a-t-il déclaré. Statista estime que d’ici 2033, le marché du renseignement sur les cybermenaces (CTI) atteindra plus de 44 milliards de dollars (contre 11,6 milliards de dollars en 2023). La combinaison des capacités de renseignement sur les menaces de Recorded Future et du vaste réseau de commerçants et d’institutions financières de Mastercard devrait fournir une protection plus grande et plus étendue aux transactions de paiement numérique, poursuit Brian Wrozek. Et d’ajouter qu’il sera intéressant de voir l’impact de ce partenariat sur d’autres cas d’utilisation des renseignements sur les menaces à long terme, comme la fourniture d’un contexte supplémentaire pour prioriser la remédiation des vulnérabilités.

Lutter contre la fraude qui se produit lorsque la sécurité n’est pas assurée

Mastercard et Recorded Future ont déjà travaillé en partenariat sur un service basé sur l’IA qui alerte les institutions financières lorsqu’une carte de crédit est susceptible d’avoir été compromise. Lancé en début d’année, ce service a permis de doubler le taux d’identification des cartes compromises, affirment les deux entreprises. « Mastercard a réalisé de nombreux investissements dans des entreprises et des technologies de prévention de la fraude au cours des dix dernières années », a déclaré Aaron Press, directeur de recherche pour les stratégies de paiement mondiales d’IDC. Ces entreprises comprennent Brighterion AI, Vocalink, Ekata et Ethoca, entre autres. « Ils ont des points de vue différents, mais ils sont tous axés sur la prévention de la fraude et la gestion des risques, tout en soulignant que le risque financier direct de la fraude pour Mastercard et ses concurrents, tels que Visa ou American Express, est minime, car ils n’émettent pas les cartes eux-mêmes dans la mesure où ce sont les institutions financières constituant leur base clientèle qui le font. « Il est intéressant qu’ils s’intéressent de si près à cette question », a-t-il déclaré. Bien que le risque soit indirect, « il est dans leur intérêt de maintenir l’intégrité des systèmes de paiement qu’ils exploitent. Si les consommateurs perdent confiance dans le processus, personne n’utilisera les cartes. Elles veulent augmenter leur pouvoir d’attraction auprès de leurs électeurs ».

Aaron Press a aussi expliqué que dans le monde des cartes, la fraude provient à la fois du côté de l’émission (octroi du prêt) que de l’acceptation (autorisation de la transaction). Le renseignement sur les menaces s’intéresse ainsi essentiellement aux conséquences des défaillances de la cybersécurité, car il intervient généralement après qu’une violation a eu lieu. « La fraude est ce qui se produit lorsque la sécurité est défaillante », a-t-il déclaré. « La fraude, c’est la façon dont les données provenant d’une faille sont monétisées. Les institutions financières doivent en fin de compte trouver un équilibre délicat : Il s’agit d’opposer la fraude à la friction et d’établir une base de référence pour ce qu’elles peuvent considérer comme un niveau de fraude acceptable. « Il est essentiel de savoir ce qu’il faut rechercher et d’être prévoyant à ce sujet, et en même temps, il faut équilibrer la menace avec l’opportunité », a déclaré Aaron Press. « Vous pouvez atteindre un niveau de fraude nul, mais vos ventes ou vos bénéfices seront nuls. Vous direz non à tout ce qui est un tant soit peu suspect ».

Fortifier le système financier mondial

En fin de compte, Mastercard construit un service de sécurité complet qui ne concerne pas seulement les paiements, mais « l’infrastructure environnante qui alimente l’économie numérique », selon Scott Dylan, soulignant les autres acquisitions récentes de la société en matière de cybersécurité, y compris RiskRecon (gestion des risques de tiers) et CipherTrace (services de crypto-monnaie et de paiement). « Cette acquisition souligne le rôle croissant que joue le renseignement sur les menaces dans la fortification du système financier mondial, où les enjeux n’ont jamais été aussi importants », a-t-il ajouté. D’un point de vue sectoriel plus large, l’opération indique également que le renseignement sur les menaces devient indispensable. « Alors que l’économie numérique continue de se développer, des entreprises comme Mastercard reconnaissent que la veille sur les menaces n’est plus facultative », a déclaré M. Dylan.

Dans le cadre du renforcement de son alliance avec Okta, le fournisseur de solutions de sécurité Jamf va apporter des fonctions de MDM supplémentaires pour améliorer la gestion de flottes de terminaux Apple et des identités.

Alors que l’Union européenne fait de son mieux pour transformer iOS en Android, l’écosystème Apple se concentre sur ce qui compte vraiment pour les utilisateurs professionnels : la sécurité, la confidentialité et l’intégrité de la plateforme. C’est précisément pour cela que Jamf, éditeur de solutions des sécurité et de gestion de terminaux mobiles (MDM) dans l’univers Apple, s’est rapproché davantage d’Okta, principal fournisseur de technologies d’identification. Cela fait plusieurs années que Jamf et Okta travaillent ensemble. En 2023, ils ont été les premiers à prendre en charge le framework d’authentification unique (Single Sign-On, SSO) d’Apple sur Mac, peu de temps après son introduction sur iPhone et iPad.Identité, gestion et sécuritéCette fois, Jamf a rejoint le programme partenaire Elevate d’Okta, ce qui signifie que les deux sociétés pourront collaborer encore plus étroitement pour proposer des services combinés aux clients, tout en élaborant de nouvelles offres de services. « Avec Okta comme fournisseur d’identité et Jamf comme solution de gestion et de sécurité, nos clients communs peuvent offrir à leurs collaborateurs des flux de travail ininterrompus et productifs, partout et à tout moment », a expliqué Henry Patel, directeur de la stratégie chez Jamf. L’intérêt de cette combinaison n’échappera pas aux services IT. Jamf peut fournir les fonctions de MDM nécessaires aux flottes d’Apple, tout en protégeant contre les menaces de sécurité, depuis le point d’extrémité jusqu’au coeur de l’entreprise. L’ajout d’un support centralisé avec les outils d’Okta, pour protéger et gérer l’identité offre aux clients une gestion et une protection de classe professionnelle pour leurs flottes d’appareils.Avantages de la solution communeSelon les deux entreprises, leur solution commune permet aux clients de gérer toutes les tâches suivantes :- Renforcer la sécurité grâce à l’authentification multifactorielle (MFA) et à l’authentification unique sans mot de passe (Passwordless Single Sign-On, PSSO).- Permettre une inscription transparente des appareils grâce à l’Enrollment SSO.- Améliorer la productivité avec des flux de travail ininterrompus, et donc moins de connexions PSSO. Personne n’aime renseigner des identifiants plus que nécessaire, car cela nuit à l’expérience de l’utilisateur et perturbe la concentration.- Assurer un accès conditionnel continu, en ajustant les autorisations d’accès des utilisateurs en fonction des changements de statut de la sécurité.- Faciliter l’accès aux ressources et aux applications de l’entreprise.L’accès conditionnel est particulièrement important dans les environnements de travail modernes.Gérer des environnements de travail à distance complexesMême si certains dirigeants continuent à résister au travail hybride, le « Bring Your Own Device » (BYOD) a montré que les changements sur le lieu de travail étaient inévitables. Cela signifie que de plus en plus de personnes salariés travailleront de n’importe quel endroit, sur l’appareil qu’elles choisissent et au moment qu’elles jugent le plus productif. Le problème de ce scénario, c’est que les entreprises doivent trouver un moyen de protéger leurs données en dehors des modèles traditionnels de sécurité liés au périmètre, et c’est ce que tente de faire l’accès conditionnel. Ce système s’appuie sur des indicateurs comme la localisation, l’heure, l’appareil ou l’utilisateur pour déterminer la fiabilité d’un appareil quand il est utilisé pour accéder aux données de l’entreprise. Ces dernières années, l’accès conditionnel a fait l’objet d’un travail considérable, et cette tâche s’est accélérée pendant la pandémie. La technologie Declarative Device Management d’Apple, la prise en charge de Microsoft Intune par Jamf et l’inclusion de Jamf sur Azure Marketplace montrent la solidité des solutions d’identité et d’accès mises en place par les entreprises, tandis que le SSO et les passkeys témoignent de l’attention portée à l’utilisateur, inhérente à toutes ces tentatives.Une simplicité de gestion pour l’entrepriseDans l’idéal, il faudrait que la sécurité des appareils et des terminaux soit assurée sans aucune intervention de l’utilisateur. Et on ne peut que se réjouir de voir cette possibilité se concrétiser sur les Mac, les iPhone et les iPad. Cela dit, même le SSO montre qu’une interaction avec l’utilisateur sera toujours nécessaire, mais en lisant entre les lignes de l’annonce de Jamf/Okta, on comprend que l’intention est de fournir une sécurité de niveau entreprise simple et facile à utiliser, tout comme n’importe quelle technologie grand public d’Apple, avec une protection qui permette aux travailleurs de se concentrer sur ce qu’ils font, tout en laissant à l’IT le niveau de contrôle, de sécurité et de fourniture d’identité dont elle a besoin. Tout cela sans le moindre accès au noyau, comme c’est le cas pour toute plateforme d’entreprise bien faite, diront certains.

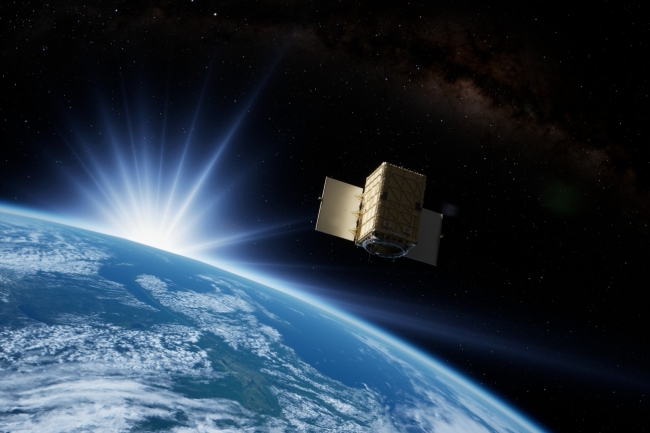

Boeing prévoit d’envoyer un satellite dans l’espace pour faciliter les communications quantiques. L’annonce a été faite par l’entreprise lors du Quantum World Congress organisé du 9 au 12 septembre près de Washington.

Boeing a annoncé hier que son satellite quantique, baptisé Q4S, sera lancé en 2026 pour démontrer les capacités d’échange d’intrication quantique en orbite. En matière de communications quantiques spatiales, seule la Chine dispose d’un satellite en orbite. En fait, le premier satellite chinois de communication quantique a été lancé en 2016. L’Europe et le Canada prévoient de lancer des satellites en 2025 ou 2026. Avec l’annonce de Boeing, faite lors du Quantum World Congress, les États-Unis rejoignent le club….

Il vous reste 93% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?