Face à Microsoft proposant Copilot pour 30 $ HT dans sa suite bureautique, Google Cloud annonce un plan tarifaire à 10 $ HT par utilisateur et par mois pour accéder à des fonctionnalités d’IA. Par ailleurs, le fournisseur a présenté l’application Vids pour créer des vidéos.

Comment se démarquer par rapport à la concurrence ? La réponse peut être soit ajouter des fonctionnalités, soit jouer sur les prix. Et c’est sur cette deuxième option que joue Google Cloud à propos de la suite bureautique Workspace et des fonctionnalités basées sur l’IA. A l’occasion de sa grande messe à Las Vegas, le fournisseur a annoncé un plan tarifaire à 10$ HT par mois et par utilisateur pour un module nommé AI Meetings et Messaging. Une manière de se démarquer de l’offre Copilot qui s’affiche à 30$ HT par mois et par utilisateur dans Microsoft 365. Un moyen aussi d’aller chercher des entreprises ne souhaitant pas investir dans le portefeuille IA complet de Workspace.

Des modules IA et de sécurité à 10$ HT par mois et par utilisateur

Le module est basé sur le LLM Gemini de Google et s’intègre dans l’outil de vidéoconférence Meet. Concrètement, les fonctions comprennent la génération d’arrière-plan, des améliorations de la qualité vidéo basées sur l’IA, une traduction automatique des sous-titres (disponible dès à présent en avant-première) et une prise de notes automatisée pendant les réunions (disponible en juin). Une fonction audio adaptative est également prévue (disponibilité générale le mois prochain), ainsi qu’un filigrane pour les partages d’écran afin d’éviter les fuites de données (prévu pour le troisième trimestre de l’année).

Google proposera la traduction automatique des messages et des résumés de conversation dans Google Chat dans le cadre de l’extension, une fois que les fonctionnalités seront disponibles dans le courant de l’année. « Je pense que les entreprises qui adopteront l’offre AI et Meetings – et qui encourageront leur utilisation et leur adoption en interne – verront des gains de temps significatifs qui justifieront les dépenses pour cet avantage », a déclaré Wayne Kurtzman, vice-président de la recherche Social, Communities and Collaboration chez IDC. A noter que Google Cloud a également annoncé un second module à 10$ HT mensuel et par utilisateur, AI Security. Il promet de « classer et de protéger automatiquement les fichiers sensibles » stockés dans Drive, selon Google.

Vids, un assistant vidéo dans Workspace

Dans le portefeuille de Workspace, il faudra compter sur une application supplémentaire : Vids. Elle vise à simplifier la création de vidéos en fournissant des conseils pour la production et l’édition de contenus vidéo dans un cadre professionnel. Il pourra donc s’agir de vidéo pour l’onboarding de nouveaux salariés, la formation ou les argumentaires de vente. L’assistant IA peut créer un story-board et suggérer des images de fond, par exemple, et propose des voix off prédéfinies pour narrer une vidéo.

Vids accompagne les utilisateurs dans la création de leurs vidéos. (Crédit Photo : Google)

« Vids sera associé à nos autres outils de productivité tels que Docs, Sheets et Slides », a déclaré Aparna Pappu, directrice générale et vice-présidente de Google Workspace, dans un billet de blog. « Comme eux, il comprend une interface simple et facile à utiliser, ainsi que la possibilité de collaborer et de partager des projets en toute sécurité à partir de votre navigateur », ajoute-t-elle. De son côté, Wayne Kurtzman d’IDC indique que l’application « démontre la multimodalité de Gemini ».

A l’occasion de son évènement .Next, Google Cloud a présenté plusieurs évolution au sein de son architecture Distributed Cloud. Recherche à base d’IA, sandbox, intégration d’Apigee et serveur orienté IA sont au programme.

L’IA était au cœur de la conférence .Next de Google et ce sujet a infusé les différentes annonces de la société. Même l’environnement Google Distributed Cloud (GDC) a évolué en conséquence. Pour rappel, cette offre s’adresse essentiellement aux clients qui ont des besoins spécifiques en matière de souveraineté des données, de latence ou de traitement local des données. Commercialisée en mars 2023, « elle comprend le matériel, les logiciels, le plan de contrôle local et les outils nécessaires pour déployer, exploiter, mettre à l’échelle et sécuriser un cloud géré complet », expliquait alors la firme.

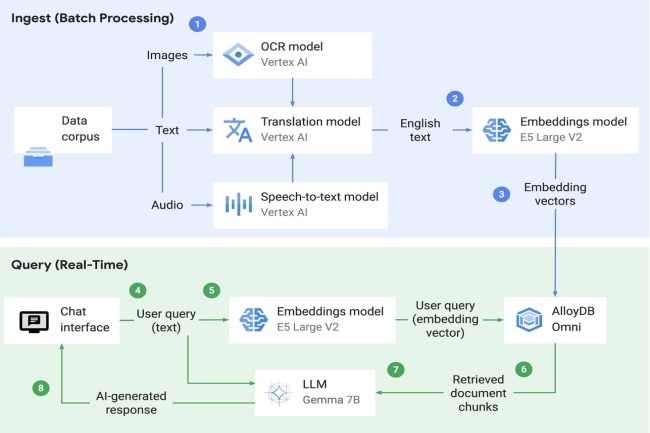

Recherche à base d’IA et sandbox

Lors de l’évènement, Google Cloud a présenté plusieurs fonctionnalités au sein de GDC dont une fonction de recherche alimentée par l’IA pour récupérer et analyser des données sur site ou en edge. Sous le capot, la recherche IA utilise le modèle Gemma 7B, Vertex AI pour le service LLM, et une API pré-entraînée (speech-to-text, traduction et reconnaissance optique de caractères) pour l’ingestion de données. « Elle prend également en charge l’extension AlloyDB Omni pgvector pour les entreprises qui déploient une base de données vectorielle au sein de GDC », a indiqué le fournisseur. La recherche IA sera disponible en avant-première au cours du deuxième trimestre de cette année.

Parmi les autres mises à jour de Distributed Cloud, on peut citer un environnement sandbox. « Le bac à sable ajouté à Google Distributed Cloud offre une expérience managée qui peut aider les développeurs d’applications à créer et à tester des services conçus pour GDC dans un environnement Google Cloud, sans avoir à naviguer dans l’isolation (air gap) et le matériel physique », a expliqué le fournisseur, ajoutant que les développeurs pouvaient utiliser les services GDC, y compris les machines virtuelles, les conteneurs, les bases de données et Vertex AI. Google a également rendu le stockage de Distributed Cloud plus flexible, de sorte que les entreprises pourront augmenter leur stockage indépendamment du calcul. « Elles pourront ainsi mieux supporter les grosses charges de travail analytiques et d’IA », a déclaré l’entreprise, en précisant qu’il y avait aussi des options pour le stockage de blocs, de fichiers et d’objets.

Une infrastructure orientée IA et intégration d’Apigee

Par ailleurs, Distributed Cloud aura désormais accès à des racks spécialement optimisés pour l’IA et les charges de travail de calcul général. « Ces infrastructures offrent plus de flexibilité dans le choix de nœuds optimisés pour le réseau ou le stockage dans le cadre d’un déploiement », a indiqué le fournisseur. De plus, grâce au partenariat entre Google et Nvidia, les entreprises pourront accéder à un nouveau serveur pour Google Distributed Cloud équipé d’un accélérateur GPU Nvidia L4 Tensor Core économe en énergie. « Il est possible de déployer un seul serveur en tant qu’appliance autonome pour les cas d’usage où la haute disponibilité n’est pas nécessaire. Cette offre vient s’ajouter à nos serveurs optimisés pour l’IA avec des GPU Nvidia H100 Tensor Core pour accélérer l’innovation en matière d’IA sur site », a précisé l’entreprise dans un communiqué.

Pour ce qui est de la capacité de résilience, les améliorations concernent le mode déconnecté avec un support de 7 jours, une suite de fonctionnalités de gestion hors ligne pour aider à assurer que les déploiements, les charges de travail sont accessibles en état de fonctionnement pendant qu’ils sont déconnectés. Enfin, Google prendra en charge Apigee, son offre de gestion des API, sur Distributed Cloud.

La Fondation Eclipse veut établir des spécifications communes pour le développement de logiciels sécurisés sur la base des meilleures pratiques open source existantes.

L’affaire de l’outil XZ a remis en lumière les questions de sécurité des composants open source. Si plusieurs initiatives existent sur ce sujet, il faut compter maintenant sur celle lancée par la Fondation Eclipse pour travailler à l’établissement de spécifications communes pour le développement sécurisé de logiciels sur la base des meilleures pratiques open source.

Dans ce cadre, elle fédère plusieurs fondations (Apache Software, Blender, OpenSSL Software, PHP, Python et Rust Foundation). Dans un billet de blog daté du 2 avril, Eclipse a déclaré que l’objectif de cette initiative était de relever les défis de la cybersécurité dans l’écosystème open source et faire la preuve de son adhésion au Cyber-résilience Act européen. L’effort de collaboration sera hébergé par la Fondation Eclipse AISBL, basée à Bruxelles, sous les auspices de l’Eclipse Foundation Specification Process et d’un nouveau groupe de travail. D’autres fondations open source hébergeant du code et des acteurs de l’industrie sont invités à s’y joindre.

Les politiques et procédures de sécurité actuelles des fondations open source et les documents similaires décrivant les meilleures pratiques serviront de point de départ à ce travail de normalisation technique. La gouvernance du groupe de travail suivra le modèle dirigé par Eclipse, mais sera complétée par une représentation de la communauté des logiciels libres. « Les résultats attendus consisteront en une ou plusieurs spécifications de processus disponibles sous une licence de copyright de spécification libérale et une licence de brevet libre de redevance », a indiqué Eclipse.

Les grands systèmes fêtent leur 60ème anniversaire et restent toujours incontournables pour traiter certaines charges de travail. Ils sont même capables de résister à des tremblements de terre comme le montre une récente actualité.

Beaucoup de choses ont été écrites et le sont encore sur les mainframes. Ces vénérables systèmes sont presque « éternels » et viennent de fêter le 7 avril leur 60ème anniversaire. En effet, en avril 1964 (le 7 pour être précis), IBM présentait le System/360 inaugurant une autre façon de penser la conception et la construction des systèmes informatiques. Ce que l’on sait moins c’est que la longévité des mainframes se conjugue aussi avec la robustesse.

Preuve en est, la récente aventure rapportée par un ingénieur d’IBM, Pasquale “PJ” Catalano, qui sur X (ex Twitter) a publié un message, « Je suis heureux de vous annoncer que les 200 ordinateurs centraux de Poughkeepsie, dans l’État de New York, ont passé avec succès ce test de tremblement de terre GRATUIT ! Whitehouse Station, dans le New Jersey, se trouve à environ 160 km au sud-ouest de notre centre de test ». En l’occurrence, il fait référence à un tremblement de terre de magnitude de 4,8 qui s’est produit aujourd’hui à une centaine de kilomètres du site de Poughkeepsie, dans l’État de New York.

Des tests avec une magnitude de 8

Ross Mauri, responsable de l’activité mainframe chez IBM, a répondu sur Twitter à Paquale PJ Catalano dans un message où il dit « au cas où vous ne le sauriez pas, nous simulons en fait un tremblement de terre de magnitude 7 dans le cadre d’une procédure de test standard pour les mainframes ». Ces derniers sont conçus pour résister aux catastrophes naturelles y compris les séismes. IBM estime même qu’ils pouvaient survivre à une secousse de magnitude 8.

La robustesse des mainframes peut varier d’un modèle à l’autre, mais les experts affirment que les boîtiers sont généralement construits avec des châssis solides capables de supporter les chocs et les vibrations. Il existe également des systèmes d’isolation sismique optionnels qui peuvent être utilisés autour des gros boîtiers pour assurer une protection maximale. En 2015, le groupe d’utilisateurs SHARE d’IBM a publié un article sur un modèle z13 qui a été secoué dans le simulateur de tremblement de terre de l’université du Nevada à Reno. Une vidéo d’un autre test de tremblement de terre est disponible ici.

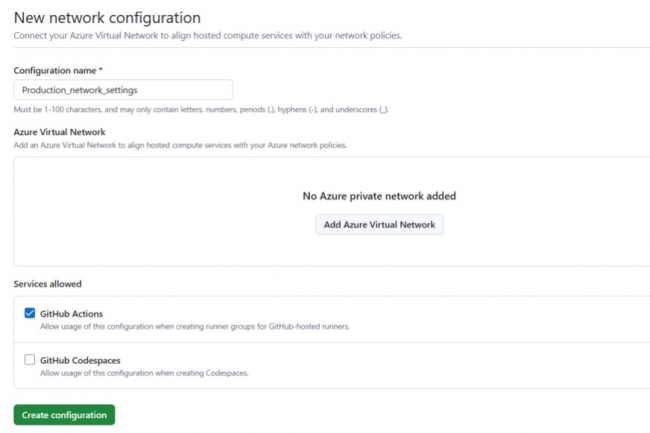

GitHub greffe à sa plateforme CI/CD automatisée le réseau privé Azure pour améliorer la sécurité et des runners hébergés sur GPU pour l’apprentissage machine.

Destinée aux clients professionnels, la plateforme CI/CD automatisée Github Actions de GitHub voit sa sécurité renforcée et s’enrichit de runners améliorés par GPU pour l’apprentissage machine. Les mises à jour du parc de runners hébergés pour Actions ont été annoncées le 2 avril. Pour renforcer la sécurité, GitHub Actions propose désormais le réseau privé Azure pour les runners hébergés par GitHub. Cette fonctionnalité combine le calcul dans le cloud avec un accès sécurisé et le contrôle de la sécurité du réseau, ce qui évite des tâches de maintenance de l’infrastructure. Les runners hébergés pour tous les principaux systèmes d’exploitation sont destinés à faciliter la construction et le test d’un projet, avec la possibilité de l’exécuter directement sur une machine virtuelle ou un conteneur.

Avec les runners hébergés sur GPU pour l’apprentissage machine, désormais en bêta publique, les équipes travaillant avec de grands modèles de langage (LLM) ou nécessitant des cartes graphiques GPU pour le développement de jeux peuvent dorénavant exécuter des processus d’automatisation et de CI/CD sur les GitHub Actions. Cette fonctionnalité prend également en charge les tests d’application, la mise à l’échelle automatique et la mise en réseau privée. GitHub a aussi élargi sa flotte de runners hébergés avec deux runners vCPU Linux et quatre runners vCPU Windows. Les projets peuvent être exécutés sur une machine virtuelle ou dans un conteneur. À noter que les runners hébergés sur les puces Apple M1 sont aussi disponibles.

Ces mises à jour interviennent alors que la plateforme GitHub Actions fête ses cinq ans, avec 22 000 Actions disponibles sur le GitHub Marketplace. « Les runners hébergés maximisent le temps de codage des développeurs en évitant les tâches associées à la gestion de l’infrastructure », a déclaré GitHub. Pour les administrateurs devops, les runners hébergés réduisent le temps et les coûts nécessaires à la maintenance de l’infrastructure informatique pour l’automatisation du cycle de vie des logiciels.

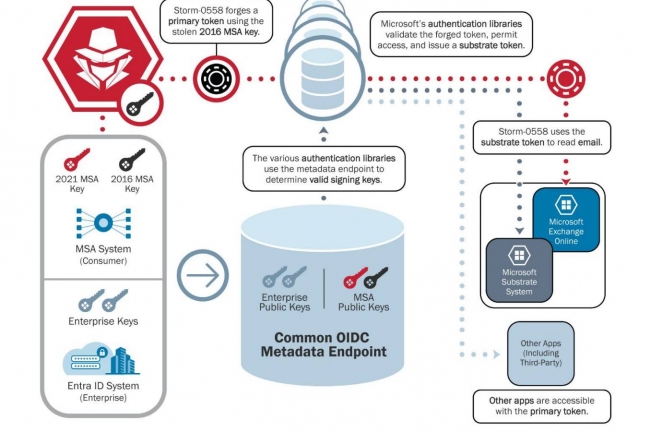

Dans un rapport, le département américain de la sécurité intérieure éreinte Microsoft pour sa façon de gérer les incidents de sécurité dont celui de sa messagerie Exchange de l’été dernier piratée par le cybergang soutenu par la Chine, Storm-0558. Ses investissements tout comme ses pratiques de facturation ont aussi été mis sur le grill.

Le département américain de la sécurité intérieure (DHS) a publié une évaluation critique des protocoles de sécurité de Microsoft à la suite de la violation d’Exchange Online de l’été 2023. Ses conclusions pointent les défaillances de sécurité au sein de l’éditeur ayant créé des conditions favorables au groupe de pirates informatiques, soutenu par l’État chinois, d’accéder à des courriels et à des données gouvernementales sensibles. Une étude indépendante du Cyber Safety Review Board (CSRB), publiée par le DHS, a conclu que l’intrusion était « évitable » et a mis en évidence ce qu’il considère comme une tendance inquiétante de Microsoft à sous-investir dans la sécurité des entreprises. Le rapport met également en évidence les lacunes de la communication publique de la firme de Redmond, soulignant que la société n’a révisé qu’en mars 2024 un billet de blog datant de septembre 2023 et détaillant la cause première de la violation, à la suite de demandes persistantes de la part du conseil d’administration. L’éditeur avait communiqué pour la première fois sur le sujet le 14 juillet dernier.

Les cyberattaques ciblées sur le courrier électronique du gouvernement américain ont exploité un jeton d’accès généré par Microsoft pour obtenir une entrée non autorisée. Dans le cadre de cette opération, les cyberespions ont utilisé une clé de compte utilisateur Microsoft compromise pour créer de faux jetons. Ces derniers ont ensuite été utilisés pour infiltrer OWA (Outlook web access) et Outlook.com, permettant un accès non autorisé à des comptes de messagerie confidentiels. « Ce groupe de pirates affilié à la République populaire de Chine a la capacité et l’intention de compromettre les systèmes d’identité pour accéder à des données sensibles, y compris les courriels de personnes présentant un intérêt pour le gouvernement chinois », a déclaré le vice-président par intérim du CSRB, Dimitri Alperovitch, dans un communiqué de presse. « Les fournisseurs de services cloud doivent mettre en œuvre de toute urgence ces recommandations pour protéger leurs clients contre cette menace et d’autres menaces persistantes et pernicieuses émanant d’acteurs étatiques ».

Un plan de réformes fondamentales attendu au tournant

Microsoft a déclaré dans un communiqué qu’il examinerait les recommandations de la commission et avait commencé à s’attaquer à ces problèmes dans le cadre de son initiative Secure Future. « Bien qu’aucune entreprise ne soit à l’abri d’une cyberattaque de la part d’adversaires disposant de ressources suffisantes, nous avons mobilisé nos équipes d’ingénieurs afin d’identifier et d’atténuer les infrastructures existantes, d’améliorer les processus et d’appliquer les normes de sécurité », a déclaré un porte-parole de la firme de Redmond.

Le CSRB recommande dans son rapport que le fournisseur partage publiquement un plan détaillé avec des échéances pour des réformes fondamentales de la sécurité. Il suggère également que tous les fournisseurs de services cloud, et pas seulement Microsoft, cessent de facturer les journaux de sécurité à leurs clients. Les positions de l’organisme couvrent de nombreux domaines, à commencer par la mise en œuvre de mécanismes de contrôle modernes et de pratiques de base dans les systèmes d’identité numérique et d’accréditation. Le document souligne par ailleurs l’importance d’établir une norme minimale pour l’enregistrement des audits par défaut dans les services cloud. « Les fournisseurs de services cloud devraient conserver suffisamment d’informations légales pour détecter l’exfiltration de ces données, notamment en enregistrant tous les accès à ces systèmes et toutes les clés privées qui y sont stockées », indique le rapport. Il recommande que les périodes de conservation des journaux couvrent toute la durée de vie d’une clé et s’étendent au moins deux ans après son expiration, une conservation plus longue de 10 ans pouvant s’avérer nécessaire pour les journaux de grande valeur.

Transparence à tous les étages attendue

Pour renforcer encore la sécurité, le CSRB conseille aux fournisseurs cloud d’adopter les normes émergentes en matière d’identité numérique. Les organismes de normalisation compétents sont invités à affiner, mettre à jour et intégrer ces normes dans leurs cadres, en veillant à ce qu’elles traitent de manière adéquate les risques couramment exploités dans le paysage moderne des menaces. La transparence est un autre élément clé des recommandations du CSRB. Le rapport pousse les cloud provider à adopter des pratiques de divulgation des incidents et des vulnérabilités auprès de leurs clients, les parties prenantes et le gouvernement des États-Unis. En outre, le développement de mécanismes plus efficaces de notification et de soutien aux victimes a été jugé essentiel.

Dans une proposition, il est souligné la nécessité de mettre à jour le Federal Risk Authorization Management Program (FedRAMP) et ses frameworks associés. Le CSRB recommande au gouvernement des États-Unis de mettre en place un processus permettant d’effectuer des examens spéciaux discrétionnaires des offres de services en nuage autorisées par le programme, en particulier à la suite de situations à fort impact. En outre, le National Institute of Standards and Technology (NIST) est encouragé à intégrer dans ses lignes directrices et ses normes le retour d’information sur les menaces et les incidents observés liés à la sécurité des fournisseurs de services en nuage. Le secrétaire à la sécurité intérieure, Alejandro Mayorkas, a souligné l’importance cruciale de la collaboration en matière de cybersécurité dans le rapport, en déclarant : « La sécurité de cette technologie n’a jamais été aussi importante ».

Malgré la longue et vague déclaration faite en mars par McDonald’s sur la panne mondiale qui l’avait empêché d’accepter tous paiements, il est possible de comprendre en grande partie ce qui s’est vraiment passé.

Une longue déclaration publiée par McDonald’s pour justifier la panne mondiale qui l’avait empêché d’accepter les paiements le mois dernier devrait servir de modèle du genre dans l’art et la manière de ne pas signaler un problème informatique. Bien que vague et trompeur, le langage utilisé par l’entreprise a quand même permis de comprendre de nombreux détails techniques, souligne notre confrère d’IDG, Evan Schuman. Par ailleurs, si McDonald’s est restée vague sur les circonstances, elle a…

Il vous reste 94% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

Dans cet accord sur le règlement d’un recours collectif sur les données d’utilisateurs suivis en mode « Incognito » évalué à plus de 5 milliards de dollars, Google s’engage également à améliorer ses politiques de divulgation.

Google a accepté de détruire des milliards d’enregistrements de données, réglant ainsi un recours collectif qui accusait la firme de Mountain View de suivre clandestinement les utilisateurs qui croyaient naviguer en mode privé. Les plaignants avaient évalué le règlement à plus de 5 milliards de dollars, mais selon les termes de l’accord, Google ne versera aucun dédommagement. Les utilisateurs peuvent cependant demander individuellement une indemnisation à l’entreprise. Déposée en 2020, la plainte affirmait que Google collectait des données sur les utilisateurs de son navigateur web Chrome même lorsqu’ils activaient la fonction « Incognito », censée empêcher ce genre de suivi. Malgré l’option de navigation privée, les outils de Google sur les sites web, y compris ses technologies publicitaires, continuaient à collecter des données sur les utilisateurs.

Dans l’accord sur le règlement conclu en décembre, Google s’engage également à améliorer ses politiques de divulgation. Avec ce règlement, l’entreprise accepte de reformuler ses déclarations pour informer les utilisateurs que « Google » recueille des données de navigation privées, notamment en divulguant explicitement ce fait dans ses politiques de confidentialité et sur l’écran d’accueil « Incognito » qui apparaît automatiquement au début de chaque session Incognito », indique un document déposé dans le district nord de la Californie. « Les plaignants ont obtenu un règlement par lequel Google a déjà commencé à mettre en œuvre ces changements, sans attendre l’approbation finale du tribunal ».

En outre, au cours des cinq prochaines années, Google permettra aux utilisateurs en mode incognito de bloquer les cookies de tiers, ce qui constitue une avancée significative en matière de protection de la vie privée des utilisateurs. « Le règlement de l’affaire Google Chrome s’inscrit dans une tendance plus large de plaintes déposées par les consommateurs concernant l’utilisation de leurs données d’une manière inattendue », a déclaré Stephanie Liu, analyste principale chez Forrester. Le principal motif de cette action en justice était lié au fait que Google affirmait que le mode Incognito permettait « de naviguer en toute confidentialité » (Google a reformulé sa présentation en réponse à la plainte). Les utilisateurs ont fait valoir qu’ils ne s’attendaient pas à ce que Google recueille des volumes de données sur ces sessions de navigation prétendument privées.

La protection de la vie privée au cœur de l’actualité

Les préoccupations relatives à la protection de la vie privée en ligne sont de plus en plus importantes, et les risques sont considérables alors que l’IA est de plus en plus intégrée dans les plateformes technologiques. Les experts mettent en garde contre le fait que les collecteurs de données et les courtiers qui échangent des informations sur les utilisateurs établissent des profils personnels exhaustifs. En cas de faille de sécurité, ces données sensibles pourraient être échangées sur le dark web, ce qui créerait un risque sérieux d’usurpation d’identité. L’an dernier, un rapport du ministère américain de la Sécurité intérieure, l’US Department of Homeland Security, a révélé que plusieurs agences gouvernementales américaines s’étaient livrées à une utilisation non autorisée des données de localisation des smartphones, en violation des normes de protection de la vie privée.

Ces agences ont acquis des données de localisation et des identifiants publicitaires (AdID) par le biais de transactions avec des courtiers en données qui ont compilé ces informations dans de nombreuses applications. « De même, les plaintes, les actions en justice et les mesures réglementaires se sont multipliées à l’encontre des entreprises qui collectent ou partagent les données de leurs clients de manière fortuite », a indiqué Mme Liu. « L’augmentation du nombre de plaintes et de recours collectifs axés sur la protection de la vie privée montre que les consommateurs sont de plus en plus conscients de l’importance de la protection de la vie privée et qu’ils agissent en conséquence ». Selon l’analyste de Forrester, la transparence est aujourd’hui essentielle. Les entreprises doivent expliquer comment les données sont partagées et utilisées. « Et pour les entreprises qui envisagent d’élargir discrètement leurs politiques de confidentialité ou leurs conditions de service, la Federal Trade Commission (FTC) a déjà averti que cette pratique pourrait être déloyale ou trompeuse », a rappelé Mme Liu. « Ces décisions doivent tenir compte du client, savoir s’il sera d’accord avec la façon dont nous utilisons ou partageons ses données. Si la réponse est négative, il faudra retourner à la case départ ».

Une année parsemée de procès

Selon Bloomberg, sur le plan juridique, l’année 2024 sera difficile pour Google. Un procès important devant un jury est prévu en septembre, où Google devra répondre des allégations du Ministère américain de la Justice et d’un groupe de procureurs généraux d’État qui accusent Google d’avoir enfreint les lois antitrust en monopolisant la publicité numérique. De plus, dans un autre procès prévu en mars 2025, le Texas et plusieurs autres États accusent le géant technologique de pratiques déloyales en matière de technologie publicitaire. Enfin, un procès fédéral antitrust, portant sur le monopole illégal de Google sur le marché de la recherche en ligne, devrait s’achever en mai avec les plaidoiries finales face à un juge de Washington.

Selon une étude d’IBM, les grandes entreprises utilisent surtout l’IA pour l’automatisation des processus IT, la sécurité et la détection des menaces.

La plus grande disponibilité des outils de développement, la volonté de réduire les coûts et l’automatisation favorisent l’adoption de l’IA par les entreprises. Mais certains défis liés aux compétences des employés, à la complexité des données et aux préoccupations éthiques restent des obstacles à l’adoption plus large de la technologie. Telles sont quelques-unes des principales conclusions de l’étude publiée par IBM, qui a interrogé 8 500 professionnels de l’IT dans le monde entier pour évaluer le déploiement de l’IA dans les entreprises de plus de 1 000 employés. Celle-ci révèle qu’environ 42 % des entreprises utilisent déjà activement l’IA et que 59 % d’entre elles prévoient d’accroître leur utilisation et leurs investissements dans la technologie. Toujours selon cette étude, les entreprises de 1 000 employés ou moins sont moins susceptibles d’adopter l’IA à usage général et l’IA générative que les grandes entreprises. « Des outils d’IA plus accessibles, la volonté d’automatiser les processus clés et la présence toujours plus importante de fonctions d’IA intégrées dans les applications commerciales prêtes à l’emploi sont les principaux facteurs de l’expansion de l’IA au niveau de l’entreprise », a déclaré Rob Thomas, vice-président senior d’IBM Software, dans un communiqué. « Les entreprises utilisent l’IA quand la technologie peut rapidement avoir un impact profond, par exemple pour l’automatisation des processus IT, le travail numérique et le service à la clientèle », a-t-il ajouté.

L’IA contribue à des fonctions organisationnelles très diverses, l’automatisation des processus IT et le marketing étant les applications les plus populaires. À l’avant-garde de l’utilisation de l’IA dans leur entreprise, les professionnels de l’IT soulignent l’importance de pouvoir construire et exécuter des projets d’IA quel que soit le lieu où résident leurs données. Selon l’étude, la confiance dans ces capacités est élevée, car la plupart des professionnels de l’IT sont convaincus que leur entreprise dispose des bons outils pour trouver des données dans l’ensemble de l’entreprise. Au cours des deux dernières années, un grand nombre d’entreprises qui explorent ou déploient déjà l’IA, ont accéléré leur déploiement, la « recherche et le développement » et « l’amélioration des compétences du personnel » apparaissant comme des priorités d’investissement, a déclaré IBM. « Dans le paysage dynamique de l’IA générative, les entreprises utilisent de plus en plus la technologie open source, avec une répartition égale entre les technologies internes et les technologies open source », a encore déclaré IBM. Parmi les entreprises qui mentionnent le recours à l’IA pour compenser les pénuries de main-d’œuvre ou de compétences, l’étude a révélé qu’elles utilisaient l’IA pour réduire les tâches manuelles ou répétitives avec des outils d’automatisation (55%), ou pour automatiser les réponses et les actions en libre-service pour les clients (47%).

Les coûts élevés entravent l’adoption

Selon l’étude d’IBM, les principaux cas d’usage de l’IA sont : l’automatisation des processus IT (33 %) ; la sécurité et la détection des menaces (26%) ; la surveillance ou la gouvernance de l’IA (25 %) ; l’analyse ou l’intelligence économique et l’automatisation du traitement, de la compréhension et du flux de documents (24%) ; l’automatisation des réponses et des actions en libre-service pour les clients ou les employés (23 %) ; l’automatisation des processus d’entreprise, l’automatisation des processus réseau, le travail numérique, le marketing et les ventes, et la détection des fraudes (22%). « Du côté des obstacles, des défis comme des connaissances limitées, l’insuffisance d’outils de développement de l’IA et des coûts élevés entravent l’adoption », a indiqué big blue. « Dans le contexte de l’IA générative, des obstacles supplémentaires apparaissent, notamment les préoccupations relatives à la confidentialité des données et une pénurie persistante de compétences de mise en œuvre », a ajouté le fournisseur. Les principaux obstacles à l’adoption réussie de l’IA dans les entreprises qui explorent ou déploient l’IA sont les compétences et l’expertise limitées en matière d’IA (33 %) et la trop grande complexité des données (25 %). Par exemple, selon les professionnels de l’IT interrogés, la plupart des entreprises (63%) utilisent 20 sources de données ou plus pour informer les systèmes d’IA, de BI et d’analyse. Selon l’étude d’IBM, les autres obstacles sont les préoccupations éthiques (23 %), les projets d’IA trop difficiles à intégrer et à mettre à l’échelle (22 %), le coût élevé (21 %) et le manque d’outils pour le développement de modèles d’IA (21 %).

Les observateurs du secteur voient un énorme potentiel dans les technologies de l’IA. Par exemple, IDC affirme qu’au cours des quatre prochaines années, les dépenses des entreprises en services, logiciels et infrastructures d’IA générative vont grimper en flèche, passant de 16 milliards de dollars cette année à 143 milliards de dollars en 2027. Cependant, la grande majorité des entreprises ne sont pas prêtes. Seules 14 % des entreprises interrogées dans le cadre du Cisco AI Readiness Index, publié récemment, ont déclaré qu’elles étaient tout à fait prêtes à déployer et à exploiter les technologies alimentées par l’IA. En particulier, Cisco a constaté que la plupart des réseaux d’entreprise actuels ne sont pas équipés pour répondre aux charges de travail de l’IA. Les entreprises comprennent que l’IA augmentera les charges d’infrastructure, mais seules 17% d’entre elles disposent de réseaux entièrement flexibles pour gérer la complexité. « 23% des entreprises ont une évolutivité limitée ou inexistante pour relever les nouveaux défis de l’IA au sein de leurs infrastructures IT actuelles », a souligné l’équipementier. « Pour répondre aux exigences accrues de l’IA en matière de puissance et de calcul, plus des trois quarts des entreprises auront besoin d’unités de traitement graphique (GPU) supplémentaires dans les centres de données pour supporter les charges de travail actuelles et futures de l’IA. De plus, 30 % déclarent que la latence et le débit de leur réseau ne sont pas optimaux ou sous-optimaux, et 48 % conviennent que leurs réseaux ont besoin d’améliorations supplémentaires pour répondre aux besoins futurs ».

Les déploiements du framework d’intelligence artificielle Ray ne sont pas censés se connecter à Internet. Si les développeurs le font quand même, ils rendent alors leurs serveurs vulnérables.

Des chercheurs avertissent que des milliers de serveurs ont été compromis au cours des sept derniers mois en raison de l’absence d’authentification par défaut dans un framework de calcul open source appelé Ray. Il est utilisé pour distribuer des workload de machine learning et d’IA. Problème, les développeurs du framework conteste le fait que ce manque d’authentification soit une faille. “Des milliers d’entreprises et de serveurs exploitant une infrastructure d’IA sont exposés à une attaque via une vulnérabilité critique qui fait l’objet d’un litige et n’a donc pas de correctif”, ont déclaré les experts de la société Oligo, spécialisée dans la sécurité des applications, dans un rapport publié cette semaine. “Cette faille accorde aux attaquants de prendre le contrôle de la puissance de calcul des entreprises et de faire fuiter des données sensibles.”

Jusqu’à présent, Oligo a identifié des serveurs compromis dans de nombreux secteurs d’activité, notamment l’éducation, les crypto-monnaies, la biopharmacie et l’analyse vidéo. Ces serveurs Ray avaient l’historique des commandes activé, ce qui signifie que les pirates pouvaient facilement découvrir des secrets sensibles utilisés dans les commandes précédentes. Ray est souvent utilisé pour exécuter des charges de travail qui servent à former, déployer et affiner des modèles d’IA. Par ailleurs, certains des travaux comprennent des scripts Python et des commandes bash qui peuvent contenir des informations d’identification nécessaires à l’intégration avec des services tiers. “Un environnement ML-OPS se compose de nombreux services qui communiquent entre eux, à l’intérieur d’un même cluster et entre les clusters”, expliquent les chercheurs. “Lorsqu’il est utilisé pour la formation ou au fine tuning, il a généralement accès à des ensembles de données et à des modèles, sur disque ou dans un stockage distant, tel qu’un bucket S3. Souvent, ces jeux de données constituent la propriété intellectuelle unique et privée qui différencie une entreprise de ses concurrents.” ajoutent-ils.

Une fonctionnalité prévue ayant des implications en matière de sécurité

L’année dernière, des chercheurs en sécurité de Bishop Fox ont découvert et signalé cinq vulnérabilités dans le cadre Ray. Anyscale, la société qui maintient le logiciel, a décidé de corriger quatre d’entre elles (CVE-2023-6019, CVE-2023-6020, CVE-2023-6021 et CVE-2023-48023) dans la version 2.8.1, mais a affirmé que la cinquième, assignée CVE-2023-48022, n’en n’était pas vraiment une et qu’elle n’avait donc pas été corrigée. En effet, la CVE-2023-48022 est directement causée par le fait que le tableau de bord Ray et l’API client n’implémentent pas de contrôles d’authentification. Ainsi, tout attaquant qui peut atteindre l’API client peut soumettre de nouveaux travaux, supprimer ceux existants, récupérer des informations sensibles et, essentiellement, exécuter des commandes à distance.

“En raison de la nature de Ray en tant qu’environnement d’exécution distribué, la frontière de sécurité de Ray se trouve à l’extérieur du cluster Ray”, a déclaré Anyscale dans son avis. “C’est pourquoi nous insistons sur le fait que vous devez empêcher l’accès à votre cluster Ray à partir de machines non fiables (par exemple via l’Internet public). C’est la raison pour laquelle la cinquième CVE (le manque d’authentification intégré dans Ray) n’a pas été abordée et qu’il ne s’agit pas, à notre avis, d’une vulnérabilité, ni même d’un bogue”. La documentation de Ray indique clairement que “Ray s’attend à fonctionner dans un environnement réseau sûr et à agir sur un code fiable” et qu’il est de la responsabilité des développeurs et des fournisseurs de plateformes de garantir ces conditions pour un fonctionnement sûr. Cependant, comme nous l’avons vu avec d’autres technologies dans le passé qui manquaient d’authentification par défaut, les utilisateurs ne suivent pas toujours les meilleures pratiques et les déploiements non sécurisés feront leur chemin sur Internet tôt ou tard. Anyscale en est conscient et va travailler sur l’ajout d’un mécanisme d’authentification dans les versions futures.

Des configurations non sécurisées par défaut

D’ici là, cependant, de nombreuses entreprises continueront probablement à exposer involontairement ces serveurs sur Internet car, selon Oligo, de nombreux guides de déploiement et référentiels pour Ray, y compris certains des guides officiels, sont fournis avec des configurations de déploiement non sécurisées.

“Les experts en IA ne sont PAS des experts en sécurité, ce qui les rend potentiellement dangereusement inconscients des risques très réels posés par les frameworks d’IA”, ont déclaré les chercheurs. “Sans autorisation pour l’API Jobs de Ray, l’API peut être exposée à des attaques RCE si les meilleures pratiques ne sont pas respectées.