Pour s’assurer que les fournisseurs de logiciels respectent les techniques de développement sécurisées, le gouvernement américain les oblige à remplir un formulaire spécial auprès de l’Office of Management and Budget.

Les exigences pour travailler avec le gouvernement fédéral américain s’enrichit d’une autre contrainte pour les éditeurs de logiciel. Ils doivent en effet remplir un formulaire d’attestation de sécurité. Ce dernier a été annoncé le 11 mars par l’Agence pour la cybersécurité et la sécurité des infrastructures (CISA) du ministère de la sécurité intérieure, qui l’a élaboré en collaboration avec l’Office of Management and Budget (OMB). Le document identifie les exigences minimales en matière de développement de logiciels sécurisés qu’un producteur de logiciels doit respecter et attester. Les solutions doivent être attestées si elles ont été développées après le 14 septembre 2022. Celles conçues avant cette date doivent renseignées toute modification par des changements de version majeurs. Une déclaration est également requise si le producteur apporte des modifications constantes au code.

Les personnes souhaitant obtenir une attestation doivent prouver que le logiciel a été développé et construit dans des environnements sécurisés. Plusieurs méthodes sont retenues telles que l’application de l’authentification multifactorielle et de l’accès conditionnel dans les environnements de développement et la création de logiciels, de manière à minimiser les risques de sécurité.

Les logiciels d’agences gouvernementales et open source exemptés

A noter que les logiciels développés par les agences fédérales ne nécessitent pas d’auto-attestation. Il en va de même pour les logiciels open source obtenus gratuitement et directement par une agence fédérale, les composants open source et propriétaires de tiers incorporés dans le logiciel, ou les logiciels obtenus gratuitement et mis à la disposition du public. Le référentiel du CISA pour la soumission de formulaires en ligne devrait être disponible à la fin de ce mois de mars, ce qui laisse (un peu) le temps aux éditeurs concernés le temps nécessaire pour comprendre le contenu et les exigences du formulaire.

Depuis un an, l’outil de gestion de cluster de containers fait face à de sérieuses failles. Après celle relative aux fichiers de configuration YAML accordant des privilèges systèmes sur les hôtes Windows l’été dernier, une autre en injection de commandes via les volumes locaux de Kubernetes a été mise à jour par le même chercheur en sécurité d’Akamai.

Kubernetes est un environnement IT comme les autres et est donc soumis à de nombreuses failles. Depuis un an, l’orchestrateur de cluster de containers en a connu deux particulièrement graves. Tout d’abord l’été dernier dans les fichiers configuration YAML des clusters Kubernetes accordant des privilèges systèmes sur les hôtes Windows. Et puis plus récemment en novembre une autre méritant une attention particulière, cette fois relative à de l’injection de commandes via des volumes locaux de l’orchestrateur de containers.

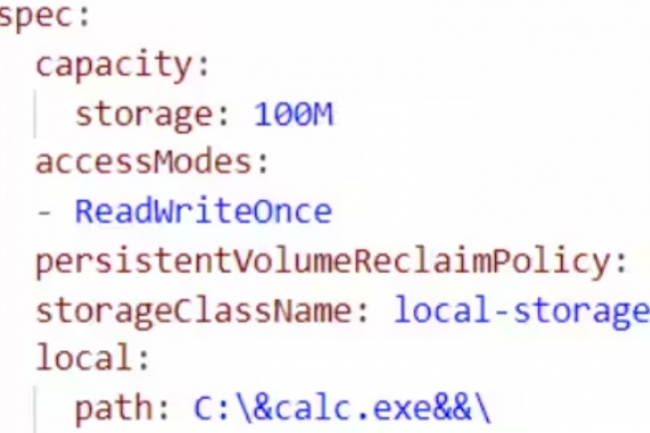

Découverte et partagée ce 13 mars par le chercheur en sécurité d’Akamai Tomer Peled, celle-ci a été répertoriée en tant que CVE-2023-5528 et corrigée dans les versions 1.28.4, 1.27.8, 1.26.11 et 1.25.16 de Kubernetes publiées en novembre 2023. La faille est similaire à la précédente CVE-2023-3676 mais au lieu de cibler la fonction de volume subPath, elle provient de la fonction de volumes locaux. Ceux-ci sont un type de volumes pris en charge dans l’orchestrateur grâce auxquels les utilisateurs montent des partitions de disque à l’intérieur d’un pod. Ils se différencient des volumes hostPath leur donnant la possibilité de monter des répertoires spécifiques. Un administrateur de clusters peut provisionner l’espace de stockage à l’avance en créant un persistentVolume, puis les utilisateurs peuvent utiliser YAML lors de la configuration d’un pod pour faire un persistentVolumeClaim afin de réclamer une partie de cet espace de stockage.

Une faille corrigée, une mise à jour à effectuer

Problème : lors de l’analyse de ces demandes à partir d’un fichier YAML, le service kubelet s’appuyait sur une fonction qui utilisait exec.command pour exécuter une commande sur le système afin de créer un lien symbolique entre le volume et l’emplacement à l’intérieur du pod. Le terminal de ligne de commande Windows accepte la concaténation de commandes – l’exécution de plusieurs commandes sur une seule ligne – en plaçant les caractères && entre les commandes.

Tomer Peled – encore lui – a découvert qu’un attaquant pouvait placer des commandes dans la définition Path du persistentVolumeClaim dans YAML et les entourer avec les caractères && avant que celles-ci soient potentiellement exécutées sur le système hôte lorsque la réclamation est traitée par le service kubelet qui s’exécute avec les privilèges SYSTEM. L’équipe Kubernetes a corrigé la vulnérabilité d’injection de commande en remplaçant l’appel cmd effectué par le service kubelet par une fonction dans GO appelée “os.Symlink()” qui effectuera la même opération de création de liens symboliques mais d’une manière sûre. Si ce n’était pas encore le cas, il convient bien entendu d’appliquer d’installer les dernières versions disponibles pour éviter tout souci lié à cette dangereuse CVE.

Disponible à partir du 1er avril, Copilot for Security son assistant à base d’IA générative dédié à la cybersécurité. Microsoft annonce une tarification de 4 $ HT de l’heure.

Après 5 mois de test, Copilot for Security prend son envol le 1er avril prochain. Collectant les données de plusieurs produits de sécurité de Microsoft, l’assistant à base d’IA générative va délivrer des explications et des suggestions de solutions. Il pourra par exemple générer des informations et des conseils de remédiation dans Defender. A noter, que l’assistant apportera également des informations provenant d’autres fournisseurs.

Des avantages dans divers domaines

Dans le cadre de la preview, Microsoft a pu identifier quatre domaines où l’assistant peut s’avérer très intéressant pour les utilisateurs, à savoir le résumé des incidents, l’analyse d’impact, la rétro-ingénierie des scripts et la réponse aux incidents étape par étape. Copilot for Security fournit des résumés d’incidents en utilisant l’IA générative pour transformer des alertes complexes en résumés clairs et exploitables. Il est aussi capable d’évaluer l’impact potentiel des incidents de sécurité, en offrant un aperçu des systèmes et des données affectés afin de prioriser les efforts de réponse. La solution analyse les scripts de ligne de commande complexes et les traduit en langage naturel avec des explications claires sur les actions à entreprendre. De plus, elle extrait et relie les indicateurs trouvés dans le script à leurs entités respectives dans l’environnement de l’utilisateur.

La réponse aux incident n’est pas oubliée avec une aide pas à pas, y compris des instructions pour le triage, l’investigation, l’endiguement et la remédiation. Des liens vers les actions recommandées apportent une réponse plus rapide. L’un des principaux avantages de ces fonctionnalités est qu’elles aident les professionnels débutants à rédiger des requêtes en langage naturel et à obtenir des réponses qu’ils peuvent comprendre. Cela peut s’avérer utile compte tenu de la « pénurie importante et chronique de compétences », comme l’a indiqué Andrew Conway, vice-président de Microsoft chargé du marketing de la sécurité. Selon les données de l’éditeur récoltées pendant la preveiw, avec Copilot, les analystes de sécurité expérimentés ont réagi 22 % plus rapidement et ils ont été 7 % plus précis pour toutes les tâches quand ils utilisaient Copilot. Presque tous, soit 97 %, ont déclaré vouloir utiliser l’outil chaque fois qu’ils auront la même tâche à effectuer.

Une ouverture aux produits et données non-Microsoft

Outre sa disponibilité générale et son accès ouvert à d’autres fournisseurs, Copilot for Security comprend plusieurs fonctionnalités nouvelles comme la création de classeurs personnalisés et la possibilité d’écrire des modules d’extension (plugins). « L’une des caractéristiques, c’est qu’il n’est pas uniquement réservé aux produits et aux données de Microsoft. Il peut raisonner sur n’importe quelle source de données, n’importe quel produit dans l’environnement auquel on peut se connecter », a expliqué Andrew Conway. Copilot for Security propose deux options d’interaction : une expérience autonome, qui fonctionne avec tous les produits de sécurité de Microsoft, et une expérience intégrée directement dans le portail Defender. Une fois en ligne, les clients pourront tirer parti de Defender Threat Intelligence pour découvrir les menaces et les techniques d’attaque, et obtenir des recommandations spécifiques au profil de risque d’un environnement particulier en utilisant le langage naturel.

Microsoft Entra (anciennement Azure Active Directory) a ajouté à Copilot des compétences en matière d’identité, notamment des détails sur les utilisateurs et les groupes, des logs de connexion, d’audit et de diagnostic. Dans Purview, Copilot pourra aider les équipes SOC à identifier les activités risquées des utilisateurs et les données sensibles potentiellement à risque lors d’une enquête sur un incident de sécurité. L’assistant fournit un résumé des alertes dans Microsoft Purview Data Loss Prevention et Insider Risk Management. Il fournit également des résumés contextuels des documents dans Purview Communication Compliance et dans les sets d’examen dans Purview eDiscovery.

Copilot for Security sera disponible en paiement à l’usage avec une tarification flexible basée sur la consommation, tout comme le modèle Azure. La capacité nécessaire, que Microsoft mesure en « unités de calcul », est estimée par le client. La tarification commence à partir de 4$ HT par usage. Le fournisseur recommande un minimum de trois unités de calcul pour démarrer. Le client pourra ajouter de la capacité si le produit signale qu’elle est insuffisante. Et si l’usage diminue, les utilisateurs pourront déprovisionner les unités de calcul inutiles.

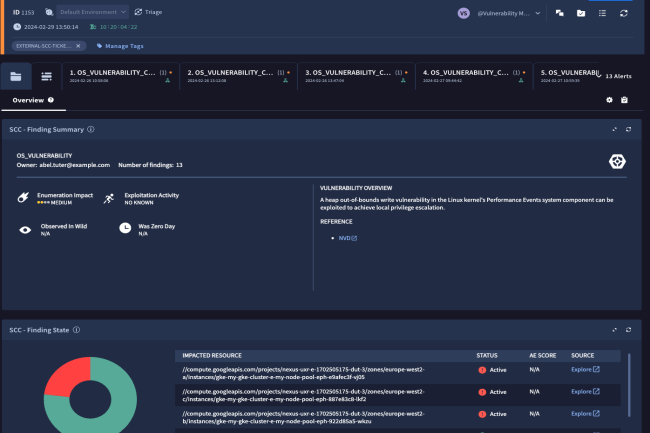

SCC Enterprise de Google Cloud rationalise la réponse aux menaces et aux mauvaises configurations sur les plateformes IaaS, y compris AWS et Azure.

La sécurité du cloud est un sujet récurrent au sein des DSI. Pour y répondre, Google vient de lancer Security Command Center Enterprise (SCC Enterprise) qui vise à combler des lacunes du cycle de vie de la sécurité du cloud. Le fournisseur promet d’offrir, avec l’aide des renseignements sur les menaces de Mandiant et de l’IA générative, des informations complètes tout au long du cycle de vie de la sécurité du cloud. Selon Google, les plateformes actuelles de type CNAPP (cloud native application protection platform) présentent des carences et la solution SCC Enterprise serait plus à même de protéger contre les menaces émergentes. « Par rapport aux solutions existantes, Security Command Center Enterprise apporte deux choses : une intégration plus étroite entre la sécurité du cloud et de l’entreprise, plus une couverture multi-cloud au lieu d’une couverture en silos », a déclaré Narayana Pappu, CEO de Zendata, un fournisseur de solutions de sécurité des données et de conformité à la vie privée basé à San Francisco, lors d’une interview.

« L’automatisation et l’intégration de l’IA génèrent des gains d’efficacité qui permettront également aux équipes de gagner du temps ». Selon Suni Potti, vice-président et directeur général de Google Cloud Security, la dernière plateforme intègre Mandiant Threat Intelligence avec des capacités SecOps modernes, de façon à répondre rapidement aux incidents de sécurité dans le cloud grâce à « une visibilité alimentée par le SIEM et un cadre de responsabilités piloté par une solution d’orchestration, d’automatisation et de réponse aux incidents de sécurité informatique SOAR (Security Orchestration, Automation and Response) ».

Une vue unique

« Les équipes de sécurité peuvent disposer d’une vue unique sur leurs contrôles de posture, des menaces actives, des identités cloud, des données et plus encore, tout en intégrant la remédiation et la responsabilité des problèmes dans les flux de travail de bout en bout d’une plateforme convergente de gestion des risques liés au cloud », a écrit M. Potti dans un article de blog. Security Command Center Enterprise (SCC Enterprise) de Google est capable d’analyser les données de sécurité sur différentes plateformes cloud et de les visualiser sous forme d’images faciles à comprendre. La solution utilise l’IA pour aider les personnes non-expertes dans la gestion de la sécurité complexe du cloud.

Le système comprend également les renseignements sur les menaces de Mandiant Hunt, auxquels les équipes de sécurité peuvent accéder chaque fois qu’elles ont besoin d’une intelligence supplémentaire. SCC Enterprise va plus loin que les services de sécurité habituels de Google. « La solution dispose d’outils plus avancés pour gérer les menaces de sécurité dans Google Cloud, Amazon Web Services (AWS) et Microsoft Azure », affirme l’entreprise. L’accent est mis sur la recherche et la correction des vulnérabilités, ainsi que sur la détection de types spécifiques de menaces susceptibles de se produire dans les installations cloud.

Réponse aux menaces et aux mauvaises configurations de l’IaaS

« L’objectif de SCC Enterprise est de rationaliser les réponses aux menaces et aux mauvaises configurations au sein des plateformes d’infrastructure en tant que service (IaaS) comme Google Cloud, AWS et Azure en ajoutant des renseignements natifs sur les menaces et une boîte à outils de réponse plus flexible, basée sur le flux de travail », a déclaré Guy Rosenthal, vice-président, produit, chez DoControl, un fournisseur de sécurité SaaS automatisé basé à New York, dans une interview. La solution de Google vise à accélérer le processus de résolution des problèmes de sécurité, ce qui pourrait réduire les risques en diminuant le temps pendant lequel les systèmes sont vulnérables et en minimisant les retards causés par la réponse humaine.

« En termes d’apport de renseignements sur les menaces au CNAPP avec les outils Mandiant et de GenIA, je pense que Google ajoute une valeur significative pour les clients potentiels », a ajouté M. Rosenthal. « Cela devrait faciliter et rendre plus efficace la coopération entre les opérateurs DevOps/Cloud et les équipes SecOps/Sécurité ». Cependant, M. Rosenthal n’est pas certain de ce qu’apporte vraiment l’intégration directe du moteur de flux de travail, et attend de voir son efficacité. « Ce que peut apporter la réduction du temps de réponse devra être mis en balance avec la charge opérationnelle et le coût de mise en œuvre et de maintenance de plusieurs systèmes offrant la même fonction SOAR », a-t-il ajouté.

Un marché du CNAPP très concurrentiel

Ce dernier fait aussi remarquer que le marché des plates-formes de protection des applications natives du cloud (CNAPP) est très concurrentiel. Microsoft propose depuis longtemps Defender for Cloud, généralement inclus dans les licences d’entreprise de Microsoft. « Les principaux fournisseurs de SASE/SSE, que ce soit Palo Alto Networks, Zscaler, ou d’autres, disposent d’une offre CNAPP pour les entreprises qui souhaitent davantage de fonctionnalités, sans parler des innovateurs clés du secteur comme Wiz, Lacework et Ermetic (qui fait maintenant partie de Tenable), qui gagnent beaucoup de terrain sur le marché », a indiqué M. Rosenthal.

« AWS est le seul acteur majeur de l’infrastructure ou de la sécurité à ne pas proposer d’offre CNAPP, et qui a choisi, jusqu’à présent, d’établir des partenariats plutôt que d’intervenir directement dans ce domaine ». Selon le consultant en sécurité John Bambenek, les acquisitions par Google d’entreprises de sécurité comme SIEMplify et Mandiant permettent au fournisseur d’améliorer ses offres de sécurité. L’entreprise vise à attirer les utilisateurs de l’écosystème Office 365 de Microsoft vers les Google Workspaces. « Tant qu’on utilise les produits Google, cela fonctionne plutôt bien, mais dès que l’on ajoute les produits d’autres fournisseurs (Azure AD, AWS, etc.), la fonctionnalité native commence à diminuer », a tempéré le consultant.

Cloudflare a ajouté une fonction de sécurisation des LLM dans son WAF. Elle analyse les requêtes et évite leur exploitation malveillante.

Les spécialistes de la cybersécurité se penchent sur la protection des grands modèles de langage. Dernier en date, CloudFlare qui a mis à jour son firewall applicatif (WAF) en ajoutant une fonction baptisée Firewall for AI. Elle a été spécialement conçue pour les applications utilisant des LLM, comprendra des outils WAF existants et nouveaux capables d’analyser les invites soumises et d’identifier les tentatives d’exploitation. « Firewall for AI est agnostique par rapport au déploiement spécifique et peut être appliqué pour protéger des modèles hébergés sur Cloudflare Workers AI ou sur n’importe quelle autre infrastructure tierce, tant que le trafic transite en proxy via Cloudflare WAF », a déclaré un porte-parole du fournisseur.

« Les clients pourront contrôler et configurer la fonction en utilisant le plan de contrôle de Web Application Firewall ». La plateforme d’inférence d’IA en tant que service Cloudflare Workers AI, ouverte et payante à l’usage, donne aux développeurs la capacité d’exécuter des modèles de machine learning sur le réseau Cloudflare à partir de leur propre code. De plus, la société a annoncé un programme appelé Defensive AI qui utilisera la technologie pour lutter contre un nombre croissant d’attaques basées sur l’IA ciblant les API et les courriels et l’accès des employés.

Protection contre le déni de service et les fuites de données

Spécifiquement destinée aux clients qui exécutent une IA sur Workers AI, Firewall for AI protège notamment contre l’injection d’invites et la fuite de données. Elle analyse et évalue les invites soumises par un utilisateur afin de bloquer l’exploitation de modèles et les tentatives d’extraction de données. La capacité s’appuie sur une combinaison d’heuristiques et de couches d’IA propriétaires pour évaluer les invites et identifier les abus et les menaces. « Firewall for AI protégera contre le déni de service par modèle ou Model Denial of Service et la divulgation d’informations sensibles ou Sensitive Information Disclosure, grâce à des outils et des fonctionnalités disponibles pour tous les clients de l’offre Web Application Firewall », a précisé le porte-parole de Cloudflare. Firewall for AI exécutera également une série de détections capables d’identifier les tentatives d’injection rapide et d’autres abus, en s’assurant par exemple que le sujet reste dans les limites définies par le propriétaire du modèle. « La validation de l’invite de Firewall for AI est actuellement en cours de développement et une version bêta sera publiée dans les prochains mois », a indiqué par ailleurs le porte-parole.

Une IA défensive pour détecter les comportements anormaux

Dans le cadre de son programme Defensive AI, Cloudflare travaille sur des systèmes IA pour examiner les modèles de trafic de clients spécifiques et construire une base de référence de comportement normal de façon à détecter toute anomalie dans les environnements, y compris les API, les courriels et l’accès des employés. « Defensive AI sert à comprendre comment les systèmes intelligents peuvent améliorer l’efficacité des solutions de sécurité », a déclaré le porte-parole du fournisseur. « Cloudflare utilise l’IA pour augmenter le niveau de protection dans tous les domaines de la sécurité, qu’il s’agisse de la sécurité des applications, de la sécurité du courrier électronique ou de la plateforme Zero Trust de Cloudflare », a-t-il poursuivi.

« Les modèles d’IA sont adaptés à l’application spécifique, de sorte que la protection de l’API utilise des modèles différents de ceux du courrier électronique ou de la confiance zéro », a ajouté le porte-parole. Même si la mise en œuvre peut différer, les concepts sont similaires – par exemple, adapter le modèle au modèle de trafic de clients spécifiques ou identifier une base de comportement normal et l’utiliser pour identifier les anomalies. Alors que Firewall for AI est déjà disponible pour les clients de Cloudflare, les modèles Defensive AI sont actuellement en cours de développement et l’entreprise n’a pas encore annoncé de date de disponibilité.

Lors de la deuxième journée de sa conférence des partenaires Amplify 2024, HP a dévoilé ce qu’il considère comme le plus grand catalogue de PC boostés à l’IA du marché.

« Attachez vos ceintures, nous allons décoller. » C’est avec ces mots qu’Alex Cho, le président de la division HP Personal Systems, a quitté la scène de la deuxième session plénière de la conférence HP Amplify Partner Conference 2024 qui s’est achevée le 7 mars à Las Vegas. Selon lui, HP dispose désormais du catalogue de PC IA le plus important du marché, basés sur des puces conçues par Intel et AMD. Le fournisseur a en effet profité de sa grand-messe partenaires annuelle pour dévoiler des équipements tels que les nouvelles générations de PC HP Elite et Elite Pro avec IA, ainsi que les stations de travail mobiles Z by HP. Tous ces produits tournent sous Windows 11 et embarquent l’assistant d’intelligence artificielle Copilot de Microsoft. HP a également présenté des produits qui, en plus d’être boostés à l’IA, proposent davantage de valeur ajoutée, notamment en termes de sécurité. Plus précisément, le fournisseur a développé une gamme de PC professionnels qui protègent les microprogrammes contre le piratage quantique et intègrent une mise à jour de sa puce Endpoint Security Controller (ESC). Cette dernière aide à garantir la gestion et la protection des données confidentielles. Isolée du processeur et du système d’exploitation, elle fournit une plateforme matérielle qui réduit le risque de fuite de données et améliore la productivité en évitant les temps d’arrêt.

Comptant aussi parmi les orateurs qui se sont succédé sur scène, Tuan Tran, le président de la division IPS (Imaging, Printing & Solutions) de HP, a expliqué comment l’évolution des usages de l’impression a conduit le fournisseur à mettre sur le marché des équipements conçus pour la nouvelle ère du travail hybride. Ils sont 20 % plus petits, en théorie 25 % plus rapides, et prêts à fournir 45 % de couleurs en plus comparé à ce que proposerait la concurrence. Tout cela avec un portefeuille « gérable, sécurisé et productif ».

La valeur des services

De son côté, Dave Shull, le président de la division HP Workforce Solutions, a dévoilé des services et solutions qui doivent permettre aux partenaires de créer et de développer leurs activités dans le domaine des prestations et des logiciels. Ces nouveautés comprennent HP WEX, la première plateforme d’expérience numérique de HP basée sur l’IA, une nouvelle offre de services gérés pour les PC, un nouveau service d’abonnement à l’impression, une approche simplifiée pour les packs d’assistance HP, ainsi que des services et des programmes visant à prolonger la durée de vie des appareils et à accélérer l’économie circulaire.

« Nous nous situons au beau milieu d’un changement historique dans la façon dont les gens travaillent. Des employés heureux, motivés et productifs génèrent de meilleurs résultats commerciaux, mais il est de plus en plus difficile de créer des environnements de travail qui inspirent une main-d’oeuvre dispersée, a expliqué Dave Shull. C’est là que notre canal de distribution joue un rôle clé en soutenant les entreprises qui traversent des transformations. C’est pourquoi ces services et solutions permettent aux revendeurs d’offrir des expériences de travail extraordinaires à leurs clients, tout en créant des flux de revenus récurrents ».

Le channel ne doit pas rater le tournant de l’IA

La deuxième session plénière de la HP Amplify Partner Conference 2024 a également donné lieu à des interventions des partenaires technologiques de HP, notamment Nvidia et AMD. Jesen Huang, CEO de Nvidia, a profité de son temps de parole pour délivrer un message clair au channel : « Pour la première fois dans l’histoire, les ordinateurs portables reconnaissent les données et, grâce à l’IA, tout ce qu’un utilisateur fait avec ces équipements. Cela inclut le sens des textes qui sont écrits et tout autre travail de conception. C’est la puissance de l’ordinateur portable, qui est le résultat de la réduction de la complexité de l’IA pour l’embarquer dans les PC. C’est pourquoi nous vivons un moment de grands progrès et d’annonces fortes.»

Quant à AMD, sa CEO Lisa Su a estimé, par vidéoconférence, que l’IA est « la plus grande révolution depuis des décennies. Je pense qu’elle est partout, qu’elle nous entoure, et que nous devons donc saisir cette opportunité. C’est pourquoi je suis si enthousiaste à l’idée de ce que cette technologie peut offrir. Le moment est venu, le channel ne doit pas rater l’occasion. L’IA est là et il est temps de chercher des cas d’utilisation pour la mettre en pratique. »

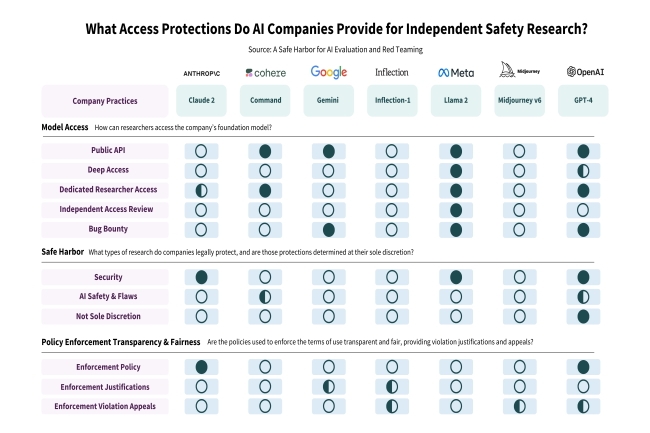

Dans une lettre ouverte, plus de 150 chercheurs, éthiciens, juristes et professeurs ont demandé aux entreprises proposant de l’IA générative d’ouvrir leur technologie à des évaluations de sécurité externes.

L’absence d’évaluations indépendantes quant aux protections de base des technologies d’IA inquiète de nombreux professionnels. Dans une lettre ouverte, plus de 150 éminents chercheurs en intelligence artificielle, éthiciens, juristes et autres appellent les entreprises commercialisant des solutions de GenAI à se soumettre à des audits de leurs systèmes. La lettre, rédigée par des chercheurs du MIT, de Princeton et de l’université de Stanford, demande des protections juridiques et techniques pour la recherche de bonne foi sur les modèles d’IA générative, qui, selon eux, entrave les mesures de sécurité qui pourraient contribuer à protéger le public. La lettre, et l’étude qui la sous-tend, ont été rédigées avec l’aide d’une vingtaine de professeurs et de chercheurs qui ont demandé « un cadre légal de sécurité » pour l’évaluation indépendante des produits de GenIA.

Militer pour des red teams

Ce document, envoyé à des entreprises comme OpenAI, Anthropic, Google, Meta et Midjourney, demande un droit d’accès des chercheurs aux produits afin de s’assurer que les consommateurs sont protégés contre les préjugés, les violations présumées des droits d’auteur et les images intimes non consensuelles. « Nombreux sont ceux qui estiment que l’évaluation indépendante des modèles d’IA déjà déployés est essentielle pour garantir la sûreté, la sécurité et la confiance », ont écrit deux des chercheurs dans un billet de blog. « Des recherches indépendantes sur les modèles d’IA ont permis de découvrir des vulnérabilités liées aux langages à faibles ressources, au contournement des mesures de sécurité et à un large éventail de jailbreaks. « Ces évaluations portent sur des défauts très divers souvent imprévus que l’on peut trouver dans les modèles, liés soit à une mauvaise utilisation, à des préjugés, à des droits d’auteur et à d’autres problèmes », ont-ils ajouté.

Parmi les signataires figurent des professeurs des écoles de l’Ivy League et d’autres universités réputées, dont le MIT, ainsi que des dirigeants d’entreprises comme Hugging Face et Mozilla. La liste comprend également des chercheurs et des éthiciens comme Dhanaraj Thakur, directeur de recherche au Center for Democracy and Technology (Centre pour la démocratie et la technologie), et Subhabrata Majumdar, président de l’AI Risk and Vulnerability Alliance.

Plus d’ouverture et de transparence souhaitées

Si la lettre reconnaît et se réjouit du fait que certains fabricants de genAI disposent de programmes spéciaux pour permettre aux chercheurs d’accéder à leurs systèmes, elle leur reproche aussi d’être trop restrictifs quant aux personnes qui peuvent ou ne peuvent pas voir leur technologie. Les chercheurs ont notamment cité les entreprises d’IA Cohere et OpenAI comme des exceptions à la règle, « même si une certaine ambiguïté subsiste quant à la portée des activités protégées ». Cohere autorise les « tests de résistance intentionnels de l’API et les attaques adverses » à condition que les vulnérabilités soient divulguées de manière appropriée (sans promesse légale explicite). Et OpenAI a élargi sa sphère de sécurité pour inclure la « recherche sur la vulnérabilité des modèles » et la « recherche universitaire sur la sécurité des modèles » en réponse à une première version de notre proposition.

Mais, dans d’autres cas, les entreprises de genAI ont suspendu les comptes des chercheurs et même modifié leurs conditions de service pour décourager certains types d’évaluation. Or, selon les chercheurs, « priver les chercheurs indépendants de leur pouvoir n’est pas dans l’intérêt des entreprises d’IA ». Les évaluateurs indépendants qui étudient les produits d’IA générique craignent la suspension de leur compte (sans possibilité d’appel) et les risques juridiques, « qui peuvent tous deux avoir un effet dissuasif sur la recherche », selon la lettre ouverte.

Pour protéger les utilisateurs, les signataires souhaitent que les entreprises d’IA offrent deux niveaux de protection à la recherche :

– Une protection juridique pour garantir une recherche indépendante de bonne foi sur la sûreté, la sécurité et la fiabilité de l’IA, le tout dans le cadre d’une divulgation bien établie des vulnérabilités.

– Un engagement de l’entreprise en faveur d’un accès plus équitable en faisant appel à des évaluateurs indépendants pour modérer les demandes d’évaluation des chercheurs.

Dans l’immédiat, les deux entreprises OpenAI et Google n’ont pas répondu à une demande de commentaire.

Depuis plus de deux ans, GitHub développe sa propre plateforme d’IA générative baptisée Copilot pour aider les développeurs à coder. L’outil a gagné en fonctionnalité et son adoption apporte des gains de productivité importants pour les programmeurs, souligne Kyle Daigle, COO de l’éditeur dans un entretien.

Ciblant les développeurs pour créer, stocker, gérer et partager leur code, Github s’est engagé sur la voie de l’IA générative (genAI) avant même que ChatGPT ou Copilot ne soit largement accessible au public. Grâce à un partenariat précoce avec OpenAI et Microsoft (qui l’a racheté 7,5 Md$ en 2018), le spécialiste du partage de code a amélioré et optimisé son outil. D’aucuns pensent qu’à mesure que la genAI continue d’évoluer et peut produire davantage de code en se basant uniquement sur les demandes des utilisateurs, les développeurs ne seront plus nécessaires. Comme l’a déclaré dernièrement le CEO de Nvidia, Jensen Huang, grâce à l’IA, « tout le monde dans le monde est maintenant un programmeur ». C’est donc cela le miracle de l’intelligence artificielle ? Au lieu de développer des logiciels, le patron de Nvidia pense ainsi que les humains devraient se concentrer sur des compétences plus importantes telles que la biologie, l’éducation, la fabrication ou l’agriculture… au point de voir le langage de programmation et le langage humain ne faire qu’un.

Travaillant chez GitHub depuis 11 ans, Kyle Daigle est directement impliqué dans ces sujets et ces réflexions puisqu’il a pris la direction des opérations du groupe il y a environ un an et a justement participé à la stratégie de développement de la genAI, qui vise à découvrir comment la technologie peut profiter à ses quelque 3 000 employés – développeurs et non-développeurs – et à sa communauté externe d’utilisateurs. Jusqu’à présent, la genIA permet aux codeurs d’être 55 % plus productifs, a notamment indiqué Kyle Daigle dans une interview accordée à notre confrère Computerworld à propos des différentes façons dont la genAI a apporté des gains d’efficacité et aidé les développeurs et les non-développeurs.

IDG NS. Quand avez-vous déployé Copilot ? Pourquoi ? Et qu’est-ce qu’il a permis à GitHub de faire ?

Kyle Daigle. Cela fait maintenant deux ans et demi que nous travaillons sur Copilot. Nous avons commencé à travailler dessus lorsque nous avons obtenu un accès anticipé aux modèles OpenAI dans le cadre de notre partenariat avec Microsoft. Comme pour beaucoup d’entreprises aujourd’hui, la question principale était de savoir comment utiliser ces LLM à bon escient. Il nous a fallu un certain temps pour mettre au point la sauce secrète qui a donné naissance à Copilot. À l’origine, lorsque nous utilisions les modèles, nous pensions que nous allions construire des outils pour documenter le code. Vous savez, vous lui donnez votre référentiel et il vous dit ce que fait ce code. Mais au fil des expériences, l’idée du « texte fantôme » – un certain modèle d’achèvement de ce que fait Copilot en montrant l’intégralité d’un message plutôt qu’une seule ligne – a été une sorte de grande avancée pour pouvoir tirer le meilleur parti d’un outil puissant. Aujourd’hui, plus d’un million d’utilisateurs de GitHub utilisent Copilot chaque jour. Nos statistiques montrent qu’il les rend 55 % plus productifs et qu’il écrit environ 60 % du code. Nous prévoyons que cette part atteindra environ 80 % au fil du temps dans de nombreux langages.

Je pense que le plus important, et nous en parlons beaucoup à nos équipes internes, c’est que les développeurs se sentent plus épanouis. Ils effectuent un travail plus créatif et non pas de fourmi. Au lieu de chercher à ce que la genAI se charge du créatif, nous offrons à l’humain d’être dans le siège du pilote en tant que développeur. Nous avons donc réussi à faire en sorte que tous les développeurs de notre environnement utilisent GitHub pour les aider à écrire du code. En interne, nous nous sommes attachés à tirer les leçons de Copilot et à les appliquer à d’autres domaines dans lesquels nous utilisons des outils d’IA en dehors des cas d’utilisation liés au développement de logiciels; et aussi pour nous aider à être un peu plus productifs.

L’aide au développement du code semble être l’un des premiers fruits à portée de main auquel votre plateforme genAI s’est attaquée. Depuis combien de temps l’utilisez-vous pour aider à la production de code et avec quels langages ?

Lors de nos premières expériences, nous travaillions beaucoup en Python, en JavaScript et dans d’autres langages de ce type. GitHub est principalement une entreprise Ruby, mais nous écrivons également en Go, en C et en FirGit. Nous avons donc élargi les cas d’utilisation de Copilot et l’avons utilisé dans différents langages. Mais dans l’ensemble il est capable de fonctionner avec la grande majorité des langages de la sphère publique. Si vous avez un langage propriétaire, il peut l’émuler parce qu’il regarde le code à l’intérieur de votre référentiel et il peut faire un très bon travail pour déterminer ce qu’il doit utiliser pour alimenter la prochaine ligne de code ou la prochaine méthode. Nous sommes donc passés de quelques langages de test à pratiquement tous les langages de programmation modernes qui ont un contexte suffisant dans l’open source et Internet.

Où en est Copilot en ce qui concerne la complétion de code ?

En termes de taux de complétion de code, ce dont nous parlons, c’est que dans certains cas, lorsque vous écrivez avec Copilot, il peut terminer une ligne de code, mais il peut aussi compléter une méthode entière, un fichier ou une classe entière, en fonction du langage que vous utilisez. Avec un outil comme Copilot Chat, vous pouvez parler à Copilot et lui dire voici le problème que j’essaie de résoudre, et il peut potentiellement générer l’intégralité d’un fichier pour vous. Vous pouvez alors dire je ne veux pas qu’il soit bleu, je veux qu’il soit rouge ou je veux qu’il utilise telle ou telle API comme ce genre d’ajustements. Lorsque nous parlons de la quantité de code générée, nous parlons de la quantité de code que Copilot a fourni et de la quantité que l’utilisateur a conservée au fil du temps. Évidemment, lorsque vous obtenez un résultat, vous pouvez penser oh, ce n’est pas correct ou si vous êtes un développeur, vous pouvez penser que le code n’est pas correct, en écrire un tas d’autre et vous rendre compte qu’il n’est pas possible de le remanier tout de suite. Mais en fait ce n’est pas tout à fait correct.

Ce que nous constatons, c’est que la grande majorité du code généré par la solution est conservé. Ensuite, après avoir écrit des codes, soumis un PR, exécuté l’intégration continue, les étapes suivantes sont également plus rapides. Ainsi, l’examen du code écrit par Copilot avec un développeur tend à être plus rapide parce que le code finit par être meilleur. L’intégration continue aboutit plus souvent à un feu vert que rouge lors de la première version parce que le code tend à être plus correct. Il y a donc beaucoup d’impacts intéressants en aval, également, lorsque vous êtes en mesure d’utiliser Copilot dans le cadre de votre charge de travail en tant que développeur.

Avez-vous constaté des problèmes – des inexactitudes – lors de l’utilisation de Copilot ?

Le code que nous vous fournissons imite également celui qu’il voit dans votre dépôt. Ainsi, dans certains cas, si la base de code est plus ancienne, il en tiendra compte et appliquera peut-être une pratique qui n’est plus moderne, comme le casing des variables ou si vous avez une bibliothèque qu’il appellera parce qu’il essaie d’émuler votre projet existant ainsi que le modèle sous-jacent. Pour certains développeurs, la solution consiste à utiliser le chat de Copilot pour dire nous sommes en train de mettre à jour ce projet, j’aimerais donc utiliser la nouvelle approche. C’est l’un des moyens de résoudre ce problème. Mais nous nous appuyons aussi sur l’outil pour trouver d’autres moyens d’aider les développeurs à rester en sécurité en corrigeant également les vulnérabilités. Ainsi, l’une des choses que nous avons partagées lors de la conférence GitHub Universe en novembre s’appelait Security Autofix, qui utilise une technologie d’IA sous-jacente similaire. Ainsi, lorsque vous lui dites que vous avez connaissance d’une vulnérabilité dans une base de code, nous n’allons pas seulement vous dire que vous avez une vulnérabilité que vous devez corriger. Nous allons également procéder à la correction sur place. Tout ce que vous avez à faire, c’est de dire oui, je suis prêt à le faire.

Copilot est donc toujours dans le siège de copilote. Vous devez toujours suivre les meilleures pratiques. Il est toujours nécessaire d’effectuer des analyses de sécurité et des analyses secrètes et toutes les choses qui ont été vraies pour les bonnes pratiques de développement de logiciels, quoi qu’il en soit. Mais nous essayons de trouver des moyens d’introduire l’IA dans l’ensemble du cycle de vie du développement logiciel sur GitHub pour vous aider. Ce n’est donc pas seulement dans votre IDE lorsque vous écrivez du code.

Certains acteurs du secteur IT craignent que la capacité de l’IA à générer automatiquement du code évincent les développeurs. Qu’en pensez-vous ?

Je pense qu’au cours de l’histoire moderne, il y a eu tant de moments où un élément technologique est apparu dans le monde, comme la presse à imprimer, que tout le monde s’est dit attendez une minute mon travail va-t-il disparaître ? Mais en réalité, ce qui s’est passé, c’est que beaucoup de travaux et d’opportunités qui n’étaient plus rentables l’ont soudain été, parce que les développeurs ne passent plus 60 à 70 % de leur temps à résoudre des problèmes qui ont été résolus des dizaines, des centaines et des milliers de fois. La réalité, c’est que GitHub Copilot rend les développeurs 55 % plus productifs. Certains clients ont réagi en disant est-ce que cela signifie que je récupère 55 % du temps de travail de mes développeurs ? En réalité, vos développeurs gagnent la capacité de résoudre des problèmes plus difficiles de manière plus créative qu’ils ne pouvaient le faire auparavant lorsqu’ils devaient faire tout ce travail eux-mêmes. Chez GitHub, nous recrutons toujours des développeurs. Nous embauchons en ce moment même. Ce que nous constatons, c’est que nous consacrons plus de temps à la discussion initiale ou à l’architecture et au problème que nous résolvons avec les clients. Car plus le codage devient rapide, plus il est important de consacrer son temps à la résolution créative de problèmes plutôt qu’au travail routinier que nous avons tous effectué à un moment ou à un autre de notre carrière.

Je suis plus excité par ce que l’IA commence à nous apporter tel la capacité de résoudre des problèmes plus importants qui n’étaient peut-être pas possibles avant, comme la réécriture complète d’une application. Beaucoup de clients remettent cela à plus tard, car ils se demandent comment ils pourraient se le permettre. Mais si c’est 50 % moins cher, vous pourrez peut-être passer à cette nouvelle technologie et l’utiliser pour résoudre encore plus rapidement la prochaine série de problèmes. Je pense qu’il nous reste beaucoup de travail à faire. Selon tous les analystes, il n’y a pas assez de développeurs dans le monde. Il y a donc du chemin à parcourir avant de devoir nous inquiéter du manque de travail des développeurs.

Quels sont les avantages de la genAI pour les équipes qui ne sont pas des développeurs ?

L’un des principaux éléments de Copilot qui n’est pas assez estimé est la capacité d’apprentissage et de développement (learn and development), ou d’amélioration des compétences au bureau. Vous avez quelqu’un qui est nouveau dans un rôle, une entreprise, une langue et vous pouvez venir et avoir immédiatement quelqu’un à qui vous pouvez poser des questions, avec qui vous pouvez écrire du code et obtenir cette boucle de rétroaction immédiate avec Copilot. Il ne s’agit pas seulement des nouveaux arrivants. Dans de nombreux cas, les développeurs les plus expérimentés se voient confier ces vieux projets qui sont extrêmement importants pour l’entreprise, mais qui sont restés sur les étagères, dans un placard, pour assurer son bon fonctionnement. Lorsqu’ils ont besoin d’aller dans ces projets et de faire des mises à jour, l’aspect L&D a été vraiment important parce qu’ils peuvent y aller et dire je connais Java, mais je ne connais pas Scala ou je connais Java, mais je ne connais pas .Net ou autre chose. Et pouvez-vous m’aider à savoir quelles sont les prochaines étapes ? Dans le même ordre d’idées, nous axons également Copilot sur l’expérience de l’utilisateur, c’est-à-dire qu’il suffit de commencer à taper. Il n’y a pas de véritable formation, il n’y a pas d’apprentissage, il n’y a pas de boutons à comprendre. J’ai donc pris ces deux enseignements et nous avons commencé à chercher en interne d’autres endroits où nous pensions qu’il y avait du travail et où nous pouvions mettre en œuvre l’IA sans avoir à l’activer. C’est là le véritable secret. Si vous devez apprendre aux gens comment l’utiliser, ce n’est pas beaucoup mieux que n’importe quel autre choix technologique que vous pourriez faire.

Quelles ont été vos autres grandes victoires ?

L’une des premières grandes victoires que nous avons remportées chez GitHub, et j’ai vu cela dans d’autres endroits, c’est de prendre l’IA et de l’amener dans l’environnement de l’informatique. Nous avons un peu plus de 3 000 Hubbers [employés de GitHub] qui ont saisi des centaines et des centaines de tickets [d’assistance] dans un ancien système, pour obtenir de l’aide sur la raison pour laquelle leur ordinateur portable ne fonctionne pas, sur la manière d’accéder au VPN, etc. GitHub fonctionne essentiellement avec Slack. Nous sommes une entreprise qui fonctionne d’abord à distance. Nous avons des employés dans le monde entier, nous ne sommes pas une entreprise qui retourne au bureau. Ce que nous avons fait, c’est dire, si nous sommes tous sur Slack, pourquoi ne pas faire en sorte que l’interaction avec le service informatique dans cet outil soit également alimentée par l’IA ?

Ainsi, au lieu d’aller sur un portail et de soumettre un ticket, nous avons un canal appelé IT Help Desk, et dans ce canal se trouve un bot que nous appelons OctoBot. Lorsque vous posez une question, un fournisseur appelé MoveWorks, avec lequel nous avons conclu un partenariat, voit cette question et OctoBot vient vous dire oui, je sais exactement ce que vous devez faire. Voici les prochaines étapes. Et dans de nombreux cas, nous pouvons même automatiser le flux de travail pour dire nous allons configurer ceci dans ces autres systèmes pour vous. Peut-être que c’est ce que veulent tous les développeurs. Cliquez sur ce bot et nous vous enverrons votre nouvel ordinateur portable. Comme nous n’avons pas créé de nouveau système et que nous n’avons pas eu à former qui que ce soit à un nouveau portail, nous avons constaté une énorme amélioration. OctoBot résout aujourd’hui 30 % des problèmes dès le départ. Nous gagnons des heures par jour sur le temps de chaque membre du personnel informatique, que nous pouvons réinvestir dans d’autres initiatives d’IA.

Le plus intéressant c’est que la satisfaction des clients a augmenté de 12 points. Aujourd’hui, le taux de satisfaction est de 98 %. Je n’ai pas eu à former qui que ce soit. Nous n’avons pas eu à déployer cette technologie comme on le ferait normalement dans une entreprise. Nous l’avons simplement mise en place là où tout le monde demandait déjà de l’aide. Je pense que c’est là le grand secret : lorsque je parle à des collègues d’autres entreprises de la manière dont on peut supprimer les tâches et faire gagner du temps aux gens tous les jours sans introduire de nouveaux comportements, je me dis que c’est un bon exemple. En voici un : nous sommes en train de tester six ou sept autres outils au sein de l’entreprise à partir de ce processus. Environ 10 % de nos employés participent à une sorte d’essai d’outil d’IA, dans le cadre duquel nous suivons le même processus : comment faire sans habilitation ? Pouvons-nous l’intégrer dans le flux ? Ensuite, nous mesurons simplement le temps gagné de l’autre côté. Si nous gagnons du temps et que l’outil est rentable, nous continuons à progresser. Ce que nous ne faisons pas, c’est d’avoir un outil sur lequel il faut se renseigner, être formé, ou qui est très ouvert. Cet outil peut tout faire pour vous ! Car nous constatons qu’il rend les gens plus productifs, plus heureux et, en fin de compte, qu’il les libère de leur labeur.

Envisagez-vous d’autres outils de genAI ?

En ce qui concerne GitHub, nous avons repris une grande partie de la technologie Copilot sous-jacente et nous l’avons appliquée à nos cas d’utilisation de l’assistance. Ainsi, lorsque vous êtes sur GitHub, que vous avez un problème et que vous devez saisir un ticket, c’est très similaire à ce que nous avons appris de notre expérience en matière d’informatique. Lorsque vous commencez à suivre le flux, et nous suivons le processus normal pour résoudre le problème, il y a une étape où vous pouvez finir par parler à Copilot. Nous l’appelons Support Copilot. Il est capable de vous guider dans le contexte de votre demande et de l’accès dont vous disposez, et de résoudre potentiellement votre problème sur-le-champ.

De l’autre côté, en regardant vers l’extérieur, nous avons également dépassé l’idée que Copilot vous aide à écrire du code et à résumer une demande d’extraction. Que se passe-t-il lorsque l’on renverse le modèle et que l’on commence à décrire à Copilot le problème que l’on cherche à résoudre ? C’est l’exploration sur laquelle nous travaillons et que nous appelons Copilot Workspace. Essentiellement, au lieu de commencer directement dans le code, vous commencez par un problème : vous commencez par une question GitHub décrivant ce que vous essayez d’accomplir. Copilot peut prendre cela et aller de la prose [messages écrits] de ce que vous essayez de faire, au code, puis vous pouvez éditer la prose et cela changera le code. Ensuite, vous pouvez modifier le code si nécessaire. Enfin, il peut le tester, l’exécuter, le construire et le déployer à partir du langage naturel. C’est un domaine que nous essayons de dépasser et de trouver comment écrire plus de code, plus rapidement et avec plus de précision. Parfois, le meilleur code n’est pas de code du tout et il s’agit simplement d’utiliser le langage humain.

Comment déterminez-vous le retour sur investissement et avez-vous calculé le retour sur investissement de cette technologie ?

Vous pouvez mesurer un million de choses [en interne] ; c’est également vrai pour le développement de logiciels. Dans le développement de logiciels, il existe des pratiques qui permettent de mesurer les paramètres DORA – cette idée de la quantité de code que l’on fait passer dans le pipeline. Vous pouvez mesurer les paramètres d’espace. Il existe toutes sortes de méthodes. En interne, lorsque nous essayions de travailler sur ces cas d’utilisation informatique, c’était la même chose. Combien de tickets sont détournés ? Combien de tickets ont été fermés ? En fin de compte, nous mesurons tous l’activité. En fin de compte, ce que nous essayons de mesurer, c’est le temps. Combien de temps récupérez-vous ? Pour moi, lorsque nous effectuons toutes ces mesures, le retour sur investissement est intégré parce que nous récupérons le temps que les employés utilisaient auparavant pour résoudre ces tickets, effectuer des flux manuels, écrire du code – peu importe ce que c’est.

Nous prenons donc ce temps et l’investissons dans des activités plus stratégiques. Le retour sur investissement a donc été très clair pour l’idée de l’OctoBot ; les 55 % de productivité supplémentaire sont en fin de compte réinvestis automatiquement parce que vous êtes capable d’avancer plus rapidement en tant que développeur de logiciels, et nous essayons d’autres outils qui redonnent aux employés, potentiellement, de 30 minutes à une heure par jour. Ils peuvent ainsi se consacrer à des tâches plus stratégiques pour nos clients et avancer plus rapidement. Je pense que vous pouvez le constater chez GitHub : nous avons l’impression de pouvoir faire beaucoup plus qu’avant, et ce n’est pas parce que nous avons connu une croissance de 50 % au cours de l’année écoulée, c’est parce que nous sommes capables de réinvestir ce temps.

Quels conseils donneriez-vous aux entreprises qui envisagent d’utiliser ou d’étendre leur utilisation de l’IA générique ?

La meilleure chose que les entreprises puissent faire pour démarrer est de trouver des méthodes pour intégrer l’IA dans les flux de travail existants – les équipes n’ont pas besoin de réinventer la roue, car il est plus facile d’utiliser des fonctionnalités d’IA qui restent dans le flux, et non pas qui exigent un comportement tout à fait nouveau. Rencontrez les employés là où ils sont, donnez-leur les outils d’IA dont ils ont besoin, et ils finiront par en faire l’évangélisation auprès des autres. Voici quelques autres conseils tirés de mon expérience chez GitHub : élaborez un plan que vous pourrez répéter. Nous ne sommes plus à l’époque où il fallait aller vite et tout casser, mais ce n’est pas non plus le moment d’élaborer une stratégie de déploiement unique sur six mois. Mais des décennies d’écriture de logiciels nous ont appris que l’itération est plus importante qu’un énorme projet de réécriture que l’on espère correct. Il est important de piloter souvent, tôt, en petits groupes.

Vous devez faire de l’expérimentation un élément central de votre culture. Chez GitHub, cela se traduit par l’implication de plus de 10 % de notre entreprise dans des projets pilotes d’IA. Laissez l’IA se charger de votre travail. Les meilleurs outils d’IA sont ceux qui permettent à nos meilleures qualités humaines de briller. Concentrez-vous sur ce qui distrait les employés de leur travail – comme la gestion des calendriers par exemple – et laissez l’IA se charger du travail pour que vos employés puissent libérer leur créativité de manière plus importante et plus profonde.

Selon Palo Alto, si les réseaux 5G privés offrent une certaine efficacité, la protection des ressources 5G privées est souvent un défi pour les entreprises.

L’engouement pour la 5G privée d’entreprise est en hausse, tout autant que les préoccupations sur la sécurité de ces réseaux. L’architecture d’un réseau 5G privé est complexe et peut grandement étendre la surface d’attaque, bien plus que les autres technologies sans fil. Pour protéger les déploiements 5G des entreprises, Palo Alto Networks s’est associé à plusieurs fournisseurs afin d’offrir des produits et des services de sécurité intégrés. « Les réseaux 5G privés peuvent apporter une efficacité considérable, mais leur protection peut représenter un défi pour les entreprises, quelle que soit leur taille », a déclaré Anand Oswal, vice-président senior et directeur général de Palo Alto. « À mesure qu’elle se connecte avec des appareils, des réseaux et des services IT, OT ou IoT, l’architecture de réseau privé 5G se complexifie de plus en plus, exposant sa surface d’attaque à d’autres vecteurs de la menace, d’où la nécessité de mettre en œuvre de nouveaux systèmes de gestion de la sécurité de bout en bout », a expliqué M. Oswal.

« La gestion et le renforcement de tous les points de sécurité des infrastructures radio, itinérante et Internet peuvent s’avérer difficile pour les entreprises, d’autant que les vecteurs de la menace, connexions de commande et de contrôle, exploits DNS, ransomware, logiciels malveillants, fuites de données, etc., ne manquent pas ! », a reconnu le vice-président senior et directeur général de Palo Alto. « Dans les environnements 5G privés, jusqu’à 90 % des menaces se produisent par le biais des ordinateurs portables qui sont souvent déplacés, ou via des capteurs et d’autres appareils IoT qui ne sont pas activement gérés », a constaté Palo Alto. « Alors que les clients numérisent leurs opérations, nous voulons nous assurer que la sécurité est prise en compte dès le départ et qu’elle n’est pas ajoutée après coup », a ajouté M. Oswal.

S’allier pour maitriser toutes les stacks

C’est pour cette raison que l’entreprise a développé un écosystème de fournisseurs qui intégreront leurs propres technologies de sécurité à l’ensemble privé de sécurité 5G de Palo Alto afin d’offrir une protection plus complète. Quelques fournisseurs, comme Nvidia, Celona et NetScout, travaillent déjà avec Palo Alto.

Nvidia : Pour sécuriser les applications basées sur l’IA dans les réseaux 5G privés, Palo Alto associe sa technologie Intelligent Traffic Offload (ITO) et son pare-feu virtuel de nouvelle génération (Virtual Next-Generation Firewall, NGFW) à l’unité de traitement des données (Data Processing Unit, DPU) Nvidia BlueField pour améliorer le volume d’inspection des menaces tout en réduisant les coûts d’infrastructure. « La prochaine solution de passerelle de sécurité 5G de Palo Alto fournit une sécurité à l’échelle en chiffrant le trafic entre de nombreux objets connectés et les réseaux de centres de données », a expliqué Anand Oswal.

Celona : Un partenariat avec Celona, spécialiste de la sécurité 5G-LAN, apporte la sécurité zero-trust aux réseaux sans fil privés 4G et 5G. La solution intégrée des fournisseurs offre une visibilité et un accès sécurisé pour les appareils d’entreprise connectés à l’infrastructure cellulaire 5G privée.

NetScout : « Palo Alto et NetScout se sont associés pour offrir une visibilité des services de bout en bout, ce qui est essentiel pour garantir l’expérience du client tout en monétisant le comportement de l’appareil et de l’utilisateur final », a affirmé M. Oswal.

D’autres fournisseurs comme NTT Data, Druid et Ataya développent aussi des offres intégrées de sécurité privée 5G avec Palo Alto. Palo Alto s’est également associé récemment à UScellular pour offrir des services de sécurité 5G basés sur le zero-trust.

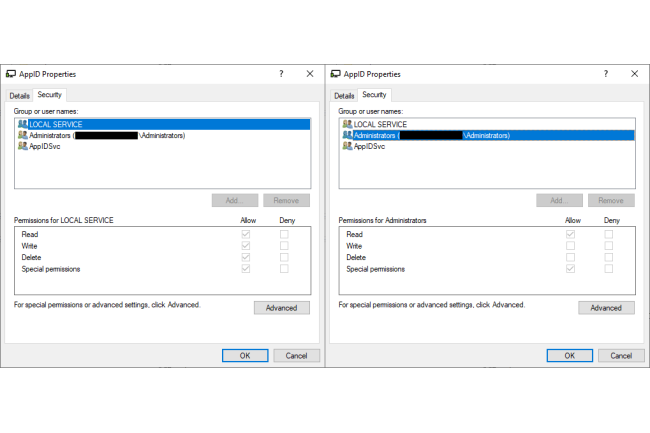

Le groupe APT Lazarus, affilié à la Corée du Nord a actualisé son rootkit FudModule pour intégrer la faille AppLocker. Elle lui octroie une élévation de privilèges dans le noyau Windows.

Le Patch Tuesday de février corrigeait une faille critique provoquant une élévation de privilèges dans le noyau Windows. Des chercheurs d’Avast ont constaté que cette vulnérabilité a été exploitée par un groupe APT du nom de Lazarus, affilié à la Corée du Nord au sein de son rootkit FudModule. Ce dernier « utilise désormais une technique de manipulation des entrées de la table de gestion pour tenter de suspendre les processus protégés PPL (Protected Process Light) associés à Microsoft Defender, CrowdStrike Falcon et HitmanPro, ce qui représente une avancée majeure dans leur technique d’attaque », précise les experts dans un rapport.

La vulnérabilité AppLocker remplace le BYOVD

Également connu sous le nom d’APT38, le groupe Lazarus est l’une des équipes de pirates informatiques du gouvernement nord-coréen, impliquée autant dans le cyberespionnage et le sabotage, que, parfois, dans des actions de cybercriminalité en vue collecter de l’argent pour le régime. Ses opérations remontent à plusieurs années, mais certains chercheurs pensent que Lazarus fédère probablement différents sous-groupes qui mènent leurs propres campagnes et développent des logiciels malveillants sur mesure pour leurs cibles. Le rootkit FudModule n’est pas un nouveau venu dans la panoplie d’outils de Lazarus et il a déjà été analysé par d’autres entreprises de cybersécurité en 2022.

FudModule est un rootkit de données uniquement qui existe dans l’espace utilisateur et exploite les privilèges de lecture/écriture du noyau par le biais de pilotes pour altérer les mécanismes de sécurité de Windows et réduire la capacité des produits de sécurité à détecter d’autres composants malveillants. Dans les versions précédentes, les attaquants obtenaient des privilèges en exploitant des vulnérabilités connues dans des pilotes tiers signés qu’ils déployaient sur le système avec le logiciel malveillant. Cette technique est connue sous le nom de BYOVD « Bring Your Own Vulnerable Driver » (Apporter son propre pilote vulnérable). Pour installer un pilote sous Windows, il faut disposer de privilèges d’administrateur, de sorte que les attaquants disposent déjà de privilèges élevés sur les systèmes.

Des techniques de rootkit améliorées

Le rootkit FudModule utilise son accès en lecture/écriture au noyau pour désactiver certaines fonctions importantes sur lesquelles s’appuient les produits de sécurité pour détecter les comportements suspects : les rappels de registre, servant à détecter les modifications du registre du système ; les rappels d’objet, utilisés pour exécuter du code personnalisé en réponse aux opérations de gestion de thread, de processus et de bureau ; et les rappels de processus, de thread et d’image du noyau, qui permettent aux produits de sécurité des points finaux d’effectuer des vérifications à chaque fois que de nouveaux processus sont créés ou que des DLL sont chargées. Le rootkit FudModule supprime tous ces types de rappels enregistrés par les produits de sécurité dans le noyau afin d’affaiblir leurs capacités de détection des logiciels malveillants. Cette dernière variante n’apporte que des modifications mineures aux rappels qu’elle supprime. Le rootkit supprime également les minifiltres du système de fichiers enregistrés par les programmes antivirus pour surveiller les opérations sur les fichiers. Une nouvelle fonctionnalité du rootkit consiste à désactiver les rappels de vérification d’image invoqués lorsqu’une nouvelle image de pilote est chargée dans la mémoire du noyau. Cette fonctionnalité est exploitée par certains programmes anti-malware pour détecter et bloquer les pilotes malveillants ou vulnérables.

Même si tout cela à l’air d’aider les attaquants avec leur technique BYOVD, il n’est pas très logique de désactiver ces rappels après avoir déjà chargé un pilote compromis pour déployer le rootkit. Ce serait alors trop tard, à moins que les attaquants ne prévoient de charger d’autres pilotes malveillants dans un but quelconque après que le rootkit a été déployé. On sait que, dans le passé, Lazarus a déjà utilisé certains pilotes personnalisés afin d’effectuer des attaques par effacement de disque. Une autre technique de rootkit mise en œuvre dans cette version vise à désactiver directement des produits de sécurité spécifiques, à savoir AhnLab V3 Endpoint Security, Windows Defender, CrowdStrike Falcon et HitmanPro. « Le groupe Lazarus reste l’un des acteurs les plus prolifiques et les plus anciens de la menace persistante avancée. Même si leurs tactiques et techniques sont désormais bien connues, ils parviennent encore parfois à nous surprendre avec un niveau inattendu de sophistication technique », ont déclaré les chercheurs d’Avast. « Le rootkit FudModule en est le dernier exemple et il représente l’un des outils les plus complexes que Lazarus possède dans son arsenal ».

Des défenses existent pour l’admin to kernel

Cependant, il existe une différence entre obtenir un accès administrateur et obtenir des privilèges du noyau (SYSTEM) sous Windows. Ces rôles fonctionnent à des niveaux d’intégrité différents et sont soumis à des limitations différentes, mais Microsoft ne considère pas officiellement l’accès administrateur au noyau comme une limite de sécurité, car il existe plusieurs façons d’exécuter le noyau à partir d’un compte administrateur – par exemple, le BYOVD, car les pilotes tiers mal écrits ne manquent pas. Tout compte administrateur peut installer un pilote et tout pilote est chargé dans le noyau. « Microsoft n’a pas renoncé à sécuriser la frontière entre l’administrateur et le noyau », ont encore expliqué les chercheurs d’Avast. « Bien au contraire, l’entreprise a fait beaucoup de progrès pour rendre cette frontière plus difficile à franchir. Les protections de défense en profondeur, comme l’application du Driver Signature Enforcement (DES) ou Hypervisor-Protected Code Integrity (HVCI), ont rendu l’exécution de code personnalisé dans le noyau de plus en plus difficile pour les attaquants.

Ils ont été obligés la plupart d’entre eux à recourir à des attaques par données uniquement (où ils atteignent leurs objectifs malveillants uniquement en lisant et en écrivant dans la mémoire du noyau). D’autres défenses, comme la mise en liste bloquée des pilotes, poussent les attaquants à exploiter des pilotes vulnérables moins connus, ce qui augmente la complexité des attaques. Même si ces défenses n’ont pas encore atteint le point où l’on peut officiellement qualifier la barrière admin-to-kernel de frontière de sécurité (les attaques BYOVD sont toujours possibles, donc l’appeler ainsi ne ferait qu’induire les utilisateurs en erreur et leur donner un faux sentiment de sécurité), elles représentent clairement des pas dans la bonne direction.

Un patch existe

La nouvelle vulnérabilité CVE-2024-21338 exploitée par Lazarus est située dans appid.sys, c’est-à-dire le moteur central d’AppLocker, la technologie de liste blanche d’applications intégrée à Windows, ce qui est assez ironique. Microsoft a attribué à cette vulnérabilité un score de 7,8 sur 10 sur l’échelle CVSS. Avast pense que ce score élevé est dû au fait que la faille pourrait aussi être exploitée à partir du compte de service local, qui a des privilèges encore plus réduits par rapport aux administrateurs.

« Même si la vulnérabilité ne répond que très partiellement aux critères de sécurité de Microsoft, nous pensons que l’application d’un correctif était le bon choix et nous tenons à remercier Microsoft d’avoir finalement résolu ce problème », ont déclaré les chercheurs d’Avast. « Le correctif perturbera sans aucun doute les opérations offensives de Lazarus, les obligeant à trouver un autre zero-day admin-to-kernel ou à revenir à des techniques BYOVD ».