Sous l’impulsion de la Maison Blanche, un groupe de travail composé de parlementaires américains va rédiger un rapport comprenant des principes directeurs ainsi que des recommandations pour aider le pays à tirer parti des technologies IA en atténuant les risques.

Les Européens avec l’IA Act ne sont pas les seuls à vouloir encadrer et mesurer les risques liés à l’intelligence artificielle. Dans le cadre d’un nouvel effort visant à promouvoir la réglementation de l’IA, les membres de la Chambre des représentants des États-Unis ont formé un groupe de travail bipartisan chargé d’étudier une législation visant à répondre aux inquiétudes et aux préoccupations croissantes liées à l’adoption de l’IA. « Le groupe de travail s’efforcera de produire un rapport complet comprenant des principes directeurs, des recommandations tournées vers l’avenir et des propositions politiques bipartisanes élaborées en consultation avec les comités compétents », indique le communiqué de presse annonçant le groupe de travail. Ce dernier explorera « les garde-fous qui pourraient être appropriés pour protéger la nation contre les menaces actuelles et émergentes ».

Une stratégie technologique responsable et éthique est essentielle pour les avantages à long terme de l’IA, a souligné Charlie Dai, vice-président et analyste principal chez Forrester. « Les efforts législatifs potentiels inciteront les entreprises et les fournisseurs de technologie à rééquilibrer les priorités d’investissement dans l’IA, ce qui pourrait ralentir le rythme de l’innovation d’un point de vue commercial à court terme, mais cela favorisera considérablement les progrès de l’IA en termes de sécurité, de confidentialité, d’éthique et de durabilité, ce qui sera essentiel pour la confiance du public dans l’IA à long terme ». Selon Akshara Bassi, analyste principal chez Counterpoint Research, « la réglementation de l’IA entrera en jeu lorsqu’elle fera partie d’un processus décisionnel actif. Jusqu’à présent, nous utilisons encore une intelligence basée sur des règles pour compléter la prise de décision. Au fur et à mesure que l’IA évolue et se perfectionne, la réglementation contribuera à structurer les modèles d’IA et à délimiter clairement les frontières, notamment en ce qui concerne le partage des données, la protection de la vie privée et les droits d’auteur ».

Un manque de réglementation qui peut s’avérer contre-productif

Les États-Unis ont pris plusieurs mesures pour élaborer des réglementations visant à mettre l’IA au service de la croissance économique tout en répondant aux préoccupations liées à l’adoption de l’IA. Par exemple, les voix générées par l’IA ont été déclarées illégales par la Commission fédérale des communications au début du mois. Récemment, le gouvernement américain a annoncé la création de l’US AI Safety Institute (AISI) sous l’égide du National Institute for Standards and Technology (NIST) afin d’exploiter le potentiel de l’IA tout en atténuant ses risques. Plusieurs grandes entreprises technologiques, dont OpenAI, Meta, Google, Microsoft, Amazon, Intel et Nvidia, ont rejoint le consortium pour garantir le développement sûr de l’IA. Malgré cela, l’absence de réglementations claires et bien définies peut potentiellement avoir un impact sur la croissance de l’IA dans le pays. Les retards dans la rédaction d’un ensemble complet de lois peuvent dissuader les entreprises de déployer la technologie pour développer leurs activités.

« Rien qu’en 2023, 190 projets de loi ont été déposés au niveau des États pour réglementer l’IA, et 14 sont devenus des lois. Au niveau fédéral, la Commission fédérale du commerce (FTC) a commencé à appliquer les lois existantes avec de nouveaux pouvoirs issus de décrets et une plus grande attention de la part de la direction de la FTC. Cela pourrait avoir un effet dissuasif sur l’innovation et la stratégie des entreprises en matière d’IA », selon un récent billet de blog de Michele Goetz, analyste principale, et Alla Valente, analyste principale chez Forrester. Récemment, l’Union européenne a été la première grande puissance à introduire des lois régissant l’utilisation de l’IA. Plusieurs pays, dont le Royaume-Uni et l’Australie, travaillent à l’élaboration de réglementations et de politiques afin de pouvoir utiliser l’IA en toute confiance pour développer leur économie tout en se protégeant des risques potentiels. Le lancement du ChatGPT d’OpenAI en novembre 2022 a été un bouleversement et a conduit à une augmentation significative de l’adoption de la technologie. Dans le même temps, il a soulevé plusieurs préoccupations en matière de cybersécurité et de confidentialité des données, ce qui a incité les pays à accélérer la réglementation de l’IA.

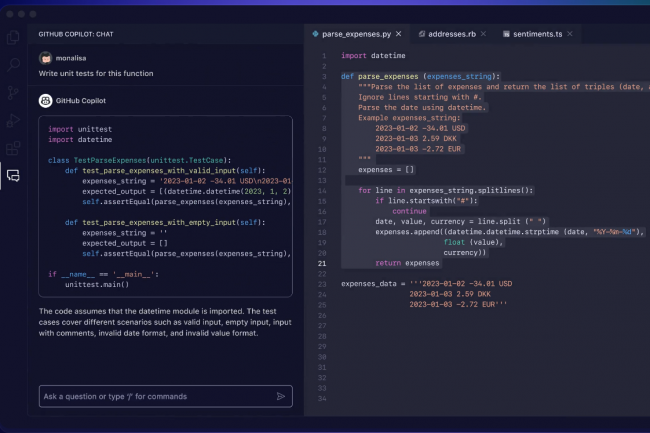

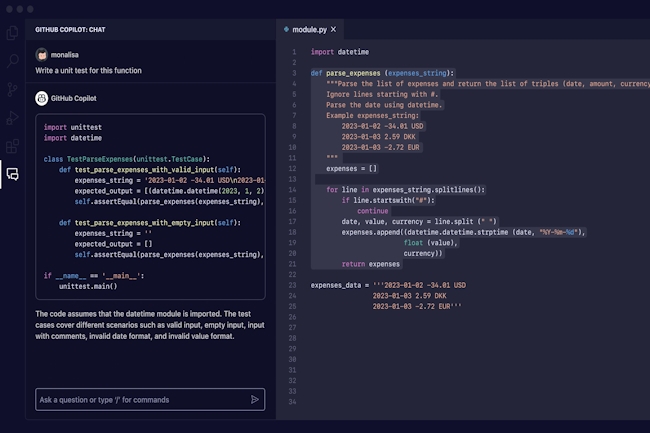

L’entreprise de sécurité des développeurs met en garde sur le fait que Copilot et d’autres assistants de codage alimentés par l’IA peuvent reproduire des vulnérabilités de sécurité déjà présentes dans la base de code de l’utilisateur.

« GitHub Copilot, l’assistant de codage de GitHub alimenté par l’IA, peut suggérer du code non sécurisé quand la base de code existante de l’utilisateur contient des problèmes de sécurité », a alerté l’éditeur Snyk. « GitHub Copilot peut reproduire les problèmes de sécurité existants dans le code », a déclaré Snyk dans un article de blog publié le 22 février. « Cela signifie que la dette de sécurité existante dans un projet peut faire que les développeurs dont le code est mal sécurisé, livrent un code encore moins sûr quand ils utilisent Copilot », a ajouté l’entreprise. Cependant, la probabilité pour GitHub Copilot de suggérer du code non sécurisé dans des projets sans problèmes de sécurité, est moins élevée, car le contexte de code dont s’inspire l’assistant est moins incertain.

« Les assistants de codage basés sur l’IA générative comme GitHub Copilot, Amazon CodeWhisperer et ChatGPT représentent un progrès considérable en termes de productivité et d’efficacité du code », a déclaré Snyk. Mais ces outils ne comprennent pas la sémantique du code et ne peuvent donc pas juger de sa qualité. GitHub Copilot génère des extraits de code en se basant sur des modèles et des structures qu’il a appris à partir d’un vaste référentiel de code existant. « Si cette approche présente des avantages, elle peut aussi présenter un inconvénient flagrant dans le contexte de la sécurité », a ajouté Snyk.

40 vulnérabilités en moyenne dans un logiciel commercial

Les suggestions de code de Copilot peuvent reproduire par inadvertance les vulnérabilités de sécurité existantes et les mauvaises pratiques présentes dans les fichiers voisins. Pour atténuer ce report des problèmes de sécurité existants dans le code généré par les assistants d’IA, Snyk conseille aux développeurs les choses suivantes :

– de procéder à des examens manuels du code. Les équipes de sécurité doivent mettre en place un garde-fou SAST (Security Application Security Testing), y compris des politiques.

– de respecter les directives de codage sécurisé. Les équipes de sécurité doivent former et sensibiliser les équipes de développement, hiérarchiser et trier les problèmes en attente par équipe. Les équipes de direction devraient imposer des garde-fous de sécurité.

Les données de Snyk indiquent qu’un projet logiciel commercial normal comporte en moyenne 40 vulnérabilités dans le code de première partie, et que près d’un tiers de ces vulnérabilités sont de haute gravité. « Les outils de génération d’IA peuvent tout à fait dupliquer le code en utilisant ces vulnérabilités comme contexte », a insisté Snyk. Les problèmes les plus courants constatés par Snyk dans les projets commerciaux sont les scripts intersites XSS, les vulnérabilité Path Traversal, l’injection SQL et les secrets et informations d’identification codés en dur. GitHub n’a pas pu être joint hier en fin d’après-midi pour répondre aux commentaires de Snyk sur GitHub Copilot.

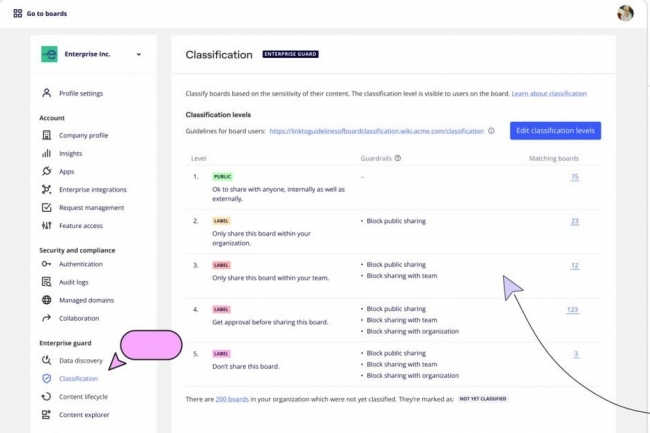

La suite Enterprise Guard permet aux utilisateurs professionnels d’identifier et de classer automatiquement les données sensibles et donne aux administrateurs informatiques un meilleur contrôle sur le cryptage.

Miro a dévoilé un ensemble d’outils de sécurité conçus pour aider les entreprises à protéger les données sensibles partagées sur son application de tableau blanc numérique. Le nouveau Miro Enterprise Guard comprend des fonctions permettant d’automatiser la détection et la classification des données sensibles, de gérer le contenu en vue d’audits juridiques et d’offrir aux administrateurs informatiques un meilleur contrôle sur le chiffrement. Selon IDC, la collaboration visuelle est l’un des domaines qui connaît la croissance la plus rapide sur le marché des logiciels collaboratifs au sens large. Les applications de tableau blanc numérique offrent aux collègues une toile partagée pour lancer des idées et planifier des projets. Miro est en concurrence avec des produits comme Mural, Figma, Microsoft et d’autres.

Comme pour toute forme de logiciel de collaboration, il existe un risque de fuite de contenu sensible partagé dans un tableau blanc virtuel à l’extérieur de l’entreprise. Il peut s’agir de données de cartes de crédit, de détails de sécurité sociale, d’informations de santé protégées ou de tout autre élément qu’une entreprise souhaiterait (ou est obligée par les autorités de réglementation) protéger. Bien que les exigences en matière de gouvernance des données impliquent souvent la formation des employés, les contrôles techniques sont également importants, a déclaré Mark Strande, directeur de la sécurité de l’information chez Miro. « Il y a toujours un risque que les employés oublient leur formation de sensibilisation à la sécurité et mettent des informations [dans un tableau] alors qu’ils ne sont pas censés le faire, ou qu’ils le fassent par erreur », a-t-il indiqué. « Il faut prendre des mesures de protection pour éviter de placer des données sensibles au mauvais endroit ».

Etiqueter automatiquement les tableaux Miro

Enterprise Guard de Miro – disponible pour les clients des plans de licence Enterprise moyennant un pourcentage « supplémentaire », selon un porte-parole – comporte plusieurs éléments. L’un de ces aspects est la capacité à trouver, classer et sécuriser le contenu sensible. Il s’agit notamment de la possibilité d’étiqueter automatiquement les tableaux Miro en fonction des données sensibles qu’ils contiennent. Sur la base de cette classification, des garde-fous de sécurité renforcée peuvent alors restreindre ce que les utilisateurs peuvent faire avec un tableau. Les administrateurs peuvent accéder à un dashboard qui fournit une vue d’ensemble de tous les tableaux Miro contenant des données sensibles au sein de leur organisation, avec des détails sur la classification de chaque tableau. Cela permet aux administrateurs informatiques désignés « de naviguer et de voir quel type de données se trouve sur tous les tableaux sans vraiment lire les informations elles-mêmes », a expliqué Mark Strande. « Les administrateurs peuvent ainsi [vérifier] : les règles sont-elles correctement respectées dans notre entreprise ? ».

Deuxièmement, il existe des outils pour gérer le cycle de vie du contenu à grande échelle. Cela inclut la possibilité de conserver et de supprimer les tableaux Miro avec une piste d’audit complète, avec un contrôle sur la suppression et la restauration permanentes. Troisièmement, les outils de découverte et de préservation juridiques comprennent des fonctions telles que la possibilité d’exporter les tableaux au format PDF avec un historique complet des modifications. Enfin, la gestion des clés d’entreprise permet aux entreprises de chiffrer le contenu « au repos ». Comme pour toutes les applications de sécurité, le défi pour Enterprise Guard de Miro est de s’assurer qu’il peut « protéger l’entreprise sans entraver le travail », a déclaré Wayne Kurtzman, vice-président d’IDC pour les applications sociales, communautaires et de collaboration. « La sécurité est le point le plus douloureux lors de la sélection d’un logiciel d’entreprise », a-t-il précisé. « Miro a relevé ce défi et centralisé le processus d’une manière qui crée de la flexibilité, tout en restant dans la gamme de prix d’un plus grand nombre de clients. L’approche de l’éditeur en matière de sécurité d’entreprise diffère de celle des autres fournisseurs en appliquant des garde-fous à la fois au contenu généré au sein de Miro et aux applications tierces intégrées. Cela inclut certaines applications de sécurité populaires, ce qui améliore la flexibilité de l’entreprise. Le développement de cette offre de sécurité, à mon avis, sera bénéfique à Miro ».

Basé sur l’IA, le service SOC Insights d’Infoblox, disponible dès maintenant, est capable de repérer rapidement les erreurs de configuration et les activités à haut risque afin d’aider les entreprises à réduire les risques et à accélérer les réponses aux menaces DNS.

Pour renforcer son portefeuille de protection du système de noms de domaine (DNS) et améliorer la sécurité des ressources de réseau DNS largement distribuées des entreprises, Infoblox a déployé une solution basée sur l’IA appelée SOC Insights. Le service est une extension cloud de l’offre BloxOne DNS Threat Defense du fournisseur. Selon Craig Sanderson, vice-président de la sécurité et de la gestion des produits chez Infoblox, SOC Insights permet aux clients d’utiliser les renseignements sur les menaces DNS pour bloquer ces menaces de manière proactive et fournir des analyses à l’équipe chargée des opérations de sécurité. « Cette offre combinée de SOC Insights avec l’IA a pour objectif de réduire le temps de réponse en transformant de grandes quantités de données d’événements de sécurité, de réseau et de renseignements DNS en un ensemble gérable d’informations immédiates et exploitables », a expliqué M. Sanderson. AI SOC Insights prend en compte les données réseau et de sécurité provenant de l’ensemble de données DNS d’Infoblox et de sources tierces, puis utilise la technologie IA pour corréler les événements, les classer par ordre de priorité et proposer des recommandations de résolution. « On peut ainsi non seulement accélérer la détection et la réponse aux menaces, mais également soulager les analystes SOC d’une lourde tâche », a ajouté M. Sanderson.

« Le DNS sert de plan de contrôle pour les réseaux d’entreprise, mais il sert aussi un plan de contrôle pour les adversaires et les logiciels malveillants », a rappelé par ailleurs M. Sanderson. « Ce qui peut poser problème, car le plus souvent, ce n’est pas l’équipe de sécurité qui examine le trafic DNS, mais les responsables du réseau, ce qui suppose qu’ils doivent être capables de passer en revue les milliards d’événements DNS envoyés chaque jour, en essayant d’identifier les centaines de milliers de domaines DNS enregistrés chaque semaine. Il est très difficile d’identifier ce que font les cyberpirates, souvent cachés à la vue de tous », a poursuivi M. Sanderson. « L’IA peut identifier les données les plus importantes à travers tout ce bruit », a encore déclaré M. Sanderson, citant l’exemple d’un client anonyme qui a récemment réduit quelque 500 000 événements en 24 informations exploitables. De plus, selon M. Sanderson, « SOC Insights peut repérer les erreurs de configuration, les activités à haut risque et d’autres comportements pour aider les entreprises à renforcer leur posture de sécurité et à atténuer les risques de manière proactive ».

Le détournement DNS très pratiqué

La protection du DNS est un élément central de la sécurité des entreprises. En effet, le DNS, familièrement appelé annuaire de l’Internet, apporte un système de dénomination décentralisé pour les ordinateurs en réseau et les services connectés à Internet ou à un réseau privé. La technologie traduit les noms de domaine en adresses IP nécessaires à la localisation et à l’identification des services et appareils informatiques avec les protocoles réseau sous-jacents. Selon l’équipe de recherche sur les menaces de l’Unité 42 de Palo Alto Networks, en raison de son utilisation généralisée, le DNS offre une surface d’attaque massive et souvent négligée qui nécessite le même examen et la même protection que le web, le courrier électronique et d’autres services. « Le DNS peut servir à diffuser des logiciels malveillants, pour le commandement et le contrôle (C2) ou l’exfiltration de données », a écrit l’équipe de l’Unité 42 dans un livre blanc sur le sujet. « Les adversaires profitent de l’omniprésence du DNS pour l’utiliser de manière abusive à différents stades d’une attaque – près de 85 % des logiciels malveillants utilisent le DNS à des fins malveillantes. Parallèlement, de nombreuses équipes de sécurité manquent de visibilité sur le trafic DNS et sur la façon dont les menaces utilisent le DNS pour garder le contrôle des appareils infectés ».

Dans une récente étude, le consultant Enterprise Management Associates (EMA) s’est intéressé aux problèmes de sécurité DNS les plus dommageables pour les entreprises. Le détournement ou la redirection DNS, qui consiste à intercepter les requêtes DNS des terminaux clients et d’orienter les tentatives de connexion vers une mauvaise adresse IP, arrivent en tête des réponses de l’enquête. Souvent, les pirates y parviennent en infectant les clients avec des logiciels malveillants de manière à rediriger les requêtes vers un serveur DNS malhonnête, ou en piratant un serveur DNS légitime et en détournant les requêtes à une échelle plus massive. Selon Shamus McGillicuddy, directeur de recherche à l’EMA, cette dernière méthode peut avoir un large rayon d’action, d’où l’importance pour les entreprises de protéger l’infrastructure DNS contre les pirates. Un autre problème de sécurité DNS est le tunneling DNS, utilisé pour échapper à la détection tout en extrayant des données d’un système compromis et en les exfiltrant. Les pirates exploitent généralement ce problème une fois qu’ils ont pénétré dans un réseau, et ils cachent les données extraites dans des requêtes DNS sortantes. « D’où l’importance de surveiller de près le trafic DNS avec des outils de contrôle de la sécurité pour repérer certaines anomalies, par exemple des tailles de paquets anormalement élevées », a préconisé M. McGillicuddy.

La fin des cookies est censée protéger la vie privée des internautes. Les solutions de remplacement, dont la très en retard Privacy Sandbox de Google, pourraient pourtant avoir l’effet inverse.

Les cookies ingèrent et conservent souvent des données sensibles sur les consommateurs, notamment leurs identifiants de connexion, des informations permettant d’identifier une personne et leur historique de navigation. L’abandon progressif des cookies, entamé en début d’année, doit normalement contribuer à réduire certains risques de violation de données personnelles. Rien n’est cependant moins évident.Dès 2019, Google a déclaré aux utilisateurs qu’il prévoyait de limiter les cookies tiers et de les éliminer progressivement dans Chrome et d’autres navigateurs open source comme Chromium d’ici à 2022. Il a repoussé ses plans à 2023, puis progressivement tout au long de 2024. Dans cette perspective, les annonceurs travaillent déjà depuis des mois sur de nouvelles technologies de suivi des consommateurs. Pourtant, les éditeurs de navigateurs rivaux de Google (néanmoins tout puissant avec 64% des parts de marché dans le monde pour Chrome) se sont rapidement attaqués au problème. Mozilla a commencé à bloquer les cookies tiers avec Firefox en 2019 et Apple avec Safari 13.1 en 2020. Microsoft, lui, a adopté avec Edge une option « tout ou rien », via laquelle l’internaute autorise ou refuse tous les cookies tiers. Google vient seulement de commencer à tester en janvier une version de Chrome sans cookies auprès de 1% de ses utilisateurs. Cette mouture s’appuie sur la Tracking Protection de sa Privacy Sandbox Initiative, conçue pour réduire le suivi intersites et interapplications.La Privacy Sandbox de Google ne remplace pas les cookiesLes API de la Privacy Sandbox ne remplacent pas les cookies tiers et ne représentent pas non plus une solution de technologie publicitaire autonome, comme a tenu à le préciser Victor Wong, directeur produit Privacy Sandbox chez Google sur son blog le 10 janvier. « Elles sont conçues pour soutenir les objectifs business des agences de marketing et les médias (stimuler les ventes en ligne, diffuser des publicités pertinentes, etc.), sans identifiants intersites », expliquait-il. « Une enchère publicitaire ‘on-device’, jusque-là exécutée sur un serveur, par exemple, interagira désormais avec du code exécuté directement dans le navigateur, poursuit-il. Et certaines fonctions qui s’appuyaient sur des cookies tiers, comme les audiences basées sur les profils d’activité des utilisateurs sur les sites Web, ne pourront pas être reproduites directement à l’aide de la Privacy Sandbox. »Mike Froggatt, analyste senior chez Gartner, confirme que rien ne se substituera exactement aux cookies. Cependant, il existe des identifiants pour annonceurs (IDFA, identifiers for advertisers) destinés aux équipements, chez Apple ou via les walled gardens de Google et de Meta, ainsi qu’au travers de propositions technologiques tierces comme UID2. « Cependant, ce sont généralement des systèmes fermés qui restreignent l’accès aux données et ne les partagent que sous forme agrégée, poursuit-il. Même la Privacy Sandbox de Google, qui propose des enchères directement dans les navigateurs, ne partage les données qu’après qu’un certain seuil atteint, et même dans ce cas, il ajoute du bruit ou des données supplémentaires pour masquer les identifiants individuels. » L’objectif de ces outils étant effectivement de ne pas donner d’accès direct aux données des internautes.Le ciblage contextuel, une solution ancienneDepuis longtemps déjà, les fournisseurs de solutions utilisent le ciblage contextuel pour que les annonceurs créent des publicités pertinentes en fonction d’informations associées à un site Web plutôt qu’à un internaute. « Ces outils ne s’appuient pas sur les cookies et n’identifient pas un individu en tant que tel, précise Roger Beharry Lall, directeur de recherche technologies publicitaires et marketing PME chez IDC. Ils fournissent aux annonceurs des audiences ciblées basées sur des comportements observés en temps réel. » Le ciblage contextuel génère d’ailleurs un meilleur taux de conversion que les cookies, selon l’analyste, car les éditeurs fournissent des groupes présegmentés en fonction de marqueurs contextuels très précis, comme les mères de famille au moment de la rentrée scolaire ou les hommes à la Saint-Valentin.Le retard de Google vis-à-vis de ses concurrents avec sa Privacy Sandbox s’explique principalement parce qu’elle est développée sous la surveillance attentive de la Competition and markets authority (CMA) britannique, selon Mike Froggatt. Sans oublier qu’une part imposante de ses revenus provient du display. « Pour le ciblage et la mesure, Google ne dépend pas que des cookies tiers, poursuit l’analyste. En revanche, ils lui permettent d’augmenter la valeur des publicités qu’il vend pour le compte des éditeurs, assorties de données réclamées par les agences et les annonceurs. » Le Californien continuera probablement à suivre les consommateurs, mais uniquement avec ses propres outils, « et donc au sein d’un walled garden, prévient Roger Beharry Lall. Et plus il agira de manière monopolistique ou fermée, plus les régulateurs devront se mobiliser. » « Avec l’API de la Privacy Sandbox, une entreprise aura peu de chance de reconstituer le puzzle de données liées à une personne spécifique pour l’identifier. Il lui faudra avoir recours à une solution de résolution d’identité ou accéder à des données first party pour passer de ‘utilisateur anonyme intéressé par XYZ’ à ‘Jane Smith a acheté XYZ’ », rappelle Roger Beharry Lall.La fin des cookies, mauvaise nouvelle pour tous ?Pour Mike Froggatt, les cookies n’étaient finalement pas une si mauvaise solution pour l’internaute. Ils étaient peu vulnérables au piratage et, surtout, laissaient aux utilisateurs un certain contrôle sur leurs données, avec l’effacement des caches de navigateur ou l’utilisation de bloqueurs de publicité. D’une certaine manière, les nouvelles méthodes de suivi des tendances de consommation transfèrent cette responsabilité de l’individu vers les entreprises qui opèrent ces systèmes très fermés. « Si l’on regarde l’histoire des violations massives de données, cela n’augure rien de bon pour les utilisateurs, explique-t-il. Les données utilisées par les annonceurs et les outils publicitaires ne devraient inclure que très peu d’éléments au-delà des données démographiques, de l’historique de navigation et d’achat et peut-être de certaines données de localisation, mais ni les numéros de carte de crédit, ni les mots de passe par exemple. »En novembre 2023, l’ICO (Information commissioner’s office, un organisme public britannique) a exigé des principaux fournisseurs de sites Web du pays de se conformer aux lois sur la protection des données qui les obligent à demander aux utilisateurs s’ils veulent « rejeter » ou « accepter » tous les cookies publicitaires. En cas de refus, les sites peuvent continuer d’afficher des publicités, mais sans les cibler par rapport à l’internaute. « Les études que nous avons menées montrent que de nombreuses personnes sont préoccupées par le fait que les entreprises utilisent leurs informations personnelles pour les cibler avec des publicités sans leur consentement, a déclaré Stephen Almond, directeur exécutif du risque réglementaire de l’ICO, dans un communiqué. Les accros au jeu peuvent être ciblés par des offres de paris basées sur leur historique de navigation ou les femmes par des publicités pour bébés même peu de temps après une fausse couche. Quelqu’un qui explore sa sexualité peut se voir présenter des publicités qui révèlent son orientation sexuelle. »

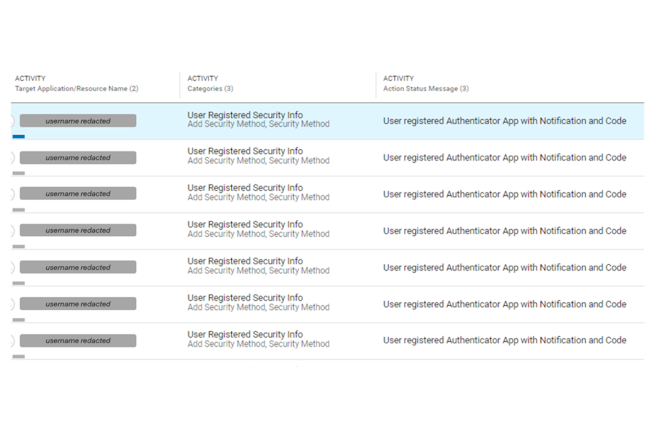

Des chercheurs ont découvert une campagne ciblant les comptes cloud de dirigeants pour ensuite avoir accès à des documents sensibles et de prendre pied dans le réseau de l’entreprise.

Au fur et à mesure que le cloud progresse au sein des entreprises, les cybercriminels s’y intéressent aussi de prés. Les experts de Proofpoint ont mis à jour une campagne de piratage particulièrement ciblée. Elle a touché en effet des comptes cloud de dirigeants d’entreprises via du phishing. « La sélection variée de rôles ciblés indique une stratégie pratique de la part des acteurs de la menace, visant à compromettre les comptes avec différents niveaux d’accès à des ressources et des responsabilités précieuses dans les fonctions organisationnelles », observe les chercheurs. Les titres comprenaient le directeur des ventes, le directeur de comptes, le directeur financier, le vice-président des opérations, le directeur financier, le président et le DG.

Un phishing personnalisé et l’installation de son propre MFA

Les campagnes utilisent du phishing individualisé via la fonctionnalité de partage de documents. Bien que cette technique ne soit pas particulièrement nouvelle, le ciblage et les mouvements latéraux utilisés par les attaquants ont augmenté le taux de réussite de l’attaque, démontrant que les méthodes de phishing relativement basiques restent efficaces. Après avoir compromis un compte, les attaquants prennent plusieurs mesures pour s’assurer qu’ils conservent leur accès et ne soient pas facilement découverts. En plus d’ajouter leur propre méthode MFA, ils créent des règles de boîte aux lettres destinées à masquer leurs traces et à effacer les preuves de leur activité malveillante.

Le but ultime de l’attaque semble être la fraude financière ou la compromission des emails professionnels (BEC), les attaquants envoyant des courriels depuis des comptes compromis aux employés des services des ressources humaines et financiers. Ils téléchargent également des fichiers sensibles contenant des informations sur les actifs financiers, les protocoles de sécurité internes et les informations d’identification des utilisateurs afin de mieux préparer leurs messages frauduleux. Les mouvements latéraux sont également un élément clef de l’attaque, des emails de phishing étant envoyés à d’autres employés clefs de l’entreprise à partir des comptes compromis.

Indicateurs de l’attaque de piratage de compte Microsoft Azure

« Notre analyse post-mortem de l’attaque a mis en évidence plusieurs proxys, services d’hébergement de données et domaines piratés, constituant l’infrastructure opérationnelle des cybercriminels », ont expliqué les chercheurs de Proofpoint. Ils ont notamment utilisés « des services proxy pour aligner l’origine géographique apparente des activités non autorisées sur celle des victimes ciblées, évitant ainsi les politiques de géolocalisation ». En outre, l’utilisation de services proxy aléatoire permet aux auteurs de menaces de masquer leur véritable emplacement et crée un défi supplémentaire pour les défenseurs cherchant à bloquer les activités malveillantes. Cela dit, les attaquants ont également été observés en train d’utiliser certaines adresses IP fixes de FAI en Russie et au Nigeria, potentiellement dans le cadre de faux pas révélant leur véritable emplacement.

Les chercheurs ont également observé que deux chaînes d’agent-utilisateur uniques servaient aux attaquants lors de l’accès aux comptes compromis. Ceux-ci pourraient être utilisés, avec les domaines d’infrastructure et les informations IP, comme indicateurs de compromission pour élaborer des règles de détection. Les applications Microsoft les plus fréquemment consultées dans les logs sont OfficeHome, Office365 Shell WCSS-Client (l’application du navigateur Web Office 365), Office 365 Exchange Online, Mes connexions, Mes applications et Mon profil.

Des conseils pour modérer les attaques

Proofpoint conseille aux entreprises de surveiller la chaîne d’agent-utilisateur et les domaines sources spécifiques dans leurs logs, d’imposer immédiatement des modifications d’informations d’identification pour les utilisateurs ciblés ou compromis et de forcer les changements de mot de passe périodiques pour l’ensemble des collaborateurs.

Les entreprises doivent également essayer d’identifier toutes les activités post-compromission ainsi que les vecteurs d’entrée initiaux : phishing, malware, usurpation d’identité, force brute, pulvérisation de mots de passe, etc. L’élaboration et l’utilisation de politiques de correction automatique pourraient minimiser l’accès des attaquants aux comptes et les dommages potentiels.

Se définissant comme toute faille qui persiste sans être corrigée pendant plus d’un, la dette de sécurité logicielle des entreprises reste critique selon Veracode. Un phénomène renforcé par la génération de code par l’IA souvent moins sécurisé.

Comme dans le domaine de l’IT, les questions de dette touchent le sujet de la cybersécurité en entreprise. Veracode met en lumière ce sujet moins connu et qui recense les failles non corrigées depuis un an encore présentes dans le parc applicatif. L’étude est basée sur les données recueillies par l’éditeur lors de récents tests de sécurité des applications statiques (Static Application Security Testing, SAST), tests de sécurité des applications dynamiques (Dynamic Application Security Testing, DAST) et l’analyse de composition logicielle (Software component analysis, SCA) de plus d’un million d’applications.

« La prolifération du code généré par l’IA s’accompagne d’un code non sécurisé à grande échelle et de la probabilité qu’il devienne une dette de sécurité », a déclaré Chris Eng, directeur de la recherche chez Veracode. « Compte tenu de l’ampleur de la dette de sécurité que nous avons constatée, il convient de se demander si les outils de remédiation assistés par l’IA peuvent être utiles pour réduire cette dette, sans avoir à réorienter les équipes de développement ou à en augmenter la taille ». L’étude a également révélé un nombre considérable de failles dans les codes de première main et de tierce partie, soulignant l’importance de les tester tous les deux tout au long du cycle de vie du développement logiciel.

Les failles critiques en baisse, mais pas éliminées

L’étude a révélé qu’en 2023, la prévalence des failles de grande gravité avait chuté (dans 17,9 % des applications) à la moitié de son niveau de 2016 (dans 37,9 % des applications). Et si, 3,2 % seulement de toutes les failles ont été jugées très graves (score CVSS supérieur ou égal à 9), près de 16 % de ces brèches étaient « fortement susceptibles » d’être exploitées. Cela signifie qu’un peu moins de 1 % (0,7 %) de toutes les vulnérabilités détectées en 2023 étaient à la fois critiques et hautement exploitables. Globalement, d’après les analyses SAST, DAST et SCA de Veracode, 80 % de toutes les applications actives présentent des failles non résolues, alors que ce chiffre était de 73 % pour les analyses SAST uniquement, qui prennent en compte les problèmes spécifiques à la phase de développement des applications. Les failles détectées dans les composants tiers et open-source étaient comparables à celles détectées dans les codes de première main. En fait, 63,4 % des applications présentaient des failles dans les codes d’origine, tandis que 70,2 % des applications présentaient des failles dans les codes de tierce partie.

Selon l’étude, cette situation est liée à l’adoption plus large de l’IA et nécessite une analyse approfondie des deux sources dans le cycle de développement. En outre, l’étude a mis en évidence le fait qu’en moyenne, une application typique comporte 42 failles pour 1 Mo de code. Les scripts intersites XSS, les injections, les traversées de répertoire et les composants vulnérables et obsolètes sont les principales failles dans les applications à forte intensité (moyenne des résultats par application) et à fort volume (pourcentage d’applications).

Des recommandations pour réduire la dette technique

La dette de sécurité logicielle concerne 42% de toutes les applications. Ce chiffre tombe à 23 % si l’on ajoute les applications de moins d’un an, ce qui signifie que 57 % des applications présentent des failles, mais n’ont pas de dette. La situation est un peu différente si l’on prend en compte l’héritage de sécurité critique (failles critiques non corrigées). « Une grande majorité des entreprises (71 %) ont peu ou prou une dette de sécurité », selon l’étude. « Près de la moitié des entreprises (46 %) présentent des failles persistantes de grande gravité que l’on peut classer dans la catégorie des dettes de sécurité critiques.

En moyenne, près de la moitié de toutes les failles (47 %) d’une entreprise peuvent être attribuées à la dette de sécurité. Pour faire face à celle-ci, l’étude formule quelques recommandations, notamment l’intégration de la sécurité dans la gestion du cycle de développement, la remédiation continue avec une priorisation sur les dettes de sécurité critiques, le renforcement des compétences des développeurs en matière de sécurité et la connaissance du profil de la dette pour le langage de programmation concerné.

La dernière mise à jour, qui corrigeait de précédentes failles dans les produits d’Ivanti, a introduit d’autres vulnérabilités. Les clients sont invités à appliquer un autre correctif.

Sale temps pour Ivanti et ses produits de sécurité. En effet, quelques jours après l’annonce par l’éditeur de la disponibilité de correctifs pour une faille découverte dans ses solutions Connect Secure et Policy Secure (son VPN SSL), une autre brèche a été découverte et les attaquants s’y intéressent de très prés. Il s’agit de la vulnérabilité CVE-2024-22024 entraînant une injection d’entité externe XML (External Entity Injection, XXE) dans le composant SAML de certaines versions de Connect Secure, Policy Secure et ZTA.

La faille a été découverte par des chercheurs de la société wtachTowr en analysant le correctif pour la vulnérabilité CVE-2024-21893. Celle-ci provoque une falsification de requêtes côté serveur ou Server-Side Request Forgery (SSRF) dans le composant SAML. Le 31 janvier, Ivanti avait révélé que cette faille zero day, découverte par l’entreprise alors qu’elle enquêtait sur deux autres vulnérabilités zero day annoncées le 10 janvier et exploitées par un groupe chinois de menaces persistantes avancées (APT), était exploitée dans des attaques ciblées. En réponse à ces attaques, Ivanti a d’abord publié une mesure d’atténuation basée sur XML applicable aux terminaux concernés le temps de préparer des mises à jour pour toutes les versions logicielles concernées.

Des mises à jour disponibles

Les mises à jour pour les quatre vulnérabilités connues – CVE-2023-46805 (contournement de l’authentification), CVE-2024-21887 (injection de commande), CVE-2024-21888 (élévation de privilèges) et CVE-2024-21893 (SSRF dans le composant SAML) – ont finalement été publiées le 31 janvier et le 1ᵉʳ février. Les mises à jour pour la récente faille CVE-2024-22024 (injection XXE) ont été publiées le 8 février. Selon Ivanti, ces mises à jour remplacent les précédentes. L’entreprise indique par ailleurs que les clients qui ont réinitialisé leurs terminaux lors de l’application des correctifs du 31 janvier et du 1ᵉʳ février n’ont pas besoin de le faire à nouveau après l’application des mises à jour du 8 février.

La réinitialisation d’usine était nécessaire pour supprimer tous les implants potentiels et les modifications apportées par les attaquants à l’aide des exploits précédents. « Nous conseillons vivement aux clients d’utiliser l’outil de vérification de l’intégrité externe d’Ivanti, publié précédemment, en combinaison avec les meilleures pratiques de surveillance de la sécurité », a recommandé l’entreprise dans un billet de blog. Les vulnérabilités d’injection XXE permettent aux attaquants d’injecter des entités XML dangereuses dans des applications web qui traitent des données XML. Les chercheurs de watchTowr précisent que la faille CVE-2024-22024 a été introduite par l’un des correctifs pour les vulnérabilités précédentes, ce qui explique pourquoi elle n’affecte que certaines versions récentes des produits. Selon Ivanti, les versions concernées sont les suivantes : Connect Secure 9.1R14.4, 9.1R17.2, 9.1R18.3, 22.4R2.2, 22.5R1.1, et 22.5R2.2 ; Ivanti Policy Secure 22.5R1.1 ; et ZTA 22.6R1.3.

Des tentatives d’exploitation de la vulnérabilité

À la suite du rapport de watchTowr et de l’avis d’Ivanti, un PoC a été développé et publié en ligne au cours du week-end. Depuis, plusieurs services et entreprises qui gèrent des pots de miel et surveillent le trafic Internet malveillant ont signalé des recherches de la vulnérabilité et des tentatives d’exploitation. « Le 9 février, soit peu de temps après la publication du PoC, nous avons repéré des tentatives d’exploitation de ‘/dana-na/auth/saml-sso.cgi’ », a déclaré la Shadowserver Foundation sur Twitter. « Il s’agit principalement de tests de rappel. 47 adresses IP ont été observées à ce jour ».

De son côté, Akamai dit avoir constaté des tentatives de scan et de charge utile pour cette faille en provenance de plus de 80 adresses IP et ciblant plus de 30 000 hôtes. La semaine dernière, dans une directive actualisée, la CISA a demandé à toutes les agences fédérales de déconnecter de leurs réseaux les produits Ivanti concernés avant le vendredi 2 février à minuit, et de procéder à des analyses forensiques supplémentaires et à des mesures de nettoyage au cas où leurs réseaux auraient déjà été compromis. Et vendredi dernier, l’agence a publié une directive supplémentaire demandant à toutes les agences d’appliquer les nouveaux correctifs Ivanti pour la faille CVE-2024-22024 avant le lundi 12 février.

Plus de 200 entreprises et organismes américains participeront à l’AI Safety Institute Consortium. Sa mission sera d’élaborer des lignes directrices pour garantir la sécurité des systèmes d’IA.

Si l’UE a pour habitude de réglementer (cf la récente approbation de l’IA Act), les Etats-Unis préfèrent laisser le marché se réguler. Et c’est bien ce qui prévaut dans la création de l’AI Safety Institute Consortium (AISIC). Cette structure, soutenue par le gouvernement américain, sera chargé de mettre en place des garde-fous pour l’utilisation et le développement de l’IA. Annoncé en fin de semaine dernière par le Département du Commerce, le consortium fait partie du NIST (National Institute of Standards and Technology et comprend plus de 200 entreprises et organismes. Parmi ses membres figurent Amazon.com, l’université Carnegie Mellon, l’université Duke, la Free Software Foundation et Visa, de même que plusieurs grands développeurs d’outils d’IA, dont Apple, Google, Microsoft et OpenAI.

Le consortium « veillera à ce que l’Amérique soit en tête de peloton » dans la définition des normes de sécurité de l’IA tout en encourageant l’innovation, a déclaré la secrétaire américaine au commerce, Gina Raimondo, dans un communiqué. « Ensemble, nous pouvons relever ces défis pour développer les mesures et les normes dont nous avons besoin pour maintenir l’avantage concurrentiel de l’Amérique et développer l’IA de manière responsable », a-t-elle ajouté.

Une nécessaire réglementation sur l’IA

La semaine dernière, outre l’annonce de ce consortium, l’administration Biden a nommé Elizabeth Kelly, ancienne conseillère du président pour la politique économique, au poste de directrice l’US Artificial Intelligence Safety Institute (USAISI), une organisation au sein du NIST qui hébergera l’AISIC. On ne sait pas encore si les travaux de la coalition déboucheront sur des réglementations ou sur de prochaines lois. Même si le 30 octobre 2023, le président Joe Biden a publié un décret sur la sécurité de l’IA, le calendrier des travaux du consortium n’est pas encore fixé.

De plus, si Joe Biden perd les élections présidentielles dans le courant de l’année, cette dynamique en faveur d’une réglementation de l’IA pourrait s’essouffler. Cependant, le récent décret de Joe Biden suggère qu’une certaine réglementation est nécessaire. « L’exploitation de l’IA pour le bien et la réalisation de ses innombrables avantages exigent que l’on atténue les risques considérables qu’elle comporte », indique le décret. « Cette entreprise appelle à un effort de toute la société, qui inclut le gouvernement, le secteur privé, le monde universitaire et la société civile ».

Plusieurs textes en préparation

Entre autres choses, la volonté de M. Biden est d’exiger des développeurs de systèmes d’IA qu’ils partagent les résultats de leurs tests de sécurité avec le gouvernement américain ; d’élaborer des normes, des outils et des tests pour garantir que les systèmes d’IA sont sûrs, sécurisés et dignes de confiance ; de protéger les résidents américains contre les fraudes et les tromperies liées à l’IA ; de mettre en place un programme de cybersécurité pour développer des outils d’IA capables de trouver et de corriger les vulnérabilités des logiciels critiques.

L’AI Safety Institute Consortium sollicite les contributions de ses membres dans plusieurs de ces domaines, notamment autour du développement d’outils de test et de normes industrielles pour un déploiement sûr de l’IA. Dans l’intervalle, au cours de la session 2023-24, les législateurs ont présenté des dizaines de projets de loi liés à l’IA au Congrès américain. L’Artificial Intelligence Bug Bounty Act pourrait obliger le Département de la Défense des États-Unis à créer un programme de primes aux bugs pour les outils d’IA qu’il utilise. Le Block Nuclear Launch by Autonomous Artificial Intelligence Act pourrait interdire l’utilisation de fonds fédéraux pour des systèmes d’armes autonomes capables de lancer des armes nucléaires sans intervention humaine significative. Mais, en cette année électorale aux États-Unis, il est difficile de faire passer des projets de loi au Congrès.

La lutte entre les pro et anti régulation resurgit

Plusieurs personnalités, dont Elon Musk et Stephen Hawking, ont fait part de leurs inquiétudes au sujet de l’IA, notamment la menace lointaine que l’IA finisse par prendre le contrôle du monde. Dans les préoccupations à plus court terme, certains s’inquiètent de l’utilisation de l’IA pour créer des armes biologiques, des cyberattaques ou des campagnes de désinformation. Mais d’autres, comme l’investisseur en capital-risque Marc Andreessen, estiment qu’un grand nombre d’inquiétudes à propos de l’IA sont exagérées. Dans un long billet de blog daté du 6 juin 2023, il affirme que l’IA sauvera le monde. Il milite en faveur de la suppression de « toute barrière réglementaire » pour le développement d’une IA open source, en mettant en avant les avantages que pourront en tirer les étudiants qui apprennent à construire des systèmes d’IA.

À l’inverse, il fustige les opportunistes qui cherchent à tirer profit de la réglementation en créant une « panique morale » sur les dangers de l’IA afin d’imposer de nouvelles restrictions, réglementations et lois. Les dirigeants des entreprises d’IA existantes « peuvent gagner plus d’argent si des barrières réglementaires sont érigées pour former un cartel de fournisseurs d’IA adoubés par le gouvernement et protégés de la concurrence des nouvelles startups et des logiciels libres », a ainsi déclaré Marc Andreessen.

Pour renforcer la sécurité des applications avec des fonctionnalités dédiées aux API, F5 Networks met à profit la technologie issue du rachat de Wib Security.

L’équipementier F5 renforce la sécurité des applications en ajoutant un service à son package principal Distributed Cloud Service. Lancé en 2023, ce dernier est une plateforme SaaS permettant la gestion des applications, la gestion de l’infrastructure et les services de sécurité sur les sites cloud publics, cloud privés et edge des clients. Le service de découverte et de protection des API du fournisseur vise à offrir aux clients un moyen simple de découvrir les points d’extrémité des API, de surveiller le trafic à la recherche de vulnérabilités, de fournir des tests et de protéger les applications. “L’objectif principal est de protéger les entreprises de l’exfiltration de données par le biais d’API non surveillées, mal implémentées ou mal configurées”, a déclaré Kara Sprague, vice-présidente exécutive et directrice des produits chez F5. “Le service offre aux entreprises une vision beaucoup plus claire des API qu’elles ont exposées au public et du type de données que ces API échangent, afin qu’elles puissent sécuriser beaucoup plus facilement ces données.”

L’ère des applications monolithiques, traditionnelles client-serveur à trois niveaux, est révolue, a déclaré Mme Sprague. Selon l’étude 2024 State of Application Strategy de F5, 88% des organisations déploient leurs applications et leurs API dans des environnements hybrides qui englobent les sites sur site et dans le cloud, et près de 40% des organisations exploitent des applications et des API dans six environnements différents. “Les nouvelles applications d’aujourd’hui sont basées sur des conteneurs et des microservices, et ces applications natives de conteneurs et de microservices sont toutes dotées d’API qui constituent en fait les portes d’entrée vers la logique applicative moderne et qui sont désormais la principale cible des cyberattaques”, a déclaré Mme Sprague.

Wib Security assure une visibilité complète des API

Le service F5 utilise la technologie de sécurité des API issue du récent rachat de la start-up israélienne Wib Security (10 millions de dollars environ). Cette dernière comprend des fonctionnalités d’analyse de code, de détection des vulnérabilités et d’évaluation des risques qui permettent aux clients de surveiller les processus de développement des applications afin d’atténuer les menaces et de repérer les problèmes, peu importe où ils se trouvent, avant qu’ils ne pénètrent sur le réseau de l’entreprise. “La sécurité des applications devient de plus en plus importante dans le secteur. Les entreprises sont contraintes – par les interactions avec les fournisseurs, les considérations relatives à la chaîne d’approvisionnement et/ou les contrôles de conformité réglementaire – d’examiner et de documenter la manière dont leurs applications sont utilisées, développées et sécurisées”, a déclaré Christopher Steffen, directeur de recherche chez Enterprise Management Associates.

“Les entreprises se rendent compte que nombre de leurs applications sont multigénérationnelles. Ce qui signifie qu’il est possible, voire probable, que les applications utilisées aient été développées sur une base qui a plusieurs générations techniques de retard”, a souligné M. Steffen. “La technologie est tellement obsolète que vous avez souvent besoin d’un spécialiste pour refactoriser l’application en quelque chose de plus moderne et utilisable. C’est extrêmement coûteux, et même avec un réaménagement, la sécurité est souvent une considération secondaire ou tertiaire dans le processus.” Alors que de nombreuses fonctions existaient en tant qu’offres indépendantes et autonomes, F5 a maintenant combiné les outils en une plateforme holistique, ce qui devrait être intéressant à la fois pour les développeurs et les gestionnaires, a indiqué M. Steffen. “Lorsque les développeurs disposent d’un outil unique conçu en fonction de leurs processus, qui leur fournit des informations exploitables au lieu d’un vague message “c’est cassé”, ils sont beaucoup plus susceptibles de l’utiliser”, a déclaré M. Steffen.

Plus d’automatisation

“En l’état actuel des choses, un ingénieur de développement doit utiliser une suite d’outils vaguement intégrés pour accomplir un grand nombre des mêmes fonctions que la solution F5 pourra accomplir pour lui en une seule fois. Les équipes de développement recherchent les meilleurs outils de sécurité qui non seulement répondent à leurs exigences en matière de sécurité, mais qui créent également le moins de friction possible dans leurs processus. Je pense que F5 a fait un grand pas dans cette direction”, a poursuivi M. Steffen. En plus de son service API, F5 promet d’intégrer de l’IA à son service cloud distribué. Par exemple, plus tard cette année, le fournisseur prévoit d’introduire un assistant IA basé sur le langage naturel pour aider les équipes de sécurité informatique à identifier plus facilement les anomalies, à interroger et à générer des configurations de politiques, et à appliquer des mesures correctives, a rapporté M. Sprague. « L’assistant fera partie de la console Distributed Cloud et permettra aux utilisateurs d’interroger leurs ensembles de données pour obtenir des recommandations sur les mesures et les capacités de sécurité qu’ils devraient appliquer à leurs diverses applications et API, entre autres cas d’utilisation ».

L’assistant IA fera partie d’un service plus large basé sur l’IA appelé AI Data Fabric, qui agrègera les données des Distributed Cloud Services ainsi que du système de support d’application NGinx de F5 et du portefeuille de produits réseau BIG-IP. À partir de ces données, la société prévoit de fournir des rapports et des analyses, voire de former et de déployer des modèles de machine learning pour exécuter des inférences afin de mieux sécuriser et optimiser les applications, a précisé M. Sprague. « L’idée derrière AI Data Fabric sera de fournir des services intelligents qui permettront aux entreprises de répondre aux menaces en temps réel, de générer des recommandations pour les aider à prendre des décisions plus éclairées et à prendre des mesures rapides telles que la correction », a assuré M. Sprague.