Le constructeur chinois intègre dans ses derniers points d’accès WiFi 7 AirEngine des technologies anticipant la norme WiFi 8, des capacités de détection de caméras cachées et une gestion avancée du réseau exploitant des ressources IA.

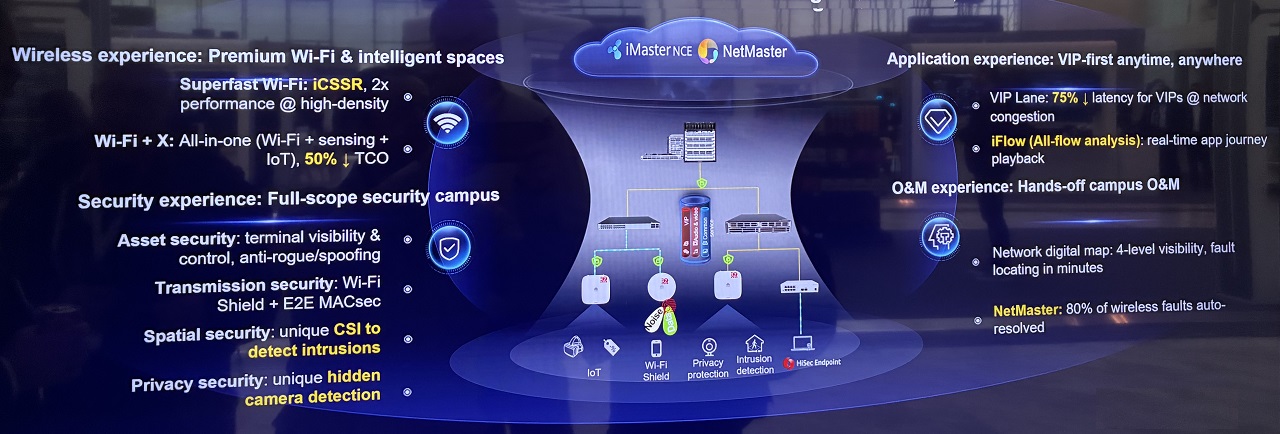

Lors du Huawei Connect Europe, organisé cette année à Madrid le 29 octobre 2025, Christophe Batiard, vice-président Europe solutions réseaux chez Huawei, nous a présenté les innovations de l’équipementier dans le domaine des réseaux sans fil et de l’infrastructure campus. Le constructeur positionne désormais sa gamme WiFi 7 AirEngine sous l’appellation maison WiFi 7 Advanced, une dénomination qui reflète l’intégration anticipée de fonctionnalités normalement attendues avec la future norme WiFi 8.

WiFi 7 Advanced : anticiper le WiFi 8

Le fournisseur de Shenzhen a décidé de marquer sa différenciation technologique en commercialisant sa dernière génération de points d’accès AirEngine sous le nom de WiFi 7 Advanced. “Nous avons déjà commencé à intégrer certaines technos qui seront dans le WiFi 8”, explique Christophe Batiard. Cette stratégie permet au constructeur d’exploiter dès maintenant des capacités avancées qui ne seront standardisées que dans la prochaine génération de la norme WiFi. Le positionnement de Huawei a d’ailleurs été salué par Gartner, qui classe l’équipementier dans le carré des leaders pour le WiFi et les solutions campus. L’une des innovations présentées par le dirigeant concerne la sécurité physique des réseaux WiFi. Huawei a développé un système de protection active (Transmission Security) qui va bien au-delà du simple chiffrement WPA traditionnel. Lorsqu’un hacker tente de se connecter à un point d’accès par attaque en force brute, le système réagit de manière autonome et proactive.

“Le WAC de l’access point et le NAC vont remonter une alerte au contrôleur chez nous. Le contrôleur avec Master NCE va identifier qu’il y a un élément qui ne va pas, suite une attaque par force brute par exemple. Ce qu’il va faire c’est changé la configuration de l’antenne de manière dynamique et proactive. L’antenne va émettre un signal blanc pour brouiller le device qui essaye de se connecter alors qu’il ne devrait pas”, détaille Christophe Batiard. Cette technologie ne se contente pas de bloquer l’attaque au niveau logiciel : elle crée un brouillage physique du signal radio pour empêcher toute connexion non autorisée. Si l’attaquant se déplace d’un point d’accès à un autre, le système le suit automatiquement et continue de brouiller ses tentatives de connexion. Cette approche représente une convergence entre la sécurité physique et la sécurité informatique traditionnelle.

Sans attendre la standardisation du WiFi 8, Huawei a commencé à intégrer certaines fonctionnalités dans son WiFi 7 Advanced. (Crédit P.K.)

Détection de présence et de caméras cachées

La deuxième innovation repose sur la technologie CSI (Channel State Information), qui transforme les points d’accès WiFi en véritables capteurs de détection avec Spatial Security. Les antennes émettent constamment des ondes radio qui fonctionnent comme un radar, permettant de détecter la présence de personnes dans une pièce en temps réel. ” Le travail est de détecter s’il y a quelqu’un dans une pièce. Maintenant on peut savoir si une personne est présente vraiment en temps réel”, précise Christophe Batiard. Cette capacité ouvre des applications multiples : sécurité périmétrique avec remontée d’alarmes vers les systèmes de sécurité, optimisation du smart building pour la gestion de l’éclairage et du chauffage en fonction de la présence réelle, ou encore détection d’intrusions. Mais Huawei va encore plus loin avec une troisième fonctionnalité baptisée Privacy Security : la détection de caméras cachées. Certains points d’accès Huawei, notamment ceux conçus dans le centre de développement de Shanghai, intègrent désormais une base de données de plus de 120 signatures électromagnétiques de caméras. Les antennes peuvent détecter les émissions électromagnétiques émises par ces dispositifs de surveillance et alerter en cas de présence de caméra cachée dans un lieu où elle ne devrait pas se trouver, comme une chambre d’hôtel ou une cabine d’essayage, indique le vice-président Europe. Cette technologie de détection par émissions électromagnétiques est intégrée dans une partie de la gamme d’antennes WiFi et constitue, selon Christophe Batiard, une des grandes nouveautés présentées lors de ce Huawei Connect Europe. Pour l’instant, seule la détection de caméras est opérationnelle, mais le constructeur travaille sur l’extension de cette capacité à d’autres types d’appareils électroniques.

Au-delà du WiFi, Huawei revendique une avance technologique significative dans le domaine du Software-Defined Networking (SDN). Selon une récente étude de Gartner sur le WiFi, les équipements campus et les switches pour data center, le constructeur chinois se positionne mieux que Cisco en termes de capacité à délivrer des systèmes SDN avancés. “Ils ont considéré que dans les capacités à délivrer, nos systèmes de SDN étaient plus avancés que Cisco”, souligne Christophe Batiard. Cette avance s’explique notamment par l’intégration précoce de scénarios d’inférence basés sur l’intelligence artificielle dans les équipements réseau. Contrairement à Arista, qui reste positionné sur des approches plus traditionnelles, Huawei a développé des capacités d’automatisation et d’optimisation qui vont au-delà des solutions SDN classiques proposées par la concurrence.

Optimisation dynamique du réseau

L’un des atouts de Huawei réside dans l’utilisation intensive de l’intelligence artificielle pour adapter le réseau en temps réel aux besoins des utilisateurs et des applications. Le constructeur a développé plusieurs technologies qui permettent une gestion automatisée et intelligente de l’infrastructure réseau. La fonction VIP Lane permet, par exemple, d’identifier précisément chaque utilisateur et chaque terminal connecté au réseau. Lorsqu’un utilisateur s’authentifie sur le NAC (Network Access Control), le système est capable de déterminer son identité, le type de terminal utilisé (iPhone, Huawei, etc.), sa localisation sur le réseau, et même sa position géographique. En fonction de ces informations contextuelles et des droits de l’utilisateur, le réseau adapte automatiquement les accès et les priorités. “Quand un utilisateur s’authentifie sur le NAC, on est capable de savoir que c’est M. X, il utilise ce type de terminal (iPhone, Xiaomi ou encore Huawei), qu’il est situé sur telle borne du réseau. Tout est contextualisé en fonction du terminal de l’utilisateur, de ses droits et de ses privilèges pour déterminer s’il a le droit d’accéder à certaines zones de l’intranet en fonction de la politique d’entreprise”, explique Christophe Batiard. Le système Device Identification va encore plus loin en intégrant une connaissance fine des capacités de chaque terminal. Le réseau dispose d’une base de données des performances moyennes de chaque modèle de smartphone ou de laptops sur les différentes bandes de fréquence. “Si le système détecte qu’un iPhone 16 performe mal sur la bande 2,4 GHz, il l’orientera automatiquement vers une autre bande plus adaptée”, indique le dirigeant. La technologie de beamforming dynamique donne aux antennes la possibilité de suivre automatiquement les utilisateurs dans leurs déplacements. Lorsqu’un utilisateur passe d’un couloir à un autre, la configuration des antennes s’adapte en temps réel pour maintenir la meilleure qualité de connexion possible. Cette capacité de suivi et d’adaptation automatique distingue Huawei de ses concurrents selon le dirigeant.

La fonction VIP Lane, quant à elle, permet de prioriser non seulement des utilisateurs, mais aussi des terminaux spécifiques ou des applications métier critiques. “On peut la prioriser de bout en bout, depuis l’access point jusqu’au cœur réseau. On peut faire de la QoS dans un campus. On peut même faire du roaming. Il est possible de dédier des bandes de fréquence à un applicatif, un terminal donné sur une application donnée”, détaille le responsable. Cette priorisation s’étend au-delà du simple réseau campus. Dans une architecture complète incluant le WAN et le data center, Huawei peut garantir une priorisation de bout en bout pour des applications comme Netflix ou Teams. Pour les opérateurs télécoms, cette technologie permet de créer des réseaux dynamiques qui priorisent certaines applications payantes par rapport aux autres trafics. Un opérateur peut dire : moi je vais avoir un réseau dynamique qui pour cette application-là va être priorisé par rapport à tous les autres. Et s’il y a un problème dans le réseau, dynamiquement change le trajet de l’appli et je prends des SLA de bout en bout”, illustre Christophe Batiard.

Télémétrie en temps réel

L’usage de l’intelligence artificielle chez Huawei ne se limite pas à la priorisation du trafic. Elle permet également une détection proactive des problèmes de couverture WiFi et une optimisation automatique de la configuration des antennes. Lorsqu’un événement modifie l’environnement radio (déplacement de cloisons, ajout d’équipements métalliques créant des interférences), le système détecte immédiatement la dégradation de la couverture. “Si on change les meubles, on crée des interférences, le réseau va donc être affecté. Une alarme est donc remontée à l’administrateur, qui gère le réseau et l’agent IA va lui demander : est-ce que tu veux que j’optimise, que je te dise où il faut remettre la borne ? Non, pas où remettre la borne, mais recalibrer les bornes entre elles depuis notre interférence”, explique Christophe Batiard. L’administrateur réseau peut alors résoudre le problème en trois clics, le système recalibrant automatiquement les antennes pour éliminer les interférences.

Toute cette approche repose sur une architecture réseau spécifique développée par Huawei. Le constructeur utilise des puces propriétaires qui renvoient les métadonnées du réseau directement au contrôleur SDN en temps réel. Cette télémétrie temps réel, que le chinois revendique depuis longtemps, donne une vision instantanée de l’état du réseau et la capacité de détecter immédiatement les anomalies. “Nos réseaux, ils sont en temps réel depuis longtemps. Cette approche permet non seulement de réagir aux incidents, mais aussi de faire de la maintenance prédictive en détectant les signes avant-coureurs de pannes matérielles. L’efficacité opérationnelle de cette approche est illustrée par les chiffres de Huawei : 16 personnes suffisent à gérer 160 000 équipements réseau internes répartis dans 70 pays, avec seulement cinq points de management centralisés, nous a précisé Christophe Batiard en conclusion.

La dernière salve mensuelle de correctifs de sécurité de Microsoft comble 63 vulnérabilités dont une zero day dans le noyau Windows. Des failles ont également été corrigées dans Kerberos pour Active Directory, Visual Studio Copilot Chat et Graphics Component.

Pour le mois de novembre, Microsoft a publié une version allégée de son traditionnel Patch Tuesday par rapport au mois précédent. Seulement 63 failles sont corrigées contre 167, mais cela ne signifie pas que les administrateurs et les équipes de sécurité doivent relâcher leurs efforts. La vigilance est de mise notamment sur une vulnérabilité de type zero day provoquant une élévation de privilèges dans le noyau Windows pour serveurs contrôleurs et postes de travail. « La vulnérabilité [affectant le noyau Windows]la plus urgente à corriger est la CVE-2025-62215 », a expliqué à CSO Satnam Narang, ingénieur de recherche senior chez Tenable.

Une faille difficile à exploiter

« Bien qu’il existe une condition préalable importante pour exploiter le bogue, Microsoft a confirmé qu’une exploitation active était en cours. Les conséquences ne peuvent être ignorées, car les vulnérabilités liées à l’élévation des privilèges sont la clé pour ouvrir d’autres portes au sein d’une entreprise. C’est ainsi que les attaquants passent d’un premier point d’ancrage à une violation à grande échelle », a expliqué M. Narang. De son côté, Chris Goettl, vice-président de la gestion des produits chez Ivanti, note que cette faille affecte toutes les éditions du système d’exploitation actuellement prises en charge, ainsi que les systèmes Windows 10 couverts par le programme ESU (Extended Security Updates), « ce qui signifie que l’utilisation de Windows 10 après la fin de vie (EOL) n’est pas un risque hypothétique ». Selon Nick Carroll, responsable de la réponse aux incidents cybersécurité chez Nightwing, certains utilisateurs ont cependant signalé des problèmes lors de leur inscription au programme Extended Security Update (ESU). Le fournisseur a récemment publié une mise à jour urgente (out of band) pour résoudre les problèmes rencontrés par les utilisateurs qui tentent de s’inscrire au programme Windows 10 Consumer Extended Security Update. Les administrateurs qui prévoient de participer à ce programme doivent installer la mise à jour KB5071959 pour résoudre les problèmes d’inscription.

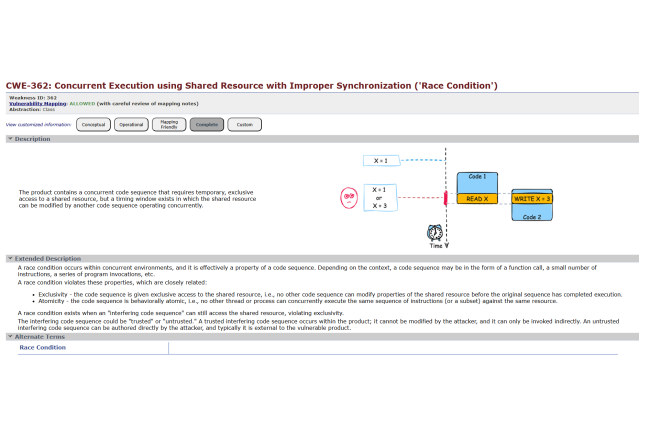

Ben McCarthy, lead cybersecurity engineer chez Immersive, a par ailleurs expliqué comment la CVE-2025-62215 peut être exploitée. Un attaquant disposant d’un accès local à faible privilège peut exécuter une application spécialement conçue qui tente à plusieurs reprises d’exploiter une race condition ou situation de compétition [interférence survenant lorsque que des processus imbriqués essayent d’accéder simultanément aux mêmes données ce qui peut provoquer des conflits dans les logiciels]. Dans le cas présent, il s’agit d’amener plusieurs threads à interagir avec une ressource partagée du noyau de manière non synchronisée, ce qui perturbe la gestion de la mémoire du noyau et l’amène à libérer deux fois le même bloc de mémoire. Cette « double libération » réussie provoque une corruption de mémoire noyau (kernel heap corruption), permettant à l’attaquant de réécrire la mémoire et de détourner le flux d’exécution du système. Si cette faille est très complexe à exploiter, le bénéfice apparait considérable pour un pirate qui y parviendrait en obtenant des privilèges système.

Une brèche dans Copilot Chat pour Visual Studio Code

La deuxième vulnérabilité majeure est la CVE-2025-62222 entraînant une exécution de code à distance dans l’extension Copilot Chat pour Visual Studio Code. Bien qu’elle soit moins susceptible d’être exploitée, M. Narang a déclaré qu’elle « souligne un intérêt croissant pour la recherche de bogues dans l’IA générative ou l’IA agentique, qui englobe les grands modèles de langage, qu’il s’agisse de modèles fondamentaux ou de modèles open source, et les outils d’édition de code assistés par l’IA ». Les chercheurs de Cisco ont déclaré que l’exploitation de cette faille n’était pas anodine, car elle nécessite plusieurs étapes : injection rapide, interaction avec Copilot Agent et démarrage d’une image de container (build trigger).

Ils expliquent aussi que Microsoft a évalué la complexité de l’attaque comme étant « élevée » mais que son exploitation est « peu probable ». Les RSSI devraient déjà s’attaquer aux risques émergents liés à l’IA par le biais de la gouvernance et de l’application de politiques de sécurité, a ajouté M. Narang. « Si le shadow AI et l’usage détourné et non sanctionné de l’IA se répandent dans leur entreprise, les responsables de la sécurité doivent modifier leur stratégie pour gérer cette surface d’attaque émergente et complexe avant qu’il ne soit trop tard. »

Kerberos dans Active Directory à risque

Un autre correctif publié concerne la CVE-2025-60704, une vulnérabilité de délégation dans le protocole d’authentification Kerberos au sein d’Active Directory baptisée CheckSum par les chercheurs de Silverfort, qui l’ont découverte. Si elle était exploitée, un pirate pourrait usurper l’identité d’un utilisateur authentifié, étendre ses privilèges et rester caché. Kerberos permettant aux applications de s’authentifier de manière sécurisée, une compromission pourrait ouvrir la voie à de l’usurpation d’identité et à l’accès à des ressources sensibles, explique Silverfort dans une description de cette vulnérabilité.

À l’aide d’une technique de type man-in-the-middle, cette faille a permis aux chercheurs en sécurité d’usurper l’identité d’utilisateurs arbitraires et, au final, de prendre le contrôle de l’ensemble du domaine. « Toute entreprise utilisant Active Directory avec la fonctionnalité de délégation Kerberos activée est concernée », prévient la société. « Cela signifie que des milliers d’entreprises à travers le monde sont touchées par cette vulnérabilité. »

Graphics Component vulnérable

Tyler Reguly, directeur adjoint de la R&D chez Fortra, s’est intéressé à la CVE-2025-60724, l’une des 4 failles critiques de ce patch tuesday. Il s’agit d’un débordement de mémoire tampon dans Graphics Component qui pourrait permettre à un attaquant non autorisé d’exécuter du code sur un réseau. Il note que la firme de Redmond affirme que « dans le pire des cas, un attaquant pourrait déclencher cette vulnérabilité sur des services web en téléchargeant des documents contenant un métafichier spécialement conçu sans interaction de l’utilisateur ». « Si j’étais responsable de la sécurité des systèmes d’information, la CVE-2025-60724 m’inquiéterait ce mois-ci », a-t-il déclaré à CSO. Il ajoute, « nous sommes confrontés à une vulnérabilité que Microsoft et CVSS considèrent comme critique et à un vecteur d’attaque qui ne nécessite aucune interaction de l’utilisateur ni aucun privilège, juste la possibilité de télécharger un fichier ». Mais il regrette de ne pas avoi plus de détails concernant la brèche, « dois-je m’inquiéter pour mon infrastructure SharePoint ? Qu’en est-il des logiciels tiers, comme mon wiki ou mon outil de suivi des bogues ? C’est vraiment quelque chose qui fait un peu peur, sans beaucoup de détails supplémentaires fournis. »

Cisco explique que la vulnérabilité peut être déclenchée en persuadant une victime d’ouvrir un fichier image EMF (Enhanced Metafile) spécifique. « Dans le pire des cas », écrivent ses chercheurs, « un attaquant pourrait déclencher cette vulnérabilité sur des services web en téléchargeant des documents contenant un fichier image EMF spécialement conçu sans interaction de l’utilisateur. Un attaquant n’a besoin d’aucun privilège sur les systèmes hébergeant les services Web. L’exploitation réussie de cette vulnérabilité pourrait entraîner un RCE ou la divulgation d’informations sur les services web qui analysent ce type de documents.

SAP dévoile aussi des correctifs

Les correctifs publiés ce mardi par SAP corrigent notamment de précédentes mises à jour dont deux HotNews. Mais il en existe également deux autres, classés comme hautement prioritaires par Onapsis, qui concernent Commerce Cloud et CommonCryptoLib, tous deux au score CVSS de 7,5/10. L’un des bulletins de sécurité n°3666261, inclut une faille au score CVSS de 10. Elle concerne une vulnérabilité liée à la gestion des clés et des secrets dans SQL Anywhere Monitor avec des identifiants codés en dur. Cet outil d’administration basé sur un navigateur fournit aux administrateurs des informations sur l’état et la disponibilité des bases de données SQL Anywhere, des serveurs et fermes de serveurs MobiLink. Il peut également fournir des informations sur la disponibilité des serveurs web et proxy ainsi que des systèmes hôtes. Le correctif supprime complètement SQL Anywhere Monitor, selon les chercheurs d’Onapsis. À titre de solution temporaire, SAP recommande aux administrateurs de cesser d’utiliser cet outil et de supprimer toutes les instances de la base de données SQL Anywhere Monitor.

Autre point à noter, la mise à jour n°3668705 qui corrige la CVE-2025-42887, une faille d’injection de code dans Solution Manager. En raison d’une absence de nettoyage des entrées dans un module fonctionnel accessible à distance, des attaquants authentifiés sont en mesure d’injecter du code malveillant dans le système. Notée 9,9 sur l’échelle CVSS, cette vulnérabilité est corrigée par l’ajout d’une vérification des entrées qui rejette la plupart des caractères non alphanumériques. « La CVE-2025-42887 est particulièrement dangereuse car elle donne à un attaquant la possibilité d’injecter du code à partir d’un utilisateur disposant de faibles privilèges, ce qui conduit à une compromission totale de SAP et de toutes les données contenues dans le système SAP », note Joris van de Vis, directeur de la recherche en sécurité chez SecurityBridge. Juan Pablo Perez-Etchegoyen, directeur technique d’Onapsis, affirme également que les administrateurs doivent traiter rapidement le bulletin n°3633049. « Même s’il s’agit d’un CVSS 7,5 », a-t-il déclaré dans un e-mail adressé à CSO, « il s’agit d’une corruption de mémoire potentiellement exploitable à distance avant l’authentification, et ce type de vulnérabilité a tendance à être très critique en raison de sa nature et de son potentiel de déni de service et de compromission du système. » Cependant, pour bon nombre de ces vulnérabilités, l’application de correctifs ne suffit pas : l’architecture, l’exposition, la segmentation et la surveillance restent importantes, conseille Mike Walters, président d’Action1. « Les RSSI doivent impliquer non seulement les équipes chargées des correctifs, mais aussi les propriétaires de services (impression, numérisation, partage de documents, accès à distance), les équipes réseau/sécurité (pour la segmentation et le contrôle de l’exposition) et les équipes de journalisation/surveillance (pour la vérification post-correctif) », a-t-il déclaré.

Des chercheurs en sécurité de Datadog affirment que le logiciel malveillant Vidar était présent dans 23 versions du référentiel npm depuis deux semaines et recommandent de prendre des précautions pour se protéger.

Des codes malveillants continuent d’être téléchargés dans des référentiels open source, ce qui rend difficile pour les développeurs responsables de faire confiance à leur contenu et pour les RSSI aux applications qui incluent du code open source. Dernier exemple en date : la découverte par des chercheurs en sécurité de Datadog le mois dernier dans le référentiel npm de 17 paquets (23 versions) contenant un malware pour les systèmes Windows qui s’exécute via un script de post-installation. Usant de typosquatting, les paquets associés se font passer pour ceux d’aide aux bots Telegram, de bibliothèques d’icônes ou de forks apparemment légitimes de projets préexistants tels que Cursor et React. Ces paquets offrent des fonctionnalités légitimes, mais leur objectif réel est d’exécuter l’infostealer Vidar sur le système de la victime. Datadog estime qu’il s’agit de la première divulgation publique du logiciel malveillant Vidar distribué via des paquets npm. Depuis, les deux comptes proposant ces paquets (aartje et saliii229911) ont été bannis. Mais, ils sont restés dans le registre pendant environ deux semaines, et les paquets malveillants ont été téléchargés au moins 2 240 fois. Les chercheurs pensent cependant que bon nombre de ces téléchargements ont probablement été effectués par des scrapers automatisés, certains ayant eu lieu après que les paquets ont été supprimés et remplacés par des paquets de sécurité vides.

Le typosquatting, c’est-à-dire la création de paquets dont les noms sont similaires à ceux de paquets officiels afin de tromper les développeurs qui recherchent une bibliothèque particulière, est l’une des tactiques préférées des acteurs malveillants qui tentent d’infecter la chaîne d’approvisionnement des logiciels open source. Par exemple, en 2018, un chercheur a découvert que des acteurs malveillants avaient créé de fausses bibliothèques dans le référentiel Python appelées « diango », « djago » et « dajngo » afin de tromper les développeurs qui recherchaient la célèbre bibliothèque Python « django ». Les RSSI doivent s’assurer que les employés sont au fait de ce problème de typosquatting et qu’ils savent ce qu’ils doivent rechercher. Les services IT doivent tenir un inventaire complet des composants utilisés par tous les logiciels approuvés, sur la base duquel des audits peuvent être effectués, afin de s’assurer que seuls les composants approuvés sont en place. Cet inventaire et cet audit doivent être effectués pour valider tout nouveau composant introduit.

Des conséquences fâcheuses

La compromission malveillante de composants open source peut entraîner toutes sortes de choses désagréables. Tout d’abord, les auteurs de la menace peuvent voler les identifiants des développeurs et insérer des portes dérobées dans leur code. Ensuite, le code malveillant contenu dans le composant téléchargé peut se propager dans le monde entier et atteindre les clients du développeur. La découverte de Datadog n’est qu’un exemple parmi d’autres de codes malveillants téléchargés sur npm, PyPI, GitHub et d’autres référentiels open source. La semaine dernière, Koi Security a signalé avoir trouvé 126 paquets malveillants dans npm, et en septembre, les chercheurs de Step Security ont signalé que des dizaines de bibliothèques npm avaient été remplacées par du code permettant de voler des identifiants. Le même mois, les chercheurs d’Aikido ont signalé que 18 paquets npm très populaires et téléchargés avaient été contaminés. « Je ne vois pas comment résoudre facilement ce problème sans une vue complète de la sécurité de tout nouveau code soumis, et ce n’est ni rapide, ni bon marché, ni facile », a commenté Roger Grimes, conseiller en sécurité informatique chez KnowBe4. « Mais c’est vraiment la seule solution si l’on veut un code open source fiable et sûr », a-t-il ajouté.

« Paradoxalement, l’une des principales raisons invoquées pour inciter à utiliser du code open source, c’est de dire qu’il est aisément vérifiable, de sorte que n’importe qui peut le consulter pour détecter et corriger les vulnérabilités », a-t-il souligné. « Sauf que, en réalité, presque personne ne vérifie la sécurité des dizaines de millions de lignes de code open source », a-t-il fait remarquer. « Des dizaines de projets open source ont tenté de mettre en place davantage de révisions de code par défaut, mais tous ont échoué », a-t-il rappelé. « L’une de mes citations préférées à ce sujet est la suivante : demander aux utilisateurs de réviser le code open source avant de l’utiliser revient à demander aux passagers d’un avion de descendre de l’appareil et de vérifier sa sécurité avant le décollage. Je ne sais pas qui est le premier à avoir dit cela, mais ça résume parfaitement les raisons pour lesquelles la révision volontaire du code open source ne fonctionne pas. »

Des actions correctives possibles

Les conseils ne manquent pas pour éviter aux développeurs et responsables IT et du SI pour éviter qu’ils ne soient victimes de paquets malveillants dans les référentiels open source. Une tactique consiste à inclure une nomenclature logicielle dans chaque application acquise par un service IT. Grâce à elle, les équipes DevOps/DevSecOps peuvent suivre les composants logiciels, identifier les vulnérabilités et garantir la conformité. Dans un avis intitulé « Defending Against Software Supply Chain Attacks » (Se défendre contre les attaques de la chaîne d’approvisionnement logicielle), et publié en 2021, l’Agence américaine de cybersécurité et de sécurité des infrastructures (Cybersecurity and Infrastructure Security Agency, CISA) et le National Institute for Standards and Technology (NIST) proposent plusieurs conseils pour créer des applications open source sécurisées. En premier lieu, elles suggèrent de créer un programme officiel de gestion des risques liés à la chaîne d’approvisionnement afin de garantir que ces risques soient pris en compte dans toute l’entreprise, y compris par les cadres et les responsables des opérations et du personnel occupant des fonctions de soutien, comme l’IT, les acquisitions, le service juridique, la gestion des risques et la sécurité.

Selon l’avis, il est possible de réduire sa surface d’attaque logicielle grâce à la gestion de la configuration, laquelle comprend :

– La mise en place d’un contrôle des modifications des configurations ;- Des analyses d’impact sur la sécurité ;- La mise en œuvre des directives fournies par les fabricants pour renforcer la sécurité des logiciels, des systèmes d’exploitation et des firmwares ;- La tenue d’un inventaire des composants du système d’information.

Par ailleurs, l’Open Source Web Application Security Project (OWASP) conseille aux développeurs qui utilisent npm :

– De toujours vérifier et effectuer les contrôles nécessaires sur les modules tiers qu’ils prévoient d’installer afin de confirmer leur état et leur crédibilité ;- De ne pas procéder immédiatement à la mise à niveau vers les nouvelles versions ; de laisser les nouvelles versions des paquets circuler pendant un certain temps avant de les essayer ;- Avant de procéder à la mise à niveau, de veiller à consulter les journaux des modifications et les notes de mise à jour de la version mise à niveau ;- De veiller à ajouter le suffixe ignore-scripts afin de désactiver l’exécution de tout script par des paquets tiers lors de l’installation de paquets ;- D’envisager l’ajout de ignore-scripts au fichier de projet .npmrc ou à la configuration globale npm.

Enfin, Andrew Krug, responsable de la sécurité chez Datadog, recommande encore :

– De donner aux développeurs la possibilité d’installer un scan des paquets en temps réel lors de l’installation ;- De se protéger contre le typosquatting et la confusion des dépendances en privilégiant l’utilisation de référentiels de paquets internes comme garde-fou pour les paquets approuvés ;- De maintenir des nomenclatures logicielles ;- De déployer l’analyse de la composition logicielle (Software Composition Analysis, SCA) à chaque phase du cycle de vie du développement logiciel. « Les outils SCA traditionnels n’analysent que périodiquement des instantanés de code », a fait remarquer M. Krug, « or, une détection efficace doit être complétée par une visibilité en temps réel sur les services déployés, y compris en production, afin de redéfinir les priorités et de se concentrer sur les problèmes exposés dans des environnements sensibles ».

Systancia scelle un accord de partenariat avec Experis pour déployer dans les entreprises une offre souveraine de sécurité basée sur le modèle zero trust.

L’éditeur français Systancia spécialisé dans la sécurité s’associe à l’ESN/intégrateur Experis (marque de ManpowerGroup) pour proposer une alternative française et indépendante aux solutions américaines d’accès de type zero trust. Rappelons que Systancia propose la plateforme appelée Cyberelements qui permet de sécuriser les accès, les identités et les applications dans des environnements IT et OT (industriels). De son côté, Experis sera en charge de l’audit de faisabilité, du conseil en architecture, de l’intégration et du support technique.Ensemble, ils vont mettre en place une équipe dédiée pour détecter les besoins et proposer un accompagnement sur-mesure. Plus précisément, cette collaboration va reposer sur trois étapes, la première consiste à bien identifier les demandes via des rendez-vous, s’ensuivent l’analyse et le cadrage qui s’effectuent par des missions de conseil en architecture de 5 à 30 jours ; puis intervient le déploiement conjoint de la solution.

« Nous savons qu’un projet de cybersécurité n’est véritablement un succès que si son intégration est parfaitement maîtrisée. C’est pourquoi nous nous entourons de partenaires comme Experis dont l’expertise et la valeur ajoutée font référence sur le marché », souligne Nicolas Augagneur, responsable channel de Systancia. De son côté, Stéphane Gand, directeur commercial cloud et infrastructure au sein d’Experis, met en avant les atouts de Systancia, à savoir sa capacité d’offrir une traçabilité complète et une sécurisation renforcée des SI et souveraine.

La Commission européenne prépare une refonte majeure du règlement général sur la protection des données à caractère personnel. Les associations de défense de la vie privée s’inquiètent d’un potentiel affaiblissement du texte.

Le 19 novembre prochain, la Commission européenne compte modifier certains textes à travers un paquet de mesures nommées « Digital Omnibus ». La semaine dernière, le Financial Times évoquait un possible assouplissement des dispositions de l’IA Act. Selon l’association allemande Netzpolitik.org, les modifications de l’exécutif bruxellois ciblent aussi le RGPD (règlement général de protection des données) et pourrait redéfinir la manière dont les entreprises traitent les données personnelles.

Un assouplissement du consentement pour les cookies

Selon le texte consulté par l’association, la Commission supprimerait l’obligation pour les sites web d’obtenir un consentement explicite avant de déposer des cookies de suivi et autoriserait explicitement l’entraînement des IA sur des données personnelles lorsque cela est justifié par les « intérêts légitimes » des entreprises. Le projet introduirait l’article 88 bis dans le RGPD afin de couvrir le « traitement des données à caractère personnel sur et à partir d’équipements terminaux », transférant ainsi la réglementation relative aux cookies de la directive ePrivacy au RGPD lui-même. Actuellement, l’article 5, paragraphe 3, de la directive ePrivacy exige des sites web qu’ils obtiennent un consentement explicite avant de stocker ou d’accéder à des cookies non essentiels sur les terminaux des utilisateurs.

Pour expliquer ce changement, la Commission a fait valoir que cette situation a engendré une insécurité juridique et des coûts de mise en conformité plus élevés en raison du chevauchement des pouvoirs de contrôle des autorités nationales. Selon la modification proposée, les sites web pourraient traiter les données collectées par le biais des cookies sur la base d’une liste restreinte de finalités à faible risque ou sur tout fondement juridique prévu par le RGPD, y compris l’intérêt légitime. Cela marquerait un tournant majeur, passant d’un suivi avec consentement explicite à un suivi avec consentement implicite avec une opposition a posteriori. « Si le consentement est nécessaire pour garantir le contrôle des personnes concernées, il ne constitue pas toujours le fondement juridique le plus approprié pour un traitement ultérieur », indique le projet.

Les associations vent debout

Les associations de défense de la vie privée estiment que l’institution européenne instrumentalisait « la lassitude face aux cookies » pour assouplir les normes de protection de la vie privée. « Le RGPD, la directive ePrivacy et la loi sur l’IA ne sont pas des obstacles à l’innovation ; ils constituent le fondement du modèle numérique européen centré sur l’humain », a écrit European Digital Rights (EDRi) dans un blog publié en octobre. « Pourtant, sous prétexte de cohérence, la Commission semble prête à affaiblir les protections offertes par ePrivacy. »

Le projet de texte détaille également l’article 88b, qui obligerait les navigateurs et les systèmes d’exploitation à transmettre automatiquement les préférences de consentement des utilisateurs une fois les normes techniques définies, ce qui pourrait entraîner la disparition progressive des bannières de cookies actuellement en vigueur. Une exception est toutefois prévue pour les entreprises de médias. Les organes de presse pourraient continuer à exiger un consentement explicite, ce que la Commission justifie par la nécessité de protéger les « fondements économiques » du journalisme.

Le feu vert pour l’entraînement de l’IA

La proposition aborde directement l’une des questions les plus controversées du droit européen de la protection des données : la possibilité pour les entreprises d’entraîner des systèmes d’IA à l’aide de données personnelles. Le projet de règlement stipule que l’entraînement, les tests et la validation de l’IA peuvent être effectués sur la base de l’« intérêt légitime » du RGPD, à condition que les entreprises mettent en œuvre des garanties telles que la minimisation des données, la transparence et un droit d’opposition inconditionnel. « Le traitement des données personnelles à des fins d’entraînement de l’IA peut donc être effectué aux fins d’un intérêt légitime », indique le projet, ajoutant que les développeurs doivent s’assurer que l’entraînement est « bénéfique pour la personne concernée et pour la société dans son ensemble ». La Commission a cité la nécessité de détecter les biais et de garantir la précision des résultats des modèles comme exemples de finalités « bénéfiques ».

Cependant, des juristes spécialisés dans la protection de la vie privée ont déclaré qu’invoquer l’intérêt légitime pour le traitement des données par l’IA pourrait ouvrir la voie à l’exploration massive de données sans consentement individuel, ce que le RGPD visait initialement à empêcher. Le projet de règlement introduirait également une exemption limitée pour les données sensibles qui apparaissent par inadvertance dans les ensembles de données d’IA. Si la suppression de ces données exigeait un « effort disproportionné », les entreprises pourraient les conserver en appliquant des mesures de protection empêchant leur utilisation ou leur divulgation. Pour Max Schrems, dirigeant de l’association Noyb, ces mesures sur l’IA donneraient ni plus, ni moins, « une carte blanche aux entreprises spécialisées dans l’IA (comme Google, Meta ou OpenAI) pour collecter les données personnelles des Européens ».

Protection des données sensibles restreinte

Autre modification controversée, une proposition restreindrait la définition des données sensibles au sens de l’article 9 du RGPD. Une protection renforcée ne s’appliquerait que lorsque les informations révèlent directement des caractéristiques telles que l’origine ethnique, la religion ou la santé, excluant les données qui ne font qu’impliquer ces caractéristiques par analyse ou déduction. « Pour la plupart des types de données personnelles énumérés à l’article 9, paragraphe 1, il n’existe pas de risques significatifs lorsque les données ne sont pas intrinsèquement sensibles », indique le projet. Les critiques craignent que cela permette aux entreprises de déduire des caractéristiques protégées – telles que l’orientation sexuelle ou les opinions politiques – à partir de données apparemment neutres sans déclencher de protections juridiques plus strictes.

L’Institut de droit européen a reconnu, dans ses observations du 14 octobre, que des mises à jour limitées du RGPD pourraient être nécessaires, mais a souligné que « les améliorations ne doivent pas se faire au détriment de la protection des droits fondamentaux ». Les modifications proposées pourraient bouleverser la gouvernance des données des entreprises en Europe. Les sociétés n’auraient plus besoin de systèmes de gestion du consentement pour la plupart des cookies de suivi, mais devraient conserver une documentation détaillée pour justifier le traitement au titre de l’« intérêt légitime ». Le Réseau européen des droits numériques a critiqué la consultation, la qualifiant d’« exclusion délibérée », avec des délais « extrêmement courts » et des évaluations de la réalité centrées « presque exclusivement sur les acteurs du secteur ».

Une extension Visual Studio Code rudimentaire mais capable de chiffrer des fichiers et de voler des données a réussi à contourner les contrôles de Microsoft sur sa place de marché VSCode pour développeurs.

La marketplace VSCode de Microsoft est-elle sécurisée ? La question se pose après la découverte d’une étrange extension pour l’éditeur de code open source adoptant un comportement proche de celui d’un ransomware. Elle a pu être publiée sans aucun problème et le ou les auteurs n’ont pas été identifiés. Selon les conclusions de Secure Annex, société spécialisée dans la sécurité des extensions qui a mené l’enquête, ce code malveillant publié sur la place de marché était clairement codé sans être très élaboré. « Il ne s’agit pas d’un exemple sophistiqué, car le code du serveur de commande et de contrôle a été accidentellement (?) inclus dans le package de l’extension publiée, avec des outils de décryptage », a déclaré John Tuckner fondateur de Secure Annex, ajoutant que l’extension comprenait une description « manifestement malveillante » sur la boutique. Malgré les signaux d’alerte évidents, le code a échappé aux filtres de vérification de Microsoft et reste disponible même après avoir été signalé, a déclaré M. Tuckner. Le code malveillant comprend des fonctionnalités de chiffrement et de vol de fichiers.

Selon le dirigeant, l’extension nommée susvsex (pour suspicious VSX) et publiée sous le pseudonyme tout aussi révélateur « Suspicious publisher » cache sa charge utile à la vue de tous. Visible sous le nom « suspublisher18.susvsex », elle comprend un fichier « package.json » qui s’active automatiquement à chaque événement, même pendant l’installation, tout en offrant une palette d’utilitaires pour « tester les fonctions de commande et de contrôle ». À l’intérieur du point d’entrée « extension.js », les chercheurs ont trouvé des variables codées en dur, notamment l’URL du serveur, les clés de chiffrement, les destinations C2 et les intervalles d’interrogation. La plupart de ces variables comportent des commentaires indiquant que le code a été généré par l’IA. Une fois déclenchée, l’extension lance la compression et le chiffrement des fichiers contenus dans un répertoire désigné, puis les télécharge vers un serveur de commande distant. M. Tucker a noté que le répertoire cible était configuré à des fins de test, mais qu’il pouvait facilement être remplacé par un véritable chemin d’accès au système de fichiers lors d’une future mise à jour ou par commande à distance. L’extension contenait deux décrypteurs, l’un en Python et l’autre en Node, ainsi qu’une clé de décryptage codée en dur, éliminant ainsi toute possibilité d’intention malveillante.

L’extension a pointé vers un C2 basé sur GitHub

Les chercheurs en sécurité de Secure Annex ont identifié une infrastructure de commande et de contrôle (C2) assez inhabituelle basée sur GitHub, au lieu de s’appuyer sur des serveurs C2 traditionnels. L’extension utilise un référentiel GitHub privé pour recevoir et exécuter des commandes. Elle vérifie régulièrement les derniers commits dans un fichier nommé « index.html », exécutait les commandes intégrées, puis réécrivait la sortie dans « requirements.txt » à l’aide d’un jeton d’accès personnel GitHub (PAT) intégré à l’extension. Outre le fait de faciliter l’exfiltration des données de l’hôte, ce comportement C2 a exposé l’environnement de l’attaquant, dont les traces ont conduit à un utilisateur GitHub à Bakou, dont le fuseau horaire correspondait aux données système enregistrées par le logiciel malveillant lui-même. La société de sécurité qualifie cela d’exemple type de développement de logiciel malveillant assisté par l’IA, avec des fichiers source mal placés (y compris des outils de décryptage et le code C2 de l’attaquant) et un fichier README.md qui décrit explicitement sa fonctionnalité malveillante. Mais M. Tuckner soutient que la véritable faille réside dans le système d’examen du marché de Microsoft, qui n’a pas signalé l’extension.

Microsoft a déclaré avoir retiré l’extension du marché. Chaque page d’extension du marché contient un lien « Signaler un abus », et la société enquête sur tous les signalements, a-t-elle déclaré ; lorsque la nature malveillante d’une extension est vérifiée, ou lorsqu’une vulnérabilité est détectée dans une dépendance de l’extension, celle-ci est retirée du marché, ajoutée à une liste de blocage et automatiquement désinstallée par VS Code, a-t-elle ajouté. Les entreprises qui souhaitent empêcher l’accès à la boutique peuvent le faire en bloquant des points de terminaison spécifiques, précise l’éditeur. Des incidents récents ont montré que les extensions malveillantes ou négligentes deviennent un problème récurrent dans l’écosystème Visual Studio Code, certaines divulguant des identifiants et d’autres volant discrètement du code ou minant des cryptomonnaies. Outre une liste d’IOC (indices de compromission) partagés, Secure Annex met en avant Extension Manager, un outil conçu pour bloquer les extensions malveillantes connues et inventorier les modules complémentaires installés dans une organisation.

AWS construit un câble sous-marin transatlantique du Maryland à l’Irlande opérationnel en 2028 d’une capacité de 320 térabits par seconde. Un apport pour les performances, mais qui peut inquiéter les DSI sur les risques de dépendance

et d’augmentation des coûts.

Amazon Web Services a annoncé le lancement de Fastnet, son dernier câble sous-marin à fibre optique transatlantique qui va relier le Maryland aux États-Unis en Irlande, soit une distance d’environ 5 300 km. Prévu pour être opérationnel en 2028, ce câble pourrait garantir la continuité des services AWS en cas de perturbations. « De plus, il permettra de créer une conception de réseau adaptée à la demande croissante de cloud, d’IA et d’applications de pointe qui utilisent les services AWS tels que CloudFront et Global Accelerator », selon le fournisseur. Afin d’assurer un réacheminement rapide des données et plusieurs niveaux de redondance, la capacité de Fastnet fournira plus de 320 térabits par seconde (Tbps) et inclura le système centralisé de surveillance du trafic en temps réel de la société afin de mettre en œuvre des millions d’optimisations quotidiennes pour éviter la congestion et d’autres problèmes avant qu’ils n’affectent les applications.

Taillé pour l’ère de l’IA

« Le système Fastnet sera doté d’une technologie évolutive et avancée de commutation optique positionnée sur le tracé du câble pour gérer les charges croissantes du trafic d’IA et s’adapter à la croissance future », a précisé le fournisseur. « Le trafic transatlantique est particulièrement sollicité en raison de l’asymétrie entre la formation des modèles d’IA basés aux États-Unis et la résidence des données et l’exécution des inférences en Europe », a expliqué Sanchit Vir Gogia, CEO et analyste en chef chez Greyhound Research. « Fastnet s’attaque directement à ce goulot d’étranglement en introduisant une marge de manœuvre à haute capacité et un itinéraire alternatif stratégiquement placé qui contourne les grappes de câbles encombrées de New York et du Royaume-Uni. Son extension entre le Maryland et l’Irlande correspond à la cartographie actuelle des actifs numériques par les entreprises : la côte est des États-Unis pour la densité de calcul et les zones d’atterrissage européennes pour l’alignement réglementaire. » Conçues pour offrir une fiabilité et des performances à long terme, les fibres optiques seront protégées par un blindage supplémentaire en acier dans les zones côtières afin de les protéger contre les activités naturelles et humaines.

La croissance explosive des charges de travail liées aux données et à l’IA de ces dernières années a poussé les hyperscalers à ne plus se contenter de s’appuyer sur une infrastructure partagée pour répondre à la demande, mais aussi à contrôler la couche de connectivité. « Pour des fournisseurs de cloud comme AWS, cela s’apparente à une intégration en amont. À mesure qu’ils construisent et possèdent des câbles sous-marins, le pouvoir passe des opérateurs de télécommunications traditionnels aux hyperscalers. Cela donne à ces derniers un plus grand contrôle sur la capacité, le routage et la gestion du réseau, et qu’ils soient adaptés à leurs besoins de services cloud et d’IA », a expliqué Pareek Jain, CEO d’EIIRTrend & Pareekh Consulting. Ce contrôle présente plusieurs avantages pour les DSI. « La propriété des câbles sous-marins par les hyperscalers améliore généralement l’efficacité opérationnelle en intégrant la gestion des câbles à l’infrastructure réseau cloud, ce qui permet une optimisation en temps réel et une gestion automatisée du trafic. Il en résulte une fiabilité et des performances accrues pour les utilisateurs finaux », a souligné M. Jain. De plus, grâce à la réduction du nombre de transferts, le débit sera meilleur et la récupération plus rapide en cas de problème.

Dépendance vis-à-vis des fournisseurs et répercussions sur les coûts

Cependant, cette consolidation accrue introduit de nouveaux risques pour les entreprises. La dépendance vis-à-vis d’une même entreprise pour l’exécution des calculs, le stockage et les routes de câbles sous-marins reliant les régions augmente le niveau de dépendance et la complexité de celle-ci avec les fournisseurs. « Cela signifie également que l’entreprise est plus exposée. Elle perd en visibilité sur l’acheminement ou la hiérarchisation du trafic, et sa résilience dépend des décisions d’un seul fournisseur. Si ce fournisseur change d’orientation, de tarification ou de politique, ses options se réduisent rapidement », glisse Sanchit Vir Gogia. Il ajoute « les entreprises doivent réfléchir sérieusement à l’influence qu’elles peuvent avoir lorsqu’un seul fournisseur possède les câbles, les capacités de calcul, les outils et les règles. Il ne s’agit plus d’une question de conception de réseau, mais d’une question de contrôle ». Techniquement, le rôle croissant des hyperscalers dans la construction et la propriété des câbles sous-marins peut avoir un impact significatif et généralement positif sur les coûts pour les entreprises, car il va de pair avec l’augmentation massive de l’offre et de la concurrence induite par ces câbles à haute capacité. Cependant, l’effet final sur les prix pratiqués par les entreprises est complexe.

M. Jain a suggéré que, même si, à terme, les câbles sous-marins appartenant aux hyperscalers peuvent réduire les coûts de transit réseau grâce à des économies d’échelle internes, l’effet sur la tarification des entreprises reste complexe. Les hyperscalers pourraient disposer d’un pouvoir de fixation des prix plus important, en particulier si leurs réseaux de câbles deviennent essentiels pour la connectivité cloud internationale à haute capacité. Cela pourrait conduire à des modèles de tarification favorisant les services cloud et réseau groupés, ce qui pourrait réduire la transparence des composants des coûts réseau pour les entreprises. « Les entreprises qui s’attendent à ce que Fastnet entraîne une baisse des factures de transfert de données dans le cloud se trompent sur la structure des prix », a fait remarquer M. Gogia. « Les économies réelles ne se concrétisent que lorsque les DSI traitent la connectivité comme une couche négociable, comparent les coûts totaux de l’architecture entre deux fournisseurs et imposent la prévisibilité des coûts à des seuils de réplication élevés. Sans ces mesures, les entreprises peuvent bénéficier d’une amélioration des performances, mais leur exposition économique reste inchangée, car elles dépendent d’une infrastructure sur laquelle elles n’ont plus aucune influence. »

Les administrateurs Windows en entreprises auront jusqu’à décembre 2027 au plus tard pour mettre en place des alternatives à la protection offerte par Microsoft Defender Application Guard (MDAG) pour Office.

La fin de vie de Defender Application Guard de Microsoft (MDAG) se précise. Cette fonction, qui protège les documents Office de logiciels malveillants envoyés par courriel, a été ajoutée à certains niveaux d’abonnement de la suite bureautique depuis 2019. Mais en décembre 2023, le fournisseur a annoncé sa fin de support. On en sait désormais un peu plus sur l’échéance : la suppression commencera avec la version 2602 d’Office current patch tuesday channel en février 2026 (avec une fin complète en décembre 2026), puis le monthly enterprise channel en avril 2026 (fin complète programmée en février 2027), et semi-annual enterprise channel en juillet 2026 (fin totale en juillet 2027). De manière ambiguë, le calendrier indique également décembre 2027 comme date finale de suppression, bien qu’il soit probable que cette date ultérieure corresponde à la date limite pour les clients disposant de licences de support étendu.

Au lieu d’ouvrir les fichiers dans la mémoire principale, MDAG les ouvre dans un bac à sable Hyper-V, isolant ainsi tout malware exécuté à partir du système d’exploitation. Le concept est judicieux, mais il présente l’inconvénient de ralentir considérablement le chargement des documents. Il pourrait également être compromis par des vulnérabilités occasionnelles dans la couche d’isolation. C’est le cas par exemple de la faille CVE-2022-26706, de type échappement de bac à sable ayant affecté macOS.

Ce que doivent faire les administrateurs

Microsoft remplace MDAG par deux couches de sécurité qui, selon lui remplissent la même fonction : les règles de réduction de la surface d’attaque (Attack Surface Reduction, ASR) et de contrôle d’application Windows Defender (Windows Defender Application Control, WDAC). ASR est un mécanisme basé sur des règles qui bloquent les scripts malveillants, les exécutables ou l’injection de code. Si ses performances sont nettement améliorées, l’un de ses inconvénients potentiels est qu’il repose sur l’analyse comportementale. À la question de savoir ce qui pourrait se passer si des pirates utilisaient une nouvelle technique qui n’est pas encore détectée par l’ASR, le fournisseur répond que cela arrive rarement, car la plupart des attaques par documents malveillants exploitent des techniques prévisibles. Grâce à l’apprentissage machine basé sur le cloud, les chances qu’une attaque innovante passe outre l’ASR sont jugées faibles. Par ailleurs, l’analyse WDAC, qui s’exécute au niveau du noyau, bloque les applications en surveillant les signatures numériques, les hachages de fichiers et d’autres signaux de réputation.

Le processus de suppression est automatique mais demande néanmoins une intervention des administrateurs. De nombreuses équipes IT ne sont probablement pas très au fait de l’existence de MDAG, et sa suppression pourrait entraîner des tâches supplémentaires. L’éditeur leur recommande de procéder comme suit :

– Activer les règles ASR de Defender pour Endpoint afin de bloquer les comportements risqués des fichiers Office ;- Activer Windows Defender Application Control (WDAC) pour garantir que seul du code fiable et signé s’exécute sur les terminaux ;- Consulter la documentation interne et les conseils du service d’assistance si l’entreprise utilisait auparavant Application Guard for Office.

Un risque potentiel si MDAG est intégré à des flux automatisés

Mais la suppression de MDAG pourrait encore poser des problèmes aux clients qui l’ont intégré dans des flux automatisés. Un exemple générique serait un script de flux de travail automatisé qui n’autorise l’ouverture d’un document Office qu’après son passage par MDAG. Si MDAG n’est plus présent, ce script devra être réécrit et les procédures modifiées si les journaux des tests de sécurité d’isolation étaient envoyés aux SIEM dans le cadre des règles de conformité. Même si cela affecte principalement les entreprises adoptant une approche prudente vis-à-vis des documents Office, notamment les infrastructures critiques ou les administrations publiques, cette réécriture de script pourrait représenter une charge de travail importante. Ce qui ne fait aucun doute, c’est le stress induit par le renouvellement régulier des fonctionnalités nouvelles et obsolètes sur une plateforme Windows dont la complexité est devenue progressivement byzantine.

En ajoutant des fonctions d’observabilité à son offre Vertex AI Agent Builder, Google Cloud renforce sa position face à AWS et Microsoft alors que les entreprises recherchent des moyens plus rapides et plus fiables pour déployer et gérer des agents IA.

Petit à petit, Google Cloud enrichit Vertex AI Agent Builder avec des tableaux de bord d’observabilité inédits, des outils de création et de déploiement plus rapides et des contrôles de gouvernance plus stricts. Objectif : faciliter le passage des agents IA du prototype à la production à grande échelle pour les développeurs. Cette évolution ajoute un dashboard de supervision dans le runtime Agent Engine pour suivre l’utilisation des tokens, la latence et les taux d’erreur, ainsi qu’une nouvelle couche d’évaluation capable de simuler les interactions des utilisateurs afin de tester la fiabilité des agents. Les développeurs peuvent désormais déployer des agents en production à l’aide d’une seule commande grâce à l’agent development kit (ADK), a fait savoir le fournisseur dans un billet de blog. Des outils de gouvernance ont été ajoutés, tels que les identités d’agents liées à Cloud IAM et Model Armor, qui bloquent les attaques par injection de prompt, sont conçus pour améliorer la sécurité et la conformité.

L’ADK, qui selon la firme de Mountain View a été téléchargé plus de sept millions de fois, prend désormais en charge Go en plus de Python et Java. Cette prise en charge linguistique élargie vise à rendre ce framework ouvert accessible à un plus grand nombre de développeurs et à améliorer la flexibilité des équipes d’entreprise qui s’appuient sur des piles multilingues. La société a également étendu les services mangés au sein du runtime Agent Engine. Les développeurs peuvent désormais déployer directement dessus à partir de l’interface de ligne de commande ADK sans créer de compte Google Cloud. Une adresse Gmail suffit pour commencer à utiliser le service, avec une période d’essai gratuite de 90 jours disponible pour le tester. Les agents créés avec Vertex AI Agent Builder peuvent également être enregistrés dans Gemini Enterprise, ce qui permet aux employés d’accéder à des agents personnalisés dans un seul espace de travail et de relier les outils internes aux workflows de GenAI. La course pour fournir des outils conviviaux aux développeurs afin de créer des systèmes d’agents sécurisés et évolutifs reflète une évolution plus large de l’IA d’entreprise. Avec les dernières mises à jour, Google renforce sa position face à la concurrence, notamment Azure AI Foundry de Microsoft et AWS Bedrock.

Des gains de productivité pour les développeurs

Ces mises à jour visent à faciliter la création et la mise à l’échelle des agents IA tout en améliorant la gouvernance et les contrôles de sécurité. « En transformant l’orchestration, la configuration de l’environnement et la gestion du temps d’exécution en services managés, le kit de développement d’agents de Google réduit le temps nécessaire à la création et au déploiement de logiciels », a déclaré Dhiraj Badgujar, directeur de recherche senior chez IDC. « Le registre de modèles intégré, l’IAM et la structure de déploiement de Vertex peuvent raccourcir les cycles de développement initiaux pour les entreprises qui utilisent déjà GCP […] LangChain et Azure AI Foundry offrent une plus grande interopérabilité entre les modèles et le cloud, ainsi qu’une plus grande flexibilité manuelle, mais ils nécessitent davantage de configuration et d’intégration sur mesure pour atteindre le même niveau d’évolutivité, de surveillance et de parité environnementale », a ajouté M. Badgujar. « Pour les nouveaux projets compatibles avec GCP, ADK peut accélérer les cycles de développement de 2 à 3 fois. »

Charlie Dai, vice-président et analyste principal chez Forrester, reconnaît que les dernières fonctions de Google rationalisent le processus de développement. « Comparé à d’autres offres qui nécessitent souvent des pipelines personnalisés et des étapes d’intégration, l’approche de Google permet de réduire le temps d’itération pour les équipes qui utilisent déjà Vertex AI », ajoute M. Dai. Tulika Sheel, vice-présidente senior chez Kadence International, souligne que l’ADK et le déploiement en un clic dans Vertex AI Agent Builder simplifient la création d’agents en réduisant les efforts de configuration et d’intégration. « Pour les workflows hautement personnalisés ou de niche, la flexibilité des solutions de frameworks ouverts reste gagnante, mais pour de nombreuses entreprises qui cherchent à accélérer leur retour sur investissement, l’offre de Google pourrait être un véritable accélérateur », ajoute Mme Sheel. Selon Sanchit Vir Gogia, analyste en chef, fondateur et CEO de Greyhound Research, cette mise à niveau représente également une réinitialisation de la manière dont les entreprises passent du prototype à la production. « Pendant des années, les équipes ont été ralenties par les transferts entre le développement, la sécurité et les opérations », explique M. Gogia. « Chaque phase ajoutait de nouveaux outils, de nouvelles révisions et de nouveaux retards. Google a regroupé tous ces éléments en une seule voie. Un développeur peut désormais créer, tester et lancer un agent qui s’inscrit déjà dans la politique de l’entreprise. »

Fonctions d’observabilité et d’évaluation

Les analystes considèrent ces outils d’observabilité et d’évaluation comme une amélioration significative, même s’ils estiment que les capacités sont encore en cours de développement pour les workflows d’agents à grande échelle et non déterministes. « Les fonctionnalités de Vertex AI Agent Builder constituent une avancée solide, mais elles en sont encore à un stade précoce pour le débogage d’agents complexes et non déterministes », indique M. Dai. « Bien qu’elles fournissent des mesures granulaires et une traçabilité, l’intégration avec OpenTelemetry ou Datadog est possible grâce à des connecteurs personnalisés, mais n’est pas encore native. » D’autres s’accordent à dire que ces outils ne sont pas encore tout à fait au point. Les dernières mises à jour facilitent un débogage en temps réel et rétrospectif avec un traçage au niveau des agents, un audit des outils et une visualisation de l’orchestrateur, ainsi qu’une évaluation à l’aide de tests de régression basés sur des mesures et sur le LLM.

« ADK offre une grande visibilité aux agents natifs GCP, mais l’observabilité multicloud n’est pas encore au point », fait savoir M. Badgujar. « Les dernières fonctionnalités facilitent considérablement le débogage des flux non déterministes, même si la corrélation approfondie entre les états multi-agents nécessite encore une télémétrie tierce. » M. Sheel a fait écho à ces réflexions tout en reconnaissant que ces fonctionnalités sont prometteuses. « À ce stade, elles sont encore en cours de maturation », selon M. Sheel. « Les entreprises qui utilisent des workflows non déterministes complexes (orchestration multi-agents, chaînes d’outils) auront probablement besoin de crochets de surveillance supplémentaires, de tableaux de bord personnalisés et d’extensions métriques. »

A l’occasion du vote pour la personnalité IT 2025 du Monde Informatique, la rédaction revient sur l’ensemble des candidats. Focus sur Johanne Brousse, vice-procureur en charge de la section de lutte contre la cybercriminalité.

Vous avez jusqu’au 30 novembre pour voter pour le ou la candidate qui deviendra la personnalité IT du Monde Informatique pour l’année 2025. 8 hommes et femmes sont en lice, l’occasion pour la rédaction de faire un focus sur chaque candidat et éclairer votre suffrage.

En quelques années, Johanna Brousse est devenue une figure importante de la lutte contre la cybercriminalité. Magistrate, elle s’est très tôt tournée vers ce sujet encore balbutiant, mais avec de fortes perspectives de développement. Affectée à la section J3 du Parquet de Paris, elle couvre plusieurs périmètres dans le domaines de la cybercriminalité allant des rançongiciels aux cryptomonnaies en passant par le cyber-espionnage ou les sites frauduleux. Ses équipes participent à des opérations internationales qui permettent de démanteler des activités cybercriminelles, comme NoName057(16) ou la chaîne d’attaque par ransomware de différents gangs (Qakbot, Trickbot et WarmCookie). En 2024, elle a mené l’enquête sur Pavel Durov, CEO de Telegram qui a conduit à son arrestation très médiatisée.

Pour soutenir et voter pour Johanna Brousse. Cliquez sur le lien