Un pirate a créé de faux comptes Twitter et Github vue d’attirer de vrais chercheurs en sécurité. Des dépôts de code compromis ont également servi aux pirates dans leur opération malveillante.

Dans cette campagne d’attaque inhabituelle, le pirate a mis en place des référentiels GitHub frauduleux hébergeant de faux exploits de type zero day pour des applications populaires, mais qui, en réalité, contiennent des logiciels malveillants. Le pirate a également créé de faux comptes GitHub et Twitter de chercheurs en sécurité et a même utilisé de vraies photos de chercheurs travaillant pour des entreprises de cybersécurité bien connues. « L’attaquant a fait beaucoup d’efforts pour créer tous ces faux profils, uniquement pour livrer des logiciels malveillants très évidents », ont déclaré dans un rapport les chercheurs de l’entreprise de sécurité VulnCheck, à l’origine de la découverte des référentiels malveillants. « On ne sait pas si leurs manœuvres ont porté leurs fruits, mais ils poursuivent leur stratégie d’attaque, semblant croire à un succès possible.

Si les attaques visant les chercheurs en sécurité ne sont pas nouvelles, elles sont relativement rares et davantage le fait de groupes de menaces persistantes avancées (Advanced Persistent Threat, APT) qui cherchent à accéder à des informations sensibles auxquelles ont accès les chercheurs. C’est ce qui s’est passé dans la campagne signalée par le Threat Analysis Group de Google en 2021, au cours de laquelle une entité nord-coréenne soutenue par le gouvernement avait créé un réseau de faux comptes de personnes qui se faisaient passer pour des chercheurs en sécurité sur Twitter, Telegram, LinkedIn et d’autres plateformes de médias sociaux, et qu’elle avait utilisé pour promouvoir des exploits « proof-of- concept » pour des vulnérabilités existantes, publiés sur un blog et dans des vidéos sur YouTube.

Une campagne de faux comptes GitHub

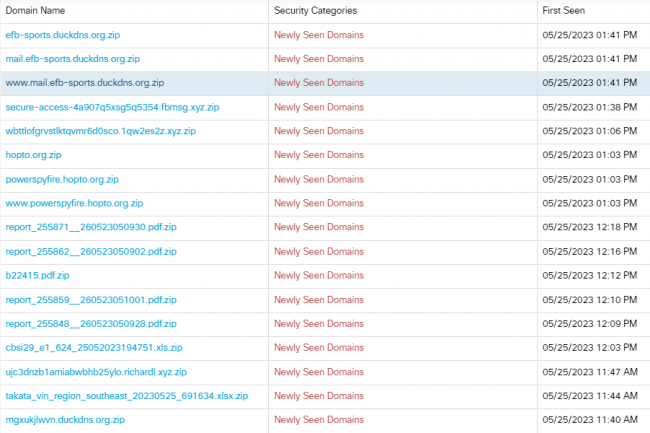

Les faux comptes ont été utilisés pour contacter de vrais chercheurs et les inviter à collaborer. Dans le cadre de cette campagne, un projet Visual Studio contenant le code d’un exploit « proof-of-concept » a été partagé, mais ce projet comprenait également une DLL malveillante qui déployait des logiciels malveillants sur l’ordinateur de la victime. Par ailleurs, certains chercheurs ayant visité le blog ont vu leurs systèmes à jour exploités, ce qui suggère que les attaquants avaient accès à des exploits de type « zero-day ». Le premier référentiel frauduleux a été découvert au début du mois de mai par VulnCheck qui l’a signalé à GitHub, qui l’a supprimé rapidement. Ce dépôt prétendait héberger un exploit d’exécution de code à distance de type « zero day » pour Signal, une application de communication sécurisée très populaire et très appréciée dans la communauté de la sécurité. L’attaquant a continué à créer de nouveaux comptes et référentiels avec de faux exploits pour Microsoft Exchange, Google Chrome, Discord et Chromium. Tous ont été créés par de faux comptes prétendant appartenir à des chercheurs travaillant pour une entreprise appelée High Sierra Cyber Security, qui ne semble pas exister.

Certains noms et informations de profil ont été réutilisés pour créer des comptes Twitter qui ont ensuite servi à promouvoir les dépôts, comme dans l’attaque signalée par Google. Cependant, il semble que l’attaque de 2021 était beaucoup plus sophistiquée que cette dernière campagne et rien ne prouve qu’elle soit l’œuvre des mêmes attaquants. Le code malveillant distribué à partir des dépôts GitHub compromis sous la forme d’un fichier appelé poc.py télécharge l’un de ces deux fichiers supplémentaires en fonction du système d’exploitation, l’un appelé cveslinux.zip et l’autre appelé cveswindows.zip. Ces fichiers d’archive sont ensuite décompressés et le fichier qu’ils contiennent est exécuté. La charge utile Windows est détectée par 36 programmes antivirus sur VirusTotal comme un Trojan, tandis que le binaire Linux est signalé par 25.

Une vigilance de tous les instants à avoir

« On ne sait pas si la campagne a été initiée par une personne seule qui a du temps à perdre ou si c’est une action plus avancée comme celle découverte par Google TAG en janvier 2021 », ont déclaré les chercheurs de VulnCheck. « Quoi qu’il en soit, les chercheurs en sécurité doivent comprendre qu’ils sont des cibles utiles pour les acteurs malveillants et doivent être prudents quand ils téléchargent du code à partir de GitHub. Ils doivent toujours examiner le code qu’ils exécutent et ne jamais utiliser un code qu’ils ne comprennent pas », ont-ils ajouté. Généralement, les spécialistes expérimentés prennent des précautions quand ils travaillent avec du code potentiellement malveillant. Pour tester un exploit « proof-of-concept », ils utilisent un système de test à l’intérieur d’une machine virtuelle bien surveillée et supprimée ensuite. Dans la plupart des entreprises, l’exécution d’un tel code sur une machine de travail constituerait très probablement une violation des politiques de sécurité standard, d’autant plus s’il s’agit d’une entreprise de cybersécurité.

Des attaques menées par le groupe de cybercriminels roumain Diicot ont été repérées et semblent principalement axées sur le cryptojacking. Mais l’acteur malveillant emploie également des botnets et des attaques par force brute à d’autres fins en s’appuyant sur une déclinaison du malware Mirai.

Selon des chercheurs en sécurité de Cado Labs, un groupe de cybercriminels se faisant appeler Diicot effectue des attaques massives par force brute et déploie une variante du botnet Mirai IoT sur des terminaux compromis. Le cybergang déploie également une charge utile de minage de crypto-monnaies sur des serveurs dotés d’un processeur de plus de quatre cœurs. « Bien que Diicot soit traditionnellement associé à des campagnes de cryptojacking, Cado Labs a découvert des preuves du déploiement par le groupe d’un agent de botnet basé sur Mirai, nommé Cayosin », ont déclaré les chercheurs de Cado Security dans une analyse de la campagne d’attaque récente et en cours du groupe. « Le déploiement de cet agent visait les routeurs utilisant le système d’exploitation OpenWrt basé sur Linux et destiné aux dispositifs embarqués ».

Diicot existe depuis au moins 2021 et s’appelait auparavant Mexals. Les chercheurs ont de fortes raisons de penser que le groupe est basé en Roumanie après avoir enquêté sur des chaînes de caractères trouvées dans ses charges utiles de logiciels malveillants, ses scripts et ses messages contre des groupes de pirates informatiques rivaux. Même son nouveau nom imite l’acronyme du Directorate for Investigating Organized Crime and Terrorism (DIICOT), un organisme roumain chargé de l’application de la loi qui, dans le cadre de son mandat de lutte contre le crime organisé, enquête également sur la cybercriminalité et engage des poursuites.

Des campagnes malveillantes au long cours

Lors des campagnes précédentes, documentées pour la première fois par l’éditeur d’antivirus Bitdefender en 2021, le groupe s’est principalement concentré sur le cryptojacking, une pratique consistant à détourner la puissance de calcul pour le minage de crypto-monnaies. Le groupe avait l’habitude de cibler les serveurs Linux dont les identifiants SSH étaient faibles en utilisant des scans de masse personnalisés et centralisés et des scripts de force brute essayant différentes combinaisons de noms d’utilisateur et de mots de passe. Si un serveur était compromis avec succès, le groupe déployait une version personnalisée du logiciel open source XMRig pour miner du Monero.

Les campagnes malveillantes se sont poursuivies, mais au début de l’année, des chercheurs d’Akamai ont noté le changement de nom du groupe et la diversification de sa boîte à outils d’attaque, avec l’ajout d’un ver SSH écrit en Golang et le déploiement d’une variante de Mirai appelée Cayosin. Mirai est un botnet qui se propage de lui-même et qui est conçu pour infecter les dispositifs de réseau intégrés. Il est apparu en 2016 et a été responsable de certaines des plus grandes attaques DDoS observées à l’époque. Le code source du botnet a ensuite été publié en ligne, ce qui a permis aux cybercriminels de développer de nombreuses autres variantes améliorées sur cette base.

Une série d’outils malveillants sur-mesure

La campagne d’attaque étudiée par Cado Security utilise un grand nombre des tactiques documentées par Bitdefender et Akamai et semble avoir commencé en avril 2023, lorsque le serveur Discord utilisé pour la commande et le contrôle a été créé. L’attaque commence par l’outil de force brute SSH Golang que le groupe appelle aliases. Celui-ci prend une liste d’adresses IP cibles et de paires nom d’utilisateur/mot de passe, puis tente de forcer l’authentification. Si le système compromis exécute OpenWRT, un système d’exploitation open source basé sur Linux pour les périphériques réseau tels que les routeurs, les attaquants déploieront un script appelé bins.sh qui est responsable de la détermination de l’architecture du processeur du périphérique et du déploiement d’un binaire Cayosin compilé pour cette architecture sous le nom cutie. Si le système n’utilise pas OpenWRT, aliases déploie l’une des nombreuses charges utiles binaires Linux créées à l’aide d’un outil open source appelé shell script compiler (SHC) et emballées avec UPX. Toutes ces payload servent de chargeurs de malware et préparent le système au déploiement de la variante XMRig.

L’une des charges utiles SHC exécute un script bash qui vérifie si le système dispose de quatre cœurs de processeur avant de déployer XMRig. Le script modifie également le mot de passe de l’utilisateur sous lequel il est exécuté. Si l’utilisateur est root, le mot de passe est fixé à une valeur codée en dur, mais si ce n’est pas le cas, celui-ci est généré dynamiquement à partir de la date actuelle. Le payload intègre également un autre exécutable SHC appelé .diicot ajoutant une clé SSH contrôlée par l’attaquant à l’utilisateur actuel afin de garantir un accès futur et de s’assurer que le service SSH est en cours d’exécution et enregistré en tant que service. Le script télécharge ensuite la variante personnalisée de XMRig et l’enregistre sous le nom Opera avec son fichier de configuration. Il crée également un script cron pour vérifier et relancer le processus Opera s’il n’est pas en cours d’exécution. L’outil de payload récupère un autre exécutable SHC « update » qui met en place l’outil de force brute de l’alias sur le système, et une copie du scanner de réseau Zmap sous le nom « chrome ». L’exécutable update diffuse également un script shell appelé « history » exécutant lui-même la mise à jour et créant ensuite un script cron garantissant que les exécutables history et chrome sont exécutés sur le système.

Des outils qui ne se limitent pas au cryptojacking

Le scanner chrome Zmap est exécuté sur un bloc réseau généré par l’outil de mise à jour et enregistre les résultats dans un fichier appelé bios.txt. Les cibles de ce fichier sont ensuite utilisées par des alias pour effectuer des attaques SSH par force brute avec une liste de noms d’utilisateur et de mots de passe que l’outil de mise à jour génère également. « L’utilisation de Cayosin démontre la volonté de Diicot de mener une variété d’attaques (pas seulement du cryptojacking) en fonction du type de cibles qu’ils rencontrent », ont déclaré les chercheurs du Cado. « Cette découverte est cohérente avec les recherches d’Akamai, ce qui suggère que le groupe continue d’investir des efforts d’ingénierie dans le déploiement de Cayosin. Ce faisant, Diicot a acquis la capacité de mener des attaques DDoS, car c’est l’objectif principal de Cayosin d’après les rapports précédents ».

Face à ces menaces, les entreprises devraient s’assurer qu’elles mettent en œuvre un renforcement de leurs connexions SSH pour leurs serveurs. Cela signifie utiliser une authentification par clé plutôt que par mot de passe et utiliser des règles de pare-feu pour restreindre l’accès SSH aux seules adresses IP de confiance. Selon les chercheurs, la détection d’un scan Diicot à partir d’un système devrait être simple au niveau du réseau, car il est assez bruyant.

L’émergence des grands modèles de langage donne des idées aux cyberpirates pour attaquer les applications d’intelligence artificielle qui les utilisent. Focus sur leurs caractéristiques et conseils pour mieux s’en prémunir.

L’Open Worldwide Application Security Project (OWASP) a publié les 10 vulnérabilités les plus critiques souvent observées affectant les grands modèles de langage (LLM) embarquées dans des applications IA, en soulignant leur impact potentiel, leur facilité d’exploitation et leur prévalence. Parmi les exemples de vulnérabilités figurent les injections rapides, les fuites de données, le sandboxing inadéquat et l’exécution de code non autorisée. Cette liste vise à sensibiliser les développeurs, les concepteurs, les architectes – et plus globalement les entreprises – aux risques de sécurité potentiels lors du déploiement et de la gestion des LLM. Et à suggérer des stratégies de remédiation en améliorant la posture de sécurité des applications LLM.

L’émergence d’interfaces de chat génératives basées sur des LLM et leur impact sur la cybersécurité est un sujet de discussion majeur. Les inquiétudes concernant les risques que ces nouvelles technologies pourraient introduire vont des problèmes potentiels liés au partage d’informations commerciales sensibles avec des algorithmes d’auto-apprentissage avancés, aux acteurs malveillants qui les utilisent pour renforcer considérablement les attaques. Certains pays et entreprises envisagent d’interdire l’utilisation de technologies d’IA générative telles que ChatGPT, ou l’ont déjà fait, pour des raisons de sécurité des données, de protection et de respect de la vie privée. Zoom sur les 10 vulnérabilités les plus critiques affectant les applications LLM et moyens de limiter leurs dégâts potentiels.

1. Attaque par injection d’invite

Les injections d’invites consistent à contourner les filtres ou à manipuler le modèle à l’aide d’invites soigneusement conçues qui font que le modèle ignore les instructions précédentes ou exécute des actions involontaires, fait savoir l’OWASP. « Ces vulnérabilités peuvent avoir des conséquences inattendues, notamment des fuites de données, des accès non autorisés ou d’autres atteintes à la sécurité ». Les failles les plus courantes en matière d’injection d’invite consistent à contourner les filtres ou les restrictions en utilisant des modèles de langage ou des jetons spécifiques, à exploiter les faiblesses des mécanismes de symbolisation ou d’encodage du LLM et à l’induire en erreur pour qu’il effectue des actions non souhaitées en fournissant un contexte trompeur.

Un exemple de scénario d’attaque est celui d’un utilisateur malveillant qui contourne un filtre de contenu en utilisant des modèles de langage, des jetons ou des mécanismes d’encodage spécifiques que le LLM ne parvient pas à reconnaître comme du contenu restreint, ce qui permet à l’utilisateur d’effectuer des actions qui devraient être bloquées, explique l’OWASP. Les mesures préventives pour cette vulnérabilité sont les suivantes :

– Mettre en œuvre une validation d’entrée et un nettoyage strict pour les invites fournies par l’utilisateur ;- Utiliser un filtrage contextuel et un encodage de sortie pour empêcher la manipulation des invites ;- Mettre à jour et affiner régulièrement le LLM pour améliorer sa compréhension des entrées malveillantes et des cas limites.

2. Fuite de données

Il y a fuite de données lorsqu’un grand modèle de langage révèle accidentellement des informations sensibles, des algorithmes propriétaires ou d’autres détails confidentiels par le biais de ses réponses. « Cela peut entraîner un accès non autorisé à des données sensibles ou à la propriété intellectuelle, des violations de la vie privée et d’autres atteintes à la sécurité », poursuit l’OWASP.

Un filtrage incomplet ou incorrect des informations sensibles dans les réponses du LLM, la configuration/mémorisation des données sensibles dans le processus de formation du modèle et la divulgation involontaire d’informations confidentielles en raison d’une mauvaise interprétation ou d’erreurs du LLM sont des vulnérabilités courantes en matière de fuite de données. Un attaquant pourrait délibérément interroger le modèle à l’aide d’invites soigneusement conçues, en essayant d’extraire des informations sensibles que le LLM a mémorisées à partir de ses données d’entraînement, ou un utilisateur légitime pourrait par inadvertance poser au modèle une question qui révèle des informations sensibles/confidentielles. Les mesures préventives contre les fuites de données sont les suivantes :

– Mettre en œuvre un filtrage strict des données de sortie et des mécanismes contextuels pour empêcher le LLM de révéler des informations sensibles ;- Utiliser des techniques de confidentialité différentielle ou d’autres méthodes d’anonymisation des données pendant le processus de formation du LLM afin de réduire le risque d’adaptation excessive ou de mémorisation ;- Auditer et examiner régulièrement les réponses du LLM pour s’assurer que des informations sensibles ne sont pas divulguées par inadvertance.

3. Un bac à sable inadéquat

Si un LLM n’est pas correctement isolé lorsqu’il a accès à des ressources externes ou à des systèmes sensibles, un sandboxing inadéquat peut conduire à une exploitation potentielle, à un accès non autorisé ou à des actions involontaires de la part du modèle. Une séparation insuffisante entre l’environnement LLM et d’autres systèmes ou magasins de données critiques, des restrictions inappropriées permettant au modèle d’accéder à des ressources sensibles, et des LLM effectuant des actions au niveau du système/interagissant avec d’autres processus sont des vulnérabilités courantes d’un sandboxing LLM inadéquat, selon l’OSWAP.

Un exemple d’attaque serait un acteur malveillant qui exploiterait l’accès d’un LLM à une base de données sensible en créant des invites qui demanderaient au système d’extraire et de révéler des informations confidentielles. Les mesures préventives sont les suivantes :

– Isoler l’environnement LLM des autres systèmes et ressources critiques ;- Restreindre l’accès du LLM aux ressources sensibles et limiter ses capacités au minimum requis pour l’objectif visé ;- Auditer et examiner régulièrement l’environnement du LLM et les contrôles d’accès pour s’assurer que l’isolement approprié est maintenu.

4. Exécution de code non autorisé

L’exécution de code non autorisé se produit lorsqu’un attaquant exploite un LLM pour exécuter un code malveillant, des commandes ou des actions sur le système sous-jacent par le biais d’invites en langage naturel. Les vulnérabilités les plus courantes sont les suivantes : entrée utilisateur non nettoyée ou restreinte qui permet aux attaquants de créer des invites qui déclenchent l’exécution d’un code non autorisé, restrictions insuffisantes sur les capacités du grand modèle de langage et exposition involontaire de fonctionnalités ou d’interfaces au niveau du système à l’IA.

L’OWASP a cité deux exemples d’attaques : un attaquant élaborant une invite qui demande au LLM d’exécuter une commande qui lance un shell inversé sur le système sous-jacent, accordant à l’attaquant un accès non autorisé, et le LLM étant involontairement autorisé à interagir avec une API au niveau du système, qu’un attaquant manipule pour exécuter des actions non autorisées sur le système. Les équipes peuvent contribuer à empêcher l’exécution de code non autorisé grâce à ces actions :

– Mettre en œuvre des processus stricts de validation et d’assainissement des entrées pour empêcher que des invites malveillantes ou inattendues ne soient traitées par le LLM ;- Assurer un sandboxing approprié et restreindre les capacités du LLM pour limiter sa capacité à interagir avec le système sous-jacent.

5. Vulnérabilités liées à la falsification des requêtes serveur

Les vulnérabilités liées à la falsification des requêtes côté serveur (SSRF) se produisent lorsqu’un attaquant exploite un LLM pour effectuer des requêtes involontaires ou accéder à des ressources restreintes telles que des services internes, des API ou des magasins de données. La validation insuffisante des entrées, qui permet aux attaquants de manipuler les invites du LLM pour lancer des requêtes non autorisées, et les mauvaises configurations des paramètres de sécurité du réseau ou de l’application, qui exposent les ressources internes au LLM, sont des vulnérabilités SSRF courantes, a déclaré l’OWASP. Pour exécuter une attaque, un cyberpirate pourrait créer une invite qui ordonne au LLM de faire une demande à un service interne, en contournant les contrôles d’accès et en obtenant un accès non autorisé à des informations sensibles. Il peut également exploiter une mauvaise configuration des paramètres de sécurité de l’application qui permet au LLM d’interagir avec une API restreinte, accédant ainsi à des données sensibles ou les modifiant. Les mesures préventives sont les suivantes :

– Mettre en œuvre une validation et un nettoyage rigoureux des entrées afin d’empêcher les invites malveillantes ou inattendues d’initier des requêtes non autorisées ;- Vérifier et examiner régulièrement les paramètres de sécurité du réseau et des applications afin de s’assurer que les ressources internes ne sont pas exposées par inadvertance au LLM.

6. Dépendance excessive à l’égard du contenu LLM généré

Selon l’OSAWP, une confiance excessive dans le contenu généré par les LLM peut conduire à la propagation d’informations trompeuses ou incorrectes, à une diminution de l’apport humain dans la prise de décision et à une réduction de la pensée critique. Et de prévenir : « les entreprises et les utilisateurs peuvent faire confiance au contenu généré par les MFR sans vérification, ce qui entraîne des erreurs, des communications erronées ou des conséquences inattendues. Les problèmes courants liés à une confiance excessive dans le contenu généré par le LLM comprennent l’acceptation du contenu généré par le LLM comme un fait sans vérification, la supposition que le contenu généré par le LLM est exempt de parti pris ou de désinformation, et le fait de s’appuyer sur le contenu généré par le LLM pour des décisions critiques sans intervention humaine ou supervision ».

Par exemple, si une entreprise se fie à un LLM pour générer des rapports et des analyses de sécurité et que le LLM génère un rapport contenant des données incorrectes que l’entreprise utilise pour prendre des décisions critiques en matière de sécurité, il pourrait y avoir des répercussions importantes en raison de la confiance accordée au contenu inexact généré par le LLM. Rik Turner, analyste principal en cybersécurité chez Omdia, parle d’hallucinations du LLM : « Si le contenu revient en disant des bêtises et que l’analyste peut facilement l’identifier comme tel, il ou elle peut l’annuler et aider l’algorithme à se perfectionner. Mais que se passe-t-il si l’hallucination est très plausible et ressemble à la réalité ? En d’autres termes, le LLM pourrait-il en fait renforcer la crédibilité d’un faux positif, avec des conséquences potentiellement désastreuses si l’analyste se lance dans la mise hors service d’un système ou bloque le compte d’un client fortuné pendant plusieurs heures ? ».

7. Alignement inadéquat de l’IA

L’alignement inadéquat de l’IA se produit lorsque les objectifs et le comportement du LLM ne sont pas alignés sur le cas d’utilisation prévu, ce qui entraîne des conséquences indésirables ou des vulnérabilités. Selon l’OWASP, les problèmes les plus fréquents sont les suivants : objectifs mal définis qui conduisent le LLM à donner la priorité à des comportements indésirables ou nuisibles, fonctions de récompense ou données d’entraînement mal alignées qui entraînent un comportement involontaire du modèle, insuffisance des tests et de la validation du comportement du LLM. Si un LLM conçu pour aider aux tâches d’administration du système est mal aligné, il pourrait exécuter des commandes nuisibles ou donner la priorité à des actions qui dégradent les performances ou la sécurité du système. Les équipes peuvent prévenir les vulnérabilités liées à un alignement inadéquat de l’IA en prenant les mesures suivantes :

– Définir les objectifs et le comportement prévu du LLM au cours du processus de conception et de développement ;- Veiller à ce que les fonctions de récompense et les données d’entraînement soient alignées sur les résultats souhaités et n’encouragent pas un comportement indésirable ou nuisible ;- Tester et valider régulièrement le comportement du LLM dans un large éventail de scénarios, d’entrées et de contextes afin d’identifier et de résoudre les problèmes d’alignement.

8. Contrôles d’accès insuffisants

Des contrôles d’accès insuffisants se produisent lorsque les contrôles d’accès ou les mécanismes d’authentification ne sont pas correctement mis en œuvre, ce qui permet à des utilisateurs non autorisés d’interagir avec le LLM et d’exploiter potentiellement les vulnérabilités. D’après l’OWASP, le fait de ne pas appliquer des exigences strictes en matière d’authentification pour accéder au LLM, une mise en œuvre inadéquate du contrôle d’accès basé sur les rôles (RBAC) permettant aux utilisateurs d’effectuer des actions au-delà de leurs autorisations prévues, et le fait de ne pas fournir de contrôles d’accès appropriés pour le contenu et les actions générés par le LLM sont autant d’exemples courants.

Un exemple d’attaque est celui d’un acteur malveillant qui obtient un accès non autorisé à un LLM en raison de la faiblesse des mécanismes d’authentification, ce qui lui permet d’exploiter les vulnérabilités ou de manipuler le système, explique l’organisme. Les mesures préventives sont les suivantes :

– Mettre en œuvre des mécanismes d’authentification forte, tels que l’authentification multifactorielle (MFA), pour s’assurer que seuls les utilisateurs autorisés peuvent accéder au LLM ;- Mettre en œuvre des contrôles d’accès appropriés pour le contenu et les actions générés par le LLM afin d’empêcher tout accès ou manipulation non autorisé.

9. Traitement inapproprié des erreurs

Il y a mauvaise gestion des erreurs lorsque les messages d’erreur ou les informations de débogage sont exposés d’une manière qui pourrait révéler des informations sensibles, des détails du système ou des vecteurs d’attaque potentiels à un acteur de la menace. Les vulnérabilités les plus courantes en matière de gestion des erreurs comprennent l’exposition d’informations sensibles ou de détails du système par le biais de messages d’erreur, la fuite d’informations de débogage qui pourraient aider un pirate à identifier des vulnérabilités ou des vecteurs d’attaque potentiels, et le fait de ne pas gérer les erreurs de manière gracieuse, ce qui peut entraîner un comportement inattendu ou des pannes du système.

Par exemple, un attaquant pourrait exploiter les messages d’erreur d’un LLM pour recueillir des informations sensibles ou des détails du système, ce qui lui permettrait de lancer une attaque ciblée ou d’exploiter des vulnérabilités connues. Par ailleurs, un développeur pourrait accidentellement laisser des informations de débogage exposées dans la production, ce qui permettrait à un attaquant d’identifier des vecteurs d’attaque potentiels ou des vulnérabilités dans le système, signale l’OWASP. Ces risques peuvent être atténués par les actions suivantes :

– Mettre en œuvre des mécanismes de gestion des erreurs appropriés pour s’assurer que les erreurs sont détectées, enregistrées et traitées ;- Veiller à ce que les messages d’erreur et les informations de débogage ne révèlent pas d’informations sensibles ou de détails du système ;- Envisager d’utiliser des messages d’erreur génériques pour les utilisateurs, tout en consignant des informations d’erreur détaillées pour les développeurs et les administrateurs.

10. Empoisonnement des données d’entraînement

L’empoisonnement des données d’entraînement se produit lorsqu’un attaquant manipule les données d’entraînement ou les procédures de réglage fin d’un LLM pour introduire des vulnérabilités, des portes dérobées ou des biais qui pourraient compromettre la sécurité, l’efficacité ou le comportement éthique du modèle, a écrit l’OWASP. Les problèmes courants d’empoisonnement des données d’entraînement comprennent l’introduction de portes dérobées ou de vulnérabilités dans le LLM par le biais de données d’entraînement manipulées de manière malveillante et l’injection de biais dans le LLM l’amenant à produire des réponses biaisées ou inappropriées. Les actions suivantes peuvent aider à prévenir ce risque :

– Garantir l’intégrité des données d’entraînement en les obtenant auprès de sources fiables et en validant leur qualité ;- Mettre en œuvre des techniques robustes d’assainissement et de prétraitement des données pour éliminer les vulnérabilités ou les biais potentiels des données d’apprentissage ;- Utiliser des mécanismes de surveillance et d’alerte pour détecter un comportement inhabituel ou des problèmes de performance dans le LLM, indiquant potentiellement un empoisonnement des données de formation.

Une responsabilité à assumer

Les responsables de la sécurité et les entreprises sont responsables de l’utilisation sécurisée des LLMLes experts s’accordent à dire que ces derniers sont responsables des interfaces de chat d’IA générative qui s’appuient sur des LLM. « Les équipes de sécurité et les équipes juridiques devraient collaborer pour trouver la meilleure voie à suivre pour leurs organisations afin d’exploiter les capacités de ces technologies sans compromettre la propriété intellectuelle ou la sécurité », a récemment déclaré Chaim Mazal, RSSI de Gigamon.

Les chatbots alimentés par l’IA ont besoin de mises à jour régulières pour rester efficaces contre les menaces et la supervision humaine est essentielle pour garantir le bon fonctionnement des LLM, a ajouté de son côté Joshua Kaiser, responsable IA et CEO de Tovie AI. « En outre, les LLM ont besoin d’une compréhension contextuelle pour fournir des réponses précises et détecter tout problème de sécurité, et doivent être testés et évalués régulièrement pour identifier les faiblesses ou les vulnérabilités potentielles ».

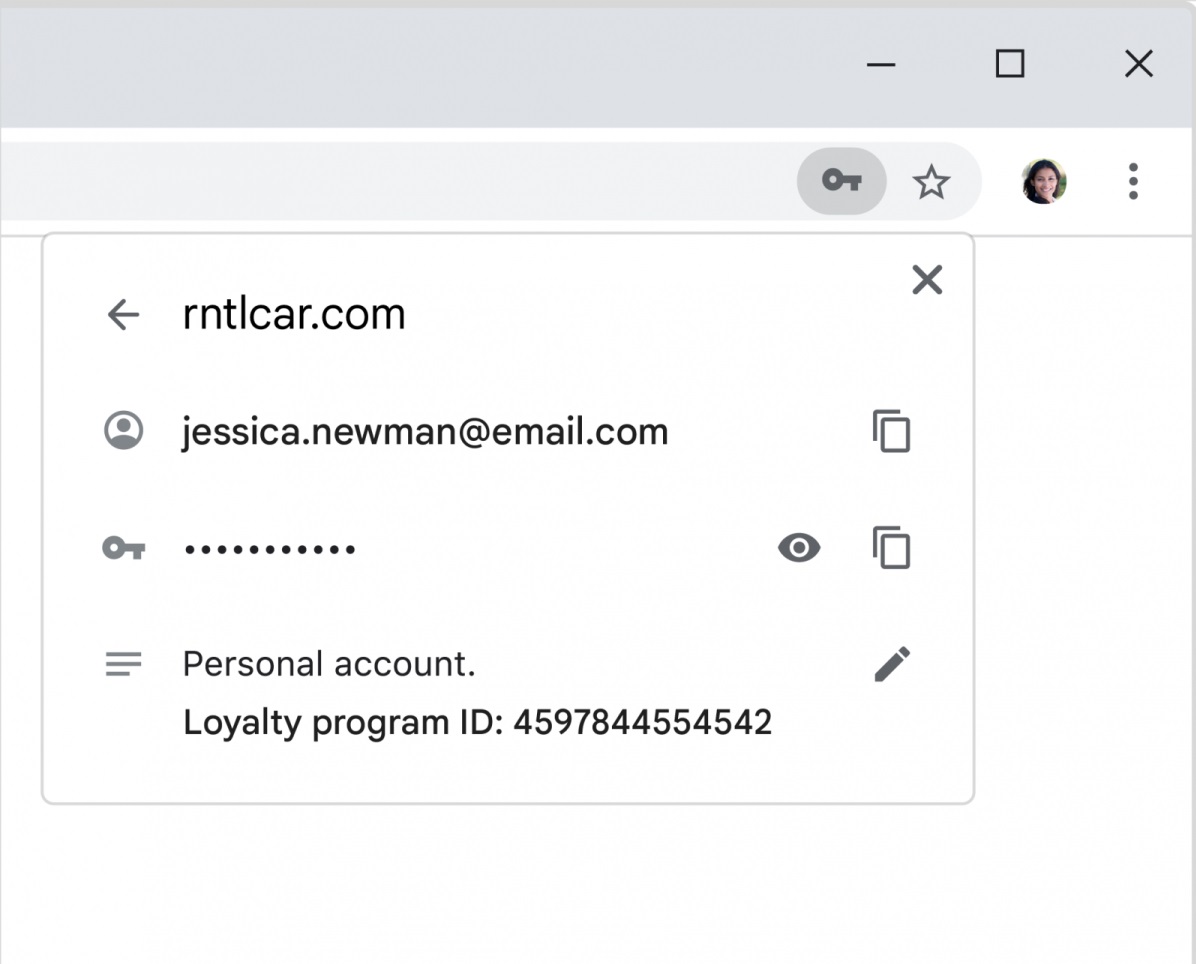

La lutte pour le stockage des mots de passe dans le navigateur ou dans un gestionnaire de mots de passe s’intensifie. En ce sens, Google a ajouté l’authentification biométrique dans Chrome.

Google a apporté des améliorations majeures à la manière dont les mots de passe sont stockés dans Chrome, en reprenant certaines des meilleures fonctions de son navigateur mobile et en les appliquant à l’ordinateur de bureau. Il y a toujours eu une certaine tension entre le navigateur et les gestionnaires de mots de passe en ce qui concerne l’application qui détient les clés de votre vie numérique. Google propose déjà de stocker les mots de passe dans le cloud Google, avec des fonctions supplémentaires telles que l’exploration du deep web pour s’assurer qu’ils n’ont pas été divulgués dans le cadre d’une intrusion.

Aujourd’hui, Google et Chrome ajoutent d’autres fonctionnalités clés : un raccourci rapide vers vos mots de passe depuis le bureau, la possibilité d’importer des mots de passe stockés ailleurs et, peut-être le plus important, la possibilité d’utiliser l’identification biométrique pour déverrouiller votre coffre-fort de mots de passe sur le navigateur de bureau. Vous pourrez également ajouter des notes à un fichier de mots de passe, afin d’identifier un code PIN ou de stocker d’autres informations utiles. La note sera également stockée en toute sécurité, avec les mêmes protections que celles appliquées au mot de passe.

Un déverrouillage par authentification biométrique

L’authentification biométrique est probablement la mise à jour la plus importante. Sur mobile, cela signifie généralement l’utilisation d’un scanner d’empreintes digitales pour déverrouiller le coffre-fort des mots de passe ou s’identifier auprès d’une application. Sur ordinateur, Google utilisera les méthodes biométriques disponibles sur votre PC, généralement les caméras Windows Hello. Il s’agit d’une fonctionnalité facultative, mais elle offre une couche de sécurité puissante qui demande peu d’efforts. Anecdotiquement, les connexions faciales via Windows Hello peuvent se dégrader au fil du temps, lorsque vous vous rasez ou que vous vous laissez pousser la barbe, par exemple. Toutefois, si Windows Hello fonctionne pour Windows, il fonctionnera pour Chrome.

Voici à quoi ressembleront les notes de mot de passe dans Google. (Crédit : Google)

Google a également ajouté un bouton « home » pour la gestion des mots de passe dans Chrome, via la rubrique « Gestionnaire de mots de passe » dans le menu des paramètres. Les utilisateurs apprécieront également la possibilité d’ajouter des notes à leurs mots de passe. Dans la plupart des cas, un site demandera simplement un nom d’utilisateur et un mot de passe, mais il peut arriver que le site lui-même fasse l’objet d’une refonte, qu’un nom d’utilisateur change, ou pour toute autre raison, qu’une note à vous-même dissipera toute confusion persistante. Naturellement, Google et Android sont indissociables. Mais le géant de la recherche a ajouté que son service Password Checkup serait également disponible sur iOS. Si vous avez réutilisé des mots de passe sur votre iPhone, ou s’ils ont été violés, Google Chrome sur iOS vous alertera pour que vous changiez votre mot de passe. La firme a déjà ajouté le remplissage automatique des mots de passe sur iOS.

Seul point faible : l’importation de mots de passe depuis des gestionnaires tiers

La seule fonctionnalité que nous remettons en question est la possibilité d’importer des mots de passe depuis d’autres gestionnaires de mots de passe. Chrome propose désormais de le faire en téléchargeant ces mots de passe sous la forme d’un fichier CSV, ce qui semble implicitement peu sûr. Autre bémol : si vous pouvez importer des mots de passe dans Chrome, ce dernier n’est qu’un navigateur web. Un gestionnaire de mots de passe synchronise vos mots de passe entre les applications et les services, ce qui n’est pas le cas de Chrome. Si vous stockez vos mots de passe dans Chrome ou Edge, c’est là qu’ils resteront.

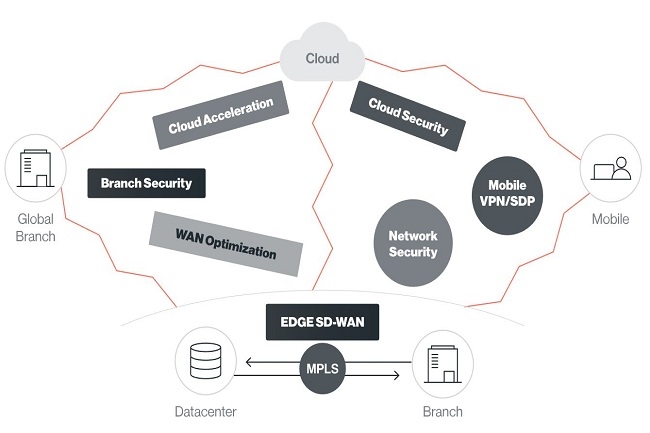

Le fournisseur de plateformes SASE, Cato Networks, a réussi à établir une connexion chiffrée de 5 Gbps avec son dispositif edge SD-WAN.

En début de semain, Cato Networks a déclaré qu’il avait réussi à créer un tunnel crypté pouvant atteindre un débit de 5 Gbps, repoussant ainsi les limites du SASE. Le fournisseur rassure ainsi les administrateurs réseau qui s’inquiétaient de la surcharge de trafic créée par les plateformes Secure Access Service Edge (SASE). Dans son communiqué, l’entreprise indique que l’adoption croissante du SASE, par les grandes entreprises en particulier, a créé un besoin de connexions cryptées plus rapides capables de prendre en charge l’ensemble des technologies de sécurité présentes dans le SASE. Selon Cato, c’est l’amélioration des performances de son moteur de traitement Single Pass Processing Engine, qui regroupe l’ensemble des services fonctionnant dans ses différents points de présence, qui a rendu possible cette augmentation du débit. Cato Networks a indiqué que les systèmes SASE basés sur des machines virtuelles fonctionnant dans le cloud ou en tant que proxies web sont limités à moins de 1 Gbps par tunnel. « Cette limitation oblige les entreprises à demander à leur appliance edge de créer et de gérer plusieurs tunnels et d’équilibrer la charge de leur trafic entre eux », a déclaré l’entreprise. « Cette couche supplémentaire de complexité et de risque n’existe pas dans la solution de Cato », a-t-elle ajouté.

Selon Seamus McGillicuddy, vice-président de la recherche chez Enterprise Management Associates, le problème que Cato tente de résoudre est lié aux nombreux et différents protocoles de sécurité utilisés dans toute configuration SASE. Chaque service ayant besoin de lire le trafic du réseau, la connexion donnée est plus sollicitée. « Le SASE consiste à faire fonctionner autant de types de sécurité réseau que possible à un point de présence cloud », a-t-il déclaré. « L’objectif est de faire fonctionner ces solutions dans un grand nombre d’endroits différents, aussi près que possible des utilisateurs finaux et des sources de trafic », a ajouté le VP de la recherche d’Enterprise Management Associates. Selon M. McGillicuddy, Cato semble penser que la vitesse de connexion via SASE pourrait se transformer en course aux armements, étant donné la demande croissante. « Il est indéniable que certaines entreprises en auront besoin. C’est aussi un facteur possible de différenciation concurrentielle », a-t-il ajouté.

Pas encore de tarif

Cato a également annoncé la disponibilité d’une connectivité privée de couche Layer 2 entre ses serveurs et n’importe quel fournisseur de cloud connecté à Equinix Cloud Exchange ou à Digital Reality, ce qui élargit la base d’utilisateurs de ces tunnels chiffrés rapides. L’idée est de permettre aux environnements traditionnels, en particulier, d’utiliser des mesures de sécurité réseau modernes comme la plateforme SASE de Cato. « Les entreprises dotées d’une infrastructure MPLS ou d’une infrastructure SD-WAN tierce peuvent désormais tirer parti des capacités SSE de Cato sans modifier leurs réseaux sous-jacents », a déclaré l’entreprise. Le service de cross-connect sera disponible sous forme de « forfait mensuel », mais pour l’instant Cato n’a pas fourni d’information sur ses tarifs.

Les entreprises prévoient d’augmenter leurs dépenses, en investissant dans des domaines comme la distribution de renseignements sur les menaces, la gestion des risques numériques et l’intégration des technologies de sécurité.

Dans un récent article, nous avions demandé à des professionnels de la cybersécurité quelles caractéristiques devait avoir un programme de renseignement sur les cybermenaces (Cyber-Threat Intelligence, CTI) pour être considéré comme mature. Selon un rapport du cabinet d’études Entreprise Strategy Group (ESG), les principales caractéristiques d’un programme CTI mature sont la diffusion de rapports à un large public, l’analyse de quantités massives de données sur les menaces et l’intégration du CTI à de nombreuses technologies de sécurité. Hélas, la plupart des programmes CTI sont loin d’être matures, mais cela pourrait changer dans les prochaines années, car la plupart des entreprises investissent davantage dans ces programmes. Au cours des 12 à 18 prochains mois, 63% des entreprises prévoient d’augmenter « considérablement » leurs dépenses liées aux programmes CTI, et 34 % d’entre elles prévoient d’augmenter « un peu » ces dépenses.

Mais pourquoi donc investir dans le CTI ? Parce que le renseignement sur les cybermenaces peut apporter des avantages technologiques et commerciaux. L’étude de l’ESG révèle ainsi que le grand intérêt pour les programmes CTI découle de la nécessité de se renseigner sur les menaces pouvant peser sur les entreprises concernées par des fusions-acquisitions, celle de se renseigner sur la menace de pirates individuels ou de groupes d’adversaires planifiant des attaques ciblées, et la nécessité de se renseigner sur les tactiques, techniques et procédures (TTP) des acteurs de la menace pour que les entreprises puissent renforcer leurs défenses en matière de sécurité.

Une démarche portée par les RSSI

Si les RSSI cherchent à investir davantage dans le renseignement sur les menaces, c’est qu’ils sont convaincus que ces investissements peuvent atténuer les cyber-risques tout en améliorant la prévention et la détection des menaces. Dans les prochains 12 à 24 mois, 30% des entreprises donneront la priorité au partage des rapports de renseignements sur les menaces avec les groupes internes. C’est un pas dans la bonne direction, car les renseignements sur les menaces ont une valeur au-delà du centre d’opérations de sécurité (SOC) et peuvent améliorer l’information sur les alertes. Les RSSI peuvent utiliser les CTI pour prioriser les investissements et valider les contrôles de sécurité, tandis que les directeurs commerciaux peuvent équilibrer les initiatives de transformation numérique avec des décisions de gestion des risques plus approfondies. La diffusion des CTI et le retour d’information des consommateurs sont des phases clés d’un cycle de vie mature du renseignement sur les menaces. Par ailleurs, 27% des entreprises investiront en priorité dans des services de protection contre les risques numériques (Digital Risk Protection, DRP). À mesure que les entreprises étendent leur empreinte numérique, elles ont besoin d’une meilleure compréhension des risques qui en découlent. Les services de protection contre les risques numériques offrent cette visibilité en surveillant les fuites de données en ligne, la réputation de la marque, les vulnérabilités de la surface d’attaque et les discussions autour de la planification des attaques sur le dark web ou le deep web.

27% des entreprises donneront la priorité à l’intégration avec d’autres technologies de sécurité. Au-delà des terminaux, du courrier électronique et des périmètres de réseau, les RSSI souhaitent une intégration du CTI avec des outils de sécurité dans le cloud, des solutions de gestion des informations et des événements de sécurité (Security Information and Event Management, SIEM) et des solutions de détection et de réponse étendues (Extended Detection and Response, XDR), ainsi que des outils de sécurité en périphérie (Security Service Edge, SSE) comme des passerelles web sécurisées (Secure Web Gateway, SWG) et des courtiers de services d’accès cloud (Cloud Access Service Brokers, CASB). Plus d’intégration équivaut à bloquer plus d’indicateurs de compromission (Indicators of Compromise, IoC) et à développer une défense plus complète basée sur les menaces. 27% des entreprises donneront la priorité à l’acquisition d’une plateforme de renseignement sur les menaces (Threat Intelligence Platform, TIP) pour la collecte, le traitement, l’analyse et le partage des renseignements sur les menaces. Autrefois apanage des plus grandes entreprises, les TIP se démocratisent peu à peu. Selon moi, une grande partie de ces dépenses sera consacrée à des fournisseurs de services comme Flashpoint, Mandiant, Rapid7 (Intsights), Recorded Future, Reliaquest (Digital Shadows), SOCRadar et ZeroFox. Les grands acteurs comme Cisco, CrowdStrike, IBM, Microsoft et Palo Alto Networks capteront aussi une bonne part de ce marché.

Sun Tzu à la rescousse

Enfin, 26% des entreprises donneront la priorité au développement d’un programme plus formel. Les entreprises réalisent qu’elles ne peuvent plus se contenter de quelques sources ouvertes de renseignements sur les menaces et de les faire examiner par des analystes à temps partiel. Elles ont besoin de personnel et de processus pour exécuter un cycle de vie CTI complet. Pendant que les RSSI réorganisent leur fonctionnement interne, la plupart d’entre eux s’appuieront sur des prestataires de services, comme ceux mentionnés ci-dessus, pour effectuer le gros du travail. Comme le dit la célèbre citation du général et stratège chinois Sun Tzu : « Qui connaît l’autre et se connaît lui-même peut livrer cent batailles sans jamais être en péril ». Les entreprises dotées de programmes CTI matures se connaissent elles-mêmes, connaissent l’ennemi et utilisent ces connaissances pour optimiser l’atténuation des cyber-risques et les défenses de sécurité.

Pour le deuxième semestre de cette année, les entreprises espèrent investir dans la sécurité, la stabilité opérationnelle et l’amélioration des performances de livraison des applications en utilisant des technologies qui incluent le SD-WAN et l’IA.

Tout le monde s’accorde pour dire que le premier semestre 2023 n’a pas été très bon pour de nombreuses entreprises, qu’il s’agisse des utilisateurs finaux, des vendeurs ou des fournisseurs. La bonne nouvelle, c’est que les utilisateurs pensent plus ou moins que la plupart des questions économiques et politiques ayant contribué de près ou de loin au problème ont été maîtrisées. L’incertitude demeure dans le monde de la technologie, mais elle est un peu moins forte qu’auparavant. La plupart des entreprises avec lesquelles j’ai discuté cette année sont restées prudemment optimistes quant à l’amélioration de la situation. Au cours du mois dernier, sur les quelque 200 entreprises avec lesquelles nous avons échangé par courrier électronique, seules 21 se déclaraient « pessimistes » quant aux perspectives de leurs dépenses technologiques pour le second semestre. Cette absence de pessimisme ne se traduit cependant pas par de l’optimisme, et l’optimisme n’est pas une caractéristique des planificateurs de réseaux et de technologies de l’information.

Alors, quelles sont les priorités des utilisateurs en matière de technologie pour le reste de l’année ? Pensent-ils que leurs budgets vont évoluer, et si oui, dans quel sens ? Cherchent-ils à apporter des changements majeurs à leurs réseaux, à changer de fournisseurs, à être plus ou moins ouverts ? Nous pensions connaître certaines des réponses à ces questions, mais nous nous sommes trompés pour certaines d’entre elles. Commençons par la première question, celle des modèles budgétaires. Deux tiers des entreprises interrogées déclarent qu’elles s’attendent à dépenser davantage pour les réseaux en 2023 que l’année dernière, même si la plupart d’entre elles admettent que leurs dépenses ont été réduites. Cette augmentation ne sera probablement pas considérable, mais la croissance prévue des dépenses correspond à peu près à la moyenne historique des dix dernières années. Cela ne signifie pas qu’elles n’essaient pas de réduire les coûts. L’entreprise moyenne de ma liste qui prévoyait une augmentation d’un peu plus de 4 % de ses dépenses en réseaux cette année, cherche aujourd’hui à réduire ses coûts dans des proportions presque identiques.

Réduire les coûts pour dépenser plus

Si dépenser plus ou dépenser moins peut sembler contradictoire, cela signifie en réalité que les entreprises veulent réduire les coûts pour maintenir ce qu’elles ont afin de financer de nouvelles initiatives, et qu’elles sont prêtes à augmenter les dépenses pour financer le reste. Là aussi, il faut se demander de quelles initiatives et de quelle réduction des coûts, il s’agit. Quasiment 100 % des utilisateurs veulent réduire le coût des services réseau plus que le coût de l’équipement réseau. Alors qu’environ un tiers d’entre eux déclarent qu’ils étaleront le recyclage de l’ancien matériel de cette année à l’année prochaine, tous veulent dépenser moins pour les services réseau. Concernant les nouvelles initiatives qu’ils espèrent financer, celles-ci se concentrent sur trois domaines spécifiques. D’abord, l’amélioration de la sécurité. Ensuite, l’amélioration de la stabilité opérationnelle et de la disponibilité. Enfin, l’amélioration des performances de livraison des applications.

Le SD-WAN est l’un des bénéficiaires de cette combinaison d’objectifs. Environ un quart des entreprises de notre liste étaient déjà au prise avec un SD-WAN, mais presque toutes l’ont adopté pour étendre l’accès VPN à des sites qu’il n’était pas justifié de connecter directement à leurs VPN. Un peu plus de la moitié des entreprises disent désormais qu’elles remplaceront le VPN par du SD-WAN quand le coût de la connexion par travailleur habilité est trop élevé. Ce groupe est à peu près également divisé sur la question de savoir s’il faut acheter le matériel SD-WAN soi-même, l’obtenir auprès d’un fournisseur de services managés (MSP) ou l’obtenir auprès d’un opérateur de réseau ou d’un fournisseur de services de communication (CSP). La voie du MSP a la préférence quand les sites cibles sont multinationaux, et la voie du CSP est privilégiée quand les sites se trouvent tous actuellement sur des VPN d’un seul opérateur. Enfin, la mise en place d’un SD-WAN en propre est le choix qui s’impose quand aucune de ces conditions n’est remplie.

La sécurité ne doit pas être une option SD-WAN

Même si de nombreux produits/services SD-WAN offrent une sécurité renforcée, cette caractéristique n’est pas mise en avant par les adoptants potentiels du SD-WAN. La plupart d’entre eux expliquent que cela est dû au fait que la gestion des coûts et non l’amélioration de la sécurité est au cœur de la réflexion sur le SD-WAN. Mais la plupart disent aussi que les vendeurs/fournisseurs de SD-WAN ne les poussent pas à considérer la sécurité comme un des motifs d’adoption. Au lieu de cela, ils se concentrent généralement sur la sécurité en tant que couche supplémentaire. La sécurité est le domaine dans lequel la plupart des utilisateurs s’attendent à dépenser davantage, mais en même temps, c’est un domaine dans lequel ils pensent que leurs dépenses sont le plus susceptible d’être sous-optimales. Les trois quarts des acheteurs estiment qu’ils dépensent déjà trop pour la sécurité parce qu’ils ont superposé des éléments sans tenir compte de la situation dans son ensemble. Ils emploient souvent des termes comme « approche holistique » ou « repenser » dans leurs commentaires, mais en même temps, moins d’un huitième des utilisateurs prévoient de reconsidérer leurs stratégies de sécurité d’une manière ou d’une autre. Ils reconnaissent qu’entreprendre un changement majeur, c’est risquer de créer une faille dans les produits ou les pratiques qui pourrait leur nuire gravement. Ils espèrent que les fournisseurs actuels leur offriront de nouvelles fonctionnalités, même à un certain prix, et qu’ils rationaliseront d’une manière ou d’une autre l’ensemble de la pile et de l’approche de la sécurité.

Ce point de vue s’applique également à l’ensemble des équipements réseau. Alors que plus de 80 % des utilisateurs affirment que les technologies ouvertes comme les boîtes blanches et les logiciels libres pourraient réduire les coûts de manière « significative » et qu’environ un sixième d’entre eux déclarent « envisager » un modèle de réseau ouvert, le nombre de ceux qui ont effectivement prévu de passer à une stratégie ouverte au cours du second semestre se situe dans le niveau de bruit statistique. En fait, deux entreprises qui avaient prévu d’augmenter leur investissement dans le modèle ouvert en 2023 disent qu’elles vont maintenant rester avec leur fournisseur dominant. Il s’agit là d’un autre changement intéressant en soi. Même parmi les opérateurs réseaux, on observe un désir non pas d’élargir le choix des fournisseurs dans leurs réseaux, mais de le restreindre. Pour chaque entreprise déclarant qu’elle va augmenter le nombre de ses fournisseurs, trois entreprises disent qu’elles vont « consolider » leurs fournisseurs. Les utilisateurs finaux souhaitent même réduire le nombre de fournisseurs de services (et, soit dit en passant, de fournisseurs de services cloud). Ils parlent de « plus d’effet de levier » et de « moins d’intégration » plutôt que de « best of breed » ou de « lock-in ».

Là, où il y a de l’IA…

Si, à la question de savoir quelle est la technologie qui les enthousiasme le plus, ils répondent volontiers l’IA, même là, on voit un tas de contradictions. Très peu d’entreprises (peut-être une sur six) ont essayé d’utiliser l’IA dans les réseaux de quelques manières que ce soit. Presque toutes disent qu’elles prévoient d’utiliser l’IA davantage, et pourtant presque toutes disent aussi que l’IA est surestimée et que « la plupart des affirmations des fournisseurs en matière d’IA sont exagérées ». Cet enthousiasme apparemment irréfléchi pour l’IA fait penser à un vieux dicton, mais à l’envers : « Là où il y a de l’espoir, il y a de la vie ». L’IA pourrait (théoriquement) réduire les erreurs des opérateurs. Elle pourrait (on peut l’espérer) améliorer la planification de la capacité des réseaux. Elle pourrait (probablement) aider à sécuriser les applications et les données et à repérer les malfaiteurs. Toutes ces choses sont des problèmes récurrents qui semblent défier toute solution, et l’IA offre l’espoir qu’une solution pourrait être à portée de main.

Il n’y a rien à redire à cela, provisoirement bien sûr. « Provisoirement », pour dire pas tout de suite. Les utilisateurs ne citent que deux outils d’IA de réseau (trois outils d’IA au total) qui, selon eux, apportent une réelle valeur ajoutée aujourd’hui. En moyenne, ils pensent que l’IA sera suffisamment mature pour tenir certaines promesses d’ici à la fin du second semestre 2023. Si c’est le cas, ils sont prêts à étendre leur budget pour obtenir les outils qui ont fait leurs preuves. Dans l’ensemble, les acheteurs de réseaux sont optimistes pour le second semestre, mais ils ont aussi, au fond d’eux-mêmes, un peu peur. L’incertitude est l’ennemie de l’investissement, et il suffirait de pas grand-chose pour basculer vers plus de prudence. Comme les utilisateurs eux-mêmes, nous restons (théoriquement, vraisemblablement, provisoirement) confiant… pour l’instant. Mais l’hiver pourrait être encore rude.

Après le secteur des télécoms, Snowflake poursuit son approche verticale de son data cloud en ciblant les administrations gouvernementales et le secteur de l’éducation.

Petit à petit, Snowflake étoffe son portefeuille de cloud sectoriel en lançant un data cloud à destination des entités gouvernementales et de l’éducation. Cette offre s’appuie sur le datawarehouse cloud de l’éditeur, où il combine les outils d’entreposage de données, d’analyse et de conformité avec un accès à des sources de données et à des ressources tierces via une place de marché. Cette dernière est basée sur des partenariats conclus avec des acteurs comme Plante Moran, Vantage Point Consulting, Carto, Collibra et Immuta.

Chaque partenaire de Snowflake apporte différentes capacités au Government and Education Data Cloud. Par exemple, PowerSchool et Merit proposent aux établissements scolaires et à l’administration d’offrir des opportunités aux étudiants, d’œuvrer pour la réussite scolaire et favoriser l’entrée dans la vie active, et de donner aux organisations gouvernementales des États les moyens de réagir rapidement en temps de crise. L’université de New York et la ville de Tacoma comptent parmi les clients de ce nouveau cloud de données.

Priorité aux normes de sécurité des données et à l’unification des données

Selon Snowflake, ce cloud sectoriel est très axé sur les normes de sécurité et l’unification des données. Cette offre a déjà obtenu les certifications FedRAMP Moderate et StateRAMP High qui aident les institutions fédérales, étatiques et locales à respecter les normes de sécurité et de conformité. Le premier est une norme qui fournit des autorisations de sécurité pour les services cloud. Selon le gouvernement américain, FedRAMP Moderate est la norme la plus utilisée par la plupart des services cloud.

Quant à StateRAMP, c’est un framework développé en 2020 par un comité de pilotage de DSI et de RSSI, qui peut être mis en œuvre par les responsables pour améliorer en continu la cybersécurité des gouvernements étatiques et locaux, des fournisseurs et des électeurs qu’ils servent. « Le Government and Education Data Cloud est conforme à l’International Traffic in Arms Regulations, aux Criminal Justice Information Services, à l’Internal Revenue Service 1075, au Federal Acquisition Regulation et au Defense FAR Supplement », a indiqué le fournisseur.

Un catalogue qui s’étoffe

Selon Snowflake, ce focus sur la sécurité et la conformité vise à résoudre le problème du partage des informations ou de la collaboration avec les données dans les institutions gouvernementales. Bon nombre de ces entités partagent encore des données de manière ad hoc ou physique, ce qui accroît le risque de fuite d’information. « Les outils de données pré-intégrés dans le Government and Education Data Cloud aideront les établissements d’enseignement à s’unifier et à tirer parti de leurs connaissances », a encore déclaré Snowflake.

L’année dernière, le fournisseur avait déjà lancé les offres sectorielles Retail Data Cloud pour les retailers et les fabricants et Healthcare and Life Sciences Data Cloud pour le secteur de la santé et des sciences de la vie.

Avec ce dernier numéro du magazine du Monde Informatique, nous vous proposons de découvrir une série de sujets autour de la progression du cloud dans le secteur public et les entreprises.

Dans ce dix huitième numéro du Monde Informatique, nous avons décidé de mettre en avant des sujets autour du cloud avec une sous-thématique sécurité. Nous vous proposons donc découvrir :

– Une interview de Stéphanie Schaer, directrice interministérielle du numérique. La patronne de la Dinum détaille pour la rédaction les grands axes de sa feuille de route. Des ambitions qui seront servies par un budget en progression de 30 % et par le recrutement de 40 ETP supplémentaires.

– Un point avec Stéphane Boulanger, DSI du PMU. Venu du mainframe et aujourd’hui sur Unix, le SI du PMU entame une nouvelle révolution, avec une migration programmée vers le cloud. Stéphane Boulanger, DSI de l’opérateur hippique, détaille cette opération qui doit se dérouler sans perturber une activité totalement dépendante de ce système.

– Un entretien avec Ashley Kramer, CMO et CSO chez GitLab. La rédaction du Monde Informatique a rencontré Ashley Kramer, chief marketing et strategy officer chez GitLab. Elle a évoqué son parcours, son intérêt pour l’informatique qui s’est transformé au fil de ses expériences, et son rôle au sein de GitLab.

– Un retour d’expérience avec O-I Glass. Les ingénieurs support d’O-I Glass utilisent HoloLens sur la plateforme SASE de Cato Networks pour répéter et résoudre à distance les problèmes.

.- Un autre témoignage avec la Compagnie des Alpes, qui amorce un virage serré dans le cloud

– Les bonnes pratiques de Delta Airlines, qui prend son envol grâce à un combo mainframe et cloud

– Un dossier sur le data management pour renforcer la sécurité, l’audit et la conformité

Nous vous invitons également à vous abonner à la version papier sur notre espace abonnement. Vous pourrez ainsi recevoir notre dix-neuvième numéro en septembre 2023.

Le service de Kyndryl, baptisé CSIRF, fournit un service de support en cas d’incident, des analyses forensiques et des capacités de remédiation.

Le service de réponse aux incidents de cybersécurité et d’analyse forensique (CSIRF) lancé par le fournisseur de services managés Kyndryl vise à aider les clients à enquêter et à réagir aux événements détectés. Il délivre des fonctionnalités de triage et de réponse aux incidents, de veille sur les menaces, de surveillance et de gestion de la conformité. Les clients ont également la possibilité de sélectionner des services proactifs qui réduit de manière significative le temps de réaction à un incident.« Passer de la simple sécurité à la résilience cyber »« La cyber-résilience est la capacité d’anticiper, de se protéger, de résister et de se remettre de conditions défavorables, de stress, d’attaque et de compromission », a déclaré Kris Lovejoy, responsable mondial de la sécurité et de la résilience chez Kyndryl. « Le service CSIRF détecte et répond aux incidents de sécurité identifiés y compris les APT et fournit des analyses forensiques. Cette offre fait passer la sécurité dans le domaine de la résilience », a-t-il ajouté.Dans la foulée d’un accord avec SAPEn outre, Kyndryl a indiqué qu’il fournirait une assistance pratique à la demande pour résoudre les menaces qui pèsent sur les activités d’un client. Le mois dernier, Kyndryl a renforcé son partenariat avec SAP afin d’encourager les migrations des clients vers la version S4/HANA de l’ERP.