Une étude de Varonis met en évidence les risques posés par les sites Salesforce inactifs. Crées pour animer des communautés, ils contiennent des données sensibles et peuvent être facilement ciblés par des acteurs malveillants.

Les sites Salesforce désactivés de manière inappropriée et non maintenus sont vulnérables aux acteurs malveillants qui peuvent accéder à des données commerciales sensibles et à des informations personnelles identifiables (PII) en changeant simplement l’en-tête de l’hôte. C’est ce que révèle une nouvelle étude de Varonis Threat Labs, qui explore les menaces posées par les « sites fantômes » de Salesforce.

Que sont les sites fantômes de Salesforce ?

Les sites que l’on décrit comme fantômes sont généralement créés lorsque les entreprises utilisent des noms de domaine personnalisés au lieu d’URL internes peu attrayants afin que les partenaires puissent les consulter, a écrit Varonis Threat Labs. Pour ce faire, l’enregistrement DNS est configuré de manière à ce que « partners.acme.org » [par exemple] pointe vers le site de la communauté Salesforce à l’adresse « partners.acme.org.00d400.live.siteforce.com ». Une fois l’enregistrement DNS modifié, les partenaires visitant partners.acme.org pourront naviguer sur le site Salesforce d’Acme. Les problèmes commencent lorsqu’Acme décide de choisir un autre fournisseur de site communautaire, estiment les chercheurs.

Comme pour toute autre technologie, les entreprises peuvent remplacer un site d’expérience Salesforce par un autre. « Par la suite, Acme modifie l’enregistrement DNS partners.acme.org pour qu’il pointe vers un nouveau site susceptible de fonctionner dans leur environnement AWS », ajoute Varonis Threat Labs. Du point de vue des utilisateurs, le site Salesforce a disparu et une nouvelle page communautaire est disponible. Cette dernière peut être complètement déconnectée de Salesforce, ne pas fonctionner dans l’environnement, et aucune intégration évidente n’est détectable. Cependant, les chercheurs ont découvert que de nombreuses entreprises s’arrêtent à la simple modification des enregistrements DNS. « Elles ne suppriment pas le domaine personnalisé dans Salesforce et ne désactivent pas le site. Au lieu de cela, le site continue d’exister, d’extraire des données et de devenir un site fantôme ».

Une exploitation possible en modifiant l’en-tête de l’hôte

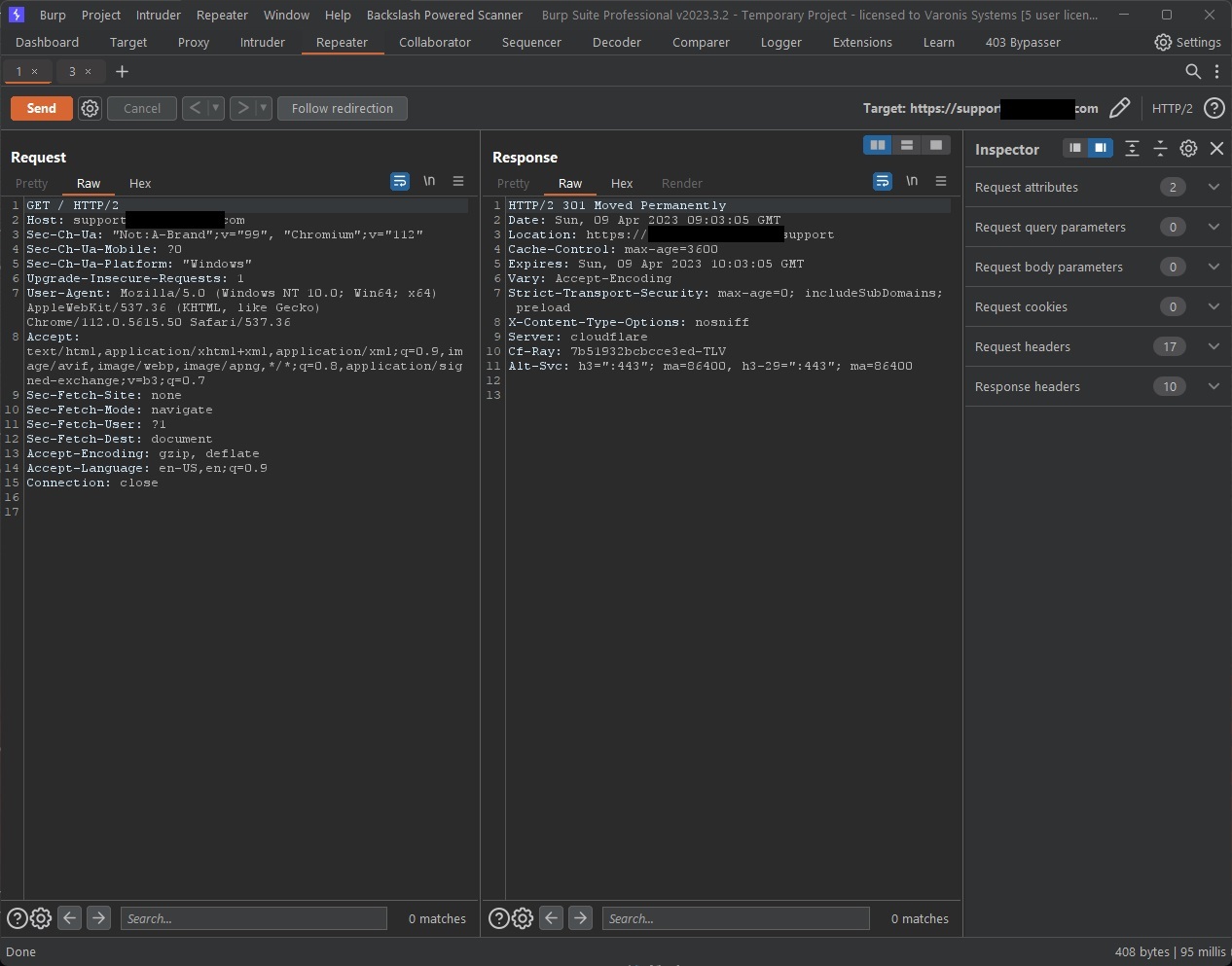

Comme un site fantôme reste actif dans Salesforce, le domaine siteforce se résout toujours, ce qui signifie qu’il est disponible dans les bonnes circonstances, expliquent les chercheurs. « Une simple requête GET aboutit à une erreur, mais il existe un autre moyen d’accéder au site. Les attaquants peuvent exploiter ces sites en modifiant simplement l’en-tête de l’hôte ». Cela fait croire à Salesforce que l’accès au site s’est déroulé correctement, et l’éditeur offrira le site à l’attaquant, ont-ils ajouté.

Bien que ces sites soient également accessibles en utilisant les URL internes complètes, ces URL sont difficiles à identifier pour un attaquant externe, ont souligné les chercheurs. « Toutefois, l’utilisation d’outils qui indexent et archivent les enregistrements DNS – tels que SecurityTrails et d’autres outils similaires – facilite grandement l’identification des sites fantômes ». Le risque est d’autant plus grand que les sites anciens et obsolètes sont moins bien entretenus et donc moins sûrs, ce qui facilite les attaques.

Les attaquants peuvent exploiter ces sites en modifiant simplement l’en-tête de l’hôte. Cela fait croire à Salesforce que le site a été consulté en tant que https://partners.acme.org/ et que Salesforce offre le site à l’attaquant. (Crédit : Varonis)

Des données commerciales sensibles et des informations confidentielles hébergées

Les chercheurs de Varonis ont affirmé avoir trouvé de nombreux sites inactifs contenant des données confidentielles, y compris des données commerciales sensibles et des informations confidentielles, qui n’étaient pas accessibles autrement. « Les données exposées ne se limitent pas à d’anciennes données datant de l’époque où le site était utilisé ; elles comprennent également de nouveaux enregistrements qui ont été partagés avec l’utilisateur invité, en raison de la configuration du partage dans son environnement Salesforce ».

Ils conseillent de désactiver les sites qui ne sont plus utilisés et soulignent l’importance du suivi de tous les sites Salesforce et des autorisations de leurs utilisateurs respectifs, y compris les utilisateurs communautaires et les utilisateurs invités. Varonis Threat Labs a également créé un guide pour protéger les communautés Salesforce actives contre la reconnaissance et le vol de données.

Mandiant a lancé une alerte sur un malware nommé Cosmicenergy. Créé par un éditeur russe en cybersécurité, il pourrait être utilisé contre des réseaux électriques d’autres pays.

Au cours des dernières années, les cyberattaquants épaulés par des Etats ont renforcé leurs capacités à frapper les infrastructures critiques, comme les réseaux électriques, pour provoquer de graves perturbations. Cet arsenal s’est enrichi d’une boîte à outils qui semble avoir été mise au point par une société russe de cybersécurité pour des exercices red team. Baptisé Cosmienergy par les chercheurs de Mandiant, le malware peut interagir avec des unités terminales distantes (RTU) et d’autres dispositifs de technologie opérationnelle (OT) qui communiquent via le protocole spécialisé IEC 60870-5-104 (IEC-104) et sont couramment utilisés pour l’ingénierie électrique et l’automatisation de la production d’énergie. « Cosmicenergy est le dernier exemple en date de logiciels malveillants spécialisés dans l’OT, capables de provoquer des impacts qui sont rarement découverts ou divulgués », expliquent les chercheurs de Mandian dans leur rapport. « L’analyse du malwware et de ses fonctionnalités révèle que ses capacités sont comparables à celles employées dans des incidents et des programmes antérieurs, tels que Industroyer et Industroyer.V2, deux variantes déployées dans le passé pour avoir un impact sur la transmission et la distribution d’électricité via la norme CEI-104 ».

Egalement connu sous le nom de Crashoverride, Industroyer est un logiciel malveillant qui a été utilisé en 2016 contre le réseau électrique ukrainien et a privé d’électricité un cinquième de Kiev, la capitale du pays, pendant une heure. Le malware atteignait les RTUs sur le réseau OT via des serveurs MS-SQL puis émettait des commandes On/Off via la CEI-104 pour impacter les interrupteurs et les disjoncteurs des lignes électriques. La création et l’utilisation d’Industroyer sont attribuées à Sandworm, un groupe APT qui serait une unité de cyberguerre au sein du GRU, le service de renseignement militaire russe. En 2022, Sandworm a tenté une nouvelle attaque contre le réseau électrique ukrainien en utilisant une version actualisée du malware, baptisée Industroyer.V2.

Caché derrière une offre red team d’un éditeur

La dernière trousse à outils Cosmicenergy découverte par Mandiant a été téléchargée sur un service public d’analyse de logiciels malveillants en décembre 2021 par une personne en Russie. Une analyse du code suggère qu’il a été créé pour les exercices red team hébergés par une société russe de cybersécurité appelée Rostelecom-Solar ayant des liens avec le gouvernement russe. « Bien que nous n’ayons pas identifié de preuves suffisantes pour déterminer l’origine ou l’objectif de Cosmicernergy, nous pensons qu’il a peut-être été développé par Rostelecom-Solar ou une partie associée pour recréer des scénarios d’attaque réels contre des actifs du réseau énergétique », ont déclaré les chercheurs. « Il est possible que le programme ait été utilisé pour soutenir des exercices tels que ceux organisés par Rostelecom-Solar en 2021 en collaboration avec le ministère russe de l’énergie ou en 2022 pour le Forum économique international de Saint-Pétersbourg (SPIEF) ».

Rostelecom-Solar a reçu des fonds du gouvernement russe pour former des experts en cybersécurité et mener des exercices de perturbation du réseau électrique et de réponse aux situations d’urgence. Un module de la boîte à outils du logiciel malveillant contient une référence à Solar Polygon et les personnes qui recherchent ce terme le relient à Rostelecom-Solar. Selon Mandiant, malgré ses liens apparents avec des exercices red team, il est possible que ce kit de logiciels malveillants ait été ou puisse être réutilisé pour des attaques réelles, y compris par des acteurs étatiques russes qui ont déjà fait appel à des entrepreneurs privés pour développer des outils.

Charge utile de logiciel malveillant à double détente déployée manuellement

Cosmicernergy se compose de deux éléments, l’un écrit en Python et l’autre en C++. Le premier, que Mandiant a baptisé PIEHOP, est conçu pour se connecter à des serveurs MS-SQL et télécharger des fichiers ou émettre des commandes. Une fois connecté, il déploie le second composant, baptisé LIGHTWORK, qui est conçu pour émettre des commandes On/Off aux RTU connectés via IEC-104 sur TCP. « Il utilise des messages configurables IEC-104 Application Service Data Unit (ASDU) pour modifier l’état des adresses d’objets d’information (IOA) des RTU en les activant ou en les désactivant », expliquent les chercheurs. « LIGHTWORK utilise des entrées de ligne de commande pour le dispositif cible, le port et la commande IEC-104. Les IOA correspondent aux entrées et sorties des RTU, qui, selon la configuration et le déploiement, peuvent correspondre à des disjoncteurs ou à des interrupteurs de lignes électriques ». Cependant, selon Mandiant, les mappings des IOA peuvent varier d’un fabricant de RTU à l’autre, d’un appareil à l’autre et même d’un environnement à l’autre, ce qui signifie que les attaquants doivent disposer d’informations de reconnaissance préexistantes sur le déploiement qu’ils ciblent. L’échantillon analysé de LIGHTWORK comportait huit IOA codés en dur, mais il est difficile de déterminer quelle était l’intention des attaquants lorsqu’ils ont émis des commandes sans connaître les actifs ciblés exacts.

En outre, le composant PIEHOP et le logiciel malveillant lui-même ne disposent d’aucune capacité de découverte de réseau intégrée, ce qui signifie que les attaquants doivent déjà disposer d’informations sur les serveurs MSSQL et les RTU ciblés, telles que les identifiants et les adresses IP, pour déployer les composants avec succès. Il s’agit donc d’une boîte à outils post-intrusion. Bien que Cosmicenergy ne partage aucun code avec les outils malveillants OT précédents, il emprunte des techniques à plusieurs d’entre eux, outre Industroyer : l’utilisation de Python pour le développement de logiciels malveillants OT a également été observée avec IRONGATE et TRITON ; l’utilisation de bibliothèques open source qui mettent en œuvre des protocoles OT propriétaires et abaissent la barre pour le développement de telles menaces ; et l’utilisation abusive de protocoles qui ne sont pas sécurisés de par leur conception, tels que IEC-104, et qui manquent de mécanismes d’authentification ou de chiffrement.

Atténuer et détecter les attaques Cosmicernergy

Bien qu’il n’y ait aucune preuve que Cosmicernergy ait été utilisé dans des attaques sauvages, la possibilité ne peut être écartée et, à tout le moins, il peut inspirer d’autres développeurs de malwares OT, tout comme Industroyer a servi à inspirer ses créateurs. L’enquête de Mandiant contient des indicateurs de compromission et des hachages de fichiers, mais l’entreprise recommande également aux organisations de mener une chasse active aux menaces. Les voici :

1/ Mettre en place la collecte et l’agrégation des journaux basés sur l’hôte pour les systèmes de la couronne tels que les interfaces homme-machine (HMI), les stations de travail d’ingénierie (EWS) et les serveurs clients OPC au sein de leurs environnements et examiner les journaux afin de prouver l’exécution de scripts Python ou de codes non autorisés sur ces systèmes ;

2/ Identifier et enquêter sur la création, le transfert et/ou l’exécution d’exécutables Python non autorisés (par exemple, PyInstaller ou Py2Exe) sur des systèmes d’OT ou des systèmes ayant accès à des ressources d’OT ;

3/ Surveiller les systèmes ayant accès aux ressources de l’OT pour détecter la création de dossiers temporaires légitimes, de fichiers, d’artefacts et de bibliothèques externes nécessaires pour prouver l’exécution de scripts Python, par exemple la création d’un dossier PyInstaller temporaire “_MEIPASS” ,

4/ Surveiller les serveurs MSSQL ayant accès aux systèmes et réseaux d’OT afin de détecter les éléments suivants : activités de reconnaissance et d’énumération des serveurs MSSQL et des informations d’identification, connexions réseau non autorisées aux serveurs MSSQL (TCP/1433) et authentification irrégulière ou non autorisée, activation et utilisation de procédures stockées SQL étendues pour l’exécution de commandes shell Windows et le transfert, la création, la mise en scène et le décodage d’exécutables codés en base64.

Quand ils ne sont pas consultés pendant de longues périodes, les comptes inactifs d’utilisateurs sont plus susceptibles d’être compromis que d’autres. En cause : l’utilisation d’anciens mots de passe ayant été piratés et l’absence d’authentification multi-facteur.

Le silence est d’or, mais pas pour les comptes dormants. En effet, ils posent des risques de sécurité importants pour les utilisateurs et les entreprises. Les cybercriminels en sont bien conscients et sont capables d’utiliser des informations volées sur des comptes oubliés pour exploiter ceux actifs. C’est ce qui ressort de la première étude Customer Identity Trends Report d’Okta qui a interrogé plus de 20 000 consommateurs dans 14 pays sur leurs expériences en ligne et leurs attitudes à l’égard de la sécurité et de l’identité numériques. Ce rapport a révélé que la prolifération des identités peut déclencher des risques de sécurité importants liés à la prise de contrôle de comptes (ATO) en raison des comptes dormants, en particulier si les clients réutilisent (ou ne modifient que légèrement) les mots de passe ou ne procèdent pas à des vérifications de sécurité. Une faille dans n’importe quel service ouvre la voie pour un acteur malveillant à disposer d’un volume considérable d’informations d’identification et de données personnelles associées. Les attaquants étant capables de se servir de ces informations à grande échelle pour compromettre des comptes actifs, y compris des comptes et des réseaux professionnels importants.

Cette enquête a été publiée après l’annonce de Google de mettre à jour sa politique d’inactivité pour les comptes en la portant à deux ans, ce qui signifie que si un compte personnel n’a pas été utilisé ou n’a pas fait l’objet d’une connexion pendant au moins deux ans, le compte et son contenu peuvent être supprimés. Cela inclut le contenu de Workspace (Gmail, Docs, Drive, Meet, Calendar) et de Photos. Les nouvelles règles entreront en vigueur au plus tôt en décembre 2023, a précisé l’entreprise.

La prolifération des comptes contribue aux risques liés aux comptes inactifs

Le volume considérable de nouveaux comptes créés débouche sur un phénomène notable d’attrition se caractérisant par un empilement de comptes non utilisés mais pas pour autant actifs d’un utilisateur. Les plus anciens ne sont pas supprimés, mais deviennent souvent inutilisés et oubliés, parfois pendant des années, devenant en sorte morts-vivants. Selon le rapport d’Okta, cette prolifération est plus fréquente chez les jeunes utilisateurs, mais elle est significative dans la plupart des groupes d’âge. Le nombre estimé de nouveaux comptes en ligne enregistrés au cours des trois derniers mois pour les 18-29 ans est légèrement supérieur à 40, avec une légère baisse à 35 pour les 30-39 ans et à 34 pour les 40 à 49 ans. Les 60 ans et plus ne sont pas en reste et en auraient créé environ 20 au cours des trois derniers mois.

L’un des principaux défis posés par le renouvellement des comptes est la capacité à gérer et à maintenir en toute sécurité les empreintes numériques d’un grand nombre de comptes. Le rapport d’Okta révèle que 71 % des personnes interrogées sont conscientes que leurs activités en ligne laissent des traces, mais que seulement 44 % d’entre elles prennent des mesures pour les atténuer. La gestion des mots de passe semble être un point d’achoppement particulier, 63% des personnes interrogées déclarant qu’elles sont incapables de se connecter à un compte parce qu’elles ont oublié leur nom d’utilisateur ou leur mot de passe au moins une fois par mois, selon le rapport. Bien que la réinitialisation des mots de passe soit généralement possible, les utilisateurs peuvent décider que le processus n’en vaut tout simplement pas la peine, ce qui entraîne une plus grande inactivité des comptes. Seuls 52 % des répondants ont déclaré avoir toujours accès à tous leurs comptes, tandis que 42 % seulement utilisent des mots de passe différents pour chaque compte et que 29 % seulement vérifient ou modifient régulièrement les paramètres de confidentialité de leurs comptes.

Les cybercriminels privilégient les informations d’identification volées pour renforcer leurs attaques

Selon Google, les comptes inactifs qui n’ont pas été consultés pendant de longues périodes sont plus susceptibles d’être compromis. « Cela s’explique par le fait que les comptes oubliés ou non surveillés reposent souvent sur des mots de passe anciens ou réutilisés qui peuvent avoir été compromis, que l’authentification à deux facteurs (2FA) n’a pas été mise en place et que l’utilisateur effectue moins de contrôles de sécurité », a ajouté l’entreprise. En fait, les comptes abandonnés ont au moins dix fois moins de chances que les comptes actifs d’être dotés d’une authentification double facteur, selon l’éditeur. Ils sont donc particulièrement vulnérables et, une fois compromis, ils peuvent être utilisés à des fins diverses, depuis l’usurpation d’identité jusqu’à la diffusion de contenus indésirables, voire malveillants, tels que des spams.

Selon l’enquête Verizon 2022 Data Breach Investigations Report, plus de 80 % des brèches impliquant des attaques contre des applications web peuvent être attribuées à des identifiants volés. Les cybercriminels privilégient le vol d’informations d’identification pour renforcer leurs attaques et contourner les mesures de sécurité, et se montrent même prêts à délaisser les logiciels malveillants au profit de l’abus d’informations d’identification pour faciliter l’accès et la persistance dans les environnements des victimes. Cette tendance a également créé une forte demande pour les services malveillants opérés par des tiers via des réseaux de cybergangs qui vendent des identifiants d’accès volés. Selon le CrowdStrike 2023 Global Threat Report, li y a eu une augmentation de 112 % sur un an du nombre de publicités identifiées pour des services de courtage d’accès malveillants, soit environ 2 500.

Selon Microsoft, le regroupement de produits existants comme Synapse et Power BI, au sein du service Fabric, offrira aux entreprises de combiner les charges de travail tout en réduisant leurs frais, la complexité et les coûts d’intégration IT.

A l’occasion de son évènement Build, Microsoft a annoncé le regroupement de ses produits existants d’entreposage de données, de veille stratégique et d’analyse de données dans une offre unique. Selon les analystes, l’offre, baptisée Fabric, pourrait aider les entreprises à combiner les charges de travail tout en réduisant leurs frais, la complexité et les coûts d’intégration IT. Selon Sanjeev Mohan, analyste principal chez SanjMo, le lancement de la plateforme d’analyse de données unifiée Fabric est peut-être une manière de répondre à la prolifération massive de produits dans la pile de données des entreprises. « Microsoft a compris que ses clients voulaient réduire leurs frais généraux et s’affranchir de la complexité de l’intégration. Ce n’est pas que les clients ne dépensent pas, mais ils cherchent une meilleure valeur pour leur investissement IT », a déclaré le consultant, ajoutant que si Fabric peut fournir de bons résultats, cette stratégie pourrait s’avérer payante pour le fournisseur de services de cloud public. « Outre une réduction de la complexité de l’IT, l’offre pourrait également contribuer à réduire les coûts », a ajouté l’analyste. « Une solution intégrée devrait coûter moins cher qu’un ensemble de solutions premium spécialisées. La solution Fabric pré-intégrée réduit aussi les coûts d’intégration et demande moins d’apprentissage et de compétences pour utiliser les différents outils ».

Microsoft affirme aussi qu’avec Fabric, il est plus simple d’acheter et de gérer les ressources. « Les clients peuvent acheter un seul pool de calcul qui alimente toutes les charges de travail Fabric. Les capacités de calcul universelles réduisent considérablement les coûts, car toute capacité de calcul inutilisée dans une charge de travail peut être utilisée par n’importe quelle autre charge de travail », a expliqué l’entreprise dans un communiqué. Selon Boris Evelson, analyste principal chez Forrester, les données brutes, qu’elles soient transactionnelles, opérationnelles ou autres, doivent passer par des étapes comme la collecte, l’ingestion, l’extraction, le déplacement, l’intégration, le nettoyage, la modélisation et le catalogage avant d’être transformées en informations utiles. « Généralement, certaines des technologies qui prennent en charge chacune de ces étapes proviennent de différents fournisseurs et les professionnels des données ou de l’analyse doivent consacrer du temps à l’intégration », a déclaré M. Evelson, ajoutant que si Fabric ne supprime pas complètement l’étape de l’intégration des composants, elle réduit le temps et les efforts d’intégration, et permet aux utilisateurs des données et de l’analytique de se concentrer davantage sur la résolution de problèmes et sur la recherche d’opportunités commerciales.

Sept services et outils principaux

Selon le fournisseur, l’architecture unifiée de Fabric offre une expérience SaaS (Software-as-a-Service) qui aide les développeurs à extraire des informations à partir de données brutes et à les présenter aux utilisateurs métiers. « La nouvelle suite analytique comprend sept modules et outils principaux, notamment des connecteurs de données, des outils d’ingénierie des données, des flux de travail pour la science des données et des outils analytiques, entre autres choses », a ajouté l’entreprise. « Le module Data Factory, actuellement en preview public, fournit plus de 150 connecteurs à des sources de données dans le cloud et sur site, avec la possibilité d’utiliser le glisser-déposer pour la transformation des données et d’orchestrer des pipelines de données », a encore déclaré l’entreprise. Microsoft a également intégré le module Synapse Data Engineering qui facilite la création de modèles dans Apache Spark. « Fabric comprend également Synapse Data Science, un workflow de bout en bout pour les scientifiques des données pour construire des modèles d’IA sophistiqués, et Synapse Data Warehousing, qui combine des outils de lakehouse et d’entreposage de données avec la possibilité d’exécuter SQL sur des formats de données ouverts », a par ailleurs déclaré l’entreprise. Les deux sont disponibles en aperçu public. « De même, le module Synapse Real-Time Analytics, également en aperçu public offre aux développeurs de travailler avec des données en continu et d’analyser de grands volumes de données semi-structurées », a indiqué Microsoft. Le fournisseur a aussi intégré un module Power BI dans Fabric pour aider les analystes et les utilisateurs professionnels à générer des informations à partir des données avec l’appui d’outils basés sur l’IA.

L’expérience Power BI est aussi profondément intégrée dans Microsoft 365. Pour Hyoun Park, analyste principal chez Amalgam Insights, « l’ajout de Power BI à Fabric comble un certain nombre de lacunes qui rendaient Power BI moins adapté aux entreprises par rapport à des plateformes analytiques comme Qlik, Tibco ou SAS ». Fabric sera livré avec un module Data Activator destiné à la détection et à la surveillance en temps réel des données. « Le module pourra déclencher des notifications et des actions quand il trouvera des modèles spécifiques dans les données », a expliqué l’entreprise, ajoutant que Data Activator était actuellement disponible en aperçu privé. Toujours selon Microsoft, il est possible de tester les sept modules sur le portail de l’entreprise.

Azure OpenAI ajouté à Fabric, et bientôt Copilot

Microsoft a annoncé l’ajout du service Azure OpenAI à Fabric et l’intégration prochaine de Copilot, alimenté par GPT, à la plateforme analytique. « Avec l’intégration de Copilot à Microsoft Fabric, les utilisateurs pourront utiliser le langage conversationnel pour créer des flux de données et des pipelines de données, générer du code et des fonctions entières, construire des modèles d’apprentissage machine ou visualiser les résultats », a déclaré l’entreprise. « L’ajout du service Azure OpenAI et de Copilot accélérera considérablement le travail effectué par les professionnels des données dans Azure en supprimant bon nombre de barrières entre les solutions », a déclaré Bradley Shimmin, analyste en chef chez Omdia.

« Cela devrait également accélérer l’adoption des modèles fondamentaux de Microsoft et très probablement de tout le portefeuille d’outils d’apprentissage machine de l’entreprise », a ajouté M. Shimmin. Sanjeev Mohan, l’analyste principal de SanjMo, pense aussi que cette décision témoigne de l’effort continu de Microsoft pour intégrer les API des grands modèles de langage d’OpenAI à l’ensemble de son portefeuille. « Les entreprises peuvent aussi combiner les grands modèles de langage du service Azure OpenAI avec leurs propres données pour créer leurs propres expériences de langage conversationnel », a déclaré Microsoft, ajoutant que Copilot n’a pas été formé sur les données d’un tenant de l’entreprise.

Prise en charge de OneLake et adoption du format Delta de Databricks

Selon Microsoft, à l’instar des données des applications 365, stockées dans OneDrive, toutes les données et charges de travail de Fabric sont stockées dans un lac de données SaaS et multi-cloud appelé OneLake. « Les données sont organisées dans un hub de données et automatiquement indexées pour la découverte, le partage, la gouvernance et la conformité. Il s’agit d’un système de stockage unique et unifié pour tous les développeurs, où la découverte et le partage des données sont faciles, avec des paramètres de politique et de sécurité appliqués de manière centralisée », a déclaré l’entreprise dans un communiqué. « Cela évite les silos de données liés au fait que les différents développeurs provisionnent et configurent leurs propres comptes de stockage isolés », a encore expliqué Microsoft, ajoutant que « OneLake propose aux entreprises de virtualiser le stockage du datalake dans ADLS Gen2, AWS S3, et Google Storage ».

Selon M. Evelson de Forrester, avec OneLake, les entreprises pourront créer plus facilement leur propre mini-lac de données en quelques minutes plutôt qu’en quelques jours ou semaines. « Certes, il faudra encore du temps pour que ce lac de données soit prêt pour les applications critiques, mais le prototypage, les PoC et le développement agile seront plus commodes », a déclaré l’analyste. En outre, Fabric traite Delta au-dessus des fichiers Parquet comme un format de données natif qui est la valeur par défaut pour toutes les charges de travail. « Cet engagement profond en faveur d’un format de données ouvert commun signifie que les clients n’ont besoin de charger les données qu’une seule fois dans le lac de données et que toutes les charges de travail peuvent fonctionner sur les mêmes données, sans avoir à les ingérer séparément », a déclaré l’entreprise. « Autrement dit, OneLake prend en charge les données structurées de n’importe quel format et les données non structurées », a-t-elle ajouté.

Boris Evelson estime que l’adoption du format open source pourrait représenter un énorme gain de temps, d’efforts et d’espace de stockage. « Même si OneLake n’est pas lui-même open source, la structure des données est basée sur un format de données open source appelé Parquet, optimisé pour l’analyse. Cela signifie qu’un lac de données, un entrepôt de données et une plateforme de BI (dans ce cas, Power BI) utiliseront exactement le même format et, surtout, la même instance/version des données », a déclaré Boris Evelson. De plus, Microsoft a déclaré qu’elle prévoyait d’introduire un modèle de sécurité universel pour le Fabric géré dans OneLake afin d’aider les entreprises à gérer la sécurité des données à travers différents moteurs de données, modules ou outils. « Ce modèle garantira que tous les moteurs ou modules de données appliquent le modèle de sécurité quand ils traitent des requêtes ou d’autres tâches », a indiqué l’entreprise.

Une capitalisation qui ne va pas de soi

Selon les analystes, le lancement de Microsoft Fabric pourrait avoir un impact sur son adoption et sa popularité. « Si chaque entreprise utilisatrice d’Office 365 reçoit une copie de Fabric, tout comme elle reçoit actuellement une copie de Power BI avec la licence E5 Office 365, elle aura le même effet viral que Power BI », a déclaré Boris Evelson. Cependant, Doug Henschen, analyste principal chez Constellation Research pense qu’il ne faut pas s’empresser de miser sur un succès immédiat de Fabric. « Nous devons garder à l’esprit que tout ce qui a été annoncé est encore en aperçu et que jusqu’à présent, la réussite de Microsoft dans des domaines comme l’entreposage de données reste mitigée.

« Plus récemment, Azure Synapse n’a pas été adoptée massivement ni acclamé par les clients comme plateforme de stockage de données », a aussi déclaré M. Henschen, ajoutant que les entreprises ne changent généralement pas rapidement de plateforme de données. Selon les analystes, Microsoft Fabric peut être comparé à Google DataPlex, SAP DataSphere et IBM Data Fabric.

Avec la fonction de résolution des erreurs SSL de l’outil de sécurité Dope Security, les administrateurs peuvent désormais contourner sans effort l’inspection SSL pour les applications.

La fonction de résolution instantanée des erreurs SSL (Secure Socket Layer) lancée par Dope Security fait désormais partie de l’offre de passerelle web sécurisée (Secure Web Gateway, SWG), Dope.swg du fournisseur de sécurité web et cloud basée sur les terminaux. L’objectif de la fonction est de simplifier la tâche d’inspection SSL réalisée par la passerelle SWG de Dope et d’aider les administrateurs à contourner les erreurs SSL générées après l’inspection. « Contrairement aux autres fournisseurs, l’architecture ‘fly-direct’ de Dope ne réachemine pas l’ensemble du trafic Internet vers un datacenter pour effectuer les contrôles de sécurité, mais ils sont réalisés directement sur l’appareil », a déclaré Kunal Agarwal, CEO de Dope Security. « Cette fonction de résolution instantanée des erreurs SSL simplifie encore plus le processus d’inspection SSL », a ajouté le CEO. L’inspection SSL est une fonction de sécurité qui permet aux passerelles web sécurisées de décrypter le trafic crypté SSL, de l’analyser pour rechercher des menaces potentielles et de le recrypter avant de l’acheminer vers sa destination.

Un impact possible sur le fonctionnement des applications

L’inspection SSL peut parfois causer des problèmes et interrompre certaines applications qui reposent sur le cryptage SSL pour fonctionner correctement. Différentes raisons sous-jacentes peuvent entraîner le blocage des applications, notamment des problèmes de validation des certificats, des adresses IP et des domaines codés en dur, ou encore des configurations SSL spécifiques à l’application. La validation des certificats peut provoquer une erreur en cas d’incohérence entre les certificats générés par SSL et le certificat original fourni par le site web. Si l’application n’est pas conçue pour gérer ce changement de certificat, la validation échoue et la connexion est refusée. Les adresses IP codées en dur dans certaines applications peuvent également entraîner une rupture, car ces applications sont conçues pour se connecter à une adresse IP ou à un domaine spécifique, et peuvent ne pas reconnaître l’adresse IP ou le domaine de la passerelle SWG après l’inspection SSL.

Plusieurs applications peuvent aussi avoir des configurations SSL spécifiques, incompatibles avec le processus d’inspection SSL de la passerelle web sécurisée et donc conduire à une rupture. Quand l’inspection SSL pose des problèmes, les administrateurs cherchent à configurer des règles de contournement SSL pour des applications ou des sites web spécifiques afin d’éviter l’inspection. Cependant, la configuration de ces règles est généralement manuelle, ce qui implique l’enregistrement de tickets d’assistance, la recherche de domaines d’application et d’URL, la saisie manuelle de listes de contournement et une surveillance manuelle continue, comme l’explique Dope Security dans un blog. « La génération précédente de produits provoquait plus de problèmes qu’elle n’en résolvait », a reconnu M. Agarwal. « Par exemple, si une application avait un problème de compatibilité avec l’inspection SSL, il fallait une énorme coordination entre l’employé, son équipe IT et le service clientèle pour comprendre ce qui se passait. Cela prend du temps et c’est très fastidieux », a déclaré le CEO. « La méthode actuelle de contournement de l’inspection SSL comporte tellement d’étapes et de vérifications qu’il est presque plus facile de désactiver complètement l’agent SWG pour qu’au moins, les applications fonctionnent », a-t-il ajouté. Il est évident que cette désactivation rendra les entreprises vulnérables aux menaces de sécurité et qu’il faut donc l’éviter. « La simplification du processus de mise à jour des listes de contournement est une bien meilleure alternative que la désactivation totale de l’inspection SSL », a déclaré Michael Sampson, analyste chez Osterman Research. « Les entreprises devraient examiner régulièrement ce qui ne marche pas et pourquoi, et voir si les mises à jour ont résolu le problème afin d’inverser les règles de contournement et de couvrir une plus grande part du processus par l’inspection SSL », a ajouté l’analyste.

Les erreurs SSL marquées instantanément

L’offre SWG de Dope, Dope.swg, dispose déjà d’une capacité d’enregistrement des erreurs SSL. La fonction de résolution instantanée des erreurs SSL ajoute des capacités de journalisation et d’analyse pour préparer et afficher une liste de processus et d’URL spécifiques affectées par des erreurs SSL. Après avoir analysé le nom du processus et récupéré les URL associées, ces résultats sont enregistrés et synchronisés avec Dope.cloud, la console utilisateur basée sur le cloud pour toutes les configurations d’administration et les rapports. Les administrateurs peuvent utiliser Dope.cloud pour ajouter ces résultats aux listes de contournement en un seul clic. Tous les contrôles de sécurité effectués par la passerelle SWG de Dope sont réalisés par Dope.endpoint, le proxy SSL de Dope présent sur l’appareil, qui conserve la politique de l’utilisateur de l’entreprise et protège l’appareil contre l’accès au mauvais contenu. Dope.endpoint est contrôlé par la console Dope.cloud où sont configurées les politiques de l’entreprise. « Cette résolution instantanée des erreurs SSL simplifie le processus d’inspection et de contournement SSL et le convertit en trois clics : quand l’erreur s’affiche, il suffit de cocher une case et d’appuyer sur le bouton de contournement. C’est tout ! Cette fonctionnalité aurait dû être disponible d’emblée chez les fournisseurs pour faciliter la vie de tous », a déclaré le CEO de Dope Security. « Une boucle de rétroaction entre Dope et les propriétaires d’applications serait également bienvenue, en s’abonnant peut-être à un flux de ruptures, afin de voir ce qui ne fonctionne pas où et pourquoi », a fait valoir Michael Sampson. La fonction sera automatiquement disponible pour les clients utilisant dope.swg, sans surcoût ni licence. Dope travaille actuellement sur des offres de courtier de sécurité d’accès au cloud (Cloud Access Security Broker, CASB) et d’accès privé afin d’offrir une solution Security Service Edge (SSE) complète.

D’après Trend Micro, le cybergang Lemon Group est parvenu à préinstaller son logiciel malveillant Guerrilla dans 8,9 millions de terminaux Android incluant aussi bien des smartphones que des montres ou encore des télévisions. Ses capacités incluent l’interception de mots de passe unique via SMS, le déploiement de reverse proxy ou encore l’infiltration dans des sessions WhatsApp.

Encore une alerte de sécurité à surveiller de près. Selon Trend Micro, le groupe de cybercriminels Lemon Group a réussi à préinstaller un logiciel malveillant connu sous le nom de Guerrilla sur environ 8,9 millions de smartphones, montres, téléviseurs et boîtiers de télévision fonctionnant sous Android dans le monde. Guerrilla peut installer des charges utiles supplémentaires, intercepter des mots de passe à usage unique (One-Time Password, OTP) à partir de SMS, mettre en place un reverse proxy à partir d’un terminal infecté et s’infiltrer dans les sessions WhatsApp. « L’infection transforme ces appareils en proxy mobiles, en outils pour voler et vendre des messages SMS, des comptes de médias sociaux et de messagerie en ligne, et pour les monétiser via des publicités et des fraudes au clic », ont déclaré les chercheurs de Trend Micro dans un rapport présenté lors de la conférence BlackHat Asia organisée du 9 au 12 mai 2023 à Singapour. Les systèmes infectés ont été distribués dans le monde entier, les logiciels malveillants ayant été installés sur des appareils expédiés dans plus de 180 pays, dont les États-Unis, le Mexique, l’Indonésie, la Thaïlande, la Russie, l’Afrique du Sud, l’Inde, l’Angola, les Philippines et l’Argentine.

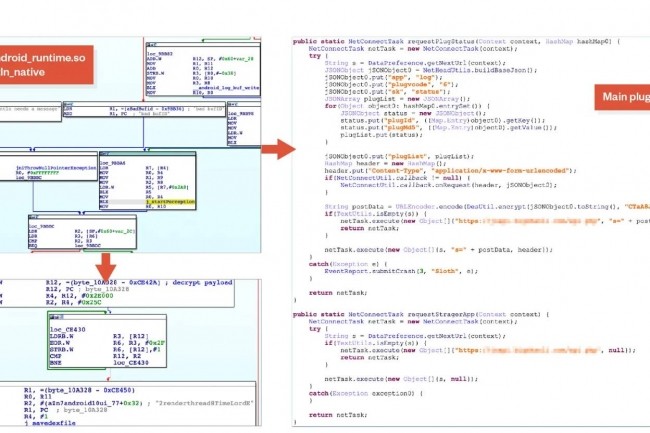

L’installation de logiciels malveillants sur les terminaux Android peut se produire chez des partenaires tiers engagés par des fabricants pour améliorer l’OS de leurs produits. Dans son analyse de Guerrilla, Trend Micro indique qu’une entreprise qui produit des composants de firmware pour les téléphones mobiles, produit également des composants similaires pour Android Auto, une app mobile Android utilisée sur les tableaux de bord d’information et de divertissement des véhicules. « Cela étend les possibilités d’infection et il est probable que certains systèmes de divertissement embarqués sont déjà infectés », a déclaré Trend Micro dans son étude. C’est après avoir pris connaissance des rapports de compromission touchant des smartphones que l’éditeur a commencé à s’intéresser à Guerrilla, et ses chercheurs ont extrait l’image ROM d’un téléphone infecté pour l’analyser. « Nous avons trouvé une bibliothèque système appelée libandroid_runtime.so qui a été altérée pour injecter un extrait de code dans une fonction appelée println_native », a expliqué le fournisseur en sécurité.

Des fonctions spécifiques activées par plug-ins

Le code injecté décrypte un fichier DEX – un format de fichier utilisé par le système d’exploitation Android pour l’exécution du bytecode – à partir de la section des données de l’appareil et le charge dans la mémoire. Le fichier est exécuté par Android Runtime pour activer le plugin principal, appelé Sloth, utilisé par les attaquants, et fournit sa configuration, qui contient un domaine Lemon Group utilisé pour les communications. L’activité principale du gang Lemon Group implique l’utilisation de big data, « l’analyse de quantités massives de données et les caractéristiques correspondantes des livraisons des fabricants, les différents contenus publicitaires obtenus de différents utilisateurs à différents moments, et les données matérielles avec un push logiciel détaillé », a encore expliqué Trend Micro. Tout cela permet aux cybercriminels de surveiller les clients qui peuvent être infectés par d’autres applications. « Nous pensons que l’acteur malveillant cherche aussi à voler des informations sur le terminal infecté pour les utiliser dans le cadre de la collecte de données massives (big data) avant de les vendre à d’autres cyberattaquants dans le cadre d’un autre programme de monétisation post-infection », a aussi déclaré Trend Micro.

Le plugin principal du malware Guerilla charge des extensions supplémentaires dédiées à l’exécution de fonctions spécifiques : SMS Plugin intercepte les mots de passe à usage unique pour WhatsApp, JingDong et Facebook ceux reçus par SMS ; Proxy Plugin met en place un reverse proxy à partir du téléphone infecté en vue d’utiliser les ressources du réseau de la victime ; Cookie Plugin pour aspirer les cookies Facebook dans le répertoire de données de l’application et les exfiltrer vers le serveur C2. Ce plug-in détourne également les sessions WhatsApp pour diffuser des messages indésirables à partir d’un terminal compromis. Le logiciel malveillant comprend par ailleurs Splash Plugin, qui affiche des publicités intrusives à l’intention des victimes quand elles utilisent des applications légitimes, et Silent Plugin, qui installe des APK (Android Package Kits) supplémentaires reçus du serveur C2, ou désinstalle des applications existantes, selon les instructions. « L’installation et le lancement de l’application sont silencieux dans la mesure où ils se déroulent en arrière-plan », a précisé Trend Micro.

Des liens avec le cheval de Troie Triada

Une partie de l’infrastructure des attaquants recoupe l’opération du cheval de Troie Triada apparu en 2016. Ce Trojan bancaire été trouvé préinstallé sur 42 modèles de smartphones Android de marques chinoises bon marché. « Nous pensons que ces deux groupes ont travaillé ensemble à un moment donné, car nous avons observé un certain chevauchement de leur infrastructure de serveurs C&C », a déclaré Trend Micro. C’est en février 2022 que le Lemon Group a été identifié pour la première fois, avant qu’il ne se rebaptise Durian Cloud SMS. Mais l’infrastructure et les tactiques des attaquants sont restées inchangées.

L’année dernière, trente-cinq millions de tentatives de compromission de courriels professionnels ont été détectées selon le dernier rapport Cyber Signals de Microsoft.

Entre avril 2022 et avril 2023, l’activité de cybersécurité autour de la compromission des courriels professionnels (BEC) a connu un pic : plus de 150 000 tentatives quotidiennes, en moyenne, ont été détectées par l’unité de lutte contre les crimes numériques Digital Crimes Unit (DCU) de Microsoft. C’est ce que montre le dernier rapport de veille sur les cybermenaces Cyber Signals de Microsoft, qui met en lumière les tendances en matière de sécurité à partir des informations recueillies par Microsoft auprès de ses 8 500 experts en sécurité et l’analyse de 43 trillions de signaux de sécurité. « Les attaques BEC se distinguent dans le secteur de la cybercriminalité par l’importance qu’elles accordent à l’ingénierie sociale et à l’art de la tromperie », a déclaré Vasu Jakkal, vice-président de la sécurité de l’entreprise, dans un billet de blog. « Chaque année, les attaques BEC réussies coûtent des centaines de millions de dollars aux entreprises », a-t-il ajouté.

Selon le rapport, entre 2019 et 2022, l’unité DCU de Microsoft a constaté une augmentation de 38 % des attaques de cybercriminalité en tant que service (Cybercrime-as-a-Service, CaaS) ciblant les courriels professionnels. Entre mai 2022 et avril 2023, la Digital Crimes Unit a également démantelé 417 678 URL de phishing uniques. Et entre avril 2022 et avril 2023, Microsoft a détecté et enquêté sur 35 millions de tentatives de BEC, avec une moyenne de 156 000 tentatives par jour. « En 2022, l’équipe Recovery Asset Team (RAT) du FBI a lancé la Financial Fraud Kill Chain (FFKC) – un processus de lutte contre les transferts d’argent frauduleux mis en place depuis 2016 – sur 2 838 plaintes BEC impliquant des transactions nationales avec des pertes potentielles de plus de 590 millions de dollars », a encore déclaré M. Jakkal. Au lieu de cibler les vulnérabilités des appareils non corrigées, les opérateurs de BEC s’efforcent de tirer parti de l’énorme volume de courrier électronique et d’autres messages quotidiens pour inciter les victimes à partager des informations financières ou à transférer à leur insu des fonds sur des comptes mule. Leur objectif est d’exploiter le flux constant de communication pour effectuer des transferts de fonds frauduleux.

Diverses tactiques de compromission

Selon le rapport, les acteurs de la menace emploient différentes méthodes pour essayer de compromettre la messagerie électronique d’une entreprise, soit par des appels téléphoniques, des messages textuels, des courriels ou des médias sociaux. Ils envoient par exemple de fausses demandes d’authentification ou se font passer pour des particuliers ou des entreprises pour tromper leurs cibles. « La paie, les factures, les cartes-cadeaux et les informations commerciales font partie des thèmes utilisés pour tromper les victimes dans les attaques BEC », a déclaré Microsoft. De plus, l’entreprise fait remarquer que, de plus en plus souvent, les attaquants s’appuient sur des plateformes CaaS comme BulletProftLink pour créer des campagnes de courriels malveillants à grande échelle. Cette plateforme offre un service complet avec des modèles, un hébergement et des fonctions automatisées spécialement conçues pour le BEC.

De plus, les adversaires qui utilisent ce service reçoivent des adresses IP qui facilitent leur ciblage. Les professionnels de la cybersécurité et les autorités judiciaires craignent que ces nouvelles tactiques dans les attaques BEC compliquent le traçage des acteurs malveillants, ce qui pourrait conduire à une augmentation des attaques à grande échelle. « Même si les acteurs de la menace ont créé des outils spécialisés pour faciliter la compromission de courriels professionnels, notamment des kits de phishing et des listes d’adresses électroniques vérifiées ciblant les dirigeants, les responsables de la comptabilité fournisseurs et d’autres postes spécifiques, les entreprises disposent de diverses solutions pour anticiper les attaques et réduire les risques », a déclaré M. Jakkal. Dans le genre, « l’utilisation d’applications de messagerie sécurisées, la sécurisation des identités pour bloquer les mouvements latéraux ainsi que l’adoption d’une plateforme de paiement sécurisée et la formation des employés sont efficaces », selon le rapport Cyber Signals de Microsoft.

Les jumeaux numériques sont des outils extrêmement utiles pour de nombreux secteurs. Mais ils présentent également des risques intrinsèques et leur usage pourrait ouvrir la voie à de nouvelles attaques si la sécurité n’est pas prise en compte lors de leur création.

Les jumeaux numériques, des représentations virtuelles d’objets réels ou envisagés dans le monde réel, sont de plus en plus utilisés. Leurs utilisations sont multiples et peuvent être incroyablement utiles, en fournissant des modèles en temps réel de biens physiques, voire de personnes ou de systèmes biologiques, qui peuvent aider à identifier les problèmes au moment où ils se produisent ou même avant qu’ils ne se produisent. Selon le cabinet d’études de marché Grand View Research, le marché mondial des jumeaux numériques, évalué à 11,1 milliards de dollars en 2022, devrait connaître un taux de croissance annuel de 37,5 % entre 2023 et 2030. Ce marché est donc appelé à peser plus de 155 milliards de dollars à cet horizon, si on se fie à cette projection.

Mais à mesure que des entreprises étendent leur utilisation des jumeaux numériques et que d’autres en créent de nouveaux, les experts affirment que les organisations augmentent également leur exposition en termes de cybersécurité. Parce que les jumeaux numériques s’appuient sur des données pour créer une représentation précise de ce qu’ils modélisent, ils sont vulnérables. Que se passe-t-il si ces données sont corrompues ou, pire encore, volées et utilisées à des fins malveillantes plutôt qu’aux fins prévues ? « Nous disposons d’un nouvel outil, qui peut être bénéfique, mais qui doit être renforcé, auquel il faut appliquer des mesures de cybersécurité, dont la connexion à l’Internet doit être sécurisée, et dont les données doivent être protégées », résume Brian Bothwell, directeur de l’équipe science, évaluation des technologies et analyse (STAA) du Government Accountability Office (GOA), l’organe chargé du contrôle des comptes publics aux États-Unis, et également auteur d’un rapport du GOA sur les jumeaux numériques en février 2023.

Les jumeaux numériques, vulnérables aux menaces, doivent être protégés

Les experts en technologie et les responsables de la sécurité affirment que les jumeaux numériques peuvent être aussi vulnérables aux menaces existantes que les environnements IT et OT conventionnels. Certains affirment que les jumeaux numériques pourraient non seulement créer de nouveaux points d’entrée pour les attaques visant ces environnements, mais aussi offrir des opportunités pour de nouveaux types d’attaques – y compris ce qu’un expert en sécurité a décrit comme le « jumeau numérique malveillant ». « Ce type de technologie offre de nombreuses possibilités d’infiltration en matière de cybersécurité et de piratage informatique », explique M. Bothwell.

L’intérêt des jumeaux numériques ? Ils permettent de tester et d’analyser le comportement de systèmes réels à l’aide de données provenant du système lui-même. L’objet représenté par un jumeau numérique peut être un objet physique tel qu’un avion, un environnement tel qu’un bâtiment ou une usine de fabrication ou une réplique virtuelle d’un système technique. Il peut s’agir d’un environnement qui existe déjà, avec tous les processus du monde réel simulés par la technologie et dupliqués dans le jumeau numérique, ou d’une réplique des plans de tels objets. Pour certains spécialistes du domaine, un jumeau numérique peut également être un double d’une personne, employé ou persona – une représentation numérique d’une entité individuelle telle qu’un client ou une entreprise.

Des représentations qui changent en temps réel pour correspondre à l’original

Un jumeau numérique n’est pas statique : il reçoit les mêmes données – souvent fournies en temps réel – que son jumeau du monde réel et les modifie en conséquence. Ce type de modélisation s’est avéré très utile dans les secteurs de la fabrication, de l’aérospatiale, des transports, de l’énergie, des services publics, de la santé, des sciences de la vie, de la vente au détail et de l’immobilier.

Quel que soit le secteur, les entreprises utilisent les jumeaux numériques pour effectuer des simulations qui peuvent être réalisées plus rapidement, plus facilement, à moindre coût et avec moins de risques dans le jumeau numérique que dans l’environnement réel. Ces simulations aident les entreprises à comprendre les résultats de divers scénarios, ce qui facilite la planification, la maintenance prédictive, l’amélioration de la conception, etc. Les entreprises peuvent ensuite appliquer à l’objet réel les résultats des simulations effectuées dans leurs jumeaux numériques.

« Les jumeaux numériques présentent de grands avantages, comme la possibilité de surveiller les systèmes en temps réel ou de prévoir ce qui pourrait se produire dans certaines situations », explique M. Bothwell. Mais il y a aussi des risques, des préoccupations et des dangers, que Brian Bothwell met en évidence dans son rapport : « De nombreux secteurs les utilisent pour réduire les coûts, améliorer la conception technique et la production, et tester les chaînes d’approvisionnement. Mais certaines applications, comme la création d’un jumeau numérique d’une personne, soulèvent des problèmes techniques, de confidentialité, de sécurité et d’éthique. »

Extension de la surface d’attaque

Les jumeaux numériques impliquent le même ensemble complexe et la même configuration de technologies que leurs homologues du monde réel, explique Mahadeva Bisappa, architecte principal chez SPR, une entreprise spécialisée dans la modernisation technologique. En d’autres termes, ils sont constitués de la même constellation de systèmes, de puissance informatique (généralement dans le cloud), de réseaux et de flux de données. « Vous devez sécuriser tous les endpoints ; la plateforme cloud – quel que soit le produit que vous utilisez – doit être sécurisée. Et toutes les données qui sont introduites doivent également être sécurisées », explique M. Bisappa. Celui-ci et d’autres soutiennent que les jumeaux numériques élargissent encore la surface d’attaque que les pirates peuvent exploiter. « Un jumeau numérique est une autre application connectée à l’Internet, on y retrouve les mêmes problèmes de sécurité. »

Et l’utilisation croissante des jumeaux numériques pose encore d’autres difficultés, explique Kayne McGladrey, membre senior de l’Institute of Electrical and Electronics Engineers (IEEE), une association professionnelle à but non lucratif, et RSSI de terrain chez Hyperproof. Pour commencer, il explique que les RSSI peuvent ne pas avoir de visibilité sur l’utilisation des jumeaux numériques par leur propre organisation.

Les RSSI doivent savoir quand les jumeaux numériques sont utilisés

« Le RSSI est-il au courant de ce qui se passe ? » interroge ainsi Kayne McGladrey, expliquant qu’il a vu des entités métiers piloter la mise en oeuvre des jumeaux numériques sans consulter l’équipe de sécurité. Comme il le souligne : « Il est difficile d’appliquer des contrôles efficaces à quelque chose dont on ignore l’existence. »

Selon M. McGladrey, les jumeaux numériques soulèvent également des questions d’ordre juridique et réglementaire. Les principales préoccupations concernent la capacité des opérateurs de jumeaux numériques à garantir que les données utilisées dans ces derniers sont traitées de manière à respecter les exigences réglementaires en matière de confidentialité, de protection de la vie privée et même de localisation pour l’hébergement des données. La propriété des données peut également devenir un point problématique si elle n’est pas prise en compte, en particulier si une organisation s’associe à d’autres entités pour gérer ses jumeaux numériques, ajoute-t-il.

D’après McGladrey, certaines organisations ne prennent pas suffisamment en compte ces considérations de sécurité et de gestion des risques, car les équipes métiers et techniques qui utilisent les jumeaux numériques peuvent craindre que l’ajout de certains contrôles de sécurité ou d’un trop grand nombre de contrôles ne ralentisse les performances des jumeaux numériques.

Risques émergents et nouvelles menaces potentielles

Certains experts considèrent que la nature même du jumeau numérique entraîne encore plus de risques. Jason M. Pittman, professeur à la School of Cybersecurity & Information Technology du Campus global de l’Université du Maryland (UMGC), en fait partie. Celui-ci a mis en évidence les risques de sécurité liés à ce qu’il appelle le « jumeau numérique malveillant ». Dans un récent billet blog de l’UMGC, M. Pittman a prédit ce qui suit : « Au cours de l’année à venir, nous assisterons à une augmentation des jumeaux numériques malveillants. Ce modèle de logiciel virtuel malveillant sera utilisé pour renforcer les activités cybercriminelles telles que les ransomwares, le phishing et la cyberguerre hautement ciblée. Ces attaques seront nettement plus efficaces que les méthodes traditionnelles en raison de la spécificité offerte par les modèles de jumeaux numériques malveillants. »

Un pirate pourrait ainsi créer un jumeau numérique d’une personne existante, « l’insérer dans votre environnement, puis observer et participer à votre organisation et ensuite injecter des logiciels malveillants dans l’écosystème », explique M. Pittman. « Cela donne aux pirates un autre moyen d’entrer dans une organisation, et il est peu probable qu’une défense soit en place contre ce type d’attaque. »

Fausser les résultats des simulations

Jason M. Pittman a observé de nouveaux scénarios d’attaques apparaître avec l’usage des jumeaux numériques. Par exemple, si des pirates parviennent à s’introduire dans un tel environnement, ils peuvent soit voler les données, soit, selon leurs motivations, manipuler les données utilisées par le jumeau numérique pour fausser délibérément les résultats de la simulation. Compte tenu des possibilités de tels scénarios, M. Pittman ajoute : « Je pense qu’il s’agit là d’un autre cas où nous propageons la technologie sans nécessairement penser aux répercussions. Je ne dis pas que c’est bien ou mal ; nous sommes humains et nous sommes doués pour ce genre de choses. Et même si je ne pense pas que nous allons voir des catastrophes, nous allons probablement observer des impacts significatifs ».

M. Pittman n’est pas le seul à s’inquiéter des nouvelles menaces que les jumeaux numériques pourraient faire peser sur la sécurité. Lors de ses recherches sur les jumeaux numériques, M. Bothwell a entendu des inquiétudes portant sur la manipulation potentielle des données de ces jumeaux par des adversaires. « Nous ne nous sommes pas penchés spécifiquement sur cette question pour le rapport, mais c’est l’une des questions qui ont été soulevées », explique-t-il, ajoutant qu’il s’agit d’une préoccupation fréquemment mentionnée à propos des données d’entraînement utilisées dans les algorithmes d’apprentissage automatique – un type d’attaque connu sous le nom d’empoisonnement des données.

David Shaw, PDG de la société de cybersécurité Intuitus, met également en garde contre les risques inhérents aux jumeaux. M. Shaw, qui est également coprésident des groupes de travail « fintech », « sécurité et confiance » et « aérospatiale et défense » du Digital Twin Consortium, une organisation à but non lucratif, note que les jumeaux numériques sont utilisés dans certains secteurs depuis de nombreuses années, mais qu’à mesure qu’ils sont associés à un nombre croissant de technologies, les risques augmentent également.

La sécurité doit commencer dès la conception

Par exemple, les technologies de réalité augmentée et virtuelle font de plus en plus partie du paysage des jumeaux numériques, ajoutant une nouvelle couche de vulnérabilité possible et nécessitant des précautions supplémentaires en termes de sécurité. Cependant, M. Shaw explique que la sécurité ne fait pas toujours partie de l’élaboration des jumeaux numériques et qu’elle est plutôt introduite tardivement dans le processus. Selon lui, cela se traduit généralement par des contrôles de sécurité de qualité médiocre. « La sécurité doit être intégrée au coeur même du jumeau numérique que vous construisez. Elle doit être présente dès le départ », ajoute-t-il. « Mais les ingénieurs [qui construisent les jumeaux numériques] et la cybersécurité ont encore beaucoup de travail à faire pour apprendre à travailler ensemble. »

À l’instar de M. Pittman, M. Shaw reconnaît que de nouveaux scénarios d’attaque pourraient voir le jour, notant que les chercheurs ont par le passé identifié de nouvelles techniques d’intrusion dans des bancs d’essai, ce qui indique que de tels scénarios sont possibles. Selon David Shaw la question se pose également de savoir si les organisations pourraient détecter un nouveau type d’attaque développé par les pirates. Dans ce contexte, celui-ci insiste sur la nécessité de rester vigilant et de mettre en place une sécurité proactive. « Nous devons rester attentifs et trouver des moyens de mettre en place des garde-fous pour identifier les comportements anormaux », rappelle-t-il.

Après avoir fermé son dernier datacenter, la division informatique de General Dynamics spécialisé dans l’aérospatiale et la défense aux Etats-Unis se tourne de plus en plus vers les applications cloud native afin d’optimiser les performances, l’évolutivité et les coûts dans le cloud.

Aujourd’hui, pour répondre aux besoins fondamentaux de plus de 100 000 employés dans le monde, il faut miser sur le cloud. C’est en tout cas le choix réalisé par James Hannah, vice-président sénior et DSI groupe au sein de General Dynamics Information Technology (GDIT), pour soutenir les 10 entités commerciales de l’entreprise d’aérospatiale et de défense basée à Reston, en Virginie, dont chacune possède son propre DSI conservant son autonomie de décisions quant aux usages du numérique au service des métiers.

Un équilibre qui aboutit à un paysage réellement multicloud, car James Hannah a choisi de travailler avec les principaux fournisseurs de cloud – AWS, Microsoft Azure, Google Cloud Platform et Oracle Cloud – pour répondre aux différents besoins de back-office de l’entreprise ainsi qu’avec Workday pour les RH et d’autres fournisseurs de SaaS pour des besoins spécifiques. GDIT est désormais à 100% sur le cloud, ayant fermé son dernier datacenter à la fin de l’année dernière.

Généraliser le zero trust

« Nous avons déjà effectué notre transformation numérique et migré tous nos applicatifs dans un environnement IaaS ou SaaS », explique le DSI, qui se concentre principalement sur les systèmes groupe, laissant à chaque autre entité du groupe la possibilité de faire ses propres choix. « Elles sont libres d’aller dans le cloud qu’elles privilégient pour répondre au mieux aux besoins de leurs propres clients », précise-t-il. Cependant, les dix entités de General Dynamics ne vivent pas de façon isolée. La division IT centrale de James Hannah collabore avec les DSI “soeurs” au sein des métiers et répond à leurs besoins lorsque cela s’avère judicieux, par exemple en hébergeant des applications financières pour certaines d’entre elles. Sans oublier les technologies numériques globales transversales au portefeuille d’activités de General Dynamics, telles que la sécurité, pour laquelle toutes les unités s’efforcent de mettre en oeuvre les principes du Zero Trust à tous les niveaux.

Mais James Hannah est clair sur sa mission, qui est de fournir des services critiques aux employés qui eux-mêmes servent les clients de General Dynamics au sein du complexe militaro-industriel du gouvernement américain et de ses partenaires dans le monde entier. Une activité évidemment très sensible. Dans ce contexte, la migration complète du GDIT vers le cloud, qui a commencé avant la pandémie de Covid-19, porte ses fruits.

Poser les fondations du multicloud

Lorsque la division IT a entamé sa transformation numérique, James Hannah et son équipe ont procédé à une évaluation approfondie des applicatifs d’entreprise de General Dynamics afin de déterminer quel cloud serait le mieux adapté en fonction des fonctionnalités. Dans le cadre de ce processus, les intégrations avec d’autres systèmes et applications ont été prises en compte afin d’éviter que les processus applicatifs ne « passent d’un cloud à l’autre » ou ne « rebondissent partout », explique le DSI. « Je pense que les clouds ont atteint un niveau satisfaisant. Nous avons constaté une forte réduction des coûts, ajoute-t-il. Nous avons pu obtenir de meilleures mesures et de meilleurs rapports. Et cela a permis d’améliorer ou de renforcer notre dispositif de reprise après sinistre ».

James Hannah, qui dirige General Dynamics Information Technology (GDIT), la DSI groupe chargée de soutenir les 10 entités commerciales de l’entreprise d’aérospatiale et de défense, réalisant près de 40 Md$ de chiffre d’affaires annuel. (Photo : D.R.)

La prochaine étape, selon James Hannah ? Faire évoluer davantage d’actifs de l’entreprise vers des applications virtualisées, nativement cloud, qui peuvent être optimisées en termes d’évolutivité, de flexibilité et de coûts sur une infrastructure 100 % multicloud. La DSI groupe apprivoise également les leviers pour renforcer et migrer des applications afin d’optimiser leurs performances et, dans certains cas, pour les déplacer du IaaS vers le SaaS lorsque cela s’avère judicieux. « Cela fait partie de l’évolution vers le cloud, explique le DSI. Vous n’allez pas être dans une phase permanente de transformation. Pour moi, il s’agit plutôt d’une évolution au long cours, d’évaluer les applicatifs et de s’assurer qu’ils sont toujours là où ils doivent être. »

GDIT a également automatisé de nombreuses tâches au sein de ses systèmes financiers, telles que le règlement des factures inter et intra-entreprises, ainsi que sur les domaines d’activité relatifs aux RH et à l’IT. Rien de tout cela n’est surprenant pour une division informatique d’une grande entreprise, d’autant que GDIT dispose lui-même d’une surface très étendue – la DSI groupe emploie environ 30 000 employés répondant aux besoins de General Dynamics.

Déployer l’IA, renforcer les compétences

La direction technique (CTO) de General Dynamics étudie également l’IA générative, ses implications et sa gouvernance, ainsi que la manière dont elle pourrait être utilisée avec les clients, explique James Hannah. Mais pour une entreprise de défense – qui fabrique des sous-marins nucléaires, des systèmes aérospatiaux et des systèmes de combat, entre autres -, il s’agit d’une démarche très complexe qui ne fait que commencer, ajoute-t-il.

Néanmoins, le DSI a d’ores et déjà utilisé des modèles d’apprentissage automatique, disponibles chez un de ses fournisseurs de cloud, pour former les employés à l’évolution rapide du numérique et favoriser la mobilité ascendante au sein de General Dynamics. L’initiative fait partie du Career Hub de General Dynamics, qui fournit aux employés des recommandations en matière d’évolution de leurs compétences et de certifications afin de les aider à progresser dans leur carrière, explique James Hannah. « Depuis que nous avons mis en place cette capacité de modélisation de l’IA, nous avons constaté une augmentation d’environ 30 % des demandes internes provenant directement du Career Hub », explique-t-il.

Les employés n’ont qu’à télécharger leur CV ou leur profil LinkedIn sur Career Hub et l’IA leur recommande des postes ouverts au sein du groupe, à l’instar de Netflix qui recommande des films, explique le DSI. Les liens avec le système d’apprentissage et de développement des compétences de l’entreprise fournissent des recommandations sur les formations certifiantes qui aideront les employés à se positionner sur les postes vacants qu’ils n’auraient pas considérés comme appropriés parce qu’ils ne possèdent actuellement que 80 % des compétences requises.

Transformer et faire évoluer l’arsenal cyber

James Hannah déploie également l’automatisation pour les tâches répétitives sans grande valeur ajoutée, pour amener les employés du GDIT à se concentrer sur des travaux plus complexes, comme le déploiement de l’automatisation au sein de la finance. En plus de renforcer l’efficacité de l’organisation, cette approche de l’automatisation par le GDIT permet donc aussi aux employés d’acquérir de nouvelles compétences favorisant leur mobilité. S’il y a une chose qui empêche James Hannah de dormir, c’est bien la sécurité, essentielle pour toute entreprise, mais encore plus cruciale pour une société du secteur de la défense. Le GDIT et les dix unités opérationnelles du groupe attendent des directives et des orientations dans le cadre d’un programme de sécurité triennal actuellement en cours de définition. Sans même attendre ce plan, la cybersécurité reste la priorité n°1 du DSI aujourd’hui et au cours des 12 prochains mois.

« L’accent est mis sur la transformation et l’évolution des outils cyber dont nous disposons… C’est l’objectif principal compte tenu des menaces qui pèsent sur notre environnement, explique James. Hannah. Nous sommes en permanence sous la menace d’acteurs malveillants venant du monde entier. Faire partie d’un groupe qui a toujours une cible dans le dos signifie qu’il faut s’assurer de toujours considérer toutes les technologies disponibles pour améliorer notre position cyber au fur et à mesure de nos progrès. »

Au coeur des efforts du département de la Défense

Daniel Snyder, analyste au sein du cabinet Gartner, explique que le gouvernement et l’armée américains s’appuient fortement sur des partenariats avec des entreprises de défense, telles que General Dynamics, pour se transformer. « Le ministère de la Défense (ou DoD, pour Department of Defense, NDLR) s’appuie sur des milliers de réseaux essentiels à l’exécution de sa mission. Au cours des dernières décennies, le processus de développement a abouti à des couches de systèmes cloisonnés difficiles à intégrer », explique-t-il, notant que dans le cadre de sa stratégie de transformation numérique, le DoD est en train de remanier son infrastructure informatique pour tirer parti du cloud. « Une grande partie de la réussite future du DOD dépend du soutien de sa base industrielle avec des intégrateurs de systèmes tels que General Dynamics, Leidos, Raytheon et Northrop Grumman », ajoute l’analyste.

Avec Real-Time CSPM, Aqua Security mise sur la visibilité en temps réel du cloud et la hiérarchisation des menaces pour parer aux risques de l’analyse « ponctuelle » qui expose davantage aux attaques.

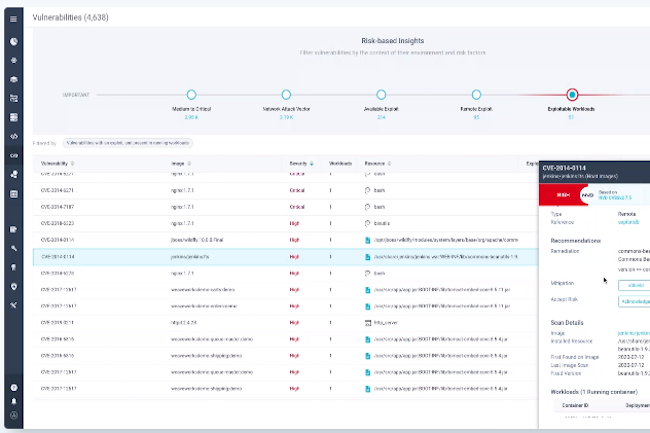

Le fournisseur de solutions de sécurité natives du cloud, Aqua Security, a annoncé le lancement de Real-Time CSPM. Dernier ajout à la plateforme de sécurité Aqua Cloud, la solution de gestion de la posture de sécurité dans le cloud (Cloud Security Posture Management, CSPM) fournit une visibilité et une hiérarchisation des risques liées au multi-cloud. Comme l’explique l’entreprise, Real-Time CSPM effectue un « scan en temps réel » pour identifier les menaces qui échappent à la détection sans agent et réduire le bruit afin que les praticiens de la sécurité puissent identifier, prioriser et remédier aux risques les plus importants en matière de sécurité du cloud. Dans ce domaine, les entreprises sont confrontées à divers défis et risques persistants, qui menacent à la fois les données et les réseaux alors qu’un nombre toujours plus grand d’applications est transféré dans le cloud. Selon un récent rapport sur la sécurité du cloud publié par l’Unité 42 de Palo Alto, la faiblesse des identifiants, l’absence d’authentification, les vulnérabilités non corrigées et les logiciels open source (Open Source Software, OSS) malveillants sont particulièrement préoccupants pour les entreprises. Parallèlement, les équipes de sécurité mettent en moyenne 145 heures à résoudre les alertes, 80 % d’entre elles étant déclenchées par seulement 5 % des règles de sécurité dans la plupart des environnements. Dans ce contexte, l’industrie devrait s’éloigner des solutions de sécurité ponctuelles pour se tourner vers des plateformes de protection des applications natives du cloud (Cloud-native Application Protection Platform, CNAPP) qui offrent une visibilité unique du cloud et des points de contrôle de sécurité centralisés.

Mettre fin aux risques de l’analyse ponctuelle

Selon un communiqué de presse d’Aqua Security, le CSPM en temps réel permet aux équipes de sécurité de faire correspondre les résultats corrélés dans des environnements multi-cloud, de dédupliquer les résultats et de se concentrer sur l’identification des risques réels liés au cloud grâce à des informations plus intelligentes. Un contexte détaillé permet également aux équipes de relier les problèmes trouvés dans leur cloud à leurs référentiels de code respectifs. « La visibilité en temps réel et la hiérarchisation des menaces au sein d’une plateforme unique suppriment les risques associés à l’analyse « ponctuelle » qui ouvre la porte à des attaques plus importantes », a ajouté l’entreprise. Selon une étude d’IDC, les trois quarts des entreprises analysent moins de 85 % de leurs actifs IT, 41 % d’entre elles le faisant une fois par mois ou moins. Si bien que de nombreuses vulnérabilités ne sont découvertes que quand elles sont exploitées par un pirate. « Les clients se disent bloqués par le bruit des offres CSPM actuelles », a déclaré Amir Jerbi, directeur technique et cofondateur d’Aqua Security. « Ils reçoivent trop de résultats, mais ne disposent pas d’une visibilité complète et ne sont donc pas en mesure d’établir correctement leurs priorités. En d’autres termes, ces solutions corrigent les mauvaises choses et finissent par être compromises », a-t-il ajouté.

Extension inexorable de la surface d’attaque

Selon l’Unité 42, les entreprises constatent régulièrement des comportements à risques dans le cloud, et le temps moyen pour remédier aux alertes (environ six jours) laisse beaucoup de marge aux adversaires pour exploiter les vulnérabilités du cloud. Par ailleurs, l’utilisation croissante de logiciels open source dans le cloud accroît les risques pour la chaîne d’approvisionnement, notamment la probabilité de logiciels dépréciés ou abandonnés, de contenus malveillants et de cycles de correctifs plus lents. « Les entreprises doivent s’attendre à ce que la surface d’attaque des applications natives du cloud s’étende, les acteurs de la menace profitant de cette mauvaise configuration pour cibler l’infrastructure du cloud, les API et la chaîne d’approvisionnement logicielle elle-même », a déclaré l’Unité 42.