Après l’accord passé avec le Département américain de la justice, HPE a officiellement annoncé l’acquisition de Juniper Networks. Les intégrations vont pouvoir commencer, sous les auspices d’une nouvelle entité réseau, HPE Networking avec un focus assumé sur l’IA.

Il aura fallu 18 mois pour HPE pour enfin boucler l’acquisition de Juniper Networks pour 14 Md$. L’opération avait été annoncée en janvier 2024 et a obtenu le feu vert de plusieurs autorités de régulation. Mais en janvier 2025, le Département américain de la justice a décidé de contester cette opération au motif qu’elle portait atteinte à la concurrence notamment sur le marché du réseau sans-fil. Après, plusieurs mois de négociations, HPE a réussi trouver un accord avec le DoJ autorisant le rachat sous conditions.

Avec cette acquisition finalisée, les travaux d’intégration entre les deux sociétés vont pouvoir commencer. Premier élément visible, la création d’une nouvelle entité baptisée HPE Networking qui va regroupe l’ensemble des activités réseaux. Elle est dirigée par Rami Rahim, ex CEO de Juniper. Ce dernier a expliqué lors d’une conférence de presse, « je peux vous assurer que mon objectif, en tant que dirigeant de cette activité réseau combinée, est de bâtir la meilleure entreprise réseau au monde, fondée sur l’innovation, et nous comptons y parvenir en nous concentrant d’abord sur nos clients et partenaires ».

Minimiser l’impact des concessions faites au DoJ

Au sein de cette entité, les deux marques HPE Aruba et Juniper vont co-exister, car l’entreprise continue d’y voir de la valeur. La refonte du portefeuille est en cours et Rami Rahim demande un peu de temps, « c’est le premier jour, et ce n’est que le début ». Le périmètre du portefeuille est également soumis à l’accord avec le DoJ qui impose deux contraintes à HPE. La première est la concession sous licence des algorithmes d’exploitation d’IA Mist de Juniper à ses concurrents par le biais d’une procédure d’enchères. « Nous avons convenu avec le DOJ d’offrir une licence, par le biais d’une procédure d’enchères, pour des aspects spécifiques de Juniper Mist, à savoir uniquement la partie exploitation d’IA », précise Antonio Neri, CEO de HPE. Cette distinction est techniquement significative. Les concurrents auront accès aux algorithmes de détection d’anomalies et de prédiction des pannes de Mist, mais pas au système d’exploitation réseau sous-jacent, aux couches d’abstraction matérielles ni aux modèles de données spécifiques aux clients qui rendent ces algorithmes efficaces en environnement de production. HPE conserve le contrôle des mécanismes de collecte de données, des pipelines de traitement de la télémétrie et des points d’intégration à l’infrastructure réseau physique.

La deuxième exigence du DOJ impose la cession du portefeuille Aruba Instant On de HPE, qui cible les déploiements des petites entreprises avec des points d’accès et des commutateurs gérés dans le cloud. Interrogé sur cette cession, Antonio Neri a tenté d’en minimiser l’impact : « Aruba Instant On est une toute récente activité que nous avons développée au cours des trois dernières années environ, et elle est totalement distincte du reste de la plateforme HP Aruba traditionnelle, ou Aruba Central ». Il ajoute, « Il s’agit d’une offre unique ciblant le segment des PME du marché, et plus particulièrement les petites entreprises; c’est une très petite activité pour nous ».

Un focus sans surprise sur l’IA

Dans la continuité du dernier Discover qui s’est déroulé fin juin à Las Vegas, Rami Rahim a expliqué que la stratégie de HPE Networking allait s’articuler autour de deux volets : l’IA pour les réseaux et la mise en réseau pour l’IA. Le premier point se concentre sur l’IA pour l’exploitation et la gestion du réseau. Cela implique l’utilisation de l’analyse prédictive de Mist pour identifier les problèmes de performance avant qu’ils n’impactent les applications, optimiser automatiquement les environnements et proposer des solutions correctives prescriptives aux problèmes réseau. L’intégration étendra ces capacités au-delà des réseaux sans fil, incluant l’infrastructure filaire, les politiques de sécurité et la corrélation inter-domaines avec les systèmes de calcul et de stockage. « Nous bénéficierons d’une portée et d’une flexibilité accrues, car grâce à la puissance de HPE et de Juniper, nous pourrons désormais répondre à davantage de cas d’utilisation avec davantage d’options de déploiement, et nous bénéficierons ainsi d’une sécurité intégrée renforcée », a déclaré Rami Rahim.

La mise en réseau pour l’IA, elle, répond aux besoins d’infrastructure des charges de travail d’IA elles-mêmes. Cela inclut les structures à large bande passante et à faible latence nécessaires à la communication entre GPU, ainsi que les systèmes intégrés de refroidissement et de distribution d’énergie nécessaires aux clusters d’IA modernes. « La deuxième opportunité de mise en réseau de l’IA est tout aussi prometteuse. Nous construisons des centres de données à grande échelle, des IA factories qui sont extrêmement importantes dans le contexte actuel », a expliqué le dirigeant de HPE Networking. « Ensemble, nous pourrons innover plus rapidement à tous les niveaux de la pile technologique, du silicium aux systèmes en passant par les logiciels, et nous aurons une solution complète. », ajoute-t-il.

Un engagement sur l’open source poursuivi

Interrogé sur la question de l’open source et sur l’implication des deux sociétés dans les communautés, Rami Rahim rappelle que « l’open source a toujours joué un rôle important dans le programme d’innovation de Juniper, et j’en suis sûr qu’il en sera de même pour HPE ». Pour lui, cette approche « a gagné en popularité dans le réseau dans des domaines comme Sonic et Juniper a investi dedans ». L’élargissement du portefeuille va créer des opportunités supplémentaires pour les contributions open source. Le dirigeant s’attend à ce que cela déborde du simple périmètre réseau pour inclure également le calcul et le stockage. HPE n’est pas non plus un novice en matière de réseaux open source. L’entreprise est membre fondateur et contributeur clé de l’Ultra Ethernet Consortium (UEC), qui a récemment publié sa spécification 1.0.

Le fournisseur n’a pas fourni de calendrier d’intégration précis. Rami Rahim et Antonio Neri penchent pour une approche mesurée pour préserver les investissements existants tout en proposant des solutions de migration. « Personne, aucun client, personne ne sera laissé pour compte ; les contrats seront honorés pendant toute la durée de vie des produits », a déclaré Antonio Neri. L’impératif stratégique à venir est d’intégrer les technologies d’IA, cloud-native et réseau.

Bien qu’il existe des chevauchements au sein du portefeuille existant, Rami Rahim a souligné que ces technologies adoptent souvent des approches architecturales différentes pour résoudre les problèmes de réseau. « Ensemble, l’opportunité est de construire une solution capable de répondre à davantage de cas d’usage, qu’ils nécessitent le cloud ou une sécurité intégrée sur site. La combinaison de ces éléments est illimitée pour atteindre des niveaux d’innovation plus élevés », observe-t-il. « Je me sens un peu comme un enfant dans un magasin de bonbons en ce moment, regardant les composants technologiques tout autour de moi, et mon équipe et moi sommes tout simplement super excités de retrousser nos manches et d’obtenir cette feuille de route que tout le monde est bien sûr très intéressé à voir ».

Après l’accord passé avec le Département américain de la justice, HPE a officiellement annoncé l’acquisition de Juniper Networks. Les intégrations vont pouvoir commencer, sous les auspices d’une nouvelle entité réseau, HPE Networking avec un focus assumé sur l’IA.

Il aura fallu 18 mois pour HPE pour enfin boucler l’acquisition de Juniper Networks pour 14 Md$. L’opération avait été annoncée en janvier 2024 et a obtenu le feu vert de plusieurs autorités de régulation. Mais en janvier 2025, le Département américain de la justice a décidé de contester cette opération au motif qu’elle portait atteinte à la concurrence notamment sur le marché du réseau sans-fil. Après, plusieurs mois de négociations, HPE a réussi trouver un accord avec le DoJ autorisant le rachat sous conditions.

Avec cette acquisition finalisée, les travaux d’intégration entre les deux sociétés vont pouvoir commencer. Premier élément visible, la création d’une nouvelle entité baptisée HPE Networking qui va regroupe l’ensemble des activités réseaux. Elle est dirigée par Rami Rahim, ex CEO de Juniper. Ce dernier a expliqué lors d’une conférence de presse, « je peux vous assurer que mon objectif, en tant que dirigeant de cette activité réseau combinée, est de bâtir la meilleure entreprise réseau au monde, fondée sur l’innovation, et nous comptons y parvenir en nous concentrant d’abord sur nos clients et partenaires ».

Minimiser l’impact des concessions faites au DoJ

Au sein de cette entité, les deux marques HPE Aruba et Juniper vont co-exister, car l’entreprise continue d’y voir de la valeur. La refonte du portefeuille est en cours et Rami Rahim demande un peu de temps, « c’est le premier jour, et ce n’est que le début ». Le périmètre du portefeuille est également soumis à l’accord avec le DoJ qui impose deux contraintes à HPE. La première est la concession sous licence des algorithmes d’exploitation d’IA Mist de Juniper à ses concurrents par le biais d’une procédure d’enchères. « Nous avons convenu avec le DOJ d’offrir une licence, par le biais d’une procédure d’enchères, pour des aspects spécifiques de Juniper Mist, à savoir uniquement la partie exploitation d’IA », précise Antonio Neri, CEO de HPE. Cette distinction est techniquement significative. Les concurrents auront accès aux algorithmes de détection d’anomalies et de prédiction des pannes de Mist, mais pas au système d’exploitation réseau sous-jacent, aux couches d’abstraction matérielles ni aux modèles de données spécifiques aux clients qui rendent ces algorithmes efficaces en environnement de production. HPE conserve le contrôle des mécanismes de collecte de données, des pipelines de traitement de la télémétrie et des points d’intégration à l’infrastructure réseau physique.

La deuxième exigence du DOJ impose la cession du portefeuille Aruba Instant On de HPE, qui cible les déploiements des petites entreprises avec des points d’accès et des commutateurs gérés dans le cloud. Interrogé sur cette cession, Antonio Neri a tenté d’en minimiser l’impact : « Aruba Instant On est une toute récente activité que nous avons développée au cours des trois dernières années environ, et elle est totalement distincte du reste de la plateforme HP Aruba traditionnelle, ou Aruba Central ». Il ajoute, « Il s’agit d’une offre unique ciblant le segment des PME du marché, et plus particulièrement les petites entreprises; c’est une très petite activité pour nous ».

Un focus sans surprise sur l’IA

Dans la continuité du dernier Discover qui s’est déroulé fin juin à Las Vegas, Rami Rahim a expliqué que la stratégie de HPE Networking allait s’articuler autour de deux volets : l’IA pour les réseaux et la mise en réseau pour l’IA. Le premier point se concentre sur l’IA pour l’exploitation et la gestion du réseau. Cela implique l’utilisation de l’analyse prédictive de Mist pour identifier les problèmes de performance avant qu’ils n’impactent les applications, optimiser automatiquement les environnements et proposer des solutions correctives prescriptives aux problèmes réseau. L’intégration étendra ces capacités au-delà des réseaux sans fil, incluant l’infrastructure filaire, les politiques de sécurité et la corrélation inter-domaines avec les systèmes de calcul et de stockage. « Nous bénéficierons d’une portée et d’une flexibilité accrues, car grâce à la puissance de HPE et de Juniper, nous pourrons désormais répondre à davantage de cas d’utilisation avec davantage d’options de déploiement, et nous bénéficierons ainsi d’une sécurité intégrée renforcée », a déclaré Rami Rahim.

La mise en réseau pour l’IA, elle, répond aux besoins d’infrastructure des charges de travail d’IA elles-mêmes. Cela inclut les structures à large bande passante et à faible latence nécessaires à la communication entre GPU, ainsi que les systèmes intégrés de refroidissement et de distribution d’énergie nécessaires aux clusters d’IA modernes. « La deuxième opportunité de mise en réseau de l’IA est tout aussi prometteuse. Nous construisons des centres de données à grande échelle, des IA factories qui sont extrêmement importantes dans le contexte actuel », a expliqué le dirigeant de HPE Networking. « Ensemble, nous pourrons innover plus rapidement à tous les niveaux de la pile technologique, du silicium aux systèmes en passant par les logiciels, et nous aurons une solution complète. », ajoute-t-il.

Un engagement sur l’open source poursuivi

Interrogé sur la question de l’open source et sur l’implication des deux sociétés dans les communautés, Rami Rahim rappelle que « l’open source a toujours joué un rôle important dans le programme d’innovation de Juniper, et j’en suis sûr qu’il en sera de même pour HPE ». Pour lui, cette approche « a gagné en popularité dans le réseau dans des domaines comme Sonic et Juniper a investi dedans ». L’élargissement du portefeuille va créer des opportunités supplémentaires pour les contributions open source. Le dirigeant s’attend à ce que cela déborde du simple périmètre réseau pour inclure également le calcul et le stockage. HPE n’est pas non plus un novice en matière de réseaux open source. L’entreprise est membre fondateur et contributeur clé de l’Ultra Ethernet Consortium (UEC), qui a récemment publié sa spécification 1.0.

Le fournisseur n’a pas fourni de calendrier d’intégration précis. Rami Rahim et Antonio Neri penchent pour une approche mesurée pour préserver les investissements existants tout en proposant des solutions de migration. « Personne, aucun client, personne ne sera laissé pour compte ; les contrats seront honorés pendant toute la durée de vie des produits », a déclaré Antonio Neri. L’impératif stratégique à venir est d’intégrer les technologies d’IA, cloud-native et réseau.

Bien qu’il existe des chevauchements au sein du portefeuille existant, Rami Rahim a souligné que ces technologies adoptent souvent des approches architecturales différentes pour résoudre les problèmes de réseau. « Ensemble, l’opportunité est de construire une solution capable de répondre à davantage de cas d’usage, qu’ils nécessitent le cloud ou une sécurité intégrée sur site. La combinaison de ces éléments est illimitée pour atteindre des niveaux d’innovation plus élevés », observe-t-il. « Je me sens un peu comme un enfant dans un magasin de bonbons en ce moment, regardant les composants technologiques tout autour de moi, et mon équipe et moi sommes tout simplement super excités de retrousser nos manches et d’obtenir cette feuille de route que tout le monde est bien sûr très intéressé à voir ».

Dans un marché sous tension face aux risques posés par les grands modèles de langage (LLM), les RSSI doivent garder le cap. Voici quatre principes de sécurité permettant d’encadrer les opérations métiers exploitant l’IA générative.

Des risques liés aux applications d’IA, tels que l’empoisonnement des données d’entraînement et les hallucinations, à la sécurité basée sur l’IA, en passant par les deep fakes, le manque de précaution des utilisateurs et les nouvelles techniques d’attaque générées par l’IA, les RSSI font face à toute une série de nouvelles problématiques liées au regain d’intérêt pour l’IA depuis la vague apportée par la GenAI.Par exemple, pendant et après la conférence RSA d’avril 2025, les participants ont vivement dénoncé la surcharge d’informations visant à provoquer un sentiment d’incertitude ou de panique (FUD, fear, uncertainty and doubt) liées à l’IA, en particulier de la part des fournisseurs. L’un d’entre eux, Tony Martin-Vegue, ingénieur risques chez Netflix, explique, lors d’un entretien après la conférence RSA, qu’il est impossible d’arrêter le train de l’IA, mais qu’il existait des moyens de couper court au battage médiatique et d’appliquer des contrôles de base là où ils étaient les plus importants.Tout d’abord, dit-il, il faut se concentrer sur les raisons pour lesquelles l’organisation déploie l’IA. « Selon moi, il y a un risque à ne pas utiliser l’IA, même si ses capacités font l’objet de beaucoup de battage et de promesses. Cela dit, les organisations qui n’utilisent pas l’IA resteront à la traîne. Mais ce sont bien les risques liés à l’utilisation de l’IA qui sont la source de toutes les rumeurs ».En ce qui concerne l’application des contrôles, il conseille d’adapter les processus suivis lors de l’adoption du cloud, du BYOD et d’autres technologies. En commençant, évidemment, par la compréhension de où et de comment l’IA est utilisée, par qui et dans quel but. Ensuite, il s’agit de se concentrer sur la sécurisation des données que les employés partagent avec les outils.1. Apprenez à connaître votre IA« L’IA est un changement fondamental qui va imprégner la société d’une manière qui pourrait même éclipser Internet. Mais ce changement se produit à un rythme si rapide que la capacité à identifier le halo qui entoure cette technologie est difficile à comprendre pour beaucoup de gens », explique Rob T. Lee, responsable de la recherche sur l’IA et les menaces émergentes à l’institut SANS, une entreprise américaine spécialisée dans l’information sur la cyber et la formation. « Aujourd’hui, chaque partie de l’organisation va utiliser l’IA sous une forme ou une autre. Vous avez besoin d’un moyen de réduire drastiquement le risque pour accompagner les mises en oeuvre. Cela signifie qu’il faut voir où les gens l’utilisent, et dans quels cas d’usage métier. Et ce, à l’échelle de l’organisation. »Rob T. Lee, qui aide la SANS à élaborer une liste de directives de sécurité sur l’IA faisant l’objet d’un consensus au sein de la communauté, consacre 30 minutes par jour à l’utilisation d’agents d’IA avancés à diverses fins professionnelles et encourage d’autres responsables de la cybersécurité et dirigeants à faire de même. En effet, une fois familiarisés avec ces outils et leurs capacités, ils peuvent plus simplement s’atteler à la sélection des contrôles.À titre d’exemple, Robert T. Lee cite les laboratoires Moderna, qui ont annoncé, en mai 2025 fusionner les ressources humaines et l’informatique sous une nouvelle direction, celle du directeur RH et du numérique. « Le travail ne concerne plus seulement les humains, à la fois ceux-ci et des agents d’IA, explique Rob T. Lee. Cela nécessite que les RH et l’informatique collaborent d’une nouvelle manière ».2. Revoir les fondamentaux de la sécuritéCe n’est pas parce que les dernières générations d’IA n’ont que quelques années que les fondamentaux actuels de la sécurité ne comptent plus. Chris Hetner, conseiller en matière de risques cyber auprès de la National Association of Corporate Directors (NACD), une association représentant les membres des conseils d’administration, explique : « le secteur de la cybersécurité fonctionne souvent comme une chambre d’écho et il est calibré pour être très réactif. La chambre d’écho alimente la machine en parlant d’IA agentique, de dérives de l’IA et d’autres risques. Et toute une nouvelle série de fournisseurs vient alors submerger le portefeuille du RSSI, explique-t-il. L’IA n’est qu’une extension de la technologie existante. C’est un nouveau point focal sur lequel nous pouvons nous recentrer sur l’essentiel. »Lorsque Chris Hetner parle de l’essentiel, il souligne l’importance de comprendre le profil de l’entreprise, de repérer les menaces dans le paysage numérique et de discerner les interconnexions entre les départements de l’organisation. À partir de là, les responsables de la sécurité doivent évaluer les répercussions opérationnelles, juridiques, réglementaires et financières qui pourraient survenir en cas de violation ou d’exposition. Ils doivent ensuite regrouper ces informations dans un profil de risque complet qu’ils présenteront à l’équipe de direction et au conseil d’administration afin qu’ils puissent déterminer les risques qu’ils sont prêts à accepter, ceux qu’il faudra atténuer et ceux qui doivent être transférés.3. Protéger les donnéesÉtant donné que l’IA est utilisée pour analyser des données financières, commerciales, RH, de développement de produits, de relations avec les clients et autres informations sensibles, Tony Martin-Vegue estime que la protection des données devrait figurer en tête de la liste des contrôles spécifiques de tout gestionnaire des risques. Cela revient à savoir comment les employés utilisent l’IA, pour quelles fonctions et quel type de données ils introduisent dans l’application basée sur l’IA. Ou, comme l’explique un mémo commun de mai 2025 sur la sécurité des données de l’IA, rédigé par les agences de sécurité d’Australie, de Nouvelle-Zélande, du Royaume-Uni et des États-Unis : sachez quelles sont vos données, où elles se trouvent et comment elles sont traitées.C’est évidemment plus facile à dire qu’à faire, étant donné que la plupart des organisations ne savent pas où se trouvent toutes leurs données sensibles, et encore moins comment les contrôler, selon de multiples enquêtes. Pourtant, comme pour les autres nouvelles technologies, la protection des données utilisées dans les LLM renvoie à l’éducation des utilisateurs et à la gouvernance des données, y compris les contrôles traditionnels tels que les revues de données et le chiffrement.« Vos utilisateurs peuvent ne pas comprendre les meilleures façons d’utiliser ces solutions d’IA, de sorte que les responsables de la cybersécurité et de la gouvernance doivent aider à concevoir des cas d’usage et des déploiements qui leur conviennent et qui soient conformes aux préconisations de votre équipe de gestion des risques », résume Diana Kelley, analyste en cybersécurité et RSSI chez Protect AI.4. Protéger le modèleDiana Kelley souligne les différences de risque entre les divers modèles d’adoption et de déploiement de l’IA. Les versions gratuites et publiques de l’IA, comme ChatGPT, où l’utilisateur insère des données dans une fenêtre de prompt sur le web, offrent le moins de contrôle sur ce qu’il advient des données que les employés partagent. Le fait de payer pour la version professionnelle et d’intégrer l’IA en interne permet aux entreprises de mieux contrôler cet aspect, mais les licences d’entreprise et les coûts d’auto-hébergement sont souvent hors de portée des petites entreprises. Une autre option consiste à exécuter des modèles de fondation sur des plateformes cloud managées comme Amazon Bedrock et d’autres services cloud configurés de manière sécurisée, où les données sont traitées et analysées dans l’environnement protégé du titulaire du compte.« Il n’y a là aucune magie, même si l’IA est souvent présentée de cette manière. Il s’agit de mathématiques. Ce sont des logiciels. Nous savons comment protéger les logiciels. Cependant, l’IA est un nouveau type de logiciel qui nécessite de nouveaux types d’approches et outils de sécurité, ajoute Diana Kelley. Un fichier modèle est un type de fichier différent, il faut donc un scanner spécialement conçu pour sa structure unique. »Un fichier modèle est un ensemble de poids et de biais, et lorsqu’il est désérialisé, les organisations exécutent un code non fiable. Ce qui fait des modèles une cible privilégiée pour les attaques par sérialisation de modèle (MSA pour Model serialization attack), menées par des cybercriminels désireux de manipuler les systèmes cibles.Outre les attaques par MSA, les modèles d’IA, en particulier ceux qui proviennent de sources ouvertes, peuvent être victimes d’attaques de typosquatting qui imitent des noms de fichiers fiables mais renferment du code malveillant. Ils sont également susceptibles de contenir des portes dérobées neuronales et d’autres vulnérabilités de type supply chain. C’est pourquoi Diana Kelley recommande d’analyser les modèles d’IA avant d’en approuver le déploiement et le développement.Étant donné que les LLM qui soutiennent les applications d’IA sont différents des logiciels traditionnels, les besoins qu’ins font naître en matière d’analyse et de monitoring a fait émerger une multitude de solutions spécialisées. Mais des signes indiquent que ce marché se contracte, car les fournisseurs de sécurité traditionnels commencent à intégrer des outils spécialisés, comme c’est le cas avec l’acquisition en cours de Protect AI par Palo Alto Network. Comme l’indique Diana Kelley : « oui, il y a beaucoup de travail, mais cela ne doit effrayer les RSSI et les organisations. Nul besoin de croire le FUD. »

Une mauvaise configuration par défaut dans MCP Inspector d’Anthropic ouvre la voie à de l’exécution de commandes arbitraires à distance. Avec à la clé de sérieux risques pour les développeurs travaillant sur des projets d’intelligence artificielle.

Un bogue critique d’exécution de code à distance (RCE) dans Model Context Protocol Inspector d’Anthropic pourrait permettre à des cyberattaquants d’exécuter des commandes arbitraires sur les postes de travail des développeurs lorsqu’ils visitent un site web malveillant. Cet outil aide les codeurs à tester et à déboguer les interactions des agents d’intelligence artificielle en utilisant MCP (Model Context Protocol) d’Anthropic, un standard ouvert qui permet aux agents d’intelligence artificielle de communiquer avec des outils et des sources de données externes.

La vulnérabilité critique affecte tous les déploiements par défaut qui se lient à toutes les interfaces réseau. Cela ouvre la porte à un large éventail d’attaques, y compris la falsification des requêtes intersites (CSRF), l’exécution de code à distance (RCE) et l’accès non autorisé. « Avec l’exécution de code sur le terminal d’un développeur, les attaquants peuvent voler des données, installer des portes dérobées, se déplacer latéralement à travers les réseaux, ce qui met en évidence des risques sérieux pour les équipes d’IA, les projets open-source et les entreprises qui s’appuient sur MCP », a déclaré Avi Lumelsky, chercheur en sécurité chez Oligo security, la société de cybersécurité qui a découvert et signalé la vulnérabilité à Anthropic, dans un billet de blog. Anthropic a corrigé la vulnérabilité (CVE-2025-49596 au score CVSS de 9.4) dans la version 0.14.1 d’Inspector MCP.

Une version non sécurisée d’Inspector MCP dans des projets open source

Pour soutenir l’écosystème MCP, les développeurs s’appuient sur des outils tels que MCP Inspector qui offrent une visibilité en temps réel des flux de messages et des comportements des agents régis par le protocole. « L’outil MCP Inspector est lancé par défaut lorsque la commande mcp dev est exécutée », explique M. Lumelsky. Il agit comme un serveur HTTP qui écoute les connexions, avec une configuration par défaut qui n’inclut pas de mesures de sécurité suffisantes comme l’authentification ou le cryptage. Cette mauvaise configuration introduit une surface d’attaque majeure, permettant à n’importe qui sur le réseau local, ou même sur l’Internet public, d’accéder potentiellement au serveur exposé et de l’exploiter.

Inspecor MCP est un outil essentiel pour les codeurs qui travaillent avec des systèmes d’IA complexes, y compris des acteurs majeurs comme Microsoft et Google pour leurs environnements IA et cloud. Une vulnérabilité affectant les déploiements open source pose de sérieux risques pour ces systèmes d’entreprise, a ajouté M. Lumelsky. À mesure que l’adoption des MCP s’accélère, des failles de sécurité commencent à apparaître, comme le bogue dans le connecteur MCP AI d’Asana qui a exposé les données de l’entreprise via des systèmes hôtes. L’incident, découvert un mois seulement après le lancement, souligne la nécessité de réévaluer le protocole expérimental avant de le déployer à plus grande échelle dans les entreprises.

Un vecteur d’attaque combinant deux vulnérabiltés

Oligo a démontré que le vecteur d’attaque combine deux failles indépendantes. Les attaquants peuvent enchaîner la faille « 0.0.0.0-day » du navigateur, qui permet aux pages web d’envoyer des requêtes à l’adresse 0.0.0.0 que les navigateurs traitent comme l’hôte local, à une attaque de type CSRF exploitant le point d’extrémité vulnérable « /sse » du proxy Inspector qui accepte des commandes via des chaînes de requêtes sur stdio. L’attaque CSRF peut se transformer en RCE lorsque l’attaquant utilise la faille pour envoyer des requêtes malveillantes. « Lorsqu’un attaquant peut créer une requête à l’inspecteur MCP à partir d’un contexte JavaScript du domaine public, cette requête peut déclencher des commandes arbitraires sur l’ordinateur de la victime, ce qui lui permet d’en prendre le contrôle », a déclaré M. Lumelsky.

L’étude d’Oligo souligne que les configurations par défaut peuvent exposer involontairement les serveurs MCP à des attaques, ce qui pourrait permettre aux acteurs de la menace de s’introduire dans les terminaux des développeurs. Alors que le jour 0.0.0.0 n’a toujours pas été corrigé dans Chromium et Firefox un an après sa découverte, la faille MCP a été rapidement corrigée par Anthropic, en raison de sa gravité critique. Un avis du Nist (référentiel américain des failles) invite les utilisateurs à mettre à jour immédiatement toutes les versions vulnérables (inférieures à 0.14.1).

En rachetant l’opérateur télécom Everlink, le groupe Inherent ajoute une agence de plus à son maillage déjà conséquent, c’est sa deuxième acquisition d’un opérateur depuis le début de l’année.

Soutenue par la société de capital investissement Keensight Capital, l’acquisition de l’opérateur Everlink par le groupe Inherent permet à ce dernier de se renforcer dans la région Île-de-France auprès des TPE/PME. Fondé en 2014, l’opérateur télécom B2B Everlink propose un large panel de services de télécommunications, cloud et IT à plus de 500 clients. Ce rachat intervient deux mois après celui de Conexio Telecom, un autre opérateur télécom B2B, ciblant toujours sur les petites et moyennes structures mais qui est situé en Occitanie. Toutes ces acquisitions permettent aujourd’hui au groupe Inherent de disposer de plus de 45 agences à travers la France. Pour Pierre-Jean Beylier, président du groupe Inherent, ces rachats s’inscrivent dans la continuité de la stratégie du groupe, à savoir de proposer un guichet unique, en alliant proximité et qualité de service.Investissement dans la cybersécuritéHormis les télécoms, le groupe s’est aussi renforcé dans la cybersécurité, au début de cette année, il avait racheté devensys cybersecurity (ex Cyberprotect), une société montpellieraine qui dispose entre autres de trois équipes SOC (Security Operations Center) disponibles 24/7, basées à Montpellier, Lyon et Fort-de-France. A noter que devensys cybersecurity fait partie des trois marques du groupe avec Adista et l’agrégateur opérateur Unyc axé sur l’indirect. Aujourd’hui, le chiffre d’affaires du groupe Inherent dépasse les 300 M€ pour plus de 1 300 collaborateurs, il vise les 500 millions d’euros à horizon 2027.

Malgré la mise en place de correctifs, la faille Citrix Bleed 2 semble être exploitée par les cybercriminels. Des experts appellent les entreprises à corriger en urgence leur système Netscaler ADC et Gateway.

Les utilisateurs de Citrix sont encore dans le collimateur : une autre faille de lecture ou « out-of-bounds read », rappelant le fameux « Citrix Bleed », a fait surface et des signes indiquent déjà une exploitation active. Comme le décrit un récent avis de l’éditeur, la vulnérabilité, référencée CVE-2025-5777 et baptisée « Citrix Bleed 2 » par les chercheurs, résulte d’un problème de validation d’entrée insuffisante sur les dispositifs NetScaler ADC et Gateway qui conduit à une lecture hors cadre de la mémoire. Selon une étude de la société de cybersécurité ReliaQuest, la faille pourrait déjà permettre aux attaquants de détourner les sessions des utilisateurs et de contourner l’authentification MFA.

« Même si aucune exploitation publique de la vulnérabilité CVE-2025-5777 n’a été signalée, ReliaQuest estime assez probable l’exploitation active de cette vulnérabilité par les attaquants pour obtenir un accès initial à des environnements ciblés », ont déclaré les chercheurs dans un blog. Ils invitent les clients de Citrix à appliquer immédiatement des correctifs aux systèmes affectés et à suivre les étapes supplémentaires nécessaires décrites par le fournisseur pour se protéger contre une exploitation en cours.

Le vol de jetons de session ciblé

La vulnérabilité, qualifiée de critique avec un score CVSS 9.3 sur 10, est liée à une validation d’entrée insuffisante, ce qui donne la capacité aux attaquants d’effectuer un dépassement en lecture de mémoire sur les périphériques NetScaler configurés en tant que passerelle ou serveurs virtuels d’authentification, d’autorisation et de traçabilité (Authentication, Authorization, and Accounting, AAA). La faille reflète celle de déni de service (DoS) originale Citrix Bleed en ce qu’elle permet une fuite de mémoire, comme c’était le cas auparavant avec les simples requêtes HTTP.

Contrairement aux tactiques traditionnelles de vol de cookies de session, qui incluent les attaques de type cross-site scripting (XSS) et man-in-the-middle (MITM), Citrix Bleed 2 cible les jetons de session, souvent utilisés pour les API et l’authentification persistante. Ces tokens peuvent être volés et réutilisés pour contourner l’authentification MFA et maintenir l’accès, même après que les utilisateurs légitimes se sont déconnectés. Le célèbre chercheur britannique en cybersécurité et analyste des menaces Kevin Beaumont a comparé cette faille au « retour de Kanye West sur Twitter », le même chaos mais en plus bruyant. Citrix a publié le 17 juin des correctifs pour les versions 14.1, 13.1 et les versions FIPS/NDcPP équivalentes. Les versions 12.1 et 13.0 sont en fin de vie et une mise à jour est obligatoire.

Des indices d’exploitation de la faille

Les chercheurs de ReliaQuest ont déclaré que, dans plusieurs incidents, les attaquants ont été vus en train de détourner des sessions Web Citrix actives et de contourner l’authentification multifactorielle (MFA) sans avoir besoin des informations d’identification de l’utilisateur. La recherche a également mis en évidence « la réutilisation de sessions sur plusieurs IP, y compris des combinaisons d’IP attendues et suspectes ». Dans les environnements compromis, les attaquants ont procédé à une reconnaissance post-authentification, en émettant des requêtes LDAP (Lightweight Directory Access Protocol) et en exécutant des outils comme ADExplorer64.exe pour cartographier les structures Active Directory.

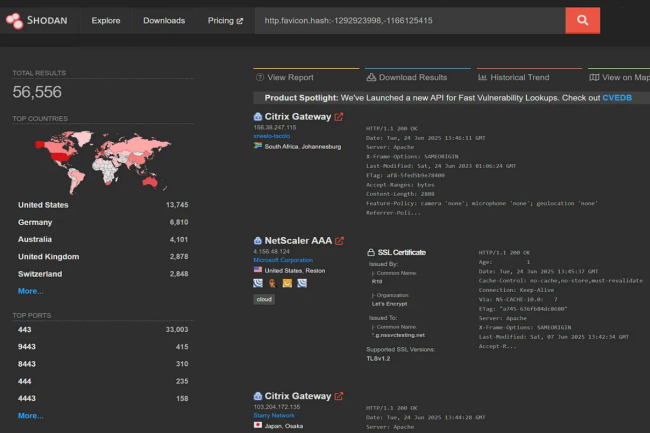

« De multiples instances de l’outil « ADExplorer64.exe » ont été observées dans l’environnement, interrogeant les groupes et les autorisations au niveau du domaine et se connectant à plusieurs contrôleurs de domaine », ont ajouté les experts. De plus, de nombreuses sessions malveillantes provenaient de services VPN grand public et d’adresses IP de centres de données, ce qui a permis de masquer davantage l’identité des attaquants tout en maintenant la persistance à l’intérieur des réseaux. Outre l’application des correctifs, il est également conseillé aux entreprises d’auditer l’exposition externe à NetScaler à l’aide d’outils comme Shodan et de mettre en place des ACL ou des restrictions d’accès au réseau jusqu’à ce que les correctifs soient entièrement appliqués. Une fois les patchs appliqués avec succès, Citrix conseille aux administrateurs de mettre fin à toutes les sessions ICA et PCoIP actives pour une ajouter une couche de protection supplémentaire.

Rapprochement entre Kardham Digital et Wallix pour le lancement de Cyber Building Guard, une offre commune de SOC dédiée aux bâtiments connectés.

L’ESN Kardham Digital, filiale numérique du groupe d’immobilier Kardham s’associe à l’éditeur Wallix, le spécialiste de la protection des identités et des accès pour créer un SOC (Security Operation Center) dédié à la protection des bâtiments tertiaires. Nommé Cyber Building Guard, ce SOC garantit aux propriétaires, aux gestionnaires et plus généralement aux occupants de bâtiments qu’ils puissent maintenir un niveau élevé de sécurité contre toute attaque de déni de service, cryptolocker ou piratage des éléments actifs du bâtiment comme les objets connectés. C’est d’autant plus important que certains de ces acteurs sont concernés par des exigences de mise en conformité avec les réglementations NIS2, DORA et REC (Résilience des infrastructures critiques), mais aussi à tous ceux qui ont besoin d’interconnecter leurs bâtiments connectés avec des solutions d’optimisation énergétique dans le cadre du Décret BACS (Building automation et control systems), ainsi qu’à tous les bailleurs et propriétaires qui souhaitent faire évoluer leur patrimoine immobilier dans un environnement de confiance.

Des solutions complémentaires

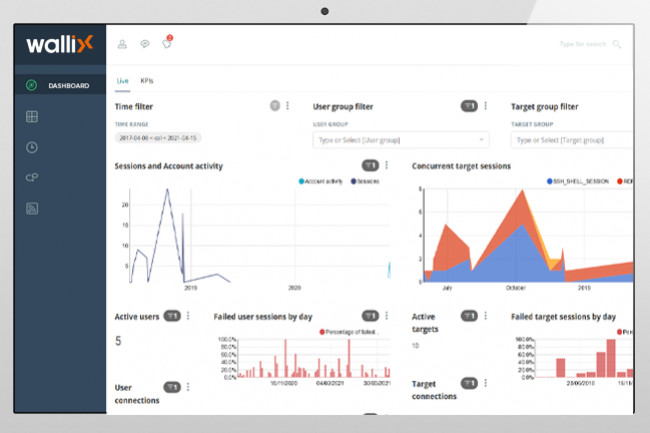

Chacun des deux associés a mis sa pierre à l’édifice dans la construction de cette offre. Ainsi, Kardham Digital s’appuie sur ses deux logiciels complémentaires pour assurer une hypervision complète du bâtiment à savoir KD Convergence, un middleware qui centralise et unifie les données issues des équipements IoT et KD Cockpit, sa plateforme de supervision qui apporte une vision d’ensemble du fonctionnement du bâtiment, une contextualisation des alertes et incidents, et qui permet de piloter en temps réel les opérations.

Wallix, de son côté, apporte sa solution PAM (Privileged Access Management), conçue pour sécuriser les accès numériques, les données sensibles des équipements et les systèmes critiques des bâtiments. Chaque intervention, réalisée par un prestataire ou un exploitant, sur site ou à distance, s’effectue dans un environnement numérique strictement contrôlé : les connexions sont ciblées, les mots de passe sécurisés, et chaque action tracée.

De nombreux chercheurs en cybersécurité et le FBI ont averti que le célèbre groupe de pirates informatiques Scattered Spider cible désormais le secteur de l’aviation avec des tactiques d’ingénierie sociale avancées. La situation génère de l’inquiétude en cette période de vacances d’été propice aux voyages.

Menaces sur le ciel américain après la découverte par plusieurs experts en cybersécurité du recentrage des activités du groupe de cybercriminel Scattered Spider vers les compagnies aériennes. Il est suspecté d’avoir mené des attaques contre Hawaiian Airlines et WestJet Airlines. « Unit 42 a constaté que Muddled Libra (également connu sous le nom de Scattered Spider) ciblait l’industrie de l’aviation », a déclaré Sam Rubin, vice-président senior de Unit 42 de Palo Alto Networks,…

Il vous reste 94% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

Pour gagner en résilience, en particulier en cas de cyberattaque, l’industriel allemand de chimie de spécialité Alzchem a mis en place un environnement de sauvegarde et de restauration de ses SI on-premise et dans le cloud. La solution répond aux nombreuses exigences de flexibilité et d’interopérabilité de l’entreprise.

Le groupe de chimie bavarois Alzchem s’est mis en quête l’an dernier d’une solution de sauvegarde pour ses SI on-premise, mais aussi dans le cloud, en particulier pour des raisons de résilience fonctionnelle et cyber. Il s’agissait pour l’industriel de remplacer son système en place, en l’occurrence Tivoli Storage Manager (TSM) d’IBM.L’entreprise fabrique des produits de chimie de spécialité pour l’agriculture et pour l’alimentation animale et humaine. Avec un CA 2024 supérieur à 554 M€, il emploie environ 1700 personnes sur quatre sites de production, en Allemagne et en Suède, ainsi que dans trois centres de distribution au Royaume-Uni, en Chine et aux États-Unis.Certification SAP S/4 Hana et compatibilité avec NetappL’industriel a cherché un outil flexible, mais surtout certifié SAP S/4 Hana, disposant d’interfaces ouvertes pour les services Web par exemple ou encore compatible avec les environnements de stockage de Netapp et avec VMware ESX. Enfin, comme l’explique Alzhem, ses chefs de projet réclamaient un logiciel sur site avec des licences et une ligne directe avec le fabricant.Alzchem a confié le projet à un binôme constitué de son responsable serveur et opérations et de son expert technique sur ce même périmètre. Ils ont travaillé avec un prestataire spécialisé dans ce type d’environnement, Data Management Professionals (DMP), qui a eu la charge de trouver l’outil répondant au cahier des charges. Il a finalement recommandé Commvault Backup & Recovery, en particulier parce que cet éditeur dispose d’un large portefeuille d’outils de sauvegarde et de restauration de données, de cloud, de virtualisation, d’archivage et de synchronisation de fichiers. DMP a fourni les licences Commvault pour les applications de messagerie et le cloud, les machines virtuelles et les bases de données et a accompagné Alzchem dans le déploiement et la mise en service du système, ainsi que dans la formation des utilisateurs.Une restauration de données dénuée de logiciels malveillantsLa solution prend en charge la sauvegarde et la restauration automatiques d’environnements informatiques complets, des applications autonomes et des machines virtuelles de l’entreprise, quel que soit le mode de stockage des données : on-premise ou dans un ou plusieurs cloud. DMP a également ajusté le dimensionnement du matériel pour garantir une utilisation optimale de la batterie de serveurs VMware ESX par les agents de la solution de sauvegarde.Joachim Rager, l’expert technique serveurs et opérations d’Alzchem en charge du projet, insiste justement sur la nécessité, dans ce type de démarche, avec une solution aussi étendue, de se familiariser avec les fonctions et les exigences de l’outil : « Il ne s’agit pas seulement d’un système de sauvegarde, précise-t-il dans un communiqué, mais aussi d’un système de gestion des données qui doit être suivi de près. C’est pourquoi il est essentiel de planifier minutieusement les ressources matérielles et la formation nécessaires ». Aujourd’hui, Alzchem dispose d’une protection proactive et sécurisée de ses données et est assuré que les processus de restauration ne restaurent que celles qui sont exemptes de logiciels malveillants.

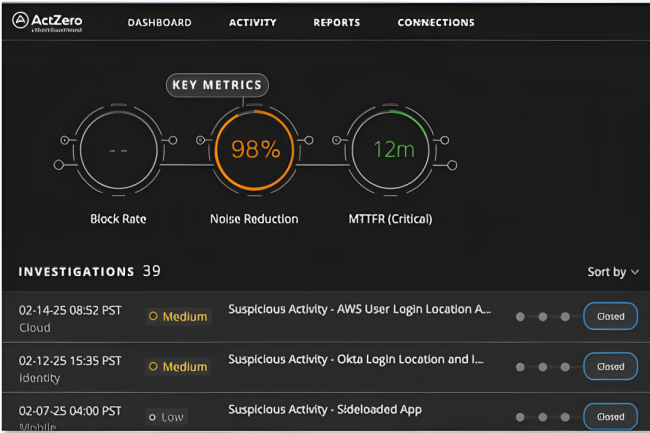

Suite au rachat de la société américaine Actzero, Watchguard a enrichi son offre SOC en la baptisant Total MDR. Celle-ci a été pensé pour les MSP avec son interface unifiée et automatisée grâce à l’IA.

Hérité du rachat d’Actzero en janvier 2025, Total MDR est désormais le service SOC de Watchguard alimenté par l’IA et orienté MSP. Cette solution fournit donc une sécurité globale 24h/7j pour les entreprises couvrant les endpoints, les identités, les réseaux et les applications cloud tierces. Quant aux partenaires MSP, ils bénéficient d’une console unique pour détecter les attaques complexes et pour y répondre rapidement. Ils ont aussi accès à un accompagnement sur mesure via des technical account managers et d’un programme d’onboarding, surtout pensé les partenaires qui adressent les PME. Watchguard promet également un tarif transparent, sans coûts cachés.

Rapidité dans la détection

Le rôle de l’IA, intégrée dans la solution, est d’automatiser les processus permettant surtout de réduire les délais, par exemple, l’éditeur avance un temps moyen de détection et de réponse réduit à 6 minutes, contre 30 minutes en moyenne dans l’industrie et annonce moins d’un faux positif par mois, contre plus de 250 en moyenne dans le secteur. Total MDR affiche d’ailleurs un faible taux de « bruit », selon le benchmark Mitre 2024. A noter que sa plateforme est ouverte donc prête à supporter davantage d’outils et technologies tierces, l’objectif étant toujours d’étendre la détection et la réponse à un panel de menaces encore plus large.

Le MSP Eiffie déjà conquis

D’ores et déjà, certains partenaires MSP se montrent très satisfaits de l’usage de ce nouveau SOC à l’image de Eiffie et de son fondateur Julien Perret : « Le paysage des menaces ne cesse de se complexifier, avec des attaques de plus en plus rapides et ciblées. Les offres SOC traditionnelles ne sont pas adaptées à la réalité économique des PME. WatchGuard Total MDR est essentiel pour nos clients car c’est un SOC virtuel personnalisé, qui fournit en continu des insights sur les menaces, du conseil stratégique et un support précieux, nous permettant de rester proactif, à un coût optimisé ».