Réduction de la durée de vie des certificats, prolifération des identités de machines, cryptographie post-quantique : une marée de problèmes touchant aux certificats menace de submerger les DSI.

Pour un DSI, considérer les certificats et les identités des machines comme de simples rouages est tentant : on parle certes de fonctions critiques, mais purement techniques et laissées entre les mains des praticiens. « Les infrastructures à clefs publiques (PKI) et la cryptographie ont toujours été vues comme des technologies de bas niveau, de l’ombre. Même si elles sont fondamentales pour la sécurité, les DSI n’y ont probablement pas prêté beaucoup d’attention », résume Christian Simko, vice-président du marketing produit chez AppViewX, plateforme d’automatisation Low Code. « Aujourd’hui, elles sont beaucoup plus sous les feux de la rampe, car la gestion des identités des machines, la gestion des identités non humaines et la cryptographie post-quantique sont autant de questions d’actualité qui vont avoir un impact sur la sécurité et la conformité des organisations. Or, lorsque la conformité commence à s’impliquer sur un sujet, le DSI commence lui aussi à s’en préoccuper un peu plus. »Des normes encore ignorées dans le courrielOr, en la matière, la plupart des entreprises accusent un retard flagrant. Vous avez peut-être remarqué que les courriels de votre boîte de réception sont étiquetés comme provenant non seulement de l’extérieur de votre organisation, mais aussi d’expéditeurs non vérifiés. Cela fait partie d’un effort visant à améliorer l’adoption de normes sur la réputation des courriels, qui reposent sur des certificats pour l’authentification. Des normes que la majorité des organisations ont tout simplement ignorées, même si les menaces liées au courrier électronique sont en augmentation rapide. « Il devrait s’agir d’une bonne pratique, mais vous seriez surpris de voir le nombre d’organisations qui sont à la traîne et qui ne l’ont pas encore mise en oeuvre de manière complète et efficace », dit Christian Simko.En début d’année, Google et Yahoo, bientôt rejoints par Microsoft, ont commencé à exiger de toute organisation ayant envoyé 5 000 messages ou plus en une seule journée qu’elle utilise l’authentification SPF, DKIM et DMARC, ce qui affecte les réinitialisations des mots de passe, les notifications d’expédition, les courriels de reçu d’achat envoyés aux consommateurs et les newsletters et autres messages marketing envoyés directement ou par l’intermédiaire de fournisseurs de messagerie électronique comme Mailchimp.Les entreprises doivent non seulement s’assurer que DMARC est correctement mis en oeuvre sur tous leurs domaines et sous-domaines – même si elles ne les utilisent pas pour envoyer des courriels, elles doivent se protéger contre un pirate qui les usurperait -, mais elles doivent également surveiller les rapports de courriels rejetés en raison d’échecs DMARC. Les DSI devront consacrer du temps et des ressources à ce sujet, soit en interne, soit par l’intermédiaire d’un fournisseur de services de sécurité pour le mail. Ils devraient également envisager de marquer et de rejeter les courriels entrants ne répondant pas à ces normes de réputation.Cette mesure va réduire considérablement le nombre de courriels d’hameçonnage, mais elle risque aussi d’avoir un impact sur les communications légitimes provenant d’autres organisations qui n’ont pas encore adopté les normes de réputation en question. Ce qui en fait une décision stratégique plutôt que technique.L’explosion des identités des machinesMais, en réalité, les certificats pour le courrier électronique ne représentent que la partie émergée de l’iceberg. Grâce à l’adoption d’infrastructures complexes telles que l’IoT, les tokens JSON et Kubernetes, entre autres, les organisations utilisent déjà des centaines de milliers d’identités de machines sécurisées par des certificats SSL/TLS, avec des durées de vie allant de plusieurs années à quelques minutes. Une seule machine physique peut exécuter des centaines de workloads éphémères.Or, ces certificats sont souvent mal gérés et mal sécurisés, même par des organisations dans des secteurs réglementés comme la finance. Erik Wahlstrom, vice-président et analyste au sein du cabinet Gartner, estime que le nombre d’identités de machines dépasse déjà celui des identités des humains d’un ordre de grandeur. Et ce total ne cesse de croître, en particulier avec l’adoption d’outils d’IA qui nécessitent des identifiants à la fois pour les systèmes auxquels ils accèdent et pour les humains au nom desquels ils agissent. Une étude de Coleman Parkes pour le fournisseur d’automatisation Venafi prévoit que les organisations de plus de 10 000 employés devront gérer jusqu’à 1,3 million d’identités et de certificats de machines d’ici à 2025.Avec de tels chiffres, les scripts manuels, les tableaux Excel et les automatismes maison ne sont plus adaptés, d’autant plus que la plupart des entreprises n’ont qu’une faible visibilité sur le nombre de certificats et d’identités de machines qu’elles utilisent déjà. « Lorsque les gens feront un inventaire complet sur ce sujet, ils seront choqués par la rapidité avec laquelle ce nombre augmente », souligne Geoff Cairns, analyste principal chez Forrester Research. Le fait que ces workloads soient exploités dans des environnements hybrides ou multicloud ne fait que complexifier les choses.Les frontières organisationnelles bousculéesLe domaine manque de maturité, abonde Matt Caulfield, vice-président produits chez Duo, filiale de sécurité de Cisco. « Aucun répertoire d’identités machines standard n’existe » souligne-t-il, relevant que les équipes IT font face à un ensemble confus de protocoles d’authentification et d’autorisations machine à machine (M2M).Autre problème : ces questions dépassent les frontières organisationnelles de la gestion d’identité traditionnelle. Les équipes en charge de l’infrastructure à clé publique existante, comme Active Directory, ne sont souvent pas impliquées dans les initiatives qui nécessitent des certificats et des identités dédiés aux machines – ni même dans les discussions sur la manière d’aborder le problème.« Le cloud a aggravé ce problème de manière exponentielle, prévient Murali Palanisamy, responsable des solutions chez AppViewX. « La PKI est généralement mise en place et gérée par l’équipe interne de Microsoft, qui n’a pas grand-chose à dire sur les décisions relatives au cloud et à la transformation numérique. Les équipes DevOps sont plus axées sur la vitesse et l’agilité : elles font ce qui est bon pour accélérer les projets, pas nécessairement ce qui est le plus indiquée ou le plus stratégique en matière de sécurité. »Et même lorsque les organisations décident d’établir des politiques et de normaliser la sécurité pour les nouveaux déploiements, la reprise de l’existant représente un effort considérable. Sans oublier le fait que dans les architectures modernes, les équipes d’exploitation sont réduites à la portion congrue.Il est donc d’autant plus important que les DSI s’approprient le problème, souligne Geoff Cairns. « En particulier dans les organisations les plus grandes, les plus complexes et les plus globales, on sous-estime souvent l’ampleur de la tâche consistant à faire passer ces messages dans l’organisation. Il s’agit en partie de bien maîtriser la culture interne et la manière d’aborder ces questions. »Multiplication des incidents liés aux certificatsMême en dehors de ce phénomène d’explosion des identités de machines, les problèmes de certificats provoquent déjà régulièrement des pannes et des problèmes de sécurité au sein des organisations, souvent parce que les notifications d’expiration passent inaperçues, même au sein de fournisseurs majeurs comme Microsoft. Ces difficultés dans la gestion des informations d’identification permettent également à, des assaillants d’accéder à l’infrastructure cloud, aux workloads des entreprises ou à leur supply chain logicielle. Un certificat expiré rompant l’inspection du trafic TLS chez Equifax a ainsi conduit à la violation massive de données qu’a connue cet acteur en 2017.« Les complexités engendrées par l’adoption du cloud et du DevOps – qui entraînent par ailleurs une croissance exponentielle des identités machine – conduisent à une incroyable prolifération d’identités et à une vulnérabilité accrue aux attaquants cherchant se déplacer latéralement au sein d’une organisation », explique Geoff Cairns.La combinaison d’une surveillance accrue – par les éditeurs de navigateurs en particulier -, de la banalisation des autorités de certification par les fournisseurs de cloud et de l’apparition de nouveaux acteurs comme Let’s Encrypt va accroître la pression sur les entreprises, rendant les mauvaises pratiques insoutenables. « Le marché des certificats TLS est devenu, comme d’autres, un marché centré sur l’approvisionnement et le coût, mais certains des incidents récents poussent les entreprises à une plus grande attention sur les questions de confiance et de sécurité sous-jacentes », ajoute l’analyste.Se préparer aux incidents et à leurs impactsDe nombreuses grandes organisations devront ainsi bientôt révoquer leurs certificats TLS et en provisionner de nouveaux, à grande échelle. Une entreprise sur cinq du classement Fortune 1000 utilise en effet Entrust comme autorité de certification et, à partir du 1er novembre 2024, Chrome, suivant l’exemple de Firefox, ne fera plus confiance aux certificats TLS de ce fournisseur en raison d’une série de défaillances de conformité, qui, selon l’autorité de certification, ont parfois été causées par des entreprises clientes qui demandaient plus de temps pour gérer la révocation de leurs certificats. Les navigateurs afficheront des avertissements de sécurité plutôt que de bloquer complètement l’accès aux sites utilisant des certificats Entrust émis après le 31 octobre 2024, mais de nombreuses organisations voudront changer d’autorité de certification pour éviter la perte de confiance des utilisateurs que risquent d’entraîner ces messages.Cette décision crée également un précédent pour une application plus stricte des politiques de sécurité sur les certificats au sein des navigateurs, après des années de tension entre leurs éditeurs et les autorités de certification. Même sans ce tour de vis, les clients de DigiCert, y compris ceux qui exploitent des infrastructures critiques comme les systèmes de santé et les réseaux de télécommunications, ont récemment dû remplacer plus de 83 000 certificats TLS, la plupart du temps avec un préavis de 24 heures seulement, parce que depuis cinq ans, son portail client en libre-service ne créait pas correctement les enregistrements pour la vérification DNS. Ces notifications sont arrivées par courrier électronique un lundi matin, mettant de nombreuses organisations dans l’embarras face à l’ampleur de la tâche.Car, à l’heure actuelle, peu d’organisations sont en mesure de traiter ce type d’urgence de manière efficace. Il s’agit d’une expertise que les organisations doivent développer, car ces problèmes vont continuer à se poser, assure Murali Palanisamy. Cela va devenir la norme, et nous devons donc nous y préparer. » Selon lui, une partie du problème réside dans le fait que les autorités de certification doivent conserver des certificats racine valables pendant des décennies pour la génération de clés. « Dans un monde numérique, il s’agit presque d’un retour à l’ère des dinosaures. Il faut maintenir la clé en vie pendant 30 ans ! »Faire face à une rotation accélérée des certificatsD’où la proposition de Google de réduire la validité des certificats TLS à seulement 90 jours, afin d’alléger le fardeau des autorités, car les exigences de validité de la racine tomberaient alors à cinq ou sept ans. Mais si cette proposition se concrétise, les entreprises devront procéder à une rotation des certificats si fréquente que le recours à l’automatisation deviendra indispensable.Les certificats TLS destinés au public étaient auparavant valables jusqu’à trois ans. Leur durée de validité a d’abord été réduite à 825 jours (deux ans plus les 30 jours précédant l’expiration, au cours desquels ils doivent être renouvelés), puis à 398 jours (un an plus 30 jours). Google a récemment proposé de réduire cette durée à 90 jours seulement. Il n’est pas certain que le CA/Browser Forum soutienne cette proposition, mais si Google décide de mettre en oeuvre cette mesure sur Chrome unilatéralement, son importante part de marché pourrait inciter les autorités de certification à ramener à 90 jours la durée par défaut de leurs certificats. Ce qui multiplierait par six le nombre de renouvellements !Une marche bien haute pour la plupart des organisations. Pour Murali Palanisamy, « il n’est en pratique pas possible de faire cela manuellement, pour chaque appareil et chaque certificat de l’organisation ». La révocation et le remplacement manuels des certificats impliquent l’utilisation de plusieurs systèmes pour générer et distribuer les clés, ce qui prend généralement une ou deux heures par certificat ; des automatisations maison peuvent ramener cette durée entre 15 et 30 minutes. Ce qui reste insuffisant.Une telle vitesse de rotation devait donc pousser les entreprises à considérer des systèmes automatisés intégrés à une gamme d’autorités de certification, ce qui signifie travailler avec une gamme d’API, de SDK, d’agents et avec le protocole ACME, ainsi qu’avec des systèmes et des outils DevOps à l’état de l’art. De quoi générer de nouvelles clés en quelques secondes ou, au pire, en quelques minutes si le certificat génère un coût qui doit être approuvé dans le cadre d’un workflow.Planifier la cryptographie post-quantiqueMême sans certificats à 90 jours, les entreprises doivent encore s’intéresser aux changements de normes de cryptographie du fait de l’arrivée annoncée des ordinateurs quantiques. Et planifier l’adoption de la nouvelle série de normes de chiffrement post-quantique, comme celles approuvées par le NIST (l’agence américaine en charge des standards technologiques). Les autorités de certification ne seront probablement pas prêtes à émettre des certificats à ces normes avant 2026… ce qui laisse un peu de temps pour se préparer à leur complexité supplémentaire.Pour éviter aux entreprises d’avoir à installer des certificats TLS en double – l’un pour les clients qui intègrent les nouveaux algorithmes, l’autre pour ceux qui ne le font pas encore – une normalisation de suites de chiffrement hybrides est en cours. Objectif : simplifier la transition, mais aussi de tenir compte du fait que, même s’ils peuvent être plus rapides, de nombreux algorithmes post-quantiques sont nouveaux et n’ont pas fait l’objet d’un examen aussi approfondi que les approches actuelles de la cryptographie, de sorte qu’un retour arrière pourrait s’avérer nécessaire si des vulnérabilités sont découvertes ultérieurement.Des problèmes lors de la mise en oeuvre sont également probables. Lorsque Chrome et Edge 124 ont activé par défaut l’échange de clés TLS hybride post-quantique de Google en début d’année, les serveurs web qui n’implémentaient pas TLS correctement ont commencé à rejeter les connexions. De même, des problèmes de compatibilité détectés lors de tests antérieurs, effectués par Google et Cloudflare, avaient déjà retardé de plusieurs années le déploiement des clés post-quantiques dans les navigateurs.Les DSI doivent être prêts non seulement à tester la compatibilité de leurs systèmes aux normes post-quantiques, mais aussi à faire face à la charge supplémentaire que représente la gestion des certificats et des identités des machines dédiées. Et ce, bien avant que les ordinateurs quantiques capables de briser le chiffrement traditionnel ne soient eux-mêmes disponibles, car les informations récoltées aujourd’hui pourraient encore être sensibles lorsque ces machines seront prêtes à les déchiffrer.Travailler sa crypto-agilitéCette capacité à remplacer les algorithmes cryptographiques ne se limite d’ailleurs pas à la révolution quantique. « Le jour viendra où les technologies de gestion des secrets et des certificats en entreprise subiront une transformation inévitable et massive qui les rendra obsolètes, prévient Erik Wahlstrom du Gartner. Ce n’est qu’une question de temps. La crypto-agilité dépend de la rapidité avec laquelle vous pouvez vous relever de ce type d’événements. »Selon l’analyste, les entreprises commencent à s’intéresser à la question. L’année dernière, l’équipe IAM de Gartner a reçu deux fois plus d’appels sur la gestion des identités des machines que sur l’authentification multifactorielle (MFA). « Ce n’est pas parce que la MFA perd en importance, mais parce que la gestion des identités des machines a pris un caractère d’urgence pour les organisations », explique-t-il. Pour reprendre le contrôle, il conseille aux DSI d’établir une stratégie pour la gestion des certificats et des identités de machines, en commençant par définir leur champ d’application, et d’ancrer cette stratégie dans les besoins techniques de l’organisation pour éviter d’être trop influencé par le marketing des fournisseurs.Des solutions encore perfectiblesSur le marché de la gestion des secrets pour l’entreprise, la consolidation est en cours. Les grands fournisseurs de solutions d’identité rachètent de plus petits acteurs spécialisés dans l’identité des machines, augmentant l’intérêt des outils. Mais la gestion de l’identité des machines demande toujours beaucoup de travail. « Il n’existe pas aujourd’hui de solution unique qui permette de prendre en charge tous les aspects de la question », explique Geoff Cairns, analyste chez Forrester Research.Son homologue du Gartner, Erik Wahlstrom, recommande aux DSI de constituer une équipe interfonctionnelle pour combler les espaces entre les silos que constituent les outils traditionnels, et d’attribuer des responsabilités claires pour les identités des machines. « Nous constatons que la plupart des entreprises échouent en n’établissant pas de responsabilité au sein des nombreuses unités métiers concernées et en se lançant directement dans l’automatisation, explique-t-il. Il faut établir des processus, mener à bien la phase de découverte et d’exploration et définir des attentes quant au degré d’automatisation possible. »Cet inventaire doit par ailleurs être pensé comme un processus continu. Le framework de gestion du cycle de vie des certificats du NIST (SP 1800-16), publié en 2020, est un bon point de départ pour ce faire, couvrant les risques et les meilleures pratiques pour la gestion des certificats TLS à grande échelle, y compris les processus automatisés d’émission, de renouvellement et de révocation.

Les services de la navigation aérienne allemands ont été victime d’une cyberattaque le 1er septembre. Le trafic aérien n’a pas été affecté et les conséquences resteraient limitées. L’attaque pourrait avoir été perpétrée par le groupe de hackers pro-russes APT 28.

« Notre système de communication bureautique a été piraté et nous sommes actuellement en train de prendre des mesures de protection », a indiqué un porte-parole de la DFS (Deutsche Flugsicherung, contrôle aérien allemand) en réponse à l’agence de presse allemande DPA. Le contrôle aérien allemand aurait ainsi subi une attaque sur son système de communication interne le 1er septembre. « Nous essayons de limiter les conséquences au maximum. Le trafic aérien n’est pas affecté et se poursuit normalement. Nous ne savons pas encore si des données ont pu être consultées. Les autorités de sécurité ont été informées ».Le groupe de pirates informatiques APT28 soupçonnéLe ministère fédéral des Transports n’a donné aucune autre information sur l’incident et a renvoyé vers la DFS. L’Office fédéral de protection de la Constitution (BfV) a confirmé l’incident : « Nous sommes au courant de cette attaque et nous la traitons », a déclaré une de ses porte-parole. Selon les informations obtenues par la radio bavaroise qui s’était fait l’écho de la cyberattaque avant la déclaration officielle, le groupe de hackers APT 28 serait impliqué dans cette action.Selon le BfV, ce groupe est actif dans le monde entier depuis au moins 2004, principalement dans le domaine du cyberespionnage. « Il compte parmi les cyberacteurs les plus actifs et les plus dangereux au monde », peut-on lire sur le site Internet du Verfassungsschutz, le service d’intelligence allemand. Le BfV relie par ailleurs APT 28 au service de renseignement militaire russe, le GRU.

Selon les autorités américaines, des spécialistes du sujet et des entreprises visées, de plus en plus de candidats informaticiens se révèlent être des “taupes”, souvent venues de Corée du Nord. Elles s’infiltrent sous de fausses identités dans les effectifs des entreprises et dans leurs systèmes informatiques. Pour éviter cette menace, RSSI et DSI doivent renforcer vérifications et contrôles.

Les RSSI qui cherchent à recruter de nouveaux informaticiens sont déjà confrontés à la pénurie de profils sur le marché et à la nécessité de combler les déficits de compétences en matière de cybersécurité. Mais il leur faut désormais affronter une nouvelle menace plus inattendue. Des développeurs nord-coréens violent les sanctions prises contre leur pays et se font passer pour des candidats potentiels. La Corée du Nord infiltre ainsi activement les entreprises occidentales via ces informaticiens qualifiés qui se font passer pour des télétravailleurs auprès de ces organisations, généralement – mais pas exclusivement – aux États-Unis.Ils utilisent de fausses identités, souvent volées à de vrais citoyens américains, pour postuler à des contrats d’indépendants ou à des postes à distance. Ces stratagèmes constituent une des méthodes déployées par le régime nord-coréen pour générer des revenus illicites, alors qu’il fait l’objet de sanctions financières en raison de son programme d’armement nucléaire. Ils s’inscrivent aussi dans le cadre des activités de cyberespionnage du pays.Des tactiques identifiées depuis 2022C’est en 2022 que le Trésor américain a mis en garde pour la première fois contre ce type de tactique. Des milliers d’informaticiens hautement qualifiés profitent en effet de la forte demande en développeurs pour obtenir des contrats d’indépendants auprès de clients du monde entier, notamment en Amérique du Nord, en Europe et en Asie du Sud-Est. « Bien que ces informaticiens de la RPDC [Corée du Nord] ne s’adonnent pas directement à des cyberactivités malveillantes, ils utilisent les accès privilégiés obtenus en tant que sous-traitants pour faciliter les cyber-intrusions malveillantes de la RPDC », mettait alors en garde le ministère.« Ils s’appuient souvent sur leurs contacts à l’étranger pour obtenir des emplois en freelance et pour être mis en contact direct avec des clients », poursuivait le Trésor américain. Ces citoyens nord-coréens se présentent comme des Sud-Coréens, des Chinois, des Japonais ou encore des Européens de l’Est, et comme des télétravailleurs basés aux États-Unis. Dans certains cas, ils dissimulent encore davantage leur identité en signant des contrats avec des sous-traitants tiers. Deux ans après ce premier avertissement du Trésor américain, de plus en plus d’exemples de mise en pratique de cette ruse sont mis au jour.Un groupe de plusieurs milliers d’informaticiens espions démanteléChristina Chapman, résidente de l’Arizona, est par exemple accusée de fraude dans le cadre d’un système complexe de ce type, qui aurait permis à des informaticiens nord-coréens de se faire passer pour des citoyens et résidents américains en utilisant des identités volées et ainsi obtenir des emplois dans plus de 300 entreprises américaines. Ces informaticiens ont utilisé des plateformes de paiement et des sites de recrutement en ligne américains pour obtenir abusivement des postes dans ces organisations, dont une grande chaîne de télévision, un constructeur automobile, une entreprise technologique de la Silicon Valley et un industriel de l’aérospatiale.« Certaines de ces entreprises ont été délibérément ciblées par un groupe de travailleurs informatiques de la RPDC », selon les procureurs américains, qui ajoutent que deux agences gouvernementales américaines ont été visées, mais sans succès. Selon l’acte d’accusation du ministère de la Justice (DoJ), dévoilé en mai 2024, Christina Chapman pilotait une ferme d’ordinateurs portables, hébergeant les ordinateurs des travailleurs informatiques étrangers à son domicile de manière à donner l’impression que ceux-ci se trouvaient aux États-Unis. Elle recevait et falsifiait des chèques de paie et blanchissait les paiements par dépôt direct des salaires sur des comptes bancaires qu’elle contrôlait.Selon les procureurs, un grand nombre des travailleurs étrangers de sa cellule étaient originaires de Corée du Nord. On estime à 6,8 millions de dollars les sommes versées pour ce travail, dont une grande partie a été faussement déclarée aux autorités fiscales au nom de 60 citoyens américains réels dont l’identité a été soit volée, soit empruntée. Les autorités américaines ont saisi les fonds liés à ce système auprès de Christina Chapman, ainsi que les salaires et les sommes accumulées par plus de 19 travailleurs informatiques étrangers.Une plateforme de recherche d’emploi piège des entreprises peu méfiantesL’Ukrainien Oleksandr Didenko, 27 ans, a été quant à lui inculpé pour avoir créé pendant des années de faux comptes sur des plateformes américaines de recherche d’emploi dans le secteur des technologies de l’information et auprès de sociétés de transfert de fonds basées aux États-Unis. « Il a vendu les comptes à des informaticiens non américains, dont certains qu’il suspectait d’être nord-coréens, et ils ont utilisé ces fausses identités pour postuler à des emplois auprès d’entreprises peu méfiantes », selon le DoJ. Oleksandr Didenko, qui a été arrêté en Pologne en mai dernier, fait l’objet d’une procédure d’extradition vers les États-Unis. Les autorités américaines ont saisi le domaine upworksell.com de sa société.La façon dont ce type de fraude s’exerce dans une entreprise ciblée a été révélée – un comble – par le témoignage du fournisseur de solutions de sensibilisation à la sécurité KnowBe4. Ce dernier a en effet reconnu en juillet avoir embauché à son insu un espion informatique nord-coréen. Le nouvel employé a été rapidement repéré après avoir infecté son ordinateur portable professionnel avec des logiciels malveillants, avant de disparaître lorsque l’incident a été détecté et de refuser de dialoguer avec les équipes de sécurité. L’ingénieur logiciel, embauché pour rejoindre l’équipe IA interne de KnowBe4, avait réussi ses entretiens vidéo et ses antécédents avaient été vérifiés.« Le candidat utilisait une identité américaine valide, mais volée », a précisé l’éditeur. Il s’est avéré par la suite que la photo figurant sur sa candidature avait été éditée à l’aide d’outils d’intelligence artificielle à partir d’une image standard. Le nouvel employé n’a cependant pas terminé son processus d’intégration et n’avait donc pas accès aux systèmes de KnowBe4. Il n’y a donc pas eu de violation de données. « Aucun accès illégal n’a été obtenu et aucune donnée n’a été perdue, compromise ou exfiltrée sur les systèmes de KnowBe4 », selon l’éditeur, qui considère l’incident comme une leçon à retenir.Un kit d’espion infiltré prêt à l’emploi découvert sur GithubUn nombre croissant de preuves suggère que KnowBe4 n’est qu’une des nombreuses organisations ciblées par les informaticiens nord-coréens sous couverture. En novembre dernier, l’éditeur de solutions de sécurité Palo Alto a indiqué que les représentants de la menace nord-coréenne cherchaient activement des emplois auprès d’organisations basées aux États-Unis et dans d’autres parties du monde. Au cours d’une enquête sur une campagne de cyberespionnage, les chercheurs de Palo Alto ont découvert un dépôt GitHub contenant de faux CV, des questions et réponses à des entretiens d’embauche, un scan de carte de résident permanent américaine volée et des copies d’offres d’emploi dans le domaine des technologies de l’information émanant d’entreprises américaines, entre autres ressources.Selon Palo Alto, les CV contenus dans ces fichiers indiquent qu’un large éventail d’entreprises américaines et de marchés de l’emploi indépendants avaient été ciblés. Mandiant, la société de renseignements sur les menaces appartenant à Google, a signalé l’année dernière que « des milliers de travailleurs informatiques hautement qualifiés de Corée du Nord » étaient ainsi à la recherche d’un emploi.« Ces informaticiens obtiennent des contrats en freelance auprès de clients du monde entier […] et bien qu’ils réalisent principalement des tâches légales, ils abusent de leurs accès pour permettre des cyber-intrusions menées par la Corée du Nord », confirme Mandiant. Les adresses électroniques utilisées par Park Jin Hyok (PJH), un cyberespion nord-coréen notoire lié au développement de WannaCry et au tristement célèbre raid de 81 M$ sur la banque du Bangladesh, sont apparues sur des sites d’emploi avant l’inculpation de Park aux États-Unis pour cybercriminalité. « Entre l’attaque de Sony [2014] et l’émission du mandat d’arrêt, PJH a été repéré sur des plateformes de recherche d’emploi aux côtés d’autres informaticiens de Corée du Nord ».Plus récemment, CrowdStrike a rapporté qu’un groupe nord-coréen surnommé “Famous Chollima” avait infiltré plus de 100 entreprises avec de faux professionnels de l’informatique. Les faux employés de ce groupe, qu’on présume lié à la RPDC et dont les cibles comprenaient des entreprises des secteurs de l’aérospatiale, de la défense, du retail et de la high tech, principalement aux États-Unis, étaient suffisamment performants pour conserver leur emploi tout en tentant d’exfiltrer des données et d’installer des outils de surveillance et de gestion à distance (RMM) permettant à de nombreuses adresses IP de se connecter aux systèmes de leurs victimes.Les entreprises européennes également menacéesEn utilisant des chatbots, les recrues potentielles adaptent parfaitement leur CV et utilisent en outre des deepfakes créés par l’IA pour se faire passer pour de vraies personnes. Crystal Morin, ancienne analyste du renseignement pour l’US Air Force devenue stratège en cybersécurité chez Sysdig, explique que la Corée du Nord vise principalement les entités du gouvernement américain, les entrepreneurs de la défense et les entreprises technologiques qui recrutent des informaticiens.Selon elle, « les entreprises européennes et d’autres pays occidentaux sont également en danger. Les informaticiens nord-coréens tentent de trouver un emploi soit pour des raisons financières – pour financer le programme d’armement de l’État -, soit pour faire du cyberespionnage. Ils essaient aussi parfois de se faire recruter dans des entreprises technologiques afin de voler leur propriété intellectuelle, puis de l’utiliser pour créer leurs propres technologies de contrefaçon. Ce sont de vraies personnes avec de vraies compétences en développement de logiciels et il n’est donc pas toujours facile de les détecter ».Naushad Uzzaman, cofondateur et directeur technique de Blackbird.AI, ajoute que, bien que la technologie de falsification de vidéos en temps réel ne soit « pas encore mature », les avancées ne feront probablement que faciliter la vie de ces faux candidats à l’emploi. « On peut imaginer quelque chose comme un filtre Snapchat pour se présenter comme quelqu’un d’autre, imagine-t-il. Cependant, même si cela se produisait, il y aurait probablement des défauts dans la vidéo qui montreraient des signes révélateurs de falsification ».L’indispensable renforcement du contrôle des recrutementsLes DSI et les RSSI doivent collaborer avec leurs collègues des RH afin d’examiner de plus près les candidats. Voici quelques suggestions : organiser des vidéoconférences en direct avec les candidats potentiels au travail à distance et les interroger sur leurs projets professionnels, rechercher les incohérences de carrière dans les CV, vérifier les références en appelant le contact fourni, confirmer l’adresse de résidence, examiner et renforcer les contrôles d’accès et les processus d’authentification, surveiller l’équipement fourni pour l’accès à distance. Car les contrôles doivent aussi se poursuivre post-embauche. Selon KnowBe4, les employeurs doivent aussi se méfier de l’utilisation sophistiquée de VPN ou de machines virtuelles pour accéder au système de l’entreprise. Pour eux, l’utilisation de numéros VoIP et l’absence d’empreinte numérique pour les informations de contact fournies sont d’autres signaux d’alerte.David Feligno, recruteur technique en chef chez Huntress, fournisseur de services managés, livre quelques précisions sur ses méthodes : « nous avons un processus en plusieurs étapes pour vérifier un profil quand il semble trop beau pour être vrai. C’est-à-dire si cette personne vole le profil de quelqu’un d’autre et le revendique comme le sien, ou si elle ment simplement au sujet de son lieu de résidence actuel. Nous vérifions d’abord si le candidat a fourni un profil LinkedIn que nous pouvons comparer à son CV actuel. Si nous constatons que la localisation du profil ne correspond pas à celle du CV, nous savons qu’il s’agit d’un faux CV. Si les deux sont identiques, il faut néanmoins s’assurer que cette personne n’a pas créé de profil LinkedIn récemment ou qu’elle a bien des relations et des followers. » Huntress vérifie également que le numéro de téléphone fourni par le candidat est valide et lance une recherche Google sur lui.Former toutes les équipes de recrutement« Toutes ces vérifications font gagner beaucoup de temps, insiste David Feligno. Car si quelque chose ne correspond pas à la réalité, vous saurez que vous avez affaire à un faux profil, et cela arrive souvent ! » Pour Brian Jack, RSSI de KnowBe4, toutes les organisations devraient se préoccuper de ce sujet. « Les RSSI devraient examiner le profil de chaque candidat pour s’assurer qu’il n’y a pas de faille dans le processus, juge-t-il. Les RSSI devraient d’ailleurs revoir les processus d’embauche de l’organisation et s’assurer que leurs pratiques globales de gestion des risques englobent l’embauche. »Les équipes de recrutement devraient, de leur côté, être formées à une vérification approfondie des CV et des références pour s’assurer que la personne interrogée est bien celle qu’elle prétend être, conseille Brian Jack. Le mieux serait de rencontrer les candidats en personne, munis d’une pièce d’identité délivrée par le gouvernement, ou de faire appel à des agents de confiance, tels que des sociétés de vérification des antécédents, d’autant plus que l’IA entre en jeu dans les programmes de recrutement de ce type. « En tant que responsable du recrutement, je pose par exemple des questions auxquelles il serait difficile de se préparer et auxquelles il serait difficile à l’IA de répondre à la volée, mais dont une personne pourrait facilement parler si elle était bien celle qu’elle prétend être », poursuit Brian Jack.

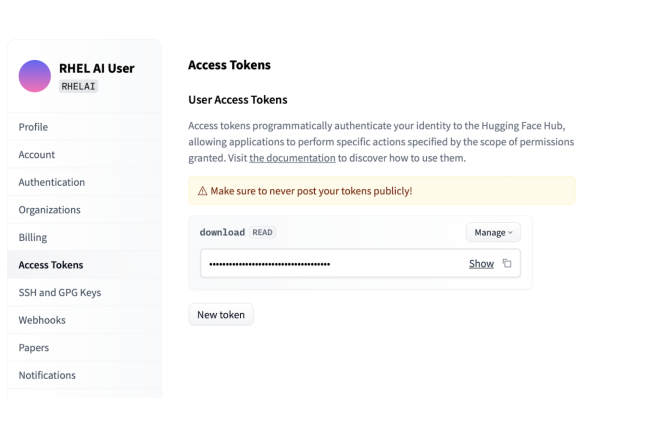

Annoncée en mai dernier, la distribution Enterprise Linux AI de Red Hat est désormais en disponibilité générale. Objectif : apporter la capacité aux entreprises de déployer plus facilement et à moindre coût des technologies de GenAI à l’aide d’outils et de modèles open source.

Il y a trois mois, Red Hat a accéléré dans l’intelligence artificielle générative en annonçant, lors de son sommet annuel à Orlando, Enterprise Linux AI. la distribution est désormais en disponibilité générale. Sa mission : répondre aux problèmes des entreprises pour construire et déployer l’IA dans les clouds hybrides et aux coûts élevés de formation et d’inférence associés selon le fournisseur. « Les entreprises sont confrontées à un choc des prix », a expliqué de son côté Andy Thurai, vice-président et analyste principal chez Constellation Research. « Non seulement il est onéreux de former ou d’affiner un modèle, mais le coût du déploiement et de l’utilisation du modèle en production – les prix d’inférence – peuvent s’accumuler rapidement, rendant les coûts de formation insignifiants en comparaison Les entreprises recherchent des solutions plus économiques. »

De son côté Tushar Katarki, directeur principal de la gestion des produits pour plateformes hybrides de Red Hat, explique que le fournisseur ne publie pas d’informations sur les tarifs, si ce n’est pour dire que RHEL AI est disponible à un prix attractif. Et d’ajouter que les coûts de sa dernière solution sont jusqu’à 50 % inférieurs pour des performances similaires, voire légèrement supérieures à d’autres. « Les plateformes d’IA fermées comme ChatGPT d’OpenAI et Claude d’Anthropic sont toutes livrées uniquement sur un modèle SaaS », indique-t’il « alors que RHEL AI, qui prend en charge plusieurs modèles open source dont Granite d’IBM, peut être exécuté sur différents clouds et sur une grande variété de serveurs OEM. »

Le LLM ouvert IBM Granite 7B pris en charge au lancement

Au démarrage, RHEL AI comprend la prise en charge du modèle de langue anglaise Granite à 7 milliards de paramètres. Un autre modèle Granite (8B) est en bêta et sera disponible à la fin de cette année ou au début de 2025. RHEL AI est également livré avec Instruct Lab, un projet open source qui aide les entreprises à affiner et à personnaliser les modèles d’IA ouverts. Enfin, ce produit est fourni avec toute l’infrastructure de la plateforme sous-jacente, poursuit Tushar Katarki. Cela inclut la prise en charge immédiate des accélérateurs GPU Nvidia et dans les prochaines semaines ceux d’AMD et d’Intel. Tout est présenté sous la forme d’une image de conteneur, ajoute le responsable, afin que les entreprises puissent utiliser leurs outils de gestion de conteneurs existants pour l’administrer. « Considérez RHEL Linux AI comme un terminal. Il contient tout. Le modèle Granite, Instruct Lab, tous les logiciels de plateforme sous-jacents dont vous avez besoin et le système d’exploitation sous-jacent », soutient Tushar Katarki. Selon le fournisseur, la distribution aide les entreprises à s’éloigner de l’approche modèle pour tous de l’IA générative, qui est non seulement coûteuse, mais qui peut aussi enfermer les entreprises dans un seul fournisseur. Il existe aujourd’hui des LLM open source dont les performances rivalisent ainsi avec les modèles propriétaires.

« Et il existe des modèles plus petits qui sont vraiment adaptés aux cas d’utilisation spécifiques des entreprises et à leurs données. Ils offrent un bien meilleur retour sur investissement et des coûts globaux bien plus intéressants que les LLM en général », ajoute Tushar Katarki. Les modèles eux-mêmes, mais aussi les outils nécessaires pour les entraîner, sont également disponibles auprès de la communauté open source. « L’écosystème alimente réellement l’IA générative, tout comme Linux et l’open source ont alimenté la révolution du cloud », poursuit le directeur. En plus de permettre aux entreprises d’exécuter l’IA générative sur leur propre matériel, RHEL AI prend également les ressources tournant sur des clouds public tiers en commençant par AWS et IBM puis Azure et GCP au cours du quatrième trimestre.

Support et architectures de référence GenAI à venir

La feuille de route de RHEL AI prévoit également d’encadrer la GenAI. « Les garde-fous et la sécurité sont l’une des valeurs ajoutées d’Instruct Lab et de RHEL AI », explique le dirigeant. « Nous les intégrons à la formation elle-même. La plateforme ne prend actuellement en charge aucun framework de sécurité spécifique et n’est pas livré avec un support prêt à l’emploi mais des documents et architectures de référence complémentaires sont prévus prochainement. « L’avenir, ce sont les flux de travail et les systèmes GenAI », déclare-t-il. « Ce n’est pas différent de l’approche des microservices. Nous disposons d’outils permettant aux gens de les adapter à différents cas d’utilisation. Les SLM en particulier s’adaptent bien à l’approche orientée agents », ajoute Tushar Katarki pour qui, contrairement à un grand modèle qui fait tout, un ensemble de petits modèles est plus facile à maintenir, plus facile à former, plus facile à personnaliser et plus rentable pour l’inférence.

Le protocole de routage BGP est dans le viseur de l’administration américaine. Une agence plaide pour des changements afin d’en renforcer la sécurité.

Assez régulièrement lors d’une panne IT, la question d’un problème de routage se pose rapidement avec un coupable souvent tout désigné BGP (Border Gateway Protocol). Le protocole de routage réseau est connu pour les mauvaises configurations ou le détournement de trafic. Des faiblesses que l’Office of the National Cyber Director (ONCD) agence rattachée à la Maison Blanche souhaite remédier. Elle vient de publier une feuille de route dans ce sens. « Les propriétés initiales de BGP ne répondent pas de manière adéquate aux menaces et aux exigences de résilience de l’écosystème de l’internet d’aujourd’hui », indique l’agence. Avant d’ajouter, « le risque d’une perturbation généralisée de l’infrastructure de l’internet, qu’elle soit accidentelle ou malveillante, est un problème de sécurité nationale ».

Cette feuille de route fait suite à une recommandation formulée par la FCC (Federal Communication Commission) selon laquelle neuf grands fournisseurs de services Internet américains devraient déposer des rapports détaillant leurs progrès en matière de sécurisation de BGP. Parmi les bonnes pratiques, l’ONCD milite pour que les agences fédérales et les opérateurs de réseaux se dépêchent de mettre en œuvre un système de cryptographie à clé publique, Resource Public Key Infrastructure (RPKI).

Un peu d’histoire

En 1989, l’année où l’informaticien britannique Tim Berners-Lee est passé à la postérité en inventant le langage HTML, les liens hypertextes et le web, deux ingénieurs d’IBM, Yakov Rekhter et Kirk Lougheedont ont conçu le protocole BGP pendant leur pause déjeuner, au dos d’une serviette de table (d’où son surnom ultérieur de « protocole à deux serviettes »). Malheureusement, personne à l’époque ne pensait que la sécurité était une question importante, ce qui explique pourquoi les ingénieurs ont essayé de l’intégrer au web et au protocole BGP depuis lors.

BGP est le protocole sans lequel l’internet ne serait pas possible. Il permet aux paquets de trouver un chemin à travers un large maillage d’autres réseaux interconnectés et d’atteindre la bonne destination. Cette tâche est complexe et nécessite à la fois un routage multi-trajet (c’est-à-dire différentes façons d’atteindre une destination pour tenir compte de problèmes tels que la congestion) et l’utilisation d’algorithmes qui proposent aux routeurs de choisir le meilleur trajet à un moment donné.

Le RPKI une bonne pratique qui a du mal à se mettre en place

Quand BGP fonctionne, personne ne le remarque. Quand ce n’est pas le cas, les choses peuvent empirer rapidement. Il s’agit souvent d’erreurs de configuration, cela a été le cas pour Microsoft en janvier 2023. Idem en juin 2019 pour un petit FAI de Pennsylvanie qui avait annoncé par inadvertance des routes BGP directes pour atteindre Amazon et Cloudflare. Une ruée de trafic s’en est suivie et un engorgement a provoqué une panne massive.

Le problème sous-jacent était que BGP n’avait aucun moyen de vérifier quels réseaux étaient autorisés à annoncer quels blocs d’adresses. Des mécanismes plus récents basés sur RPKI, appelés Route Origin Authorization (ROA) et Route Origin Validation (ROV), tentent de résoudre cette problématique. Ils vérifient qu’un réseau a le droit d’annoncer une route avant de recevoir des paquets. Il est ainsi beaucoup plus difficile d’annoncer de manière malveillante des itinéraires de routage pour détourner le trafic. Ces deux techniques ont leurs limites, mais elles constituent un bon point de départ largement accepté. Mais, comme toujours dans les comités Internet, les choses prennent beaucoup de temps à se mettre en place, même avec des mandats de la Maison Blanche.

L’ONCD fixe des contraintes

L’agence rattachée à la Maison Blanche a déclaré que d’ici la fin de l’année, elle s’attend à ce que 60% de l’espace IP du gouvernement fédéral soit couvert par des accords de service d’enregistrement (RSA) nécessaires à l’établissement des ROA. Malgré cela, la feuille de route identifie plusieurs obstacles qui ralentissent la révision de BGP à long terme. L’un d’eux est que les effets négatifs de son insécurité ne sont souvent pas ressentis directement par les fournisseurs de services pour lesquels l’investissement n’offre pas de retour financier direct. Le fait que certains opérateurs devront également remplacer ou mettre à niveau leurs routeurs pour qu’ils soient compatibles avec ROV n’est pas non plus une bonne chose.

L’ONCD conseille aux FAI de vérifier les effets techniques que la mise en œuvre de la ROA et de la ROV pourrait avoir sur leur organisation et d’inclure la question de la sécurité BGP dans l’évaluation des risques de cybersécurité. Les recommandations complètes s’étendent sur plusieurs points, qui détaillent également la manière dont les FAI devraient établir des contrats pour le transit IP, le cloud et l’infrastructure. Le message général est clair : les fournisseurs de services devraient surveiller la qualité et le profil de menace de leur configuration BGP plutôt que de laisser d’autres personnes nettoyer le désordre.

Une démarche en solitaire

Notre confrère de Networkworld a interrogé Kieren McCarthy, expert en matière d’Internet et ancien journaliste sur les propositions de l’ONCD. Si le jugement est positif, il émet quelques réserves. « Ce qui est un peu inquiétant, c’est que le gouvernement américain semble faire cavalier seul, allant même jusqu’à créer un nouveau groupe de travail dont il n’a pas annoncé les membres », observe-t-il. Tout en ajoutant, « L’internet reste un réseau mondial, et le gouvernement américain devrait joindre le geste à la parole et soutenir le modèle international multipartite pour trouver des solutions aux problèmes de l’internet ».

Il a fait remarquer que la feuille de route était complémentaire des groupes existants tels que le Mutually Agreed Norms for Routing Security (MANRS), une initiative mondiale ayant le même objectif de sécuriser les menaces de routage. « Je me demande pourquoi ils ont ressenti le besoin de développer leur propre approche », s’interroge Kieren McCarthy.

Un expert français a démontré une attaque nommée Eucleak permettant de cloner des clés Yubikey, utilisés dans le cadre d’une authentification à plusieurs facteurs. Il s’appuie sur une faille par canal auxiliaire et propose des solutions d’atténuation du risque.

Beaucoup d’entreprises appuient leur stratégie d’authentification de l’identité sur la clé YubiKey. Ce matériel FIDO (Fast Identity Online) est l’un des plus populaires et l’un des mieux notés pour le MFA (authentification à plusieurs facteurs). Cependant, dans le cadre d’une attaque récemment identifiée, baptisée « Eucleak», le dispositif USB s’est révélé vulnérable au clonage quand des cybercriminels mettent physiquement (temporairement) la main dessus, car ils peuvent alors accéder aux informations d’identification FIDO de l’utilisateur en menant une attaque par canal auxiliaire (side channel).

Cette semaine, Yubico, qui fabrique ces clés, a publié un avis à propos de cette faille découverte par un chercheur français, Thomas Roche, co-fondateur de la start-up Ninjalab, spécialisée en cryptographie. Il a détaillé dans un rapport les détails de l’attaque. Yubico a qualifié la gravité de la faille de « modérée ». Mais, étant donné qu’il est impossible de mettre à jour le firmware de la YubiKey, le matériel reste définitivement vulnérable. « Cela montre que les éléments sécurisés ne sont pas parfaits et que leur sécurité doit être continuellement remise en question, mais trop peu de gens prennent en compte cet aspect inhérent à la sécurité », a déclaré l’expert.

Les clés, considérées comme plus sûres pour la MFA

Les entreprises mettent de plus en plus en œuvre l’authentification multifactorielle pour renforcer leurs défenses contre les cyberattaques toujours plus nombreuses. Les clés sont souvent considérées comme plus sûres (et moins coûteuses) que les outils logiciels, car si un pirate vole les informations d’identification du compte d’un utilisateur, il a toujours besoin du token, qui est (ou devrait être) physiquement entre les mains de son propriétaire légitime.

Les YubiKeys, comme tous dispositifs FIDO, sont un « facteur d’authentification », a expliqué Thomas Roche. « Ils peuvent jouer le rôle de deuxième facteur d’authentification (en plus d’un login/mot de passe) ou de facteur unique (comme dans les récents passkeys). Dans son rapport, celui-ci écrit que les dispositifs sont soumis au plus haut niveau d’évaluation de sécurité existant et qu’ils sont habituellement considérés comme « inviolables », même dans les pires scénarios. Ainsi, « les systèmes sécurisés complexes fondent leur sécurité sur ces scénarios ».

Un clonage de l’appareil à l’insu de l’utilisateur

Bien que très répandus, ces dispositifs ne sont manifestement pas inviolables. Avec l’attaque par canal latéral du YubiKey récemment découverte, les cybercriminels peuvent accéder à des fuites de signaux provenant d’un système cryptographique dans l’appareil. Thomas Roche a expliqué que les fuites par canal latéral sont liées à la physique même du semi-conducteur et « qu’elles ne peuvent être évitées ». Leur prévention nécessite des contre-mesures spécifiques, souvent coûteuses. Dans un scénario d’attaque réussie, un acteur malveillant peut voler l’identifiant et le mot de passe d’un utilisateur (par hameçonnage ou par d’autres méthodes), puis gagner un accès physique à son token sans qu’il le sache. Après quoi il pourra envoyer des demandes d’authentification au token tout en enregistrant des mesures sur le token latéral. Une fois le dispositif restitué, il pourra alors lancer un canal latéral pour extraire l’algorithme de signature numérique à courbe elliptique (Elliptic Curve Digital Signature Algorithm, ECDSA) lié au compte et accéder au compte sans être détecté. « Supposons qu’un pirate parvient à voler la YubiKey d’un utilisateur, l’ouvre pour accéder à la carte logique, applique l’attaque Eucleak et reconditionne la YubiKey originale à l’insu de l’utilisateur, il pourra alors créer un clone de son facteur d’authentification, c’est-à-dire une copie de sa YubiKey », a détaillé l’expert. « L’utilisateur pensera qu’il est en sécurité, alors que ce n’est pas le cas ».

La faille cryptographique se trouve dans un petit microcontrôleur de l’appareil et affecte toutes les YubiKeys et Security Keys utilisant un firmare antérieur à la version 5.7, publiée en mai. Elle concerne également les versions de la clé YubiHSM 2 antérieures à la version 2.4.0 publiée cette semaine. M. Roche a rappelé que les attaquants devaient être en possession physique d’une clé et disposer d’un équipement spécialisé souvent coûteux pour visualiser l’opération vulnérable. Ils peuvent également avoir besoin d’informations supplémentaires, notamment d’un nom d’utilisateur, d’un mot de passe ou d’un VPN. De plus, les acteurs de la menace ont besoin d’avoir une connaissance approfondie de l’ingénierie pour mener à bien une telle attaque. Dans la grande majorité des cas, les RSSI ne devraient pas s’inquiéter de l’attaque Eucleak. En effet, cette attaque vise généralement des personnes spécifiques d’une administration ou d’une organisation. Elle n’est pas « techniquement très compliquée », mais « logistiquement très difficile ». « Elle nécessite un effort considérable pour une seule cible et doit être réappliquée pour chaque cible », a-t-il poursuivi.

Remplacer les clés (mais ce n’est pas la seule option)

Les utilisateurs doivent vérifier leur YubiKey pour voir si elle a été affectée. Thomas Roche a conseillé aux entreprises de continuer à utiliser les dispositifs vulnérables plutôt que de passer à des outils alternatifs dépourvus de mécanismes de sécurité. Si l’achat d’une nouvelle clé est une option viable, il existe d’autres solutions temporaires. Il s’agit notamment d’éviter complètement l’algorithme de signature numérique à courbe elliptique ECDSA et d’opter pour d’autres algorithmes de chiffrement de bas niveau tels que l’Edwards-curve Digital Signature Algorithm (EdDSA), une variante de la cryptographie sur les courbes elliptiques, ou le système de cryptage à clé publique Rivest-Shamir-Adleman (RSA), qui a fait ses preuves. Une autre option consiste à appliquer des protocoles supplémentaires tels que les codes PIN ou la biométrie.

Les outils de contrôle des signatures et des enregistrements peuvent également être utilisés pour détecter les dispositifs FIDO clonés. Cela permet à un service web protégé par FIDO d’invalider les demandes et de verrouiller les comptes si des signaux suspects sont détectés, réduisant ainsi la capacité d’utilisation du clone à une période de temps limitée. Thomas Roche fait remarquer que, même si cette méthode d’atténuation n’est malheureusement pas obligatoire, elle est utile pour identifier, bloquer et sécuriser les comptes. Enfin, selon lui, il est toujours plus sûr d’utiliser des YubiKeys ou d’autres produits vulnérables que de ne pas en utiliser du tout.

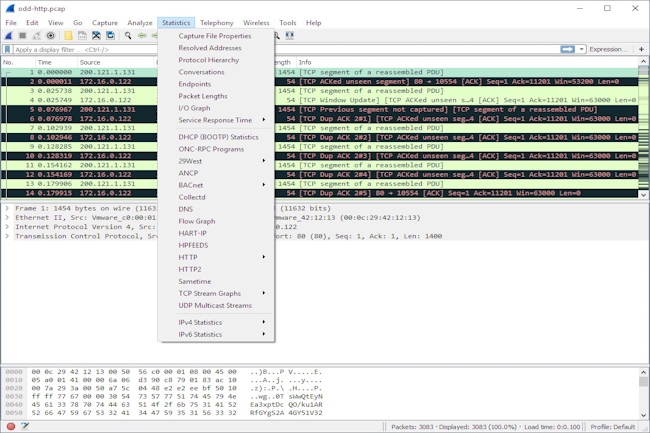

Disponible depuis le 28 août, la dernière version 4.4 de Wireshark, le célèbre analyseur de protocoles réseau open source, s’enrichit de plusieurs fonctionnalités. L’analyseur change aussi de gouvernance.

L’analyseur de protocole réseau open source Wireshark est l’une des technologies parmi les plus utilisées par les professionnels des réseaux. Les fonctionnalités ajoutées à la version 4.4, généralement disponible depuis le 28 août, visent à faciliter son utilisation et à mieux comprendre ce qui se passe sur un réseau.Cette déclinaison bénéficie notamment :- de dialogues graphiques améliorés (graphiques E/S, graphiques de flux, graphiques de flux TCP) ;- d’un changement automatique de profil en fonction des filtres d’affichage ;- de filtres d’affichage améliorés.- de la prise en charge de plusieurs protocoles supplémentaires, notamment ATN Security Label, Bit Index Explicit Replication (BIER), ZeroMQ Message Transport Protocol (ZMTP) et Matter Bluetooth Transport Protocol (MatterBTP).Wireshark a été créé en 1997 par Gerald Combs sous le nom originel d’Ethereal dont il est toujours le principal développeur. Le changement de nom a eu lieu en 2006. Selon M. Combs, les améliorations apportées par Wireshark 4.4.0 aux dialogues de graphiques, aux filtres d’affichage et aux colonnes personnalisées devraient être particulièrement utiles aux professionnels des réseaux. « Les différents dialogues de graphiques comportent un certain nombre de corrections de bogues, d’améliorations des performances et de la convivialité qui aideront les utilisateurs à analyser les données plus rapidement et plus efficacement », a déclaré le développeur. « La syntaxe du filtre d’affichage comporte aussi un certain nombre de petites améliorations qui constituent une mise à niveau notable pour les utilisateurs de tous horizons ». Le développeur fait remarquer que bon nombre des améliorations apportées au filtre d’affichage se reflètent également dans la fonction de colonnes personnalisées, qui permet aux utilisateurs de mieux contrôler le contenu de la liste des paquets. « Pour les personnes qui utilisent Wireshark quotidiennement, tous ces changements devraient améliorer considérablement leur flux de travail », a affirmé M. Combs.Changements progressifs et grandes améliorationsLa plupart des modifications apportées à Wireshark 4.4.0 sont considérées par M. Combs comme incrémentielles. Mais cela ne signifie pas qu’elles n’ont pas d’impact. « Le fait d’apporter continuellement des améliorations progressives au fil du temps peut s’avérer très puissant », a fait valoir le développeur. Le changement automatique de profil est un exemple d’amélioration progressive que l’on trouve dans cette mise à jour. Comme l’a rappelé M. Combs, cela fait de nombreuses années que Wireshark prend en charge les profils de configuration qui rendent possible la modification d’éléments comme la disposition de l’écran, les règles de coloration, l’affichage des boutons de filtrage, etc. Cette fonctionnalité permet de créer des configurations personnalisées pour différents types de trafic et d’environnements et de passer rapidement de l’une à l’autre. « La version 4.4.0 ajoute également la commutation automatique de profil, c’est-à-dire la possibilité d’associer un filtre d’affichage à un profil de configuration », a expliqué M. Combs. « Au moment de charger un nouveau fichier de capture et quand le filtre d’un profil correspond au contenu du fichier, Wireshark bascule automatiquement vers ce profil ».Une fondation pour soutenir l’analyseurAu fil des ans, Wireshark a bénéficié du soutien de plusieurs entreprises, dont Riverbed et, plus récemment, de Sysdig créé par Loris Degioanni. Sous la direction de ce dernier, la Fondation Wireshark a été officiellement créée en mars 2023 afin de fournir une gouvernance et un lieu ouvert pour l’évolution continue de la technologie open source. « Au cours de l’année écoulée, la Wireshark Foundation s’est principalement attachée à assurer la continuité de notre communauté », a précisé M. Combs. Ce dernier a fait remarquer qu’avant la création de la fondation, les aspects organisationnels du projet Wireshark étaient pris en charge par Sysdig, notamment l’infrastructure du projet et la logistique du SharkFest, la conférence des développeurs et des utilisateurs de Wireshark. « Grâce à l’aide de Sysdig, la transition du projet Wireshark a pu se dérouler en douceur et la fondation a pu fonctionner de manière autonome, ce qui est bénéfique à la fois pour le projet et pour sa communauté », a fait valoir M. Combs. « Depuis la transition, notre directrice exécutive, Sheri Najafi, a fait un excellent travail pour développer la fondation et faire avancer sa mission grâce à des initiatives comme le parrainage de Women in Technology, qui aide les femmes qui se lancent dans le domaine de la cybersécurité à assister gratuitement au SharkFest », s’est félicité M. Combs. « Nous prévoyons d’entreprendre d’autres initiatives de ce genre à l’avenir ». En ce qui concerne l’avenir de la technologie Wireshark elle-même, M. Combs se dit très enthousiaste sur le développement en cours pour 2024 et aux perspectives pour 2025. « J’ai travaillé à l’extension de Wireshark au-delà des paquets et à l’ajout de l’analyse des appels système et des journaux, et j’aurai beaucoup à dire à ce sujet dans les mois à venir », a-t-il ajouté.

L’ingénierie du chaos fait de plus en plus d’émules. Mais cette méthode de stress test des infrastructures IT comporte des avantages et des inconvénients à soupeser avant son adoption.

Après avoir eu son heure de gloire au sein de Netflix (et l’outil Chaos Monkey), l’ingénierie du chaos séduit de plus en plus d’entreprise (Mano Mano, SNCF…). Pour autant, casser volontairement un système d’information pour voir comment il réagit et l’améliorer n’est pas une décision à prendre à la légère.

Les sociétés doivent examiner attentivement les ressources exigées, les risques introduits et l’alignement de la démarche sur des objectifs stratégiques plus larges. Il est essentiel de comprendre ces facteurs pour décider si cette approche doit être un élément central ou un outil complémentaire dans la stratégie IT d’une entreprise. Chaque organisation doit déterminer dans quelle mesure elle suivra cette évolution technologique et le temps qu’elle peut attendre pour que son fournisseur IT lui propose des solutions.

Des erreurs de plus en plus fréquentes et coûteuses

Les récentes actualités montrent que les erreurs humaines (mauvaises configuration, problème de code…), les attaques de type DDoS et les pannes peuvent avoir un impact important sur la résilience des infrastructures IT. Ainsi sur les campagnes par déni de service, Cloudflare a enregistré 4 millions d’attaques au deuxième trimestre 2024, en forte progression par rapport au trimestre précédent. Les fournisseurs de cloud ne sont pas épargnés non plus par les défaillances de serveurs ou les cyberattaques. L’actualité la plus emblématique de cet été a eu lieu le 19 juillet avec la panne des services Microsoft Azure. Elle était liée à une mise à jour défectueuse du capteur Falcon de Crowdstrike. Plusieurs firmes ont été touchées avec de lourdes conséquences financières. La compagnie Delta Airlines évoque un manque à gagner de 500 M$.

Cet incident a été un signal d’alarme pour plusieurs raisons. En premier, la plupart des entreprises ont commencé à se rendre compte de leur vulnérabilité. La production pouvait s’arrêter à cause d’une erreur stupide. Deuxièmement, le coût total de cet événement a été beaucoup plus élevé que ce à quoi s’attendaient la plupart des entreprises. Il a également eu un impact plus important que prévu sur des questions non techniques comme les relations publiques et avec les clients. Enfin, l’enseignement que l’on en a tiré, c’est que le plus grand risque vient des personnes et non de la technologie. Se préparer à ces erreurs, donc de se tourner vers l’ingénierie du chaos, est donc devenu une réflexion dans nombre d’organisations, en mettant dans la balance les bénéfices et les contraintes.

Avantages de l’ingénierie du chaos

Supposons qu’une grande société du e-commerce mette en œuvre l’ingénierie du chaos pour tester la résilience de son système cloud pendant les périodes de pointe des achats. Elle utilise un outil dédié pour simuler des charges de trafic accrues qui imitent les conditions du Black Friday. L’équipe introduit délibérément des temps de latence et des arrêts de serveur aléatoires pour observer comment le système réagit au stress. Au cours de ces tests, ils découvrent des goulets d’étranglement dans l’architecture de leur base de données que les tests traditionnels auraient dû déceler. Grâce à des mesures en temps réel, ils mettent rapidement en œuvre des stratégies adaptatives comme la mise à l’échelle automatique des ressources du serveur et l’optimisation des requêtes de la base de données.

En répétant continuellement ces expériences de chaos, la plateforme de commerce électronique résiste non seulement aux pressions simulées, mais améliore sa capacité à s’adapter automatiquement aux pics inattendus. Cela garantit, ou devrait garantir, une expérience client transparente pendant les périodes de vente critiques. Cette approche proactive transforme un chaos potentiel en une opportunité de renforcer la résilience de l’infrastructure. C’est du moins l’idée.

Inconvénients de l’ingénierie du chaos

Malgré ses avantages, l’ingénierie du chaos pose des défis et des questions importants aux entreprises. En premier lieu, il y a l’intensité des ressources mobilisées. En effet, la mise en œuvre de cette méthode nécessite des investissements substantiels dans les bons outils, du personnel qualifié et du temps pour simuler et analyser efficacement les scénarios. Cela peut grever les budgets et détourner l’attention des principaux objectifs de l’entreprise. Autre point de friction, les possibles impacts opérationnels car l’introduction intentionnelle d’erreurs comporte des risques inhérents. Les sociétés doivent être prudentes, car ces pratiques peuvent perturber les services, affecter les performances et créer des effets secondaires indésirables susceptibles d’entraîner le mécontentement des clients ou des pertes financières.

Par ailleurs, l’ingénierie du chaos peut détourner l’attention d’initiatives plus stratégiques. Les entreprises donnent souvent la priorité à des projets simples, basés sur le retour sur investissement, qui contribuent directement à la croissance. S’engager à fond dans la méthode pourrait les détourner de la poursuite d’innovations ou d’améliorations opérationnelles qui présentent des avantages immédiats. Il faut aussi prendre en considération la gestion de la complexité. L’ingénierie du chaos exige une compréhension approfondie des interdépendances au sein des systèmes. Un défi qui pourrait dissuader les entreprises d’appliquer efficacement les principes de cette démarche.

Une choix réfléchi et équilibré

L’ingénierie du chaos offre un mécanisme de défense proactif contre les faiblesses des systèmes, mais les sociétés doivent en évaluer les risques par rapport à leurs objectifs stratégiques. Investir massivement dans l’ingénierie du chaos peut être justifié pour certains, en particulier dans les secteurs où la disponibilité et la fiabilité sont cruciaux. D’autres, en revanche, feraient mieux de se concentrer sur l’amélioration des normes de cybersécurité, la mise à jour de l’infrastructure et le recrutement de talents.

Par ailleurs, il y a lieu de se demander ce que comptent offrir les fournisseurs de services cloud en la matière ? Beaucoup d’entreprises se lancent sur les clouds publics parce qu’elles veulent transférer une partie de la charge aux fournisseurs, y compris l’ingénierie de la fiabilité. Parfois, le modèle de responsabilité partagée est trop axé sur les souhaits des fournisseurs de cloud plutôt que sur ceux de leurs clients. Il est peut-être temps que certains acteurs cloud passent à la vitesse supérieure. Certains l’ont déjà fait comme AWS. En fin de compte, les entreprises devraient réfléchir à la manière dont l’ingénierie du chaos s’inscrit dans leur stratégie IT plus large. En intégrant des éléments qui correspondent à leurs objectifs plutôt qu’en adoptant la méthode en bloc, les sociétés peuvent bénéficier des idées sans être détournées de leurs missions principales. Comme pour toute innovation, la clé réside dans une application judicieuse.

Une étude de Cisco Talos montre que l’activité de la franchise de ransomware BlackByte a été plus intense qu’estimée. Le groupe de cybercriminels a modifié et fait évoluer ses tactiques et ses outils au fil du temps.

Il ne faut pas se fier aux sites de revendications des groupes de ransomware pour établir un baromètre de leurs activités. Des chercheurs de Talos, division cybersécurité de Cisco, ont trouvé que le nombre de victimes répertoriées par BlackByte sur son site ne représente que 20 à 30% des compromissions du groupe de ransomware. De plus, les attaques récemment analysées montrent des changements de tactiques et un autre variant de son chiffreur de fichiers.

Un pic d’activité passé sous le radar

Dans son rapport, les experts de Talos spécialisés en réponse à incident et threat intelligence ont « remarqué des similitudes étroites entre les indicateurs de compromission (IOC) découverts au cours de l’enquête et d’autres événements signalés dans la télémétrie globale de Talos ». Ils ajoutent qu’ « un examen plus approfondi de ces similitudes a permis de mieux comprendre la stratégie actuelle de BlackByte et a révélé que le groupe a été beaucoup plus actif qu’il n’y paraît au vu du nombre de victimes publié sur son site de fuites de données. »

La raison pour laquelle le cybergang ne publie pas toutes les compromissions réussies sur son site n’est pas claire. Il se peut que ce soit pour éviter d’attirer trop d’attention ou que certaines victimes acceptent de payer avant qu’il ne soit nécessaire de les répertorier. Il est également possible que toutes les attaques de BlackByte n’aboutissent pas à une exfiltration de données. Les chercheurs donnent un exemple où l’outil d’exfiltration des données nommé ExByte a été déployé mais sans confirmer avec certitude que des données ont été dérobées.

Une émanation de Conti

BlackByte est un groupe de ransomware-as-a-service (RaaS) apparu pour la première fois fin 2021 et qui est soupçonnée d’être une ramification de Conti, gang de premier plan qui s’est dissous en mai 2022 après avoir attiré trop d’attention et commis une série d’erreurs opérationnelles. Après l’invasion de l’Ukraine par la Russie en février 2022, de nombreux groupes de cybercriminels se sont déclarés neutres d’autant plus que beaucoup d’entre eux étaient à la fois en Russie et en Ukraine.

Mais Conti s’est publiquement rangé du côté de la Russie et a menacé de cibler les infrastructures critiques occidentales en représailles, ce qui a probablement incité certains de ses affiliés à prendre leurs distances par rapport au groupe. Après la fin de Conti, plusieurs franchises sont apparues. BlackByte, Black Basta et KaraKurt se sont rapidement distingués comme trois nouveaux groupes ayant adopté un code, des outils et des tactiques très similaires à ceux précédemment associés à Conti

Des outils et des attaques affinés

Si BlackByte a conservé les mêmes tactiques, techniques et procédures (TTP) depuis sa création, les attaques les plus récentes en ont révélé d’autres. Par exemple, le groupe est connu pour avoir déployé un chiffreur de ransomware de type ver qui se propage de lui-même et qui est personnalisé pour chaque victime à l’aide d’identifiants SMB et NTLM codés en dur et volés à l’intérieur du réseau ciblé. Bien que ce procédé serve toujours, le chiffreur de fichiers a été remanié au fil du temps dans plusieurs langages de programmation : Go, .NET et enfin C++. La dernière variante observée par Cisco Talos ajoute l’extension « blackbytent_h » aux fichiers chiffrés.

Le groupe était également connu pour déployer plusieurs pilotes officiels mais vulnérables sur des systèmes compromis afin de les utiliser pour l’escalade des privilèges et d’autres tâches. Pour cette technique, connue sous le nom de BYOVD (bring your own vulnerable driver), BlackByte était connu pour utiliser trois pilotes spécifiques : RtCore64.sys, utilisé à l’origine par l’utilitaire d’overclocking MSI Afterburner ; DBUtil_2_3.sys, issu de l’utilitaire de mise à jour du firmware Dell Client ; et gdrv.sys, un driver du logiciel Gigabyte Tools pour les cartes mères du fournisseur. Lors d’attaques récentes, le gang a ajouté un quatrième pilote appelé zamguard64.sys, qui fait partie de l’application Zemana Anti-Malware (ZAM). Il présente une vulnérabilité qui peut être utilisée pour mettre fin à d’autres processus et pour désactiver les produits EDR sur les ordinateurs des victimes. La franchise s’intéresse par ailleurs aux environnements virtuels avec l’exploitation de la vulnérabilité CVE-2024-37085 de contournement de l’authentification dans VMware ESXi quelques jours après sa divulgation publique. La faille permet aux membres d’un groupe Active Directory appelé « ESX Admins » de contrôler les machines virtuelles sur les hôtes ESXi.

Des mesures d’atténuations recommandées

Cisco Talos recommande aux entreprises de mettre en œuvre les MFA pour toutes les connexions à distance et dans le cloud et d’auditer leurs configurations VPN. Les sociétés devraient également mettre en place des alertes pour les changements dans les groupes privilégiés d’Active Directory et limiter ou désactiver l’utilisation de NTLM à l’intérieur de leurs réseaux. Un protocole d’authentification que Microsoft a abandonné au profit de Kerberos. SMBv1, un autre protocole ancien, devrait également être désactivé et les versions plus récentes de SMB devraient être signées et cryptées. Tous les comptes fournisseurs et les fonctions d’accès à distance qui ne sont pas utilisés devraient également être désactivés et des détections de politiques Windows Defender et d’objets de stratégie de groupe non autorisés devraient être déployées sur les systèmes.

Les accords signés par OpenAI et Anthropic avec l’Institut américain de sécurité de l’IA dépendant du NIST prévoient une validation amont des dernières versions de ChatGPT et de Claude avant publication. Un moyen de s’assurer de la sécurité de ces LLM et de s’engager aussi sur l’évaluation des capacités et des méthodes d’atténuation des risques.

Les fournisseurs de grands modèles de langage (LLM) OpenAI et Anthropic ont signé des accords individuels avec l’institut américain de sécurité de l’IA (US AI Safety Institute) rattaché au NIST (institut national des normes et de la technologie du ministère du commerce américain. Objectif : collaborer à la recherche sur la sécurité de l’IA, qui comprend des tests et des évaluations. Dans le cadre de ces accords, les deux sociétés vont partager leurs derniers modèles avec l’institut avant qu’ils ne soient mis à la disposition du public pour des contrôles de sécurité. « Grâce à ces accords, nous sommes impatients de commencer nos collaborations techniques avec Anthropic et OpenAI pour faire progresser la science de la sécurité de l’IA », a déclaré Elizabeth Kelly, directrice de l’Institut américain de sécurité de l’IA, dans un communiqué.

Les accords prévoient une recherche collaborative sur la manière d’évaluer les capacités et les risques pour la sécurité, ainsi que sur les méthodes permettant d’atténuer ces risques. Ces accords interviennent près d’un an après que le président américain Joe Biden a adopté un décret visant à mettre en place une série complète de normes, de mesures de protection de la sécurité et de la vie privée et de mesures de surveillance pour le développement et l’utilisation de l’intelligence artificielle. Début juillet le NIST a publié un logiciel libre appelé Dioptra disponible sur GitHub pour les développeurs afin de déterminer le type d’attaques qui rendraient un modèle d’intelligence artificielle moins performant. Outre Dioptra, le NIST a également publié plusieurs documents visant à promouvoir la sécurité et les normes en matière d’IA, conformément au décret. Ces documents comprennent la première version de ses lignes directrices pour le développement de modèles de base, intitulées Managing Misuse Risk for Dual-Use Foundation Models, et deux documents d’orientation qui serviront de ressources complémentaires au cadre de gestion des risques de l’IA (AI RMF) et au cadre de développement de logiciels sécurisés (SSDF) du NIST, destinés à aider les développeurs à gérer les risques de la GenAI.

Une approche de sécurité de l’IA au diapason du Royaume-Uni

Les accords avec les fournisseurs de LLM comprennent également une clause qui permettra à l’institut de sécurité américain de fournir un retour d’information aux deux entreprises sur les améliorations potentielles à apporter à leurs modèles en matière de sécurité, en collaboration avec leurs partenaires de l’institut de sécurité de l’IA du Royaume-Uni. Au début du mois d’avril, les États-Unis et le Royaume-Uni ont signé un accord visant à tester les LLM de sécurité qui sous-tendent les systèmes d’IA. L’accord – ou protocole d’accord – a été signé à Washington par Gina Raimondo, secrétaire au commerce des États-Unis, et Michelle Donelan, secrétaire à la technologie du Royaume-Uni, et la collaboration entre les instituts de sécurité de l’IA découle directement de cet accord.

Les accords signés par OpenAI et Anthropic interviennent au moment où le projet de loi californien sur la sécurité de l’intelligence artificielle entre dans sa phase finale de transformation en loi. Celui-ci pourrait établir la réglementation la plus stricte du pays en matière d’IA et ouvrir la voie à d’autres similaires dans l’ensemble du pays. Le projet de loi, intitulé « Safe and Secure Innovation for Frontier Artificial Intelligence Models Act » (SB 1047), propose des tests rigoureux et des mesures de responsabilisation pour les développeurs d’IA, en particulier ceux qui créent des modèles complexes et de grande envergure. S’il est adopté, le projet de loi obligera les entreprises d’IA à tester la sécurité de leurs systèmes avant de les mettre à la disposition du public. Au début du mois, l’OpenAI s’est opposée au projet de loi pendant au moins cinq jours avant de s’engager à le soutenir la semaine dernière.

Le NIST a par ailleurs pris d’autres mesures, notamment la formation d’un groupe consultatif sur la sécurité de l’IA en février dernier, qui comprend des créateurs d’IA, des utilisateurs et des universitaires, afin de mettre en place des garde-fous pour l’utilisation et le développement de l’IA. Le groupe consultatif, baptisé US AI Safety Institute Consortium (AISIC), a été chargé d’élaborer des lignes directrices concernant les systèmes d’IA en équipe restreinte, l’évaluation de la capacité de l’IA, la gestion des risques, la garantie de la sûreté et de la sécurité, et le filigrane des contenus générés par l’IA. Plusieurs grandes entreprises technologiques, dont OpenAI, Meta, Google, Microsoft, Amazon, Intel et Nvidia, ont rejoint le consortium afin de garantir le développement sûr de l’IA.