Le géant des réseaux intègre activement des capacités d’IA dans Cisco Security Cloud et au-delà.

L’équipementier Cisco a fourni davantage de détails sur ses projets d’intégration de l’intelligence artificielle dans son portefeuille de produits, sans doute l’un des plus grands de l’industrie technologique. Et même si l’événement Cisco Live qui s’est tenu cette semaine (2 au 6 juin) à Las Vegas n’a pas donné lieu à des annonces fracassantes, les participants ont pu avoir un aperçu des fonctionnalités et des capacités qui seront introduites prochainement dans un grand nombre de produits et services. Prises dans leur ensemble, ces fonctionnalités et ces capacités témoignent d’une transformation progressive de l’offre de Cisco et de sa volonté de soutenir, et d’utiliser, l’IA dans toute l’entreprise.

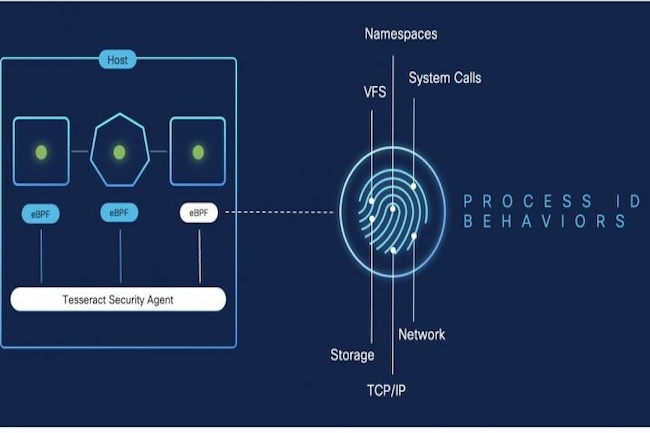

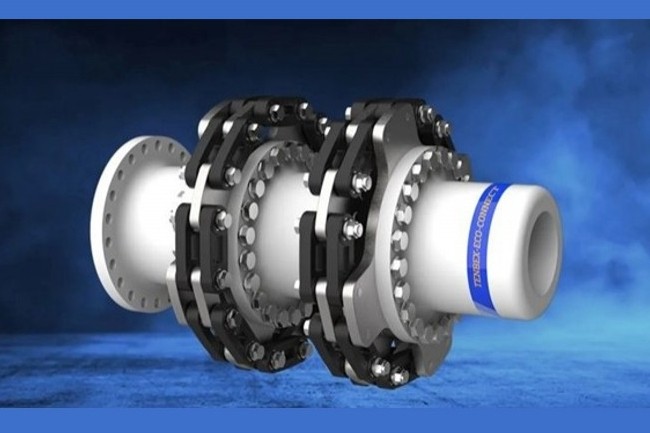

Hypershield, un système de sécurité du cloud hyperscale annoncé en avril en tant qu’extension de Security Cloud, prend désormais en charge les unités de traitement de données (Data Processing Unit, DPU) Pensando d’AMD, une plateforme matérielle destinée à accélérer les charges de travail d’IA. « Celles-ci seront intégrées dans les serveurs Unified Computing System (UCS) de Cisco d’ici à la fin de l’année 2024 », a indiqué l’entreprise. Plus haut dans la pile, Security Cloud inclut à présent une couche de gestion activée par l’IA appelée Security Cloud Control. Présentée par Cisco comme « AI Native » et disponible à partir de septembre, cette couche automatise les réponses de sécurité dans les environnements cloud hybrides sans intervention humaine.

Enfin, Cisco Live ne serait pas un événement Cisco sans au moins une annonce de pare-feu. Bien sûr, l’entreprise fait la promotion de sa série Firewall 1200 qui, selon elle, résout le problème de la prolifération du matériel réseau qui rend le SD-WAN plus difficile à mettre en œuvre qu’il ne devrait l’être. « Disponible en octobre, cette série s’adresse aux réseaux de succursales qui cherchent à consolider plusieurs routeurs et commutateurs dans un espace plus compact », a déclaré le fournisseur.

De l’IA pour ThousandEyes

L’entreprise a également ajouté des capacités IA à sa plateforme de performance et d’intelligence réseau ThousandEyes. Grâce à cela, les clients disposent d’une vue unifiée de la télémétrie dans tous leurs environnements cloud, ce qui serait impossible sans la capacité de l’IA à traiter de grands volumes de données. « La majorité des pannes sont imputables à une erreur de l’opérateur », a expliqué Jonathan Davidson, vice-président exécutif et directeur général de Cisco Networking. « Digital Experience Assurance powered by ThousandEyes permet une remédiation proactive et automatisée des événements et peut même corréler les historiques de configuration entre l’infrastructure sur site détenue par l’entreprise et son infrastructure de cloud public. Entre une panne de quatre heures et une interruption de quatre minutes, ça peut faire une grande différence ».

Couche d’abstraction de la sécurité

Selon Chintan Patel, directeur technique de Cisco pour le Royaume-Uni et l’Irlande, l’IA est devenue un véritable casse-tête pour les clients, qui veulent profiter de ses avantages dès que possible, mais savent qu’ils n’ont pas l’infrastructure nécessaire pour y parvenir. « On ne peut pas se contenter d’ajouter des fonctions d’IA aux logiciels en haut de la pile si le matériel sous-jacent et l’intégration entre les différentes couches de technologie ne peuvent pas les prendre en charge », a-t-il expliqué. « C’est la raison pour laquelle Cisco se concentre désormais sur l’innovation à travers chaque couche de la pile matérielle et logicielle », a-t-il ajouté.

« La fragmentation des chaînes d’approvisionnement numériques qui va de pair avec la dépendance toujours plus grande des entreprises aux plateformes tierces offre un bon exemple de cette complexité », a déclaré M. Patel. « Toute la numérisation engagée après la pandémie a introduit plus de couches à l’expérience numérique comme jamais auparavant, et si les entreprises possèdent certaines infrastructures, elles sont devenues dépendantes de celles qu’elles ne possèdent pas ».

Cette complexité introduit des milliers de points de défaillance et d’angles morts en matière de sécurité, les interfaces de gestion et les technologies différentes que proposent les principaux fournisseurs de cloud ne rendent pas les choses plus faciles. Dans ce contexte, Security Cloud de Cisco pourrait agir comme une couche d’abstraction qui protège les entreprises. « Nous pouvons aider nos clients à simplifier ces environnements et à réduire cette complexité », a affirmé M. Patel. Les unités de traitement de données (Data Processing Unit ou DPU) Pensando d’AMD prennent désormais en charge le système de sécurité cloud Hypershield de Cisco.

Une vulnérabilité a été découverte dans l’application EmbedAI. Elle peut être exploitée pour tromper un utilisateur et lui faire télécharger à son insu des données incorrectes dans le LLM de l’application.

Avec l’engouement autour de l’IA, les spécialistes la cybersécurité se penchent sur le sujet pour détecter et dénicher des failles dans les différentes solutions proposées. C’est ce que vient de faire Synopsys qui a découvert une vulnérabilité d’empoisonnement des données dans l’application EmbedAI, spécialisée dans la création de chatbot via ChatGPT et Gemini. « Cette faille pourrait compromettre l’application et entraîner des entrées non autorisées ou des attaques par empoisonnement de données », a déclaré Synopsys dans un blog. « L’exploitation de cette vulnérabilité peut perturber le fonctionnement immédiat du modèle et avoir des effets durables sur sa fiabilité et la sécurité des systèmes qui en dépendent ». La CVE-2024-5185, dont le score CVSS est de 7,5/10, affecte la branche « principale » d’EmbedAI.

Une faille CSRF

Selon Synopsys, EmbedAI est confronté à une faille CSRF (cross-site request forgery), une vulnérabilité de sécurité web où les pirates incitent les utilisateurs finaux à exécuter des actions non désirées sur une application web dans laquelle ils sont actuellement authentifiés. « Ces attaques sont rendues possibles par une vulnérabilité CSRF (cross-site request forgery) résultant de l’absence d’implémentation de la gestion des sessions sécurisées et de politiques de partage de ressources inter-origines faibles », a expliqué l’éditeur.

Dans le contexte des LLM, le bug autorise des tentatives malveillantes pour inciter les utilisateurs victimes à télécharger des données empoisonnées dans leur modèle de langage. Les applications utilisant le composant EmbedAI peuvent ainsi être exposées à des fuites de données potentielles. En outre, la compromission des données peut nuire aux applications de l’utilisateur de bien d’autres façons, notamment en diffusant des informations erronées, en introduisant des biais, en dégradant les performances et en risquant de provoquer des attaques par déni de service.

L’isolation des applications peut aider

Synopsys fait remarquer que la seule solution disponible pour remédier à ce problème est d’isoler les applications potentiellement affectées des réseaux intégrés. Dans son blog, le Cybersecurity Research Center (CyRC) de Synopsys « recommande de déconnecter immédiatement les applications des réseaux » en ajoutant qu’il a informé les développeurs au sujet de la vulnérabilité, mais qu’il n’a pas eu de réponse de leur part dans le délai de 90 jours imposé par sa politique de divulgation responsable. La vulnérabilité a été découverte par Mohammed Alshehri, chercheur en sécurité chez Synopsys. « Certains produits prennent une implémentation existante de l’IA et la fusionnent pour créer quelque chose de nouveau », a expliqué le chercheur lors d’un entretien avec DarkReeading.

« Ce que nous voulons souligner ici, c’est que même après l’intégration, les entreprises devraient tester pour s’assurer que les mêmes contrôles mis en place pour les applications Web sont également mis en œuvre sur les API pour leurs applications d’IA. » Le travail de recherche montre que l’intégration rapide de l’IA dans les opérations métiers comporte des risques, en particulier pour les entreprises qui accordent aux LLM et autres applications d’IA générative (GenAI) d’accéder à de vastes référentiels de données. Même si ce domaine est très nouveau, les fournisseurs de sécurité comme Dig Security, Securiti, Protect AI, eSentire, etc. se démènent déjà pour mettre en place une défense contre les menaces GenAI en constante évolution.

Selon la maison mère du spécialiste en vente de billets Ticketmaster touchée par une violation massive de données et revendiquée par un cybercriminel, celle-ci proviendrait du vol d’informations d’identification utilisées par l’un des partenaires cloud de sa filiale. Certains parlent de Snowflake qui a démenti.

Après qu’un groupe de cybercriminels a affirmé avoir volé les données de 560 millions de clients de Ticketmaster, la société mère de l’entreprise de vente et de distribution de billets a mené l’enquête. Suite à ces investigations, elle a déclaré vendredi dernier à la commission des marchés financiers (SEC) des États-Unis avoir identifié une activité non autorisée avec l’un des partenaires cloud de sa filiale. « Le 20 mai 2024, Live Nation Entertainment a identifié une activité non autorisée dans un environnement de base de données cloud tiers contenant des informations d’entreprise – principalement de sa filiale Ticketmaster LLC – et a lancé une enquête avec des enquêteurs assermentés pour comprendre ce qui s’est passé », indique la SEC. Le dossier ne mentionne pas le nombre de comptes clients concernés, mais il semble faire référence aux revendications du groupe de cybercriminels ShinyHunters.

« Le 27 mai 2024, un acteur de la cybermenace a mis en vente sur le dark web ce qu’il prétendait être des données d’utilisateurs de l’entreprise. Nous nous efforçons d’atténuer les risques pour nos utilisateurs et pour l’entreprise, et nous avons informé les forces de l’ordre et coopérons avec elles. Le cas échéant, nous informons également les autorités réglementaires et les utilisateurs de l’accès non autorisé à des informations personnelles », a expliqué LiveNation. Cette société fait actuellement l’objet de poursuites antitrust (avec demande de démantèlement) par le gouvernement américain pour avoir gonflé illégalement le prix des billets, et déclaré qu’elle ne pensait pas que la violation aurait un impact important sur ses activités ou sa situation financière. « Nous continuons à évaluer les risques et nos efforts de remédiation se poursuivent », a aussi indiqué LiveNation.

Le partenaire cloud à l’origine de la violation pas encore identifié

L’entreprise n’a pas identifié le partenaire cloud en question, mais l’un de ses fournisseurs cloud – Snowflake – a publié de son côté sa propre déclaration le 2 juin, faisant référence aussi à une « activité cybermalveillante ». Plusieurs médias ont fait le lien entre la situation de Ticketmaster et la déclaration de Snowflake, mais le RSSI n’a pas pu confirmer avec certitude que les deux incidents étaient liés. Le fournisseur de datawarehouse cloud a déclaré dans son communiqué qu’il avait récemment observé et enquêté sur une augmentation des menaces ciblant certains comptes de ses clients.

« Nous pensons qu’il s’agit du résultat d’attaques en cours ciblant les identités dans l’ensemble de l’industrie avec l’intention d’obtenir des données sur les clients. Les recherches indiquent que ces types d’attaques sont menées à l’aide des informations d’identification de nos clients qui ont été exposées dans le cadre d’une cybermenace sans rapport avec le sujet », a déclaré la société. « À ce jour, nous ne pensons pas que cette activité soit causée par une vulnérabilité, une mauvaise configuration ou une activité malveillante au sein du produit Snowflake. Tout au long de notre enquête en cours, nous avons rapidement informé le nombre limité de clients qui, selon nous, ont pu être affectés ». L’éditeur revendique quelque 9 437 clients, dont Albertsons, JetBlue, Honeywell, Disney, MasterCard, Pfizer et Petco.

Des dommages propagés à d’autres environnements cloud ?

Danielle Stepien, CEO d’Igniter Engineering, qui travaille dans le domaine de la cybersécurité pour l’aérospatiale et d’autres secteurs verticaux connexes, craint que cet exploit de faille ne soit le signe d’une menace généralisée. « S’il s’agit d’une attaque par ransomware, il pourrait s’agir d’une sorte d’infection qui aurait un impact considérable sur les opérations commerciales et pourrait affecter les chaînes d’approvisionnement, d’autres systèmes dont nous n’avons pas encore connaissance publiquement, et bien plus encore », explique-t-il. « Le fait que le piratage ait été effectué dans le cloud est une mauvaise chose, car il peut affecter n’importe quel autre système utilisant le même cloud », ajoute-t-il. Danielle Stepien précise par ailleurs que la nature de ce type d’exposition à des tiers pourrait étendre les dommages avec une escalade du risque cyber.

« Les piratages de bases de données ont d’énormes implications, qu’ils aient lieu dans le cloud ou sur site. Vous n’avez aucune idée de la façon dont une base de données est connectée à toutes les autres bases de données, car il s’agit évidemment d’une connaissance propriétaire », a fait savoir Danielle Stepien. « Si elles sont connectées, les conséquences sur les opérations commerciales sont énormes pour tout ce qui est touché. »

Les dernières directives de la SEC en matière de déclaration d’incidents suivies

Il semble que Live Nation ait pris au sérieux les récentes directives révisées de la SEC concernant le formulaire de déclaration à utiliser lorsqu’un incident de sécurité n’est pas clairement établi, en l’occurrence le 8.01. La confusion qui règne autour des exigences de la SEC en matière de déclaration tient en partie au fait que les entreprises sont désormais invitées à déterminer si un incident est important avant de le déclarer. Une fois qu’elles l’ont fait, elles disposent alors de quatre jours pour déposer un rapport. Or, de nombreuses entreprises, dont Live Nation, indiquent à la SEC qu’elles n’ont pas encore déterminé l’importance de l’incident. Reste à savoir (et comprendre) en quoi ces informations vont être utiles aux investisseurs.

En règle générale, une entreprise considère un événement établit en fonction de l’impact probable sur le chiffre d’affaires et/ou le résultat net. Pour les grandes entreprises – le dernier chiffre d’affaires annuel de Live Nation s’élevait à 22,7 Md$ – cela ne se produit généralement que lorsque l’entreprise s’attend à ce qu’un grand nombre de clients quittent l’entreprise à cause de l’incident ou à ce qu’elle perde une grande partie de son chiffre d’affaires en raison du départ de certains de ses plus gros clients. Dans le cas de Ticketmaster, cela ne se produirait que si les consommateurs allaient acheter des billets de spectacle ailleurs. Or aux États-Unis, il existe peu de commerçants alternatifs, ce qui suggère qu’une cyberattaque ne deviendrait importante que si elle aliénait un grand nombre de lieux de spectacles et/ou impactait la production d’artistes majeurs. Dans le cas présent, l’attaque n’a même pas visé l’entreprise, mais un de ses partenaires IT dans le cloud, ce qui rend encore plus complexe à déterminer de l’importance de l’attaque.

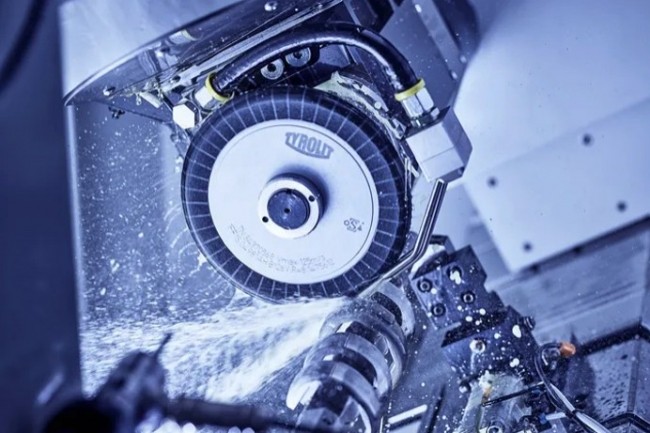

Tyrolit, fabricant autrichien de machines et d’outils pour le BTP, pilote toute son activité avec SAP. Quand il a dû migrer vers S/4 Hana, il a imposé de réaliser l’opération en un week-end.

L’industriel autrichien Tyrolit, dont le siège est à Schwaz au Tyrol, fabrique des machines et outils de tronçonnage, de sciage, de carottage entre autres, pour le secteur du BTP. Il pilote toute son activité, et en particulier sa production, à partir de son ERP SAP. Pas question donc d’interrompre le fonctionnement de ce dernier sans mettre en danger l’entreprise.Un hébergement en datacenter Tier 3+Quand il a souhaité migrer vers la version S4/Hana de la solution, il a donc exigé de ses potentiels partenaires une interruption de service la moins longue possible durant la transition. Il a finalement fait appel à son ancienne filiale de services IT devenue indépendante, Tycom Digital, et à l’ESN Kyndryl. Les deux prestataires ont réussi à limiter le délai d’interruption à un week-end, du vendredi à 13 heures jusqu’au dimanche après-midi, ce qui a permis de maintenir certains processus en activité tout en réalisant progressivement les mises à niveau et les modifications du système.L’industriel en a profité pour migrer son ERP dans un environnement fiable et sécurisé. Pour cela, il a opté pour une gestion et une exploitation de son infrastructure SAP en service managé dans un datacenter Kyndril de type Tier 3+. Tous les équipements ainsi que l’alimentation électrique et le système de refroidissement sont redondés et le datacenter dispose d’un accès de secours au réseau de communications. La nouvelle infrastructure hébergée garantit moins de deux heures d’arrêt par an à l’industriel.Tyrolit en faits et chiffresActivité : fabrication d’outils de rectification, de tronçonnage, de sciage, de carottage et de dressage métallique et fournisseur de machines et outils pour le bâtiment (Groupe Swarovski)Siège : Schwaz (Autriche)Date de création : 1919CA 2023 : 740 M€Effectifs : 4500 employésInternational : présence dans plus de 140 pays, avec plus de 30 sites de production

Les modèles d’IA générative open source peuvent être téléchargés librement, utilisés à grande échelle sans coûts d’appels d’API et exécutés en toute sécurité derrière les pare-feu des entreprises. Mais ne baissez pas la garde. Car des risques sont bel et bien présents.

Selon le rapport AI Index de Stanford, publié en avril, 149 modèles de base ont été publiés en 2023, dont deux tiers en open source. Et il existe un nombre impressionnant de variantes. Hugging Face suit actuellement plus de 80 000 LLM pour la seule génération de texte et dispose heureusement d’un tableau qui vous permet de trier rapidement les modèles en fonction de leurs résultats à divers tests de référence. Et ces modèles, bien qu’ils soient en retard technologiquement par rapport aux grands modèles commerciaux, s’améliorent rapidement.Les classements constituent un bon point de départ pour étudier l’IA générative open source, selon David Guarrera, responsable de l’IA générative chez EY Americas. Et Hugging Face en particulier a fait un bon travail d’analyse comparative, dit-il. « Mais il ne faut pas sous-estimer la valeur d’utilisation de ces modèles, relève-t-il. Comme il s’agit de logiciel libre, il est facile de tester ces modèles et de les échanger. » Et d’ajouter que l’écart de performance entre les modèles open source et leurs alternatives commerciales se réduit.« L’open source est une excellente chose et s’avère extrêmement utile, ajoute Val Marchevsky, responsable de l’ingénierie chez Uber Freight (le service logistique d’Uber). Non seulement les modèles ouverts rattrapent les modèles propriétaires en termes de performances, mais certains offrent des niveaux de transparence que les sources fermées ne peuvent égaler. Certains modèles open source permettent de voir ce qui est utilisé pour l’inférence et ce qui ne l’est pas. Or, l’auditabilité est importante pour éviter les hallucinations. » Et puis, bien sûr, il y a l’avantage du prix. « Si vous disposez d’un datacenter avec de la capacité disponible, pourquoi payer quelqu’un d’autre ? », reprend Val Marchevsky.Les entreprises sont déjà très habituées à utiliser du code source ouvert. Selon l’analyse de sécurité et de risque de Synopsys publiée en février dernier, 96 % de toutes les bases de code de logiciels commerciaux renferment des composants open source.Fortes de cette expérience, les entreprises connaissent déjà les bonnes pratiques pour s’assurer qu’elles utilisent du code sous une licence appropriée et qu’elles disposent de versions à jour et dûment patchées. Toutefois, certaines de ces meilleures pratiques doivent être adaptées au contexte particulier de l’IA générative. Revue de détails.1. Bizarreries des nouvelles licencesLe paysage des différents types de licences open source est déjà assez compliqué. Un projet peut-il être utilisé à des fins commerciales ou seulement à des fins non commerciales ? Peut-il être modifié et distribué ? Peut-il être incorporé en toute sécurité dans une base de code propriétaire ? Mais, avec l’IA générative, un certain nombre de nouveaux problèmes se font jour. Tout d’abord, il existe de nouveaux types de licences qui ne sont libres que dans le cadre d’une définition très souple du terme.Prenons par exemple la licence Llama. La famille de modèles Llama fait partie des meilleurs LLM open source existants, mais Meta la décrit officiellement comme une « licence commerciale sur mesure qui équilibre le libre accès aux modèles avec des clauses de responsabilité et des protections mises en place pour aider à traiter les abus potentiels ».Les entreprises sont autorisées à utiliser les modèles à des fins commerciales et les développeurs à créer et à distribuer des travaux supplémentaires à partir des modèles Llama de base, mais elles ne sont pas autorisées à utiliser les résultats de Llama pour améliorer d’autres LLM, à moins qu’il ne s’agisse eux-mêmes de dérivés de Llama. Et si les entreprises – ou leurs filiales – comptent plus de 700 utilisateurs mensuels, elles doivent demander une licence que Meta peut ou non leur accorder. Si elles utilisent Llama 3, elles doivent inclure la mention « Built with Llama 3 » dans leurs applications à un endroit bien visible.De même, Apple vient de publier OpenELM sous la « Apple Sample Code License », qui a également été inventée pour l’occasion et ne couvre que les notions de droits d’auteur, à l’exclusion de la question des brevets.Ni Apple ni Meta n’utilisent les licences open source communément acceptées, mais le code est en fait ouvert. Apple a en effet publié non seulement le code, mais aussi les paramètres du modèle, l’ensemble des données d’entraînement, les logs d’entraînement et les configurations de pré-entraînement. Ce qui nous amène à l’autre aspect des licences open source. Les logiciels open source traditionnels ne sont rien d’autre que du code. Le fait qu’il soit open source signifie que vous pouvez étudier son fonctionnement, les problèmes potentiels ou la présence de vulnérabilités.L’IA générative, cependant, n’est pas seulement du code. Il y a aussi les données d’entraînement, les paramètres des modèles et le fine-tuning. Tous ces éléments sont essentiels pour comprendre le fonctionnement d’un modèle et identifier ses biais potentiels. Un modèle formé à partir, par exemple, d’une archive de théories du complot sur la terre plate ne répondra pas bien aux questions scientifiques, ou un modèle mis au point par des pirates nord-coréens ne parviendra pas à identifier correctement les logiciels malveillants. Les LLM à source ouverte divulguent-ils donc toutes ces informations ? Cela dépend du modèle, voire de la version spécifique du modèle, puisqu’il n’existe pas de normes en la matière.« Parfois, ils mettent le code à disposition, mais si vous ne disposez pas des réglages de fine-tuning, vous risquez de dépenser beaucoup d’argent pour obtenir des performances comparables », explique Anand Rao, professeur d’IA à l’université Carnegie Mellon et ancien responsable de l’IA chez PwC.2. Pénurie de compétencesL’open source est souvent un projet à réaliser soi-même. Les entreprises peuvent télécharger le code, mais elles ont ensuite besoin d’une expertise interne ou de consultants pour que le projet aboutisse. Un gros problème dans le domaine de l’IA générative. Personne ne possède des années d’expérience sur le sujet, car la technologie est très récente. Si une entreprise débute dans l’IA générative ou si elle veut avancer rapidement, il est plus sûr de commencer par une plateforme propriétaire, indique Anand Rao.Au début de la courbe d’apprentissage, « il faut de l’expertise pour télécharger la version open source, explique-t-il. Mais une fois qu’une entreprise a fait son PoC, qu’elle déploie le modèle en production et que les factures commencent à s’accumuler, il est peut-être temps d’envisager un retour à des alternatives open source », ajoute-t-il.Le manque d’expertise crée également un autre problème dans l’IA générative open source. L’un des principaux avantages de l’open source est que de nombreuses personnes examinent le code et peuvent repérer les erreurs de programmation, les failles de sécurité et autres faiblesses. Mais cette approche « à mille yeux » de la sécurité de l’open source ne fonctionne qu’en présence… d’un millier d’yeux capables de comprendre ce qu’ils voient. Ce qui n’est pas (encore) le cas dans l’IA générative.3. JailbreakingLes LLM sont notoirement sensibles au « jailbreaking », c’est-à-dire qu’un utilisateur leur donne une instruction intelligente qui les incite à violer leurs directives et, par exemple, à générer des logiciels malveillants. Dans les projets commerciaux, les éditeurs consacrent des moyens importants à identifier ces failles et à les combler au fur et à mesure. En outre, ces fournisseurs ont accès aux prompts que les utilisateurs envoient aux versions publiques des modèles, de sorte qu’ils peuvent surveiller les signes d’activité suspecte. Les acteurs malveillants sont moins susceptibles d’acheter des versions entreprise des modèles fonctionnant dans des environnements privés, où les prompts ne sont pas communiqués au fournisseur pour améliorer le modèle.Dans le cas d’un projet open source, il se peut que personne dans l’équipe ne soit chargé de rechercher des signes de jailbreaking. Les acteurs malveillants peuvent télécharger ces modèles gratuitement et les exécuter dans leurs propres environnements afin de tester des piratages potentiels. Les malfaiteurs ont également une longueur d’avance sur leur jailbreaking puisqu’ils ont accès au système de prompts utilisé par le modèle et à tout autre garde-fou que les développeurs du modèle ont pu mettre en place.« Il ne s’agit pas ici seulement d’essais et d’erreurs, précise Anand Rao. Les attaquants peuvent analyser les données d’entraînement, par exemple pour trouver des moyens d’amener un modèle à mal identifier des images ou à dérailler lorsqu’il rencontre un prompt inoffensif en apparence. » Si un modèle d’IA ajoute un filigrane à ses résultats, un acteur malveillant pourrait analyser le code pour faire de la rétro-ingénierie afin de supprimer ce filigrane.Les attaquants pourraient également analyser le modèle ou d’autres codes et outils de support pour trouver des zones de vulnérabilité. « Vous pouvez submerger l’infrastructure de requêtes pour que le modèle ne parvienne plus à produire de résultat, explique Elena Sügis, data scientist senior chez Nortal, un cabinet de conseil en transformation numérique. Si le modèle s’intègre à un système plus vaste et que son résultat est utilisé par une autre partie de ce système, si on parvient à attaquer la façon dont le modèle produit le résultat, on perturbe l’ensemble du système, ce qui pourrait générer des risques pour l’entreprise. »4. Risques liés aux données d’entraînementLes artistes, écrivains et autres détenteurs de droits d’auteur ont lancé des poursuites contre les éditeurs de modèles propriétaires d’IA. Mais que se passe-t-il s’ils estiment que leurs droits de propriété intellectuelle sont violés par un modèle open source, et que les seules poches bien garnies qu’ils entrevoient sont celles des entreprises qui ont incorporé ce modèle dans leurs produits ou services ? Les entreprises utilisatrices pourraient-elles être poursuivies en justice ?« C’est une question ouverte et personne ne sait vraiment comment les litiges en cours vont se dérouler, dit David Guarrera d’EY. Nous nous dirigeons peut-être vers un monde où l’utilisation des ensembles de données devront faire l’objet d’une compensation ». Et de noter toutefois que les grands acteurs de la technologie sont mieux armés pour résister à la tempête qui pourrait s’abattre sur les droits d’auteur.Les grands fournisseurs n’ont pas seulement de l’argent à dépenser pour acheter des données d’entraînement et lutter contre les poursuites judiciaires, ils ont aussi de l’argent à dépenser pour des ensembles de données nettoyées, explique Elena Sügis. Les ensembles de données publics et gratuits ne contiennent pas seulement des contenus protégés par des droits d’auteur et utilisés sans autorisation, ils renferment aussi des informations inexactes et biaisées, des malwares et autres éléments susceptibles de dégrader la qualité des résultats. « De nombreux concepteurs de modèles parlent d’utiliser des données nettoyées, explique-t-elle. Mais cela coûte plus cher que d’utilise tout Internet pour entraîner un modèle ».5. Nouveaux domaines d’expositionÉtant donné qu’un projet d’IA générative ne se limite pas à du code, les domaines d’exposition potentielle sont plus nombreux. Un LLM peut être attaqué par des acteurs malveillants sur plusieurs fronts. Ils pourraient infiltrer l’équipe de développement d’un projet mal gouverné et ajouter un code malveillant au logiciel lui-même. Mais ils peuvent aussi empoisonner les données d’entraînement, le fine-tuning ou les paramétrages, explique Elena Sügis.« Les pirates peuvent ré-entraîner un modèle avec des exemples de codes malveillants, de sorte à envahir l’infrastructure de l’utilisateur avec ces menaces, explique-t-elle. De même, ils peuvent aussi l’entraîner sur de fausses nouvelles et des informations erronées.Un autre vecteur d’attaque est réside dans le système de prompting du modèle. « Il est généralement caché de l’utilisateur, indique Elena Sügis. Le système de prompting peut contenir des garde-fous ou des règles de sécurité qui permettraient au modèle de reconnaître un comportement indésirable ou contraire à l’éthique. » Les modèles propriétaires ne révèlent pas cet aspect essentiel souligne la data scientist, et le fait d’y avoir accès dans les modèles open source offre aux pirates des clefs pour comprendre comment attaquer ces modèles.6. Garde-fous manquantsCertaines équipes open source peuvent avoir une objection philosophique à la présence de garde-fous sur leurs modèles, ou ils peuvent penser qu’un modèle fonctionnera mieux sans aucune restriction. Enfin, certains modèles sont créés spécifiquement pour être utilisés à des fins malveillantes. Les entreprises à la recherche d’un LLM à tester ne savent pas nécessairement dans quelle catégorie classer les modèles qu’elles expérimentent.Selon Elena Sügis de Nortal, il n’existe actuellement aucun organisme indépendant chargé d’évaluer la sécurité des modèles d’IA génératives open source. La loi européenne sur l’IA exigera une partie de cette documentation, mais la plupart de ses dispositions n’entreront pas en vigueur avant 2026. « Il faut essayer d’obtenir autant de documentation que possible, de tester et d’évaluer le modèle et de mettre en place des garde-fous au sein de l’entreprise », dit la data scientist.7. Absence de normesLes projets open source pilotés par les utilisateurs sont souvent basés sur des standards, les entreprises les privilégiant à des fins d’interopérabilité. En fait, selon une enquête menée l’année dernière par la Fondation Linux auprès de près de 500 professionnels de la technologie, 71 % d’entre eux préfèrent les standards ouverts. Si vous vous attendez à ce que l’IA à code source ouvert soit basée sur des normes, vous vous trompez.En fait, lorsque la plupart des gens parlent de normes en matière d’IA, ils évoquent des sujets tels que l’éthique, la protection de la vie privée et l’explicabilité. Des travaux sont en cours dans ce domaine, comme la norme ISO/IEC 42001 pour les systèmes de gestion de l’IA, publiée en décembre dernier. Le 29 avril, le NIST a publié un projet de normes sur l’IA qui couvre un large éventail de sujets, à commencer par la création d’un langage commun pour parler de l’IA. Ce se concentre également sur les questions de risque et de gouvernance. En revanche, concernant les standards techniques, les travaux sont plus embryonnaires.« C’est un espace incroyablement naissant, estime ainsi Taylor Dolezal, DSI et responsable des écosystèmes à la Cloud Native Computing Foundation. J’assiste à de bonnes conversations sur la classification des données, sur la nécessité d’avoir un format standard pour les données d’entraînement, pour les API, pour les prompts. Mais pour l’instant, il ne s’agit que de conversations. »Il existe déjà une norme commune pour les bases de données vectorielles, mais pas de langage d’interrogation standard. Et qu’en est-il des normes pour les agents autonomes ? « Je n’en ai pas encore entendu parler, mais j’aimerais bien que ce soit le cas, reprend Taylor Dolezal. Il s’agit de trouver des moyens non seulement pour que les agents accomplissent leurs tâches spécifiques, mais aussi pour les relier entre eux. »L’outil le plus courant pour créer des agents, LangChain, est plus un cadre qu’un standard, dit-il. Et les entreprises utilisatrices, celles qui créent la demande de standards, ne sont pas encore prêtes. « La plupart des utilisateurs finaux ne savent pas ce qu’ils veulent tant qu’ils n’ont pas commencé à jouer avec », souligne le DSI. Selon lui, les gens ont plutôt tendance à considérer les API et les interfaces des principaux fournisseurs, comme OpenAI, comme des normes de fait, encore naissantes. « C’est ce que je vois les gens faire », dit-il.8. Manque de transparenceOn pourrait penser que les modèles open source sont, par définition, plus transparents. Mais ce n’est pas toujours le cas. Les grands projets propriétaires peuvent, en effet, avoir plus de ressources à consacrer à la création de la documentation, souligne Eric Sydell, Pdg de l’éditeur de logiciels de BI Vero AI, qui a récemment publié un rapport évaluant les principaux modèles d’IA générative sur la base de critères tels que la visibilité, l’intégrité, l’état de préparation aux évolutions législatives et la transparence. Gemini de Google et GPT-4 d’OpenAI ont obtenu les meilleures notes.« Ce n’est pas parce qu’ils sont open source qu’ils fournissent nécessairement le même niveau d’informations sur le contexte du modèle et la manière dont il a été développé explique Eric Sydell. Les grands modèles commerciaux ont fait un meilleur travail à cet égard. » Exemple avec l’atténuation des biais. « Nous avons constaté que les deux premiers modèles propriétaires de notre classement disposaient d’une documentation assez complète et qu’ils avaient consacré du temps à l’étude de cette question », ajoute-t-il.9. Lignage incertainIl est courant que les projets open source fassent l’objet d’un fork, mais lorsque cela se produit avec l’IA générative, vous vous exposez à des risques que vous ne rencontrez pas avec les logiciels traditionnels. Supposons, par exemple, qu’un modèle de base utilise un ensemble de données d’entraînement problématique et que quelqu’un crée un nouveau modèle à partir de cet ensemble, il héritera alors de ces problèmes, explique Tyler Warden, vice-président chargé des produits chez Sonatype, un fournisseur de cybersécurité.« De nombreux aspects boîte noire se situent dans les paramétrages et les réglages », explique-t-il. En fait, ces problèmes peuvent remonter à plusieurs niveaux et ne seront pas visibles dans le code du modèle final. Lorsqu’une entreprise télécharge un modèle pour son propre usage, le modèle s’éloigne encore plus des sources d’origine. Le modèle de base original peut avoir corrigé les problèmes, mais, selon le degré de transparence et de communication en amont et en aval de la chaîne, les développeurs qui travaillent sur le dernier modèle peuvent ne même pas être au courant des corrections apportées.10. Nouveau « Shadow IT »Les entreprises qui utilisent des composants open source dans le cadre de leur développement de logiciels ont mis en place des processus pour contrôler les bibliothèques et s’assurer que les composants sont à jour. Elles s’assurent que les projets sont bien supportés, que les problèmes de sécurité sont traités à temps et que les logiciels sont exploités sous des conditions de licence appropriées.Dans le cas de l’IA générative, cependant, les personnes censées procéder à cette vérification ne savent pas toujours ce qu’elles doivent rechercher. En outre, les projets d’IA générative échappent parfois aux processus de développement logiciel standard. Ils peuvent émaner d’équipes de Data Science ou d’innovation. Les développeurs peuvent télécharger les modèles pour les tester et finir par les utiliser plus largement. Ou bien les utilisateurs eux-mêmes peuvent suivre des tutoriels en ligne et mettre en place leur propre IA générative, en contournant complètement la DSI. Et la dernière évolution de l’IA générative, les agents autonomes, a le potentiel pour conférer un pouvoir énorme à ces systèmes, augmentant les risques associés au Shadow IT.« Si vous voulez expérimenter, créez un conteneur pour le faire de manière sûre pour votre organisation », conseille Kelley Misata, directrice principale de l’open source chez Corelight. Selon elle, cette précaution devrait relever de la responsabilité de l’équipe de gestion des risques au sein de l’entreprise, et de la personne qui s’assure que les développeurs, et l’entreprise dans son ensemble, comprennent qu’il existe un processus encadrant les usages. Autrement dit le DSI. « C’est lui qui est le mieux placé pour instaurer une culture d’entreprise, dit-elle. Tirons parti de l’innovation et de tout ce que l’open source peut offrir, mais allons-y les yeux ouverts. »Le meilleur des deux mondes ?Certaines entreprises recherchent le faible coût, la transparence, la confidentialité et le contrôle de l’open source, mais souhaitent qu’un fournisseur soit présent pour assurer la gouvernance, la viabilité à long terme et l’assistance. Dans le monde traditionnel de l’open source, de nombreux prestataires remplissent ce rôle, comme Red Hat, MariaDB, Docker, Automattic et d’autres.« Ils offrent un niveau de sécurité aux grandes entreprises, explique Priya Iragavarapu, vice-président Data Science et analytique chez AArete. C’est presque un moyen d’atténuer les risques. » Il n’y a pas encore beaucoup de fournisseurs de ce type dans le domaine de l’IA générative. Mais les choses sont en passe de changer, selon elle.

L’entreprise allemande de la grande distribution Edeka a recours à de la reconnaissance faciale épaulée par l’intelligence artificielle dans son magasin de l’aéroport de Stuttgart pour vérifier l’âge de ses clients. La vente de certains produits comme l’alcool ou le tabac étant interdite aux mineurs.

Le magasin du grand distributeur allemand Edeka à l’aéroport de Stuttgart reste ouvert 24 heures sur 24 et 7 jours sur 7. Pour ce faire, à certaines heures de la nuit ou le week-end, il fonctionne à effectif réduit et essentiellement avec des caisses automatiques. Néanmoins, quand un client veut acheter des boissons alcoolisées ou du tabac, produits interdits aux mineurs, il doit néanmoins prouver son âge. Pour ne pas systématiquement ralentir le processus d’achat automatique dans ce cas, le distributeur a installé un système de reconnaissance faciale sur ses caisses automatiques.Dès qu’un client scanne des marchandises soumises à une restriction, le système développé par Diebold Nixdorf lui propose une vérification automatique de son âge. Si le client est d’accord, une caméra prend alors une photo de son visage. Un algorithme d’IA évalue son âge à partir des caractéristiques de ce dernier. S’il est supérieur au minimum autorisé selon cette évaluation, l’achat est validé.Les employés peuvent ainsi se concentrer sur le contrôle des clients que le système estime mineurs ou ceux qui n’ont pas souhaité se soumettre à la détection par caméra. Dès la première semaine d’utilisation de Vynamic Smart Vision Age Verification, plus de 80 % des achats soumis à une limite d’âge ont été autorisés automatiquement dans le magasin de Stuttgart.Conforme au RGPD« Nous avons déjà réduit considérablement les interventions de nos employés, affirme Florian Jäger, propriétaire du magasin de l’aéroport et de quatre autres magasins Edeka dans la région de Stuttgart. Mon objectif est de créer des processus d’achat rapides et faciles pour les clients et mes employés. » Selon Diebold Nixdorf, plus d’un cinquième des transactions nécessitent un contrôle de l’âge. Un processus qui durerait jusqu’à deux minutes en fonction du nombre d’employés en caisse, entraînant des files d’attente plus longues et donc de la frustration chez les clients.Par ailleurs, l’éditeur de la solution garantit ne stocker ni les images, ni aucune information concernant le client pris en photo. Son système est donc considéré comme conforme au RGPD.

Une vulnérabilité a été découverte dans plusieurs produits Check Point dont le service Security Gateway utilisé dans ses passerelles de sécurité et VPN. Des correctifs ont été poussés pour contrer des risques en termes de violation de confidentialité des données.

Le fournisseur de cybersécurité Check Point a conseillé à ses clients utilisant ses VPN de corriger immédiatement le service Security Gateway afin d’empêcher les acteurs de la menace d’obtenir un accès initial aux réseaux d’entreprise par le biais de configurations VPN vulnérables. Le fournisseur a publié un avis pour aider à corriger la vulnérabilité. “Le groupe de travail de Check Point continue d’enquêter sur les tentatives d’accès non autorisé aux produits VPN utilisés par nos clients”, a déclaré l’entreprise dans une mise à jour de sécurité. “Le 28 mai 2024, nous avons découvert une vulnérabilité dans les Security Gateways avec Remote Access VPN ou Mobile Access blade activé.” Selon le fournisseur israélien, les tentatives d’exploitation remontent cependant au 30 avril dernier. Check Point a publié un correctif pour empêcher les tentatives d’exploitation de cette vulnérabilité. Outre Security Gateway, sont aussi concernés par ce risque d’exploit CloudGuard Network Security (versions R81.20, R81.10, R81 et R80.40), Quantum Maestro et Quantum Scalable Chassis (versions R81.20, R81.10, R80.40, R80.30SP et R80.20SP) ainsi que Quantum Spark Gateways (versions R81.10.x, R80.20.x et R77.20.x). Le CERT-FR a également publié un bulletin d’alerte à ce sujet.

La vulnérabilité, répertoriée sous le code CVE-2024-24919, n’affecte apparemment que les passerelles de sécurité configurées avec une protection par mot de passe, que Check Point recommande de ne pas utiliser. « Les tentatives que nous avons vues jusqu’à présent se concentrent sur des scénarios d’accès à distance avec d’anciens comptes locaux avec une authentification par mot de passe non recommandée », a déclaré Check Point. « L’authentification par mot de passe uniquement ne peut pas garantir les plus hauts niveaux de sécurité, et nous recommandons fortement de ne pas se fier à cette méthode pour se connecter à l’infrastructure du réseau. » Pour enquêter sur les tentatives ou cas d’exploit, le fournisseur a constitué des équipes spéciales de professionnels de la réponse aux incidents, des services techniques et des produits. « En se basant sur les notifications de ces clients et sur l’analyse de Check Point, les équipes ont trouvé dans les 24 heures quelques clients potentiels qui ont fait l’objet de tentatives similaires », a ajouté Check Point. Les environnements concernés sont CloudGuard Network, Quantum Maestro, Quantum Scalable Chassis, Quantum Security Gateways et Quantum Spark Appliances.

Correctifs pour la passerelle de sécurité

Pour corriger la configuration vulnérable sur les services de passerelle de sécurité concernés, la société a publié une mise à jour corrective. Celle-ci est accessible sur le portail Security Gateway dans la rubrique des mises à jour logicielles disponibles. « Dans les heures qui ont suivi ce développement, Check Point a publié une solution facile à mettre en œuvre qui empêche les tentatives d’exploitation de cette vulnérabilité », a déclaré la société dans le communiqué. Le correctif est également disponible séparément en téléchargement dans le cadre de l’avis de sécurité. Check Point a demandé à ses clients d’appliquer immédiatement le correctif afin d’empêcher les tentatives d’accès à distance non autorisé. Outre l’application du patch, l’entreprise a recommandé de modifier le mot de passe du compte de la Security Gateway dans Active Directory et d’empêcher les comptes locaux de se connecter au VPN avec une authentification par mot de passe. La firme a également recommandé aux entreprises d’évaluer leur utilisation des comptes locaux et de désactiver ceux qui ne sont pas nécessaires. Si les comptes locaux sont nécessaires, le fournisseur suggère de renforcer leur sécurité en mettant en œuvre une couche d’authentification supplémentaire, telle que des certificats, en plus des mots de passe.

L’hébergeur et fournisseur de noms de domaine GoDaddy a depuis quelques années pris le sujet de l’IA à bras le corps. Usage, LLM, formation, intégration, le CTO Charles Beadnall évoque les différents aspects de cette adoption à grande vitesse.

Il y a un an, la société ne disposait pas d’un seul grand modèle de langage fonctionnant avec ses systèmes centraux. Aujourd’hui, la société d’enregistrement de domaines Internet et d’hébergement Web GoDaddy travaille avec 50 LLM, dont certains sont dédiés à des produits d’automatisation côté client, tandis que d’autres sont préparés pour des projets pilotes visant à améliorer la productivité de ses salariés. A l’occasion d’un entretien à nos…

Il vous reste 96% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

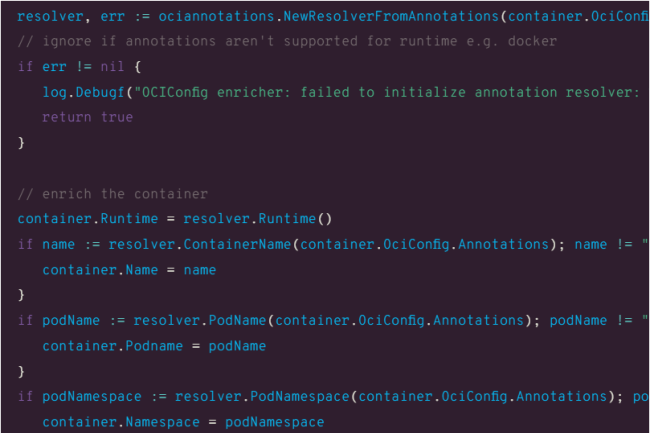

Développé par Kinvolk, filiale de Microsoft, Inspektor Gadget comprend plusieurs outils open source pour la surveillance et l’observabilité des environnements Kubernetes.

Surtout connue pour sa distribution Linux Flatcar, la filiale Kinvolk de Microsoft est en train de devenir rapidement l’un des centres d’excellence open source de l’éditeur. Alors que Deis Labs s’est concentré sur le développement cloud native, Kinvolk est plus aligné sur l’ingénierie et les opérations de plateforme, fournissant par exemple des outils tels que l’interface utilisateur Headlamp Kubernetes. Au cours des cinq dernières années, Kinvolk a travaillé sur un ensemble d’outils de surveillance et de capture eBPF (ce…

Il vous reste 93% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

Pour mieux piloter son réseau IoT de production et le protéger des intrusions, l’Allemand SGF a déployé une solution d’identification des équipements autorisés et de leur état de connexion.

Selon une étude réalisée en 2023 par la compagnie d’assurance allemande Gothaer, près de la moitié des PME considère une cyberattaque comme le risque le plus important pour leur activité. C’est pourquoi Süddeutsche Gelenkscheibenfabrik (SGF) a décidé de sécuriser l’accès à son réseau d’équipements informatiques et IoT en production avec la solution de network access control (NAC) de son compatriote Macmon Secure. L’industriel bavarois, qui emploie 700 personnes et a réalisé un CA de 120 M€ en 2023, fabrique des pièces métalliques résistantes pour le découplage et la réduction des vibrations et du bruit, principalement à destination des industries automobile et ferroviaire.L’industriel exploite de nombreux objets connectés : robots, automates programmables, capteurs, caméras, etc. Autant d’équipements dont la cyberprotection devient de plus en plus importante. SGF a voulu contrôler et sécuriser l’accès aux terminaux par les équipes internes et les prestataires extérieurs. Un sujet d’autant plus central que les employés de SGF changent très souvent d’affectation dans les sites de production. Dans ce cas, les équipes IT et informatique industrielle devaient reconfigurer manuellement les ports de commutation. « Nous nous sommes aussi rendu compte que chaque machine avait toujours son propre VLAN, ce qui nous impose actuellement de gérer plus de 250 réseaux », ajoute Thomas Schuster, administrateur système chez SGF.Gestion et protection du réseau IoTL’industriel a donc d’abord opté pour un NAC pour simplifier la gestion de son réseau IoT. Il a identifié à partir de la base SNMP, tous les terminaux disponibles et la façon dont ils sont physiquement intégrés au réseau, le VLAN auquel ils appartiennent, ainsi que les droits d’accès qui lui sont associés. La solution répertorie également la soixantaine de switches. « C’est particulièrement utile lorsqu’il faut déplacer, étendre ou convertir certaines machines, ou en cas de problème, explique Thomas Schuster. Les développeurs d’automates programmables, par exemple, me demandent pourquoi tel ou tel terminal spécifique ne communique pas. Dans ce cas, il est essentiel que je sache rapidement où l’appareil est physiquement branché ou encore s’il est mal branché, voire débranché. » Le NAC permet aussi de savoir quels ports de commutation n’ont pas été utilisés depuis longtemps.Mais le projet a aussi pour objectif de protéger le réseau des intrusions. Tous les terminaux étant ainsi identifiés, aucun appareil inconnu ou non autorisé ne peut se greffer sur le réseau IoT de l’industriel. « En revanche, contrairement au réseau informatique, nous ne pouvons pas bloquer instantanément un système, précise l’administrateur système, car il comprend parfois plus d’une centaine d’équipements. Et le maintien de la fluidité des opérations de production demeure évidemment la priorité absolue. »