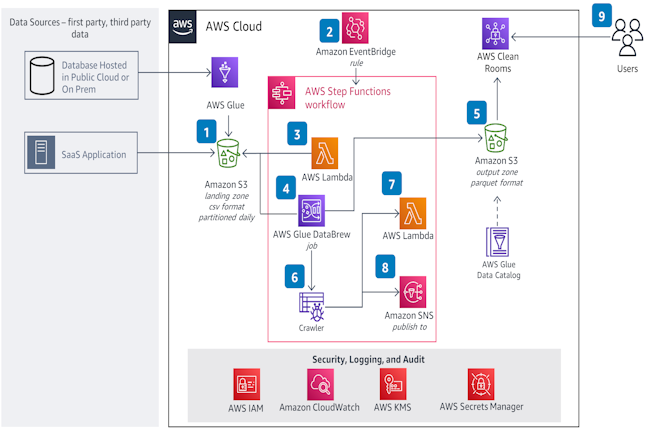

Le fournisseur de cloud a dévoilé des fonctionnalités en test de machine learning pour son service Clean Rooms. Un espace où les entreprises et leurs partenaires pourront travailler sur des modèles d’IA à partir de données échangées.

L’IA et le machine learning infusent toutes les couches de l’IT. AWS a multiplié les annonces cette semaine lors de son évènement re:Invent. Parmi les présentations, une concerne Clean Rooms, un service sécurisé de partage de données et de collaboration entre les entreprises et leurs partenaires. Le fournisseur de cloud a instillé dans cette solution des fonctions de machine learning.

Baptisées Clean Rooms ML, ces fonctions seront capables de former des modèles d’IA avec les données présentes dans ces salles sécurisées. « Avec AWS Clean Rooms ML, vous pouvez former votre propre modèle personnalisé en utilisant vos données, et inviter vos partenaires à apporter un petit échantillon de leurs informations pour générer un modèle d’IA test tout en protégeant vos données sous-jacentes et celles de votre partenaire », a déclaré Swami Sivasubramanian, vice-président des données et de l’IA chez AWS. Il ajoute que prochainement cette capacité de modéliser sera disponible pour les données de santé.

Pilotable depuis une console

Clean Rooms ML est accessible en module autonome dans le cadre de l’offre d’AWS for Advertising and Marketing. Les fonctions seront disponibles dans les régions suivantes : Est des États-Unis (Ohio), Est des États-Unis (Virginie du Nord), Ouest des États-Unis (Oregon), Asie-Pacifique (Séoul), Asie-Pacifique (Singapour), Asie-Pacifique (Sydney), Asie-Pacifique (Tokyo), Europe (Francfort), Europe (Irlande), Europe (Londres) et Europe (Stockholm).

Pour mémoire, Clean Rooms a été lancé lors de re:Invent 2022 et il est accessible via la console de gestion, où une entreprise peut choisit le partenaire avec lequel elle souhaite collaborer. Cette console offre des options pour choisir les ensembles de données à partager et configurer les autorisations pour les participants. AWS ajoute que les ensembles de données qui sont partagés dans la salle blanche sont chiffrés et n’ont pas besoin de sortir de l’environnement AWS ou d’être chargés dans une autre plateforme.

L’accord, qui exclut la Chine, comprend des recommandations sur la surveillance des systèmes d’IA et leurs abus potentiels, la protection des données et le contrôle des fournisseurs de logiciels.

Ce week-end, 22 organismes judiciaires et agences de renseignement de 18 pays (dont la France) ont signé un accord international sur la sécurité de l’IA. Il vise à rendre les dernières versions de la technologie « sûres dès leur conception », intervient quelques mois après la validation par le Parlement européen de l’ IA Act, en juin. Ce texte toujours en discussion interdit certaines technologies d’IA, notamment la surveillance biométrique et la prévision policière pour la prévention de la criminalité, et classe dans la catégorie des systèmes à haut risque les systèmes d’IA pouvant avoir un impact significatif sur la santé, la sécurité, les droits ou les élections. « Les systèmes d’IA peuvent apporter de nombreux avantages à la société. Mais, pour que les possibilités offertes par l’IA se concrétisent pleinement, celle-ci doit être développée, déployée et exploitée de manière sûre et responsable », stipule l’accord. Celui-ci estime que, compte tenu du rythme rapide du développement de l’IA, la question de la sécurité ne doit pas être posée après coup, mais qu’il faut la considérer comme une exigence fondamentale du cycle de vie de ces systèmes. « Ils sont exposés à de nouvelles vulnérabilités de sécurité qu’il faut prendre en compte au même titre que les menaces classiques de cybersécurité », indique le rapport.

« Quand le rythme de développement est élevé, comme c’est le cas de l’IA, la sécurité peut souvent passer au second plan. Avec une différence de sécurité spécifique à l’IA : l’existence d’un phénomène appelé « machine learning antagoniste ». Qualifié de critique par le rapport, le ML antagoniste est défini comme l’exploitation stratégique des vulnérabilités fondamentales, inhérentes aux composants du ML. En manipulant ces éléments, les adversaires peuvent potentiellement perturber ou tromper les systèmes d’IA, avec pour conséquence la génération de résultats erronés ou la compromission d’une fonctionnalité. Outre le projet de réglement européen sur l’IA, aux États-Unis, le président Joe Biden a signé en octobre un décret visant à réglementer le développement de l’IA, exigeant des développeurs de modèles d’IA puissants qu’ils partagent avec le gouvernement les résultats en matière de sécurité et les informations critiques.

La Chine, exclue de l’accord

Alors qu’elle est l’un des moteurs du développement de l’IA et qu’elle fait l’objet de plusieurs sanctions commerciales de la part des États-Unis en vue de limiter son accès au silicium de haute puissance, nécessaire au développement de l’IA, la Chine est absente de l’accord. Dans un discours prononcé dimanche lors d’un événement organisé par la chambre de commerce de Taïwan, Mark Liu, président de TSMC, a déclaré que la décision des États-Unis d’exclure la Chine entraînerait un ralentissement mondial de l’innovation et une fragmentation de la mondialisation.

L’IA reste un champ de mines juridique

Bien que non contraignant, l’accord propose principalement des recommandations générales et n’aborde pas les questions complexes concernant les applications appropriées de l’IA ou les méthodes de collecte de données pour les LLM. Il n’aborde pas les litiges civils en cours aux États-Unis sur la manière dont les systèmes ingèrent des données pour développer leurs grands modèles de langage, et sur la question de savoir si ces pratiques sont conformes à la législation sur les droits d’auteur.

Aux États-Unis, plusieurs auteurs ont porté plainte contre OpenAI et Microsoft pour violation des droits d’auteur et de la propriété intellectuelle, estimant que leurs œuvres créatives ont été utilisées sans leur accord dans la formation de ChatGPT d’OpenAI. La plainte met en évidence les préoccupations croissantes concernant l’impact de l’IA sur les industries créatives et journalistiques traditionnelles. Selon K&L Gates, OpenAI et d’autres défendeurs dans ces affaires font valoir le défaut de compétence et utilisent la doctrine de l’usage loyal pour se défendre. Si l’on ajoute à cela le scepticisme des tribunaux dans les premières affaires, on peut dire que l’avenir des litiges en matière d’IA est « incertain ».

Dans une lettre ouverte signée par les membres de Digital Europe, le groupe avertit qu’une réglementation excessive de l’industrie de l’IA pourrait avoir un impact négatif sur la capacité de l’UE à devenir un leader mondial dans ce domaine.

Digital Europe, un groupe de lobbying représentant les industries IT à travers le continent, a publié une déclaration commune avant les dernières semaines de négociation de la réglementation européenne sur l’IA, avertissant qu’une réglementation excessive pourrait paralyser l’innovation et pousser les start-ups à quitter le continent. L’argument principal du groupe est que l’IA Act va au-delà de son champ d’application initial et devrait plutôt se concentrer sur les cas d’utilisation à haut risque, plutôt que de viser des technologies spécifiques. Digital Europe a également prévenu que la charge financière que la loi pourrait imposer aux entreprises souhaitant mettre sur le marché des produits basés sur l’IA pourrait rendre l’exploitation en dehors de l’UE non viable pour les petites entreprises.

« Pour que l’Europe devienne une puissance numérique mondiale, nous avons besoin d’entreprises capables de mener l’innovation en matière d’IA en utilisant également des modèles de fondation et le GPAI (General-purpose AI) », peut-on lire dans la déclaration. « En tant que représentants de l’industrie numérique européenne, nous voyons une énorme opportunité dans les modèles de base, et de nouveaux acteurs innovants émergent dans cet espace, dont beaucoup sont nés ici en Europe. Ne les obligeons pas à disparaître avant qu’ils n’aient eu la chance de se développer, ou ne les forçons pas à partir ». La lettre a été signée par 32 membres de Digital Europe (incuant Michel Combot, délégué général de Numeum) et présente quatre recommandations qui, selon les signataires, permettraient à la loi de trouver l’équilibre nécessaire entre la réglementation et l’innovation.

Il s’agit notamment de veiller à ce que l’approche fondée sur le risque reste au cœur du règlement sur l’IA, de mieux aligner le cadre sur la législation existante en matière de sécurité des produits et d’ignorer les demandes visant à ce que la réglementation s’attaque aux questions de droit d’auteur. « Le cadre global de protection et d’application des droits d’auteur de l’UE contient déjà des dispositions qui peuvent aider à résoudre les problèmes de droits d’auteur liés à l’IA, tels que l’exemption pour l’exploration de texte et de données et l’exemption correspondante », peut-on lire dans la déclaration.

Des craintes de surrèglementation ont déjà été exprimées par le passé

Ce n’est pas la première fois que l’AI Act européen fait l’objet de critiques de la part de dirigeants de l’industrie qui s’inquiètent de la portée de la législation et de son potentiel à surréglementer l’industrie. En juin dernier, 163 cadres éminents représentant certaines des plus grandes entreprises technologiques et commerciales d’Europe, dont Airbus, ARM, Capgemini, Schneider Electric et Siemens, ont signé une lettre ouverte exhortant l’UE à adopter une approche plus souple en matière de réglementation de l’IA, craignant que le projet de loi sur l’IA ne rende le continent moins compétitif dans ce domaine en plein essor. « Vouloir ancrer la réglementation de l’IA générative dans la loi et procéder à une logique de conformité rigide est une approche aussi bureaucratique qu’inefficace pour remplir son objectif », indique la lettre. « Dans un contexte où nous en savons très peu sur les risques réels, le modèle commercial ou les applications de l’IA générative, le droit européen devrait se limiter à énoncer de grands principes dans le cadre d’une approche fondée sur les risques ». Bien que la loi sur l’IA ait été approuvée par le Parlement européen en juin, elle doit être ratifiée par chaque pays de l’UE avant d’avoir force de loi.

Si les pays s’accordent largement sur les exigences en matière d’étiquetage et sur les mesures de protection contre les contenus générés par l’IA, les propositions d’interdiction de la surveillance biométrique dans les lieux publics et des systèmes dits de “notation sociale”, qui classent les personnes en fonction de leur comportement social, de leur statut socio-économique et de leurs caractéristiques personnelles, ont suscité des réactions négatives. Lorsque la loi sur l’IA sera finalement adoptée, le non-respect de ses dispositions entraînera des sanctions pouvant aller jusqu’à 21,8 millions de dollars (20 millions d’euros) ou 4 % du chiffre d’affaires mondial.

En adoptant une approche méthodique du shadow IT et en identifiant clairement ses causes, les DSI peuvent réduire les risques inhérents à cette pratique. Cette dernière peut même devenir une source de bénéfices pour l’IT et pour l’entreprise.

Lorsqu’on parle shadow IT avec des responsables informatiques, la plupart évoquent les questions de sécurité, les risques opérationnels et les enjeux d’intégration. Mais pour certains, le développement de cette pratique révèle surtout l’incapacité de l’IT à répondre à certains besoins technologiques des métiers.Il ne s’agit pas de minimiser les risques inhérents au shadow IT. Selon un rapport de l’éditeur de solutions d’identité numérique Entrust, 77 % des professionnels de l’informatique sont en effet préoccupés par le sujet. Et pour cause, 41 % des employés achètent, modifient ou créent des outils pour combler leurs besoins sans en informer le service informatique. Enfin, selon une enquête de EY dans le monde entier, 52 % des personnes interrogées sur la gestion des risques ont subi une panne – et 38 % une violation de données – causée par des tiers au cours des deux dernières années.Reste que le shadow IT n’est pas une informatique malveillante, comme évoqué à l’occasion de l’événement Coffee with digital trailblazers (un café avec les pionniers de l’informatique), organisé par CIO. L’informatique malveillante se développe lorsque les dirigeants ne font pas confiance à la DSI, la contournent délibérément et dérogent aux règles de l’IT interne. Le shadow IT est, généralement, moins conflictuel, et découle davantage d’un manque d’informations sur la façon d’impliquer le service IT. Ou encore, comme l’explique Dinesh Varadharajan, directeur général de l’éditeur de solutions no code/low code Kissflow, « d’un manque de soutien et de bande passante de la DSI pour résoudre les défis spécifiques auxquels sont confrontés les métiers ».Une des stratégies face à cette situation consiste, non pas à la nier ou à la combattre, mais à en faire une opportunité d’améliorer la collaboration avec les équipes informatiques. Ce n’est une transformation ni rapide ni facile, car elle nécessite de traiter simultanément deux aspects de l’équation. D’une part, la manière dont la DSI gère les besoins technologiques des métiers et d’autre part, la façon dont ceux-ci sont étudiés et mis en regard de réponses technologiques. CIO a identifié sept étapes pour développer la démarche.

1. Développer la relation avec les métiers

« Une des façons de résoudre la question du shadow IT pour une entreprise, sans forcément l’éliminer, c’est de trouver des moyens d’intégrer les solutions choisies ou développées, mais non approuvées par les canaux officiels, en garantissant leur sécurité, leur conformité et une gestion efficace tout en conservant les capacités d’innovation et l’agilité qui ont conduit les employés à agir de cette façon », estime Brian Platz, PDG et cofondateur de l’éditeur de plateforme de données sécurisée Fluree.Mais, pour ce faire, les responsables informatiques doivent d’abord identifier ce qui se passe dans l’ombre en accroissant le nombre de managers avec lesquels ils collaborent, en augmentant la fréquence des échanges et en se plongeant davantage dans les workflows des métiers. Certaines grandes entreprises créent des fonctions de responsables des relations avec les métiers. Un rôle clé dans la compréhension et la traduction des besoins technologiques en business cases. Les PME peuvent, quant à elles, élaborer un programme de communication pour impliquer les métiers et les parties prenantes, avec un processus d’idéation comme le design thinking pour identifier les nouveaux besoins.

2. Définir une gouvernance et mettre l’accent sur la collaboration

Il faut également définir un modèle de gouvernance et de delivery pour l’évaluation, l’achat et la mise en oeuvre de solutions technologiques métier. Il est tout aussi important de communiquer sur la manière de prendre en compte les demandes technologiques, de partager la manière dont elles sont hiérarchisées, de documenter les responsabilités des différentes parties prenantes dans la recherche de solutions et de fournir un état des programmes en cours.C’est justement en l’absence d’un modèle de delivery et d’un plan de communication solide, que les utilisateurs sont susceptibles de se lancer dans du shadow IT. L’achat et la mise en oeuvre de solutions technologiques prennent du temps. Aussi, l’outil le plus simple dont dispose le DSI pour lutter contre ces pratiques est de donner aux métiers toute l’assurance que la collaboration va dans leur intérêt.« L’élément humain est le plus important, déclare Brian Suk, CTO du cabinet de conseil en cloud Sada. La plupart des employés sont d’accord pour se conformer aux politiques IT, mais si la DSI est trop stricte ou crée trop de frictions, elle provoque le shadow IT. Il faut communiquer clairement et fréquemment sur ces politiques IT, leur origine et leurs avantages, créer une culture du feed-back et de la collaboration, et être souple et adaptable en fonction de l’évolution des besoins des utilisateurs. »

3. Cartographier les risques et promouvoir les contrôles financiers

Le shadow IT donne l’occasion de réévaluer les stratégies IT en ce qui concerne les solutions métiers. Il faut identifier les applications de shadow IT déjà installées et les gérer, travailler en partenariat avec les équipes de l’entreprise sur des alternatives, améliorer et assurer le support des applications et des technologies en place, étendre leur utilisation et améliorer l’expérience des employés, et enfin mesurer et ainsi démontrer la valeur générée. Un processus de priorisation formalisé et transparent est également important. Les DSI doivent identifier des business cases simples et mesurer la valeur business pour prioriser les nouvelles opportunités. Sans oublier, avec les RSSI et les responsables de la conformité, d’établir un cadre de gestion des risques associés au shadow IT.Par ailleurs, se rapprocher des DAF permet aussi de mettre en lumière les coûts d’acquisition et les risques liés au shadow IT. Le point de vue de l’architecte d’entreprise permet, lui, d’éclairer l’organisation sur les capacités de réutilisation, levier essentiel pour garder les coûts sous contrôle. « Le shadow IT gaspille souvent les ressources, car les logiciels ne sont accompagnés d’aucune documentation qui faciliterait la réutilisation par d’autres, explique Anant Adya, vice-président exécutif de l’éditeur de solutions cloud Infosys Cobalt. Une gouvernance ambitieuse, ainsi qu’une documentation systématique des privilèges d’accès applicatifs découragent la pratique et contribue à la mise en place de modèles d’exploitation collaboratifs. »

4. Définir des modèles de gouvernance low-code et no-code

Les trois premières étapes de la démarche contribuent à réduire le shadow IT, mais elles ne tiennent pas compte du fait que les services informatiques disposent rarement du personnel, de l’expertise ou du budget suffisants pour mener à bien tous les programmes prioritaires.Pour pallier cette pénurie de ressources, les DSI peuvent encourager le citizen development et définir des modèles de gouvernance pour les solutions low code et no code. Ces modèles doivent couvrir l’examen des idées de nouvelles solutions, les rôles et responsabilités, l’intégration, la gestion des versions, la documentation et d’autres exigences visant à garantir la fiabilité et la sécurité des processus métier. Le no-code est efficace face au shadow IT, car il fait basculer la mise en oeuvre et le support du côté des métiers. Les utilisateurs vont, par exemple, convertir des feuilles de calcul en workflow, développer des bases de connaissances ou intégrer du SaaS.Toutefois, là-encore, la gouvernance est essentielle ainsi qu’un plan d’architecture de solutions pour accompagner la sélection de plateformes low code et no code. Sans oublier de répertorier les utilisations pertinentes de celles-ci, de décrire le cycle de vie de développement et d’assurer un support continu. « Les business cases doivent être organisés en fonction de trois critères : la complexité business, la complexité technique et les exigences de sécurité et de conformité, insiste Dinesh Varadharajan. Tout business case pour lequel l’un de ses critères est important doit passer par le service informatique, tandis que les autres peuvent être délégués aux entités opérationnelles. »

5. Développer la citizen data science et des fonctions en libre-service

Les DSI ont adopté la citizen data science parce que les outils de dataviz et autres plateformes BI en libre-service sont désormais faciles à utiliser par les métiers pour du reporting et des requêtes ad hoc que les services IT prenaient en charge jusque-là. Ces approches diminuent le shadow IT à condition que les DSI encouragent une gouvernance proactive des données et mettent en place des pratiques d’intégration, de catalogage et de qualité des données. Choisir des solutions solides pour gérer les data et des plateformes standards permettant aux employés des métiers, du Data Office et de la DSI d’exploiter les données dans leurs prises de décision contribue à réduire la prolifération des outils et le shadow IT.

6. Définir et partager une stratégie d’IA générative

Prochaine étape, sans aucun doute, la shadow IA. Les métiers explorent déjà l’IA générative et risquent d’exposer des informations propriétaires ou confidentielles. Des études récentes de la société de capital-risque Sequoia Capital montrent le nombre important d’outils d’IA générative qui arrivent sur le marché dans le domaine des ventes, du marketing, de la conception, de l’ingénierie logicielle, du support client, du juridique, etc.C’est un domaine idéal pour le shadow IT, car les dirigeants sont avides d’exploiter la technologie pour dégager de nouvelles sources d’efficacité. Rien n’empêche aujourd’hui un chef de service ou un employé d’essayer un nouvel outil et de lancer un autre shadow program. Lorsque la conformité réglementaire est assurée, les DSI ont tout intérêt à éviter de refuser une expérimentation d’IA générative. Des refus répétés menacent de provoquer une explosion des usages en shadow IA.Les DSI doivent plutôt définir, mettre à jour et partager une stratégie d’IA générative qui englobe à la fois les perspectives à court et à long terme. Les plans à court terme devraient préciser dans quels métiers expérimenter, vers quels résultats et opportunités d’affaires tendre, ainsi que les outils à utiliser, les données à exploiter ou les entraînements de modèles à expérimenter. Il leur faut aussi mettre à jour la stratégie de transformation digitale pour tenir compte de l’impact des LLM sur le secteur d’activité.

7- Favoriser une culture de la co-création

La dernière étape est probablement la plus importante et doit être gérée parallèlement aux six premières. Le shadow IT est plus qu’un risque ou une opportunité manquée, il traduit un fossé opérationnel et culturel entre les métiers et l’informatique que les DSI doivent s’efforcer de combler. Pour ce faire, il faut développer un sens du métier au sein de l’IT en établissant des relations avec les différentes parties prenantes de l’entreprise, en développant une forme d’empathie pour les besoins des clients et des employés et en améliorant la communication. Cela suppose également que les DSI opèrent un « shift left » (anticipation des problèmes en cours de développement), afin que les employés les plus à l’aise avec le numérique dans les fonctions commerciales, marketing, RH, etc. disposent d’outils approuvés et d’un processus sous contrôle pour répondre à leurs besoins technologiques en libre-service.Les DSI qui suivent ces sept étapes peuvent transformer le shadow IT en avantage concurrentiel en répondant à un plus grand nombre de besoins des métiers de leur organisation, en réduisant les risques liés à ces applications et en permettant à davantage de métiers de répondre en libre-service à leurs besoins propres, en matière de workflow et de données.

La Cloud Security Alliance a dévoilé le premier certificat faisant autorité dans l’approche zero trust. Il vise à établir des normes et à promouvoir les meilleures pratiques de cette stratégie de sécurité.

Le certificat et les supports de formation dévoilés récemment par la Cloud Security Alliance (CSA) proposent aux professionnels de la sécurité d’acquérir les connaissances nécessaires pour mettre en œuvre et gérer une stratégie zero trust dans leur entreprise. « L’omniprésence de la technologie, des systèmes de contrôle industriels au cloud en passant par l’IA générative, a dépassé les modèles de sécurité traditionnels », a déclaré Jim Reavis, cofondateur et directeur général de la Cloud Security Alliance, dans un communiqué. « Les principes du zero trust, qui consistent « à ne jamais faire confiance et à toujours vérifier », sont clairement la voie à suivre », a-t-il poursuivi, « et nous pensons que pratiquement toutes les entreprises appliqueront cette stratégie à divers environnements technologiques afin de protéger les actifs stratégiques et de prévenir les violations ».

Selon l’Alliance, le certificat de compétence dans le zero trust (Certificate of Competence in Zero Trust, CCZT) permettra à son titulaire d’acquérir une compréhension approfondie de l’architecture de confiance zéro, de ses composantes et de son fonctionnement. Il comprend également les meilleures pratiques fondamentales en matière de confiance zéro publiées par des sources faisant autorité comme la CISA américaine, le NIST, les travaux novateurs de CSA Research sur le périmètre défini par logiciel (Software-Defined Perimeter, SDP) et les conseils d’experts en zero trust tels que John Kindervag, fondateur de la philosophie zero trust.

Une base de connaissances et de compétences pour le zero trust

En lançant son programme de certificats, la Cloud Security Alliance s’engage dans un domaine qui s’est embrouillé au fil du temps. « Le zero trust est un concept convaincant qui, s’il est appliqué correctement, offre une grande valeur en termes de sécurité aux entreprises qui l’adoptent », a déclaré Nick Edwards, vice-président de Menlo Security, une entreprise spécialisée dans la sécurité web basée sur la confiance zéro. « Malheureusement, comme c’est souvent le cas dans l’industrie technologique, les frameworks industriels font l’objet d’une publicité excessive et d’abus de la part de la communauté des fournisseurs, ce qui entraîne une dilution de la valeur et un scepticisme général à l’égard de l’idée d’origine.

Les certificats offrent un support intéressant pour créer une base de connaissances et de compétences qui aide les entreprises à exécuter correctement le zero trust et à distinguer le « signal » du « bruit » », a ajouté M. Edwards. Wayne Hankins, directeur senior pour la sécurité et la gestion des risques chez Gartner, partage cet avis. « Le paradigme de la cybersécurité est souvent obscurci par les fournisseurs qui présentent leurs produits comme des solutions zero trust uniques », a-t-il encore déclaré. « Pour mettre en œuvre cette approche, sans se laisser piéger par le bruit des fournisseurs, les entreprises auront besoin des conseils de leaders d’opinion expérimentés ».

Développer les programmes de certifications

Cela peut prendre un certain temps, mais les programmes de certification auront un impact sur la diffusion des stratégies ero trust « Ce programme de certification n’aura pas d’impact immédiat sur l’adoption d’architectures zero trust, car les investissements dans la cybersécurité ne sont pas alignés sur les incitations actuelles des entreprises », a déclaré pour sa part Shane Miller, chercheur principal à l’Atlantic Council’s Cyber Statecraft Initiative. « Un changement radical et global se profile à l’horizon, sous l’impulsion d’organisations telles que la CISA aux États-Unis, qui commencera à remédier à ce décalage », a-t-il encore déclaré.

« Le zero trust est un changement de culture d’entreprise et, comme toute évolution, il ne peut réussir que si les résultats sont compris et appréciés », a ajouté M. Miller. « Nous avons encore beaucoup à faire sur le plan de l’éducation et de la défense des principes et de l’architecture de confiance zéro, et des initiatives comme ce programme de certificat contribuent à faire avancer les choses pour les parties prenantes. Il faut initier plus de programmes comme le Certificate of Competence in Zero Trust ».

Un faible coût très attractif pour démarrer

Selon Dean Webb, ingénieur en solutions chez Merlin Cyber, un éditeur d’IAM, la clé de la reconnaissance et de l’acceptation de cette certification par l’ensemble de l’industrie réside dans son adoption par les entreprises. « À mesure que les entreprises ajouteront la CCZT à leur liste de certifications souhaitées et requises, les professionnels de l’IT en général chercheront à obtenir la certification pour saisir de futures opportunités.

Les entreprises adopteront alors davantage de pratiques de zero trust, simplement parce qu’elles disposent d’un personnel qui les comprend et qui souhaite les mettre en place ». M. Webb a salué la décision de la Cloud Security Alliance d’offrir gratuitement en ligne tout le matériel de formation pour la CCZT. « Le faible coût total de la certification est idéal pour les personnes autonomes qui ont leurs propres objectifs », a-t-il expliqué. « Les personnes travaillant dans d’autres domaines de l’IT, et qui souhaitent se lancer dans la sécurité, auraient tout intérêt à s’en emparer ».

L’enquête menée par O’Reilly auprès des entreprises utilisatrices d’IA générative révèle une adoption rapide, mais aussi des obstacles et des préoccupations majeures, comme la difficulté à trouver des cas d’utilisation métiers, les incertitudes juridiques et les coûts d’infrastructure élevés.

Selon un rapport de l’éditeur et fournisseur de formation O’Reilly, l’IA générative, cette technologie d’intelligence artificielle menée par les grands modèles de langage GPT d’OpenAI et ChatGPT, connaît des niveaux d’adoption rapides et inédits. Mais des problèmes subsistent notamment l’absence d’analyse de rentabilité et des questions juridiques préoccupantes. Publié le 21 novembre, le rapport « 2023 Generative AI in the Enterprise » indique que deux tiers des personnes interrogées utilisent déjà l’IA générative. « Aucune technologie n’a été adoptée aussi rapidement que l’IA générative, au point qu’il est difficile de croire que ChatGPT a à peine un an. Néanmoins, la difficulté à trouver des cas d’utilisation commerciale et les préoccupations juridiques freinent l’IA générative », indique le rapport.

Par ailleurs, ces solutions mal conçues et mal mises en œuvre peuvent être dommageables, et des incertitudes demeurent sur les conséquences juridiques. Par exemple, la question des droits d’auteur liés à l’IA est source de plusieurs contentieux. « La culture d’entreprise peut également freiner l’adoption de l’IA », a encore déclaré O’Reilly. « À certains égards, ignorer le besoin est aussi pénalisant que de ne pas trouver de cas d’utilisation métiers appropriés ». La difficulté et le coût élevé de la mise en place d’une infrastructure pour l’IA générative sont aussi évoqués. L’enquête qui a servi de base à ce rapport a été réalisée du 14 au 23 septembre 2013. « Sur un total de 4 782 réponses, 2 857 personnes ont répondu à toutes les questions », a précisé O’Reilly. 74% des réponses provenaient d’Amérique du Nord ou d’Europe.

77 % des personnes sondées utilisent l’IA comme aide à la programmation

Parmi les autres conclusions du rapport « 2023 Generative AI in the Enterprise » d’O’Reilly, on note que 54 % des utilisateurs d’IA pensent que les gains en productivité seront l’un des plus gros apports de l’IA. Seuls 4 % d’entre eux évoquent une réduction du nombre d’employés. Par ailleurs, 77 % des personnes interrogées utilisent l’IA comme aide à la programmation. Parmi les applications spécifiques citées figurent la détection des fraudes, l’enseignement et la gestion de la relation client. Sur la question des compétences, selon les utilisateurs d’IA, ce sont celles dans la programmation de l’IA (66 %) et dans l’analyse des données (59 %) qui sont les plus recherchées.

Si l’on s’intéresse aux early adopter de cette technologie, on constate que 26 % travaillent avec l’IA depuis moins d’un an, tandis que 18 % ont déjà des applications en production. Enfin, 16 % des personnes interrogées travaillant avec l’IA utilisent des modèles open source. Le rapport pointe également du doigt les principaux risques surveillés par les utilisateurs d’IA, à savoir les résultats inattendus, la sécurité, la sûreté, l’équité, la partialité et la protection de la vie privée.

Les différents rebondissements du licenciement de Sam Altman d’OpenAI suscitent des interrogations sur un marché en pleine croissance.

Depuis vendredi dernier, le monde de l’IA a vécu à l’heure des différents soubresauts chez OpenAI après la décision du conseil d’administration de limoger son CEO, Sam Altman. Retour probable, regrets, menaces de la part des salariés, recrutements chez Microsoft, le feuilleton a alimenté les médias tout le week-end. Mais il a aussi soulevé des interrogations sur l’impact d’une telle affaire sur le développement de l’IA générative.

Une vie sans OpenAI est possible

Pour plusieurs experts, si OpenAI venait à imploser, cela n’aurait pas d’incidence notable sur le développement de l’IA. « Ce n’est plus un secret pour personne, les gens savent ce que ces modèles peuvent faire et les recettes pour y parvenir », a déclaré Braden Hancock, CTO et cofondateur de Snorkel AI, une startup qui aide les entreprises à développer de grands modèles de langage (LLM) pour un usage spécifique. « Open AI a réussi à commercialiser et à livrer le produit, mais au moins une douzaine de grandes entreprises IT, bien financées et dotées en personnel, développent simultanément la technologie de base, sans parler des laboratoires de recherche et des centaines de startups spécialisées dans l’IA », ajoute-t-il.

« Elles ont eu l’avantage d’être les premières à se lancer, mais l’IA générative est là pour durer, peu importe qui mène la course en tête à un moment ou à un autre », précise le dirigeant. Il conseille aux entreprises qui déploient ou envisagent de déployer des plateformes d’IA générative, d’élaborer leurs stratégies d’IA de manière responsable, c’est-à-dire de ne pas trop dépendre d’un seul fournisseur. « Tout comme le multi-cloud a été essentiel dans la gestion des risques pour les entreprises pendant des années, le multi-LLM devrait l’être également », déclare-t-il.

L’IA générative, un Far West à réguler

Selon Jack Gold, analyste principal chez J. Gold Associates, l’univers de l’IA est actuellement un véritable Far West. Et avec le changement de direction d’OpenAI, il est devenu encore plus sauvage. « Les deux créateurs, fondateurs et forces vives d’OpenAI ont été embauchés par Microsoft, qui est aujourd’hui un investisseur », observe le consultant. « Mais à l’avenir, Microsoft deviendra un concurrent direct. Le fait qu’ils dirigent le laboratoire d’IA avancée de Microsoft leur donne la possibilité de recréer et de surpasser ce qu’OpenAI a fait. Microsoft dispose d’une quantité massive de ressources qu’il peut mettre en œuvre ».

Avivah Litan, analyste distinguée et vice-présidente de Gartner, a déclaré que le conflit au sein d’OpenAI montre la nécessité d’une réglementation mondiale pour une IA sûre et sécurisée. « Notre sécurité future ne devrait pas dépendre des caprices des individus qui dirigent les entreprises d’IA vers une IA générative », constate la consultante, faisant référence à la marche vers la « singularité », c’est-à-dire le moment où l’IA n’aura plus besoin du contrôle de l’homme. « Le récent décret du Président Joe Biden, qui a mis en place des garde-fous autour de l’IA pour les agences fédérales, représente un bon début vers une réglementation substantielle significative, mais il faut aller plus loin », ajoute-t-elle. Avant de compléter, « la crise d’OpenAI devrait servir de signal d’alarme quant au besoin urgent d’action et de leadership ».

Un chaos où l’open source a sa carte à jouer

Selon Cliff Jurkiewicz, vice-président de la stratégie mondiale pour le service de recrutement basé sur l’IA Phenom, contrairement aux technologies de rupture précédentes, ChatGPT et d’autres outils d’IA génératives innovent à un rythme beaucoup plus rapide. Il pense que ce qui se joue publiquement dans l’affaire OpenAI, c’est la capacité de suivre ce rythme tout en maintenant la stabilité et la confiance dans leur prise de décision. « Le conseil d’administration d’OpenAI a adopté l’approche « fail fast » de l’innovation et l’a appliquée à la gestion d’une entreprise. Mais ce n’est pas de l’innovation. C’est le chaos », estime Cliff Jurkiewicz. « La monétisation de la technologie n’était pas conforme à la mission et aux valeurs du conseil d’administration. Nous vivons dans un monde capitaliste. Les entreprises peuvent être à la fois rentables et éthiques. La confiance dans une entreprise dépendra du niveau d’éthique auquel elle se situe quant à l’usage de l’intelligence artificielle, si, en particulier, elle fait passer l’humain au premier plan ».

« En tant que start-up, OpenAI dépend presque entièrement d’investisseurs en capital-risque, et ceux-ci, sont souvent impatients d’obtenir un retour rapide sur leurs investissements », analyse Jon Gold. C’est peut-être ce qui a conduit au licenciement de Sam Altman. Bizarrement, celui-ci a fait partie des 33 700 personnes qui ont signé une lettre ouverte, avec des personnalités du monde de la technologie comme le cofondateur d’Apple Steve Wozniak, appelant à une pause dans le développement du LLM GPT d’OpenAI. Les experts du secteur ont estimé que la prochaine itération du LLM, GPT-5, pourrait se réaliser et ouvrir la porte à l’inconnu en matière d’IA. « Même si quelques startups d’IA pourraient pâtir de cette situation, elles ne sont pas les seules sur le marché », a déclaré Luis Ceze, CEO de la plateforme de déploiement de modèles d’IA OctoML, professeur à l’université de Washington et investisseur en capital-risque chez Madrona Ventures. « Par exemple, l’open source offre aujourd’hui un tas de modèles qui permettent aux entreprises de se diversifier. Ce faisant, ces startups peuvent se transformer rapidement et minimiser les risques ». Selon lui, l’affaire OpenAI pourrait avoir un « effet positif majeur » dans la mesure où de nombreux modèles open source surpassent déjà GPT-4 en termes de prix, de performances et de rapidité. Ils ne sont tout simplement pas encore reconnus.

Cette année, le trophée innovation fait son apparition et récompense la start-up la plus innovante. C’est Sekoia.io, jeune pousse française spécialisée dans la lutte contre les menaces et le renseignement cyber qui remporte le titre. On retrouve respectivement en 2e et 3e position les start-ups Nano Corp et Optimize Network.

10 start-ups prétendaient au titre Innovation Startup 2023 du Monde Informatique. Après plusieurs semaines de vote et de mobilisation des lecteurs, c’est finalement Sekoia.io qui est arrivée en tête, représentée par son fondateur et dirigeant, Freddy Milesi. La société de cybersécurité à l’origine de la plateforme éponyme orientée XDR (eXtended Detection & Response) s’est faite remarquer en mai dernier lors de sa dernière levée de fonds – 35 millions d’euros – auprès de la Banque des Territoires, de l’investisseur européen Bright Pixel (ex-Sonae IM) et de ses investisseurs historiques Omnes Capital, Seventure et BNP Paribas Développement. L’annonce avait fait mouche avec un montant qui défie les observations relatives au ralentissement du marché de l’investissement en ce début d’année 2023. Son précédent tour de table de 10 millions d’euros remontait à 2020 et marquait alors son lancement commercial.

Créé en 2019, juste avant la pandémie de covid, Sekoia.io est né de la séparation des activités conseils et solutions de la société Sekoia spécialisée dans le renseignement cyber et la lutte contre les menaces. Le projet a ensuite incubé durant cinq ans. C’est donc en 2020 que la plateforme de détection et de réponse aux cybermenaces naît pour se protéger contre des attaques de plus en plus complexes. Une offre de cyber threat intelligence conçue par une équipe de chercheurs qui se démarque par son approche favorisant l’interopérabilité grâce à l’intégration de toutes les solutions cyber de ses clients pour fournir une tour de contrôle unique. Depuis, Sekoia.io a largement fait ses preuves, aussi bien utilisée par des grandes entreprises du CAC40, des administrations européennes et françaises, ou encore des acteurs majeurs des services de sécurité managés. Elle s’appuie pour cela sur un modèle de ventes 100 % indirect via un réseau de revendeurs et de MSSP.

Nano Corp et Optimize Network complètent le podium

Les votes des lecteurs du Monde Informatique ont placé Nano Corp en deuxième position du podium. Fondée en 2019 par une équipe issue de l’unité cyber du ministère de la Défense, dont son dirigeant Fanch Francis, Nano Corp propose le contrôle des réseaux – cartographie de l’environnement, analyse temps réel des flux, visibilité des tunnels et réseaux virtuels, détection des goulots d’étranglement – mais aussi la sécurité avec l’analyse événementielle, l’intégration avec les gestions de flotte et des services de type Siem ou SOAR. Elle bénéficie du soutien du plan France 2030 et de BPI et a notamment été sélectionnée pour intégrer l’accélérateur d’Intel (Ignite) et le programme start-up d’OVH. Début octobre, elle a bouclé un tour de table de 4,2 millions d’euros en seed, mené par G+D Ventures, avec Elaia Partners (investisseur historique), ainsi que Cyber K1 et Inovia Capital Precede Fund I.

Enfin, en troisième position nous retrouvons Optimize Network, créé et dirigé par Mickaël Charrier. La jeune pousse Ligérienne propose une plateforme de centralisation des données IoT avec pour axe principal l’optimisation des réseaux télécom, eau et énergie. La start-up s’attache à faciliter la visualisation des données avec des tableaux de bord personnalisables. Son objectif : accompagner ses clients sur la conception et le déploiement de solutions IoT. Sa plateforme est disponible en mode SaaS ou on-premise, interopérable à l’aide d’API notamment pour s’adapter aux applicatifs métiers. Côté stabilité financière, l’entreprise annonce avoir réalisé un chiffre d’affaires de 170 000 euros pour son premier exercice et vise un doublement de ce dernier sur l’exercice 2023.

Alors que des conflits cinétiques se déroulent sur deux terrains internationaux importants et que la crainte de voir la Chine infiltrer furtivement des infrastructures critiques augmente, les experts présents à la conférence Cyberwarcon aux États-Unis ont évoqué les dommages croissants que peuvent causer les cyber-outils malveillants.

Alors que les conflits militaires causent des destructions dévastatrices dans le monde physique, les gouvernements de l’Ukraine et d’Israël luttent contre l’escalade des dommages cyber, causés par des acteurs de la menace soutenus, ou non, par des États. Dans ce contexte, le gouvernement américain s’inquiète de plus en plus de la Chine et de sa capacité à passer en mode cyberguerre active. Lors de la Cyberwarcon organisée le 9 novembre dernier à Arlington, en Virginie, des experts gouvernementaux et industriels de haut niveau se sont réunis pour examiner les espaces complexes et multilatéraux dans lesquelles les cyberattaques et les menaces numériques connues et émergentes apparaissent dans le cadre de conflits imprévisibles. Il ressort de ces discussions que l’agression menée par la Russie dans le cyberespace devient de plus en plus destructrice, que le paysage de la désinformation et des perturbations numériques au Moyen-Orient est encore très mouvant et que l’infiltration permanente et difficile à repérer des infrastructures critiques américaines par des cyber-espions chinois pourrait préparer le terrain pour des actions dangereuses à venir.

Inquiétudes sur la Chine

Même si l’on sait que la Chine utilise largement ses compétences en cybersécurité pour voler de la propriété intellectuelle et espionner, il n’est pas rassurant qu’une loi chinoise adoptée en 2021 oblige les entreprises IT opérant dans le pays à signaler la découverte de failles exploitables à une base de données nationale sur les vulnérabilités dans les 48 heures suivant leur découverte, avant la disponibilité d’un correctif. Cette réglementation s’accompagne d’une série de restrictions sur ce que les chercheurs en sécurité peuvent dire au sujet des failles qu’ils découvrent. Cette obligation conduira probablement à la constitution d’un stock secret de failles de type zero day qui pourront être partagées avec le ministère chinois de la sécurité d’État, chargé de superviser les opérations de piratage parrainées par l’État. Lors de la Cyberwarcon, Dakota Cary, chercheur non résident au Global China Hub de l’Atlantic Council, et Kristin Del Rosso, directrice technique de Sophos pour le secteur public, ont présenté leurs recherches sur le fonctionnement et les implications que fait peser cette menace. « Je pense que certaines personnes commencent à comprendre la gravité de la situation », a déclaré la dirigeante.

L’accumulation de failles zero day a entraîné « une augmentation de l’utilisation par les Chinois de failles zero-day pour pénétrer dans les infrastructures critiques des États-Unis », a déclaré pour sa part Morgan Adamski, directrice du Cybersecurity Collaboration Center (CCC) de la NSA, lors de l’événement. En exhortant l’industrie à collaborer avec son agence sur la question de la Chine, Morgan Adamski a averti que « la République Populaire de Chine (RPC) disposait de ressources considérables ». Ajoutant que, selon le gouvernement américain, « leurs ressources étaient plus importantes que celles des États-Unis et de tous nos alliés réunis ». « La capacité de la Chine à échapper à la détection et à masquer ses activités explique en grande partie pourquoi le gouvernement américain a intensifié ses efforts pour sensibiliser l’industrie aux cyberdangers que représente la Chine », a-t-elle encore déclaré. « L’une de nos principales préoccupations est que la Chine continue d’utiliser l’infrastructure nationale américaine pour dissimuler ses activités et échapper à la détection du gouvernement et de l’industrie », ajoute-t-elle. « La Chine utilise un grand nombre d’infrastructures et de réseaux clandestins pour accéder aux infrastructures essentielles des États-Unis ». Cette intrusion est un projet à long terme. Selon Morgan Adamski, « la Chine se pré-positionne dans l’intention de s’infiltrer discrètement dans les réseaux essentiels pendant une longue période ».

Josh Zaritsky, directeur des opérations du Cybersecurity Collaboration Center de la NSA, a déclaré pour sa part que l’une des techniques utilisées par la Chine, et plus exactement par le groupe APT connu sous le nom de Volt Typhoon, pour s’introduire dans les réseaux américains, consiste à vivre en dehors du territoire ou à exploiter des produits courants que les acteurs de la menace utilisent pour éviter la détection. « Ils veulent continuer à nier avoir fait quoi que ce soit, même s’ils se font prendre. Autant dire qu’il n’y a pas grand-chose que l’on peut faire face à ce type d’acteurs qui exploitent les éléments déjà présents dans l’environnement ». En ce qui concerne Volt Typhoon, « nous n’avons détecté aucun signe d’attaques informatiques », ajoute Mark Parsons, principal analyste au Threat Intelligence Center de Microsoft. « Nous savons que c’est toujours l’impression qui se dégage. Nous n’avons rien vu de tel jusqu’à présent, mais c’est une chose à laquelle nous sommes évidemment attentifs. Nous avons remarqué que Volt Typhoon passait beaucoup de temps à essayer de maintenir la persistance à l’intérieur des réseaux. Ils sont très actifs à ce sujet, et ils sont là sur le long terme », a-t-il précisé. Malgré l’absence d’attaques actives, le groupe Volt Typhoon pourrait se préparer à des offensives destructrices. « Nous pensons qu’il y a là une possibilité de destruction ou de perturbation », a affirmé Judy Ng, analyste principale au sein du centre de Threat Intelligence de Microsoft.

Des attaques destructrices et permanentes de la Russie contre l’Ukraine

Volt Typhoon n’est pas le seul acteur soutenu par un État-nation à agir hors du territoire de son commanditaire pour dissimuler ses activités. Lors de la Cyberwarcon, John Wolfram, analyste principal au sein de l’équipe Mandiant Advanced Practices, et Mike Worley, analyste principal au sein de l’équipe Mandiant Cyber-Physical Threat, sont revenus plus en détail sur le rapport publié par les chercheurs en cybersécurité de la firme sur le groupe russe Sandworm, lequel associait le groupe à l’unité militaire 74455 du GRU russe. Ce rapport expliquait comment, fin 2022, Sandworm avait provoqué une panne d’électricité en Ukraine en ciblant un opérateur, panne qui avait coïncidé avec des frappes massives de missiles sur des infrastructures critiques dans toute l’Ukraine. L’attaque a mis en évidence la maturité croissante de l’arsenal technologique opérationnel offensif de la Russie. « Plus précisément, Sandworm a ciblé un composant du système MicroSCADA de Hitachi Energy, que plus de 10 000 sous-stations utilisent dans plus de 70 pays pour surveiller l’alimentation en électricité d’environ 10 % de la population mondiale », a expliqué Mike Worley. « Mener des actions en dehors du pays commanditaire est une caractéristique clé des opérations de Sandworm », a déclaré John Wolfram. « Ce qui est vraiment intéressant dans leur manière de procéder, c’est que ce groupe se fait souvent passer pour un service système officiel et l’arrête à temps pour qu’il corresponde aux services officiels », a-t-il ajouté.

« Depuis le début de l’invasion à grande échelle, l’adversaire se concentrait principalement sur la destruction des systèmes, l’effacement des données, etc. », a déclaré Victor Zhora, chef adjoint du service d’État ukrainien des communications spéciales et de la protection de l’information. « De nombreuses cyberattaques ont été combinées à des frappes physiques et à de brèves coupures d’électricité dans différentes régions, et la question est de savoir si elles sont dues à des cyberattaques ou à des attaques physiques. Dans la guerre Hamas-Israël, la Russie a déjà commencé à déployer certaines des tactiques utilisées en Ukraine, notamment des campagnes DDoS et l’infiltration de caméras de télévision en circuit fermé », poursuit Victor Zhora. « Nous nous attendions à ce que la Russie étende ces tactiques au-delà des territoires ukrainiens et à d’autres pays, et qu’elle ne se concentre pas uniquement sur des entreprises commerciales ou des ennemis gouvernementaux de nos alliés », a-t-il ajouté.

Les cybercriminels associés au Hamas pris au dépourvu

Israël est le dernier pays en date à avoir été victime d’attaques de groupes liés à la guerre. Cependant, le contexte de sa guerre avec le Hamas est compliqué par le déclenchement inattendu et soudain des hostilités début octobre et par l’implication d’adversaires autres que des acteurs politiques étatiques. Selon Yuri Rozhansky, directeur de recherche chez Mandiant, et Ben Read, directeur de l’équipe d’analyse du cyberespionnage de Mandiant Threat Intelligence, les trois principales menaces cybernétiques dans la guerre Hamas-Israël sont la démoralisation, la désinformation et la perturbation. « La démoralisation est évidemment très importante dans les opérations de désinformation et, plus généralement, cette désinformation est encore plus importante après coup, quand les gens ont été pris au dépourvu par l’attaque et qu’elle bascule dans l’espionnage, comme c’est toujours le cas », a déclaré Ben Read. « La combinaison de ces menaces a changé depuis le déclenchement de la guerre par le Hamas. La communauté de la sécurité s’est vraiment mobilisée pour tenter de défendre les réseaux et protéger tous ceux qui sont menacés », a-t-il ajouté.

Dans l’ensemble, les efforts déployés par les acteurs palestiniens de la menace, principalement associés au Hamas, pour démoraliser Israël ou diffuser de la désinformation ont échoué. « Il y a eu beaucoup d’actions contre des cibles israéliennes. Mais, ce qui est intéressant, c’est que la plupart ont échoué. Des gens ont affirmé que certains sites web étaient hors service, mais je pense que la plupart des sites étaient en service 98 % du temps », a déclaré Ben Read. Les faibles performances des acteurs de la menace pro-Hamas sont probablement liées au manque de ressources. Ben Read ajoute que la bande de Gaza ne fonctionne pas bien et il n’exclut pas que les personnes qui travaillaient sur les cyberactivités avant la guerre aient été appelées au service militaire actif. « Ces groupes n’ont pas accès à des tonnes de ressources sophistiquées, mais ils ont le temps, et ils sont nombreux », a-t-il déclaré.

L’Iran fait partie des États-nations à être intervenus dans la guerre. « En privé, nous avons constaté que le Ministère iranien du renseignement et de la sécurité (Ministry of Intelligence and Security, MOIS) et le Corps des gardiens de la révolution islamique (Islamic Revolutionary Guard Corps, IRGC) ciblent des organisations à mesure que le conflit prend de l’ampleur », a déclaré Simeon Kakpovi, analyste principal au Threat Intelligence Center de Microsoft. « Du côté du MOIS, nous avons comptabilisé au moins neuf acteurs actifs. Du côté du CGRI, nous avons compté au moins sept groupes actifs dans le cadre du conflit », a déclaré Simeon Kakpovi. « Cependant, nous n’avons aucune preuve que les acteurs iraniens de la menace étaient réellement préparés pour ces attaques. Ce que nous avons vu principalement, c’est que les acteurs iraniens ont profité de l’accès et des capacités qu’ils avaient déjà et qu’ils ont essayé d’en tirer le meilleur parti. Ils ont surtout réagi, plus qu’ils n’ont agi », a-t-il ajouté.

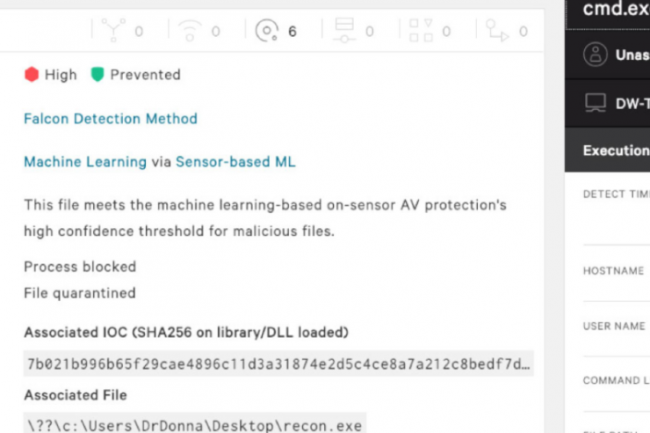

La mise à jour Go de la plateforme Falcon de CrowdStrike apporte aux petites et moyennes entreprises une solution de sécurité des endpoint renforcée à l’intelligence artificielle.

Appelée Falcon Go, la plateforme en cybersécurité de CrowdStrike est présentée comme « un produit de sécurité unique et sans friction qui laisse l’IA faire le travail à la place du personnel IT ». Facile à déployer, ce produit protège les endpoints. Elle comporte un assistant d’installation, des préréglages intégrés pour de nombreuses tâches de protection courantes et un écran d’accueil unifié montrant l’activité des menaces et les appareils protégés. La console principale fournit également des options de gestion pour la majeure partie du système, ce qui permet aux utilisateurs de gérer les terminaux, de déployer des agents et de gérer les autorisations des utilisateurs.

L’idée est de fournir une cybersécurité robuste et facile à utiliser – « accessible aux utilisateurs non techniques », selon la présentation de l’éditeur – contre les menaces courantes, notamment les ransomwares, le vol de données via des appareils non sécurisés et bien d’autres encore. « Les PME achètent des solutions de cybersécurité parce qu’elles se sentent obligées de le faire, mais jusqu’à présent, il n’y avait pas de solution solide qui leur était spécifiquement destinée », a expliqué Daniel Bernard, directeur général de CrowdStrike. « Ces entreprises de cinq à deux cents personnes n’ont pas de centre opérationnel de sécurité, et si on leur demandait à quoi ressemble leur SOC, elles baisseraient probablement les yeux », a ajouté le directeur général.

Un duo d’IA comportementale et statique

Comme la plupart des solutions de protection des terminaux et serveurs du marché, Falcon Go ne se contente pas d’utiliser la détection basée sur les signatures pour identifier les menaces déjà connues. Le système se sert plutôt l’analyse comportementale de l’IA pour comprendre leur activité sans qu’il soit nécessaire d’identifier les signatures. Selon Daniel Bernard, « l’expérience de l’entreprise dans le domaine de l’IA remonte à plusieurs années ». Il précise que Falcon Go, comme de nombreux produits du groupe, embarque deux types d’IA pour assurer la sécurité. Outre la détection de l’IA comportementale, le système adopte l’IA statique – l’intelligence artificielle formée sur un ensemble de données spécifiques – pour identifier les menaces qui auraient été détectées par les systèmes basés sur les signatures.

L’utilisation de l’intelligence artificielle a donné lieu à un changement de marque. La qualification « cloud native », généralisée jusque-là pour les produits de CrowdStrike, passe à « AI native » pour Falcon Go. Le prix de la plateforme démarre à 300 dollars par an, pour 5 terminaux. Un essai gratuit de 15 jours est disponible. Dans un communiqué, CrowdStrike a aussi déclaré qu’une assistance 24/7 et des services managés étaient disponibles.