La déclaration de Bletchley, signée lors du AI Safety Summit constituera une ligne de pensée commune afin de superviser l’évolution de l’IA et de garantir que la technologie progresse en toute sécurité.

La Chine et les États-Unis ont accepté de collaborer avec au moins 25 autres pays pour atténuer les risques liés à la progression de l’IA. Les deux pays, ainsi que plusieurs autres, dont l’Allemagne, la France, l’Inde ainsi que l’UE ont signé un accord, baptisé « Bletchley declaration », lors du sommet britannique sur la sécurité de l’IA, afin d’établir une ligne de conduite commune pour superviser l’évolution de l’IA et veiller à ce que la technologie progresse en toute sécurité. L’accord porte le nom d’un lieu à Londres – Bletchley Park – qui a abrité l’équipe dirigée par Alan Turing pour déchiffrer les codes de la machine Enigma pendant la seconde guerre mondiale.

Le sommet au cours duquel l’accord a été signé s’est déroulé en présence de plusieurs dirigeants politiques et des CEO d’entreprises technologiques, dont Elon Musk et le CEO d’OpenAI, Sam Altman. La déclaration de Bletchley invite les pays membres signataires à adopter deux grandes approches pour contrôler les risques de guerre nucléaire, chimique ou biologique découlant de l’IA. « Nous sommes particulièrement préoccupés par ces risques dans des domaines tels que la cybersécurité et la biotechnologie, ainsi que dans les cas où les systèmes d’IA les plus poussés peuvent amplifier des risques tels que la désinformation. Les capacités les plus importantes de ces modèles d’IA peuvent entraîner des dommages graves, voire catastrophiques, délibérés ou involontaires », souligne l’accord.

Deux approches pour endiguer les risques liés à l’IA

La première approche consiste à identifier les risques de sécurité liés à l’IA qui suscitent des préoccupations communes, puis à les comprendre avec des données scientifiques et factuelles. Une fois cette compréhension acquise, les pays membres évalueront l’évolution des capacités de l’IA et mesurer son impact sur la société dans son ensemble, selon l’accord.

La deuxième approche consiste à élaborer des politiques fondées sur les risques dans les pays membres afin de garantir la sécurité. A noter que ces politiques peuvent varier en fonction des circonstances nationales et des cadres juridiques applicables. « Cette deuxième approche comprend, outre une transparence accrue de la part des acteurs privés qui développent des capacités d’IA de pointe, des mesures d’évaluation appropriées, des outils pour tester la sécurité, ainsi que le développement de capacités et de recherches scientifiques pertinentes dans le secteur public », peut-on lire dans l’accord.

Les États-Unis ont pris de l’avance en matière de régulation de l’IA

Au début du mois de mai, des centaines de dirigeants de l’industrie technologique, d’universitaires et d’autres personnalités ont signé une lettre ouverte avertissant que l’évolution de l’IA pourrait conduire à un phénomène d’extinction et déclarant que le contrôle de cette technologie devrait être une priorité mondiale absolue.

Cette semaine, OpenAI, à l’origine de ChatGPT, a déclaré qu’il préparait une équipe pour empêcher ce que l’entreprise appelle les modèles d’IA d’avant-garde de déclencher une guerre nucléaire et d’autres menaces. L’administration du président américain Joe Biden a également publié cette semaine un décret attendu depuis longtemps, qui définit des règles claires et des mesures de contrôle pour veiller à ce que l’IA soit maîtrisée, tout en lui offrant la possibilité de se développer.

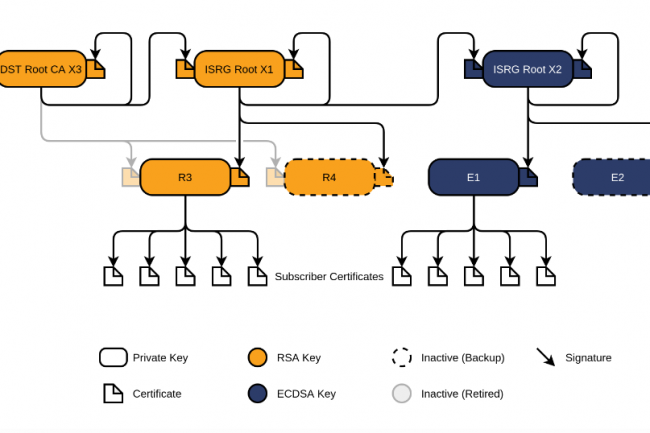

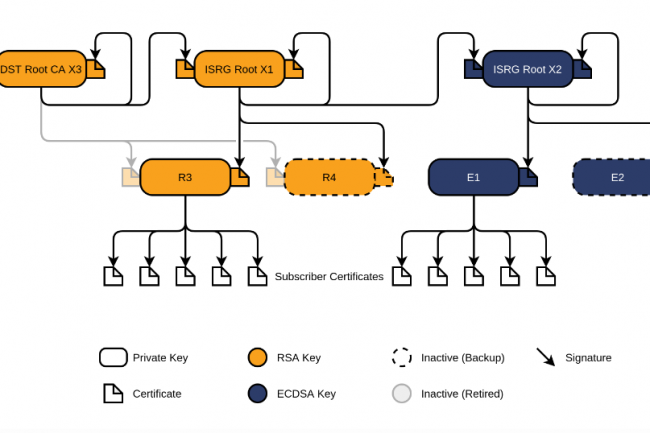

Si le soutien d’une fondation est important, ce qui compte le plus c’est d’apporter une solution technologique solide à un problème reconnu. Une recette dont a manifestement pu bénéficier l’autorité de certification Let’s Encrypt dépendant de l’Internet Security Research Group.

Dans le domaine des logiciels en général et de l’open source en particulier, le taux de réussite des fondations est très variable. Dans certains cas, l’absence de soutien de la part des fournisseurs de cloud est flagrante, comme avec l’Open Enterprise Linux Association et d’OpenTofu, alors que dans d’autres tel que Kubernetes, la communauté est soutenue par sa fondation. En fait, les fondations peuvent contribuer à encourager la communauté, mais elles ne sont pas en elles-mêmes une garantie de succès. C’est la raison pour laquelle Let’s Encrypt et l’Internet Security Research Group (ISRG) sont si fascinants.

Les motifs de leur réussite n’ont rien d’évident, et pourtant, dix ans plus tard, Let’s Encrypt de l’ISRG a délivré plus d’un milliard de certificats pour sécuriser plus de 360 millions de sites web. Il est également probable que Prosimmo (projet de sécurisation de la mémoire) et Divvi Up (système de mesure préservant la vie privée), suivront ce modèle. Même si de nombreuses autres fondations ne parviennent pas à remporter des victoires similaires, ce qui a été un peu le cas d’OpenStack. La question est de savoir pourquoi. Pourquoi Let’s Encrypt a réussi, et quelles leçons peuvent en tirer d’autres organisations à but non lucratif ou projets open source ?

10 ans de sécurisation de l’internet

L’une des principales raisons du succès de Let’s Encrypt est qu’il a résolu un problème de taille. Au moment de la création de Let’s Enrypt, à peine 28 % des chargements de pages étaient sécurisés sur le web. « Il y avait beaucoup d’autres options disponibles, comme le TLS et le SSL, mais elles n’étaient pas largement utilisées », a rappelé Sarah Gran, vice-présidente des communications de l’ISRG. « Pour faire réellement progresser la sécurité du web, il fallait que cela change et que cela corresponde davantage au rythme de la croissance et de la dépendance à l’égard de l’Internet qu’expérimentaient chaque jour les utilisateurs », a-t-elle ajouté. Let’s Encrypt n’a pas essayé de changer les choses avec des messages d’intérêt public. Elle s’est concentrée sur l’automatisation et la simplification du processus d’obtention des certificats. Plus les développeurs pouvaient adopter et appliquer facilement des certificats à leurs sites web, plus ils étaient susceptibles de les utiliser. Comme l’a affirmé Steve O’Grady de RedMonk, « la facilité d’utilisation l’emporte sur tout le reste pour les développeurs ».

Par ailleurs, le fait que l’Internet Security Research Group et son initiative Let’s Encrypt n’aient pas eu pour objectif de concurrencer les autorités de certification commerciales a également joué un rôle. « Nous ne sommes pas là pour jouer les héros », a expliqué Sarah Gran. « Tout ce que nous essayons de faire, c’est de résoudre un problème. En travaillant avec des fournisseurs de certificats propriétaires, Let’s Encrypt pouvait se concentrer sur la résolution du problème de la sécurité de l’Internet, sans chercher à s’en attribuer le mérite », a-t-elle ajouté. Quand j’ai demandé à Sarah Gran quel était, selon elle, le secret de la réussite de l’ISRG avec Let’s Encrypt, celle-ci n’a pas hésité : « Nous savons ce que nous faisons bien et nous nous y tenons. Et ce que nous faisons bien, c’est nous attaquer à des problèmes d’infrastructure technique difficiles », en particulier en ce qui concerne la sécurité de l’Internet, à laquelle l’ISRG s’attaque sous l’angle de l’automatisation, de l’efficacité et de l’échelle. L’Internet Security Research Group se concentre sur la résolution de problèmes discrets, d’où ce succès retentissant avec Let’s Encrypt. Cette même orientation axée sur les fondations devrait aussi contribuer au succès de Prossimo et de Divvi Up.

Des secrets de réussite efficaces

Il est clair que l’approche de l’ISRG a fonctionné, lui permettant de travailler avec des entreprises « concurrentes » sans être compétitive. Cependant, il est important de noter que les fondations ne sont pas indispensables à la réussite d’un projet logiciel. Dans le monde des autorités de certification, Comodo et Digicert prospèrent aux côtés de Let’s Encrypt. En dehors du domaine de la sécurité de l’Internet, c’est à peu près la même chose. Il serait difficile d’affirmer que HashiCorp, MongoDB, Elastic, etc. ne sont pas très populaires et ne connaissent pas le succès commercial qui va avec. On ne peut pas dire non plus que l’introduction d’une fondation sur un marché garantit qu’elle fera mieux que les produits d’un seul fournisseur. À propos de HashiCorp, alors même que le projet OpenTofu était lancé avec l’idée de fournir un fork open source de Terraform, soutenu par la fondation HashiCorp, le CEO de la Fondation Linux, Jim Zemlin, m’avait dit qu’il pensait que « Terraform et OpenTofu allaient réussir pour des raisons différentes ». Selon lui, Terraform réussira parce qu’il s’agit d’un excellent logiciel soutenu par une entreprise crédible. Il pense également qu’OpenTofu prendra une grande part du marché : « Personne ne veut investir d’importantes ressources d’ingénierie dans un projet qui n’est pas détenu de manière neutre ou qui est détenu et contrôlé par une seule entité commerciale. Cela conduira à un « meilleur investissement » dans OpenTofu ». Même si les entreprises qui contribuent aujourd’hui à OpenTofu sont relativement petites, Jim Zemlin pense que « la dépendance des fournisseurs en aval à l’égard du code développé par OpenTofu créera un écosystème plus large, car davantage de fournisseurs réinvestiront pour améliorer leurs produits en aval ».

Les projets menés par les fondations semblent donc voués à l’échec avec le temps. Mais pourquoi dans ce cas Kubernetes a-t-il réussi alors qu’OpenStack a échoué, alors même que les deux sont portées par de fortes communautés soutenues par des fondations ? Selon Jim Zemlin, « il s’avère que les conteneurs Kubernetes apportaient la bonne abstraction pour les charges de travail du cloud et pas les VM OpenStack ». La technologie est importante. Aucune fondation ne peut aller à l’encontre du fait qu’il faut aussi être en phase avec les choix technologiques particuliers des clients.

La sécurité de la mémoire en question

Ce qui nous ramène à l’ISRG et à sa mission. Tout comme il l’avait fait en 2015 pour la sécurité des sites web, l’Internet Security Research Group constate aujourd’hui que la sécurité de la mémoire pose un problème tout aussi important. Comme le dit Sarah Gran, « après examen de notre infrastructure et des diverses infrastructures dont dépend l’Internet, nous avons constaté qu’une grande partie est écrite en C et en C++ », avec tous les problèmes de sécurité de la mémoire, de bogues et de vulnérabilités que cela implique. Pourquoi est-ce un problème aujourd’hui ? Après tout, cela fait longtemps que ces langages sont problématiques. Sarah Gran reconnaît que Microsoft et Google ont admis que la grande majorité de leurs vulnérabilités provenaient de problèmes de sécurité de la mémoire, ce qui a mis en évidence le fait que la sécurité de la mémoire était un problème important, qui pouvait être résolu par des langages comme Rust. Le succès sera-t-il comparable à celui de Let’s Encrypt ? Difficile de l’affirmer, mais s’il s’avère dans ce cas particulier qu’une technologie claire comme Rust peut résoudre ce problème, alors ce succès devient beaucoup plus probable. Qu’il s’agisse d’une fondation à but non lucratif ou d’une entreprise à but lucratif, le fait de se concentrer sur la résolution d’un problème client, et, avec un peu de chance, être aussi en phase avec les choix technologiques du client, semblent plus que jamais de bonnes garanties de réussite.

Si le soutien d’une fondation est important, ce qui compte le plus c’est d’apporter une solution technologique solide à un problème reconnu. Une recette dont a manifestement pu bénéficier l’autorité de certification Let’s Encrypt dépendant de l’Internet Security Research Group.

Dans le domaine des logiciels en général et de l’open source en particulier, le taux de réussite des fondations est très variable. Dans certains cas, l’absence de soutien de la part des fournisseurs de cloud est flagrante, comme avec l’Open Enterprise Linux Association et d’OpenTofu, alors que dans d’autres tel que Kubernetes, la communauté est soutenue par sa fondation. En fait, les fondations peuvent contribuer à encourager la communauté, mais elles ne sont pas en elles-mêmes une garantie de succès. C’est la raison pour laquelle Let’s Encrypt et l’Internet Security Research Group (ISRG) sont si fascinants.

Les motifs de leur réussite n’ont rien d’évident, et pourtant, dix ans plus tard, Let’s Encrypt de l’ISRG a délivré plus d’un milliard de certificats pour sécuriser plus de 360 millions de sites web. Il est également probable que Prosimmo (projet de sécurisation de la mémoire) et Divvi Up (système de mesure préservant la vie privée), suivront ce modèle. Même si de nombreuses autres fondations ne parviennent pas à remporter des victoires similaires, ce qui a été un peu le cas d’OpenStack. La question est de savoir pourquoi. Pourquoi Let’s Encrypt a réussi, et quelles leçons peuvent en tirer d’autres organisations à but non lucratif ou projets open source ?

10 ans de sécurisation de l’internet

L’une des principales raisons du succès de Let’s Encrypt est qu’il a résolu un problème de taille. Au moment de la création de Let’s Enrypt, à peine 28 % des chargements de pages étaient sécurisés sur le web. « Il y avait beaucoup d’autres options disponibles, comme le TLS et le SSL, mais elles n’étaient pas largement utilisées », a rappelé Sarah Gran, vice-présidente des communications de l’ISRG. « Pour faire réellement progresser la sécurité du web, il fallait que cela change et que cela corresponde davantage au rythme de la croissance et de la dépendance à l’égard de l’Internet qu’expérimentaient chaque jour les utilisateurs », a-t-elle ajouté. Let’s Encrypt n’a pas essayé de changer les choses avec des messages d’intérêt public. Elle s’est concentrée sur l’automatisation et la simplification du processus d’obtention des certificats. Plus les développeurs pouvaient adopter et appliquer facilement des certificats à leurs sites web, plus ils étaient susceptibles de les utiliser. Comme l’a affirmé Steve O’Grady de RedMonk, « la facilité d’utilisation l’emporte sur tout le reste pour les développeurs ».

Par ailleurs, le fait que l’Internet Security Research Group et son initiative Let’s Encrypt n’aient pas eu pour objectif de concurrencer les autorités de certification commerciales a également joué un rôle. « Nous ne sommes pas là pour jouer les héros », a expliqué Sarah Gran. « Tout ce que nous essayons de faire, c’est de résoudre un problème. En travaillant avec des fournisseurs de certificats propriétaires, Let’s Encrypt pouvait se concentrer sur la résolution du problème de la sécurité de l’Internet, sans chercher à s’en attribuer le mérite », a-t-elle ajouté. Quand j’ai demandé à Sarah Gran quel était, selon elle, le secret de la réussite de l’ISRG avec Let’s Encrypt, celle-ci n’a pas hésité : « Nous savons ce que nous faisons bien et nous nous y tenons. Et ce que nous faisons bien, c’est nous attaquer à des problèmes d’infrastructure technique difficiles », en particulier en ce qui concerne la sécurité de l’Internet, à laquelle l’ISRG s’attaque sous l’angle de l’automatisation, de l’efficacité et de l’échelle. L’Internet Security Research Group se concentre sur la résolution de problèmes discrets, d’où ce succès retentissant avec Let’s Encrypt. Cette même orientation axée sur les fondations devrait aussi contribuer au succès de Prossimo et de Divvi Up.

Des secrets de réussite efficaces

Il est clair que l’approche de l’ISRG a fonctionné, lui permettant de travailler avec des entreprises « concurrentes » sans être compétitive. Cependant, il est important de noter que les fondations ne sont pas indispensables à la réussite d’un projet logiciel. Dans le monde des autorités de certification, Comodo et Digicert prospèrent aux côtés de Let’s Encrypt. En dehors du domaine de la sécurité de l’Internet, c’est à peu près la même chose. Il serait difficile d’affirmer que HashiCorp, MongoDB, Elastic, etc. ne sont pas très populaires et ne connaissent pas le succès commercial qui va avec. On ne peut pas dire non plus que l’introduction d’une fondation sur un marché garantit qu’elle fera mieux que les produits d’un seul fournisseur. À propos de HashiCorp, alors même que le projet OpenTofu était lancé avec l’idée de fournir un fork open source de Terraform, soutenu par la fondation HashiCorp, le CEO de la Fondation Linux, Jim Zemlin, m’avait dit qu’il pensait que « Terraform et OpenTofu allaient réussir pour des raisons différentes ». Selon lui, Terraform réussira parce qu’il s’agit d’un excellent logiciel soutenu par une entreprise crédible. Il pense également qu’OpenTofu prendra une grande part du marché : « Personne ne veut investir d’importantes ressources d’ingénierie dans un projet qui n’est pas détenu de manière neutre ou qui est détenu et contrôlé par une seule entité commerciale. Cela conduira à un « meilleur investissement » dans OpenTofu ». Même si les entreprises qui contribuent aujourd’hui à OpenTofu sont relativement petites, Jim Zemlin pense que « la dépendance des fournisseurs en aval à l’égard du code développé par OpenTofu créera un écosystème plus large, car davantage de fournisseurs réinvestiront pour améliorer leurs produits en aval ».

Les projets menés par les fondations semblent donc voués à l’échec avec le temps. Mais pourquoi dans ce cas Kubernetes a-t-il réussi alors qu’OpenStack a échoué, alors même que les deux sont portées par de fortes communautés soutenues par des fondations ? Selon Jim Zemlin, « il s’avère que les conteneurs Kubernetes apportaient la bonne abstraction pour les charges de travail du cloud et pas les VM OpenStack ». La technologie est importante. Aucune fondation ne peut aller à l’encontre du fait qu’il faut aussi être en phase avec les choix technologiques particuliers des clients.

La sécurité de la mémoire en question

Ce qui nous ramène à l’ISRG et à sa mission. Tout comme il l’avait fait en 2015 pour la sécurité des sites web, l’Internet Security Research Group constate aujourd’hui que la sécurité de la mémoire pose un problème tout aussi important. Comme le dit Sarah Gran, « après examen de notre infrastructure et des diverses infrastructures dont dépend l’Internet, nous avons constaté qu’une grande partie est écrite en C et en C++ », avec tous les problèmes de sécurité de la mémoire, de bogues et de vulnérabilités que cela implique. Pourquoi est-ce un problème aujourd’hui ? Après tout, cela fait longtemps que ces langages sont problématiques. Sarah Gran reconnaît que Microsoft et Google ont admis que la grande majorité de leurs vulnérabilités provenaient de problèmes de sécurité de la mémoire, ce qui a mis en évidence le fait que la sécurité de la mémoire était un problème important, qui pouvait être résolu par des langages comme Rust. Le succès sera-t-il comparable à celui de Let’s Encrypt ? Difficile de l’affirmer, mais s’il s’avère dans ce cas particulier qu’une technologie claire comme Rust peut résoudre ce problème, alors ce succès devient beaucoup plus probable. Qu’il s’agisse d’une fondation à but non lucratif ou d’une entreprise à but lucratif, le fait de se concentrer sur la résolution d’un problème client, et, avec un peu de chance, être aussi en phase avec les choix technologiques du client, semblent plus que jamais de bonnes garanties de réussite.

Après le shadow IT, voici venu le temps du shadow IA. Les entreprises sont confrontées à une infiltration silencieuse de l’IA générative parmi leurs équipes, alors que seulement 28 % d’entre elles en autorisent expressément l’usage.

Les chefs d’entreprise semblent avoir perdu le contrôle du déploiement, de la supervision et des objectifs de l’IA générative au sein de leurs organisations, selon une nouvelle étude de Kaspersky. Or, d’après l’Isaca, association professionnelle internationale dont l’objectif est d’améliorer la gouvernance des systèmes d’information, 28 % seulement des organisations autorisent expressément l’usage de l’IA générative, et un nombre encore plus faible (10 %) ont mis en place une politique formelle encadrant cette utilisation. Une enquête récente menée par la société de marketing Add People a d’ailleurs révélé qu’un travailleur britannique sur trois utilise des outils d’IA générative à l’insu de son patron.

Les cadres profondément préoccupés par les risques de sécurité

La quasi-totalité (95 %) des 1 863 cadres dirigeants européens interrogés par Kaspersky pensent que l’IA générative est régulièrement utilisée par les employés, et plus de la moitié d’entre eux (53 %) déclarent même qu’elle pilote désormais certains départements de l’entreprise. L’ampleur de cette prise de contrôle est telle que la plupart des cadres (59 %) expriment de vives inquiétudes quant aux risques de sécurité potentiels liés à l’usage de la technologie, risques qui pourraient mettre en péril des informations sensibles de l’entreprise et entraîner une perte totale de contrôle des fonctions essentielles de l’entreprise.Seulement 22% des répondants expliquent que leur organisation discute de l’établissement de règles encadrant les usages en interne, alors que 91% d’entre eux estiment avoir besoin de mieux comprendre comment les données internes sont utilisées par les employés, afin de se protéger des risques de sécurité critiques ou des fuites de données.

Des politiques insuffisantes, une gestion des risques défaillante

L’enquête de l’Isaca menée auprès de 2 300 professionnels dans le monde révèle que si l’utilisation de l’IA générative s’intensifie, la plupart des organisations n’ont pas mis en place des politiques suffisantes ou une gestion efficace des risques. Pour 40 % des entreprises, les employés utilisent l’IA générative malgré tout, sans se soucier de ces faiblesses, un pourcentage probablement sous-estimé étant donné que 35 % des répondants ne se prononcent pas quant à l’attitude des collaborateurs.Les employés utilisent l’IA générative de plusieurs façons, notamment pour créer du contenu écrit (65%), augmenter la productivité (44%), automatiser les tâches répétitives (32%), fournir un service à la clientèle (29%) ou encore améliorer la prise de décision (27%), selon l’étude de l’Isaca.Alors que 41% des répondants à l’enquête estiment que les normes éthiques relatives à l’IA ne font pas l’objet d’une attention suffisante, moins d’un tiers des organisations considèrent la gestion des risques liés à la technologie comme une priorité immédiate. Et ce, bien que les personnes interrogées associent plusieurs risques à la technologie : la désinformation (77 %), les violations de la vie privée (68 %), l’ingénierie sociale (63), la perte de propriété intellectuelle (58 %) ou encore le déplacement des emplois et l’élargissement du fossé des compétences (35 % pour chaque item).

Une formation encore lacunaire

« Si l’enquête de l’Isaca montre que l’IA générative est largement utilisée à diverses fins, elle met également en évidence une lacune flagrante en matière de considérations éthiques et de mesures de sécurité », écrit Raef Meeuwisse, auteur de Artificial Intelligence for Beginners. « Seulement 6 % des organisations dispensent une formation complète à l’IA à l’ensemble de leur personnel, et 54 % d’entre elles n’offrent tout simplement aucune formation sur le sujet. »Ce manque de formation, associé à une attention insuffisante aux normes éthiques, peut entraîner des risques accrus, notamment l’exploitation par des acteurs malveillants, estime Raef Meeuwisse : « il n’est peut-être pas surprenant que 57 % des personnes interrogées soient très ou extrêmement préoccupées par l’exploitation de l’IA générative par des acteurs malveillants. »

Après le shadow IT, voici venu le temps du shadow IA. Les entreprises sont confrontées à une infiltration silencieuse de l’IA générative parmi leurs équipes, alors que seulement 28 % d’entre elles en autorisent expressément l’usage.

Les chefs d’entreprise semblent avoir perdu le contrôle du déploiement, de la supervision et des objectifs de l’IA générative au sein de leurs organisations, selon une nouvelle étude de Kaspersky. Or, d’après l’Isaca, association professionnelle internationale dont l’objectif est d’améliorer la gouvernance des systèmes d’information, 28 % seulement des organisations autorisent expressément l’usage de l’IA générative, et un nombre encore plus faible (10 %) ont mis en place une politique formelle encadrant cette utilisation. Une enquête récente menée par la société de marketing Add People a d’ailleurs révélé qu’un travailleur britannique sur trois utilise des outils d’IA générative à l’insu de son patron.

Les cadres profondément préoccupés par les risques de sécurité

La quasi-totalité (95 %) des 1 863 cadres dirigeants européens interrogés par Kaspersky pensent que l’IA générative est régulièrement utilisée par les employés, et plus de la moitié d’entre eux (53 %) déclarent même qu’elle pilote désormais certains départements de l’entreprise. L’ampleur de cette prise de contrôle est telle que la plupart des cadres (59 %) expriment de vives inquiétudes quant aux risques de sécurité potentiels liés à l’usage de la technologie, risques qui pourraient mettre en péril des informations sensibles de l’entreprise et entraîner une perte totale de contrôle des fonctions essentielles de l’entreprise.Seulement 22% des répondants expliquent que leur organisation discute de l’établissement de règles encadrant les usages en interne, alors que 91% d’entre eux estiment avoir besoin de mieux comprendre comment les données internes sont utilisées par les employés, afin de se protéger des risques de sécurité critiques ou des fuites de données.

Des politiques insuffisantes, une gestion des risques défaillante

L’enquête de l’Isaca menée auprès de 2 300 professionnels dans le monde révèle que si l’utilisation de l’IA générative s’intensifie, la plupart des organisations n’ont pas mis en place des politiques suffisantes ou une gestion efficace des risques. Pour 40 % des entreprises, les employés utilisent l’IA générative malgré tout, sans se soucier de ces faiblesses, un pourcentage probablement sous-estimé étant donné que 35 % des répondants ne se prononcent pas quant à l’attitude des collaborateurs.Les employés utilisent l’IA générative de plusieurs façons, notamment pour créer du contenu écrit (65%), augmenter la productivité (44%), automatiser les tâches répétitives (32%), fournir un service à la clientèle (29%) ou encore améliorer la prise de décision (27%), selon l’étude de l’Isaca.Alors que 41% des répondants à l’enquête estiment que les normes éthiques relatives à l’IA ne font pas l’objet d’une attention suffisante, moins d’un tiers des organisations considèrent la gestion des risques liés à la technologie comme une priorité immédiate. Et ce, bien que les personnes interrogées associent plusieurs risques à la technologie : la désinformation (77 %), les violations de la vie privée (68 %), l’ingénierie sociale (63), la perte de propriété intellectuelle (58 %) ou encore le déplacement des emplois et l’élargissement du fossé des compétences (35 % pour chaque item).

Une formation encore lacunaire

« Si l’enquête de l’Isaca montre que l’IA générative est largement utilisée à diverses fins, elle met également en évidence une lacune flagrante en matière de considérations éthiques et de mesures de sécurité », écrit Raef Meeuwisse, auteur de Artificial Intelligence for Beginners. « Seulement 6 % des organisations dispensent une formation complète à l’IA à l’ensemble de leur personnel, et 54 % d’entre elles n’offrent tout simplement aucune formation sur le sujet. »Ce manque de formation, associé à une attention insuffisante aux normes éthiques, peut entraîner des risques accrus, notamment l’exploitation par des acteurs malveillants, estime Raef Meeuwisse : « il n’est peut-être pas surprenant que 57 % des personnes interrogées soient très ou extrêmement préoccupées par l’exploitation de l’IA générative par des acteurs malveillants. »

Publié hier par la Maison-Blanche, ce décret très attendu établit des règles claires et des mesures de contrôle afin de garantir que l’intelligence artificielle reste maîtrisée, tout en lui ouvrant des voies de développement.

Dans un décret de grande envergure, le président américain Joseph R. Biden Jr. a mis en place lundi une série complète de normes, de mesures de sécurité, de protection de la vie privée et de contrôle pour le développement et l’utilisation de l’intelligence artificielle (IA). Selon de nombreux observateurs qui ont suivi l’évolution de l’IA et l’essor de l’IA générative (genAI) au cours de l’année écoulée, le décret de Joe Biden intitulé « Safe, Secure, and Trustworthy Artificial Intelligence » (Pour une intelligence artificielle sûre et fiable) était attendu depuis longtemps parmi une vingtaine d’autres initiatives. Outre les mesures de sécurité et de sûreté, le décret de Joe Biden traite de la protection de la vie privée des Américains et des problèmes liés à l’IA générative, en particulier pour ce qui est des préjugés et des droits civils. C’est le cas par exemple des systèmes de recrutement automatisés basés sur l’IA générative et leurs biais intégrés qui peuvent donner à certains candidats à l’emploi des avantages fondés sur leur race ou leur sexe.

Le décret s’appuie sur les orientations existantes de la loi de Production de défense ou Defense Production Act, datant de la guerre froide, qui confère au président américain un important pouvoir d’urgence pour contrôler les industries nationales, et exige des principaux développeurs de genAI qu’ils partagent les résultats des tests de sécurité et d’autres informations avec le gouvernement. L’Institut national des normes et de la technologie (National Institute of Standards and Technology, NIST) doit créer des normes pour garantir que les outils d’IA sont sûrs et sécurisés avant leur diffusion publique. « Le décret souligne la nécessité pour la communauté mondiale de porter une plus grande attention à la réglementation de l’IA, notamment après le boom de l’IA générative dont nous avons tous été témoins cette année », a déclaré Adnan Masood, architecte en chef de l’IA chez UST, une entreprise de services de transformation numérique. « L’aspect le plus marquant de cette ordonnance est qu’elle reconnaît clairement que l’IA n’est pas simplement une autre avancée technologique ; c’est un changement de paradigme qui peut redéfinir les normes sociétales », a ajouté Adnan Masood. « Reconnaître les ramifications d’une IA non maîtrisée est un début », fait-il encore remarquer, ajoutant que les détails sont encore plus importants. « C’est un bon premier pas, mais en tant que praticiens de l’IA, nous avons maintenant la lourde tâche de nous conformer à des détails complexes puisque le décret exige des développeurs qu’ils créent des normes, des outils et des tests pour garantir la sécurité des systèmes d’IA et qu’ils partagent les résultats de ces tests avec le public ».

Le décret demande au gouvernement américain de mettre en place un « programme de cybersécurité avancée » afin de développer des outils d’IA permettant de trouver et de corriger les vulnérabilités des logiciels critiques. En outre, le Conseil national de sécurité (National Security Council, NSC) doit se coordonner avec le chef de cabinet de la Maison-Blanche pour veiller à ce que les militaires et les services de renseignement utilisent l’IA en toute sécurité et dans le respect de l’éthique, quelle que soit leur mission. Enfin, le Département du Commerce des États-Unis (United States Department of Commerce) a été chargé d’élaborer des lignes directrices pour l’authentification des contenus et la création de filigranes afin de marquer clairement les contenus générés par l’IA, un problème qui prend rapidement de l’ampleur à mesure que les outils d’IA générative parviennent à imiter les œuvres d’art et d’autres types de contenus. « Les agences fédérales utiliseront ces outils pour aider les Américains à savoir facilement que les communications qu’ils reçoivent de leur gouvernement sont authentiques, et pour donner l’exemple au secteur privé et aux gouvernements du monde entier », indique le décret. À ce jour, les développeurs de logiciels indépendants et les départements IT des universités ont mené la charge contre le vol intentionnel ou non de la propriété intellectuelle et de l’art par l’IA. De plus en plus, les développeurs créent des outils capables de filigraner un contenu unique ou même d’empoisonner les données ingérées par les systèmes de genAI, qui fouillent l’Internet à la recherche d’informations sur lesquelles s’entraîner.

« Le contenu de ce décret nous pousse à avoir plus de questions »

Hier, les représentants du G7 se sont également mis d’accord sur un ensemble de principes de sécurité de l’IA en 11 points et sur un code de conduite volontaire pour les développeurs d’IA. Ce décret est similaire à l’ensemble de principes « volontaires » que l’administration Biden a publié au début de l’année, qualifié à l’époque de trop vague et généralement décevant. « Alors que nous faisons avancer ce programme au niveau national, l’administration travaillera avec ses alliés et ses partenaires à l’étranger sur un cadre international solide pour régir le développement et l’utilisation de l’IA », indique le décret de Joe Biden. « L’administration a déjà mené de vastes consultations sur les cadres de gouvernance de l’IA ces derniers mois, avec l’Allemagne, l’Australie, le Brésil, le Canada, le Chili, la Corée du Sud, les Émirats arabes unis, la France, l’Inde, Israël, l’Italie, le Japon, le Kenya, le Mexique, la Nouvelle-Zélande, le Nigéria, les Pays-Bas, les Philippines, Singapour et le Royaume-Uni ». L’ordonnance du président des États-Unis vise également les entreprises qui développent des grands modèles de langage (LLM) susceptibles de présenter un risque grave pour la sécurité nationale, la sécurité économique ou la santé publique. Elles seront tenues d’informer le gouvernement fédéral lorsqu’elles formeront le modèle et devront partager les résultats de tous les tests de sécurité.

Avivah Litan, vice-présidente et analyste distinguée chez Gartner Research, a déclaré que si les nouvelles règles commencent bien, avec la clarté et les tests de sécurité visant les plus grands développeurs d’IA, les mandats restent insuffisants. Selon elle, ce fait reflète les limites de l’application des règles par un ordre exécutif et la nécessité pour le Congrès de mettre en place des lois. Elle estime que les nouveaux mandats ne sont pas à la hauteur dans plusieurs domaines : « Qui définit les systèmes d’IA « les plus puissants » ? Comment cela s’applique-t-il aux modèles d’IA open source ? Comment les normes d’authentification des contenus seront-elles appliquées sur les plateformes de médias sociaux et autres lieux de consommation populaires ? De manière générale, quels sont les secteurs/entreprises concernés lorsqu’il s’agit de se conformer à ces mandats et lignes directrices ? », a-t-elle demandé. « Par ailleurs, je ne vois pas très bien à quoi ressembleront les mécanismes d’application, même s’ils existent. Quelle agence contrôlera et mettra en œuvre ces actions ? Quelles seront les sanctions en cas de non-respect des règles ? » a aussi déclaré Avivah Litan. Adnan Masood a abondé dans ce sens, estimant que même si la Maison-Blanche avait fait un « grand pas en avant », le décret ne faisait qu’effleurer la surface d’un énorme défi. « Le contenu de ce décret nous pousse à avoir plus de questions que de réponses : qu’est-ce qui constitue une menace pour la sécurité ? Qui assume la responsabilité de cette prise de décision ? Comment tester exactement les menaces potentielles ? Plus important encore, comment neutraliser les capacités dangereuses dès leur apparition ? », ajoute Adnan Masood. L’utilisation de l’IA dans le domaine de la bio-ingénierie est l’une des préoccupations majeures que l’ordonnance tente d’aborder. Le mandat crée des normes visant à garantir que l’IA n’est pas utilisée pour créer des organismes biologiques nuisibles, comme des virus mortels ou des médicaments qui finissent par tuer des gens, qui peuvent nuire aux populations humaines. « Le décret n’appliquera cette disposition qu’en utilisant les normes émergentes comme base de référence pour le financement fédéral des projets relatifs aux sciences de la vie », a déclaré Avivah Litan. « Il doit aller plus loin et appliquer ces normes aux capitaux privés ou à tout organisme ou source de financement non fédéral (comme le capital-risque). L’ordonnance doit également aller plus loin et expliquer qui et comment ces normes seront appliquées et quelles seront les sanctions en cas de non-conformité ».

L’IA, une opportunité pour les pays du monde entier

Pour sa part, Ritu Jyoti, vice-présidente du cabinet de recherche IDC, se dit frappée par la reconnaissance claire par Joe Biden « de l’obligation d’exploiter le pouvoir de l’IA pour le bien, tout en protégeant les gens des risques potentiellement profonds qu’elle présente ». Au début de l’année, le Parlement européen a approuvé le projet de loi sur l’IA, AI Act. La loi proposée exige que les systèmes d’IA générative comme ChatGPT se conforment à des exigences de transparence en révélant si le contenu a été généré par l’IA et en distinguant les fausses images des images réelles. Si les États-Unis ont suivi l’Europe dans l’élaboration de règles régissant l’IA, Ritu Jyoti estime que le gouvernement américain n’est pas nécessairement en retard sur ses alliés et que l’Europe a mieux réussi à mettre en place des garde-fous. « C’est une opportunité pour les pays du monde entier de travailler ensemble sur la gouvernance de l’IA pour le bien social », a-t-elle déclaré. Avivah Litan n’est pas d’accord, affirmant que la loi sur l’IA de l’UE est en avance sur le décret présidentiel parce que les règles européennes clarifient la portée des entreprises auxquelles elle s’applique, « ce qu’elle peut faire en tant que règlement – c’est-à-dire qu’elle s’applique à tous les systèmes d’IA mis sur le marché, mis en service ou utilisés dans l’UE », a-t-elle déclaré.

Caitlin Fennessy, vice-présidente et responsable de la gestion des connaissances de l’Association internationale des professionnels de la vie privée (International Association of Privacy Professionals, IAPP), un groupe de défense à but non lucratif, a déclaré que les mandats de la Maison-Blanche feront que les attentes du marché se positionneront en faveur d’une IA responsable grâce aux exigences de test et de transparence. Caitlin Fennessy a également salué les efforts du gouvernement américain en matière de watermarking numérique pour les contenus générés par l’IA et de normes de sécurité de l’IA pour les marchés publics, parmi de nombreuses autres mesures. « Le président a notamment assorti son décret d’un appel au Congrès pour qu’il adopte une législation bipartisane sur la protection de la vie privée, soulignant ainsi le lien essentiel entre la protection de la vie privée et la gouvernance de l’IA », indique Caitlin Fennessy. « Le fait de s’appuyer sur la loi sur la Production de défense pour réglementer l’IA montre clairement l’importance des risques envisagés pour la sécurité nationale et l’urgence pour l’administration d’agir. Selon la Maison-Blanche, le décret contribuera à promouvoir un « écosystème de l’IA équitable, ouvert et compétitif », en veillant à ce que les petits développeurs et entrepreneurs aient accès à l’assistance technique et aux ressources, en aidant les petites entreprises à commercialiser les percées de l’IA et en encourageant la Federal Trade Commission (FTC) à exercer ses pouvoirs.

Le gouvernement veut attirer les profils spécialistes en IA

La question de l’immigration et des visas de travail a également été abordée par la Maison-Blanche, qui a déclaré qu’elle utiliserait les autorités existantes en matière d’immigration pour accroître la capacité des immigrants hautement qualifiés et des non-immigrants ayant une expertise dans des domaines critiques à étudier, séjourner et travailler aux États-Unis, « en modernisant et en rationalisant les critères, les entretiens et les examens relatifs aux visas ». Selon Caitlin Fennessy, le gouvernement américain montre l’exemple en recrutant rapidement des professionnels pour construire et gouverner l’IA et en offrant une formation à l’IA dans toutes les agences gouvernementales. « L’accent mis sur les professionnels de la gouvernance de l’IA et sur la formation garantira que les mesures de sécurité de l’IA sont élaborées avec une compréhension approfondie de la technologie et du contexte d’utilisation nécessaires pour permettre à l’innovation de se poursuivre au rythme voulu, d’une manière qui nous inspire confiance », a-t-elle déclaré.

Jaysen Gillespie, responsable de l’analyse et de la science des données chez RTB House, une entreprise polonaise spécialisée dans la publicité basée sur l’IA, a déclaré que Joe Biden partait d’une position favorable, car même la plupart des chefs d’entreprise spécialisés dans l’IA s’accordent à dire qu’une certaine réglementation est nécessaire. Selon Jaysen Gillespie, il devrait également bénéficier des échanges passés et présents entre le chef de la majorité au Sénat, Chuck Schumer et des chefs d’entreprise de premier plan. « La réglementation de l’IA semble aussi être l’un des rares sujets où une approche bipartisane serait réellement possible », a déclaré Jaysen Gillespie, dont l’entreprise utilise l’IA dans la publicité ciblée, y compris le reciblage et les stratégies d’enchères en temps réel. « Étant donné le contexte dans lequel s’inscrit son éventuel décret, le président a une réelle opportunité d’établir un leadership, à la fois personnel et pour les États-Unis, sur ce qui pourrait être le sujet le plus important de ce siècle ».

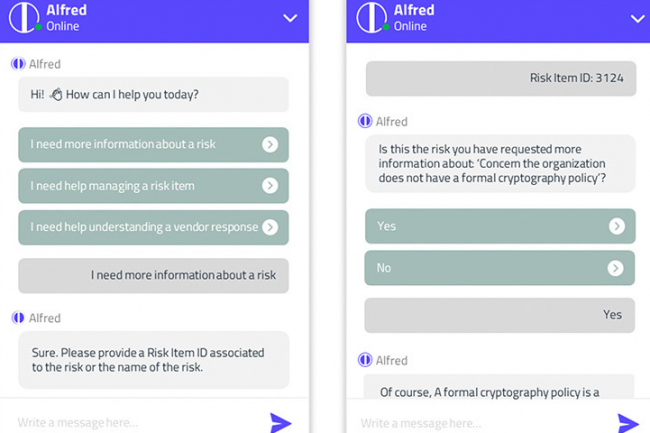

Dénommé Alfred, le chatbot de Prevalent basé sur l’intelligence artificielle générative est utilisé dans l’évaluation de la gestion des risques. Un outil de plus à rejoindre la déferlante de solutions IA qui inondent le marché de la sécurité.

Poussé par le fournisseur de produits en gestion des risques liés aux tiers (Third Party Risk Management, TPRM) Prevalent, le chatbot Alfred alimenté par un grand modèle de langage (LLM) doit aider les utilisateurs à effectuer des tâches de gestion des risques liés aux tiers. Il répond à des questions courantes d’évaluation et de gestion des risques pour lesquelles les utilisateurs peuvent avoir une expertise humaine limitée en interne, et peut aussi réduire le temps de prise de décision, tout comme améliorer la précision des choix. En coulisses, l’outil est basé sur la technologie d’IA générative d’OpenAI, soutenue par Microsoft, qui utilise des données généralisées sur les événements et les observations en matière de risque pour générer des informations précises sur le profil de risque d’un client donné. Prevalent précise que toutes les données sont anonymisées et que les conseils fournis par Alfred s’appuient sur des normes industrielles telles que NIST, ISO et SOC2. « L’IA est intégrée de manière transparente à la solution TPRM existante », a aussi ajouté Prevalent.

Dans un communiqué, l’entreprise a déclaré que les résultats de l’IA sont continuellement vérifiés et examinés pour s’assurer de leur exactitude, et que les données utilisées pour l’entraîner ont été « validées par plus de 20 ans d’expérience dans l’industrie », sans préciser toutefois leur nature et leur volume. Brad Hibbert, directeur des opérations et responsable des recherches scientifiques de Prevalent, a déclaré que, en dépit d’une prudence naturelle, la clientèle de l’entreprise avait exprimé sa curiosité quant à l’utilisation de l’IA dans l’évaluation des risques. Prevalent a donc adopté ce que Brad Hibbert appelle une « approche axée sur les cas d’usage ». « Il est important de noter que, depuis un certain temps déjà, les capacités liées à l’IA font partie des fonctionnalités de la plateforme Prevalent, comme l’analyse ML et l’analyse de documents NLP, mais il s’agit de la première fonctionnalité d’IA conversationnelle/générative », a fait savoir Brad Hibbert.

L’examen amélioré des artefacts de sécurité pour bientôt

Même si la prise de décision d’Alfred ne dépend pas, pour l’instant, des informations fournies par le client, Brad Hibbert a précisé que l’interface utilisateur et le workload avaient été développés en tenant compte, en partie, des commentaires des utilisateurs. Il a également fait remarquer que l’entreprise prévoyait d’ajouter d’autres fonctionnalités d’IA générative à sa plateforme, y compris un examen amélioré des artefacts de sécurité et un ensemble d’évaluation automatisée (essentiellement en remplissant des formulaires de sécurité complexes), mais que celles-ci n’étaient pas encore disponibles. « Le développement reste focalisé sur la résolution des problèmes réels des clients », a déclaré Brad Hibbert. « Alfred résout le problème du manque de contexte ou de ressources qualifiées pour comprendre la signification d’un risque et ce qu’il faut faire à ce sujet ». Alfred est disponible dès à présent pour tous les clients de la plateforme Prevalent, sans frais supplémentaires.

Le logiciel vient s’ajouter à la série d’outils basés sur l’IA que l’on retrouve désormais dans les produits de sécurité d’un grand nombre de fournisseurs. Cette semaine, AuditBoard a ajouté des capacités d’IA et d’analyse de risque et de conformité, et la semaine dernière, Vanta a annoncé l’intégration d’IA générative dans son principal produit de sécurité et de conformité. Certains des plus grands fournisseurs de technologie intègrent également de l’IA générative dans leurs offres de sécurité. C’est le cas par exemple de Microsoft, qui a annoncé en mars Copilot Security, un assistant d’IA pour la cybersécurité basé sur GPT-4.

L’adoption du modèle de cybersécurité zero trust poursuit sa progression au niveau mondial. Selon un récent rapport d’Okta, 61 % des entreprises ont déjà mis en oeuvre une initiative de ce type.

Au cours des trois dernières années, la part des entreprises dans le monde ayant mis en œuvre une initiative zero trust est passée de 24 % en 2021 à 61% en 2023, selon les données du rapport State of Zero Trust 2023 d’Okta. Parmi elles, ce sont surtout les entreprises de 5 000 à 9 999 employés – soit trois sur quatre – qui ont opté pour cette stratégie de cybersécurité, par rapport à celles comptant entre 500 et 999 employés. Le rapport est basé sur les réponses de 860 responsables de la sécurité de l’information d’Amérique du Nord (États-Unis, Canada), de la région EMEA (Danemark, Finlande, France, Allemagne, Irlande, Pays-Bas, Norvège, Suède, Royaume-Uni) et de la région APJ (Japon, Australie). Par ailleurs, dans les 18 prochains mois, 35 % des personnes interrogées prévoient de mettre en œuvre une initiative zero trust, contre 4 % qui n’en prévoient pas et n’en ont pas mis en place.

En termes d’initiatives déjà en place, la région Amérique du Nord est en tête, mais les entreprises des régions EMEA (Europe Moyen-Orient et Afrique) et APJ (Asie-Pacifique et Japon) gagnent rapidement du terrain, et presque tous les retardataires de ces deux régions prévoient d’adopter une initiative zero trust dans les 6 à 12 ou 13 à 18 mois à venir. Malgré les pressions macroéconomiques qui obligent à réduire les coûts, 80 % des personnes interrogées ont déclaré que leurs budgets pour les initiatives zero trust avaient augmenté par rapport à l’année précédente. 60 % font état d’augmentations de budget de 1 % à 24 %, et 20 % ont augmenté ces budgets de 25 % ou plus. À noter aussi que l’identité est devenue un élément important de ce type de stratégies. Ainsi, 51 % des personnes interrogées déclarent qu’elle est extrêmement importante, ce qui représente une augmentation considérable par rapport aux 27 % de 2022, et 40 % des personnes interrogées ont déclaré qu’elle était assez importante.

L’IAM, de plus en plus dévolue aux équipes de sécurité

La gestion des identités et des accès (Identity and Access Management ou IAM), autrefois pré carré des départements IT, est de plus en plus confiée aux équipes de cybersécurité. C’est ce que confirme l’étude d’Okta, selon laquelle 73 % des équipes de sécurité sont désormais responsables de l’IAM en Amérique du Nord et 50 % dans la région EMEA. Dans la région Asie-Pacifique, le changement est plus lent : si 41% des entreprises demandent toujours aux équipes de sécurité de gérer l’IAM, 56% d’entre elles confient à ces équipes soit la supervision de l’identité, soit la gestion de la technologie, mais pas les deux. D’autres indicateurs témoignent de l’importance croissante des initiatives en matière d’identité, puisque 34 % des personnes interrogées utilisent l’authentification multi-facteurs (MFA) pour les utilisateurs externes et 33 % pour le personnel interne. Parmi les quatre secteurs sondés par le rapport, les organismes de santé donnent la priorité au MFA pour les utilisateurs externes et internes et à la connexion des annuaires aux applications cloud. Le secteur public privilégie ce type d’authentification pour les utilisateurs externes, et l’accès sécurisé aux API et cette méthode d’authentification pour les employés. Dans les services financiers, c’est elle a la préférence pour les employés, mais pour les utilisateurs externes on retrouve à la fois le MFA et la gestion des accès à privilèges pour l’infrastructure cloud. Enfin, dans le secteur des logiciels, l’authentification multifactorielle est privilégiée pour les employés, et l’accès sécurisé aux API et le MFA pour les utilisateurs externes.

Les priorités de sécurité à venir

Au cours des 12 à 18 prochains mois, les décideurs donneront la priorité à la gestion des accès à privilèges pour l’infrastructure cloud (42%), à la sécurisation de l’accès aux API (42%) et à la mise en œuvre du MFA pour les employés (42%). De plus, en matière d’authentification, les entreprises devraient utiliser davantage cette méthode et l’authentification unique pour protéger les serveurs et les bases de données. Plus de la moitié des dirigeants interrogés ont déclaré que dans le cadre d’une stratégie zero trust l’identité était extrêmement importante, et 40 % ont déclaré qu’elle était assez importante. C’est un changement notable par rapport à l’année dernière, où 26 % des personnes interrogées avaient déclaré que l’identité était essentielle à la mission de l’entreprise. Les responsables IT intègrent leurs IAM à la gestion des terminaux mobiles (MDM). Selon le rapport d’Okta, le SIEM, le MDM et la protection des endpoints sont les trois systèmes les plus importants à intégrer directement et en priorité dans une solution IAM.

Au niveau mondial, « malgré leur faible degré d’assurance », l’usage des mots de passe perdure obstinément pour l’authentification, « et ils restent la norme dans plus de la moitié des entreprises interrogées ». L’authentification à l’aide de questions de sécurité en guise d’identifiant, guère plus efficaces, est la deuxième modalité la plus répandue au niveau mondial et dans les régions EMEA et APJ, et elle occupe désormais la première place en Amérique du Nord. Le rapport a également mis en évidence l’utilisation d’autres services à faible degré d’assurance, notamment les mots de passe à usage unique (One Time Password, OTP) matériels et par SMS, par voix et par courrier électronique. Les facteurs comme les OTP à jeton physique et les authentificateurs push, considérés par le rapport comme ayant un degré d’assurance moyen, sont utilisés par moins d’entreprises (36 % et 29 %, respectivement), et seulement 19 % d’entre elles utilisent des facteurs ayant un niveau d’assurance élevé, comme les authentificateurs basés sur des plates-formes et la biométrie. « Nous pensons que l’usage de l’authentification multi-facteurs va continuer à se diffuser jusqu’à devenir dominante, mais de nouvelles réglementations vont probablement obliger certains secteurs comme les services financiers et le secteur public à adopter des facteurs d’authentification sans mot de passe et d’autres solutions capables de résister au phishing », peut-on encore lire dans le rapport.

L’essor du télétravail et l’évolution organisationnelle s’est accompagnée de pression de la part des employés concernés sur les équipes informatiques de leurs entreprises. Des matériels procurant un accès à distance sécurisé, à une connectivité réseau fiable en passant par des performances applicatives optimales, les doléances s’enfilent comme les perles.

La pandémie de Covid-19 a obligé les entreprises à renvoyer leurs employés chez eux. Mais, même après la reprise, la demande de travail à distance est restée forte. En effet, cette solution, d’abord considérée comme temporaire, est devenue une réalité persistante du monde du travail si bien que les services IT des entreprises doivent revoir leur manière de fournir un support, un service et une technologie cohérents aux employés, quel que soit l’endroit où ils décident de travailler. « On a beaucoup parlé de retour au travail, mais ce n’est pas vraiment le cas », a déclaré Shamus McGillicuddy, vice-président de la recherche chez Enterprise Management Associates (EMA), lors d’un récent webinaire.

Dans une enquête réalisée par EMA aux Etats-Unis, 96 % des organisations IT ont déclaré qu’elles soutenaient les travailleurs hybrides. « En d’autres termes, 30 % de tous les employés qui travaillent à distance sont des travailleurs hybrides », a précisé Shamus McGillicuddy. « Ils viennent au bureau de temps en temps, ce qui signifie que toute organisation IT doit les prendre en charge à la maison et au bureau. Et cela peut s’avérer un peu complexe. Les équipes chargées des opérations réseau doivent revoir leur approche du travail distant et hybride si elles veulent fournir les mêmes applications et niveaux de service que les employés attendent au bureau. En l’état actuel des choses, seuls 32 % des professionnels de l’IT interrogés ont déclaré qu’ils avaient l’impression d’avoir pleinement réussi à mettre en œuvre et à prendre en charge les exigences de mise en réseau des travailleurs distants et hybrides.

Le travail à distance bien là pour durer

Dans le futur, les équipes réseau prévoient d’investir par exemple dans la commutation et le WiFi. Shamus McGillicuddy recommande aux entreprises d’investir dans une technologie d’accès à distance plus sécurisée ainsi que dans des outils d’observabilité du réseau afin de mieux suivre les performances sur des sites disparates. « Les entreprises ont besoin de solutions d’accès à distance sécurisées qui offrent une automatisation intégrée de la sécurité du réseau, une gestion centralisée et une optimisation du réseau ou une amélioration du réseau d’une manière ou d’une autre. Elles doivent envisager la surveillance des points d’extrémité et la surveillance synthétique pour améliorer leur observabilité globale des travailleurs à distance », a-t-il préconisé.

Même si la crise du Covid-19 a été à l’origine du travail à distance, les entreprises ne peuvent ignorer qu’elle a transformé les habitudes de travail d’un grand nombre de personnes. Selon Enterprise Management Associates, 94 % des organisations IT ont observé que le recours au travail à distance n’avait cessé d’augmenter après la pandémie. Avant la pandémie, seuls 17 % des employés travaillaient à domicile. Aujourd’hui, les entreprises indiquent que 43 % de leur personnel travaille à domicile, et les personnes interrogées prévoient que d’ici à 2025, près de la moitié (49 %) des employés effectueront leur travail en dehors de l’environnement professionnel. La prise en charge du travail à distance pour une poignée d’employés représente un défi bien différent de la prise en charge de près de la moitié de tous les employés travaillant à distance, souvent avec des problématiques de connectivité différentes. Trouver le bon équilibre entre la sécurité et l’expérience utilisateur, par exemple, est un défi commun. « Les responsables informatiques – DSI, directeurs techniques, RSSI – ne fournissent pas à tous les employés le même soutien ou l’aide dont ils ont besoin pour mener à bien leur tâche », a expliqué Shamus McGillicuddy. « Quelle est la priorité, la sécurité ou l’expérience utilisateur ? Il faut trouver un équilibre, mais parfois il est nécessaire de sacrifier l’expérience au profit de la sécurité. Ce genre de décisions doit être pris à un niveau plus élevé de la chaîne ».

Sécurité et manque de contrôle, un défi pour les services IT

Concernant les défis posés par l’augmentation de la main-d’œuvre à distance, la conformité et la sécurité arrivent en tête des principales préoccupations de 31 % des personnes interrogées. L’utilisation de multiples applications, à partir d’une myriade d’endroits, rend le défi de la sécurisation des données et de la fourniture d’accès encore plus critique. « Dans le cadre de ce travail à domicile de plus en plus répandu, les employés manipulent des données sensibles et accèdent à des éléments sans nécessairement bénéficier de la protection des dispositifs de sécurité du réseau », poursuit Shamus McGillicuddy. « Ils ouvrent de nouveaux points d’attaque et créent également des opportunités de perte de données ». Le défaut de leadership en matière d’IT arrive en deuxième position des réponses à l’enquête d’EMA, 27 % des personnes interrogées le citant comme un obstacle au travail à distance.

Quelque 24 % des personnes interrogées ont également indiqué que le manque de personnel qualifié constituait un obstacle, et 22 % des professionnels de l’IT ont indiqué qu’ils étaient confrontés à des contraintes budgétaires et à la collaboration entre les services IT, respectivement. Le manque de contrôle est un autre problème important pour les professionnels de l’IT chargés de soutenir le travail à distance. De nombreux « bureaux à domicile » dépendent de fournisseurs d’accès Internet pour leur connectivité, et les services IT des entreprises n’ont pas accès à ces réseaux et ne peuvent pas contrôler les performances de leurs services pour leurs employés. « Les DSI et les directeurs techniques partent peut-être du principe que l’Internet est tout simplement fiable et que les personnes travaillant à domicile ont de bonnes connexions. Mais ce n’est pas forcément le cas », a encore déclaré le vice-président de la recherche chez Enterprise Management Associates (EMA).

L’enjeu majeur de la collaboration

L’essor des applications de communication en temps réel pendant la pandémie ne faiblit pas non plus. Les employés utilisent de plus en plus des outils de collaboration, notamment des outils de vidéoconférence et de chat en temps réel, pour communiquer avec leurs collègues plutôt que le téléphone. À cet égard, 89 % des personnes interrogées dans le cadre de l’enquête EMA ont déclaré que, depuis le début de la pandémie, l’utilisation des applications vocales, vidéo et de collaboration en temps réel a beaucoup augmenté. Or l’usage de ces technologies exerce une pression supplémentaire sur les réseaux domestiques dont la connectivité peut être irrégulière. Selon Enterprise Management Associates, les professionnels de l’IT qui assistent les employés travaillant à domicile rencontrent de nombreux problèmes de performance du réseau, notamment : des problèmes avec le WiFi domestique (cité par 42%) ; un problème de distance des applications qui augmente la latence du réseau, plus important dans les grandes entreprises (42%). Parmi les autres problèmes, les professionnels de l’IT citent encore : la qualité du FAI (41%), l’utilisation de la bande passante par la famille/les colocataires/etc (35%), un routage Internet inefficace (33%), la congestion du FAI aux heures de pointe (32%), une concurrence avec les autres utilisateurs du WiFi partagé dans les logements collectifs (32%).

Pour répondre à ces défis, les équipes réseau qui fournissent des services aux travailleurs hybrides ont dû mettre à jour les capacités de commutation, WiFi, mobiles et autres réseaux pour prendre en charge cette main-d’œuvre à distance. Par exemple, 76 % des personnes interrogées font état d’une augmentation de la demande de bande passante sur site, et 90 % déclarent qu’elles doivent mettre à jour le WiFi pour répondre aux nouvelles exigences de mobilité. Selon l’enquête d’EMA, 83 % d’entre eux explorent les technologies basées sur la localisation, comme le « bureau flexible » ou « hot-desking » et les petites salles de conférence. Les organisations IT devront probablement faire de nouveaux investissements ou mettre à jour les technologies pour soutenir ces nouvelles habitudes de travail. Selon EMA, 87 % des entreprises ont déjà alloué des budgets pour ces investissements. Plus de la moitié (56 %) ont l’intention de mettre à jour les outils existants. De plus, 49 % prévoient d’acquérir des outils auprès de nouveaux fournisseurs, et 48 % déclarent qu’elles vont acquérir de nouveaux outils auprès de leurs fournisseurs actuels.

Les bénéfices d’IBM au troisième trimestre ont été dopés par l’intérêt des entreprises pour l’IA générative, ce qui a entraîné une hausse de ses revenus en matière de logiciels et de conseil.

« Dans l’ensemble, nous pensons que les vents favorables l’emportent sur les vents contraires et que les dépenses technologiques continueront à dépasser le PIB. Au cours du trimestre écoulé, nous avons enregistré une bonne croissance du chiffre d’affaires dans les domaines des logiciels et du conseil », a déclaré Arvind Krishna, CEO d’IBM, lors d’une conférence téléphonique sur les résultats. « Les clients adoptent de plus en plus notre plateforme d’IA et de données Watsonx ainsi que nos solutions de cloud hybride pour débloquer la productivité et l’efficacité opérationnelle. Cela contribue à stimuler une croissance solide dans nos activités de logiciels et de conseil. Par conséquent, nous restons confiants dans nos prévisions de croissance du chiffre d’affaires et du flux de trésorerie disponible pour l’ensemble de l’année », a ajouté Arvind Krishna.

Le chiffre d’affaires total d’IBM pour ce troisième trimestre a augmenté de 4,6 % en glissement annuel pour atteindre 14,8 milliards de dollars. Les revenus provenant des données et de l’IA ont augmenté de 6 % en glissement annuel. Au cours du trimestre qui s’est achevé en septembre, IBM a fait plusieurs gros paris sur l’IA générative après avoir constaté la demande de ses clients, a fait savoir Arvind Krishna lors du point financier. « Le travail que nous effectuons fait apparaître des modèles clairs en termes de cas d’utilisation de l’IA en entreprise. Sur la base des nombreux retours d’expérience et des essais réalisés à ce jour, trois d’entre eux sont arrivés en tête : la modernisation du code, le service à la clientèle et le travail numérique. Tous ces domaines sont pertinents et apportent des avantages commerciaux tangibles », indique le CEO, ajoutant que l’entreprise a lancé des produits pour répondre à ces cas d’utilisation au cours des trois derniers mois.

De gros paris sur l’IA générative

Ces produits comprennent Granite – un modèle de fondation de plusieurs milliards de paramètres sur Watsonx.ai – qui excelle à la fois dans le langage et le code, et Watsonx Code Assistant, qui comprend l’Assistant pour les systèmes Z. L’entreprise prévoit également de lancer Watsonx.governance avant la fin de l’année. Ce produit est conçu pour fournir les outils de gouvernance dont les entreprises ont besoin pour atténuer les risques et garantir la conformité tout au long du cycle de vie de l’IA. La gouvernance de l’IA générative, selon Arvind Krishna, est une question clé pour les entreprises qui s’inquiètent des ramifications juridiques et de la sécurité des données de l’utilisation de cette technologie pour générer des résultats. Toutefois, le CEO indique que l’entreprise fournira une couverture d’indemnisation pour soutenir tous ses grands modèles de langage. Cela signifie que Big Blue garantira les données qu’elle a utilisées pour former ces modèles. D’autres grands fournisseurs de technologie, dont Microsoft et Adobe, ont également commencé à fournir des garanties similaires pour leurs grands modèles linguistiques.

IBM a déclaré avoir plus de 20 000 consultants en données et en IA et un centre d’excellence pour l’IA générative, visant à aider les entreprises à naviguer dans le paysage de l’IA – de l’élaboration d’une stratégie à la compréhension de la façon dont l’IA peut être utilisée, en passant par le déploiement de l’IA de manière responsable. « Ces consultants fournissent également un retour d’information précieux en temps réel aux autres équipes de produits », affirme Arvind Krishna, ajoutant que l’intérêt pour l’IA générative devrait également alimenter la croissance de ses activités de conseil.

Le cloud hybride, Red Hat et Apptio stimulent la croissance des logiciels

Le cloud hybride, l’automatisation et l’IA ont été les principaux contributeurs à la croissance du chiffre d’affaires des services logiciels pour le trimestre rapporté. « Les clients s’engagent dans notre approche de cloud hybride, avec des réservations annuelles en hausse de 14 % au cours du trimestre. Cela inclut une croissance à deux chiffres pour RHEL, OpenShift et Ansible, partiellement compensée par des vents contraires dans les services basés sur la consommation », a déclaré Jim Kavanaugh, directeur financier d’IBM, lors de l’appel.

La croissance d’AIops et de la gestion, selon Jim Kavanaugh, a été menée par de « bonnes performances » dans Instana, Turbonomic et maintenant Apptio (acquisition réalisée en juin dernier), alors que les entreprises cherchent à optimiser les résultats commerciaux et à stimuler la productivité. Les activités liées aux données et à l’IA ont été soutenues par la croissance dans des domaines tels que la fabrication de données et les exigences en matière de service à la clientèle, a déclaré la société, ajoutant que les entreprises se préparaient à déployer des solutions d’IA générative. Cependant, le chiffre d’affaires des logiciels de sécurité a diminué de 3 % en glissement annuel, car les activités de services de sécurité gérés ont ralenti.