Même si les leviers de la transformation digitale évoluent, certaines choses restent inchangées dont les habitudes qui nuisent aux résultats et dont les DSI sont trop souvent victimes. Zoom sur les écueils à éviter.

Alors que les DSI se préparent à la prochaine vague de transformation numérique, ils doivent démontrer les impacts commerciaux à court terme des investissements technologiques et atteindre des objectifs d’innovation plus vastes qui font évoluer le modèle de l’entreprise. Mais peut-être plus important encore, ils doivent tirer les leçons de leurs précédents grands succès numériques – et éviter de répéter les erreurs trop fréquentes qui font que les transformations échouent ou sont à la traîne par rapport aux attentes. Les moteurs de la première vague de transformation numérique jusqu’en 2020 étaient la croissance, les capacités en matière de données, la migration vers le cloud et la mise à disposition de capacités technologiques compétitives. Au cours des dernières années, les DSI se sont concentrés sur la mise en œuvre du travail hybride, l’amélioration de l’efficacité grâce à l’automatisation, la modernisation des applications, la mise en œuvre des prédictions d’apprentissage automatique et la maturation de l’entreprise axée sur les données. L’IA générative étant désormais une priorité absolue de la transformation numérique, 2024 marquera le début d’une ère de transformation axée sur l’IA.

Même si les moteurs de chaque ère numérique évoluent, les DSI peuvent encore faire dérailler la transformation en personnalisant les solutions ou en donnant la priorité à un trop grand nombre d’indicateurs de performance clés. En revanche, ils peuvent l’accélérer en donnant la priorité à des initiatives qui multiplient les forces, comme l’alignement des programmes en datat science et de gouvernance des données ou l’amélioration des opérations informatiques avec des capacités AIops. Pourtant, certains problèmes refont surface à maintes reprises pour perturber les résultats de l’entreprise, quels que soient les objectifs stratégiques. Sur la base de conversations avec des experts du secteur, voici sept manières de rater sa transformation numérique dont les DSI doivent se méfier.

1. Se concentrer sur la technologie et non sur les résultats

Selon une récente enquête de Gartner, le résultat le plus critique de la transformation numérique est d’exceller dans la fameuse « expérience client » ou « expérience employé ». Malheureusement, l’enquête révèle également que seuls 12 % des DSI sont des « franchiseurs » qui « codirigent, livrent et gouvernent les initiatives numériques avec leurs homologues CxO [chief experience officer, ndlr] ». Il est difficile d’obtenir des résultats à partir d’un investissement technologique sans que les dirigeants d’entreprise ne soient des partenaires. Les données de Gartner suggèrent que, sans le partenariat de la direction, 88 % des DSI sont prêts à échouer. « Peu d’entreprises réalisent le rôle que jouent la structure organisationnelle et la culture dans la conduite de la transformation, et se concentrent plutôt sur la technologie », déclare Sunil Senan, SVP et responsable mondial des données, de l’analyse et de l’IA chez Infosys.

En se concentrant sur la technologie, les DSI peuvent obtenir des résultats transitoires, tels que l’amélioration de l’agilité de l’infrastructure en migrant vers le cloud ou l’amélioration de l’expérience des utilisateurs en mettant à niveau les systèmes existants vers le SaaS. Mais les initiatives de transformation exigent des dirigeants d’entreprise qu’ils repensent les priorités des clients, les opérations et les domaines dans lesquels la technologie peut changer la donne en matière de concurrence. « Pour atteindre les objectifs de la transformation numérique, les entreprises doivent construire une ambidextérité structurelle, se concentrer sur les opportunités d’efficacité à court terme qui correspondent à la structure et au modèle actuels, mais aussi poursuivre des opportunités d’expansion discontinue à moyen et long terme dans les activités qui nécessiteraient potentiellement des changements structurels et culturels », conseille Sunil Senan.

2. Donner la priorité à tout en ignorant les tendances du marché et les besoins des clients

Le deuxième péché mortel est d’utiliser la transformation numérique comme un appel à la mise à niveau de tous les systèmes existants et à l’élimination de toute la dette technique accumulée. Les DSI ne peuvent pas tout prioriser et doivent regarder au-delà des risques technologiques, des coûts, des lacunes de sécurité et des inefficacités pour cibler les investissements qui apporteront le plus de valeur au client et s’aligneront sur les tendances concurrentielles. « L’une des plus grandes erreurs des entreprises est de s’attaquer à trop de choses à la fois, et la transformation numérique est ancrée dans une gestion du changement organisationnel bien conçue », déclare Josh Miramant, CEO de BlueOrange. « On a souvent l’ambition de s’attaquer à tous les problèmes ou à la plupart d’entre eux, mais cela peut laisser de côté l’utilisateur du système. Une solution parfaitement construite n’a aucune valeur si elle n’est pas conçue en fonction des utilisateurs ».

Srikumar Ramanathan, directeur des solutions chez Mphasis, partage un péché similaire : lorsque l’informatique place la barre trop haut en termes de portée, ce qui prend trop de temps à réaliser et ne permet pas d’apporter des améliorations incrémentales aux clients. « Les transformations numériques les plus réussies se concentrent sur la création d’un impact pour les parties prenantes telles que les clients et les employés dans un cycle court de trois à six mois », déclare-t-il. Les transformations qui mettent l’accent sur la construction plutôt que sur l’achat peuvent également être en cause. « L’innovation coûte cher, et les DSI doivent gérer les aspects culturels de la transformation numérique en décourageant les projets de construction non différenciés qui n’apportent pas de valeur ajoutée à l’entreprise, tout en récompensant fortement l’innovation sélective et stratégique », déclare Sean Knapp, fondateur et CEO d’Ascend. Les DSI doivent commencer par les besoins des clients, les mettre en correspondance avec les limites technologiques actuelles, rechercher des approches de mise en œuvre simples, fournir des capacités par itérations courtes et recueillir les commentaires des clients afin d’ajuster les priorités.

3. Négliger la gestion du changement dès le départ

Laisser la communication au second plan et aborder la gestion du changement juste avant que les nouvelles capacités ne soient prêtes à être déployées est une autre recette pour l’échec de la transformation. « Lors d’une transformation numérique, les dirigeants oublient souvent de prendre en compte la nécessité d’une communication claire avec leurs employés », déclare John Veltri, directeur général de SADA. « Lorsqu’il s’agit d’innovation d’entreprise, la plupart des employés sont enthousiastes, mais il est important de reconnaître qu’un petit pourcentage peut s’inquiéter de la façon dont ils communiqueront et collaboreront avec leurs pairs, de la façon dont ils accompliront leurs tâches quotidiennes, et dans certains cas, ils s’inquiètent même de leur niveau de sécurité de l’emploi ».

L’informatique adore trouver des solutions et les mettre en œuvre, surtout lorsque certaines limitations techniques sous-jacentes sont enracinées dans les systèmes existants et la dette technique. En outre, les parties prenantes de l’entreprise exigent souvent des résultats rapides. Les équipes se sentent donc souvent obligées de se plonger dans la mise en œuvre, de rater des étapes de communication essentielles et de ne pas mettre en place un programme de gestion du changement au début d’une initiative de transformation numérique. Une étape facile pour faire partir les équipes du bon pied est de documenter et de communiquer une déclaration de vision avec les parties prenantes et les utilisateurs finaux sélectionnés avant de commencer.

4. Attendre des responsables IT qu’ils sachent comment mener des initiatives de transformation

Dans son ouvrage, Digital Trailblazer, Isaac Sacolick conseille aux DSI de former et d’encadrer les dirigeants pour qu’ils pilotent les initiatives de transformation. Ces dirigeants sont souvent issus du monde de l’informatique, comme la gestion de produits, la gestion de programmes, le développement d’applications, la science des données et les opérations informatiques. Ils auront réussi à gérer des initiatives technologiques, mais n’auront peut-être pas la confiance ou l’expérience nécessaire pour diriger des initiatives de transformation et obtenir des résultats. Lorsque les DSI ne prennent pas en compte le mentorat, la formation et le soutien nécessaires pour développer la confiance de ces leaders afin qu’ils puissent relever les nombreux défis auxquels ils seront confrontés au cours des initiatives de transformation, ils ne rendent pas service à leurs adjoints. Comment apprendront-ils à connaître les besoins des clients, à gérer des priorités contradictoires, à aligner des équipes auto-organisées sur une vision, à superviser la gestion du changement ou à gérer les détracteurs ?

La constitution d’une équipe dirigeante de pionniers du numérique est un plus grand défi aujourd’hui que lors des vagues précédentes de transformation numérique, en raison du travail hybride, de la pénurie de talents et du large éventail de cadres et de meilleures pratiques de plus en plus impliquées dans de telles initiatives. Les DSI qui n’imposent pas de méthodes de travail ou de modèles de gouvernance standard risquent de voir leurs équipes débattre des cadres agiles à adopter, des outils devops à privilégier ou de la manière de mettre en œuvre le design thinking dans leurs feuilles de route. Les enjeux sont trop importants pour que les DSI limitent les programmes d’apprentissage au développement des compétences et laissent le développement du leadership au Chief Human Resources Officer (CHRO). Une approche pour les directeurs informatiques consiste à s’associer à ces métiers pour investir dans des programmes de leadership transformationnel et développer une vision de l’avenir du travail au sein de l’entreprise.

5. Supposer que les équipes auto-organisées répondront aux exigences de sécurité et de conformité

Les enjeux en matière de réglementation et de sécurité sont aussi importants aujourd’hui qu’ils ne l’ont jamais été, et les entreprises introduisent également des objectifs de durabilité, des objectifs de diversité et d’autres exigences ESG que les responsables de l’innovation doivent prendre en compte dans les initiatives de transformation numérique. Supposer que toutes les personnes impliquées dans la conduite de l’innovation connaissent bien toutes les contraintes réglementaires et de sécurité est un péché aux ramifications considérables. S’attendre à ce que les développeurs des équipes agiles auto-organisées, les scientifiques des données et les spécialistes de l’expérience utilisateur possèdent toutes les connaissances et les meilleures pratiques requises peut entraîner des risques matériels et des revers de mise en œuvre.

Les DSI doivent s’assurer que les experts en sécurité et en conformité sont branchés et collaborent efficacement avec toutes les équipes impliquées dans les initiatives de transformation numérique. « Une collaboration connectée et efficace au sein de l’entreprise est essentielle pour comprendre le rôle du changement technologique, les cas d’utilisation et les bonnes approches à adopter », déclare Andres Velasquez, consultant en technologie chez EY. « Idéalement, l’organisation s’attachera à institutionnaliser des méthodes de travail qui rationalisent la manière dont les équipes fonctionnelles, technologiques, de données et de gestion du changement expérimentent les nouvelles technologies et en tirent des enseignements ».

6. Investir dans l’IA sans stratégie ni gouvernance des données

L’IA générative semble être une priorité fondamentale pour les DSI au cours des prochaines années, mais comme le dit Brett Hansen, directeur de la croissance chez Semarchy, « comme toute nouvelle technologie, une approche réfléchie et pragmatique doit être appliquée ». Heureusement, les DSI ont une grande expérience en la matière, comme l’explique Joerg Tewes, CEO d’Exasol : « Les entreprises ont toujours eu besoin de transformer leurs énormes quantités de données en informations exploitables. Si l’IA va, en théorie, accélérer le processus, les particularités restent les mêmes ». Toutefois, un débat subsiste quant à la mesure dans laquelle le travail préalable des DSI en matière de fourniture de capacités axées sur les données s’appliquera à la prochaine ère de l’intelligence artificielle. « Les organisations qui pensent pouvoir tirer parti de l’intelligence artificielle comme un ajout à leurs stratégies de transformation numérique existantes sont vouées à l’échec », affirme Kjell Carlsson, responsable de la stratégie et de l’évangélisation de la science des données chez Domino. « L’IA est un ensemble de technologies fondamentalement différent qui nécessite une stratégie et des capacités distinctes ».

La gestion des données est un élément clé de cette stratégie. « Avant de se lancer dans un voyage de transformation numérique complexe, les dirigeants doivent évaluer la viabilité de leurs données et mettre en œuvre une stratégie complète de nettoyage et de gestion pour s’assurer que les données sont exactes et complètes. Sinon, l’IA basera ses résultats sur des hypothèses incomplètes ou inexactes, ce qui entraînera des ramifications potentiellement désastreuses pour l’organisation », explique Brett Hansen. Selon Joerg Tewes, des questions organisationnelles sont également en jeu et pourraient amplifier les problèmes au fur et à mesure que l’IA devient de plus en plus utilisée : « Pour minimiser la complexité et créer des synergies, le DSI et le CDO doivent rendre compte au CEO. Tous trois doivent aligner les stratégies commerciales et de gestion des données, complétées par des capacités de données et d’analyse rationalisées ». Trop souvent, les initiatives numériques ne rendent pas pleinement justice aux besoins sous-jacents de gestion des données pour réussir, et ces exigences – et la façon dont elles sont satisfaites – peuvent changer à mesure que l’IA est de plus en plus intégrée. En outre, l’absence d’alignement sur la stratégie des données, en particulier en ce qui concerne la gouvernance des données et l’attribution des responsabilités de leadership, reviendra vous hanter si vous ne faites pas les choses correctement.

7. Déclarer que la transformation numérique est un voyage sans communiquer de feuille de route

De nombreux DSI diront que « la transformation numérique est un voyage », mais communiquent-ils et mettent-ils à jour la feuille de route de ce voyage ? Les feuilles de route donnent aux employés un sens de l’orientation, une explication de l’objectif et transmettent les priorités stratégiques. Elles indiquent souvent les objectifs de l’entreprise, les investissements prévus, les possibilités de fusion et d’acquisition, et partagent une vision de l’itinéraire à suivre, ainsi que les étapes à franchir : types de technologies ciblées, technologies dont l’extinction est prévue, calendrier, intégrations prévues, fonctionnalités prioritaires et délais de livraison prévus.

« L’un des faux pas les plus courants que nous constatons dans les organisations qui entreprennent une transformation numérique est la sous-estimation de la fatigue décisionnelle que cela implique », déclare Asaf Darash, CEO de Regpack. Dans ce cas, les feuilles de route permettent de limiter les types de décisions, le moment où elles sont nécessaires et les options. Les DSI doivent toutefois se garder d’élaborer des feuilles de route dans une tour de lierre, sans aller sur le terrain pour comprendre les besoins des clients et les objectifs commerciaux des parties prenantes. Il est tout aussi important de passer du temps avec les technologues pour en savoir plus sur les architectures modernisées, les plateformes technologiques et les capacités d’IA/ML.

« Les responsables informatiques efficaces doivent s’intéresser à ce qui se fait au niveau du terrain pour mener une transformation numérique réussie », déclare Jeremy Burton, CEO d’Observe. « Si les responsables informatiques ne transpirent pas les détails et l’impact commercial de ces nouvelles technologies, telles que les microservices, la livraison continue, l’infrastructure cloud-native et l’IA, ils prendront du retard ». Que la transformation numérique soit un voyage ou une compétence organisationnelle de base, les DSI devraient effectuer une rétrospective d’apprentissage avec leurs dirigeants pour éviter de répéter les problèmes du passé.

De multiples vulnérabilités de gravité élevée affectant certaines versions de NetScaler ADC et Gateway peuvent entraîner la divulgation d’informations et permettre des attaques par déni de service. Les mises à jour doivent être effectuées au plus vite.

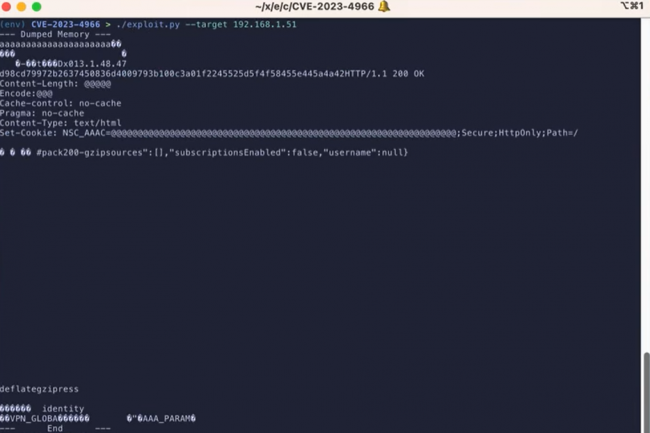

Citrix a demandé à ses clients de mettre à jour immédiatement les produits de mise en réseau NetScaler ADC et NetScaler Gateway afin d’empêcher l’exploitation active de vulnérabilités qui pourraient conduire à la divulgation d’informations et à des attaques par déni de service. NetScaler ADC (Application Delivery Controller) et NetScaler Gateway améliorent les performances, la sécurité et la disponibilité des applications et des services au sein des réseaux. Le 10 octobre dernier, l’éditeur avait déjà mis en garde contre les vulnérabilités référencées CVE-2023-4966 et CVE-2023-4967 pouvant affecter ces produits, qu’il décrivait alors comme des bogues « liés à la mémoire tampon non authentifiée ». La vulnérabilité CVE-2023-4966, de gravité élevée et de divulgation d’informations critiques, avait reçu un score CVSS de 9,4.

L’entreprise de cybersécurité AssetNote, spécialisée dans l’identification et la gestion des risques de sécurité dans les applications web et les actifs en ligne, a publié sur GitHub un PoC d’exploit de la vulnérabilité baptisée Citrix Bleed. L’entreprise propose également des tests permettant aux clients de vérifier leur exposition à la vulnérabilité. Dans un avis, Citrix a déclaré que « l’exploitation de la vulnérabilité CVE-2023-4966 avait été observée sur des appareils non atténués ». Ajoutant que le « Cloud Software Group recommandait vivement aux clients de NetScaler ADC et NetScaler Gateway d’installer les mises à jour correspondantes dès que possible ». Les exploits actifs pour la vulnérabilité CVE-2023-4967, qui peut permettre à des attaquants de lancer des attaques DoS, n’ont pas été aussi largement observés. Cette faille a été affectée du score CVSS de 8,2.

L’application immédiate des correctifs préconisé

Dans le dernier avis actualisé sur ses trous de sécurité, Citrix a recommandé de mettre à jour sans délai les dispositifs concernés. Plusieurs versions de NetScaler ADC et NetScaler Gateway affectées par les vulnérabilités, sont listées par Citrix dans le dernier bulletin de sécurité. « La version 12.1 de NetScaler ADC et NetScaler Gateway est désormais en fin de vie (End-of-Life, EOL) », a ajouté Citrix dans son avis. « Il est recommandé aux clients de mettre à jour leurs appareils vers l’une des versions prises en charge qui corrigent les vulnérabilités ». AssetNote a fourni de son côté quelques détails techniques sur la vulnérabilité CVE-2023-4966.

L’entreprise de cybersécurité a notamment effectué un patch-diffing, une analyse différentielle qui compare les versions corrigées et non corrigées d’un produit, sur les versions NetScaler 13.1-49.15 (corrigée) et 13.1-48.47 (non corrigée), afin de déterminer les fonctions vulnérables. Le processus de différenciation a consisté à examiner le binaire /NetScaler/nsppe. « Ce moteur de traitement des paquets NetScaler contient une pile réseau TCP/IP complète ainsi que plusieurs services HTTP », a expliqué AssetNote dans un billet de blog. « S’il existe une vulnérabilité dans NetScaler, c’est là que nous regardons en premier ». AssetNote a découvert deux fonctions vulnérables : ns_aaa_oauth_send_openid_config et ns_aaa_oauthrp_send_openid_config. Les correctifs pour ces fonctions, qui permettent un accès non authentifié, ont été réalisés avec la même logique. Outre la mise à jour vers les versions corrigées, le fournisseur recommande de supprimer toutes les sessions actives et persistantes au moyen d’une série de commandes, notamment : kill icaconnection -all ; kill rdp connection -all ; kill pcoipConnection -all ; kill aaa session -all ; et clear lb persistentSessions. Cependant, le fournisseur fait également remarquer que « les clients utilisant les services cloud gérés par Citrix ou l’authentification adaptative gérée par Citrix n’ont pas besoin de prendre de mesures ».

Le président Joe Biden devrait annoncer des règles imposant aux agences gouvernementales d’évaluer de manière plus approfondie les outils d’IA afin de s’assurer qu’ils sont sûrs et qu’ils n’exposent pas d’informations sensibles. En parallèle, le gouvernement devrait également assouplir les politiques d’immigration pour les travailleurs technophiles.

Après avoir critiqué les efforts déployés pour encadrer l’intelligence artificielle générative (genAI), jugés trop vagues et inefficaces, l’administration Biden devrait annoncer d’autres règles plus restrictives concernant l’utilisation de cette technologie par les fonctionnaires fédéraux, relevant donc du gouvernement. Le décret, qui devrait être dévoilé lundi, modifierait également les normes d’immigration afin de permettre un plus grand afflux de travailleurs du secteur technologique et d’accélérer ainsi les efforts de développement des États-Unis. Mardi soir, la Maison Blanche a envoyé des invitations pour un événement intitulé « Safe, Secure, and Trustworthy Artificial Intelligence », organisé lundi par le président Joseph Biden, selon The Washington Post.

L’IA générative, qui progresse à une vitesse fulgurante et suscite l’inquiétude des experts du secteur, a incité Joe Biden à publier des « orientations » en mai dernier. La vice-présidente Kamala Harris a également rencontré les CEO de Google, de Microsoft et d’OpenAI – le créateur du populaire chatbot ChatGPT – pour discuter des problèmes potentiels de l’IA générative, notamment en matière de sécurité, de protection de la vie privée et de contrôle. Avant même le lancement du ChatGPT en novembre 2022, l’administration avait dévoilé un projet de « charte des droits de l’IA » ainsi qu’un cadre de gestion des risques liés à l’IA. Elle a également proposé une feuille de route pour la création d’une ressource nationale de recherche sur l’IA.

Un décret pour renforcer les moyens en matière de cybersécurité

Le décret devrait renforcer les défenses nationales en matière de cybersécurité en exigeant que les grands modèles de langage (LLM) – le fondement de l’IA générative – fassent l’objet d’une évaluation avant de pouvoir être utilisés par les agences gouvernementales américaines. Ces agences comprennent le ministère de la défense, le ministère de l’énergie et les agences de renseignement, selon The Washington Post. Ces règles viendront renforcer l’engagement volontaire pris par 15 entreprises de développement de l’IA de faire le nécessaire pour garantir une évaluation des systèmes d’IA générative qui soit compatible avec une utilisation responsable. « Je crains que nous n’ayons pas de très bons antécédents dans ce domaine ; l’exemple de Facebook en est la preuve », a déclaré Tom Siebel, CEO du fournisseur d’applications d’IA d’entreprise C3 AI et fondateur de Siebel Systems, à un auditoire lors de la conférence EmTech du MIT en mai dernier. « J’aimerais croire que l’autorégulation fonctionnerait, mais le pouvoir corrompt, et le pouvoir absolu corrompt totalement ».

Bien que l’IA générative offre des avantages considérables grâce à sa capacité à automatiser des tâches et à créer des réponses textuelles sophistiquées, des images, des vidéos et même des codes logiciels, la technologie est également connue pour ses dérapages – une anomalie connue sous le nom d’hallucinations. « Les hallucinations se produisent parce que les LLM, dans leur forme la plus classique, n’ont pas de représentation interne du monde », explique Jonathan Siddharth, CEO de Turing, une entreprise de Palo Alto, en Californie, qui utilise l’IA pour trouver, embaucher et intégrer des ingénieurs en logiciel à distance. « Il n’y a pas de notion de fait. Ils prédisent le mot suivant sur la base de ce qu’ils ont vu jusqu’à présent – il s’agit d’une estimation statistique ».

Un risque d’exposition de données sensibles

L’IA générative peut également exposer de manière inattendue des données sensibles ou personnellement identifiables. Au niveau le plus élémentaire, les outils peuvent rassembler et analyser des quantités massives de données provenant d’Internet, d’entreprises et même de sources gouvernementales afin d’offrir un contenu plus précis et plus approfondi aux utilisateurs. L’inconvénient est que les informations recueillies par l’IA ne sont pas nécessairement stockées en toute sécurité. Les applications et les réseaux d’IA peuvent rendre ces informations sensibles vulnérables à l’exploitation des données par des tiers. Les smartphones et les voitures auto-conduites, par exemple, suivent la localisation des utilisateurs et leurs habitudes de conduite. Si ce logiciel de suivi est censé aider la technologie à mieux comprendre les habitudes pour servir plus efficacement les utilisateurs, il recueille également des informations personnelles dans le cadre d’ensembles de données volumineuses utilisés pour entraîner les modèles d’IA.

Pour les entreprises qui développent l’IA, le décret pourrait nécessiter une révision de la façon dont elles abordent leurs pratiques, selon Adnan Masood, architecte en chef de l’IA chez UST, une société de services de transformation numérique. Les nouvelles règles peuvent également entraîner une augmentation des coûts opérationnels dans un premier temps. « Toutefois, l’alignement sur les normes nationales pourrait également rationaliser les processus d’approvisionnement fédéraux pour leurs produits et favoriser la confiance des consommateurs privés », indique Adnan Masood. « En fin de compte, si la réglementation est nécessaire pour atténuer les risques de l’IA, elle doit être délicatement équilibrée avec le maintien d’un environnement propice à l’innovation ». Il poursuit : « Si nous faisons trop pencher la balance vers une surveillance restrictive, en particulier dans le domaine de la recherche, du développement et des initiatives de sources ouvertes, nous risquons d’étouffer l’innovation et de céder du terrain à des juridictions plus indulgentes à l’échelle mondiale », avant d’ajouter que « la clé réside dans l’élaboration de réglementations qui protègent les intérêts publics et nationaux tout en alimentant les moteurs de la créativité et du progrès dans le secteur de l’IA ».

Une réglementation pour lutter contre les biais intégrés

Adnan Masood a déclaré que la réglementation à venir de la Maison Blanche était « attendue depuis longtemps, et qu’il s’agit d’une bonne étape [à] un moment critique de l’approche du gouvernement américain pour exploiter et contenir la technologie de l’IA ». Il a ainsi déclaré : « J’ai des réserves quant à l’extension de la portée de la réglementation aux domaines de la recherche et du développement […] La nature de la recherche sur l’IA exige un niveau d’ouverture et d’examen collectif qui peut être étouffé par une réglementation excessive. Je m’oppose en particulier à toute contrainte susceptible d’entraver les initiatives d’IA à code source ouvert, qui ont été la force motrice de la plupart des innovations dans ce domaine. Ces plateformes collaboratives permettent d’identifier et de corriger rapidement les failles des modèles d’IA, renforçant ainsi leur fiabilité et leur sécurité ».

Cette technologie est également vulnérable aux biais intégrés, tels que les applications d’embauche assistées par l’IA qui ont tendance à choisir des hommes plutôt que des femmes, ou des candidats blancs plutôt que des minorités. Et comme les outils d’IA générative parviennent de mieux en mieux à imiter le langage naturel, les images et les vidéos, il sera bientôt impossible de discerner les faux résultats des vrais ; cela incite les entreprises à mettre en place des « garde-fous » contre les pires résultats, qu’il s’agisse d’efforts accidentels ou intentionnels de la part d’acteurs malveillants. Les efforts déployés par les États-Unis pour contrôler l’IA font suite à ceux déployés par les pays européens pour s’assurer que la technologie ne génère pas de contenu contraire aux lois de l’UE, notamment la pornographie enfantine ou, dans certains pays de l’UE, la négation de l’Holocauste. L’Italie a carrément interdit la poursuite du développement de ChatGPT pour des raisons de protection de la vie privée, après que l’application de traitement du langage naturel a été victime d’une violation de données impliquant des conversations d’utilisateurs et des informations de paiement.

L’UE, pionnière en matière de réglementation

Le règlement sur l’intelligence artificielle (AI Act) de l’Union européenne est la première du genre à être adoptée par un ensemble de pays occidentaux. La législation proposée s’appuie fortement sur les règles existantes, telles que le règlement général sur la protection des données (RGPD), la loi sur les services numériques et la loi sur les marchés numériques. La loi sur l’IA a été proposée à l’origine par la Commission européenne en avril 2021. Les États et les municipalités envisagent d’imposer leurs propres restrictions à l’utilisation de robots basés sur l’IA pour trouver, sélectionner, interviewer et embaucher des candidats à l’emploi, en raison de problèmes de confidentialité et de partialité. Certains États ont déjà adopté des lois. La Maison-Blanche devrait également s’appuyer sur l’Institut national des normes et de la technologie pour renforcer les lignes directrices de l’industrie en matière de test et d’évaluation des systèmes d’IA – des dispositions qui s’appuieraient sur les engagements volontaires en matière de sûreté, de sécurité et de confiance que l’administration Biden a obtenus de 15 grandes entreprises technologiques cette année en matière d’IA.

L’initiative de Joe Biden est d’autant plus importante que l’IA générative connaît un essor continu, qui se traduit par des capacités sans précédent en matière de création de contenu, de « deepfakes » et, potentiellement, de nouvelles formes de cybermenaces, affirme Adnan Masood. « Ce paysage montre clairement que le rôle du gouvernement n’est pas seulement celui d’un régulateur, mais aussi celui d’un facilitateur et d’un consommateur de la technologie de l’IA », ajoute-t-il. « En imposant des évaluations fédérales de l’IA et en soulignant son rôle dans la cybersécurité, le gouvernement américain reconnaît la double nature de l’IA, à la fois comme un atout stratégique et comme un risque potentiel ». Adnan Masood a déclaré être un fervent défenseur d’une approche nuancée de la réglementation de l’IA, car il est essentiel de superviser le déploiement des produits d’IA pour s’assurer qu’ils respectent les normes de sécurité et d’éthique. « Par exemple, les modèles d’IA avancés utilisés dans les soins de santé ou les véhicules autonomes doivent être soumis à des tests rigoureux et à des contrôles de conformité pour protéger le bien-être du public », conclut-il.

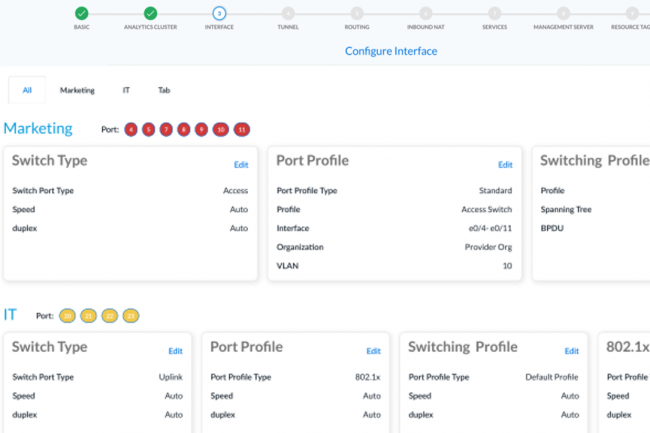

Avec Secure SD-LAN, le logiciel de Versa est déployé sur les commutateurs Ethernet et les points d’accès afin de relier les services de commutation, de routage, de sécurité et de réseau.

Le logiciel SASE (Secure Access Service Edge) de Versa Networks se muscle avec plusieurs fonctionnalités. L’éditeur a ainsi renforcé son offre notamment avec une brique ‘IA pour faciliter la gestion des ressources LAN en bordure des réseaux. La solution logicielle Versa SD-LAN annoncée par le fournisseur permettra aux clients d’intégrer des services de sécurité, de commutation, de routage, de réseau et de gestion de l’IA sur des commutateurs Ethernet et des points d’accès approuvés. « En tant qu’extension de la plateforme Unified SASE de Versa, Versa Secure SD-LAN partage la même console de gestion, le même référentiel de politiques et le même lac de données que nos produits cloud et centre de données Versa Secure SD-WAN », a expliqué Kevin Sheu, vice président du marketing produit chez Versa.

Versa Secure SD-WAN apporte plusieurs capacités réseau, y compris le pilotage des paquets et la réduction de la perte de paquets. Secure SD-WAN est un élément de la plateforme SASE de Versa, laquelle exécute le système d’exploitation Versa Operating System (VOS) et intègre les services réseau et de sécurité. La plateforme Versa SASE prend en charge les environnements cloud, sur site et hybrides. Elle inclut du VPN, du SD-WAN sécurisé, de la protection edge, un pare-feu de nouvelle génération (Next Generation Firewall, NGFW), un pare-feu en tant que service (FireWall-as-a-Service, FWaaS), une passerelle web sécurisée (Secure Web Gateway, SWG), une protection contre les fuites de données (Data Leak Prevention, DLP), l’accès au réseau zero trust (Zero Trust Network Access, ZTNA) et un courtier en sécurité d’accès au cloud (Cloud Access Security Broker, CASB).

Evaluer la posture de sécurité des utilisateurs et détecter les menaces

« Le SD-LAN résout les problèmes liés à la fragmentation des produits ponctuels qui manquent de flexibilité commerciale et imposent une configuration et une gestion disparates, boîte par boîte, onéreuses et sujettes aux erreurs. De plus, les architectures LAN traditionnelles s’appuient encore sur une sécurité périmétrique obsolète qui fait implicitement confiance aux utilisateurs et leur permet d’accéder à toutes les ressources du réseau », a déclaré Kevin Sheu. Le SD-LAN peut supprimer ces problèmes et bien d’autres encore. « Concernant le zero trust, grâce au logiciel, les clients peuvent mettre en place des politiques d’accès locales ajustables en fonction de l’identité, de la position de l’utilisateur ou du terminal, et de l’application spécifique à laquelle on accède », a encore expliqué Kevin Sheu.

La plateforme propose une connaissance des utilisateurs, des terminaux et des applications, combinée à un référentiel de politiques centralisé, de façon à donner aux entreprises une visibilité et un contrôle complets sur l’ensemble du réseau de campus ou de succursale, systèmes OT et IoT compris. « Cette approche permet à chaque commutateur et point d’accès de se transformer en point d’application zero trust qui évalue continuellement la posture de sécurité des utilisateurs, des appareils et du réseau pour identifier les menaces internes et externes et d’arrêter la propagation des attaques potentielles », a encore déclaré Kevin Sheu. « Le pack SD-LAN peut être combiné au programme Versa Secure Private Access pour fournir un ZTNA intégré pour les utilisateurs distants et sur site avec un seul référentiel de politiques intégré ».

VersaAI de la partie

« Concernant l’IA, le nouveau pack prend en charge VersaAI, qui se compose d’un ensemble partagé de moteurs d’IA/ML finement réglés, nativement intégrés dans la plateforme et incorporés dans le LAN pour identifier les comportements malveillants en temps réel », a précisé Kevin Sheu. VersaAI utilise la plateforme SASE unifiée Unified SASE Platform de Versa pour intégrer un ensemble de données provenant de toute l’infrastructure de l’entreprise – WAN Edge, cloud, campus, sites distants, utilisateurs et appareils – dans un datalake unifié. VersaAI puise dans ce lac de données pour extraire des informations AI/ML qui sont appliquées de manière transparente dans toute la suite de produits Versa, y compris désormais le LAN. Avec l’aide de l’IA, les clients peuvent identifier les menaces et les comportements anormaux et fournir des informations exploitables pour accélérer la remédiation. « En outre, les clients peuvent ajuster de manière préemptive les chemins de trafic en temps réel, automatiser le dépannage et réduire les temps d’arrêt du réseau », a fait savoir Kevin Sheu.

Le logiciel prend également en charge la fonction de microsegmentation définie par logiciel du fournisseur, supportée par tous les systèmes basés sur VOS. Grâce à cette fonctionnalité, les clients peuvent définir des politiques à l’échelle du réseau et fixer l’accès à des micro-segments spécifiques du réseau sans les limitations des VLAN. Le logiciel permet d’identifier et d’évaluer les utilisateurs et les appareils, et de les placer ensuite dans les micro-segments appropriés. « Il est également possible d’appliquer les fonctions de sécurité L4-7 en ligne en fonction de la posture de sécurité et des classes de trafic », a indiqué Versa. Secure SD-LAN fonctionne directement sur les appareils approuvés, y compris les applicances edge CSG3300 et CSG3500 de Versa. Il fonctionne aussi sur ses commutateurs Ethernet des séries CSX4000 et CSX8000, qui offrent une sécurité de débit de ligne L2, L3, VXLAN et L4-7, sans oublier un pare-feu, une identification des applications, une microsegmentation adaptative, d l’IoT fingerprinting et du ZTNA en ligne. « Plusieurs de nos partenaires avec lesquels nous travaillons développent des appliances certifiées qui prennent en charge Versa Secure SD-LAN », a indiqué Kevin Sheu.

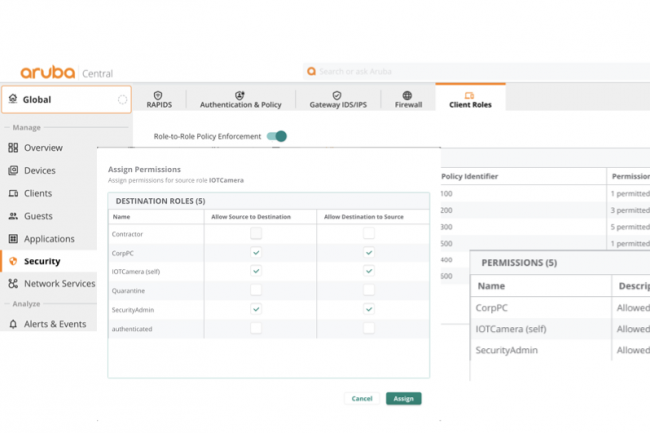

La dernière version de NetConductor d’Aruba Networks renforce la visibilité des applications et les capacités d’application des politiques de sécurité sur les réseaux distribués. En attendant l’arrivée d’un système de contrôle des politiques réseau et sécurité plus large dans les tuyaux chez cette filiale d’HPE.

Plus de contrôle et de sécurité sur les réseaux de campus et WAN. C’est ce que promet Aruba Networks avec la dernière mise à jour de sa solution NetConductor apportant une meilleure visibilité sur les applications et la possibilité de contrôler l’application des politiques de sécurité sur ce type de réseaux. La filiale d’HPE propose aux entreprises de mieux gérer de manière centralisée la sécurité des réseaux distribués, de simplifier le provisionnement des politiques et d’automatiser l’orchestration des configurations réseau dans les infrastructures câblées, sans fil et WAN. NetConductor fournit une superposition de réseaux basée sur Ethernet VPN (EVPN) et sur la virtualisation réseau VXLAN (Virtual Extensible LAN) à travers les réseaux câblés et sans fil d’un client, l’objectif étant, selon Larry Lunetta, vice président du marketing des réseaux locaux sans fil et des solutions de sécurité d’Aruba Networks, « d’apporter une vue unifiée et simplifiée du réseau et de permettre aux équipes de gestion des réseaux et de la sécurité de collaborer pour résoudre les problèmes ».

La dernière version de NetConductor étend et apporte spécifiquement la visibilité des applications et l’application des politiques à ses commutateurs d’accès et d’agrégation du réseau d’entreprise CX 6300 et aux commutateurs centraux 6400 pour centre de données. « NetConductor peut désormais, par l’intermédiaire de ces commutateurs, exprimer des politiques de contrôle d’accès basées sur le rôle, l’identité et les résultats commerciaux recherchés », explique Larry Lunetta. Ainsi, au lieu d’avoir à programmer individuellement chaque commutateur, point d’accès et passerelle, les configurations VLAN spécifiques et les listes de contrôle d’accès ACL, tout est dorénavant abstrait dans NetConductor. L’équipe chargée de la sécurité et du réseau peut décrire très simplement ces politiques de contrôle d’accès sans avoir à connaître toutes les adresses et tous les détails des appareils.

Des politiques de sécurité étendues au SD-WAN

Cette version étend également la capacité de NetConductor à diffuser les politiques de sécurité à travers l’entreprise distribuée via les solutions SD-WAN et SD-Branch Networking EdgeConnect de HPE Aruba. « Grâce à la prise en charge WAN des passerelles EVPN-VXLAN normalisées, les entreprises peuvent désormais définir une politique une fois pour toutes et l’appliquer partout, depuis l’edge jusqu’au cloud », fait savoir Larry Lunetta. « Quel que soit le lieu où le terminal à partir duquel se connecte l’utilisateur, la même politique de contrôle d’accès adaptée à l’application peut être appliquée à l’échelle mondiale […] L’ajout de capacités d’exécution au sein de l’infrastructure de commutation et de réseau étendu du campus évite le transit inutile de données par des points centraux d’application des politiques, ce qui rapproche effectivement l’application des politiques de l’utilisateur et optimise les performances du réseau ».

« Auparavant, NetConductor avait une connaissance des applications, ce qui permettait par exemple aux clients de définir des politiques de bande passante. Aujourd’hui, il prend en charge les capacités EVPN et VXLAN, si bien qu’il peut simplement lire les balises du trafic et mettre en œuvre des politiques de sécurité en plus des politiques d’exploitation sur l’ensemble du réseau », poursuit Larry Lunetta. « La nouvelle version de NetConductor peut également mieux découvrir les terminaux IoT présents dans l’entreprise, puis attribuer, propager et appliquer automatiquement des politiques pour ces appareils, tout comme ils le font pour les utilisateurs […] ar exemple, un système d’IRM nouvellement installé dans un établissement de santé se trouve souvent en dehors du champ d’action de l’IT. NetConductor le trouvera, l’identifiera et lui attribuera la politique automatiquement ».

Unifier la gestion et la sécurité logicielle et matérielle

À long terme, Aruba veut unifier tous ses logiciels et matériels et permettre aux clients de les sécuriser et de les gérer dans le cadre d’une politique unique assure par ailleurs le dirigeant. Par exemple, Aruba dispose d’un logiciel de sécurité issu de la récente acquisition du fournisseur de sécurité cloud Axis Security, ainsi que de son propre logiciel Secure Service Edge (SSE), et chacun dispose d’un gestionnaire de politiques. Lors de la conférence Black Hat du mois d’août, Aruba a présenté en avant-première un gestionnaire de politiques centralisé et global qui, selon elle, gérera et contrôlera l’ensemble de son réseau d’entreprise et de son système de sécurité. Ce système devrait s’étendre aux offres EdgeConnect SD-WAN, SD-Branch et Microbranch d’Aruba, ainsi qu’à sa plateforme Aruba SSE en cours de développement, et devrait être centré sur sa plateforme de gestion de politiques ClearPass et sa plateforme de gestion centrale, Aruba Central. « L’objectif est de parvenir à une politique universelle uniforme, que les clients peuvent exécuter et appliquer à toutes les applications et à tous les services. C’est très puissant, et c’est vers cela que nous nous dirigeons », indique Larry Lunetta.

Aux États-Unis, la Commission fédérale des communications va évaluer si elle dispose de l’autorité et des outils nécessaires pour réprimer les spams dopés à l’IA.

Alors que des entreprises comme Microsoft et Nvidia misent à fond sur la puissance des algorithmes de machine learning de dernière génération, certains régulateurs redoutent ce que cela pourrait signifier pour nos réseaux de communication déjà très sollicités. C’est le cas de la présidente de la Commission fédérale des communications des États-Unis, qui vient de proposer une enquête sur ce que l’IA pourrait signifier pour un nombre encore plus grand d’appels et de textes non sollicités. La FCC votera l’adoption d’une action à plusieurs niveaux en novembre. La présidente Rosencworcel, qui siège à la Commission depuis 2012 et en assure la direction depuis sa confirmation fin 2021, est particulièrement préoccupée par la manière dont les outils d’IA – qui se sont multipliés ces derniers mois – pourraient affecter les personnes âgées.

Le communiqué de presse initial de la FCC énumère quatre objectifs principaux : déterminer si les technologies d’IA relèvent de la compétence de la Commission via le Telephone Consumer Protection Act de 1991, si et quand les futures technologies d’IA pourraient faire de même, comment l’IA a un impact sur les cadres réglementaires existants et si la FCC devrait envisager des moyens de vérifier l’authenticité de la voix et du texte d’IA générés automatiquement à partir de « sources de confiance ». Ce dernier point semble être celui qui risque de poser le plus de problèmes. Le texte généré automatiquement et les algorithmes de voix naturelle sont déjà des outils assez faciles à utiliser, même s’ils ne sont pas aussi rapides que nécessaire pour les échanges en temps réel dans le cadre d’un appel téléphonique. Si l’on ajoute à cela des datacenters que l’on pourrait qualifier de « big iron », qu’ils soient entièrement créés dans le but de traiter des appels et des textes en masse ou simplement loués à des sociétés telles qu’Amazon et Microsoft, on obtient la recette d’un désastre.

Utiliser l’IA pour lutter contre les spams et les arnaques

Remplacer les centres d’appel à personnel humain du monde entier, dans des pays comme l’Inde et le Cambodge qui en comptent beaucoup, par des systèmes d’IA entièrement automatisés pourrait augmenter de manière exponentielle le volume et l’efficacité des escroqueries, qui sont déjà envoyées des centaines de milliards de fois chaque année. Bien qu’il existe des filtres et des blocages, on estime que des milliards de dollars sont perdus chaque année dans des escroqueries rien qu’aux États-Unis, dont beaucoup ciblent spécifiquement les personnes âgées.

Le brief de la FCC mentionne que la technologie de l’IA pourrait également être utilisée pour lutter contre les spammeurs et les escroqueries, probablement avec une sorte de système d’analyse en temps réel alertant les utilisateurs qu’ils sont en train de parler à un ordinateur. Mais les détails de cette question, ainsi que l’évolution potentielle de la menace posée par les outils d’IA, devront attendre la session de la Commission du 15 novembre.

Selon une étude de Cato Networks, un responsable informatique sur trois pense que les équipes IT et réseau devraient travailler sur la base de processus communs. Se dirige-t-on vers une fusion inéluctable des équipes réseau et sécurité ?

Dans de nombreuses entreprises, les équipes réseau et sécurité restent bien séparées, chacune avec ses technologies et outils, indicateurs, alertes et processus de gestion des incidents. Plus pour longtemps ? Selon une étude publiée par Cato Networks, les entreprises envisagent de plus en plus de consolider les deux entités, ou au moins d’améliorer la collaboration entre les équipes. Menée auprès de 1 694 responsables IT du monde entier, cette enquête montre que 44 % des personnes interrogées pensent que les équipes chargées des réseaux et de la sécurité « doivent travailler ensemble ». Surtout, 30 % d’entre elles estiment qu’elles « doivent partager leur processus ». 8 % des répondants indiquent même qu’elles s’efforcent de créer une entité unique chargée à la fois des réseaux et de la sécurité.Ce partage des processus risque bien de représenter un défi de taille pour certaines entreprises. Dans l’enquête, 12 % des personnes interrogées expliquent en effet que leurs équipes chargées des réseaux et de la sécurité se livrent à des « guerres intestines ou ont du mal à travailler ensemble », et 34 % qu’elles rencontrent « occasionnellement des problèmes de collaboration ». Les 54 % restants indiquent que les deux équipes travaillent déjà bien ensemble aujourd’hui. Sur le plan technologique, 68 % des entreprises indiquent qu’elles utilisent actuellement différentes plateformes de gestion et d’exploitation pour la sécurité et les réseaux. Plus des trois quarts (76 %) d’entre elles pensent que « l’utilisation d’une seule plateforme pour les deux objectifs améliorerait la collaboration entre les équipes » en charge de ces deux pans technologiques.

« S’assurer que la bière continue de couler », pour Carlsberg

Dans une récente étude IDC, 68 % des 830 personnes interrogées expliquent qu’elles aimeraient utiliser le même fournisseur pour leur solution réseau SD-WAN et leur solution de sécurité/SASE. Dans le même esprit, le cabinet Gartner pense que les entreprises feront converger leurs rôles en matière de réseau et de sécurité dans un avenir proche. Près d’un quart (24 %) des entreprises interrogées par Cato Networks ont déjà fusionné les responsabilités en matière de réseau et de sécurité dans une seule équipe.C’est le cas du brasseur Carlsberg, client de Cato Networks, qui a consolidé ses équipes réseau et de sécurité. « La convergence des équipes réseau et de sécurité nous permet mettre un terme aux guerres de territoire qui ont longtemps perduré dans l’IT. Nous pouvons identifier et agir sur les potentielles vulnérabilités créées par les changements introduits au niveau du réseau et identifier les problèmes opérationnels provoqués par les paramètres de sécurité beaucoup plus rapidement parce que les équipes réseau et de sécurité travaillent ensemble comme une entité unique », observe Tal Arad, RSSI et CTO de Carlsberg, dans un communiqué. « Pour Carlsberg, les opérations réseau et de sécurité ont la même finalité : s’assurer que la bière continue de couler. Selon moi, estomper les frontières entre les personnes chargées du réseau et celles chargées de la sécurité est le bon moyen pour atteindre cet objectif ».

Grâce à l’authentification multi-facteurs, une faille de sécurité chez Okta a pu être détectée et bloquée avant qu’elle ne permette aux attaquants d’accéder au système.

Le fournisseur en solutions de gestion des identités et des accès Okta a dernièrement indiqué que « des attaquants ont réussi à pénétrer dans son système de support en utilisant des identifiants volés et en extrayant des jetons de session client valides à partir de fichiers de support téléchargés ». Mais les politiques d’authentification multifactorielle (MFA) appliquées par l’un de ses clients ont permis de détecter l’accès non autorisé, de le bloquer et de signaler la violation à Okta. « Dans le cadre des activités normales, le support Okta demande aux clients de télécharger un fichier d’archive HTTP (HAR) qui aide à résoudre les problèmes en reproduisant l’activité du navigateur », a expliqué dans un billet de blog David Bradbury, responsable de la sécurité chez Okta. « Les fichiers HAR contiennent parfois des données sensibles, notamment des cookies et des jetons de session, que des acteurs malveillants peuvent utiliser pour se faire passer pour des utilisateurs valides », a-t-il ajouté. L’incident a été découvert par des ingénieurs en sécurité de BeyondTrust, un fournisseur de solutions de sécurité des identités et des accès, dont le compte administrateur Okta interne a été détourné. Les contrôles de politique mis en place par l’équipe de sécurité de l’entreprise ont bloqué une tentative d’authentification suspecte provenant d’une adresse IP en Malaisie.

L’attaquant invité à s’authentifier par MFA

Dans l’environnement Okta, la politique de BeyondTrust n’autorisait l’accès à la console d’administration Okta qu’à partir d’appareils gérés sur lesquels avait été installée Okta Verify, une application d’authentification multifactorielle développée par Okta. Dans le cadre de cette politique, l’attaquant a été invité à s’authentifier par MFA quand il a essayé d’accéder à la console d’administration, même si le jeton qu’il avait volé lui avait fourni une session valide. « Il est important que les clients d’Okta améliorent leurs politiques de sécurité en s’appuyant sur certains paramètres, par exemple, en invitant des utilisateurs avec des privilèges d’administration à s’authentifier par MFA à chaque connexion », a déclaré l’équipe de sécurité de BeyondTrust dans un bulletin. « Même si l’attaquant a détourné une session existante, Okta considère toujours l’accès au tableau de bord comme une nouvelle ouverture de session et demande l’autorisation d’ouvrir une session MFA. En outre, le compte administrateur de BeyondTrust a été configuré pour s’authentifier à l’aide d’un dispositif compatible avec la norme d’authentification sans mot de passe FIDO2 qui utilise la cryptographie à clé publique pour valider les utilisateurs, une option beaucoup plus sûre que les implémentations basées sur les SMS, vulnérables à des attaques basées sur l’échange de cartes SIM et d’autres techniques man-in-the-middle. Cette précaution a permis à BeyondTrust de comprendre rapidement que le vol du jeton de session n’avait pas eu lieu en interne et que Okta pouvait être à l’origine de la faille. De plus, l’authentification non autorisée s’est produite 30 minutes après que l’administrateur de BeyondTrust a téléchargé un fichier HAR vers le système de support d’Okta dans le cadre d’une demande de dépannage. Les fichiers HAR sont des enregistrements du navigateur utilisés par l’ingénieur du support pour reproduire les actions de l’utilisateur.

Des identifiants volés à l’origine de la faille

L’attaquant n’ayant pas réussi à accéder au tableau de bord d’administration d’Okta, il a décidé d’accéder au compte via l’API d’Okta de façon à créer un faux compte de service dénommé svc_network_backup. « Il est possible d’utiliser les cookies de session pour s’authentifier auprès de l’API officielle d’Okta qui, très souvent, ne sont pas soumis aux restrictions de politique qui s’appliquent à la console d’administration interactive », a mis en garde l’équipe de sécurité de BeyondTrust. « L’attaquant a agi rapidement, mais nos détections et nos réponses ont été immédiates, désactivant le compte et atténuant toute exposition potentielle ».

BeyondTrust a fait part de ses soupçons à Okta, qui a ensuite remonté la piste de la violation jusqu’aux identifiants volés qui donnaient l’accès nécessaire pour consulter les dossiers des clients dans les tickets d’assistance. Le fournisseur a indiqué qu’elle avait notifié tous les clients potentiellement concernés et révoqué tous les jetons de session intégrés dans les fichiers. Il conseille aux clients d’inspecter les cookies et les jetons de session des fichiers HAR avant de les télécharger et d’examiner les journaux de leur système Okta à la recherche de toute session suspecte. Dans son avis, l’entreprise fournit la liste des adresses IP utilisées par les attaquants pour accéder aux comptes des clients, associées en majorité à des services VPN commerciaux. Cloudflare, également touché par cet incident, a pu détecter et bloquer l’utilisation abusive de ses identifiants Okta avant que le fournisseur ne découvre la brèche. L’entreprise recommande vivement aux clients d’Okta de mettre en place un système MFA basé sur le matériel. « Les mots de passe seuls n’offrent pas le niveau de protection nécessaire contre les attaques », a indiqué Cloudflare dans son rapport. « Nous recommandons fortement l’utilisation de clés matérielles, car les autres méthodes de MFA peuvent être vulnérables aux attaques de phishing », a ajouté l’entreprise. « Il faut enquêter et répondre à tous les changements inattendus de mot de passe et de MFA de ses instances Okta et les événements suspects initiés par le support », a aussi conseillé Cloudflare. « Assurez-vous que toutes les réinitialisations de mot de passe sont valides et forcez une réinitialisation de mot de passe pour toute personne suspecte et assurez-vous que la configuration du compte de l’utilisateur ne contient que des clés MFA valides », a encore préconisé le fournisseur.

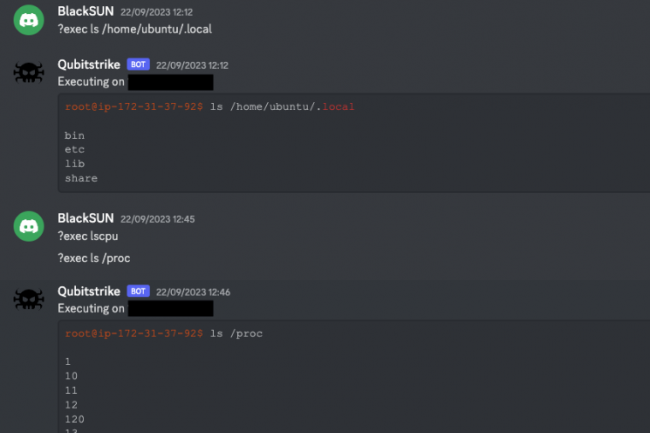

Des chercheurs de Cado Security ont détecté des instances cloud Jupyter Notebook ciblées par le malware de cryptojacking Qubitstrike utilisant un serveur Discord détourné par des pirates. Sa capacité de persistance apparait problématique.

La campagne d’attaque découverte par des chercheurs de Cado Security, une entreprise spécialisée dans l’investigation du cloud et la réponse aux incidents, compromet les instances Jupyter Notebook et déploie un logiciel malveillant de cryptojacking. Cette opération malveillante utilise un serveur Discord à des fins de C&C (command and control) et du vol d’identifiants AWS et Google Cloud sur des serveurs compromis. « Relativement sophistiquée, la campagne de logiciels malveillants Qubitstrike se concentre particulièrement sur l’exploitation des services cloud », ont expliqué les chercheurs dans leur rapport. « Les instances Jupyter Notebooks sont couramment déployées dans les environnements cloud, chez des fournisseurs comme Google et AWS qui les proposent en tant que services managés ». Jupyter Notebook est une plateforme informatique dynamique basée sur le web qui prend en charge plus de 40 langages de programmation et est utilisée pour la visualisation de données, l’apprentissage machine, les transformations de données, les simulations numériques, la modélisation statistique et la gestion de divers autres résultats de calcul. Il s’agit d’une application open source qui peut être déployée sur des serveurs et a été utilisée comme point d’entrée pour d’autres campagnes d’attaques basées sur le cloud au cours de l’année écoulée, car elle expose des fonctionnalités puissantes, notamment l’exécution de commandes.

Cado Security a pu voir les attaquants de Qubitstrike se connecter à ses honeypots Jupyter Notebook volontairement non protégés et tirer parti de la fonction d’accès au terminal pour ouvrir une interface de ligne de commande Bash. Mais aussi exécuter manuellement une série de commandes de reconnaissance pour collecter des informations sur le processeur du système, l’utilisateur actuellement connecté, et voir si l’accès root était disponible via la commande su et si l’outil curl était installé. À la fin de cette première, ils ont exécuté une commande codée en base64 utilisant curl pour télécharger un script Bash appelé mi.sh à partir d’un compte sur codeberg.org, une plateforme d’hébergement Git similaire à GitHub. Enfin, le script a été enregistré dans un dossier temporaire, puis exécuté et finalement supprimé.

Un malware configuré pour persister

Le script mi.sh configure le système pour le déploiement d’outils supplémentaires, en particulier une version du programme de minage de crypto-monnaie XMRig. Dans un premier temps, le script renomme les utilitaires curl et wget dans le système pour éviter de déclencher des détections système. Il analyse également les processus en cours d’exécution à la recherche de cryptomineurs concurrents et les supprime, ainsi que les connexions à une liste codée en dur d’adresses IP associées à des opérations de minage de cryptomonnaies. Le script supprime aussi divers journaux système et met en place une persistance sur le système en enregistrant plusieurs tâches cron et en ajoutant la clé SSH de l’attaquant au système. Plus important encore, il télécharge et déploie un rootkit appelé Diamorphine. Ce rootkit fonctionne comme un module de noyau chargé avec la commande insmod et dont le but est de cacher les processus de l’attaquant sur le système.

Si la commande insmod échoue, les attaquants compilent Diamorphine à partir des sources sous la forme d’un fichier Linux Shared Object, puis utilisent la technique LD Preload pour l’enregistrer auprès de l’éditeur de liens dynamiques, ce qui entraîne l’exécution du fichier malveillant chaque fois qu’un nouvel exécutable est lancé sur le système. « Le rootkit Diamorphine est bien connu dans les milieux des logiciels malveillants Linux. Il a été observé dans les campagnes de TeamTNT et, plus récemment, de Kiss-a-dog », ont déclaré les chercheurs de Cado. « La compilation du logiciel malveillant à la livraison est courante et est utilisée pour échapper aux EDR et à d’autres mécanismes de détection. Enfin, le script mi.sh recherche dans les répertoires locaux des jetons d’accès à AWS et Google Cloud et exfiltre tous ceux qui sont trouvés vers un groupe Telegram. Les chercheurs de Cado ont intentionnellement placé un jeton AWS sur leur système honeypot et ont immédiatement observé une tentative d’utilisation du jeton pour accéder au compte AWS associé. Qubitstrike agit également comme un travail SSH, le script essayant de se connecter à toutes les adresses IP répertoriées dans le fichier hosts SSH du système et tentant de leur envoyer le script mi.sh.

D’autres implants découverts dans le dépôt Codeberg

En enquêtant sur le dépôt Codeberg qui hébergeait le script mi.sh, les chercheurs ont découvert d’autres scripts et charges utiles, notamment un implant écrit en Python, appelé kdfs.py. Une fois exécuté sur un système, cet implant agit comme un bot qui rejoint un serveur et un canal Discord et attend des commandes. Il permet également de télécharger et d’envoyer des fichiers par l’intermédiaire de la fonction d’attachement de Discord. Le nom du serveur utilisé est « NETShadow » et le canal sur lequel le bot se connecte s’appelle « victims » », ont encore expliqué les chercheurs. « Le serveur disposait aussi d’un autre canal intitulé « ssh ». Cependant, il était vide. Tous les canaux ont été créés exactement à la même heure, le 2 septembre 2023, ce qui suggère que le processus de création a été automatisé. Le nom d’utilisateur du bot est Qubitstrike (d’où le nom que nous avons choisi de donner au logiciel malveillant) ».

Les chercheurs de Cado supposent que le fichier kdfs.py pourrait être exécuté sur certains systèmes avant d’être utilisé pour déployer mi.sh. Toutefois, le bot kdfs.py n’a jamais été déployé sur le système honeypot. Si l’objectif final de l’attaque était de déployer un mineur XMRig sur les systèmes compromis, l’accès des attaquants n’est évidemment pas limité à cela et ils pourraient également adopter d’autres tactiques. « Cado conseille vivement aux lecteurs qui déploient des carnets Jupyter de vérifier la sécurité des serveurs Jupyter eux-mêmes, en accordant une attention particulière aux configurations des pare-feux et des groupes de sécurité », ont déclaré les chercheurs. « Idéalement, les notebooks ne devraient pas être exposés à l’Internet public. S’il est nécessaire de les exposer, il faut s’assurer que l’authentification pour ces notebooks n’a pas été activée ».

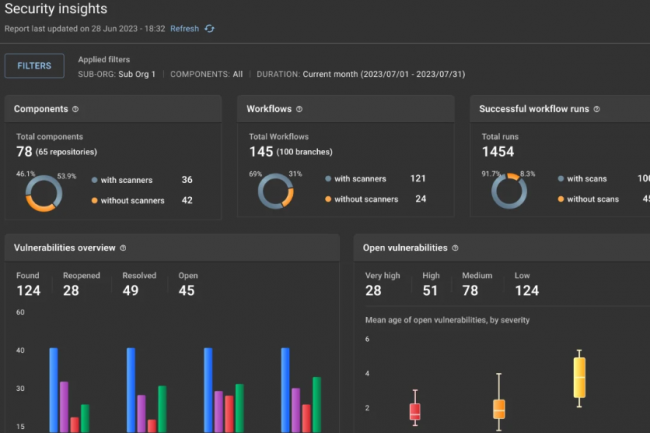

Basée sur Tekton, la plateforme DevSecOps de CloudBees se dote de fonctionnalités de feature flagging, de gestion du flux de valeur, d’orchestration du pipeline CI/CD et d’automatisation de workflow à la manière de GitHub Actions. Son lancement est calé pour ce 1er novembre.

CloudBees a lancé le compte-à-rebours pour sa plateforme DevSecOps cloud native basée sur le framework open source Tekton pour concevoir des pipelines d’intégration et de livraison continue (CI/CD) sur Kubernetes. Simplement dénommée CloudBees – pour l’instant -, cet environnement sera disponible dans les offres SaaS single et multi-tenant, ainsi que dans des instances de cloud privé virtuel sur site à partir du 1ᵉʳ novembre 2023. Selon CloudBees, cette plateforme vise à simplifier les processus complexes de développement et de déploiement cloud native et doit permettre aux développeurs de construire, tester et déployer des applications à travers les fournisseurs cloud et les systèmes on premise. En plus de Tekton, la plateforme utilise un langage spécifique au domaine (Domain-Specific Language DSL) de type GitHub Actions et apporte des fonctions de feature flagging, une technique de développement permettant d’activer ou de désactiver certaines fonctionnalités à la demande d’orchestration de pipelines, d’analyse, ainsi que des capacités intégrées de sécurité et de conformité.

La plateforme CloudBees met en avant les atouts suivants :

– Une expérience centrée sur le développeur, en rendant les processus devops presque invisibles ;

– L’extensibilité, en tirant parti des outils de développement, à commencer par le système CI/CD Jenkins. Les équipes peuvent également intégrer leurs technologies de prédilection dans la plateforme ;

– Un modèle en libre-service et une autonomie pour les équipes de développement ;

– Des modèles de workloads prêts à l’emploi avec une sécurité intégrée sachant que les informations sensibles comme les mots de passe et les tokens sont retirées du pipeline ;

– Des contrôles de sécurité et de conformité de premier ordre sur le code source, les binaires, les environnements cloud, les données et l’identité, basés sur Open Policy Agent.

Le mois dernier, CloudBees avait annoncé d’importantes mises à jour de haute disponibilité et de mise à l’échelle pour CloudBees CI, la version entreprise de Jenkins. « Parmi elles figurent la mise en cache de l’espace de travail pour des constructions plus rapides, un explorateur de pipeline pour un débogage plus rapide, et l’introduction de la mise à l’échelle horizontale pour Jenkins, qui supprime les goulets d’étranglement pour la mise à l’échelle des charges de travail CI/CD sur Jenkins », a déclaré CloudBees.