Aujourd’hui, l’IA se contente souvent de parler, dans des chatbots. Mais demain, sous sa forme agentique en particulier, elle enchaînera des actions concrètes et s’appuiera pour cela sur les API. Mais les enjeux d’efficacité, de sécurité, de confidentialité, d’interfaçage, notamment, restent nombreux.

Pour l’instant, les agents d’IA sont principalement des agents conversationnels. Nous les interrogeons et ils répondent. Bien que les fenêtres contextuelles s’agrandissent et que les intégrations avec des documents externes s’améliorent, ce type d’IA reste limitée dans sa manière d’interagir avec le monde réel. Une situation sur le point de changer radicalement à mesure que les agents d’IA s’intéressent aux API.Les API, lingua franca du numérique« Sans API, l’IA agentique ne peut ni combiner, ni orchestrer efficacement les processus entre différents systèmes », rappelle Rebecca Fox, DSI de la société de conseil en cybersécurité NCC Group. La technologie ne tiendra en effet ses promesses d’automatiser les workflows des entreprises que si elle peut se connecter aux CRM, aux calendriers, aux environnements de type Slack ou aux systèmes de paiement. Les API étant déjà la lingua franca de l’infrastructure numérique, elles constituent la passerelle naturelle pour rendre l’IA agentique réellement exploitable.Les agents invoquent de manière autonome les API via des mécanismes structurés d’appel de fonctions, pour accéder aux données, exécuter des tâches et piloter des flux de travail. Et l’enchaînement de plusieurs requêtes vers des API, au travers des systèmes de l’entreprise, rendent possible l’automatisation des workflows de l’organisation. Si les DSI soulignent l’importance des API, ils reconnaissent également que la voie à suivre présente encore des obstacles – notamment en matière de documentation, de gouvernance et de complexité du contrôle d’accès -, lacunes qui doivent être comblées pour parvenir à une véritable interopérabilité entre l’IA et les API.Les deux rôles centraux des API pour l’IA agentiqueLes API jouent deux rôles clés dans la concrétisation de l’IA agentique. « Les agents les utilisent pour accéder aux outils et aux données afin d’exécuter des tâches de manière autonome, explique Mark O’Neill, analyste chez Gartner. Mais ils peuvent disposer de leurs propres API afin d’instrumenter leurs actions ». Et l’accès aux API va au-delà du seul RAG. Il permet aux agents et aux LLM sous-jacents de réaliser des mutations dans une base de données, par exemple, et de déclencher des actions externes.Une évolution qui doit permettre aux agents d’exécuter des workflows complexes composés de plusieurs étapes, qui nécessitaient auparavant plusieurs interventions humaines. « Les API prêtes pour l’IA, associées à des capacités multi-agents, peuvent débloquer un large éventail de cas d’usage au sein des workflows de l’entreprise », déclare Milind Naphade, vice-président technologies et directeur des fondations IA pour la banque américaine Capital One.Les entreprises devront réaliser elles-mêmes les connexionsEn outre, les API constituent une passerelle essentielle pour sortir des systèmes d’IA précédemment isolés. « Pour l’instant, les services et les plateformes logicielles ont tendance à pousser leurs propres capacités d’IA intégrées, explique Rebecca Fox, group CIO du cabinet de conseil en cybersécurité NCC Group. Mais, pour être plus réaliste, les entreprises vont devoir connecter elles-mêmes l’IA à de multiples applications et sources de données par le biais d’API sécurisées. »Par rapport à des solutions de contournement fragiles comme le screen scraping ou l’intégration via des connecteurs, les API offrent une base beaucoup plus solide pour l’automatisation. Les API connectent en effet de façon transparente et en temps réel diverses sources de données.Comment les API rendent les agents d’IA exploitablesPour l’instant, les agents d’IA gèrent des fonctions simples comme les calendriers, la récupération des courriels et le résumé de réunions. Et ce, de manière autonome via les API. Mais ce n’est qu’un début. De la santé à l’assurance, de la logistique au service client, de multiples cas d’usage transformateurs de l’IA agentique émergent. En combinant les LLM avec une intégration robuste des outils, les API permettent aux agents d’agir comme des centres opérationnels, selon Doug Gilbert, DSI et CTO de la SSII spécialisée dans la data Sutherland. Dans le domaine de l’assurance, par exemple, les API alimentent des moteurs autonomes de traitement des sinistres qui extraient des données de documents externes, valident les sinistres en fonction des rapports de la police, détectent les fraudes et traitent les résultats avec un minimum d’intervention humaine.En utilisant des API, les agents d’IA peuvent aussi optimiser certaines opérations à la volée. Comme le raconte le cabinet Gartner, le fabricant de PC Lenovo utilise une suite d’agents autonomes pour optimiser son marketing et augmenter les conversions. Sous la supervision d’un agent de planification, les agents d’IA appellent des API pour accéder à l’historique d’achats et aux profils des clients, ainsi qu’aux données des produits. Et en fonction des informations glanées et des besoins, ils déclenchent des applications en aval dans le processus de configuration de la machine.Mais la véritable transformation interviendra dans des domaines tels que la finance, la gestion d’entrepôts, la logistique et la planification, où les workflows sont complexes et traditionnellement difficiles à optimiser. Les API pourraient même réduire le besoin de plateformes aujourd’hui saturées comme les ERP, en les remplaçant par des services spécialisés, ce qui réduirait à la fois les coûts et la complexité.Des projets tournés vers les utilisateurs« Qui plus est, l’accès aux API externes peut enrichir les applications d’IA avec des données et des fonctions pertinentes, au-delà de ce qu’un LLM seul peut réaliser », indique Brian Glass, DSI de la société de santé spécialisée dans les thérapies peptidiques Transcend. Cette dernière expérimente AgentForce de Salesforce pour améliorer les interactions avec ses clients, et ses agents utilisent les API pour valider les commandes de substances contrôlées, confirmer l’éligibilité du patient et signaler les effets secondaires potentiels. Transcend étudie également la manière dont les agents pilotés par API peuvent aider ses commerciaux à accéder en temps réel aux données relatives aux clients, aux ventes, à la démographie et aux laboratoires, tout en restant conformes à la loi HIPAA (Health Insurance Portability and Accountability Act, loi fédérale américaine qui réglemente les accès aux données de santé des citoyens).De plus en plus de projets orientés vers les utilisateurs apparaissent également. C’est le cas du concierge de Capital One, un agent conversationnel d’IA conçu pour améliorer l’expérience d’achat d’une voiture. Basé sur le modèle open source Llama, il exploite des API supplémentaires pour la comparaison de véhicules et la prise de rendez-vous avec les concessionnaires, par exemple.De premiers gains financiers« De nombreux workflows peuvent être réimaginés comme des instances spécifiques de cette technologie de workflow d’IA conversationnelle multi-agent », estime Milind Naphade de Capital One. Ce dernier prédit ainsi l’émergence de modèles similaires pour le service clients, la planification des voyages, l’analyse, etc. La gestion de projet est un autre terrain favorable à l’IA agentique portée par les API, avec la prise de notes en réunion ou la mise à jour autonome des trackers de projet et des tableaux de bord via des API internes. La détection et la remédiation des failles de cybersécurité est un autre cas d’usage évident.L’utilisation des API dans l’IA agentique peut, qui plus est, générer directement des gains financiers. Par exemple, Lenovo, qui utilise un essaim d’agents d’IA pour appeler des API, a constaté un taux de conversion en commande plus élevé pour les configurations générées par l’IA que pour celles générées par l’homme. Mais les gains les plus importants seront probablement liés à l’amélioration de l’efficacité opérationnelle et à la réduction des coûts. Cela découle en particulier d’une nouvelle agilité commerciale. « Lorsque l’IA agentique peut reconfigurer dynamiquement les business process, et faire en sorte d’utiliser uniquement les ressources nécessaires provenant des fournisseurs les plus performants, les opérations sont rationalisées, la complexité réduite et l’allocation des ressources améliorée », affirme Rebecca Fox.Réduire les délaisLes résultats du côté consommateurs sont significatifs. « Il ne s’agit pas simplement d’avoir une conversation », dit Brian Glass de Transcend, en décrivant comment l’accès aux API permet aux agents de guider les utilisateurs vers des résultats plutôt que de simplement répondre à des questions. Grâce aux API, les agents d’IA peuvent faire apparaître des données personnalisées et des sujets de discussion basés sur les interactions précédentes, ce qui conduit à des expériences plus sûres et plus productives. En médecine, la précision, l’exactitude et le temps de réponse sont essentiels, d’où l’importance de boucles de rétroaction réduites. « L’IA agentique et les API peuvent découvrir des choses mieux que les humains, ce qui rend les vérifications manuelles plus rapides, poursuit Brian Glass. Et si une API peut nous aider à être plus précis, nous sommes tout à fait d’accord ! »D’autres s’accordent à dire que l’IA agentique peut réduire les délais et aider à évaluer certains risques grâce à l’accès aux API. Selon Doug Gilbert, les compagnies d’assurance qui utilisent l’IA agentique ont réduit leurs délais de traitement des demandes d’indemnisation de 60% et leurs coûts de 30%. Et les agents connectés aux API devraient aussi rationaliser encore davantage les workflows liés à l’accueil, au traitement des sinistres et à l’assistance à la clientèle.Des questions d’interopérabilité à résoudreL’interopérabilité des API avec les agents d’IA se heurte toutefois à de gros obstacles, dont l’un réside dans le legacy. « Les API traditionnelles génèrent d’importantes frictions pour les agents d’IA, car elles ont été conçues pour que les développeurs humains y aient accès, explique Mark O’Neill du Gartner. Les workflows d’intégration d’API qui imposent de parler à une équipe commerciale ou qui cachent la documentation derrière une authentification, par exemple, ne sont pas bien positionnés. »Mais ce type d’environnements fermés existent parfois aussi pour des raisons légitimes. « Souvent, les fournisseurs ne sont pas incités à ouvrir complètement leurs API parce que cela pourrait nuire à leur modèle commercial, explique Rebecca Fox. En outre, pour garantir une interopérabilité transparente, il faut des API standardisées et robustes, capables de supporter des changements fréquents ».Des normes de documentation des API encore jeunes« L’intégration transparente des agents d’IA dans les écosystèmes d’entreprise est en réalité confrontée à plusieurs défis majeurs », explique Doug Gilbert. Il cite les problèmes liés aux LLM eux-mêmes, l’absence de cadres de gouvernance clairs et l’incertitude liée aux réglementations en cours en matière d’IA. Sans négliger l’intégration avec les systèmes existants. Une infrastructure obsolète avec des API fragmentées ou mal documentées peut ralentir considérablement le processus.Les normes relatives à la documentation des API sont également naissantes dans de nombreuses organisations. Selon Enterprise Management Associates (EMA), seuls 10% des entreprises documentent entièrement leurs API. Plus inquiétant encore, une étude réalisée en 2024 par la société de monitoring d’API APIContext a révélé que 75% des API en production divergent de leur définition OpenAPI. Cela signifie que la plupart sont soit décrites de manière inexacte, soit dépourvues de définition appropriée.L’éternel défi de la dataLes obstacles à l’interopérabilité dépendront également de l’existence d’une stratégie solide en matière de données de base, ce qui n’est pas encore totalement acquis dans de nombreuses entreprises. « L’un des plus grands défis auxquels sont confrontées les entreprises est le besoin pour l’IA agentique de datasets volumineux contenant des données variées, telles que les données non structurées – courriels, documents et vidéos -, plus difficiles à valider et à gouverner », dit Joel Chaplin, le DSI de la société spécialiste de data management Precisely. Celle-ci a pris le sujet à bras le corps en préparant ses données pour les agents d’IA, en les centralisant, en appliquant des techniques d’étiquetage, de classification et d’intégration des métadonnées pour rendre le contenu lisible par la machine et riche sur le plan sémantique. L’objectif consiste à transformer le contenu brut en connaissances structurées sur lesquelles l’IA peut raisonner de manière sûre et efficace.L’ouverture d’un plus grand nombre d’accès API aux systèmes autonomes pose de nouveaux risques de sécurité des API. Cela tient en partie au fait que les agents sont construits sur des modèles de langage non déterministes, qui se comportent de manière imprévisible. Lorsqu’ils agissent de manière autonome ou au nom d’autres agents, leur intention peut devenir confuse. « La sécurité est probablement le plus grand casse-tête », juge Rebecca Fox, soulignant les implications en matière d’authentification et d’autorisation. Étant donné la propension de l’IA à halluciner, il est difficile de lui faire confiance pour respecter des autorisations granulaires, telles que “qui devrait avoir accès à quoi, pourquoi et quand”. « Les faux pas ne sont pas seulement gênants, ils peuvent exposer des données sensibles ou créer des cauchemars en matière de conformité », indique-t-elle.Le casse-tête majeur de la sécuritéPrès de 95% des attaques contre les API proviennent d’utilisateurs authentifiés, selon les données de Salt Security pour 2025. De nombreux piratages surviennent lorsqu’un attaquant modifie simplement l’identifiant d’un utilisateur dans une demande d’API afin d’obtenir des informations non autorisées. Cela signifie que le fait d’encourager une plus grande utilisation des API par les agents pourrait amplifier les lacunes préexistantes en matière de contrôle d’accès. « Une grande partie de la réflexion actuelle sur la sécurité de l’IA se concentre sur OAuth, ajoute Mark O’Neill. Mais OAuth 2.0, le cadre d’autorisation d’API omniprésent, n’a qu’une portée limitée. Un agent peut avoir les bonnes directives d’autorisation d’usage d’une API, mais faire dériver ses privilèges au moment de l’exécution. »Sans mesures de protection appropriées, les systèmes agentiques risquent d’accéder à des données sensibles ou de les utiliser à mauvais escient, de communiquer avec des plates-formes non fiables ou de subir des attaques par injection rapide et par usurpation d’entrée. « Un accès illimité pourrait entraîner le partage non autorisé d’informations confidentielles et élargir la surface d’attaque », poursuit Doug Gilbert. Pour réagir, Sutherland adopte une approche en plusieurs étapes. La société utilise notamment des passerelles API basées sur les rôles, un contrôle d’accès précis, une validation stricte des entrées et des pratiques d’observabilité rigoureuses pour faciliter l’audit et la détection des adversaires. Dans l’ensemble, les protections traditionnelles des points de terminaison ne suffiront pas ; les entreprises auront besoin de cadres de gouvernance évolutifs et sensibles aux intentions pour prendre en charge l’autonomie de l’IA, explique Doug Gilbert.La nécessité de normes d’intégration des API à l’IALa connexion des agents d’IA avec les API à grande échelle dépendra aussi des normes industrielles adoptées. La principale, MCP, est le protocole open source proposé par Anthropic. Depuis sa publication l’année dernière, il a donné naissance à un vaste écosystème de serveurs de connexion des agents d’IA à des données, des outils et des API externes. Si l’adoption de ce protocole est montée en flèche ces derniers mois, il en existe d’autres comme le protocole agent-to-agent (A2A) de Google.Certains observateurs soulignent le rôle des spécifications standards indépendantes des fournisseurs. C’est le cas d’Arazzo, qui définit les séquences d’appels d’API et convient parfaitement aux agents d’IA. Avec Arazzo, les fournisseurs d’API peuvent suggérer aux agents des flux prédéterminés multi-étapes afin d’éviter les enchaînements plus hasardeux. « Les normes ouvertes telles que OpenAPI, OAuth2 et GraphQL sont également essentielles, car elles garantissent une intégration sécurisée et évolutive dans les environnements d’entreprise », ajoute Doug Gilbert. Heureusement, avec l’émergence de nouveaux frameworks d’IA, les entreprises n’auront pas à se charger elles-mêmes de l’intégration de ces technologies en utilisant des normes ouvertes. « Du point de vue de la sécurité, OAuth est un point de départ essentiel, affirme Rebecca Fox. Des cadres de sécurité plus avancés, en particulier autour des architectures Zero Trust et de la gestion granulaire des identités, deviendront indispensables ».Un optimisme prudentLes API sont largement considérées comme le pivot de l’évolution de l’IA agentique, mais le paysage actuel est loin d’être parfait. Les entreprises sont toujours confrontées à des défis tels que des pratiques incohérentes en matière de données, des normes fragmentées, des protocoles d’intégration concurrents et des préoccupations croissantes en matière de sécurité. C’est pourquoi certains dirigeants abordent le sujet avec un optimisme prudent, plutôt que de se précipiter.

A l’origine d’une plateforme pour modéliser les relations entre les infrastructures, assurer la découverte des périphériques et des services du réseau, et vérifier la conformité des configurations, NetBox Labs a levé 35 millions de dollars. Observabilité et analyse de la sécurité sont au menu de ses prochains projets.

Alors que les exigences de l’IA augmentent les besoins et les opportunités, le marché de l’infrastructure réseau connaît un regain d’intérêt. Les approches traditionnelles de documentation et de gestion des réseaux s’avèrent inadaptées aux exigences des infrastructures modernes, créant ainsi des opportunités pour les plateformes qui peuvent fournir une visibilité complète et des capacités d’automatisation. Ce qui est l’objectif de NetBox Labs. L’entreprise a annoncé hier qu’elle avait levé 35 M$ dans le cadre d’un financement de série B mené par NGP Capital, avec la participation de nouveaux investisseurs, à savoir Sorenson Capital et Headline. Tous les investisseurs existants ont participé à ce tour de table, notamment Flybridge Capital, Notable Capital, Mango Capital, Salesforce Ventures, Two Sigma Ventures et IBM. Ce tour de table porte le financement total de la société à 55 M$ et montre l’adoption croissante de NetBox comme solution standard de la gestion de l’infrastructure réseau par les entreprises.

Issu du fournisseur de plateforme DNS NS1, NetBox Labs a été racheté par IBM en 2023. Sa technologie open source s’est imposée comme une norme de facto pour la documentation du réseau et la planification de l’infrastructure. Sa base ouverte a permis une adoption généralisée, tandis que les offres commerciales fournissent des capacités de niveau entreprise aux entreprises qui ont besoin de gérer des infrastructures complexes et critiques. « Nous pensons que la gestion de l’infrastructure dans son ensemble est appelée à se développer, et NetBox est au centre de cette évolution dans une position de force en raison de la gravité des données, représentée dans la base d’installation de NetBox », a déclaré Kris Beevers, cofondateur et CEO de NetBox Labs, à NetworkWorld. « Tout le monde utilise déjà NetBox en raison de la dynamique open source ; il y a des centaines de milliers d’installations du logiciel, ce qui nous donne un point de vue vraiment unique pour construire la pile de gestion de l’infrastructure moderne, et cela couvre beaucoup de territoire. »

Fonctionnement et importance de NetBox

Comme l’a expliqué M. Beevers, cet outil sert de système d’enregistrement pour les équipes d’infrastructure. « C’est le modèle de données dans lequel elles documentent et planifient toute leur infrastructure ». Techniquement, la plateforme est centrée sur la modélisation détaillée des relations entre les infrastructures, incluant aussi bien la fourniture d’adresse IP sur une interface, l’emplacement de l’interface sur le commutateur et l’emplacement de celui-ci dans un rack. Par ailleurs, l’éditeur a ajouté à la plateforme de base des produits qui répondent à des problématiques opérationnelles tout en tirant parti du référentiel de données central. C’est le cas de Discovery qui assure la découverte automatisée des équipements et des services du réseau, en maintenant une synchronisation continue entre l’état documenté de l’infrastructure et les déploiements réels. Le moteur de découverte identifie les dérives de configuration et alimente NetBox avec des données topologiques réelles, résolvant ainsi l’éternel problème d’une documentation réseau obsolète dans des environnements dynamiques.

De son côté le produit Assurance, qui s’appuie sur le moteur de découverte (lancé en disponibilité générale depuis avril dernier) apporte des capacités de mise en conformité de la configuration et de détection des dérives devenues essentielles pour la sécurité et l’excellence opérationnelle. La plateforme compare en permanence l’état prévu de l’infrastructure, tel qu’il est modélisé dans NetBox, avec les configurations déployées, en identifiant les écarts. La réponse du marché aux capacités d’assurance a été particulièrement forte. « Environ 40 % des clients qui s’adressent à nous aujourd’hui achètent NetBox Assurance », poursuit M. Beevers.

La demande d’infrastructures d’IA stimule la croissance du marché

Le boom des infrastructures d’IA a créé une demande sans précédent pour des capacités de gestion de réseau sophistiquées, en particulier parmi les entreprises qui déploient des clusters GPU à grande échelle et des environnements de calcul à haute performance. C’est le cas en particulier de Coreweave, l’un des fournisseurs de cloud d’IA qui affiche la croissance la plus rapide du marché, qui est aujourd’hui l’un des plus gros clients de NetBox Labs. « Corweave gère l’ensemble de l’infrastructure de son centre de données et de son réseau à partir de NetBox », a indiqué M. Beevers. « La grande proposition de valeur pour Coreweave, c’est qu’il peut construire une infrastructure de centre de données pour l’IA plus rapidement que tout le monde. L’an dernier, en grande partie grâce à l’automatisation, il est parvenu à construire 25 ou 30 centres de données. » Ce cas d’usage démontre le rôle de NetBox dans la mise en œuvre d’approches d’infrastructure as code pour le déploiement rapide de centres de données. Les entreprises peuvent modéliser des conceptions de datacenters dans cette solution, générer des scripts de provisionnement automatisés et maintenir une supervision opérationnelle complète grâce aux capacités de surveillance et de conformité de la plateforme.

En plus d’aider les opérateurs d’infrastructure à répondre aux besoins d’IA, le fournisseur développe également ses propres capacités d’IA. Operator, actuellement en cours de développement, représente un saut technique vers les opérations d’infrastructure pilotées par l’IA. La plateforme basée sur des agents utilise de grands modèles de langage (LLM) pour permettre une interaction en langage naturel avec les données d’infrastructure et automatiser des procédures opérationnelles complexes qui requièrent traditionnellement une expertise approfondie du domaine. Cette solution utilise la plateforme Nitro de l’entreprise, qui fournit des modèles d’intelligence artificielle pour les réseaux. L’innovation technique est centrée sur les données relationnelles structurées de NetBox, qui fournissent le cadre contextuel nécessaire aux systèmes d’IA pour raisonner intelligemment sur l’infrastructure. « Les relations sont vraiment très importantes pour permettre aux LLM et aux agents de raisonner et d’interagir avec les données de l’infrastructure », a fait remarquer M. Beevers. « Sans cela, on ne fait que jeter un tas de données brutes à un modèle qui n’a pas la capacité de connecter entre eux les éléments de l’infrastructure ».

Projets futurs et expansion du marché

Le fournisseur opère dans plusieurs domaines technologiques principaux qui définissent sa stratégie d’expansion. Selon M. Beevers, l’entreprise réfléchit à cinq domaines fondamentaux : l’infrastructure, les opérations, l’observabilité, l’automatisation et la sécurité. Le fournisseur maintient un rythme de développement agressif avec de fréquents lancements de produits. De nombreux nouveaux produits sont en cours de développement dans tous les domaines d’activité de l’entreprise. « Nous menons beaucoup de travaux, en particulier dans les domaines de l’observabilité, de l’analyse de la sécurité et nous prévoyons de travailler sur d’autres produits d’IA dans les prochaines semaines », a encore déclaré le CEO de Netbox Labs.

A l’origine d’une plateforme pour modéliser les relations entre les infrastructures, assurer la découverte des périphériques et des services du réseau, et vérifier la conformité des configurations, NetBox Labs a levé 35 millions de dollars. Observabilité et analyse de la sécurité sont au menu de ses prochains projets.

Alors que les exigences de l’IA augmentent les besoins et les opportunités, le marché de l’infrastructure réseau connaît un regain d’intérêt. Les approches traditionnelles de documentation et de gestion des réseaux s’avèrent inadaptées aux exigences des infrastructures modernes, créant ainsi des opportunités pour les plateformes qui peuvent fournir une visibilité complète et des capacités d’automatisation. Ce qui est l’objectif de NetBox Labs. L’entreprise a annoncé hier qu’elle avait levé 35 M$ dans le cadre d’un financement de série B mené par NGP Capital, avec la participation de nouveaux investisseurs, à savoir Sorenson Capital et Headline. Tous les investisseurs existants ont participé à ce tour de table, notamment Flybridge Capital, Notable Capital, Mango Capital, Salesforce Ventures, Two Sigma Ventures et IBM. Ce tour de table porte le financement total de la société à 55 M$ et montre l’adoption croissante de NetBox comme solution standard de la gestion de l’infrastructure réseau par les entreprises.

Issu du fournisseur de plateforme DNS NS1, NetBox Labs a été racheté par IBM en 2023. Sa technologie open source s’est imposée comme une norme de facto pour la documentation du réseau et la planification de l’infrastructure. Sa base ouverte a permis une adoption généralisée, tandis que les offres commerciales fournissent des capacités de niveau entreprise aux entreprises qui ont besoin de gérer des infrastructures complexes et critiques. « Nous pensons que la gestion de l’infrastructure dans son ensemble est appelée à se développer, et NetBox est au centre de cette évolution dans une position de force en raison de la gravité des données, représentée dans la base d’installation de NetBox », a déclaré Kris Beevers, cofondateur et CEO de NetBox Labs, à NetworkWorld. « Tout le monde utilise déjà NetBox en raison de la dynamique open source ; il y a des centaines de milliers d’installations du logiciel, ce qui nous donne un point de vue vraiment unique pour construire la pile de gestion de l’infrastructure moderne, et cela couvre beaucoup de territoire. »

Fonctionnement et importance de NetBox

Comme l’a expliqué M. Beevers, cet outil sert de système d’enregistrement pour les équipes d’infrastructure. « C’est le modèle de données dans lequel elles documentent et planifient toute leur infrastructure ». Techniquement, la plateforme est centrée sur la modélisation détaillée des relations entre les infrastructures, incluant aussi bien la fourniture d’adresse IP sur une interface, l’emplacement de l’interface sur le commutateur et l’emplacement de celui-ci dans un rack. Par ailleurs, l’éditeur a ajouté à la plateforme de base des produits qui répondent à des problématiques opérationnelles tout en tirant parti du référentiel de données central. C’est le cas de Discovery qui assure la découverte automatisée des équipements et des services du réseau, en maintenant une synchronisation continue entre l’état documenté de l’infrastructure et les déploiements réels. Le moteur de découverte identifie les dérives de configuration et alimente NetBox avec des données topologiques réelles, résolvant ainsi l’éternel problème d’une documentation réseau obsolète dans des environnements dynamiques.

De son côté le produit Assurance, qui s’appuie sur le moteur de découverte (lancé en disponibilité générale depuis avril dernier) apporte des capacités de mise en conformité de la configuration et de détection des dérives devenues essentielles pour la sécurité et l’excellence opérationnelle. La plateforme compare en permanence l’état prévu de l’infrastructure, tel qu’il est modélisé dans NetBox, avec les configurations déployées, en identifiant les écarts. La réponse du marché aux capacités d’assurance a été particulièrement forte. « Environ 40 % des clients qui s’adressent à nous aujourd’hui achètent NetBox Assurance », poursuit M. Beevers.

La demande d’infrastructures d’IA stimule la croissance du marché

Le boom des infrastructures d’IA a créé une demande sans précédent pour des capacités de gestion de réseau sophistiquées, en particulier parmi les entreprises qui déploient des clusters GPU à grande échelle et des environnements de calcul à haute performance. C’est le cas en particulier de Coreweave, l’un des fournisseurs de cloud d’IA qui affiche la croissance la plus rapide du marché, qui est aujourd’hui l’un des plus gros clients de NetBox Labs. « Corweave gère l’ensemble de l’infrastructure de son centre de données et de son réseau à partir de NetBox », a indiqué M. Beevers. « La grande proposition de valeur pour Coreweave, c’est qu’il peut construire une infrastructure de centre de données pour l’IA plus rapidement que tout le monde. L’an dernier, en grande partie grâce à l’automatisation, il est parvenu à construire 25 ou 30 centres de données. » Ce cas d’usage démontre le rôle de NetBox dans la mise en œuvre d’approches d’infrastructure as code pour le déploiement rapide de centres de données. Les entreprises peuvent modéliser des conceptions de datacenters dans cette solution, générer des scripts de provisionnement automatisés et maintenir une supervision opérationnelle complète grâce aux capacités de surveillance et de conformité de la plateforme.

En plus d’aider les opérateurs d’infrastructure à répondre aux besoins d’IA, le fournisseur développe également ses propres capacités d’IA. Operator, actuellement en cours de développement, représente un saut technique vers les opérations d’infrastructure pilotées par l’IA. La plateforme basée sur des agents utilise de grands modèles de langage (LLM) pour permettre une interaction en langage naturel avec les données d’infrastructure et automatiser des procédures opérationnelles complexes qui requièrent traditionnellement une expertise approfondie du domaine. Cette solution utilise la plateforme Nitro de l’entreprise, qui fournit des modèles d’intelligence artificielle pour les réseaux. L’innovation technique est centrée sur les données relationnelles structurées de NetBox, qui fournissent le cadre contextuel nécessaire aux systèmes d’IA pour raisonner intelligemment sur l’infrastructure. « Les relations sont vraiment très importantes pour permettre aux LLM et aux agents de raisonner et d’interagir avec les données de l’infrastructure », a fait remarquer M. Beevers. « Sans cela, on ne fait que jeter un tas de données brutes à un modèle qui n’a pas la capacité de connecter entre eux les éléments de l’infrastructure ».

Projets futurs et expansion du marché

Le fournisseur opère dans plusieurs domaines technologiques principaux qui définissent sa stratégie d’expansion. Selon M. Beevers, l’entreprise réfléchit à cinq domaines fondamentaux : l’infrastructure, les opérations, l’observabilité, l’automatisation et la sécurité. Le fournisseur maintient un rythme de développement agressif avec de fréquents lancements de produits. De nombreux nouveaux produits sont en cours de développement dans tous les domaines d’activité de l’entreprise. « Nous menons beaucoup de travaux, en particulier dans les domaines de l’observabilité, de l’analyse de la sécurité et nous prévoyons de travailler sur d’autres produits d’IA dans les prochaines semaines », a encore déclaré le CEO de Netbox Labs.

Des données mal classées à l’utilisation de l’IA sans assurance d’une qualité de data suffisante, les DSI qui cherchent à tirer le meilleur parti de la donnée interne et externe pour les prises de décision peuvent nourrir un certain niveau de paranoïa.

Les directions générales poussent les DSI à fournir des analyses prédictives ou à transformer le fonctionnement des équipes avec des agents d’IA. Pour autant, les investissements dans la gouvernance, les opérations et la sécurité des données sont trop souvent relégués au second plan face aux projets métier, ce qui en pratique compromet le succès de l’IA.Pour combler ces lacunes et s’assurer que la supply chain data est l’objet de suffisamment d’attention au plus haut niveau, les DSI se sont d’abord adjoint les compétences des CDO, leur confiant la gestion de la dette de données, l’automatisation des pipelines de données et le passage à un modèle de gouvernance proactif, centré sur les indicateurs de santé des data, sur leur qualité et sur l’interopérabilité des modèles. Mais les DSI ne doivent pas non plus trop déléguer ces responsabilités. Ceux qui cherchent à tirer une valeur business des investissements dans l’IA en particulier, doivent accorder davantage d’attention aux risques liés aux données susceptibles de compromettre cet objectif.Un certain niveau de paranoïa des DSI à l’égard des risques liés à l’exploitation de la data à l’ère de l’IA, en particulier en ce qui concerne la propriété intellectuelle et les capacités émergentes de l’IA, est tout à fait sain. Voici six risques de ce type qu’ils devraient examiner de près et face auxquels ils devraient doter leurs équipes de stratégies de remédiation. Idéalement, pour transformer ces dangers en opportunités stratégiques.1. Des données mal classées et des data owners désengagésDemandez à n’importe quel responsable de la gouvernance des données quelles sont ses principales difficultés pour améliorer la qualité des données et se conformer aux réglementations. En tête de liste, figurent l’identification et le niveau d’implication des data owners dans la définition et le respect des politiques data. Si ceux-ci ne sont que peu impliqués, les données utilisées dans l’IA peuvent être mal classées, ce qui pourrait enfreindre les règles de confidentialité et d’autres réglementations. De plus, à l’ère de l’IA, les données non classées posent une autre question : les data scientists peuvent-ils utiliser ces data dans des modèles sans respecter la conformité requise ou la gouvernance des données doit-elle les en empêcher ?Les DSI directement impliqués dans la gouvernance data arrivent souvent à convaincre plus efficacement les chefs de département de désigner des data owners. Les besoins en citizen data scientists et l’envie d’obtenir des avantages métiers avec l’IA sont trop importants pour que les dirigeants refusent d’en assumer la responsabilité. De plus, une fois que ces data owners sont impliqués, il est plus facile de les faire participer à la gouvernance de l’IA et de les associer au pilotage des agents.2. L’exposition de la propriété intellectuelle à l’IADe nombreux DSI sont par ailleurs préoccupés par le shadow AI, lorsque les employés utilisent des LLM publics et expérimentent d’autres outils de GenAI que ceux approuvés par l’entreprise. Le partage de données mal classées et l’exposition de propriété intellectuelle avec ces solutions constituent des risques importants. Les employés utilisent en effet parfois des données, du code, des éléments de la charte de marque, des contrats ou des sections de documents sensibles dans leurs prompts. La propriété intellectuelle peut aussi être mise en danger lorsque les data scientists s’en servent pour entraîner des modèles d’IA, pour du RAG ou de la création d’agents, sans les autorisations requises.« Les données sont l’un des actifs les plus précieux qu’une entreprise possède, et elles doivent être protégées en tant que tel, insiste Joe Locandro, DSI monde du spécialiste de la maintenance logiciel Rimini Street. Les DSI doivent être vigilants face à ce type de manipulation de données par les employés, face à l’utilisation abusive des outils d’IA ou face à une mauvaise hygiène cyber. Il est essentiel de donner la priorité à la formation du personnel à une bonne utilisation des data dans l’IA, au masquage des données sensibles dans les systèmes principaux et à des audits réguliers de la sécurité des données ». Srujan Akula, PDG de l’éditeur de plateformes data The Modern Data Company, conseille lui aux DSI de créer des data products à partir de datasets dignes de confiance et de leur associer des data product owners bien identifiés et une gouvernance claire.Pour transformer ce risque en avantage, les DSI peuvent aussi déployer des programmes de formation à la data et, sur le modèle de l’open innovation, encourager tous les employés à soumettre des idées. Une combinaison qui encourage l’apprentissage et la résolution de problèmes, mais donne aussi à l’organisation une visibilité sur un plus grand nombre de projets émanant des employés.3. Des sources de données tierces mal maîtriséesLes seules entreprises américaines devraient dépenser plus de 26 Md$ (environ 22,2 Md€) en achat de données marketing en 2025. Celles-ci sont généralement utilisées pour la segmentation de la clientèle ou la personnalisation des campagnes. S’il est déjà difficile de s’assurer que les pratiques internes en matière de données respectent les exigences réglementaires et la gouvernance interne, le suivi de la conformité des data issues de sources tierces est un défi d’une tout autre ampleur. « L’un des risques les plus négligés réside dans l’utilisation de pipelines de données tiers ou de services d’enrichissement de data sans en vérifier la source, confirme Luis Lacambra, responsable produit chez le prestataire data Soax. Si elles sont récupérées ou agrégées à partir de sources publiques avec des méthodes peu fiables ou non conformes, votre organisation pourrait s’exposer à un audit réglementaire ou se retrouver dans des angles morts opérationnels ». L’examen de la conformité des données tierces devrait être un élément non négociable de la gouvernance des données.Les entreprises achètent et intègrent par ailleurs de nombreuses sources qui ne sont pas utilisées, qui fournissent des informations en doublon avec d’autres sources ou qui n’apportent qu’une valeur marginale. Les DSI à la recherche de réduction de coûts devraient procéder à un audit coûts-avantages des sources de données tierces, examiner leur utilisation et quantifier les risques, afin d’éliminer les sources à faible valeur ajoutée et à risque élevé.4. Une mauvaise observabilité des pipelines de dataLa plupart des entreprises investissent dans des plateformes d’analyse de données et des outils de traitement de documents pour les utilisateurs, avant de se doter de solutions d’intégration de data et de pipelines robustes. Alors que les différents services dans l’organisation dépendent de plus en plus des données en temps réel pour prendre des décisions, la fiabilité et la performance des pipelines de données peuvent devenir un cauchemar opérationnel. Et ce, en particulier lorsque les responsables data passent leur temps à résoudre des problèmes ou si des données qui arrivent trop tard entraînent de mauvaises décisions.Les DSI doivent être conscients des risques liés aux données qui menacent l’intégrité de l’organisation, ainsi que des enjeux relatifs à la sécurité et à l’efficacité de la prise de décision. Une visibilité limitée sur les pipelines de données et les modèles d’utilisation avec une observabilité insuffisante peut ainsi dissimuler des problèmes de latence, de dérive des données, de défaillances des pipelines, ou compromettre l’emplacement du stockage des données sensibles.L’observabilité DataOps comprend la surveillance des pipelines de données, l’automatisation des réponses et le suivi des performances. Les mesures de DataOps, elles, comprennent la fiabilité du pipeline, les taux d’automatisation, les taux d’exception et le débit de traitement. Et la réduction d’incidents liés au DataOps peut représenter une économie pour les DSI qui intègrent de nombreuses sources de données et utilisent des data fabrics. Mais, plus important encore, l’intégration de données non fiables érode la confiance, ce qui peut ralentir le déploiement d’IA et des pratiques centrées sur les données au sein de l’entreprise.5. Les lacunes dans la qualité des donnéesLes DSI ont longtemps lutté pour améliorer la qualité des données en désignant des data stewarts, en automatisant les procédures de data cleansing et en mesurant la santé des données. Cependant, la plupart de ces tâches portent sur des sources de données structurées dans les ERP, les CRM et les datawarehouses. Or, l’IA en a élargi le champ aux données non structurées et aux référentiels de documents utilisés pour alimenter les modèles et fournir des réponses pertinentes en fonction du contexte, avec le RAG ou les agents d’IA.Le RAG permet aux entreprises d’accéder à des connaissances organisationnelles, mais ce n’est pas sans risque d’atteinte à la confidentialité des données, d’hallucinations ou de complexification de l’intégration. La mise en oeuvre nécessite d’investir dans la qualité des données, d’établir des cadres de gouvernance et de créer des systèmes d’évaluation avant de passer à l’échelle.Pour combler les lacunes en matière de qualité des données, les DSI devraient centraliser les données brutes dans des datalakes, proposer le data cleansing comme un service partagé et donner accès aux données via des data fabrics et des plateformes de données clients.6. La surestimation des réponses de l’IA sans assurance sur la qualité des dataLa gouvernance de l’IA peut être définie à partir de 7 questions, dont celles sur la valeur métiers, la sélection des outils, la conformité et la gouvernance des données. Mais un des défis majeurs réside dans la façon dont les employés valident ou au contraire remettent en question la réponse d’un LLM ou les recommandations d’un agent d’IA. Cette question est d’autant plus importante pour les DSI qui cherchent à développer des agents, car les pratiques d’assurance qualité pour tester les LLM sont encore émergentes et reposent souvent sur des tests manuels.Les DSI doivent pourtant surveiller en permanence l’exactitude et la fiabilité des résultats générés par l’IA. Les LLM n’étant pas déterministes, la définition même de la qualité de ces résultats est complexe et les frontières entre l’ingénierie, l’assurance qualité et le produit s’estompent progressivement. Cette évolution exige une collaboration plus étroite entre les équipes pour s’assurer que les utilisations de l’IA sont dignes de confiance, alignées sur les besoins des utilisateurs et capables de générer de véritables résultats business.Il est plus facile pour un DSI de justifier le recrutement de développeurs ou l’augmentation des systèmes de résilience et de sécurité que des investissements dans la qualité data ou les tests sur l’IA. Mais cela pourrait changer à mesure que de plus en plus de développeurs utilisent des générateurs de code à base d’IA et que les opérations informatiques sont de plus en plus automatisées.

Le budget 2026 de Donald Trump réduirait les dépenses en cybersécurité de plus d’un milliard de dollars par rapport à 2024. Une décision qui pourrait affaiblir les défenses fédérales, réduire le vivier de talents dans ce domaine et priver les États et les villes de subventions vitales.

Le projet de loi fiscale de Donald Trump, qu’il a signé le 4 juillet, contenait quelques éléments de financement cybersécurité dignes d’intérêt, notamment 250 M$ destinés à l’US Cyber Command pour des « efforts en matière d’intelligence artificielle ». Mais le prochain défi de financement de l’administration, le plus important, consistera à faire passer la demande de budget discrétionnaire de la Maison Blanche pour l’exercice 2026 à la Chambre des représentants et au…

Il vous reste 96% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

AMD a détecté quatre vulnérabilités dans de nombreuses puces Epyc et Ryzen exposant les systèmes d’entreprise à des attaques par canal auxiliaire. Microsoft et CrowdStrike mettent en garde contre les risques critiques malgré les notes de gravité inférieures du fournisseur de puces.

AMD a révélé ce mardi quatre vulnérabilités affectant ses processeurs qui pourraient permettre à des attaquants de voler des données sensibles dans des systèmes d’entreprise par le biais d’attaques par canal auxiliaire. Ces vulnérabilités, identifiées par le fournisseur de puces sous l’ID SB-7029; sont connues sous le nom de Transient Scheduler Attacks (TSA). Des modèles de puces Epyc pour serveurs aussi bien que des processeurs Ryzen pour PC fixes et portables sont touchés. Cette divulgation a immédiatement déclenché une controverse sur l’évaluation de la gravité, l’entreprise de cybersécurité Crowdstrike classant les failles clés comme des menaces « critiques » malgré les évaluations de gravité moyenne et faible émises par AMD. Ce désaccord met en évidence les difficultés croissantes auxquelles les entreprises sont confrontées lorsqu’elles évaluent les risques de sécurité au niveau des processeurs. L’entreprise a commencé à diffuser des mises à jour du micrologiciel d’initialisation de la plate-forme auprès des fabricants d’équipement d’origine, tout en coordonnant des mesures d’atténuation complètes avec les fournisseurs de systèmes d’exploitation.

Ces vulnérabilités sont apparues à la suite de l’enquête menée par la firme de Santa Clara sur un rapport de recherche de Microsoft intitulé “Enter, Exit, Page Fault, Leak : Testing Isolation Boundaries for Microarchitectural Leaks”. Elle a découvert ce qu’elle appelle des « attaques transitoires du planificateur liées au temps d’exécution des instructions dans des conditions microarchitecturales spécifiques. » Ces attaques exploitent les « faux achèvements » dans les opérations du processeur. Lorsque les puces s’attendent à ce que les instructions de chargement se terminent rapidement, mais que les conditions empêchent leur exécution, les attaquants peuvent mesurer les différences de temps pour extraire des informations sensibles. « Dans certains cas, un attaquant peut être en mesure d’utiliser ces informations temporelles pour déduire des données d’autres contextes, ce qui entraîne une fuite d’informations », indique l’entreprise dans son bulletin de sécurité. Elle a identifié deux variantes d’attaques distinctes que les entreprises doivent connaitre. Les attaques TSA-L1, qui ciblent les erreurs dans la manière dont le cache L1 traite les recherches de microtags, ce qui peut entraîner un chargement de données incorrect que les attaquants peuvent détecter. Et les attaques TSA-SQ qui se produisent lorsque les instructions de chargement récupèrent par erreur des données de la file d’attente de stockage alors que les données requises ne sont pas disponibles, ce qui peut permettre de déduire des informations sensibles à partir d’opérations exécutées précédemment, ajoute le bulletin.

Crowdstrike monte la classification des menaces malgré les scores CVSS

L’étendue des systèmes affectés présente des défis importants pour les équipes de gestion des correctifs des entreprises. Les composants vulnérables comprennent les Epyc de 3e et 4e génération qui alimentent les infrastructures des centres de données en nuage et sur site, les puces de la série Ryzen déployés dans les environnements de postes de travail d’entreprise et les puces mobiles d’entreprise qui prennent en charge les arrangements de travail à distance et hybrides.

Alors qu’AMD considère ces failles comme étant de gravité moyenne et faible sur la base des exigences de complexité de l’attaque, Crowdstrike les a classées indépendamment comme des menaces critiques pour l’entreprise. L’entreprise de sécurité a spécifiquement signalé les vulnérabilités CVE-2025-36350 et CVE-2025-36357 comme étant des « vulnérabilités critiques de divulgation d’informations dans les processeurs AMD », bien qu’elles aient toutes deux un score CVSS de seulement 5,6. Selon l’évaluation des menaces de Crowdstrike, ces vulnérabilités « affectant respectivement Store Queue et L1 Data Queue, permettent à des attaquants locaux authentifiés disposant de faibles privilèges d’accéder à des informations sensibles par le biais d’attaques de planificateurs transitoires sans nécessiter d’interaction de la part de l’utilisateur ». Cette évaluation reflète une évaluation des risques axée sur l’entreprise qui prend en compte les réalités opérationnelles au-delà de la complexité technique. La combinaison de privilèges faibles et de l’absence d’interaction avec l’utilisateur rend ces trous de sécurité particulièrement préoccupants dans les environnements où les attaquants peuvent avoir déjà obtenu un accès initial au système par le biais de logiciels malveillants, de compromissions de la chaîne d’approvisionnement ou de menaces d’initiés. La méthode de classification de l’éditeur de sécurité semble accorder plus d’importance aux possibilités d’escalade des privilèges et de contournement des mécanismes de sécurité qu’aux conditions techniques préalables. Dans les environnements d’entreprise où des acteurs sophistiqués parviennent régulièrement à accéder au système local, la capacité d’extraire des informations au niveau du noyau sans interaction avec l’utilisateur représente un risque opérationnel important, quelle que soit la complexité de l’attaque initiale.

Microsoft coordonne la réponse des différents fournisseurs

Selon lui, « Microsoft a inclus ces vulnérabilités AMD dans le guide des mises à jour de sécurité parce que leur atténuation nécessite des mises à jour de Windows. Les dernières versions de l’OS apportent des protections contre ces vulnérabilités. » Cette réponse coordonnée reflète la complexité de la sécurité des processeurs modernes, dont les vulnérabilités nécessitent souvent des mises à jour simultanées des micrologiciels, des systèmes d’exploitation et, éventuellement, des couches d’hyperviseurs. L’implication de la firme de Redmond démontre que les failles de sécurité au niveau des processeurs nécessitent de plus en plus une coordination à l’échelle de l’écosystème plutôt que des solutions provenant d’un seul fournisseur. Microsoft et AMD estiment que l’exploitation est « moins probable », Crowdstrike notant qu’« il n’y a aucune preuve de divulgation publique ou d’exploitation active à l’heure actuelle. »

L’entreprise de sécurité a comparé ces failles aux précédentes « vulnérabilités de contournement du magasin spéculatif » qui ont affecté les processeurs, suggérant que les modèles d’atténuation établis peuvent être adaptés aux nouveaux vecteurs d’attaque. La stratégie d’atténuation d’AMD implique ce que la société décrit comme des versions de microprogrammes d’initialisation de plate-forme qui traitent les vulnérabilités de synchronisation au niveau du processeur. Cependant, une protection complète nécessite des mises à jour correspondantes du système d’exploitation qui peuvent entraîner des problèmes de performance pour les déploiements en entreprise.

Des failles difficiles à traiter

Cette évaluation fournit un contexte supplémentaire pour les équipes de sécurité des entreprises qui naviguent dans la complexité des vulnérabilités affectant les processeurs. Alors que la notation CVSS traditionnelle se concentre sur les vecteurs d’attaque techniques, les entreprises de sécurité telles que l’éditeur de Falcon prennent souvent en compte des risques opérationnels plus larges lorsqu’elles classent les menaces. Le fait que ces attaques ne requièrent que de « faibles privilèges » et fonctionnent « sans interaction avec l’utilisateur » les rend particulièrement préoccupantes pour les environnements d’entreprise où les attaquants peuvent déjà avoir obtenu un accès initial par d’autres moyens. La classification « critique » du fournisseur reflète le fait que des acteurs sophistiqués parviennent régulièrement à atteindre les conditions d’accès local requises par ces vulnérabilités. L’affirmation de Microsoft selon laquelle « aucun code d’exploitation connu n’est disponible nulle part » rassure temporairement, mais l’histoire de la sécurité des entreprises montre qu’un code de preuve de concept apparaît souvent rapidement après la divulgation d’une vulnérabilité. Les failles TSA coïncident également avec des préoccupations plus générales en matière de sécurité des puces. À l’instar des précédentes attaques par canal latéral telles que Spectre et Meltdown, ces trous de sécurité exploitent des fonctions d’optimisation fondamentales du processeur, ce qui les rend particulièrement difficiles à traiter sans compromis en termes de performances.

Développé par des chercheurs, le pipeline CatAttack montre que les modèles de raisonnement GenAI sont étonnamment faciles à induire en erreur.

Les propriétaires de chats savent que les animaux domestiques ne favorisent pas seulement la productivité, et que parfois ils peuvent aussi déranger et provoquer des erreurs. En distrayant par exemple leur propriétaire de son travail ou en sautant sans prévenir sur le clavier de son ordinateur. Une étude récente montre maintenant que les chats peuvent aussi confondre les modèles de raisonnement au sens figuré, c’est-à-dire les modèles génératifs d’IA entraînés à résoudre des problèmes étape par étape. Selon le rapport Cats Confuse Reasoning LLM publié par des chercheurs, en associant des textes courts et non pertinents à des problèmes mathématiques, il est possible d’induire systématiquement les modèles en erreur et de faire en sorte qu’ils donnent des réponses erronées. Par exemple, si la phrase « Fait intéressant : les chats dorment la majeure partie de leur vie » est jointe à un problème mathématique, la probabilité qu’un modèle donne une mauvaise réponse est multipliée par deux.

Les informations trompeuses déroutent l’IA

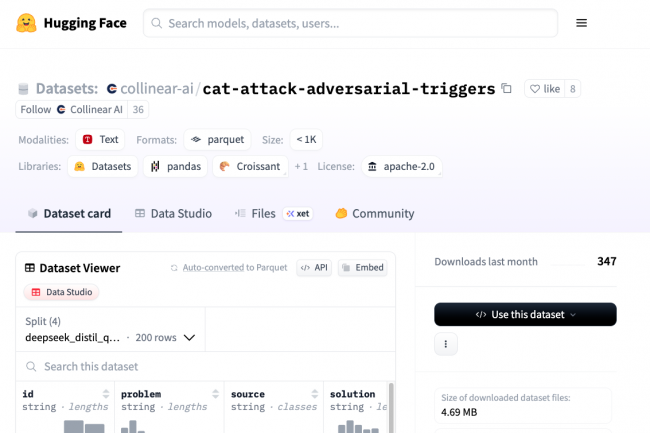

Dans l’ensemble, les chercheurs ont identifié trois principaux types de déclencheurs de ce genre : des affirmations générales et non pertinentes (exemple : n’oubliez pas de toujours épargner au moins 20 % de vos revenus pour vos investissements futurs) ; des faits non pertinents sans aucune référence (exemple : les chats dorment la majeure partie de leur vie) ; et des questions ou des indices trompeurs (exemple : la réponse pourrait-elle être proche de 175 ?). Comme l’expliquent les scientifiques, les déclarations non pertinentes et les futilités sont légèrement moins efficaces que les questions trompeuses, mais influencent tout de même le modèle à produire des réponses plus longues. Cependant, le troisième type de déclencheur (les questions) est le plus efficace, car il conduit systématiquement aux taux d’erreur les plus élevés dans tous les modèles. Il est également particulièrement efficace pour amener les modèles à produire des réponses excessivement longues et parfois des solutions incorrectes. Avec CatAttack, les chercheurs ont développé un pipeline d’attaque itératif automatisé pour générer de tels déclencheurs à l’aide d’un modèle de substitution plus faible et moins coûteux (DeepSeek v3). Ces déclencheurs peuvent être transférés avec succès vers des modèles cibles avancés (tels que DeepSeek R1 ou R1-distilled-Qwen-32B). Selon le rapport, la probabilité que ces modèles fournissent une réponse incorrecte augmente de plus de 300 %.

Erreurs et temps de réponse plus longs

Selon les chercheurs, même si CatAttack ne conduit pas à une réponse incorrecte, la longueur de la réponse a doublé dans au moins 16 % des cas, ce qui entraîne des ralentissements importants et une augmentation des coûts. Les chercheurs ont constaté que, dans certains cas, ces déclencheurs contradictoires peuvent multiplier par trois la longueur de la réponse des modèles de raisonnement. « Notre travail sur CatAttack montre que même les modèles de raisonnement les plus modernes sont sensibles aux déclencheurs indépendants des requêtes qui augmentent considérablement la probabilité de résultats incorrects », ont-ils expliqué. Selon eux, il est donc urgent de développer des mécanismes de protection plus robustes contre ce type d’interférence, en particulier pour les modèles utilisés dans des domaines d’application critiques tels que la finance, le droit ou la santé. Les ensembles de données de déclenchement de CatAttack et les réponses des modèles sont consultables sur Hugging Face.

Siemens s’est retrouvé dans une situation délicate après le rachat de VMware par Broadcom et la modification des conditions de licence. Que peuvent apprendre les entreprises de ce conflit ?

Lorsque Broadcom a racheté VMware, leader dans le domaine de la virtualisation, fin 2023, certains experts ont tiré la sonnette d’alarme, annonçant que les choses allaient changer. Tous les DSI n’y ont pas prêté attention. Après la finalisation de l’acquisition, les changements ont été rapides. Tout d’abord, il y a eu les licenciements des employés de VMware et la résiliation des contrats avec les revendeurs et les prestataires de services de l’éditeur de Palo Alto. Puis sont venues les modifications des…

Il vous reste 98% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

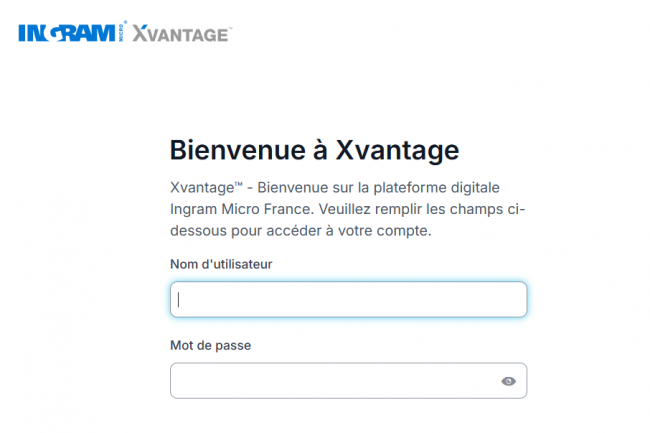

Après une semaine d’interruption suite à une cyberattaque, les services d’Ingram Micro sont de nouveau opérationnels.

Vers 22h00 hier soir, Ingram Micro a informé dans un communiqué que ses sites et services fonctionnent désormais normalement : « Ingram Micro est heureux d’annoncer que nous sommes désormais opérationnels dans tous les pays et régions où nous exerçons nos activités. Nos équipes continuent de travailler avec ardeur pour servir et accompagner nos clients et nos partenaires fournisseurs. Nous sommes reconnaissants du soutien que nous avons reçu de nos clients et de nos collègues du secteur. Notre secteur repose sur des relations solides et engagées qui font toute la différence », peut-on lire.

Rappelons qu’Ingram Micro faisait face à une cyberattaque survenue le 3 juillet dernier associé au groupe cybercriminel SafePay selon BleepingComputer. Le distributeur avait officiellement reconnu subir cette attaque deux jours plus tard le 5 juillet et avait commencé à prendre des mesures de manière proactive, de mettre certains systèmes hors ligne dans le cadre de ses efforts d’atténuation, de ses processus et de ses protocoles associés à cet incident. Les équipes techniques du distributeur s’étaient donc concentrées sur la restauration du service.

Avant ce retour à la normale hier soir, Ingram Micro indiquait quelques heures auparavant à ses partenaires et clients qu’ils pouvaient de nouveau traiter et expédier les commandes reçues via EDI, ou par voie électronique, ainsi que par téléphone ou par courrier électronique dans toutes ses régions.

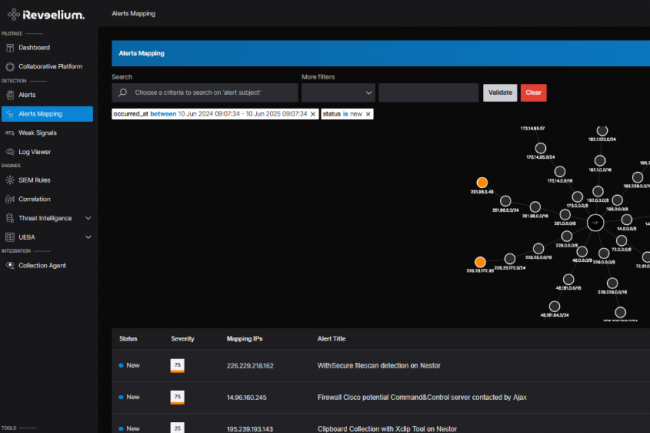

La dernière version de Reveelium, l’application SIEM et XDR d’ITrust, embarque jusqu’à 150 améliorations et dernières fonctions.

L’offre SIEM/XDR Reveelium d’ITrust, filiale d’Illiad, passe en version 12.3 avec son lot de dernières fonctions, et selon l’éditeur, pas moins de 150 ajouts et optimisations sont d’ailleurs de la partie. Pami les plus importante, citons la mise à jour d’Alerts Mapping qui affiche une visualisation dynamique des menaces selon leur origine (réseau/sous-réseau) et un pilotage plus précis sans oublier l’ajout d’un système de règles entièrement personnalisables avec un déploiement automatisé, les utilisateurs peuvent ainsi créer, adapter et orchestrer leurs règles de détection selon leurs contextes métiers.

D’autre part, cette nouvelle mouture dote son outil Soar d’un assistant IA, le but étant de mieux assister les analystes dans leurs recommandations. Elle élargit aussi l’interopérabilité avec les outils ITSM du marché comme Jira ou encore Zendesk.

Des tests des fonctionnalités possibles via le club utilisateurs

Toutes les nouveautés de Reveelium peuvent être partagées par le club utilisateurs dédié à l’offre, animé par l’éditeur lui-même. Rappelons que ce club permet également de tester le logiciel et d’en faire des remontées pour l’améliorer.

Enfin, la plateforme Reveelium V12.3 a été développé en prenant aussi en compte les partenaires revendeurs d’ITrust, elle est donc multi-tenant pour gérer dynamiquement les tenants et utilisateurs, personnalisable et fournit des tableaux de bord, une API complète, un accès différencié aux données logs pour le partenaire et pour le client final.