Selon la presse américaine, Apple et Google s’apprêtent à corriger une faille de sécurité présente depuis près de 20 ans dans leur navigateur. Un chercheur doit présenter cette vulnérabilité lors de la Def Con à Las Vegas.

Régulièrement de vieilles failles sont dénichées par des chercheurs. Celle trouvée par un expert de l’entreprise de cybersécurité Oglio est originale par sa longévité, 18 ans (les dernières traces du bug datent de 2006). Il va présenter sa trouvaille à l’occasion de la Def Con de Las Vegas. La faille touche les navigateurs Safari d’Apple, Chrome de Google et Firefox de Mozilla.

Elle concerne une adresse IP qui a une fonction particulière. Les terminaux connectés à Internet utilisent des adresses IP pour l’identification des terminaux et de leur emplacement, et l’adresse IP 0.0.0.0 est utilisée dans des circonstances spécifiques : elle sert généralement d’adresse de remplacement le temps que l’adresse IP réelle soit disponible.

Apple et Google en mode correctif, Mozilla en mode réflexion

Le spécialiste d’Oglio a découvert que des cybercriminels exploitent le traitement par Safari, Chrome et Firefox des requêtes à une adresse IP 0.0.0.0. Selon Forbes qui s’est fait l’écho de ce bug, les navigateurs envoient les requêtes « à d’autres adresses IP, y compris ‘localhost’, un serveur sur un réseau ou un ordinateur généralement privé et souvent utilisé pour tester du code en cours de développement ». Un cybercriminel peut envoyer une requête à cette adresse pour obtenir des données privées.

Apple a rapidement pris les devants en indiquant au quotidien américain que Safari dans macOS Sequoia bloquera tout site web tentant de contacter l’adresse IP 0.0.0.0. Le correctif étant basé sur Safari et non sur le système d’exploitation, il sera inclus dans Safari 18 lorsqu’il sera disponible pour les anciennes versions de macOS, dont Sonoma et Ventura. Google a publié un billet de blog expliquant qu’elle fera la même chose avec Chrome. Par contre Mozilla ne prévoit pas de bloquer les requêtes 0.0.0.0 dans son navigateur Mozilla, mais l’entreprise étudie la question, souligne Forbes.

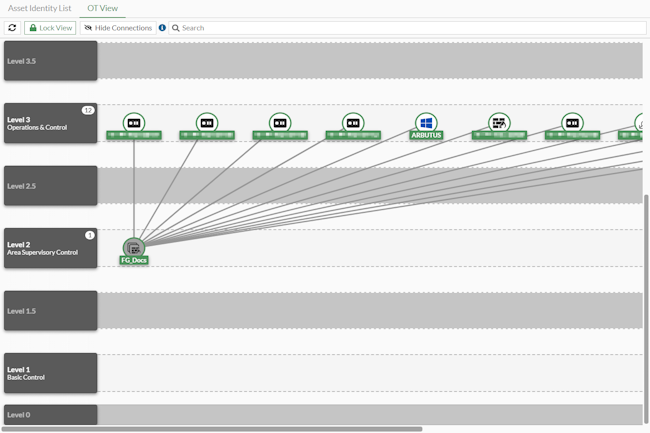

Fortinet améliore sa plateforme de sécurité OT Security Platform autour de l’identification des terminaux et des capacités de correction.

La protection des SI industriels est souvent considérée comme en retard. Pour y remédier, des fournisseurs proposent des plateformes dédiées à ce domaine et les améliorent régulièrement. C’est le cas de l’OT Security Platform de Fortinet destinées à protéger les systèmes de contrôle industriels et les infrastructures contre les cybermenaces. La plateforme offre une visibilité sur les réseaux OT, l’identification des vulnérabilités, des capacités de zero trust et une protection avancée contre les menaces. « À l’instar des réseaux IT, la sécurité des réseaux OT doit évoluer rapidement pour faire face aux nouvelles menaces et aux changements technologiques, en particulier la nécessité de connecter tous les équipements », a écrit John Maddison, directeur du marketing chez Fortinet, dans un blog sur ces fonctionnalités. « Traditionnellement, la sécurité OT repose sur l’obscurité, car tout est très compartimenté et rien n’est connecté à des systèmes externes. Mais, ces cinq dernières années, cette approche a beaucoup évolué pour rendre les environnements OT plus agiles et plus réactifs, et les risques se sont accrus », a-t-il ajouté.

Selon le rapport « 2024 Global State of Operational Technology and Cybersecurity Report » de Fortinet, les cyberattaques qui compromettent les systèmes OT sont en hausse. Parmi les entreprises interrogées pour ce rapport, 73% ont subi une intrusion qui a impacté soit les systèmes OT uniquement, soit les systèmes IT et OT, contre 49% en 2023. Pour aider les clients à faire face à ces risques, Fortinet a ajouté à l’écran de gestion du package FortiOS OT View, des vues améliorées de l’identification des actifs et de la topologie du réseau OT. Grâce à cette prise en charge, le système peut désormais voir et identifier les appareils connectés ainsi que les réseaux qui les relient.

Des fonctionnalités supplémentaires

Par ailleurs, le fournisseur a ajouté des signatures de correctifs virtuels dans FortiGuard OT Security Service, lequel offre une protection contre les vulnérabilités et un blindage des actifs OT non corrigés. « Il devient de plus en plus important de comprendre chaque dispositif OT, ce qu’il fait, comment il est connecté et avec quoi il peut communiquer », a déclaré M. Maddison. « Les dernières fonctionnalités applique une stratégie NAC et de microsegmentation plus efficace, mais aussi déploie des correctifs virtuels pour se protéger contre les vulnérabilités urgentes ».

Fortinet a également amélioré la visibilité des actifs OT à partir de sa plateforme FortiSOAR d’orchestration de la sécurité, d’automatisation et de réponse, afin d’aider les clients à gérer plus efficacement les ressources OT. L’amélioration de l’analytique et de l’analyse du comportement du réseau fait aussi partie des évolutions apportées à la plateforme. « Enfin, une option FortiDeceptor-as-a-Service étend les capacités de tromperie pour l’OT et l’IoT avec plus d’appareils et de protocoles, simplifiant ainsi les déploiements pour les utilisateurs », a ajouté M. Maddison. FortiDeceptor DaaS crée et déploie des systèmes de leurre qui imitent les ressources réelles au sein d’un réseau. En créant des ressources leurres qui attirent les attaquants, les clients peuvent identifier et analyser leur comportement sans compromettre les systèmes réels. La plateforme fournit des informations détaillées sur les activités des attaquants, ce qui aide les entreprises à concevoir des contre-mesures.

En avril dernier, environ 4 000 experts en cybersécurité ont participé à un exercice grandeur nature de l’OTAN, opposant Red Team et Blue Team défendant un pays fictif. Reportage au sein du Commandement interarmées du cyberespace espagnol, qui participait à ces grandes manoeuvres virtuelles.

L’île-pays de Berylia est menacée. Au cours des prochaines 48 heures, elle sera soumise sans interruption à un nombre infini de cyberattaques, qu’elle devra contenir au mieux. Bien que le pays soit préparé, le scénario est loin d’être idéal, car il est, en même temps, engagé dans un conflit ouvert avec la Crimsonie portant sur ses eaux territoriales, cette dernière ayant même osé envahir une partie de son territoire. Les activités hostiles sont désormais dirigées contre les services essentiels de Berylia connectés à Internet.Le 25 avril, vers 11 heures, à la base Retamares de Pozuelo de Alarcón (à Madrid), un exercice de l’OTAN, exceptionnellement ouvert à la presse, a permis de montrer comment ce pays fictif se prépare à protéger ses systèmes dans « un exercice sans précédent par son ampleur et ses caractéristiques », selon les termes d’Enrique Pérez de Tena, responsable des relations internationales, de la communication et des médias du Commandement interarmées du cyberespace espagnol (MCCE). Ce dernier fait référence à Locked Shields 2024, un test que le Centre d’excellence en coopération pour la cyberdéfense de l’OTAN (CCDCOE) effectue chaque année depuis 2010 et qu’il qualifie de « pratique de cyberdéfense à balles réelles la plus avancée au monde ».« Lorsque les gens en font l’expérience, ils ne veulent plus rien d’autre. Ils ont la possibilité de réaliser des activités auxquelles ils n’ont pas accès dans leur vie quotidienne », explique Enrique Pérez de Tena, alors que nous nous promenons dans la salle de contrôle. « C’est comme lorsqu’un avion de chasse lance des missiles. »Défendre les infrastructures critiquesDans cette édition de Locked Shields, explique le responsable, trois divisions ont été organisées, chacune devant défendre les 18 régions de Berylia qui sont attaquées par un autre groupe d’équipes situées à Tallinn, en Estonie, le lieu central de l’événement. Dans le cadre de l’exercice, chaque ville de l’île de Bérylia a sa propre équipe opérationnelle, et toutes ont les mêmes infrastructures critiques à défendre, allant des centrales nucléaires aux systèmes bancaires, en passant par les satellites et les centrales de distribution d’électricité. En bref, « tout ce qui peut intéresser les cybercriminels », selon Enrique Pérez de Tena.Ce test, connu dans les milieux de la cybersécurité, met donc classiquement aux prises une Red Team (les assaillants) et une Blue Team (les défenseurs). Cette année, près de 4 000 personnes y participent. L’équipe espagnole est composée d’environ 200 experts, dont 40 % de militaires du MCCE (terre, mer et air), appuyés par des soldats portugais, brésiliens et chiliens, et 60 % de civils, issus du MCCE lui-même et d’entreprises privées qui mettent leurs compétences à disposition pour ce type d’événements.A l’issue des deux jours, le CCDCOE établit un classement des plus de 40 pays participants, parmi lesquels figurent des pays non-membres de l’OTAN, comme le Japon. Cette année, l’Espagne s’est installée en milieu de peloton, tandis que la Lettonie et les tandems Finlande-Pologne et Estonie-France se sont distingués (ce dernier terminant à la 3ème place). Quel que soit le classement, le CCDCOE et le MCCE mettent tous deux l’accent sur la nature collaborative de l’exercice et ses vertus en termes d’apprentissage, plutôt que sur la compétition. « Cela nous aide aussi à mettre des visages face à telle ou telle situation. Savoir que quelqu’un est un grand spécialiste d’un outil ou d’un système donné. Ainsi, si j’ai tel problème, je sais que je peux compter sur lui ».Anticiper la communication de criseAu cours de notre reportage, nous sommes témoins de l’agitation et de la tension qui s’emparent parfois du centre de Retamares. Même si la visite des médias coïncide probablement avec une période au cours de laquelle l’intensité des incidents est moindre. Enrique Pérez de Tena nous présente une équipe, celle qu’il dirige lui-même : des experts en gestion de crise.

Enrique Pérez de Tena, responsable des relations internationales, de la communication et des médias du Commandement interarmées du cyberespace espagnol. (Photo : Juan Marquez)

« Imaginons que nous ayons devant nous des membres de la présidence du gouvernement ou d’autres ministères, dit-il pour cadrer la situation. Comment doivent-ils gérer, par exemple, une conférence de presse ? Nous gérons même une page web avec des simulations de réseaux sociaux dans lesquels des contenus sont postés, certains faux et d’autres réels. Notre travail consiste à tout comparer et à communiquer. »Dans la même salle, un groupe de professionnels de l’équipe juridique débat vivement. « Il y a même des professeurs de fiscalité, précise Enrique Pérez de Tena. En temps de guerre, les décisions doivent être prises en tenant compte de multiples aspects ». Ces participants donnent le feu vert à certaines actions en fonction des différentes conventions existantes, ajoute-t-il. « Est-ce conforme à la Convention de Genève ? Allez-y », dit-il à titre d’exemple.L’avantage des attaquantsNous nous dirigeons ensuite vers une grande tente enveloppée de silence. C’est le centre qui coordonne les communications et les aspects légaux avec les hackers. C’est là qu’ils reçoivent les informations sur tout ce qui se concocte. Enfin, direction le centre névralgique de l’exercice, où des « cracks » de la cybersécurité, que nous n’avons pas le droit de nommer, défendent les différentes régions de Berylia.« Les attaquants ont un avantage sur nous parce qu’ils ont eu le temps de se préparer », explique Enrique Pérez de Tena. « Pour nous, c’est comme si nous faisions notre travail quotidien. Et il n’y a pas de moment prédéfini pour lancer les incidents. Le cyberespace n’a pas de frontières, c’est un terrain de jeu pour tous ceux qui possèdent un appareil connecté. »Cet exercice est-il également une cible pour les cybercriminels ? « Bien sûr », dit Enrique Pérez de Tena. « Mais nous avons ici les meilleurs [défenseurs], en ce moment même. Si quelqu’un réussit à pénétrer nos systèmes, nous rentrerons tous chez nous et changerons de métier », plaisante-t-il.Evoluer dans la zone grise, entre guerre et paixCette fiction pourrait tout aussi bien se dérouler dans la réalité, nos pays se trouvant dans un état permanent de cyberguerre. « La couleur de notre casquette est grise parce que nous sommes constamment dans cette zone qui existe entre la guerre et la paix », explique Enrique Pérez de Tena. Quant à l’impact attendu de l’IA sur cette guerre larvée, le responsable ne pense pas qu’il sera plus déterminant que « tout autre développement technologique passé ». La guerre hybride a toujours existé et son principal problème aujourd’hui est l’attribution.« Face à la difficulté d’obtenir des preuves d’experts pour traduire une personne, une organisation ou un État devant la Cour internationale, les pays procèdent à des attributions politiques. Par exemple, un ministre des affaires étrangères dit : ‘Je sais que [cette attaque] provient de vous, et si vous continuez comme ça, je [riposterai]’ », explique Enrique Pérez de Tena.

Alors que Google reporte une fois encore son projet d’abandonner la technologie dans son navigateur Chrome, le Worldwide Web Consortium (W3C) estime que cette décision « n’est pas bonne pour le Web » et que cette technologie devrait être restreinte.

Décidément les cookies tiers continuent d’alimenter le débat avec la prise de position du W3C (Worldwide Web Consortium) sur la récente décision de Google de continuer le support de ces outils de tracking dans Chrome. L’organisme de normalisation estime que ce choix « n’est pas bon pour le web » et qu’il est néfaste pour les utilisateurs. Cette décision surprise, « sape une grande partie du travail que nous avons accompli ensemble pour que le web fonctionne sans cookies tiers », a écrit Hadley Berman, du Worldwide Web Consortium (W3C), dans un billet de blog. Le W3C est d’accord avec la définition actualisée des cookies du RFC (Request for comments), qui reconnaît qu’ils posent des « problèmes inhérents de protection de la vie privée ». En outre, le RFC recommande vivement que « les agents utilisateurs adoptent une politique pour les cookies tiers qui soit aussi restrictive que les contraintes de compatibilité le permettent ».

« Si les cookies tiers, installés par un site web autre que celui que l’utilisateur visite par le biais d’un contenu intégré comme des publicités, des widgets de médias sociaux ou des pixels de suivi, peuvent être utiles pour l’authentification sur plusieurs sites, ils permettent également de collecter des données cachées sur l’activité des utilisateurs sur Internet », a déclaré Hadley Berman. « Le suivi, la collecte de données et le courtage » par les cookies tiers exposent aussi à d’autres risques cachés, notamment le « micro-ciblage de messages politiques » qui nuisent à la société dans son ensemble », a-t-elle encore écrit.

Le « choix de l’utilisateur » prôné par Google

Au lieu de mettre fin au support des cookies tiers, Google a décidé de mettre à jour les règles de protection contre le suivi intersite de Chrome, dévoilées en décembre dernier, en ajoutant une option dans les paramètres du « Privacy Sandbox » de Chrome, un ensemble d’API préservant la vie privée. Avec cette option, les utilisateurs peuvent choisir soit de naviguer dans l’environnement « Privacy Sandbox » soit de maintenir les cookies intersites traditionnels. Les utilisateurs de Chrome peuvent aussi utiliser la fonction « Enhanced Ad Privacy » introduite l’année dernière dans la version 115 de Chrome qui permet, selon Google, de diffuser des publicités basées sur les centres d’intérêt sans suivre les utilisateurs individuels sur les sites web.

Depuis plusieurs années, le W3C travaille avec l’équipe Privacy Sandbox de Google sur les politiques relatives aux cookies tiers et a réalisé des « progrès substantiels », a estimé Mme Berman. « Le récent changement d’orientation de Google représente un grand pas en arrière dans cet effort », a-t-elle ajouté. « Ce regrettable recul aura également des effets secondaires, car il pourrait retarder les travaux inter-navigateurs sur des alternatives efficaces aux cookies tiers », a poursuivi la responsable. « Nous craignons que ce choix ait un impact négatif sur les efforts entrepris pour améliorer la protection de la vie privée sur le web », mais le W3C espère que Google « reviendra sur sa décision et s’engagera à nouveau sur la voie de la suppression des cookies tiers », a-t-elle ajouté. Google n’a pas répondu immédiatement aux demandes de commentaires adressées par nos confrères d’IDG.

Manque de leadership de Google

Les experts de la protection de la vie privée ont reconnu que si les cookies tiers posent des problèmes en matière de protection de la vie privée, de nombreuses parties prenantes doivent aussi être prises en compte. « Google a tenté à plusieurs reprises de remplacer les cookies […] afin de trouver un équilibre entre la protection de la vie privée des utilisateurs et les besoins des annonceurs », a déclaré Jason Soroko, vice-président senior des produits chez Sectigo, un fournisseur de gestion du cycle de vie des certificats. « Cependant, ces efforts se sont heurtés à la résistance des défenseurs de la vie privée, à des obstacles réglementaires et à des défis techniques », a-t-il expliqué, ajoutant que « l’interaction complexe entre l’innovation, les préoccupations en matière de protection de la vie privée et les cadres réglementaires a probablement contribué à la décision de Google de ne pas abandonner le support des cookies. »

Mais, le plus décevant encore, c’est que l’entreprise « ne semble toujours pas avoir de plan clair pour mettre en œuvre des contrôles de confidentialité et de sécurité plus importants contre le pistage », a estimé un expert en protection de la vie privée, qui pense que le géant de la recherche n’en fait pas assez. Google « se vante depuis longtemps de l’innovation suscitée par son initiative Privacy Sandbox, mais celle-ci n’a pas encore porté ses fruits publiquement », a déclaré Gal Ringel, cofondateur et directeur général de Mine, une société internationale de gestion de la confidentialité des données. En outre, compte tenu de la position de Google en tant qu’« entreprise la plus influente sur l’Internet aujourd’hui », le fait qu’elle n’ait pas pris de véritable position en matière de protection de la vie privée crée un mauvais précédent à un moment crucial où les États-Unis tentent d’adopter une nouvelle législation pour résoudre le problème », a-t-il regretté.

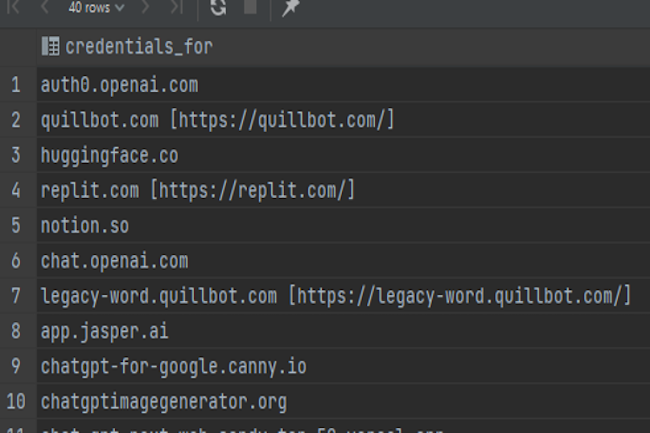

Des identifiants piratés pour accéder des comptes de ChatGPT, Quillbot, Notion, Huggingface et Replit sont devenus très recherchés sur le dark web. Une place de marché, nommée LLM Paradise s’est particulièrement fait remarquer.

De plus en plus de cybercriminels se servent de l’IA générative pour créer des campagnes de phishing ou de malware. Pour cela, ils ont besoin d’accéder aux différents modèles du marché avec des accès piratés. Face à cette demande, le dark web fourmille d’offres dans ce domaine en particulier sur les marchés clandestins russophones. Des chercheurs de la société eSentire ont indiqué « les noms d’utilisateur et les mots de passe d’environ 400 comptes GenAI sont vendus chaque jour par les pirates ». Ils ajoutent, « bon nombre de ces informations d’identification sont volées sur les ordinateurs des utilisateurs finaux quand ils sont infectés par un info stealer. Les logs ainsi récupérés, comprenant des identifiants de GenAI se vendent actuellement 10 dollars l’unité sur les marchés underground »

LLM Paradise, parmi les marchés les plus utilisés

Les chercheurs ont indiqué que LLM Paradise était l’un des marchés clandestins les plus importants à faciliter l’échange d’identifiants GenAI. Les propriétaires qui dirigent ce marché sont particulièrement doués pour le marketing. Dans cette plateforme, ils font la promotion des clés d’API GPT-4 et Claude volées avec des bandeaux affirmant que sa place de marché était la seule à proposer « des clés d’API GPT-4 et Claude » et « à des prix imbattables », ont déclaré les chercheurs.

Les cybercriminels « ont fait de la publicité pour des clés API GPT-4 ou Claude à partir de 15 dollars chacune, alors que les prix habituels pour divers modèles OpenAI se situent entre 5 et 30 dollars par million de jetons utilisés », ont ajouté les experts. Pour des raisons inconnues, LLM Paradise a cessé son activité et la boutique a récemment fermé. Cependant, les pirates ont contourné l’obstacle et continuent de diffuser sur TikTok des publicités pour des clés API GPT-4 volées, proposées avant la fermeture de la place de marché. Outre les API GPT-4 et Claude, d’autres identifiants notamment ceux de Quillbot, Notion, Huggingface et Replit ont été mis en vente sur des places de marché similaires à LLM Paradise.

Des identifiants utilisables pour le phishing, les malwares et les intrusions

Selon les chercheurs d’eSentire, les identifiants volés ont une plus grande valeur entre les mains des cybercriminels en raison de leurs possibilités d’exploitation multiples. « Ils utilisent des plateformes d’IA populaires pour créer des campagnes de phishing convaincantes, développer des logiciels malveillants sophistiqués et produire des chatbots pour leurs forums clandestins », ont-ils expliqué. En outre, ces identifiants peuvent servir à accéder aux comptes genAI d’une entreprise, et ensuite aux informations personnelles et financières des clients, à la propriété intellectuelle exclusive et aux informations personnellement identifiables. Les identifiants piratés peuvent aussi ouvrir l’accès à des données réservées aux entreprises clientes, ce qui affecte également les fournisseurs de plateformes d’IA générative.

Avec plus de 200 identifiants mis en vente chaque jour, la plateforme OpenAI est probablement la plus touchée par le phénomène. Plusieurs mesures sont à la disposition des entreprises pour se défendre contre les attaques ciblant la GenAI, en mettant par exemple en place une surveillance régulière de l’utilisation de la GenAI par les employés, par la mise en œuvre par les fournisseurs de modèles de WebAuthn avec des options MFA, ou encore en incluant de meilleures pratiques en matière de clé d’accès ou de mot de passe pour l’authentification de l’IA générative et en utilisant des services de surveillance du dark web pour identifier les informations d’identification volées.

Le règlement de l’UE visant à renforcer la résilience des organisations financières aux cyberattaques s’appliquera à partir du 17 janvier 2025. Il incombe aux RSSI de s’assurer que leurs organisations sont en conformité avec le nouveau règlement.

Le secteur financier figure parmi les cibles préférées des cybercriminels. Selon le Fonds monétaire international, près d’un cinquième des cyberattaques récentes visaient des entreprises financières, les banques étant les plus ciblées. Pour aider les institutions financières à résister à ces menaces, l’UE a introduit la loi sur la résilience opérationnelle numérique (Digital Operational Resilience Act ou Dora), qui s’appliquera à partir du 17 janvier 2025.Dora vise à renforcer la sécurité des entités financières, traditionnelles ou non, notamment les banques, les entreprises d’investissement, les établissements de crédit, les cabinets d’audit, les agences de notation, ainsi que les fournisseurs de services de crypto-actifs et les plateformes de financement participatif (crowdfunding). Par extension, le règlement s’applique aux fournisseurs de services tiers qui travaillent avec ces entités financières, comme les opérateurs de datacenters et les fournisseurs de cloud.Explorons DoraEn termes simples, cette réglementation a deux objectifs : offrir un cadre complet pour la gestion des risques dans le secteur financier et harmoniser les réglementations en matière de gestion des risques dans l’ensemble de l’UE, car les règles applicables aux organisations financières varient d’un pays à l’autre. L’harmonisation est l’une des plus grandes réussites de Dora, qui « va simplifier les choses pour tout le monde à long terme », estime Joel Brandon, responsable des ventes pour la région EMEA chez ProcessUnity, éditeur spécialiste de la gestion des risques et de la conformité.La législation donne aux entités financières la possibilité de se mettre l’accent sur le renforcement de leur résilience face aux cyber-menaces, ajoute-t-il. Elle encouragera les organisations à améliorer leur posture de sécurité globale et à favoriser la collaboration. « Ce que nous apprécions vraiment dans Dora, c’est l’opportunité qu’elle offre aux entités concernées de se concentrer sur les perturbations des TIC et l’impact qu’elles pourraient avoir non seulement sur leurs propres activités, mais aussi sur l’écosystème plus large dans lequel elles opèrent », analyse Joel Brandon.Toutefois, se conformer au texte d’ici à janvier 2025 est tout sauf une sinécure, et le calendrier apparaît difficile à respecter pour de nombreux RSSI. Si beaucoup ont fait des efforts pour se préparer, il reste encore beaucoup de travail à accomplir. Une petite enquête de McKinsey, réalisée en mars 2024, a révélé que cinq des 16 cadres et responsables de programmes interrogés doutaient de pouvoir respecter le délai fixé par Dora, et que seuls cinq d’entre eux étaient confiants dans leur capacité à se conformer au règlement dans les temps.Des exigences dans 4 domainesEn plus d’intensifier leurs efforts, les entités financières doivent donc définir leurs priorités. « De nombreuses entreprises ne réalisent pas à quel point la conformité à Dora peut être complexe, d’autant plus que le texte implique la collaboration d’un grand nombre de parties différentes de l’organisation, reprend Joel Brandon. Nous constatons que nos clients sous-estiment souvent les ressources et le temps nécessaires, notamment pour la gestion des risques liés aux tiers et la mise en place de systèmes efficaces de signalement des incidents. »Le texte sur la résilience opérationnelle numérique fixe des exigences dans quatre domaines clés : la gestion des risques, la réponse aux incidents, les tests de résilience opérationnelle et la gestion des risques liés aux tiers. En outre, il encourage les entités financières à partager les informations relatives aux cybermenaces, même si cet aspect n’a pas de caractère obligatoire.La première des exigences, la gestion des risques et la gouvernance, fait reposer la responsabilité sur les épaules de l’organe de direction. Il stipule que les membres du conseil d’administration, les dirigeants exécutifs et les cadres supérieurs doivent définir des stratégies solides de gestion des risques et s’assurer de leur mise en oeuvre. En outre, Dora exige que tous les décideurs se tiennent au courant des derniers risques cyber. En cas de non-respect de ces obligations, les membres du conseil d’administration et les dirigeants peuvent être tenus personnellement responsables.Répertorier et classifier les incidentsDans ce contexte, le rôle des RSSI, qui consiste à fournir aux parties prenantes des informations sur les tendances en matière de sécurité, devient de plus en plus important. Ils doivent offrir des informations claires à des publics non techniques et s’assurer que tout le monde comprend les risques encourus. A la fois un défi, mais aussi une opportunité de faire prendre conscience de l’importance de leur rôle dans l’organisation. « Une fois que les membres du conseil d’administration et les autres dirigeants seront tenus pour responsables, ils prendront la sécurité plus au sérieux », explique Sagie Dulce, vice-président de la recherche chez Zero Networks, spécialiste de la protection des réseaux.La règlementation exige également que les entités financières « identifient, suivent, enregistrent, catégorisent et classent les incidents liés aux TIC en fonction de leur priorité et de leur gravité et en fonction de la criticité des services touchés », peut-on lire dans le document. L’impact d’un incident est déterminé sur la base de plusieurs critères, dont le nombre et l’importance des clients affectés, la durée de l’incident, son étendue géographique, les pertes potentielles de données, la criticité des services affectés et, enfin, les coûts et pertes directs et indirects.Trois natures de notifications d’incidentsLorsque des incidents critiques se produisent, les organisations doivent, par ailleurs, en informer les autorités compétentes. Trois notifications sont prévues : une initiale qui reconnaît l’incident, un rapport intermédiaire suivi de notifications mises à jour chaque fois que de nouvelles informations sont disponibles pour expliquer comment l’incident est géré, et un rapport final qui examine la cause de l’incident, son impact réel et les mesures d’atténuation prises par l’organisation.Un autre aspect essentiel du texte réside dans l’obligation de tester régulièrement les systèmes. Les évaluations de vulnérabilité et les tests basés sur des scénarios d’incidents doivent être effectués une fois par an, tandis que les tests de pénétration basés sur des menaces peuvent, eux, être réalisés tous les trois ans.Dora s’attaque aux risques liés aux tiersMais ce qui est remarquable dans ce texte, c’est qu’il ne s’applique pas seulement aux entités financières, mais également aux fournisseurs de services tiers. Or, selon l’enquête de McKinsey, la gestion des risques liés aux tiers est l’un des domaines dans lesquels les organisations financières éprouvent le plus de difficultés. Plus de la moitié des cadres et des responsables de programmes interrogés dans le cadre de cette étude ont déclaré qu’il s’agissait de l’un des éléments de Dora les plus complexes à mettre en oeuvre. Le RSSI joue un rôle clé à cet égard, car il aide les employés à évaluer les cybermenaces de la supply chain IT et veille à ce qu’ils comprennent les conséquences d’un engagement avec tel partenaire sur la sécurité de l’information.Les entités financières qui n’ont pas de programme dédié aux risques liés aux tiers devront en mettre un en place. « Nous allons assister à une surveillance beaucoup plus stricte et à moins de vérifications préalables basées sur une liste d’exigences à cocher. Et cette attention s’étendra tout au long du cycle de vie d’un contrat, dit Joel Brandon. Nous nous attendons à ce que l’accent soit mis davantage sur les clauses de sécurité, les droits d’audit, les mécanismes de reporting, ainsi que sur des clauses de résiliation strictes, permettant aux organisations de mettre fin plus facilement à des relations contractuelles en cas d’incidents. »Priorités absolues à l’approche de janvier 2025Dora commençant à s’appliquer dans six mois seulement, les organisations qui opèrent dans le secteur financier doivent accélérer leurs efforts, et les RSSI doivent s’assurer qu’ils mettent en oeuvre toutes les politiques de sécurité requises par la loi. « Six mois, c’est un délai très court », observe Wayne Scott, responsable des solutions de conformité réglementaire chez Escode, une entité du groupe NCC spécialisée dans la sécurisation des codes source. Dans l’idéal, les entités réglementées devraient avoir déjà effectué un grand nombre de tests de scénario d’incidents, avec un pourcentage élevé de tests réussis ».Les RSSI travaillant pour des petites ou moyennes entreprises, qui n’ont pas suffisamment investi dans la cybersécurité, seront confrontés à de nombreux défis. Selon Wayne Scott, un bon point de départ consiste à effectuer une analyse d’écarts afin de déterminer dans quels domaines les contrôles existants répondent aux exigences de Dora et dans quels domaines il faut investir. L’échéance approchant à grands pas, il n’est pas réaliste de viser une conformité à toutes les obligations dans les délais impartis ; mieux vaut commencer par se concentrer sur les plus critiques.Bien entendu, à ce stade, la cartographie de l’environnement est cruciale. Les organisations doivent « s’assurer qu’elles peuvent répondre aux questions fondamentales, comme savoir qui a accès à quoi, que l’on parle des collaborateurs en interne ou des tiers, dit Sagie Dulce. Elles doivent effectuer des tests de pénétration complets et disposer d’une certaine forme de journalisation et de surveillance. »Rapatrier ou externaliser en cas de panneLes RSSI doivent également se pencher sur les systèmes existants qui pourraient avoir besoin d’être mis à niveau pour répondre aux exigences du texte. Cette mise à niveau peut s’avérer difficile et coûteuse à ce stade, mais elle permettra théoriquement à l’organisation d’être plus sûre à long terme.Les entités financières doivent également affiner leurs plans de sortie de crise. Selon Dora, les plans de sortie doivent être complets, « suffisamment testés et révisés périodiquement ». « Ces plans doivent être testés de succès, ils doivent montrer clairement que l’entité réglementée peut rapatrier la gestion d’un service défaillant en interne [si ce service est externalisé, NDLR] ou, à l’inverse, en confier la gestion à un tiers, ajoute Wayne Scott. Il faut également établir clairement si des solutions de dépôt de code entièrement testées ont été mises en place. »Dora ne cite pas directement le dépôt de code auprès d’un tiers neutre (les solutions dites escrow) comme une composante des plans de sortie de crise. « Dora est agnostique sur le plan technologique et ne peut citer aucune solution, reconnaît Wayne Scott. Mais il y a une raison évidente pour laquelle des organismes comme la PRA, l’OCC, la RBI et le MAS citent tous le séquestre de code : cette solution fonctionne. »Conformité et technique avancent de concertQuelles que soient les priorités fixées par une organisation, une équipe pluridisciplinaire au sein de laquelle le personnel technique joue un rôle central, doit être mise en place et les RSSI devraient plaider en ce sens. Car, ainsi, les mesures de conformité et de sécurité ont une bonne chance d’avancer de concert. Selon Beltug, la plus grande association belge de DSI et de responsables des technologies, se concentrer uniquement sur une approche descendante de la conformité, sans impliquer le personnel technique, pourrait créer des problèmes à terme.Selon Joel Brandon, une fois que l’on aura « bien compris le champ d’application de Dora, il sera plus facile de constituer une équipe interne composée des services concernés, tels que la sécurité informatique, la conformité, les approvisionnements et le service juridique ».Les erreurs à éviterLes RSSI doivent également être attentifs aux pièges les plus courants. La plus grosse erreur qu’ils pourraient commettre est peut-être « d’aller trop lentement, de rendre les choses plus compliquées qu’elles ne le sont et de ne pas prendre de conseils extérieurs », selon Rois Ni Thuama, expert en cyber-gouvernance et en conformité aux risques. Joel Brandon, de ProcessUnity, ne dit pas autre chose : « l’erreur principale est de s’attaquer aux sujets trop tard ou de délibérer trop longtemps sur les mesures à prendre ».Les RSSI doivent également être conscients des chevauchements entre Dora et d’autres exigences. Une erreur fréquente consiste à penser que le texte sur la résilience couvre entièrement la directive NIS2, ce qui est faux. « La directive NIS2 est prioritaire dans les domaines où Dora ne contient pas d’exigences spécifiques », indique ainsi Beltug. Les États membres de l’UE doivent adopter la directive NIS2 avant le 17 octobre de cette année.Les organisations financières ont également tendance à sous-estimer certains risques : la défaillance des fournisseurs, la détérioration des services et le risque de concentration. Wayne Scott estime que les accords de licence devraient être modifiés pour inclure des exigences relatives aux plans de sortie en urgence d’un fournisseur. Toutefois, cela pourrait s’avérer difficile à réaliser étant donné l’échéance qui approche. « Les négociations contractuelles prennent du temps, conclure ces négociations dans le timing prévu risque d’être difficile », reconnaît-il.L’impact mondial de DoraLe Digital Operational Resilience Act devrait être un texte marquant tant au sein de l’Union européenne qu’à l’échelle mondiale. Si elle s’avère efficace, la réglementation pourrait être reproduite dans d’autres parties du monde, ce qui permettrait aux banques et aux autres entreprises financières d’être mieux préparées aux incidents liés à la technologie.« Les régulateurs américains ont clairement indiqué leur penchant pour Dora et ont fortement laissé entendre que les États-Unis peuvent s’attendre à des discussions réglementaires similaires dans un avenir assez proche », dit ainsi Wayne Scott. Joel Brandon juge que Dora pourrait, en fin de compte, rendre le secteur financier mondial plus sûr, en empêchant les entités financières de perdre de l’argent à la suite d’incidents liés à la technologie. « Il s’agit de mettre en place un ensemble de règles unifiées pour tous les pays, ce qui devrait permettre de mieux gérer les risques liés aux services technologiques externes », résume-t-ilEt Dora pourrait même avoir un impact sur d’autres secteurs. « Ces changements réglementaires devraient s’étendre en dehors des services financiers, principalement aux secteurs de l’énergie et des communications », pense Wayne Scott. Au fur et à mesure que les effets d’entraînement de Dora deviennent plus évidents, il pourrait être utile pour d’autres secteurs de se préparer à des changements réglementaires similaires. Comme le dit Rois Ni Thuama, « Dora n’est que le début de changements indispensables ».

Le NIST a publié un outil nommé Dioptra à destination des développeurs pour déterminer l’exposition des modèles d’IA à des attaques. L’organisme présente aussi des lignes directrices sur la protection de la GenAI.

La sécurité des systèmes d’IA devient de plus en plus importante au fur et à mesure de leur déploiement. Dans ce cadre, le NIST (National Institute of Standards and Technology) du ministère américain du Commerce apporte sa pierre à l’édifice en présentant un outil open source nommé Dioptra et de la documentation. « Tester les effets des attaques adverses sur les modèles d’apprentissage machine est l’un des objectifs de Dioptra », a déclaré le NIST dans un communiqué, ajoutant que « ce logiciel était destiné à aider les développeurs d’IA et les clients à savoir comment leur application d’IA pouvait résister à différentes attaques ». La solution, téléchargeable gratuitement, « peut aussi aider les développeurs de systèmes d’IA à quantifier la perte de performance d’un modèle et savoir ainsi à quelle fréquence et dans quelles circonstances le système échouerait », a expliqué l’organisme. La publication de Dioptra répond au décret adopté en 2023 par le président Biden, qui demandait au NIST d’apporter son aide dans les tests de modèles.

Outre cette solution et conformément au décret, le NIST a également publié plusieurs documents visant à promouvoir la sécurité et les normes de l’IA. L’un de ces documents, intitulé « Managing Misuse Risk for Dual-Use Foundation Models » est la première version publique des lignes directrices pour le développement de modèles de fondation. Le document décrit les pratiques que les développeurs peuvent adopter lors de la conception et de l’élaboration de leur modèle afin d’éviter qu’il ne soit utilisé à mauvais escient pour nuire délibérément à des personnes, à la sécurité publique et à la sécurité nationale. Le projet propose sept approches clés pour atténuer les risques d’utilisation abusive des modèles, ainsi que des recommandations sur la manière de les mettre en œuvre et de faire preuve de transparence à ce sujet. « Ensemble, ces pratiques peuvent contribuer à empêcher les modèles de nuire via des activités comme le développement d’armes biologiques, la réalisation d’opérations cybernétiques offensives et la production de matériel pédopornographique et d’images intimes sans consentement », a déclaré le NIST, ajoutant qu’il acceptait les commentaires sur le projet jusqu’au 9 septembre.

Des annexes sur la sécurité de l’IA générative

Les autres publications comprennent deux directives du NIST appelées respectivement « AI Risk Management Framework (AI RMF) » et Secure Software Development Framework (SSDF), qui serviront de ressources complémentaires pour la gestion des risques de l’IA et le développement de logiciels sécurisés et dont l’objectif est d’aider les développeurs à gérer les risques de l’IA générative. L’un des deux documents, intitulé AI RMF Generative AI Profile, fournit une liste de 12 risques provisoires liés à l’IA générative et propose aux développeurs près de 200 mesures pour les gérer. Parmi ces risques figurent un accès plus facile à la mise en œuvre d’attaques de cybersécurité, la production de fausses informations et de désinformation, de discours haineux et autres contenus nuisibles, et les hallucinations des systèmes d’IA générative. « La seconde directive, intitulée Secure Software Development Practices for Generative AI and Dual-Use Foundation Models, est complémentaire de la directive Secure Software Development Framework (SSDF) », a indiqué l’organisme. « Alors que le SSDF s’intéresse de manière générale aux pratiques de codage des logiciels, le document d’accompagnement élargit le SSDF en partie pour traiter la question d’un modèle compromis par des données d’entraînement malveillantes qui affectent négativement les performances du système d’IA », a expliqué le NIST.

Dans le cadre de son plan visant à garantir la sécurité de l’IA, le NIST a aussi proposé une initiative distincte qui autorise les parties prenantes américaines de collaborer avec d’autres pays à l’élaboration de normes en matière d’IA. En novembre de l’année dernière, la Chine et les États-Unis ont convenu de collaborer avec au moins 25 autres pays pour atténuer les risques liés à la progression de l’IA. Les deux pays, ainsi que plusieurs autres, dont l’UE, l’Inde, l’Allemagne et la France, ont signé, en novembre 2023, un accord, baptisé « Déclaration de Bletchley », lors du sommet sur la sécurité de l’IA « UK AI Safety Summit », afin de définir une ligne de conduite commune pour superviser l’évolution de l’IA et veiller à ce que la technologie progresse en toute sécurité.

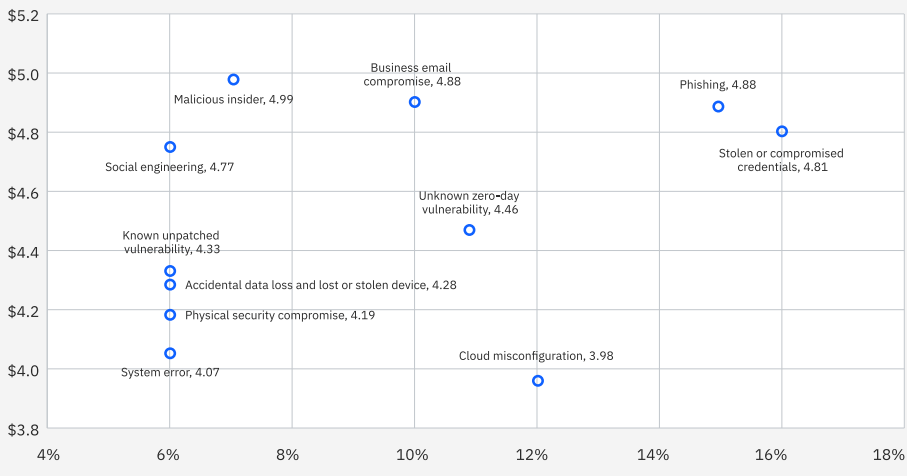

Dans un dernier rapport, IBM pointe un un coût moyen par violation de données en progression de 9 % à 4,88 M$ contre 4,45 M$ il y a un an. En France la hausse se limite à 3 % avec un coût moyen de 3,85 M€ qui atteint 5,19 M€ dans le secteur pharmaceutique.

Il n’y a pas que l’inflation qui a progressé, le coût moyen mondial d’une violation de données aussi. Selon le Cost of a Data Breach Report 2024 d’IBM, il a même atteint un niveau record de 4,88 M$, en augmentation de 9 % par rapport à 2023, signant la plus forte progression depuis la pandémie. Cette 19e étude de big blue (réalisée par Ponemon Institute) analyse les violations de données réelles subies par 604 entreprises dans le monde entre mars 2023 et février 2024. Elle a identifié les principaux problèmes qui ont eu un impact direct sur l’augmentation des coûts des violations, notamment la croissance des ressources hautement distribuées sur site, dans les cloud privés et publics, ainsi que la pénurie de personnel de sécurité. IBM a constaté que les coûts liés à la perte d’activité et à la réaction après une violation ont augmenté de manière significative ; ces coûts, pris ensemble, ont représenté 2,8 M$ sur les 4,88 M$ que coûte en moyenne une violation.

La France, terre de violation de données…

Des extraits de données ont par ailleurs été communiqués par IBM pour la France avec 36 entreprises interrogées pour l’occasion. On y apprend que le coût moyen d’une violation de données dans l’Hexagone a atteint 3,85 M€, en progression de “seulement” 3 % sur un an. Les secteurs qui ont connu les coûts moyens de violation de données les plus élevés sont les suivants : industrie pharmaceutique (5,19 M€), services financiers (4,79 M€), technologies (4,73 M€). Le coût moyen et la fréquence des violations de données par vecteur d’attaque initial sont les suivants : informations d’identification volées ou compromises (14 % des incidents ; coût moyen de 3,35 M€), mauvaise configuration cloud (14 % des incidents ; coût moyen de 3,57 M€), vulnérabilité inconnue aka zero day (12 % des incidents ; coût moyen de 3,97 M€), phishing (11 % des incidents ; coût moyen de 3,86 M€), et compromission de sécurité (9 % des incidents ; coût moyen de 4,23 M€). En France, il faut par ailleurs en moyenne 218 jours pour identifier une violation et 76 jours pour la contenir, soit une augmentation respectivement de 8 et 4 jours par rapport à 2023.

“70 % des entreprises françaises étudiées déploient désormais l’IA et l’automatisation de la sécurité pour prévenir et combattre les violations. Une société qui a eu largement recours à l’IA et à l’automatisation de la sécurité a détecté et contenu un incident 97 jours plus rapidement et a encouru en moyenne 1,83 million d’€ de moins en coûts de violation, par rapport aux organisations qui n’utilisent pas ces technologies – la plus grande économie de coûts révélée dans le rapport 2024”, indique IBM. Enfin, on retiendra (toujours en France) que 33 % des violations de données étudiées concernaient des données stockées dans plusieurs environnements (clouds publics et privés, on premise) pour un coût moyen de 4,22 M€.

… au coût moyen moins élevé qu’ailleurs

Pour la 14e année, les États-Unis ont cependant enregistré le coût moyen d’une violation de données le plus élevé (9,36 M$) parmi les 16 pays et régions étudiés. Le Moyen-Orient, l’Allemagne, l’Italie et le Benelux complètent le top 5. Les chercheurs précisent que le Canada et le Japon ont vu leurs coûts moyens baisser, tandis que l’Italie et le Moyen-Orient ont connu des augmentations significatives. « Ces violations multi-environnements ont coûté plus de 5 M$ en moyenne et ont été les plus longues à identifier et à contenir (283 jours), soulignant le défi que représentent le suivi et la sauvegarde des données, y compris celles circulant sous le radar (shadow data) et dans les charges de travail d’IA, qui peuvent être non chiffrées », a écrit John Zorabedian, responsable de la stratégie des contenus sécurité d’IBM, dans un billet blog relatif aux résultats de l’étude. « Les types d’enregistrements de données volés dans ces brèches ont souligné l’importance croissante de la protection des données les plus sensibles d’une organisation, y compris les données d’identification personnelle des clients (PII), les informations d’identification des employés et la propriété intellectuelle (IP). Les coûts associés aux données d’identification personnelle des clients et des employés étaient en moyenne les plus élevés », a fait savoir John Zorabedian. Les PII des clients ont été impliquées dans un plus grand nombre de violations que tout autre type d’enregistrement (46 % des violations). Les IP pourraient devenir encore plus accessibles au fur et à mesure que les initiatives de GenAI font apparaître ces données au grand jour. Les données critiques devenant plus dynamiques et disponibles dans tous les environnements, les entreprises devront alors être amenées à évaluer les risques spécifiques de chaque type de données et leurs contrôles de sécurité et d’accès applicables selon John Zorabedian.

Coût et fréquence des brèches de données par vecteur d’attaque initial. (crédit : IBM)

Une étude récente de Cisco a confirmé les résultats d’IBM et a révélé que 92 % des entreprises avaient déployé au moins deux fournisseurs de cloud public pour héberger leurs workloads et que 34 % en utilisaient plus de quatre, selon un rapport de 2023. « Cependant, chaque fournisseur de services de cloud public, datacenter privé et environnement cloud hybride utilise des modèles opérationnels de réseau et de sécurité différents. Les sociétés doivent aborder la complexité de gestion qui en résulte avec une stratégie qui permet une meilleure visibilité et un contrôle plus cohérent de la connectivité et de la sécurité à travers des environnements de cloud privé et public disparates », selon Cisco. D’ici deux ans, 60 % des entreprises s’attendent à disposer d’une plateforme intégrée de gestion de réseau et de sécurité multicloud avec des API communes pour sécurser le déplacement des charges de travail, la visibilité du réseau et des applications, et la gestion des politiques, a déclaré Cisco.

Des pénuries de ressources SSI qui pèsent

Quant aux pénuries de personnel, le problème ne cesse de s’aggraver, indique John Zorabedian : « 53 % des entreprises sont confrontées à une pénurie de compétences de haut niveau, soit 26 % de plus qu’en 2023. La pénurie de compétences à l’échelle du secteur pourrait coûter cher aux entreprises. Celles qui souffrent d’une grave pénurie de personnel ont subi des coûts de violation supérieurs d’1,76 M$ en moyenne par rapport à celles qui n’ont pas ou peu de problèmes de dotation en personnel de sécurité. » Dans le même temps, ces pénuries pourraient s’atténuer, car les entreprises ont indiqué qu’elles avaient l’intention d’augmenter leurs investissements en matière de sécurité à la suite de la violation. Selon le rapport, les firmes prévoient d’investir notamment dans des outils de détection et de réponse aux menaces tels que SIEM, SOAR et EDR. Elles prévoient en outre d’augmenter leurs investissements en gestion des identités et des accès et protection des données.

La pénurie de personnel pourrait toutefois inciter les grands organismes à se tourner vers l’IA et l’automatisation de la sécurité pour les aider et réduire les coûts des violations, poursuit John Zorabedian. « Davantage d’entreprises adoptent l’IA et l’automatisation dans leurs opérations de sécurité, en hausse de 10% par rapport au rapport 2023. Et le plus prometteur, c’est que l’utilisation de l’IA dans les workloads de prévention a eu l’impact le plus élevé dans l’étude, réduisant le coût moyen d’une violation de 2,2 M$, par rapport aux entreprises qui n’ont pas déployé l’IA dans la prévention […] Deux entreprises sur trois dans l’étude ont déployé des technologies d’IA et d’automatisation dans l’ensemble de leur centre de sécurité opérationnelle », fait savoir John Zorabedian. « Ce facteur peut également avoir contribué à la diminution globale des temps de réponse moyens – ceux qui utilisent l’IA et l’automatisation ont vu leur temps d’identification et de confinement d’une violation réduit de près de 100 jours en moyenne. » Seules 20 % des organisations ont déclaré utiliser des outils de sécurité GenAI, mais celles qui l’ont fait ont constaté un impact positif. Selon John Zorabedian, ces derniers ont permis de réduire le coût moyen d’une violation de plus de 167 000 $.

D’autres indicateurs pertinents à considérer

– Les informations d’identification volées sont en tête des vecteurs d’attaque initiale : le vol ou la compromission d’informations d’identification est le vecteur d’attaque initial le plus courant (16 %). C’est également dans ce cas qu’il a fallu le plus de temps pour identifier et contenir la faille, soit près de 10 mois ;

– De tous les vecteurs d’attaque, c’est celui dont les informations d’identification ont été volées ou compromises qui a été le plus long à identifier et à contenir (292 jours). Les attaques similaires qui consistaient à tirer profit des employés et de leur accès ont également pris beaucoup de temps à résoudre. Par exemple, les attaques par hameçonnage ont duré en moyenne 261 jours, tandis que celles par ingénierie sociale ont nécessité en moyenne 257 jours ;

– Par rapport aux autres vecteurs, les attaques malveillantes internes ont engendré les coûts les plus élevés, avec une moyenne de 4,99 M$. Parmi les autres axes d’attaque coûteux figurent la compromission de la messagerie électronique, le phishing, l’ingénierie sociale et le vol ou exposition d’informations d’identification ;

– Deux tiers des entreprises victimes d’attaques par ransomware et qui ont fait appel aux forces de l’ordre n’ont pas payé la rançon. Ces entreprises ont également réduit le coût de l’attaque de près d’1 M$ en moyenne, si l’on exclut le coût de toute rançon payée. L’intervention des forces de l’ordre a également permis de réduire le temps nécessaire à l’identification et à la remédiation des violations, qui est passé de 297 à 281 jours ;

– Les coûts les plus élevés ont été enregistrés par les entreprises d’infrastructures critiques. Les secteurs de la santé, des services financiers, de l’industrie, de la technologie et de l’énergie sont ceux qui ont enregistré les coûts les plus élevés. Pour la 14e année consécutive, les participants du secteur de la santé ont subi les violations les plus coûteuses, atteignant en moyenne 9,77 M$.

Le spécialiste de l’informatique quantique D-Wave a présenté ses ambitions pour les prochaines années avec un focus autour de l’IA et du machine learning. Les analystes sont séduits, mais estiment qu’il est encore tôt pour connaître l’impact d’une telle avancée

Mêler informatique quantique et IA, voilà l’ambition de D-Wave pour les années qui viennent. La société basée à Palo Alto veut « renforcer le lien entre l’optimisation quantique, l’IA et l’apprentissage machine » tout en améliorant son service cloud nommé Leap. Elle estime que le timing de cette annonce est bon et « intervient à un moment où l’ensemble de l’industrie de l’IA était confronté à une situation critique »

Selon D-Wave, « le coût de la quantité de calcul, et de l’énergie associée, nécessaires pour satisfaire des cas d’usage de plus en plus nombreux, augmente rapidement ». Dans un communiqué, il a ajouté que sa prochaine offre pouvait tirer parti de la « capacité unique du recuit quantique à résoudre les problèmes d’optimisation pour aider les clients à mieux traiter les charges de travail d’IA et de ML, plus rapidement et plus efficacement sur le plan énergétique. »

Trois domaines ciblés par la feuille de route

Dans son communiqué, D-Wave indique se concentrer sur trois domaines :

– Des distributions quantiques pour la GenAI : D-Wave prévoit d’axer son développement sur « la conception d’architectures d’IA générative qui utilisent des échantillons de l’unité de traitement quantique (Quantum Processing Unit, QPU) à partir de distributions quantiques qui ne peuvent pas être générées de manière classique ». Dans ce domaine, les premiers cas d’usage concerneront la découverte de molécules.

– Des architectures de machines de Boltzmann restreintes (Restricted Boltzmann Machine, RBM) : elles exploiteront la QPU de D-Wave pour des applications qui vont de la cybersécurité et de la découverte de médicaments à l’analyse de données de physique des hautes énergies, ce qui pourrait potentiellement conduire à une réduction de la consommation d’énergie pour l’entraînement et l’exécution de modèles d’IA.

– L’intégration du GPU avec Leap : D-Wave compte incorporer des ressources GPU supplémentaires pour l’entraînement et le soutien des modèles d’IA parallèlement aux charges de travail d’optimisation. De plus, « des efforts sont en cours pour réduire encore plus la latence entre les QPU et les ressources informatiques classiques, une étape essentielle pour permettre la technologie hybride quantique pour l’IA/ML. »

Les analystes séduits mais sur le long terme

« Les avancées de D-Wave dans le domaine de l’informatique quantique pour l’IA sont certes captivantes, mais il est encore trop tôt pour évaluer l’impact et la valeur de cette technologie pour les cas d’usage de l’IA dans le monde réel », a déclaré Selon Bill Wong, chargé de recherche à l’Info-Tech Research Group. « Aujourd’hui, la plupart des entreprises ne se préparent pas à des percées dans le domaine de l’IA grâce à l’utilisation de l’informatique quantique et ne les anticipent pas. Cela restera probablement l’un des principaux défis de l’informatique quantique, à savoir trouver les cas d’usage de l’IA qui peuvent bénéficier de manière significative de cette plateforme de calcul accéléré alors que les plateformes traditionnelles (c’est-à-dire basées sur le GPU) peuvent répondre aux exigences de calcul à un coût beaucoup plus faible », a-t-il ajouté. Selon l’analyste, les cas d’usage possibles « peuvent se concentrer sur le développement d’une cryptographie résistante au quantique, pour laquelle les plateformes informatiques traditionnelles ne peuvent pas fournir les ressources requises. D-Wave est à la pointe de cette recherche, et je suis moi aussi en quête de cas d’usage qui pourront conduire à l’adoption de cette plateforme unique ».

Heather West, analyste en informatique quantique chez IDC, fait remarquer que « l’on s’est souvent interrogé sur la manière dont l’IA et l’informatique quantique pourraient fonctionner en synergie, mais à ce stade, il s’agit plutôt de l’IA qui influence l’informatique quantique ». Selon elle, un élément clé de l’annonce tourne autour du recuit quantique, car ce processus a été conçu spécifiquement pour résoudre des problèmes d’optimisation, et, pour que le quantique « ait vraiment un impact, il faut une base de clients plus importante ». À la question de savoir si l’annonce faite hier par D-Wave faisait entrer le débat sur l’informatique quantique dans le courant dominant, elle a répondu : « Oui, en effet, D-Wave a adopté une approche centrée sur le client pour développer son système quantique. » Contrairement à la plupart des fournisseurs de matériel quantique, qui parlent de leurs qubits, des différents composants du système quantique, des cas d’usage possibles, « D-Wave parle de cas d’usage en cours d’exploration et qui ont une valeur ajoutée, en mettant vraiment l’accent sur le client. »

Sid Nag, analyste de Gartner, spécialisé dans le Scalable Computing, a déclaré que « même si D-Wave ne le disait pas explicitement », l’annonce représentait une « alternative aux GPU ». Celui-ci a toutefois mis en garde contre « l’apparition de tout un tas de fournisseurs de cloud spécialisés, concurrents des hyperscalers, à l’image de ce qui se passe de plus en plus dans le domaine de l’IA ». Ajoutant : « Je ne sais pas quelle sera son ampleur en croissance réelle. À un moment donné, le « creux des désillusions », une expression de Gartner pour désigner une phase « où, après l’engouement initial et les attentes exagérées, l’intérêt commence à diminuer », va s’installer ». M. Nag précise encore que, dans le cas de D-Wave, « ils visent un marché très particulier ».

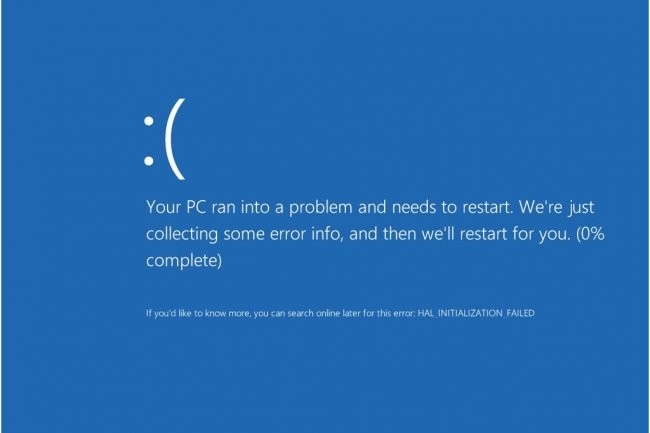

Une société a chiffré à 5,4 Md$ le coût de la panne de Windows de Microsoft provoqué par Crowdstrike pour les grandes entreprises américaines. Une affaire qui a remis l’option Linux au goût du jour, mais aussi Apple.

Si Microsoft indique que 97% des systèmes affectés par la panne géante de Windows et Azure survenue le 19 juillet dernier sont revenus à la normal, la facture s’annonce lourde pour les sociétés victimes. En effet, Parametrix Insurance, spécialisé dans l’assurance cloud, chiffre dans une étude à 5,4 Md$ les pertes financières pour l’ensemble des entreprises américaines du classement Fortune 500. Au niveau mondial, le CEO du fournisseur a indiqué à Reuters que les pertes pourraient s’élever à 15 Md$.

Dans le détail, l’éditeur estime que le secteur de la santé (1,938 Md$), suivies par celles du secteur bancaire (1,149 Md$) ont subi les plus lourdes pertes (57% du total). Les compagnies aériennes ont été impactées à hauteur de 860 M$ (Delta estime son préjudice entre 350 et 500 M$) et le secteur industriel limite la casse à 36 M$. Parametrix Insurance prévoit que les polices d’assurance souscrites pour ce type de risque ne devraient couvrir qu’entre 10 à 20% des pertes financières totales.

Migrer maintenant ?

Cette panne a remis en lumière la dépendance des SI aux environnements Windows. Si le monde Linux est rapidement monté au créneau, Apple se positionne aussi comme une alternative en entreprise, mais aussi dans l’administration. La firme de Cupertino peut s’appuyer sur des partenaires comme Addigy, Jamf, Kandji pour les accompagner dans leur migration. Par ailleurs, elle met en avant la résilience intrinsèque de ses plateformes.

Même si aucune plateforme n’est jamais totalement sûre, la grande majorité des problèmes ayant affecté les plateformes d’Apple sont dus à des erreurs de l’utilisateur, et non à des mises à jour logicielles automatisées déployées à l’échelle mondiale, qui mettent les PC hors d’usage. Certes, le préjugé selon lequel les produits Apple sont orientés grand public qui ne sont pas adaptés aux entreprises, reste profondément ancré, et changer cette opinion prend du temps, même si des événements comme la panne de Crowdstrike devraient y contribuer.

L’aval des gouvernements

Le fait que le gouvernement allemand ait choisi Apple en témoigne. Le service des achats du Ministère fédéral de l’Intérieur et de la Patrie (BMI) a récemment conclu un accord avec Bechtle pour la fourniture de 300 000 terminaux Apple dans l’ensemble de l’administration fédérale. Cela signifie que toutes les agences gouvernementales utiliseront des iPhones et des iPads équipés de la plateforme iNDIGO (iOS Native Devices in Government Operation) d’Apple. iNDIGO offre des fonctions de sécurité intégrées, des mises à jour régulières, un chiffrement matériel et des politiques strictes de protection des données. Il a été approuvé par l’Office fédéral de la sécurité des technologies de l’information (BSI) pour le partage sécurisé de contenus confidentiels classés « à usage officiel uniquement » (VS-NfD). Cela ressemble beaucoup à l’adoption croissante des produits Apple par le gouvernement américain. Apple participe aussi « activement à plusieurs évaluations et certifications gouvernementales en matière de sécurité au niveau mondial », a indiqué l’entreprise.