Le groupe UAC-0184 cible le personnel militaire ukrainien, y compris à l’étranger, et utilise la stéganographie pour infecter leurs terminaux avec un cheval de Troie d’accès à distance.

Le conflit en Ukraine est souvent qualifié de guerre hybride avec une présence de plus en plus marquée du volet cyber-offensif. Dernier exemple en date, l’usage de la stéganographie où un groupe d’attaquants a diffusé des charges utiles en les cachant dans les pixels d’images. Repéré sous le nom de UAC-0184 par plusieurs entreprises de sécurité, ainsi que par le CERT ukrainien, le groupe a ciblé des militaires ukrainiens via des courriels d’hameçonnage se faisant passer pour des messages de la 3e brigade d’assaut Separate Assault Brigade de l’Ukraine et des Forces de défense israéliennes (Israeli Defense Forces, IDF).

Bien que la plupart des destinataires de ces messages se trouvaient en Ukraine, l’éditeur de sécurité Morphisec a confirmé l’existence de cibles en dehors du pays. « Si l’adversaire a stratégiquement ciblé des entités basées en Ukraine, il a apparemment cherché à s’étendre à d’autres entités affiliées à l’Ukraine », ont indiqué les chercheurs dans un rapport. Ils ajoutent que « les investigations ont mis en évidence une cible plus spécifique : les entités ukrainiennes basées en Finlande ». Morphisec a également observé que cette technique d’attaque stéganographique avait été élaborée pour livrer des charges utiles malveillantes après la compromission initiale.

La diffusion du cheval de Troie Remcos comme finalité

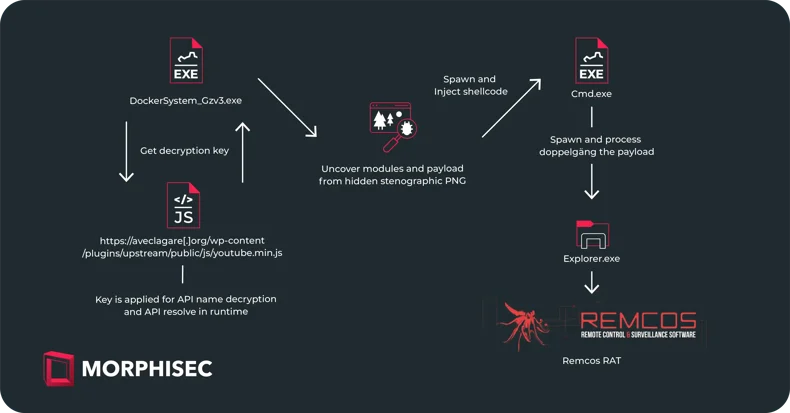

Les attaques détectées par Morphisec comprennent un chargeur de malware connu sous le nom d’IDAT ou HijackLoader, utilisé par le passé pour diffuser divers chevaux de Troie et programmes malveillants, notamment Danabot, SystemBC et RedLine Stealer. Dans le cas présent, UAC-0184 s’en est servi pour déployer un RAT (Remote Access Trojan) appelé Remcos. « IDAT se distingue par son architecture modulaire et utilise des caractéristiques uniques comme l’injection de code et les modules d’exécution, ce qui le différencie des chargeurs conventionnels », ont expliqué les chercheurs. « Le chargeur utilise des techniques sophistiquées comme le chargement dynamique des fonctions de l’API Windows, les tests de connectivité HTTP, les listes de blocage de processus et les appels système pour échapper à la détection. Le processus d’infection d’IDAT se déroule en plusieurs étapes, chacune remplissant des fonctions distinctes », complètent-ils. L’infection se déroule en plusieurs phases, la première consistant à appeler une URL distante pour accéder à un fichier .js (JavaScript). Le code de ce fichier indique à l’exécutable où chercher un bloc de code chiffré dans son propre fichier et la clé à utiliser pour le déchiffrer.

Les chercheurs ont retracé le processus d’infection via la stéganographie. (Crédit Photo : Morphisec)

La configuration IDAT exploite aussi un fichier PNG intégré dont le contenu est recherché pour localiser et extraire la charge utile en prenant l’emplacement 0xEA79A5C6 comme point de départ. Le code des malwares peut être caché dans les données des pixels des fichiers image et vidéo sans nécessairement avoir d’incidence sur le fonctionnement de ces fichiers ou sur les informations multimédias qu’ils contiennent. Même si cette technique n’est pas nouvelle pour les attaquants, elle est rarement observée. « Par exemple, une image avec une profondeur de pixel de 24 bits (16,7 millions de couleurs) peut contenir un code intégré dans les bits de poids faible (Least Significant Digit, LSD) de chaque pixel, sans modifier l’aspect de l’image », ont encore expliqué les experts de Morphisec. « Même en scannant le fichier multimédia, la charge utile malveillante étant obscurcie, elle peut échapper à la détection basée sur les signatures, ce qui permet à un chargeur de logiciels malveillants de déposer le média, d’extraire la charge utile malveillante et de l’exécuter dans la mémoire ».

Des IoC publiés

Pour exécuter le payload caché, le chargeur IDAT s’appuie sur une autre méthode connue sous le nom de « module stomping », où il est injecté dans un fichier DLL légitime – appelé PLA.dll (Performance Logs and Alerts) dans ce cas – afin de réduire les chances d’être détectée par un produit de sécurité des endpoint.

Remcos permet aux attaquants de voler des informations et de surveiller l’activité d’une victime. Il donne également aux attaquants la capacité de contrôler un ordinateur infecté et, comme il s’agit d’un RAT commercial et non d’un RAT personnalisé, de nombreux groupes l’ont utilisé par le passé. Les avis de sécurité de Morphisec et du CERT-UA contiennent des hachages de fichiers et des adresses IP qui peuvent servir d’indicateurs de compromission pour développer des signatures de détection.

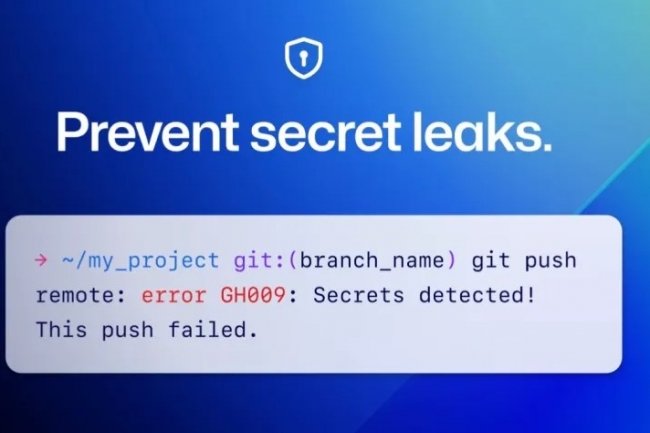

Avec la protection push, GitHub empêche les utilisateurs de pousser des secrets vers un dépôt. Une fonction d’exception est toutefois proposée.

Github a commencé à déployer la protection push pour tous ses utilisateurs. De quoi s’agit-il ? C’est une fonction d’analyse des secrets qui donne aux utilisateurs la possibilité de les supprimer des commits. Les développeurs peuvent vérifier leur statut et opter pour cette option dans les paramètres de sécurité et d’analyse du code. L’analyse des secrets de GitHub protège plus de 200 types de token et de modèles provenant de plus de 180 fournisseurs de services. Les développeurs peuvent toutefois contourner un blocage même si la protection push est activée.

L’analyse des secrets peut également rechercher des modèles personnalisés dans les messages push. Elle est toujours activée par défaut, mais peut être désactivée dans les paramètres de sécurité de l’utilisateur. GitHub recommande de laisser la protection push activée et de faire des exceptions en fonction des besoins.

La filiale de Microsoft a déclaré qu’au cours des huit premières semaines de l’année 2024, il a détecté plus d’un million de fuites de secrets sur des dépôts publics. Les organisations qui bénéficient du plan Enterprise peuvent ajouter Advanced Security pour empêcher les fuites de secrets dans les dépôts privés.

La version 2.0 du Cybersecurity Framework publié par le NIST est plus axée sur les questions de gouvernance et de la supply chain. Le référentiel bénéficie par ailleurs de plus de ressources pour accélérer sa mise en oeuvre.

Après deux ans de travail, le NIST (National institute of standards and technology) vient de publier la version 2.0 du son référentiel sur la cybersécurité. L’organisation américaine fait autorité dans plusieurs domaines de l’IT notamment dans le domaine du cloud. Cette deuxième itération du Cybersecurity Framework (CSF) n’est plus focalisée sur la protection des infrastructures critiques, comme les hôpitaux et les centrales électriques, mais sur celle de toutes les entités, quel que soit leur secteur d’activité. La précédente dénomination « Framework for Improving Critical Infrastructure Cybersecurity » a été abandonnée au profit de « NIST Cybersecurity Framework (CSF) 2.0 » pour tenir compte de ce changement.

Plus que les deux versions précédentes du CSF, la version originale publiée en 2015 et la version 1.1 publiée en 2018, la 2.0 est moins une ressource statique et plus un panier de ressources pour accompagner la mise en œuvre du framework. « Le CSF a été un outil vital pour de nombreuses entités, les aidant à anticiper et à faire face aux menaces de cybersécurité », a déclaré Laurie E. Locascio, sous-secrétaire d’État au commerce pour les normes et la technologie et directrice du NIST. « Le CSF 2.0, qui s’appuie sur les versions précédentes, n’est pas un simple document. Il s’agit d’un ensemble de ressources qui peuvent être personnalisées et utilisées individuellement ou en combinaison au fil du temps, à mesure que les besoins d’une structure publique ou privée en matière de cybersécurité changent et que ses capacités évoluent ».

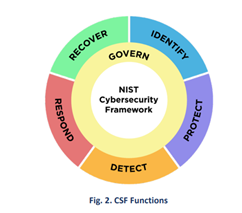

La gouvernance, changement majeur du CSF

Le changement structurel le plus important apporté au CSF concerne l’ajout d’une sixième fonction, « gouvernance », autour de laquelle gravitent les cinq fonctions précédentes : identifier, protéger, détecter, réagir et restaurer. Cette fonction vise à aider les organisations à intégrer la composante cybersécurité dans des programmes plus larges de gestion des risques d’entreprise en présentant des « résultats » ou des états souhaités, afin de l’informer sur ce qu’elle peut faire pour atteindre les résultats des cinq autres fonctions et les classer par ordre de priorité.

Dans les fonctions du CSF, il faut maintenant intégrer la gouvernance. (Crédit Photo : NIST)

La création d’une catégorie de gouvernance a pour but d’élever toutes les activités de gestion du risque de cybersécurité au niveau de la direction et du conseil d’administration des organisations. « L’objectif principal de cette version 2.0 est de faire de la gouvernance une fonction », a expliqué Padraic O’Reilly, fondateur et directeur de l’innovation de CyberSaint. « Ce l’on comprend aujourd’hui, et c’est assez courant dans le domaine de la cybersécurité, c’est que si la gouvernance n’est pas activement impliquée, on ne fait que tourner en rond ».

Importance accrue de la supply chain

Le Cybersecurity Framework 2.0 intègre et développe également les résultats de la gestion des risques liés à la supply chain contenus dans le CSF 1.1 et regroupe la plupart d’entre eux sous la fonction de gouvernance. Le framework 2.0 estime que, étant donné « les relations complexes et interconnectées dans cet écosystème, la gestion des risques liés à la chaîne d’approvisionnement (SCRM) est essentielle pour les organisations ». Le Cybersecurity SCRM (C-SCRM) est un processus systématique de prise en compte de ce risque et d’élaboration de stratégies, de politiques et de procédures de réponse appropriées. Les sous-catégories de la catégorie C-SCRM du CSF [GV.SC] font le lien entre les résultats purement axés sur la cybersécurité et ceux orientés sur la C-SCRM ».

L’intégration de la gestion des risques liés à la chaîne d’approvisionnement dans la fonction « Gouvernance » n’est qu’un pas dans la bonne direction pour résoudre l’un des problèmes les plus épineux de la cybersécurité. « La supply chain est un véritable gâchis », s’emporte Padraic O’Reilly. « C’est un gâchis, parce que c’est complexe. Selon moi, une partie de ce sujet a été placée sous la tutelle de la gouvernance car il doit être géré de plus en plus au niveau de la direction. En effet, à l’heure actuelle, certaines pratiques sont à moitié satisfaisantes, mais elles ne couvrent que la moitié du problème ».

Des ressources supplémentaires

Pour faciliter l’adoption de son dernier référentiel, le NIST propose un ensemble de fiches informatives, de lignes directrices et des frameworks. Un effort pour mettre en œuvre les 106 sous-catégories regroupées en 23, elles-mêmes rassemblées en fonctions principales. Pour réduire les difficultés, l’organisme a intégré dans la version 2.0 du CSF une série de guides de démarrage rapide sur plusieurs sujets, notamment sur la façon de créer des profils et des niveaux CSF et, en particulier, sur la façon de commencer à gérer les risques liés à la sécurité de la chaîne d’approvisionnement. Il est possible aussi de créer des profils communautaires pour faciliter les échanges.

La mise en oeuvre du référentiel peut s’avérer complexe avec un ensemble de catégories et sous-catégories. (Crédit Photo : NIST)

Afin de fournir des conseils encore plus pratiques sur la manière de mettre en œuvre le framework, le CSF 2.0 propose également des exemples d’implémentation (voir encadré). Ils témoignent de l’effort du NIST pour formuler les résultats écrits passivement, en étapes plus actives et actionnables que les organisations peuvent reprendre pour adopter le framework. Depuis la création du référentiel, le NIST a veillé à ne pas prescrire aux entreprises ou administrations des mesures particulières, étant donné que chaque structure dispose de configurations techniques et de ressources uniques.Les différentes implémentations du CSF 2.0Le NIST a proposé plusieurs aides à la mise en oeuvre du CSF 2.0

– SP 800-221, Enterprise Impact of Information and Communications Technology Risk: Governing and Managing ICT Risk Programs Within an Enterprise Risk Portfolio (Impact des risques liés aux technologies de l’information et de la communication sur l’entreprise : gouvernance et gestion des programmes de risques liés aux TIC dans le cadre d’un portefeuille de risques d’entreprise)

– SP 800-221A, Information and Communications Technology (ICT) Risk Outcomes: Integrating ICT Risk Management Programs with the Enterprise Risk Portfolio. (Résultats des risques liés aux technologies de l’information et de la communication (TIC) : Intégration des programmes de gestion des risques liés aux TIC dans le portefeuille de risques de l’entreprise).

– SP 800-37, Information and Communications Technology (ICT) Risk Outcomes: Integrating ICT Risk Management Programs with the Enterprise Risk Portfolio. (Résultats des risques liés aux technologies de l’information et de la communication (TIC) : Intégration des programmes de gestion des risques liés aux TIC dans le portefeuille de risques de l’entreprise).

– SP 800-37, Risk Management Framework for Information Systems and Organizations. (Framework de gestion des risques pour les systèmes d’information et les organisations).

– SP 800-30, and Guide for Conducting Risk Assessments from the NIST Risk Management Framework (RMF) (Guide pour l’évaluation des risques à partir du framework de gestion des risques (RMF) du NIST)

A l’occasion du Mobile World Congress à Barcelone, le commissaire européen au marché intérieur a détaillé les piliers du futur règlement sur les réseaux.

Le partage des coûts de réseau, ou le partage équitable, comme l’appellent les opérateurs de réseau, est à l’ordre du jour du MWC à Barcelone. Le commissaire européen chargé du marché intérieur, Thierry Breton, a profité de l’événement pour détailler les axes stratégiques qui serviront de base au futur Digital Networks Act. Il a été élaboré en réponse à la consultation publique organisée par l’UE l’année dernière sur le partage des coûts des réseaux. Au début du salon, les dirigeants des opérateurs avaient appelé à une collaboration sur les coûts avec d’autres acteurs du marché IT. Dans un premier temps, Thierry Breton a évoqué les différentes technologies de rupture présentes au MWC 2024 et ce qu’elles avaient en commun : la dépendance à l’égard d’infrastructures robustes et sûres, « une nouvelle architecture où convergent les télécommunications, le cloud et les infrastructures edge ».

Cependant, pour le commissaire européen, les réseaux actuels ne sont pas à la hauteur et près de 200 milliards d’euros seront nécessaires au cours des six prochaines années pour achever le déploiement de la 5G et la fibre. De même, le cadre réglementaire conçu il y a deux décennies à l’époque des réseaux en cuivre n’est pas adapté aux nouveaux besoins. C’est pourquoi l’exécutif bruxellois a présenté il y a quelques jours les bases du Digital Networks Act. Celle-ci repose sur trois piliers : l’investissement dans la recherche et le déploiement technologique, la création d’un véritable marché unique numérique doté de son propre cadre réglementaire et la protection des infrastructures de réseaux. « Il est temps de changer l’ADN de notre infrastructure de connectivité », a déclaré M. Breton.

Investir dans le leadership technologique

« L’Europe est déjà une puissance en matière de recherche et de technologie. Nous devons maintenant investir dans la maîtrise des transformations IT en cours et veiller à ce que la recherche débouche sur de nouveaux marchés », a ajouté le responsable. Pour cela, la Commission propose la création d’un écosystème européen d’innovateurs dans le domaine de l’informatique, appelé « Collaborative Connected Computing » ou « 3C Network ». Cette initiative vise à garantir que l’investissement dans le déploiement des réseaux en tant que service conduise au développement d’offres réellement « made in Europe » dans divers secteurs économiques.

Plus précisément, elle vise à soutenir le déploiement d’une infrastructure de connectivité de bout en bout, sécurisée et à haut débit, pour relier les différents acteurs et dispositifs impliqués dans un cas d’usage spécifique, en utilisant des réseaux terrestres et non terrestres. Dans un premier temps, trois projets pilotes à grande échelle seront menés dans les domaines des soins de santé, de la mobilité et des smart cities.

Un marché unique numérique

Le deuxième pilier de la loi sur les réseaux numériques concerne la création d’un marché unique du numérique, doté d’un cadre réglementaire propre qui uniformise les règles du jeu entre les acteurs de l’écosystème. « Actuellement, notre cadre réglementaire est trop fragmenté. Nous ne tirons pas le meilleur parti de notre marché unique de 450 millions de clients potentiels. Nous avons besoin d’un véritable marché unique numérique pour faciliter l’émergence d’opérateurs paneuropéens ayant la même envergure et les mêmes opportunités commerciales que leurs homologues dans d’autres régions du monde. Et nous avons besoin de conditions de concurrence véritablement équitables, car dans un espace technologique où les infrastructures de télécommunications et cloud convergent, rien ne justifie qu’elles ne respectent pas les mêmes règles », a estimé le commissaire européen.

Cela signifie, pour lui, « des droits et des obligations similaires pour tous les acteurs et utilisateurs finaux des réseaux numériques. Cela implique avant tout d’établir le principe du « pays d’origine » pour les services d’infrastructure de télécommunications, comme c’est déjà le cas pour le cloud, afin de réduire les coûts de mise en conformité et les exigences d’investissement pour les opérateurs paneuropéens », a-t-il poursuivi. Cela implique également, selon lui, de « démystifier la question du nombre optimal d’opérateurs, car il n’y a pas de nombre magique dans ce domaine. On ne peut pas avoir une vision étroite des marchés et de leurs acteurs ». Enfin, le responsable préconise « d’européaniser l’attribution des licences d’utilisation du spectre ». « Dans la course technologique vers la 6G, nous ne pouvons pas nous permettre de nouveaux retards dans le processus de concession, avec d’énormes disparités dans le calendrier des enchères et le déploiement des infrastructures entre les États membres : nous ne pouvons pas nous permettre le même résultat que pour les enchères 5G, où, après huit ans, le processus n’est toujours pas achevé », a-t-il regretté.

Des réseaux sécurisés et résilients

« Dans le contexte géopolitique actuel, nous devons renforcer la sécurité économique de l’UE dans le domaine des technologies de la communication et assurer la sécurité physique et la cybersécurité de nos infrastructures, ainsi que des données qui y transitent », a encore souhaité Thierry Breton. Pour faire face aux menaces et aux risques posés par les nouvelles technologies, il est nécessaire de développer des stratégies et des normes européennes de cryptage post-quantique et de coordonner les efforts de sécurité des câbles sous-marins entre les États membres. « Nous sommes actuellement plongés dans une course technologique mondiale. Dans ce sprint pour la résilience et la compétitivité, l’Europe ne peut pas être et ne sera pas laissée pour compte. Avec de la vision, de la détermination et de la coopération, je crois qu’une loi sur les réseaux numériques comme le Digital Networks Act est à portée de main, pour le bénéfice de tous », a conclu M. Breton.

L’administration Biden demande aux développeurs d’adopter des langages de programmation sans risque pour la mémoire. C et C++ sont clairement dans le viseur, mais le changement prendra du temps.

Déjà taclés par la NSA, les langages C et C++ n’ont plus la cotes auprès des plus hautes instances américaines. En effet, la Maison-Blanche souhaite que les développeurs se servent de langages sécurisés pour la mémoire. Dans un rapport publié lundi, l’Office of the National Cyber Director (ONCD) de la Maison-Blanche invite les développeurs à réduire le risque de cyberattaques en utilisant des langages sans risque de vulnérabilités pour la mémoire. Les entreprises IT « peuvent empêcher l’introduction de multiples vulnérabilités dans l’écosystème numérique en adoptant des langages sécurisés », a déclaré la présidence dans un communiqué. Elle fait référence à ceux qui sont protégés contre les débordements de mémoire tampon, les lectures hors-limites (out-of-bounds reads ) et les fuites de mémoire.

Rust cité en exemple

Des études récentes de Microsoft et de Google ont montré qu’environ 70 % de toutes les failles de sécurité sont dues à des problèmes de sécurité de la mémoire. « En tant que nation, nous avons la capacité et la responsabilité de réduire la surface d’attaque dans le cyberespace et d’empêcher des catégories entières de bogues de sécurité d’entrer dans l’écosystème numérique, mais pour cela, nous devons nous attaquer au difficile problème de l’adoption de langages de programmation sans risque pour la mémoire », a déclaré Harry Coker, le directeur de l’Office of the National Cyber Director. Dans un billet de blog publié en septembre, la CISA (Cybersecurity and Infrastructure Security Agency), a donné le même conseil aux développeurs.

Dans son rapport de 19 pages, l’ONCD cite le C et le C++ comme deux exemples de langages présentant des vulnérabilités en matière de sécurité de la mémoire, et qualifie Rust comme sûr. Par ailleurs, une fiche d’information de la NSA sur la cybersécurité datant de novembre 2022 mentionne, en plus de Rust, les langages C#, Go, Java, Ruby et Swift, comme sécurisés. Selon Statista, en 2023, environ 22 % de tous les développeurs utilisaient le C++ et 19 % le C, ce qui les rend moins populaires que JavaScript, Python, Java et quelques autres. Cependant, l’indice Tiobe classe Python comme le plus populaire, suivi de C, C++ et Java.

Transfert de responsabilité

L’un des objectifs du rapport de l’ONCD est de transférer la responsabilité de la cybersécurité des particuliers et des petites entreprises vers les grands groupes, les entreprises IT et le gouvernement américain, qui sont « plus à même de gérer une menace en constante évolution », selon le communiqué de presse de la Maison-Blanche. L’ONCD a travaillé avec le secteur privé, y compris les sociétés IT, la communauté universitaire et d’autres organisations, pour élaborer ses recommandations.

L’organisme a lancé un appel à contribution publique sur le sujet en août. Il a également recueilli les commentaires de plusieurs firmes, dont Hewlett Packard Enterprise, Accenture et Palantir, qui soutiennent l’initiative. D’autres experts en sécurité des logiciels ont aussi fait l’éloge du rapport. Selon Dan Grossman, professeur en informatique fondamentale à l’université de Washington, le rapport de l’ONCD est utile et arrive à point nommé. Même si les « dangers du C et du C++ sont connus depuis des décennies », c’est le bon moment pour la Maison-Blanche de faire pression en faveur de la sécurité de la mémoire, « car des alternatives pratiques et matures sont désormais disponibles », a-t-il déclaré.

Un changement qui prendra du temps

Ces changements s’imposent aussi du fait de « la sophistication des menaces des adversaires qui exploitent les violations de la sécurité de la mémoire », a ajouté le professeur. « Des discussions sur la sécurité de la mémoire impliquant le gouvernement, l’industrie et les universitaires peuvent conduire à des changements significatifs », a-t-il estimé. « Naturellement, beaucoup de directions du gouvernement fédéral sont des créateurs et des vendeurs clés de logiciels et ils peuvent utiliser cette perspective pour décider de leur priorité pour les changements à venir dans les systèmes ou les nouveaux systèmes. Cependant, l’abandon du C et du C++ ne se fera pas du jour au lendemain, en particulier dans les systèmes embarqués », a reconnu Dan Grossman. « Mais l’utilisation d’autres langages pour les logiciels de systèmes, notamment Rust, a déjà augmenté de manière significative, et beaucoup prévoient une accélération de cette évolution plutôt qu’un arrêt pur et simple du développement du C et du C++, ce qui semble encore inimaginable dans son intégralité ».

L’abandon du C et du C++ sera « long et difficile », a aussi estimé Josh Aas, directeur exécutif et cofondateur de l’Internet Security Research Group. « Il faut un effort soutenu pour amener les gens à penser autrement, et des communications comme celle-ci contribuent à rappeler l’importance de la sécurité. Pour que le changement se produise, le gouvernement et le secteur privé doivent travailler ensemble pour faire du code sécurisé une priorité », a ajouté le dirigeant. « Il est clair que nous devons écrire et déployer de nouveaux codes, mais pour y parvenir, nous avons besoin de ressources et que des dirigeants à tous les niveaux, du gouvernement au secteur privé, en fassent une priorité », a-t-il insisté. « Les dirigeants concernés doivent être sensibilisés à ce problème et savoir qu’ils seront soutenus s’ils cherchent à le résoudre ».

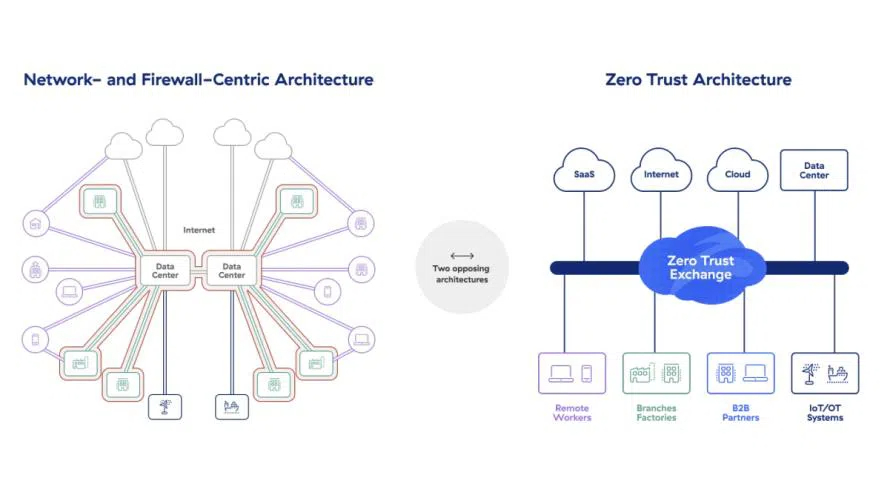

Le fabricant allemand de procédés de traitement des poudres et d’installations de films soufflés Hosokawa Alpine a migré ses applications et ses processus dans le cloud. Une démarche qui l’a conduit à davantage sécuriser ses infrastructures avec une plate-forme zéro trust.

L’industriel allemand Hosokawa Alpine AG se concentre sur deux domaines d’activité : les systèmes d’ingénierie de procédés mécaniques utilisés dans le traitement des poudres, des granulés et des solides en vrac, et les machines de production de films, pour le conditionnement de produits frais par exemple. Pour moderniser son architecture informatique, l’entreprise a décidé de migrer ses processus et ses applications dans le cloud. « Nous avons constaté que la maintenance sur site entravait notre croissance, déclare le DSI Alexander Kiffe. Nous avons donc commencé à regarder ce qui dans l’infrastructure existante correspondait à des processus métier et pouvait raisonnablement passer dans le cloud. »

La plate-forme zéro trust fournit une architecture d’accès et de sécurité centralisée pour différents scénarios d’application, tels que l’accès sécurisé aux applications dans le cloud, ainsi qu’aux données et aux applications on-premise. (Photo Zscaler)

Or, 60 à 70 % des employés d’Hosokawa Alpine travaillent à domicile jusqu’à trois jours par semaine. Et l’accès aux applications dans ce contexte de travail hybride nécessite des mesures de sécurité, dont certaines spécifiques aux applications désormais dans le cloud. Le VPN en place s’est vite révélé insuffisant à la fois en matière de protection et de performance en la matière. « Pour renforcer notre sécurité IT au niveau du cloud, nous avons opté pour un modèle de services en edge, poursuivant ainsi le déploiement de la stratégie zéro trust déjà entamée au niveau du réseau », explique Alexander Kniffe.Prolongement de la stratégie de sécurisation du réseauL’industriel a ainsi opté pour la plate-forme cloud Zero Trust Exchange de Zscaler qui donne un accès sécurisé à distance à la fois aux applications cloud et aux applications internes. Il était important pour Hosokawa Alpine d’avoir un aperçu de tous ses flux de données. Ainsi, même le shadow IT peut être détecté et sécurisé. Le principe de l’approche zéro trust consiste à n’accorder aux utilisateurs que les droits d’accès strictement nécessaires (Least Privileged Access). De plus, l’accès aux applications peut être contrôlé de façon très granulaire via des politiques spécifiques prédéfinies. La solution réduit les risques de sécurité, mais aussi le nombre de points d’entrée pour d’éventuels cyberattaquants. « Nous donnons désormais une visibilité applicative en zéro trust aux employés qui travaillent à domicile et nous sommes aussi mieux équipés pour déployer davantage d’applications cloud comme Microsoft 365 ou SAP S/4HANA », précise Alexander Kiffe.Hosokawa Alpine en chiffresActivité : fabrication de procédés de traitement des poudres et d’installations de films soufflésDate de création : 1898Siège social : Augsburg (Allemagne)CA 2022-2023 : 250 M€ dont 80% hors d’AllemagneEffectifs : 870 employés

Le Mobile World Congress 2024 s’est ouvert sur un appel des dirigeants des opérateurs télécoms pour que les secteurs technologiques partagent les coûts des réseaux et l’accès aux API face à la croissance du trafic.

Le Mobile World Congress 2024 s’est ouvert à Barcelone avec des dirigeants d’opérateurs télécoms qui ont appelé à la collaboration et à la coopération entre les opérateurs télécoms, les autorités publiques et les entreprises technologiques. En ouverture de l’événement sur la scène du MWC ce 26 février, les dirigeants des grands opérateurs ont demandé que les entreprises technologiques partagent les coûts des réseaux – ce que l’on appelle le Fair Share – et que soit créé un écosystème unique qui permette l’innovation et le progrès technologique. Mats Granryd, directeur général de la GSM Association, l’organisme industriel qui organise le MWC, a célébré quant à lui le rôle que l’événement a joué au fil des ans. « Nous ne sommes plus les représentants d’un seul secteur, mais de plusieurs secteurs, la connectivité et la technologie étant au cœur de notre travail », a indiqué le dirigeant.

Lors de la session inaugurale, Mats Granryd a défini quatre priorités pour le secteur des télécommunications dans les années à venir : la croissance, en recherchant des opportunités dans tous les domaines, une passerelle ouverte, pour libérer le potentiel des réseaux 5G dans un monde basé sur les API, l’alignement dans un environnement en mutation, et l’inclusion numérique, en ne laissant personne de côté. « Lorsque nous aurons réussi ces quatre choses, nous aurons le meilleur environnement possible pour l’humanité », a-t-il déclaré. Et de souligner que la 5G, l’intelligence artificielle et le cloud étaient les principaux moteurs de la croissance et a appelé à un investissement continu dans les nouvelles technologies. Il a également salué l’adoption rapide de l’initiative Open Gateway, qui vise à rationaliser les réseaux de télécommunications et à les ouvrir aux développeurs. En seulement 12 mois, 47 opérateurs ont rejoint le projet, représentant 239 réseaux et plus de 65 % des connexions mobiles mondiales.

Des API branchées aux réseaux

José María Álvarez-Pallete, président de la GSMA et CEO de l’opérateur de réseau Telefónica, a quant à elle parlé du besoin croissant de capacité, de vitesse et de qualité des connexions, en particulier pour les nouveaux produits et services qui circulent sur les réseaux tels que le ChatGPT et l’IA générative. « Les modèles centrés sur l’API sont essentiels », a-t-il expliqué, rappelant le lancement, il y a un an, de l’initiative Open Gateway de la GSMA. Open Gateway propose des API pour les fonctions réseau, notamment l’état d’un terminal, la vérification du numéro, le SMS avec mot de passe unique et sa localisationl, que les développeurs peuvent utiliser dans leurs applications mobiles. « Je suis particulièrement fier que deux des principaux marchés de Telefonica, l’Espagne et le Brésil, aient procédé avec succès à des lancements coordonnés d’API auxquels ont participé tous les opérateurs concernés sur le territoire », poursuit José María Álvarez-Pallete. Six marchés dans le monde, dont le Sri Lanka, l’Allemagne, l’Indonésie et l’Afrique du Sud, ont suivi cet exemple et 40 réseaux ont lancé commercialement au moins une API. Les réseaux évoluent également sur d’autres plans, a-t-il ajouté : « Les réseaux sont basés sur des logiciels, puis l’IA leur est appliquée et ils commencent à réfléchir. Nos réseaux deviennent proactifs. Ils deviennent liquides.”

Toutefois, cette vision des réseaux présente de nouveaux défis, a-t-il déclaré. Actuellement, six entreprises consomment plus de 50 % de la capacité du réseau, et dans les sept prochaines années, le volume de données quadruplera. « L’IA aura besoin d’une puissance de traitement massive, elle a besoin que la Terre (les opérateurs de télécommunications) et l’informatique cloud collaborent. Il est temps de mettre en place un partenariat mondial et une gouvernance équitable pour créer une chaîne de valeur durable et mutuellement bénéfique. Il est temps de collaborer, et non de se positionner de manière abusive. Il est temps de faire un usage responsable des ressources partagées. Il est temps d’adopter un nouveau paysage réglementaire. Nous avons besoin d’une réglementation du 21e siècle », a déclaré José María Álvarez-Pallete. Le président du principal opérateur national a également profité de l’occasion pour célébrer le centenaire du groupe. « Nous sommes étonnamment résistants. Une entreprise n’atteint 100 ans que si elle sert la société et s’adapte en permanence pour continuer à la servir. Le fait qu’il y ait plusieurs entreprises centenaires dans notre secteur en témoigne. Joyeux anniversaire à Telefonica. Joyeux nouvel anniversaire à notre industrie », a-t-il déclaré.

Des gouvernances à trouver pour un futur modèle économique

Une autre intervenante, Margherita Della Valle, CEO de Vodafone et membre du conseil d’administration de la GSMA, s’est penchée sur les changements que la technologie a apportés à la société au cours des 30 dernières années et des années à venir. « La plus grande opportunité se trouve dans l’internet industriel, dans la connexion des machines et des applications au cloud et aux services alimentés par l’IA. La seule limite est fixée par notre imagination », a-t-elle déclaré. Selon Margherita Della Valle, cette avancée technologique nécessite une approche différente de celle des dernières années : « Nous avons besoin de partenariats entre les opérateurs, les décideurs politiques et les entreprises technologiques pour contribuer à l’avènement de l’internet industriel. Nos décideurs politiques doivent agir maintenant et créer un véritable marché unique. L’Europe a besoin d’investisseurs et les investisseurs ont besoin de voir le changement. Mais il faudra plus que de bonnes politiques pour réussir à l’ère de l’internet industriel. Il faut que les télécommunications oublient les anciens modèles et qu’elles rivalisent et collaborent avec les autres leaders du marché. Nous devons être ouverts à la collaboration. Les opérateurs de réseaux devront eux aussi changer, les opérateurs de télécommunications doivent jouer un nouveau rôle, être flexibles au sein d’un écosystème plus large ».

Des chercheurs ont découvert que de nombreux déploiements de Salesforce comprennent du code Apex non sécurisé. Des failles critiques ont été observées pouvant entraîner des fuites ou des corruptions de données.

Des experts de Varonis alertent sur la présence d’instances de code Apex non sécurisé dans les déploiements Salesforce de nombreuses entreprises, laissant craindre de sérieuses vulnérabilités qui mettent en danger leurs données et les workflows. Ces derniers disent avoir trouvé des failles de gravité élevée et critique dans le code Apex utilisé par plusieurs entreprises du Fortune 500 et des agences gouvernementales.

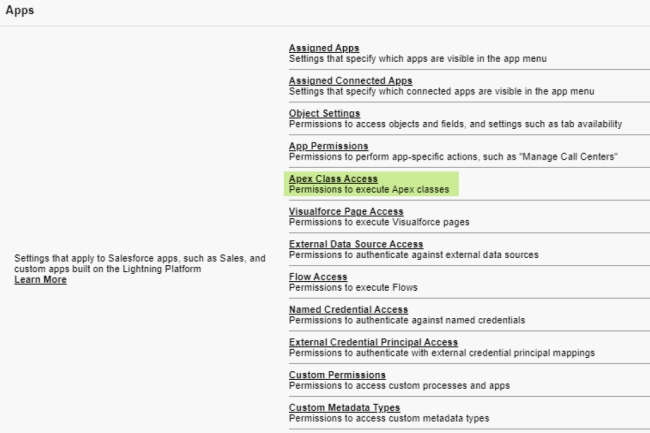

« Si elles sont exploitées, ces vulnérabilités peuvent entraîner des fuites et des corruptions de données et nuire aux fonctions métiers de Salesforce », ont expliqué les chercheurs dans un rapport. « C’est la raison pour laquelle il est essentiel de garder une trace des classes Apex et de leurs propriétés, de savoir qui peut les exécuter et comment elles sont utilisées ».

Des classes Apex insuffisamment restreintes

Apex est un langage de programmation orienté objet dont la syntaxe est similaire à Java et que les développeurs peuvent utiliser pour exécuter des instructions de flux et de contrôle sur les serveurs Salesforce ainsi que des appels via l’API Salesforce. Apex propose aux utilisateurs de personnaliser leurs instances Salesforce en ajoutant une logique métier supplémentaire aux événements du système, notamment les clics sur les boutons, les mises à jour d’enregistrements connexes et les pages Visualforce. « Une classe Apex est un template ou un blueprint utilisé pour créer des objets Apex », ont encore expliqué les spécialistes. « Les classes comprennent d’autres classes, des méthodes définies par l’utilisateur, des variables, des exceptions de types et un code d’initialisation statique ». Elles constituent donc un outil puissant pour les développeurs, mais il est également très important d’examiner attentivement leurs capacités et de restreindre les personnes qui peuvent y accéder.

Le code Apex peut fonctionner en deux modes « sans partage » et « avec partage ». Dans le premier, le code Apex ignore les autorisations de l’utilisateur et peut accéder à n’importe quel enregistrement et apporter des modifications, alors que dans le second, le code respecte les autorisations de l’utilisateur au niveau de l’enregistrement mais ignore celles au niveau de l’objet et du champ. Les classes Apex configurées pour fonctionner en mode « sans partage » sont parfois nécessaires pour mettre en œuvre des fonctionnalités importantes, mais elles peuvent présenter un risque sérieux, en particulier quand elles sont mises à la disposition d’invités ou d’utilisateurs externes. Parmi les problèmes les plus courants pouvant découler des classes Apex, on peut citer les références directes d’objets non sécurisées (Insecure Direct Object References, IDOR), où un attaquant peut lire, manipuler ou supprimer des tables complètes de données auxquelles il ne devrait pas avoir accès, ou l’injection SOQL ; et l’injection SOSL, où le code présente des failles qui permettent aux attaquants de manipuler les requêtes effectuées par la classe pour exfiltrer des données ou modifier le flux de processus prévu.

Vérifier l’appel des classes Apex

Les experts recommandent aux entreprises de vérifier qui peut appeler les différentes classes Apex utilisées dans leurs instances et leurs capacités, en particulier les classes qui fonctionnent en mode « sans partage ». Cette opération peut être réalisée manuellement en passant en revue chaque classe, mais ce processus prend du temps. « Pour déterminer qui peut appeler une classe Apex, il faut vérifier à la fois les profils et les ensembles de permissions (depuis Winter, si l’on clique sur « Sécurité » en examinant la classe Apex elle-même, on ne peut voir que les profils, ce qui n’est pas suffisant pour déterminer qui peut appeler une classe Apex) », mettent en garde les chercheurs. La bonne façon de procéder est d’aller d’abord dans la section « Utilisateur », puis dans « Profils », et de cocher la case « Accès activé à la classe Apex » (Enabled Apex Class Access) dans chaque profil. Ensuite, pour chaque entrée de l’option « Accès activé à la classe Apex », l’administrateur doit faire défiler la section Apps et cliquer sur l’option « Accès à la classe Apex » (Apex Class Access) pour voir les droits. En outre, pour vérifier si une classe Apex est configurée pour fonctionner « sans partage », son code source peut être examiné, car la chaîne « sans partage » se trouve dans l’une des premières lignes de la déclaration de la classe.

Le rapport Varonis comprend également des bonnes pratiques sur la manière de sécuriser le code Apex pour éviter les entrées non sécurisées qui peuvent conduire à une injection SOQL ou SOSL. Selon le modèle de responsabilité partagée, ce sont les clients de Salesforce et non Salesforce qui sont responsables de la sécurité de leur code Apex. « Une stratégie de sécurité complète devrait vérifier que les classes Apex ont été examinées par des spécialistes de la sécurité, et pas seulement par les développeurs et les administrateurs de Salesforce », ont déclaré les chercheurs. « C’est généralement le cas pour le code qui fait partie d’un paquet AppExchange, mais ce n’est pas toujours le cas pour les autres codes qui ne font pas partie d’AppExchange. Cela s’applique particulièrement au code interne, qui est souvent négligé. »

L’offensive de charme européenne de Microsoft se poursuit, avec maintenant une collaboration avec le gouvernement espagnol. Objectif : mettre en oeuvre une IA qualifiée de responsable et sécuriser les infrastructures des administrations espagnoles.

Microsoft prévoit de quadrupler ses investissements dans l’IA et le cloud en Espagne, en y dépensant 1,95 Md€ au cours des deux prochaines années. Ceci fait suite à l’engagement du CEO de Microsoft Satya Nadella à promouvoir l’innovation numérique et l’utilisation responsable de l’IA. Brad Smith, président de Microsoft, a rencontré Pedro Sánchez, président du gouvernement espagnol, pour présenter ce qui est le plus grand investissement de l’entreprise en Espagne en près de quatre décennies de présence dans le pays. Brad Smith fait le tour des nations européennes pour parler des investissements de Microsoft sur le continent. La semaine dernière, il a annoncé un plan d’investissement de 3,2 Md€ en Allemagne dans l’IA et l’infrastructure des datacenters sur deux ans.

La firme de Redmond ouvrira bientôt une région cloud près de Madrid, et a annoncé son intention de construire un campus de datacenters en Aragon qui servira aux entreprises et aux entités publiques européennes. Ces deux infrastructures doivent permettre aux services cloud de Microsoft de garantir la sécurité, la confidentialité et la souveraineté – toute relative – des données, et de mettre à la disposition des entreprises et des administrations publiques toute la gamme de solutions d’intelligence artificielle de l’éditeur. Selon une analyse d’IDC, les datacenters de Microsoft en Espagne pourraient ajouter jusqu’à 8,4 Md€ au PIB du pays et contribuer à la création de 69 000 emplois indirects sur la période 2026-2030.

Une alliance stratégique

Cet engagement d’investissement s’inscrit dans le cadre de la collaboration annoncée par Pedro Sánchez et Brad Smith. Les deux parties travailleront ensemble à l’application d’une IA responsable pour améliorer les services aux citoyens, à la promotion de l’innovation basée sur l’IA et au renforcement de la cybersécurité nationale et de la cyber-résilience des entreprises, des organismes publics et des infrastructures critiques espagnols. L’alliance stratégique a été définie dans le cadre de la stratégie nationale de l’Espagne en matière d’IA et de cybersécurité, et repose sur quatre axes fondamentaux : étendre l’utilisation de l’IA dans l’administration, promouvoir l’IA responsable, renforcer la cybersécurité nationale et enfin améliorer la cyber-résilience des entreprises. Avec l’objectif de partager les meilleures pratiques dans le but de moderniser les processus administratifs et de fournir aux fonctionnaires les outils d’IA nécessaires pour accroître leur efficacité et leur efficience. Du côté de l’administration, cela couvrira le déploiement de solutions d’IA générative et les plans de formation des fonctionnaires à l’utilisation de l’IA. Parallèlement, l’éditeur partagera avec l’Agence espagnole de supervision de l’intelligence artificielle (AESIA) ses normes de conception responsable de l’IA, ses guides de mise en œuvre et d’autres documents sur les meilleures pratiques dans ce domaine.

En outre, dans le but de renforcer la cybersécurité nationale et, en particulier, la cyber-résilience des infrastructures critiques, Microsoft et le Centre national de cryptologie du Centre national de renseignement (CNI-CCN) étudieront conjointement l’amélioration des mécanismes d’alerte précoce et de réponse aux incidents de sécurité informatique dans les administrations publiques. Le fournisseur collaborera également avec l’Institut national de cybersécurité (INCIBE) pour apporter un accès à la télémétrie et à des informations globales sur les menaces et les cyberattaques potentielles susceptibles d’affecter les entreprises et les institutions publiques espagnoles. Des actions conjointes de diffusion dans le domaine de la cybersécurité seront également mises en place à l’intention des PME et des citoyens.

Pour sécuriser les réseaux WiFi, il faut aussi se protéger contre le piratage du WiFi ou Wi-Jacking, les attaques de jumeaux maléfiques ou attaques Evil Twin et les attaques Karma.

Sécuriser efficacement les réseaux WiFi d’entreprise ne se limite pas seulement à mettre en place le dernier cryptage ou à implémenter l’authentification 802.1x. Ces protections sont certes importantes, mais bien d’autres vulnérabilités sont à prendre en compte. Pour éviter un comportement WiFi étrange ou mieux comprendre les faiblesses du spectre sans fil afin de mieux concevoir ses réseaux ou leur administration, il est important de bien comprendre ces vulnérabilités WiFi potentielles.

Écoute du trafic sans fil par les utilisateursÉtant donné que les signaux WiFi se déplacent sur les ondes, les attaquants peuvent écouter passivement les communications sans fil entre les terminaux et les points d’accès (PA), même en dehors des barrières physiques d’un établissement. Sur les réseaux non sécurisés, les attaquants peuvent capturer des informations sensibles comme des identifiants de connexion, l’historique de navigation ou d’autres données confidentielles. Sur les réseaux professionnels en particulier, un utilisateur disposant de la phrase secrète du WiFi peut espionner le trafic réseau d’un autre utilisateur et effectuer des attaques. C’est l’une des principales vulnérabilités du protocole de sécurité WPA/WPA2-Personal. Le mode Enterprise du WPA/WPA2 offre une protection contre l’espionnage d’utilisateur à utilisateur. Mais il nécessite le déploiement d’un serveur Radius ou d’un service cloud, et exige davantage de l’utilisateur ou de l’appareil client pour se connecter. C’est pourquoi de nombreux environnements d’entreprise continuent de diffuser des signaux avec la sécurité WPA/WPA2-Personal, plus simple.

Grâce au WPA3, introduit par la WiFi Alliance en 2018, l’écoute clandestine n’est plus un problème pour les réseaux et les appareils qui prennent en charge ce protocole de sécurité plus récent. Le chiffrement WPA3 (en mode Personal et Enterprise) est plus individualisé. Les utilisateurs d’un réseau WPA3 ne peuvent pas décrypter le trafic des autres utilisateurs du réseau, même si l’utilisateur possède le mot de passe WiFi et qu’il réussit à se connecter. La méthode d’authentification par clé pré-partagée (Pre-Shared Key, PSK) utilisée dans les versions antérieures du WPA est remplacée dans le WPA3 par l’authentification simultanée d’égal à égal (Simultaneous Authentication of Equals, SAE). Cela signifie que les réseaux WPA3-Personal avec des phrases secrètes simples sont beaucoup plus difficiles à pirater par des tentatives de craquage hors site, par force brute, basées sur des dictionnaires, qu’ils ne l’étaient avec le WPA/WPA2.

Attaques par déni de service (DoS)

Comme les réseaux câblés, le WiFi est sensible aux attaques par déni de service (DoS), qui peuvent submerger un réseau WiFi avec un volume de trafic excessif. Une attaque DoS peut ralentir le trafic sur un réseau WiFi ou le rendre indisponible, ce qui perturbe le fonctionnement normal du réseau, voire de l’entreprise. Il est possible de lancer une attaque DoS en générant un grand nombre de demandes de connexion ou d’authentification, ou en injectant dans le réseau d’autres pseudo-données pour casser le WiFi. Un attaquant peut également envoyer des trames de désauthentification pour déconnecter les appareils du réseau WiFi, ce qui perturbe les connexions et peut amener les appareils clients à se connecter à des points d’accès (PA) illicites. Les attaquants peuvent aussi inonder le réseau de trames de balises fausses ou malveillantes, semant la confusion parmi les appareils connectés et perturbant le fonctionnement du réseau. La prévention des attaques DoS contre le WiFi passe par la mise en œuvre de mesures de sécurité comme des systèmes de détection d’intrusion (Intrusion Detection Systems, IDS), des pare-feux et le filtrage du trafic. La mise à jour régulière des firmwares, l’utilisation d’un cryptage fort et la configuration de l’équipement réseau pour gérer un trafic excessif peuvent également contribuer à atténuer l’impact des attaques DoS. En outre, la surveillance du trafic réseau pour détecter des situations inhabituelles et la correction rapide des vulnérabilités peuvent renforcer la sécurité globale du WiFi.

Le Wi-Jacking d’appareils WiFi autorisés

On parle de « Wi-Jacking », ou de piratage du WiFi, quand un attaquant accède à un appareil connecté au réseau WiFi ou qu’il en prend le contrôle. Le pirate peut récupérer les mots de passe WiFi ou les informations d’authentification du réseau enregistrés sur l’ordinateur ou l’appareil. Il peut par ailleurs installer des logiciels malveillants, des logiciels espions ou d’autres logiciels sur l’appareil. Il peut également manipuler les paramètres de l’appareil, y compris la configuration WiFi, pour que l’appareil se connecte à des points d’accès malveillants. Pour réduire les risques de Wi-Jacking, il faut mettre en œuvre des mesures générales de sécurité informatique, par exemple, utiliser un bon antivirus et un pare-feu, sécuriser physiquement les appareils, mettre en place des dispositifs antivol et sensibiliser les utilisateurs aux attaques d’ingénierie sociale.

Interférences électromagnétiques

Les interférences électromagnétiques ou interférences RF peuvent provoquer des perturbations du WiFi. Elles ne sont pas causées par des acteurs malveillants et peuvent être déclenchées par une mauvaise conception du réseau, des changements dans les bâtiments ou d’autres appareils électroniques émettant ou s’infiltrant dans l’espace de radiofréquences. Les interférences peuvent entraîner une dégradation des performances, une réduction du débit et une augmentation de la latence. Une mauvaise conception du réseau WiFi ou des changements dans le bâtiment peuvent entraîner des problèmes d’interférence, notamment en raison du chevauchement des canaux de fréquence entre des points d’accès voisins et d’autres réseaux WiFi avoisinants. D’autres appareils sans fil qui partagent la bande passante WiFi, comme les appareils Bluetooth, les téléphones sans fil, les caméras sans fil et les moniteurs pour bébés, peuvent provoquer des interférences. Même les appareils électroniques que l’on n’imagine pas être sans fil peuvent provoquer des interférences RF, comme les fours à micro-ondes, les lampes fluorescentes et les câbles mal blindés. Il y aura toujours du bruit dans les bandes WiFi qui pourra avoir un impact sur le réseau, mais il existe des moyens d’atténuer les vulnérabilités aux interférences WiFi. Une étude professionnelle par un site RF au cours de la phase de conception peut contribuer à réduire les problèmes, de même que des études du site à l’avenir pour effectuer des vérifications. Il est également possible d’utiliser la surveillance fournie par ses points d’accès WiFi ou ses contrôleurs pour garder un œil sur la santé des bandes WiFi.

Jumeaux maléfiques et mauvais Karma

Dans un réseau WiFi, on parle de point d’accès (PA) malveillant quand un PA ou un routeur sans fil non autorisé ou illégitime a été installé sur le réseau sans le consentement explicite ou la connaissance de l’administrateur du réseau. Il peut être le fait d’employés ou de visiteurs innocents qui branchent un routeur domestique en espèrant ainsi augmenter la portée du WiFi, ou celui d’acteurs malveillants qui cherchent spécifiquement à exploiter des vulnérabilités. Il peut aussi s’agir de points d’accès mal configurés, par exemple un point d’accès légitime dont la sécurité n’est pas assurée en raison d’un dysfonctionnement ou d’un oubli de l’équipe IT. Quelle que soit la manière dont il a été inséré au réseau, un point d’accès malveillant peut introduire des vulnérabilités de sécurité, et permettre un accès non autorisé au réseau. Les attaquants peuvent exploiter cet accès pour lancer différentes attaques, par exemple intercepter des données, injecter du contenu malveillant ou accéder de manière non autorisée à des informations sensibles.

Des acteurs malveillants peuvent mettre en place des points d’accès malveillants qui imitent des réseaux légitimes et incitent les utilisateurs à s’y connecter. Cet exploit, connu sous le nom d’attaque « Evil Twin » ou « jumeau maléfique », leur permet d’intercepter et de manipuler des données. Les attaquants peuvent attendre passivement que les utilisateurs se connectent ou ils peuvent accélérer le processus en envoyant des trames de désauthentification pour déconnecter les utilisateurs du réseau réel. Les attaques KARMA exploitent le comportement par défaut de la plupart des appareils WiFi, qui se connectent automatiquement aux réseaux auxquels ils se sont connectés par le passé. Les attaquants peuvent mettre en place des points d’accès frauduleux avec des noms de réseaux (SSID) couramment utilisés, incitant les appareils à se connecter automatiquement et les exposant potentiellement à des attaques. La réalisation d’études de site professionnelles avant et après le déploiement du réseau, la recherche régulière de points d’accès non autorisés et l’utilisation de systèmes de détection des intrusions peuvent aider à identifier les points d’accès malveillants. En outre, la mise en œuvre de mesures de sécurité solides comme le cryptage WPA3, l’authentification 802.1X basée sur un certificat et la mise en œuvre de contrôles d’accès appropriés peuvent également atténuer le risque lié aux points d’accès malveillants.

Réaliser ses propres tests de pénétration WiFi

L’un des meilleurs moyens d’en savoir plus sur la sécurité des réseaux et de mieux protéger les réseaux que l’on administre est d’étudier les outils de test de pénétration. Ces derniers peuvent aider à évaluer la sécurité d’un réseau WiFi afin d’en identifier les vulnérabilités et les faiblesses. Bien entendu, il faut veiller à ne pas exploiter d’autres utilisateurs WiFi ou à ne pas attaquer des réseaux que l’on n’est pas chargé d’administrer. L’accès non autorisé aux réseaux et aux appareils est illégal et contraire à l’éthique. Les pentesteurs doivent respecter les directives légales et éthiques et s’assurer qu’ils ont l’autorisation d’évaluer la sécurité des réseaux WiFi qu’ils testent. En particulier, quand on commence à savoir utiliser les outils de test d’intrusion, il est important de bien se renseigner sur l’outil et sur ce qu’il fera avant de l’utiliser, afin de ne pas interrompre sans le savoir son propre réseau ou d’attaquer ses pairs et ses voisins.