Les terminaux avec WiFi des passagers offrent aux pirates un meilleur accès aux avions de ligne que l’avionique embarquée.

À quelles compromissions de cybersécurité les avions de ligne sont-ils les plus exposés ? Tout dépend de la partie de leurs systèmes IT dont on parle. L’équipement avionique qui fait fonctionner l’aéronef est plutôt bien protégé contre le piratage, même s’il ne résiste pas à toutes les attaques. Par contre, les systèmes d’accès à Internet à bord des avions, qui connectent les passagers au web sont aussi vulnérables aux pirates que n’importe quel réseau au sol.

L’avionique, difficile, mais pas impossible, à pirater

L’avionique englobe tous les « systèmes d’instrumentation, de télémétrie et de communication utilisés par les pilotes et le personnel navigant à bord des avions », a expliqué Patrick Kiley, consultant principal en sécurité chez Rapid7. Dans les avions modernes où ces unités sont contrôlées par ordinateur, elles sont mises en réseau et connectées au sol pour fournir des rapports réguliers de surveillance du système. Les compagnies aériennes peuvent ainsi détecter les problèmes dès qu’ils surviennent et y remédier efficacement en minimisant l’impact sur les plans de vol. Par rapport aux systèmes d’accès à Internet en vol, les systèmes avioniques en réseau sont plus difficiles à pirater. À cause en particulier de leur architecture (les réseaux avioniques ne sont pas connectés au web), aux fonctions limitées qu’ils exécutent et à leurs environnements d’exploitation généralement fermés. « Cependant, le piratage reste possible », comme l’a indiqué M. Kiley lui-même dans un document de recherche de Rapid7 de 2019 intitulé « Investigating CAN Bus Network Integrity in Avionics Systems » (Enquête sur l’intégrité du réseau CAN Bus dans les systèmes avioniques). « Les avions actuels utilisent un réseau électronique pour traduire les signaux des différents capteurs et placer ces données sur un réseau afin qu’elles soient interprétées par les instruments appropriés et affichées au pilote », a écrit M. Kiley.

Quand ce réseau physique (le « bus du véhicule ») est combiné à une norme de communication standard appelée « Controller Area Network » (CAN), il crée le « bus CAN », qui sert de système nerveux central à l’avion. « Après avoir mené une enquête approfondie sur deux systèmes avioniques disponibles dans le commerce, Rapid7 a démontré qu’il était possible pour une personne malveillante d’envoyer de fausses données à ces systèmes, à condition d’avoir un certain accès physique à un petit câblage d’un avion », a écrit M. Kiley. « Dans ce cas, un attaquant pourrait attacher un dispositif – ou prendre le contrôle d’un dispositif existant – à un bus CAN avionique afin d’injecter de fausses mesures et de les communiquer au pilote. Ces mesures erronées pourraient inclure des relevés de télémétrie moteur incorrects, des données de compas et d’attitude incorrectes, ainsi que des informations d’altitude, de vitesse et d’angle d’attaque (Angle of Attack, AoA) erronées. « Un pilote se fiant à ces relevés d’instruments ne serait pas en mesure de faire la différence entre des données erronées et des relevés légitimes, ce qui pourrait entraîner un atterrissage d’urgence ou une perte de contrôle catastrophique de l’aéronef concerné », a écrit M. Kiley. Cela étant dit, « nous tenons à souligner que cette attaque nécessite un accès physique, ce qui est très réglementé et contrôlé dans le secteur de l’aviation », a précisé le consultant en sécurité de Rapid7. « Les systèmes avioniques ont une surface d’attaque à distance limitée, du simple fait de la nature de leur architecture », a encore expliqué M. Kiley. « Les systèmes avioniques font l’objet d’un examen approfondi de la part du fabricant, de l’industrie et de la FAA, mais ces examens ne sont pas exclusivement axés sur la sécurité, mais plutôt sur la sûreté », a-t-il ajouté.

« L’amélioration de la sécurité est la raison pour laquelle les systèmes avioniques des avions modernes sont si fortement interconnectés. Mais cette tendance n’a pas été accompagnée par un renforcement de la cybersécurité », a mis en garde le groupe Thales dans un billet de blog. « Si au cours des dix dernières années, l’industrie aéronautique a récolté les fruits de la numérisation, cette numérisation a également engendré de nouveaux risques, notamment des vulnérabilités sociales et techniques qui n’avaient jamais été prises en compte auparavant », a encore écrit le groupe. Sean Reilly, vice-président de la gestion du transport aérien et des solutions numériques chez le fournisseur de services à large bande sol-air SmartSky Networks, n’est pas d’accord avec ce point de vue négatif. « Le protocole de sécurité de l’avionique est en fait très, très strict », a-t-il affirmé. Pour le contourner, un pirate informatique devrait comprendre les principes fondamentaux d’un bus ARINC 429, qui est en fait le bus de données principal d’un avion, ainsi qu’une connaissance approfondie de ce qui se trouve à l’intérieur de « la couche logicielle au-dessus de cette pièce d’avionique et être en mesure de s’y connecter », a-t-il ajouté. « Ce ne sont pas des informations que l’on peut trouver facilement ».

Le problème de l’accès à Internet en vol

Si l’on interroge des experts en cybersécurité sur les piratages connus d’avions commerciaux, il y a de fortes chances qu’ils citent en exemple le pirate informatique Chris Roberts. Selon un article paru en 2015 sur Wired.com, « Chris Roberts, chercheur en sécurité chez One World Labs, a déclaré à l’agent du FBI qui l’interrogeait en février de la même année, qu’il avait piraté le système de divertissement à bord (In-Flight Entertainment, IFE) d’un avion et écrasé le code de l’ordinateur de gestion de la poussée de l’avion alors qu’il se trouvait à bord du vol ». Une déclaration sous serment du FBI déposée par l’agent spécial Mark S. Hurley à l’appui de la saisie par le Bureau fédéral d’enquête de l’iPad, du MacBook Pro et de divers supports de stockage de Chris Roberts indique que ce dernier a piraté les systèmes IFE de divers avions commerciaux en ouvrant les boîtiers électroniques situés sous les sièges et en y connectant son ordinateur portable à l’aide d’un câble CAT6. « Il a déclaré qu’il avait réussi à commander au système auquel il avait accédé d’émettre le ‘CLB’ ou ordre de montée », indique la déclaration sous serment du FBI. « Il a déclaré qu’il avait ainsi provoqué la montée d’un des moteurs de l’avion, ce qui a entraîné un mouvement latéral de l’avion. En toute justice pour M. Roberts, les 15 à 20 piratages de l’IFE qu’il a effectués en volant sur des avions Airbus et Boeing sélectionnés entre 2011 et 2014 l’ont été « parce qu’il souhaitait que ces vulnérabilités soient corrigées », indique la déclaration sous serment du FBI. Conformément à la déclaration antérieure de M. Kiley, Chris Roberts a dû effectuer ce piratage en se connectant physiquement au réseau interne de l’avion. Depuis le développement d’avions numériquement intégrés et connectés au web, comme le Boeing 787 Dreamliner, ce n’est plus le cas. D’après une présentation/papier faite à BlackHat USA 2019 par Ruben Santamarta, alors consultant principal en sécurité chez IOActive, il est désormais possible « d’atteindre efficacement le réseau avionique d’un avion commercial à partir de domaines non critiques, comme les services d’information et de divertissement des passagers, ou même de réseaux externes ».

Du point de vue d’un RSSI, l’important n’est pas qu’une faille de sécurité spécifique ait été découverte dans un modèle d’avion particulier, mais plutôt l’idée générale que les aéronefs modernes dotés de réseaux informatiques interconnectés pourraient potentiellement permettre des intrusions dans des équipements avioniques de haute sécurité à partir de systèmes d’accès à Internet faiblement sécurisés des passagers. Dans ces conditions, il est temps que tous les systèmes embarqués – y compris l’avionique – soient considérés comme vulnérables aux cyberattaques. À ce titre, les procédures de sécurité visant à les protéger devraient être aussi complètes et approfondies « que n’importe quel autre appareil connecté à Internet », a expliqué le consultant en sécurité de Rapid7. « La divulgation publique que j’ai faite en 2019 était la première du genre à impliquer l’industrie, les compagnies aériennes et le gouvernement américain qui ont coopéré pour s’assurer qu’elle se passait de manière responsable et en suivant les meilleures pratiques de l’industrie de la sécurité. Ces modalités devraient servir d’exemple pour alerter l’industrie de manière responsable ». Malheureusement, « beaucoup de fabricants de l’industrie aéronautique ne savent pas comment travailler avec les chercheurs en sécurité et tentent d’étouffer la recherche en menaçant de prendre des mesures au lieu de collaborer pour résoudre les problèmes identifiés », a fait remarquer M. Kiley. Cette manière de répondre aux cybermenaces est contre-productive, à un moment où tous les acteurs de l’industrie sont des cibles potentielles. Après tout, « même l’armée américaine a vu ses avions autonomes piratés par des adversaires », a ajouté M. Kiley.Les avions dotés de réseaux informatiques sont vulnérables aux intrusions à partir de systèmes d’accès à Internet faiblement sécurisés des passagers.

Un système quantique pertinent sur le plan cryptographique pourrait bien mettre en péril les transactions en ligne quotidiennes. Mastercard se prépare dès aujourd’hui pour contrer cet avenir angoissant.

L’écosystème des paiements numériques est une proie facile. Les milliards de transactions effectuées en ligne chaque jour aujourd’hui sont protégées par ce que l’on appelle des technologies de chiffrement à clé publique. Toutefois, à mesure que les systèmes quantiques deviendront plus puissants, ils seront en mesure de casser ces algorithmes cryptographiques. Un tel ordinateur quantique cryptographique (CRQC pour cryptographically relevant quantum computer) pourrait avoir un impact dévastateur sur les protocoles mondiaux de cybersécurité. Pour se préparer à ce scénario catastrophe, Mastercard a lancé son projet Quantum Security and Communications. « Nous travaillons de manière proactive pour atténuer les risques futurs liés à l’informatique quantique pouvant avoir un impact sur la sécurité des milliards de transactions numériques que nous traitons à l’échelle mondiale », explique George Maddaloni, directeur technologique des opérations chez Mastercard, pour justifier l’impulsion donnée au projet.

À l’heure actuelle, les transactions en ligne que vous et moi effectuons font donc allégeance à la cryptographie à clé publique. Dans cette technique, la personne (ou l’entité) qui envoie le message le sécurise (le verrouille) à l’aide d’une clé accessible au public et l’entité qui le reçoit le déchiffre à l’aide d’une clé privée. Le principe est que, puisque seul le destinataire possède la clé privée, la transaction est sécurisée. Les clés privées sécurisées découlent d’algorithmes mathématiques – celui de Rivest-Shamir-Adleman (RSA) est un exemple courant – qu’il est impossible d’inverser et de pirater. Du moins jusqu’à ce qu’un système quantique arrive et le fasse par la force brute. Les entités des secteurs privé et public se préparent donc en suivant l’une des deux voies suivantes : travailler sur un tout nouvel ensemble d’algorithmes résistants au quantique sur lesquels baser les clés privées (cryptographie post-quantique, PQC) ou utiliser la physique quantique pour faire la même chose (distribution quantique des clés, QKD). Le projet de Mastercard se concentre sur cette dernière méthode. D’autres entreprises du secteur financier explorent également la QKD. Parallèlement, des institutions publiques telles que le National Institute of Standards and Commerce (NIST) suivent l’approche PQC « harden-the algorithms » (renforcer les algorithmes) sur lequel repose notamment le protocole Post-Quantum Extended Diffie-Hellman choisi dernièrement par Signal. Le NIST a sélectionné quatre algorithmes résistants au quantique et est en train de les normaliser. Les algorithmes définitifs devraient être disponibles au cours du premier semestre 2024 et le NIST a établi une feuille de route pour la préparation aux technologies quantiques à l’intention des entreprises.

La carte maîtresse de Mastercard

Mastercard ayant adopté la méthode de distribution des clés quantiques, son projet pilote a permis de déterminer les exigences architecturales et les limites de la QKD, ainsi que l’état de préparation opérationnelle des systèmes QKD. George Maddaloni indique que l’équipe a testé la solution de distribution de clés quantiques sur un réseau de fibres noires. Toshiba et ID Quantique ont été utilisés pour produire les clés. Deux fournisseurs de réseaux avec lesquels Mastercard a travaillé par le passé ont également été sollicités. Selon George Maddaloni, leur contribution du point de vue du réseau Ethernet IP a été utile. L’objectif était de dresser un inventaire deq capacités de mise en réseau au sein du réseau de Mastercard, qui compte des milliers de points d’extrémité connectés avec quelques capacités de télécommunication différentes. « Nous voulions vérifier si les capacités de distribution de clés quantiques fonctionnaient dans cet environnement », pointe le directeur technique.

« La disponibilité de services et d’équipements compatibles avec la technologie QKD est très spécialisée et actuellement assez limitée », poursuit George Maddaloni. Peu de fournisseurs de matériel proposent des fonctions pouvant s’intégrer aux systèmes QKD. La conception du test a également constitué un défi. La QKD exige que les photons individuels arrivent à des moments précis, et les états quantiques utilisés pour le chiffrement peuvent être facilement perturbés par des facteurs externes tels que le bruit, les changements de température et les vibrations, entre autres. « Le projet a été conçu pour relever ces défis et fournir des résultats prouvables ainsi qu’une validation du potentiel de la technologie », ajoute le CTO de Mastercard. Et il a été couronné de succès.

La grande migration à portée de qubits

Les questions de cybersécurité telles que celles abordées par Mastercard sont essentielles, car elles touchent aux fondements mêmes du système que les institutions financières ont construit. « La sécurité des transactions et la confiance de nos clients sont l’épine dorsale de notre activité », souligne par ailleurs George Maddaloni. « L’impact de la compromission des méthodes actuelles de chiffrement PKI pourrait littéralement menacer notre capacité à opérer en toute sécurité […]. Nous pensons qu’être prêts pour un paysage post-quantique fait partie de notre travail et envoie le bon message à nos partenaires, à nos clients et aux régulateurs ». De son côté Jeff Miller, DSI et premier vice-président des technologies de l’information et de la sécurité chez Quantinuum, une société de services orientés quantiques, reconnaît que la protection des données est vitale, car « il s’agit d’un contrat de confiance avec le consommateur ». Pour devenir « crypto-agile», il faut se rendre compte que les acteurs malveillants sont de plus en plus créatifs dans la manière dont ils s’introduisent dans les environnements. Les entreprises doivent donc continuer à mettre en place un processus itératif et à développer des protocoles pour remédier à ces vulnérabilités. Alors que des établissements financiers tels que Mastercard se préparent en utilisant leurs propres projets pilotes, le comité de normalisation de l’industrie X9 travaille également sur des orientations pour les entreprises du secteur financier, souligne Dustin Moody, un mathématicien qui dirige le projet de cryptographie post-quantique à l’Institut national des normes et de la technologie (NIST).

Les experts admettent que le chemin à parcourir n’est pas facile. « La disponibilité des services et des équipements de distribution de clés quantiques est encore très limitée. Certains des fournisseurs de matériel avec lesquels nous avons travaillé proposent des fonctions qui viennent d’être annoncées et sont très récentes sur le marché, et certaines n’ont même pas encore été mises à disposition », explique par ailleurs George Maddaloni. « Je pense que le secteur comprend que les services financiers auront besoin de cette capacité à l’avenir ». Dustin Moody conseille de son côté aux entreprises d’affiner leur préparation post-quantique en dépit d’un paysage qui peut sembler décourageant. La première chose à faire ? « Vous devez trouver toutes les instances de cryptographie à clé publique, ce qui est délicat et prendra du temps pour faire cet inventaire », prévient Dustin Moody. « Il s’agira d’une migration complexe qui prendra du temps […] c’est pourquoi nous encourageons les organisations à prendre de l’avance dès qu’elles le peuvent ». Un avis partagé par Jeff Miller qui compare le processus à la préparation du passage à l’an 2000, lorsque les entreprises s’inquiétaient du formatage et du stockage des informations au-delà de l’an 2000. La migration vers la préparation post-quantique a même un acronyme accrocheur similaire : Y2Q. Selon ce dernier, la différence essentielle réside dans le fait qu’il existait un compte à rebours fixe pour le passage à l’an 2000. L’ordinateur quantique pertinent sur le plan cryptographique n’est pas là aujourd’hui, mais il pourrait l’être dans cinq ans. Ou dans dix ans. « Le fait de savoir que nous n’avons pas de date précise pour le moment où nos méthodes de chiffrement actuelles ne seront plus utiles », avance Jeff Miller. « C’est ce qui m’empêche de dormir la nuit ».

Des chercheurs de Microsoft a trouvé des bugs dans la bibliothèque ncurses. L’exploitation de ces vulnérabilités donne aux attaquants la capacité d’obtenir un accès non autorisé aux systèmes et aux données en modifiant la mémoire d’un programme.

Plusieurs vulnérabilités de corruption de mémoire ont été découvertes par Microsoft dans la bibliothèque ncurses. Celle-ci fournit un environnement de programmation pour écrire des interfaces utilisateur basées sur le texte (Text-based User Interfaces, TUI) ou des applications de console avec une apparence graphique. Désignées collectivement sous la référence CVE-2023-29491, ces vulnérabilités, affectées d’un score CVSS de 7,8, peuvent permettre à des attaquants d’obtenir un accès non autorisé aux systèmes et aux données en modifiant la mémoire d’un programme.

« Les correctifs pour ces vulnérabilités ont été déployés avec succès par les responsables de la bibliothèque ncurses, Thomas E. Dickey, dans le commit 20230408 », a déclaré Microsoft dans un billet de blog. « Nous avons également travaillé avec Apple pour résoudre les problèmes spécifiques à macOS liés à ces failles. Nous remercions à ce sujet Gergely (Kalman) pour sa contribution et l’engagement de la communauté ». Les brèches liées à la corruption de mémoire peuvent être exploitées dans divers types d’attaques, dont le déni de service distribué (DDoS), l’escalade des privilèges, l’exécution de code arbitraire et la fuite d’informations sensibles.

Attaques par empoisonnement des variables

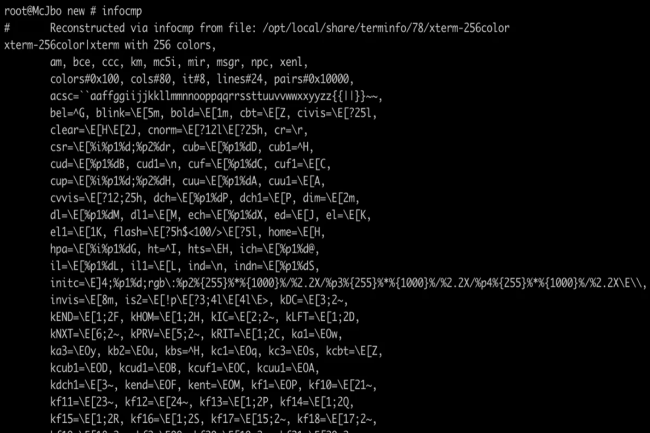

« La bibliothèque ncurses utilise des bases de données de terminaux pour être indépendante du terminal (il n’est pas nécessaire de connaître à l’avance les capacités du terminal) », a indiqué Microsoft. Cela signifie que la bibliothèque a accès à un ensemble d’informations clés concernant le terminal utilisé. « Les bases de données de terminaux contiennent un ensemble de capacités qui déterminent en fin de compte les caractères de contrôle envoyés au terminal (ordonnant au terminal d’effectuer des interactions de base) et en décrivent diverses propriétés », a déclaré Microsoft. Pendant son enquête, la firme a découvert qu’au cours de l’initialisation, la bibliothèque ncurses recherchait plusieurs variables d’environnement, dont TERMINFO pour les bases de données de terminaux. TERMINFO peut être manipulé pour pointer vers un répertoire arbitraire afin d’exploiter potentiellement les failles de ncurses.

HOME, une autre variable d’environnement utilisée par ncurses, peut être également manipulée avec des techniques similaires. « Chaque système d’exploitation moderne contient un ensemble de variables d’environnement pouvant affecter le comportement des programmes », a déclaré Microsoft. Une technique bien connue des attaquants consiste à manipuler ces variables d’environnement pour amener les programmes à effectuer des actions qui profiteraient à leurs objectifs malveillants, c’est-à-dire à les « empoisonner ».

Les versions 6.4 et antérieures affectées

C’est suite à un audit de code et à un fuzzing que Microsoft a découvert les bug La firme a précisé que les contributions en privé de Gergely Kalman sur Twitter l’avaient aidé à faire avancer la recherche avec plusieurs cas d’usage. Microsoft fait également remarquer que bien que l’audit ait été réalisé sur la dernière version 6.4 de ncurses, des versions antérieures de la bibliothèque peuvent aussi comporter quelques-unes ou toutes ces vulnérabilités.

« Il est intéressant de noter que, si que la version de ncurses que nous avons vérifiée était la 6.4 (la plus récente au moment de la recherche), la version de ncurses sur macOS était la 5.7, mais elle avait reçu plusieurs correctifs de sécurité de la part d’Apple », a déclaré Microsoft. « Néanmoins, toutes nos conclusions sont vraies pour toutes les versions de ncurses, donc, y compris les versions Linux et macOS ». Microsoft recommande d’utiliser Microsoft Defender pour détecter et protéger les abus potentiels des bases de données TERMINFO sur Linux et macOS.

Juste avant le tunnel de l’automne, nous vous proposons de découvrir le 19e numéro du magazine du Monde Informatique. Dans cette édition, vous retrouverez un dossier sur les clouds dédiés à un secteur d’activité – comme la santé accompagné des certifications propres à ce domaine, verticalisé en s’aidant du logiciel, ou encore pour répondre à un besoin métier précis dans l’entreprise – des retours d’expérience comme l’utilisation de la technologie RTC chez Mercedes F1, et des témoignages de DSI et de responsables informatiques comme Sandrine Lorne, directrice de la relation client et marketing de la CNAM.

Avant dernier numéro de l’année avant notre attendu spécial tendances technologiques 2024 LMI Mag 19 revient sur les stratégies cloud des DSI français, avec la mise en perspective d’Andy Nallapan, CTO de Broadcom sur le point d’acquérir le spécialiste de la virtualisation et du cloud computing VMware.

Dans ce numéro 19, vous retrouverez :

– Un entretien avec Pauline Flament, la Chief Technology Officer de Michelin: « Nous avons été rattrapés par la réalité cloud first »

– Un point avec Sandrine Lorne, directrice de la relation client et marketing de la CNAM : « Nous travaillons de plus en plus sur la connaissance des assurés »

– L’avis éclairé de Carl Eschenbach, co-CEO de Workday : « Nous avons l’ambition d’atteindre 10 Md$ de chiffres d’affaires ».

– Dossier : Des clouds dédiés pour accompagner un secteur d’activité

– Retour d’expérience : Gigafactory : comment la DSI d’ACC a construit un système d’information en partant de zéro

– Retour d’expérience : L’écurie Mercedes F1 utilisait Teamviewer plusieurs années avant son partenariat

– Retour d’expérience : Nissan accélère dans le PLM pour ses logiciels embarqués

– Focus : Erasure coding, plus efficace que le RAID pour la redondance du stockage

Investigation sur les incidents améliorée par l’IA, développement d’applications no-code, XDR, protection des données, gestion de l’exposition et fonctions d’automatisation de l’IT, telles sont quelques-unes des capacités ajoutées à la suite Falcon de CrowdStrike.

Baptisée Falcon Raptor par l’entreprise de sécurité, cette version remaniée de la plateforme Falcon s’enrichit notamment de capacités d’enquête sur les incidents alimentées par de l’IA générative et de fonctions de détection et de réponse étendues (XDR). Selon CrowdStrike, Raptor, qui peut fonctionner à l’échelle du pétaoctet, collecte, recherche et stocke les données plus rapidement. CrowdStrike a également présenté Falcon Foundry, « première plateforme de développement d’applications no-code de l’industrie de la cybersécurité », selon l’entreprise.

« Foundry est capable de créer rapidement des applications no-code avec un accès complet aux données et aux renseignements sur les menaces dans l’ensemble de la plateforme Falcon », a affirmé CrowdStrike qui a annoncé par ailleurs des améliorations de sa plateforme Falcon unifiée dans les domaines de la protection des données, de la gestion de l’exposition et de l’automatisation de l’IT.

Focus sur l’IA et sur l’XDR

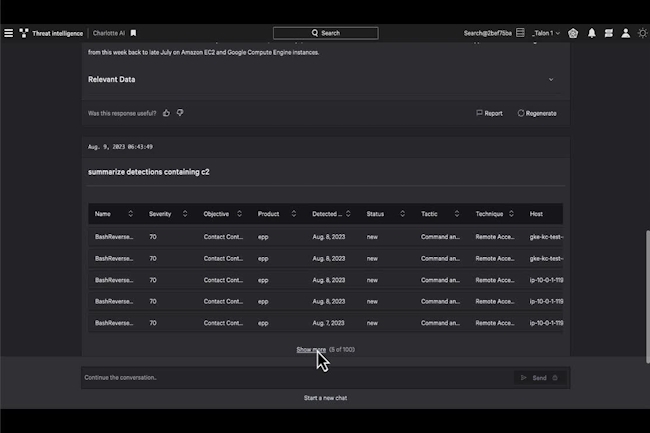

L’offre CrowdStrike comprend d’autres ajouts de composants. Ainsi, Charlotte AI Investigator est un outil alimenté par l’IA automatise la création et l’investigation des incidents. Selon la société, il peut automatiquement corréler le contexte associé en un seul incident à partir d’une « graine » d’informations. Il génère ensuite un résumé de l’incident pour les analystes de la sécurité. De son côté, XDR for All est un composant proposant essentiellement aux clients EDR de CrowdStrike de passer à la version native de XDR pour accélérer les enquêtes.

La fonctionnalité XDR Incident Workbench offre à l’utilisateur une autre expérience de l’EDR/XDR et sa rapidité accélère les temps d’enquête et de réponse. Collaborative Incident Command Center fournit une « source unifiée de vérité » aux analystes de la sécurité pour travailler sur des incidents en temps réel depuis n’importe quel endroit. Crowdstrike promet également des recherches plus rapides sur de grands ensembles de données avec une latence inférieure à la seconde, de façon à identifier plus rapidement les adversaires et les risques. Le déploiement de la version Raptor pour tous les clients actuels de l’éditeur démarrera ce mois-ci et se poursuivra l’année prochaine.

Du développement no-code sécurisé avec Falcon Foundry

La plateforme de développement d’applications no-code Foundry s’appuie sur d’autres outils de la famille de produits Falcon pour créer des applications personnalisées destinées à résoudre des problèmes de sécurité et d’IT. Selon l’entreprise, la solution exploite les données de la plateforme CrowdStrike, le framework Falcon Fusion SOAR et l’infrastructure cloud. Les applications créées dans Foundry s’intègrent à la plateforme Falcon.

Parmi les caractéristiques de Foundry, CrowdStrike met en avant :

– Une interface intuitive : la solution peut guider les utilisateurs tout au long du processus de développement d’applications grâce à des instructions étape par étape et à un studio d’application visuel de type « glisser-déposer ».

– Un accès complet aux données et aux renseignements sur les menaces de la plateforme Falcon, y compris la télémétrie de tiers stockée dans le SIEM Falcon LogScale Next-Gen.

– Une automatisation avec réponse de bout en bout : Les scripts Falcon Fusion et Falcon Real Time Response (RTR) fonctionnent ensemble pour définir des flux de travail automatisés et exécuter une réponse rapide sur les terminaux et au-delà.

Une plateforme élargie

Pour éviter que les clients se laissent tenter par des solutions ponctuelles, CrowdSrike a apporté trois améliorations à sa plateforme Falcon unifiée :

– Falcon Data Protection : remplacera les outils de prévention des pertes de données. La fonction fournit un agent unique pour la protection des données et la sécurité des terminaux. Elle étend également le champ de l’EDR/XDR de la compromission initiale à l’exfiltration des données. « Falcon Data Protection est capable de créer des politiques de suivi du contenu à mesure qu’il se déplace dans les fichiers ou les applications SaaS », a affirmé l’entreprise.

– Falcon Exposure Management : selon l’éditeur, cette fonction offre « une visibilité sur chaque actif et une évaluation en temps réel des risques internes et externes ». Elle utilise les agents CrowdStrike existants pour les points d’extrémité et la gestion native de la surface d’attaque externe (External Attack Surface Management, EASM). Elle permet aussi la visibilité et la gestion des vulnérabilités des tiers dans les mêmes flux de travail que les vulnérabilités internes.

Parmi les autres fonctions de la plateforme Falcon unifiée, on peut citer la visualisation des chemins d’intrusion des adversaires et l’évaluation des paramètres de configuration critiques. Falcon for IT automatise les flux de travail de l’IT et de la sécurité dans un « cycle de vie de bout en bout, de la visibilité à l’action ». Il s’appuie sur l’outil Charlotte AI de CrowdStrike pour générer des requêtes et des actions à partir d’invites d’IA génératives en langage clair. L’entreprise affirme qu’elle peut surveiller en permanence les points d’extrémité gérés par CrowdStrike et automatiser la remédiation sur ces points d’extrémité.

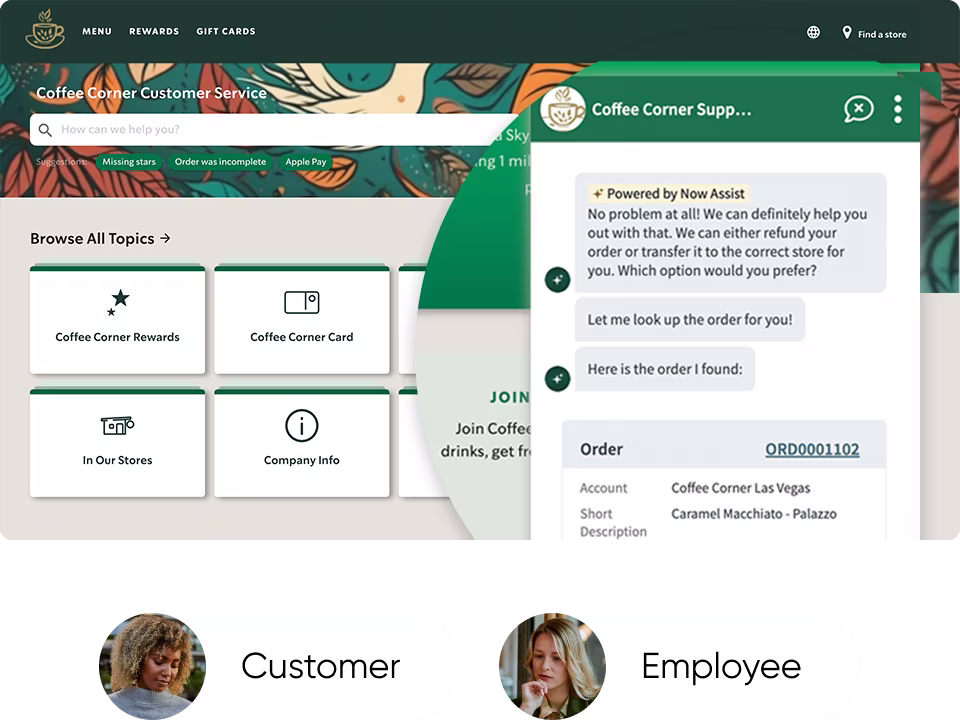

ServiceNow a présenté l’édition Vancouver de la plateforme Now. La fonction Assist à base d’IA générative se greffe sur les différents flux de travail et sera complètement effective le 29 septembre prochain.

Avec l’ajout d’Assist à Vancouver, la dernière itération de Now, ServiceNow infuse de l’IA générative aux trois principaux flux de travail pris en charge par sa plateforme, IT Service Management, Customer Service Management, et HR Service Delivery. Il apportera des fonctions de création de texte et de résumé en complément du chatbot. La solution Assist (renforcée en juillet dernier) s’appuie sur Now LLM, développé par le fournisseur, même si les entreprises peuvent connecter des LLM tiers ou leurs propres modèles. Vancouver propose par ailleurs des outils d’automation et de sécurité.

Un effort sur l’interface utilisateur

Une chose est sûre, les interfaces des chatbot d’IA générative sont épurées et certains considèrent qu’il s’agit d’un retour à la ligne de commande. Un comble au moment où les entreprises développent des applications avec un UX soigné. ServiceNow a donc mené un effort sur ce point. « Notre approche est double », a déclaré Amy Lokey, vice-présidente senior de l’expérience produit chez ServiceNow. Elle ajoute, « pour accéder à l’IA générative, les utilisateurs peuvent choisir entre des capacités contextuelles in-app, ou un panneau d’analyse situé sur la droite ». En cliquant sur un bouton dans l’interface web de Now Platform, les utilisateurs peuvent demander par exemple de générer un résumé d’une affaire en cours dans Now Assist for HRSD ou la discussion d’un agent avec un client pour mettre à jour un dossier dans Now Assist for ITSM.

Un exemple de cas d’usage d’Assist. (Crédit : ServiceNow)

Dans ces flux de travail, ils peuvent interagir avec l’interface de chat dans un autre panneau d’analyse, présent à droite de l’écran. « L’utilisateur pourra profiter de cette aide tout le temps qu’il navigue dans les applications de la plateforme », a déclaré Amy Lokey. « Elle peut même l’aider à passer d’une partie à l’autre de la plateforme. La saisie n’est peut-être pas ce qu’il y a de plus rapide, mais c’est une façon assez universelle de s’engager. L’un des avantages de l’interface texte et frappe au clavier, c’est qu’elle peut être utilisée avec la saisie vocale et les lecteurs d’écran », a-t-elle ajouté.

Aide au codage

Cette assistance peut aussi intéresser les entreprises qui souhaitent mettre en place leurs propres flux de travail. Now Assist for Creator vise à aider les équipes de développement à élaborer des processus plus rapidement grâce à ses capacités de conversion de texte en code. Ceux-ci peuvent prendre en compte des descriptions de fonctions en langage naturel et suggérer des fragments de code, voire un code complet.

Assist dispose de la capacité de coder. (Crédit : ServiceNow)

Selon Jon Sigler, vice-président de Platform, ServiceNow dispose d’un avantage, car le fournisseur a formé son LLM spécifique à son domaine sur sa propre base de données de gestion de configuration (Configuration Management Database, CMDB), son catalogue de services et sa façon spécifique d’écrire JavaScript. « Pour toutes ces raisons, un LLM spécifique à un domaine permet d’obtenir un meilleur résultat », a-t-il déclaré. « Ils sont en fait plus rapides, moins chers et plus sûrs. Si l’on a besoin de connaissances spécifiques à un domaine pour ServiceNow, il faut construire son propre LLM ».

Le coût en question

Les dernières fonctions d’IA générative ont un coût. Les entreprises devront payer pour utiliser l’un des packs complémentaires « Professional Plus » ou « Enterprise Plus » en fonction de son flux de travail. Ce pack comprendra un ensemble d’« assistances » ou d’ « appels » pour la fonctionnalité d’IA souhaitée. Les assistances seront comptabilisées indépendamment du fait qu’une entreprise utilise le LLM de ServiceNow, un LLM hébergé par un fournisseur comme OpenAI, ou un LLM propre, et une fois le forfait épuisé, les entreprises devront payer à nouveau. « Nous sommes très généreux sur le nombre d’assistances », a déclaré M. Sigler. « 80 à 90 % de nos clients seront satisfaits du nombre d’interactions que nous autorisons avec ces LLM ». Ce dernier est convaincu que les 10 à 20 % de clients de ServiceNow confrontés à des frais supplémentaires en auront pour leur argent :

« La valeur pour le client est vraiment énorme », a-t-il affirmé. Pour Stephen Elliot, vice-président du groupe IDC sur les opérations cloud et devops, le coût n’est pas un obstacle majeur, car il y a beaucoup d’autres aspects de l’IA générative à prendre en compte en premier. « Les DSI doivent disposer d’un plan d’affaires et de gouvernance spécifique pour équilibrer et accepter les risques et les avantages de l’IA », a déclaré le consultant. « Le prix du produit n’est qu’un aspect. Il y a aussi la dotation en personnel, l’acquisition des compétences, l’implication des partenaires, l’exposition juridique et l’atténuation des risques ». Le modèle d’IA utilisé a aussi son importance : « Les modèles généralistes peuvent apporter une certaine valeur ajoutée, mais les modèles spécifiques en proposent une plus importante ».

Pas de beta ou d’alpha pour Assist

La disponibilité de la version Vancouver de Now Platform et de ses modules complémentaires Assist est prévue pour le 29 septembre 2023. Selon Jon Sigler, ServiceNow pourrait bien être le premier fournisseur à rendre l’IA générative réellement disponible pour les clients. « D’après ce que j’entends, beaucoup d’entreprises en sont au stade alpha ou bêta de leur développement », a-t-il déclaré. « Dans les faits, notre service sera généralement disponible et commercialisé le 29 septembre », ajoute-t-il.

Il n’a peut-être pas tort : si des fournisseurs de plateformes comme OpenAI proposent des composants d’IA générative depuis un certain temps, d’autres éditeurs ont adopté une approche plus prudente. La semaine dernière, Salesforce a annoncé à grand renfort de publicité son intention de mettre son assistant Einstein Copilot à la disposition de sa plateforme cloud, mais seulement à un nombre limité de clients, avant la fin de l’année. Stephen Elliot d’IDC estime « qu’il est trop tôt pour dire s’il y a un avantage à être le premier à agir, car c’est un marathon, pas un sprint ».

Autres évolutions de Vancouver

L’IA générative n’est pas la seule évolution de Vancouver. La plateforme offre aussi des capacités d’automatisation pour les prestataires de santé et les équipes RH et du secteur de la finance, et propose une autre approche de la sécurité des applications. C’est le cas de la fonctionnalité Zero Trust Access pour ServiceNow Vault, qui propose aux entreprises d’ajouter des politiques d’authentification granulaires pour accéder à leurs données, d’évaluer le risque en fonction de l’emplacement, du réseau, de l’appareil et de l’utilisateur, et de limiter l’accès aux données en conséquence. ServiceNow a aussi étendu les fonctions de son outil de gestion des risques des tiers. Désormais, davantage d’employés pourront l’utiliser pour évaluer la sécurité des applications.

Par ailleurs, les entreprises du secteur de la santé disposeront d’un processus d’automatisation pour la gestion des appareils cliniques qui aidera les équipes chargées de la maintenance des équipements médicaux à suivre leur travail et à commander les pièces nécessaires. Enfin, pour le secteur de la finance, le fournisseur a amélioré ses processus Source to Pay Operations avec l’ajout de la fonction Accounts Payable Operations qui numérisera la réception des factures, leur rapprochement et leur paiement. « ServiceNow espère ainsi réduire le coût du traitement manuel des factures de 16 dollars HT à moins de 3 dollars HT », a déclaré Amy Lokey.

ServiceNow a présenté l’édition Vancouver de la plateforme Now. La fonction Assist à base d’IA générative se greffe sur les différents flux de travail et sera complètement effective le 29 septembre prochain.

Avec l’ajout d’Assist à Vancouver, la dernière itération de Now, ServiceNow infuse de l’IA générative aux trois principaux flux de travail pris en charge par sa plateforme, IT Service Management, Customer Service Management, et HR Service Delivery. Il apportera des fonctions de création de texte et de résumé en complément du chatbot. La solution Assist (renforcée en juillet dernier) s’appuie sur Now LLM, développé par le fournisseur, même si les entreprises peuvent connecter des LLM tiers ou leurs propres modèles. Vancouver propose par ailleurs des outils d’automation et de sécurité.

Un effort sur l’interface utilisateur

Une chose est sûre, les interfaces des chatbot d’IA générative sont épurées et certains considèrent qu’il s’agit d’un retour à la ligne de commande. Un comble au moment où les entreprises développent des applications avec un UX soigné. ServiceNow a donc mené un effort sur ce point. « Notre approche est double », a déclaré Amy Lokey, vice-présidente senior de l’expérience produit chez ServiceNow. Elle ajoute, « pour accéder à l’IA générative, les utilisateurs peuvent choisir entre des capacités contextuelles in-app, ou un panneau d’analyse situé sur la droite ». En cliquant sur un bouton dans l’interface web de Now Platform, les utilisateurs peuvent demander par exemple de générer un résumé d’une affaire en cours dans Now Assist for HRSD ou la discussion d’un agent avec un client pour mettre à jour un dossier dans Now Assist for ITSM.

Un exemple de cas d’usage d’Assist. (Crédit : ServiceNow)

Dans ces flux de travail, ils peuvent interagir avec l’interface de chat dans un autre panneau d’analyse, présent à droite de l’écran. « L’utilisateur pourra profiter de cette aide tout le temps qu’il navigue dans les applications de la plateforme », a déclaré Amy Lokey. « Elle peut même l’aider à passer d’une partie à l’autre de la plateforme. La saisie n’est peut-être pas ce qu’il y a de plus rapide, mais c’est une façon assez universelle de s’engager. L’un des avantages de l’interface texte et frappe au clavier, c’est qu’elle peut être utilisée avec la saisie vocale et les lecteurs d’écran », a-t-elle ajouté.

Aide au codage

Cette assistance peut aussi intéresser les entreprises qui souhaitent mettre en place leurs propres flux de travail. Now Assist for Creator vise à aider les équipes de développement à élaborer des processus plus rapidement grâce à ses capacités de conversion de texte en code. Ceux-ci peuvent prendre en compte des descriptions de fonctions en langage naturel et suggérer des fragments de code, voire un code complet.

Assist dispose de la capacité de coder. (Crédit : ServiceNow)

Selon Jon Sigler, vice-président de Platform, ServiceNow dispose d’un avantage, car le fournisseur a formé son LLM spécifique à son domaine sur sa propre base de données de gestion de configuration (Configuration Management Database, CMDB), son catalogue de services et sa façon spécifique d’écrire JavaScript. « Pour toutes ces raisons, un LLM spécifique à un domaine permet d’obtenir un meilleur résultat », a-t-il déclaré. « Ils sont en fait plus rapides, moins chers et plus sûrs. Si l’on a besoin de connaissances spécifiques à un domaine pour ServiceNow, il faut construire son propre LLM ».

Le coût en question

Les dernières fonctions d’IA générative ont un coût. Les entreprises devront payer pour utiliser l’un des packs complémentaires « Professional Plus » ou « Enterprise Plus » en fonction de son flux de travail. Ce pack comprendra un ensemble d’« assistances » ou d’ « appels » pour la fonctionnalité d’IA souhaitée. Les assistances seront comptabilisées indépendamment du fait qu’une entreprise utilise le LLM de ServiceNow, un LLM hébergé par un fournisseur comme OpenAI, ou un LLM propre, et une fois le forfait épuisé, les entreprises devront payer à nouveau. « Nous sommes très généreux sur le nombre d’assistances », a déclaré M. Sigler. « 80 à 90 % de nos clients seront satisfaits du nombre d’interactions que nous autorisons avec ces LLM ». Ce dernier est convaincu que les 10 à 20 % de clients de ServiceNow confrontés à des frais supplémentaires en auront pour leur argent :

« La valeur pour le client est vraiment énorme », a-t-il affirmé. Pour Stephen Elliot, vice-président du groupe IDC sur les opérations cloud et devops, le coût n’est pas un obstacle majeur, car il y a beaucoup d’autres aspects de l’IA générative à prendre en compte en premier. « Les DSI doivent disposer d’un plan d’affaires et de gouvernance spécifique pour équilibrer et accepter les risques et les avantages de l’IA », a déclaré le consultant. « Le prix du produit n’est qu’un aspect. Il y a aussi la dotation en personnel, l’acquisition des compétences, l’implication des partenaires, l’exposition juridique et l’atténuation des risques ». Le modèle d’IA utilisé a aussi son importance : « Les modèles généralistes peuvent apporter une certaine valeur ajoutée, mais les modèles spécifiques en proposent une plus importante ».

Pas de beta ou d’alpha pour Assist

La disponibilité de la version Vancouver de Now Platform et de ses modules complémentaires Assist est prévue pour le 29 septembre 2023. Selon Jon Sigler, ServiceNow pourrait bien être le premier fournisseur à rendre l’IA générative réellement disponible pour les clients. « D’après ce que j’entends, beaucoup d’entreprises en sont au stade alpha ou bêta de leur développement », a-t-il déclaré. « Dans les faits, notre service sera généralement disponible et commercialisé le 29 septembre », ajoute-t-il.

Il n’a peut-être pas tort : si des fournisseurs de plateformes comme OpenAI proposent des composants d’IA générative depuis un certain temps, d’autres éditeurs ont adopté une approche plus prudente. La semaine dernière, Salesforce a annoncé à grand renfort de publicité son intention de mettre son assistant Einstein Copilot à la disposition de sa plateforme cloud, mais seulement à un nombre limité de clients, avant la fin de l’année. Stephen Elliot d’IDC estime « qu’il est trop tôt pour dire s’il y a un avantage à être le premier à agir, car c’est un marathon, pas un sprint ».

Autres évolutions de Vancouver

L’IA générative n’est pas la seule évolution de Vancouver. La plateforme offre aussi des capacités d’automatisation pour les prestataires de santé et les équipes RH et du secteur de la finance, et propose une autre approche de la sécurité des applications. C’est le cas de la fonctionnalité Zero Trust Access pour ServiceNow Vault, qui propose aux entreprises d’ajouter des politiques d’authentification granulaires pour accéder à leurs données, d’évaluer le risque en fonction de l’emplacement, du réseau, de l’appareil et de l’utilisateur, et de limiter l’accès aux données en conséquence. ServiceNow a aussi étendu les fonctions de son outil de gestion des risques des tiers. Désormais, davantage d’employés pourront l’utiliser pour évaluer la sécurité des applications.

Par ailleurs, les entreprises du secteur de la santé disposeront d’un processus d’automatisation pour la gestion des appareils cliniques qui aidera les équipes chargées de la maintenance des équipements médicaux à suivre leur travail et à commander les pièces nécessaires. Enfin, pour le secteur de la finance, le fournisseur a amélioré ses processus Source to Pay Operations avec l’ajout de la fonction Accounts Payable Operations qui numérisera la réception des factures, leur rapprochement et leur paiement. « ServiceNow espère ainsi réduire le coût du traitement manuel des factures de 16 dollars HT à moins de 3 dollars HT », a déclaré Amy Lokey.

Selon un dernier rapport de l’Institut Ponemon et de DTEX Systems, le coût des menaces de cybersécurité causées par des salariés de l’entreprise a augmenté au cours de l’année 2023.

Les pertes financières potentielles liées aux incidents de sécurité causés par des personnes internes à l’entreprise – intentionnelles ou accidentelles – sont en forte augmentation, car les sociétés continuent à mal appréhender cette menace. Selon un rapport de Ponemon Institute publié par DTEX Systems, fournisseur de technologies de gestion des risques basées sur l’IA, les entreprises sous-financent généralement leurs programmes de lutte contre le risque d’intrusion, dépensant environ 200 dollars par employé pour ce type de sécurité. « Le financement est involontairement mal orienté en partie à cause d’une incompréhension généralisée des risques provenant de l’interne et de la façon dont ils se manifestent sur la base de comportements d’alerte précoce », indique l’étude. « Une approche globale de l’industrie est nécessaire pour éduquer et trouver un terrain d’entente sur la façon dont nous définissons et discutons des risques internes avec les entreprises et les entités gouvernementales ».

Le rapport, qui s’appuie sur une enquête menée auprès de plus de 1 000 décideurs dans le domaine des technologies de l’information et de la sécurité informatique, révèle que 58 % des personnes interrogées estiment que ce montant n’est pas suffisant. Selon le rapport, les conséquences de cette sous-utilisation des budgets pourraient être graves. Le coût total moyen d’un risque provoqué par l’interne est passé de 15,4 M$ en 2022 à 16,2 M$ en 2023, tandis que le nombre moyen de jours nécessaires pour contenir une menace de sécurité provenant d’un salarié est passé de 85 à 86 au cours de la même période.

Des erreurs et négligences qui coûtent chers

Ponemon Institute a classé les menaces internes en trois catégories. Premièrement, les menaces dues à des collaborateurs malveillants qui cherchent à nuire à l’entreprise, comme des employés mécontents. Deuxièmement, les menaces dues à un attaquant extérieur qui a compromis un employé vulnérable, qui s’est fait avoir par une escroquerie par hameçonnage ou autre. Enfin, dans la catégorie la plus coûteuse, le rapport décrit les cas de négligence ou d’erreur de la part de salariés qui ont ignoré les avertissements des systèmes de sécurité ou qui ont mal configuré un système.

Plus de la moitié, soit 55 %, des sommes consacrées à la réponse aux incidents d’initiés ont été affectées à des problèmes causés par des négligences ou des erreurs, contre 20 % pour les nouvelles attaques qui ont simplement déjoué les plans du personnel de l’entreprise ou des services informatiques, et 25 % pour celles causées par des employés activement malveillants. Selon les auteurs du rapport, les équipes de sécurité pourraient donc économiser beaucoup d’argent en se concentrant sur la détection et la prévention, au lieu d’être obligées de consacrer leurs budgets à la remédiation. Dans l’estimation finale, l’étude a révélé que seulement 10 % des budgets de gestion des risques liés aux personnes internes aux entreprises étaient consacrés aux dépenses préalables à l’incident, soit environ 64 000 dollars par incident. Les 565 363 dollars restants par incident ont été consacrés au confinement, à la remédiation, à l’investigation, à la réponse à l’incident et à l’escalade.

Des chercheurs de Cisco ont détecté des backdoor qui se font passer pour des composants de l’agent Cortex XDR de Palo Alto Networks. La cible est un opérateur télécom pour toucher ses clients.

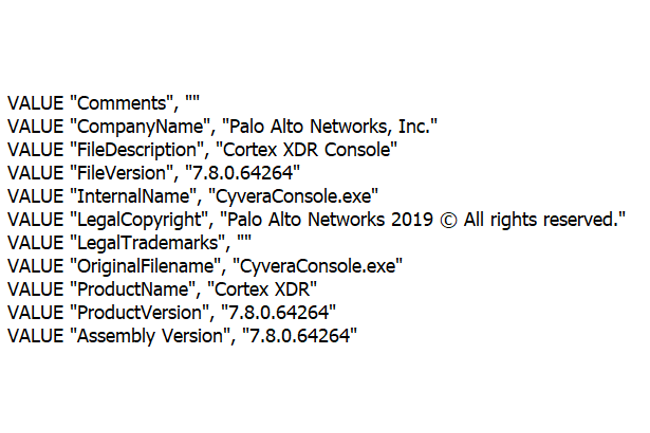

La série de backdoors découverte par des chercheurs en sécurité a été utilisée pour compromettre un opérateur de télécommunications au Moyen-Orient. On ne sait pas encore si ces programmes sont liés à un groupe de cyberattaques connu, mais ces dernières années, beaucoup d’acteurs étatiques ont ciblé des telcos, car leurs équipements réseaux peuvent servir de passerelles vers d’autres entreprises. C’est la première fois que les deux portes dérobées baptisées HTTPSnoop et PipeSnoop par les chercheurs de Cisco Talos sont mises en évidence, mais elles ont été créées par des attaquants ayant une bonne connaissance des rouages de Windows. Elles se font passer pour des composants du client de sécurité pour points d’extrémité Cortex XDR de Palo Alto Networks.

HTTPSnoop : un backdoor pour les serveurs ouverts sur Internet

En général, HTTPSnoop est déployé sous forme d’une DLL malveillante en utilisant des techniques de détournement de DLL, c’est-à-dire en incitant une application légitime à la charger en lui donnant un nom et un emplacement spécifiques. Une fois exécutée, elle utilise des API Windows de bas niveau pour accéder au périphérique HTTP dans le noyau et commencer à écouter les requêtes HTTP spécialement conçues. Le backdoor s’enregistre en tant que listener pour des URL spécifiques, auxquelles les attaquants peuvent ensuite envoyer des requêtes avec un mot-clé spécifique dans l’en-tête. Lorsqu’il reçoit de telles requêtes, HTTPSnoop décode le corps de la requête et en extrait un shellcode qu’il exécute ensuite sur le système. Les chercheurs de Talos ont trouvé plusieurs versions de cette porte dérobée, la seule différence résidant dans les URL qu’elles écoutent. L’une des versions s’enregistre en tant que listener d’URL HTTP qui ressemblent à celles utilisées par l’API Exchange Web Services (EWS) de Microsoft, ce qui laisse penser qu’elle a été conçue pour être déployée sur des serveurs Microsoft Exchange compromis et que les attaquants voulaient dissimuler les requêtes suspectes dans le trafic légitime.

Une autre version a écouté des URL qui ressemblaient à celles utilisées par l’application de gestion des ressources humaines OfficeTrack, anciennement appelée OfficeCore’s LBS System. Selon les chercheurs de Talos, cette application est commercialisée auprès des entreprises de télécommunications, ce qui suggère que les attaquants ont personnalisé leur porte dérobée pour chaque victime en se basant sur les logiciels qu’ils savent qu’ils exécutent sur leurs serveurs. « Les URL HTTP sont également constituées de modèles imitant les services d’approvisionnement d’une entreprise de télécommunications israélienne », ont déclaré les chercheurs. « D’après les résultats de sources ouvertes, il est possible que cet opérateur télécom ait utilisé OfficeTrack dans le passé et/ou qu’il utilise actuellement cette application. Certaines des URL de l’implant HTTPSnoop sont aussi liées à celles des systèmes de l’entreprise de télécommunications ». HTTPSnoop et sa porte dérobée sœur PipeSnoop se sont fait passer pour un fichier exécutable appelé CyveraConsole.exe, lequel appartient normalement à une application contenant l’agent Cortex XDR de Palo Alto Networks pour Windows. « Les variantes de HTTPSnoop et de PipeSnoop que nous avons découvertes présentaient des horodatages de compilation modifiés, mais elles se faisaient passer pour des agents XDR de la version 7.8.0.64264 », ont déclaré les chercheurs. « Cortex XDR v7.8 a été publié le 7 août 2022 et mis hors service le 24 avril 2023. Il est donc probable que les auteurs de la menace aient exploité ce groupe d’implants au cours de cette période ».

Les systèmes internes également ciblés par le backdoor PipeSnoop

PipeSnoop n’écoute pas les URL HTTP, mais un canal spécifique. Les canaux IPC (Inter-Process Communication) sont un mécanisme par lequel les processus locaux peuvent communiquer entre eux sur les systèmes Windows. L’utilisation de ce mécanisme comme moyen de commande et contrôle laisse penser que cette backdoor pourrait avoir été conçue pour des systèmes internes qui ne sont pas directement accessibles depuis lnternet, contrairement à HTTPSnoop. PipeSnoop ne peut pas fonctionner seul sur un système parce qu’il ne crée pas lui-même de canal spécifique, mais il en écoute seulement un. Cela signifie qu’un autre implant doit obtenir le shellcode des attaquants d’une manière ou d’une autre, puis créer un canal local spécifiquement nommé et transmettre le shellcode à PipeSnoop pour qu’il l’exécute.

Pour l’instant, les chercheurs de Talos n’ont pas encore identifié ce second composant. « Il est probable que PipeSnoop a été conçu pour fonctionner au sein d’une entreprise compromise, plutôt que sur des serveurs publics comme HTTPSnoop, et le backdoor est probablement destiné à être utilisé contre des terminaux que les opérateurs de malwares considèrent comme plus précieux ou plus prioritaires », ont déclaré les chercheurs de Talos.

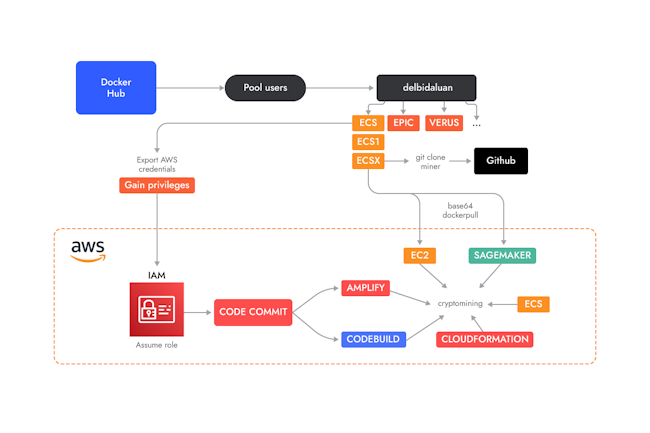

Baptisée Ambersquid, cette campagne de cryptojacking exploite des services cloud sans déclencher les processus d’approbation d’AWS.

Pour passer inaperçus plus longtemps dans les environnements cloud, les attaquants ont commencé à abuser de services moins courants qui ne font pas l’objet d’un examen de sécurité approfondi de la part du fournisseur de cloud. C’est le cas de la campagne de cryptojacking Ambersquid découverte récemment, qui déploie des malware de minage de cryptomonnaie sur AWS Amplify, Fargate et SageMaker au lieu du plus évident Elastic Compute Cloud (EC2).

« L’opération Ambersquida pu exploiter des services cloud sans déclencher le processus d’approbation de ressources supplémentaires généralement exigé par AWS, ce qui aurait été le cas s’ils n’avaient spammé que des instances EC2 », ont déclaré les chercheurs de l’entreprise de sécurité Sysdig dans un rapport. « Cibler plusieurs services pose également des défis supplémentaires, notamment en matière de réponse aux incidents, puisqu’il faut trouver et supprimer tous les mineurs dans chaque service exploité », ont-ils ajouté.

Fonctionnement de la campagne

C’est en analysant 1,7 million d’images de conteneurs Linux hébergés sur Docker Hub pour y rechercher des charges utiles malveillantes que les chercheurs de Sysdig ont découvert la campagne de cryptojacking. Suite aux indices de cryptojacking trouvés lors de l’exécution d’un conteneur, une analyse plus poussée réalisée par les chercheurs a mis à jour plusieurs conteneurs similaires téléchargés par différents comptes depuis mai 2022 qui chargent des crypto-mineurs hébergés sur GitHub. À en juger par les commentaires utilisés dans les scripts malveillants à l’intérieur des conteneurs, les chercheurs pensent que les attaquants à l’origine de la campagne sont originaires d’Indonésie. Après leur déploiement sur AWS à l’aide d’identifiants volés, les images Docker malveillantes exécutent une série de scripts, à commencer par celui qui configure divers rôles et autorisations AWS. L’un d’eux appelé AWSCodeCommit-Role donne accès au service Amplify qui permet aux développeurs de créer, de déployer et d’héberger des applications web et mobiles complètes sur AWS. Ce rôle a également accès au service de référentiel de code source managé CodeCommit, et au service de surveillance de l’infrastructure et de visualisation des données CloudWatch.

Un deuxième rôle, appelé sugo-role, créé par les scripts de conteneur, dispose d’un accès complet à SageMaker, un autre service AWS utilisé par datascientist pour construire, entraîner et déployer des modèles d’apprentissage machine. Un troisième rôle appelé ecsTaskExecutionRole donne, quant à lui, accès à Elastic Container Service (ECS), un système de gestion de conteneurs Docker natif d’AWS. Les attaquants exploitent ensuite les rôles nouvellement créés dans divers services, à commencer par CodeCommit où ils créent un dépôt Git privé qui héberge le code dont ils ont besoin pour les prochaines étapes de leur attaque, ce qui leur évite de quitter l’écosystème AWS après la compromission initiale et réduit les risques d’alertes de trafic sortant. Le dépôt Git sert à héberger le code d’une application malveillante conçue pour être construite et déployée avec le service Amplify. Le script génère ensuite cinq applications Amplify à déployer dans différentes régions AWS et, dans le cadre de leurs scripts de construction, une commande télécharge et exécute un cryptomineur.

Fargate et CodeBuild dans le viseur

Étant donné que le cryptomining et le vol de ressources ont lieu pendant la construction de l’application, les attaquants ont ajouté du code pour prolonger ce processus autant que possible. Quand les applications finissent de se construire, un autre script est exécuté pour mettre à jour le code et le processus est redémarré, ce qui relance la phase de construction et, par conséquent, le cryptominage. Un autre script du conteneur met en place un processus similaire, mais sur le service ECS, qui permet de déployer des conteneurs sur des instances EC2, Fargate – le moteur de calcul serverless d’Amazon – ou des machines virtuelles sur site. Le script donne les autorisations nécessaires au compte ecsTaskExecutionRole, utilisé ensuite pour configurer une tâche ECS qui configure un conteneur sur Fargate avec deux CPU virtuels et 4 Go de RAM et déploie une image Linux regroupant un mineur. La tâche est configurée avec un desiredCount de 30, ce qui signifie que 30 instances seront créées.

Le service d’intégration continue CodeBuild, utilisé pour compiler et tester le code source, est une autre cible de cette campagne. Le fichier de spécification autorisant CodeBuild à exécuter des tâches peut inclure des commandes de compilation et les attaquants ont ajouté des commandes pour exécuter leur mineur. Les attaquants ont également fixé la valeur « timeout-in-minutes » pour la tâche de construction à un maximum de huit heures pour s’assurer que leur mineur fonctionnera pendant cette durée avant d’être redémarré. Ensuite, les attaquants ont ciblé le service d’infrastructure as-code, CloudFormation, qui propose aux utilisateurs de provisionner des ressources AWS et tierces via des modèles. Ces ressources peuvent être regroupées en piles et contrôlées comme une seule unité. « Les scripts des attaquants créent plusieurs piles CloudFormation à partir d’un modèle qui définit un composant EC2 Image Builder », ont expliqué les chercheurs. « Dans ce composant, ils mettent des commandes pour exécuter un mineur pendant la phase de construction de l’image. Ces commandes sont similaires à celles qui peuvent être définies dans un fichier Docker ».

Comme pour Amplify et CodeBuild, le processus de minage est lancé pendant une phase de construction. Les attaquants ont essayé de la prolonger autant que possible en ajoutant des commandes cron dans le modèle pour démarrer une nouvelle build toutes les minutes. Les attaquants ont également abusé de la fonction EC2 Auto Scaling, qui offre aux utilisateurs d’ajouter ou de supprimer des instances EC2 à l’aide de politiques de mise à l’échelle, définies dans des modèles. Cette fonction a été utilisée pour créer deux groupes de huit instances On-Demand et Spot, chacune exécutant une image de conteneur Docker avec un mineur. Enfin, les pirates ont aussi abusé des instances de calcul d’apprentissage machine exécutant Jupyter Notebook App dans le cadre du service Amazon SageMaker. Pour chaque instance Jupyter Notebook, les utilisateurs peuvent définir une configuration de cycle de vie qui inclut une série de scripts shell exécutés au moment de la création des instances. Ils ont utilisé cette fonctionnalité pour inclure une commande qui exécute Docker et déploie l’une de leurs images Docker Hub contenant un mineur. « L’abus de tous ces services, avec des instances de conteneurs voyous et des tâches de construction exécutées dans différentes régions, peuvent engendrer des coûts de fonctionnement de 2 244 dollars par jour et plus pour les victimes », ont estimé les chercheurs de Sysdig.

Des services cloud intégrant du calcul ciblés

« Les fournisseurs de services cloud (CSP) comme AWS offrent une gamme très étendue de services à leurs clients », ont déclaré les chercheurs. « Même si la plupart des attaquants motivés financièrement ciblent des services de calcul comme EC2, il est important de se rappeler que de nombreux autres services fournissent également un accès aux ressources de calcul (certes de manière plus indirecte). Or, on peut facilement négliger la sécurité de ces services, car la visibilité est moindre par rapport à celle offerte par la détection des menaces en cours d’exécution ».

Étant donné que bon nombre de ces services ne sont destinés qu’à exécuter du code temporairement, il n’est pas toujours possible d’installer des solutions de détection de l’exécution. Dans ce cas, les entreprises devraient mettre en place un système de journalisation et de surveillance des tendances d’utilisation de ces services sur leurs comptes afin d’identifier les anomalies et les comportements suspects.