Un salarié de Macy’s a réussi à cacher entre 132 et 154 millions de dollars de frais de livraison dans la comptabilité de la société l’obligeant à retarder la publication de ses résultats. L’affaire montre les limites des ERP et des logiciels de comptabilité pour détecter ces erreurs.

En début de semaine la chaîne de magasin américaine Macy’s a annoncé retarder la publication de ses résultats financiers. Le motif : un employé a dissimulé pendant trois ans des frais de livraison pour un montant compris entre 132 et 154 millions de dollars. Une annonce qui tombe au plus mal à quelques jours des fêtes (Thanksgiving et du Black Friday) et qui met en évidence les lacunes des contrôles sur les logiciels de comptabilité et des ERP.

Dans un communiqué, le distributeur précise…

Il vous reste 94% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

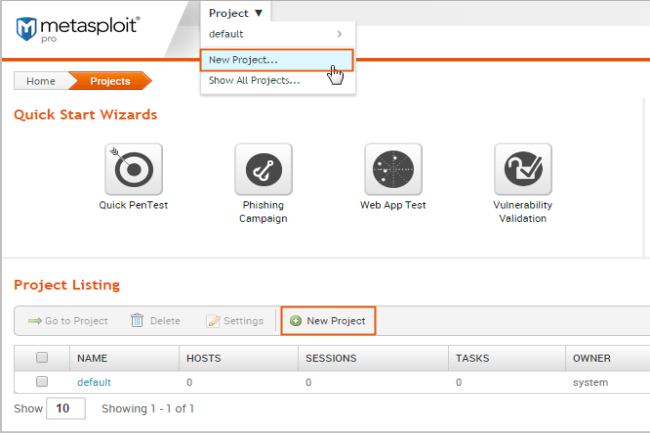

Une étude montre que les solutions de tests d’intrusion servent de plus en plus aux cybercriminels pour mener leurs attaques. Une autre tendance est leur appétence pour les identifiants plutôt que les techniques de contournement des outils de défense.

Le détournement d’outils de red teaming populaires comme Cobalt Strike et Metasploit à des fins malveillantes provoque des perturbations substantielles. Il s’impose aussi comme stratégie dominante dans les campagnes de malware. Selon une étude menée par Elastic, la version dévoyée de ces deux outils conventionnels de pen-testing est impliquée dans près de la moitié de toutes les activités de malware en 2024. « Les familles de logiciels malveillants les plus couramment observées sont…

Il vous reste 91% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

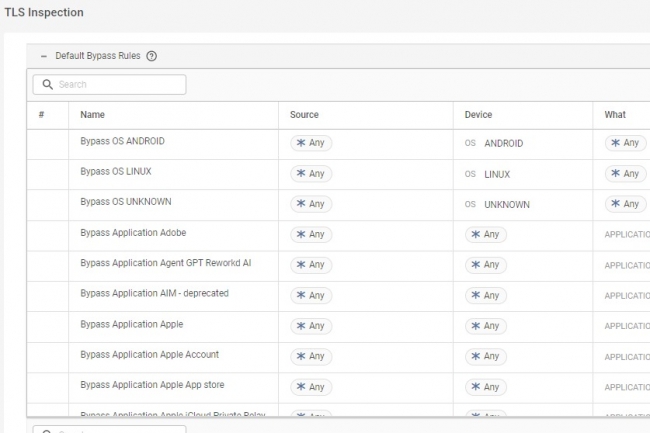

Dans son dernier rapport sur les menaces SASE, Cato a constaté que les entreprises ayant utilisé l’inspection TLS ont réussi à bloquer 52 % de trafic malveillant de plus que les autres.

Pour faciliter et accélérer l’inspection du trafic TLS par ses clients, Cato Networks a annoncé l’ajout de capacités d’inspection de la couche de transport sécurisée TLS à sa plateforme SASE. Comme le précise le fournisseur de services d’accès sécurisé dans son rapport Q3 CTRL SASE sur les menaces, « intégré à la plateforme SASE Cloud de Cato, Cato Safe TLS Inspection offre aux clients la possibilité d’inspecter entièrement les flux de trafic TLS, ce que seuls 45 % des 2 500 clients de Cato font actuellement ». Seuls 3 % ont indiqué au fournisseur qu’ils inspectaient toutes les sessions pertinentes, ce qui, selon l’entreprise, représente un risque important pour les utilisateurs finaux et les données.

D’après ce dernier rapport CTRL SASE sur les menaces, les entreprises qui activent l’inspection TLS ont bloqué 52 % de trafic malveillant de plus que celles qui n’y ont pas recours. « L’inspection TLS est essentielle pour empêcher les contenus nuisibles d’entrer dans les réseaux d’entreprise. Mais beaucoup hésitent à l’activer, car elles craignent des ralentissements opérationnels ou des problèmes juridiques liés à l’inspection du trafic crypté », a écrit Andrea Napoli, responsable du marketing produit chez Cato Networks, dans un blog sur l’annonce et les résultats de l’enquête (https://www.catonetworks.com/blog/how-cato-is-transforming-encrypted-traffic-security/). « Sans inspection TLS, ces entreprises exposent leurs réseaux sans le savoir, et elles sont incapables de détecter et de sécuriser un volume croissant de trafic potentiellement malveillant caché dans des canaux cryptés ».

Une inspection fastidieuse

Les technologies d’inspection TLS interceptent et déchiffrent le trafic TLS pour vérifier la présence de contenu malveillant ou de vulnérabilités. Elles recryptent ensuite le trafic et l’acheminent vers sa destination. Ces capacités permettent d’identifier les logiciels malveillants, l’exfiltration de données et d’autres types de trafic malveillant, mais aussi de garantir la conformité en matière de sécurité et l’intégrité des données en transit. Certes, ce type d’inspection TLS sur tous les flux de trafic peut devenir fastidieux pour les équipes réseau et de sécurité, selon Cato, qui cherche à simplifier le processus et à ce que l’inspection TLS puisse se faire sans perturber les applications d’entreprise. « Les fournisseurs de sécurité informatique ne cessent de vanter les mérites de leurs nouvelles capacités et fonctionnalités, mais si l’exploitation de ces capacités est trop difficile ou compliquée pour les entreprises, il y a lieu de se demander à quoi elles servent » a déclaré Shlomo Kramer, cofondateur et CEO de Cato Networks, dans un communiqué. « Safe TLS Inspection incarne cette philosophie, en faisant en sorte que les entreprises puissent tirer facilement parti de toute la puissance de la plateforme SASE ».

Comme plus de 90 % des communications web utilisent le chiffrement, il est donc essentiel que les entreprises puissent inspecter en toute sécurité l’ensemble du trafic sans angles morts. Les capacités d’inspection identifient automatiquement les applications et les domaines sûrs pour l’inspection, évitant l’usage de listes de contournement. « Safe TLS Inspection permet également un déploiement automatisé, en appliquant en quelques clics des configurations basées sur les meilleures pratiques », a indiqué l’entreprise.

Selon le blog du fournisseur, la visibilité sur le trafic cloud apportée par l’inspection Safe TLS permet aux équipes de sécurité de :

– Réduire la surface d’attaque en découvrant les menaces cachées dans le trafic crypté.

– Prévenir la perte de données sensibles grâce à une visibilité totale sur le trafic des applications exécutées dans le cloud.

– Éviter les configurations manuelles et la maintenance continue requises par les solutions d’inspection TLS.

– Recommander automatiquement des règles de contournement de l’inspection pour les applications et les domaines relevant de secteurs spécifiques.

– Sécuriser les applications cloud tout en offrant une protection des données axée sur la conformité et une sécurité renforcée pour les effectifs distants et hybrides.

SASE Cloud Platform fonctionne sur un réseau mondial privé de plus de 90 points de présence (PoP) connectés via de multiples fournisseurs de réseau bénéficiant d’accords de niveau de service (SLA). Le logiciel des points de présence surveille en permanence la latence, la perte de paquets et la gigue des fournisseurs afin de déterminer en temps réel le meilleur itinéraire pour chaque paquet. Cato applique l’optimisation et l’accélération à tout le trafic passant par le backbone pour améliorer les performances des applications et l’expérience de l’utilisateur. Pour s’assurer que tous les sites en bénéficient, le fournisseur optimise le trafic à partir de l’ensemble de la périphérie et vers toutes les destinations, sur site et dans le cloud. Safe TLS Inspection est disponible dès maintenant partout dans le monde, sans surcoût, pour tous les clients SASE Cloud Platform.

Sous l’impulsion de la CNCF et de la fondation Linux, la certification OpenTelemetry Certified Associate (OTCA) lancée en 2025 validera les compétences des professionnels informatique dans l’utilisation de la solution open source d’observabilité.

Un nouveau programme de certification de la Cloud Native Computing Foundation (CNCF) et de la Linux Foundation vise à valider les compétences nécessaires à l’utilisation d’OpenTelemetry pour gagner en visibilité sur les systèmes IT. La certification OpenTelemetry Certified Associate (OTCA) est conçue pour les ingénieurs en applications, DevOps, fiabilité des systèmes, plateformes ou les professionnels IT qui cherchent à accroître leurs capacités à exploiter les données de télémétrie à travers les systèmes d’applications cloud native et basées sur des microservices. « OpenTelemetry est un projet d’observabilité open source transformateur pour donner aux ingénieurs les moyens d’analyser en profondeur les comportements complexes des environnements IT à travers de nombreuses intégrations », a déclaré Chris Aniszczyk, CTO de la CNCF, dans un communiqué. « L’OTCA montre qu’un développeur peut mettre en œuvre des cadres d’observabilité ainsi que comprendre les subtilités de la performance et du flux de données, des compétences essentielles pour une résolution proactive et précise des problèmes dans les applications cloud native. »

OpenTelemetry est le deuxième projet open source le plus actif de la CNCF, après Kubernetes. Il est utilisé depuis sa phase d’incubation en août 2021 pour capturer et collecter des données et des mesures (traces, journaux,…) à travers des systèmes d’une manière standardisée et neutre. Celles-ci sont essentielles pour les technologies d’observabilité car elles fournissent des informations brutes et détaillées sur le comportement d’un système pour fournir des informations allant au-delà des métriques de surveillance de base. Les infomations peuvent également être utilisées pour détecter et résoudre de manière proactive des problèmes dans les environnements IT « OpenTelemetry devient rapidement un composant incontournable des systèmes cloud native, et cette certification est un excellent moyen pour les développeurs de démontrer leur maîtrise. Nous sommes ravis de lancer ce programme avec la CNCF et prévoyons qu’il ne sera que la première étape des programmes de formation que nous construirons ensemble », a fait savoir Austin Parker, membre du comité de gouvernance d’OpenTelemetry et directeur de l’open source chez honeycomb.io, dans un communiqué.

Une certification à 250 $ HT

« L’obtention de l’OTCA donne un coup de pouce à votre carrière en vous dotant de compétences recherchées pour les opérations informatiques modernes », a déclaré Clyde Seepersad, vice-président senior et directeur général de la Linux Foundation Education. « Ces compétences vous positionnent en tant que professionnel proactif, capable de résoudre les problèmes dans une ère de systèmes complexes et distribués ». Les principales compétences couvertes par la certification OTCA sont les suivantes : principes fondamentaux de l’observabilité, l’API et le SDK OpenTelemetry, le collecteur OpenTelemetry, la maintenance et le débogage des pipelines d’observabilité.

La certification OTCA se déroule sur un an pour planifier et passer l’examen (deux tentatives possibles), son coût étant de 250 $ HT. Les premières sessions débuteront en janvier 2025. La certification OTCA a été élaborée en collaboration avec Honeycomb, avec la participation de Chronosphere, Elastic, Lynxmind, F1rst Digital Services, Sicredi, DBS Bank, Accenture, Datadog et Lightstep.

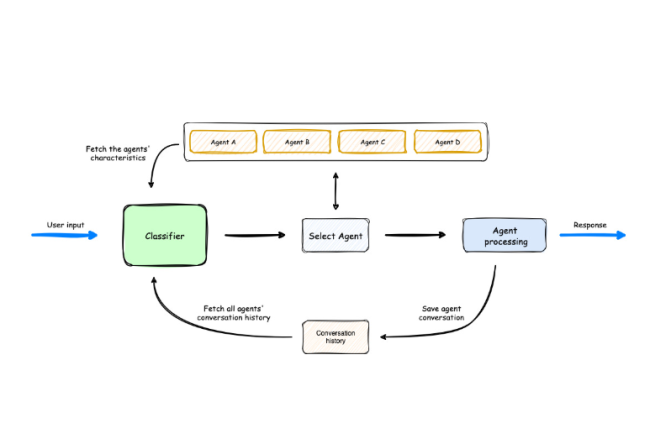

Le laboratoire d’AWS a présenté le projet open source Multi-Agent Orchestrator pour administrer la prolifération des agents IA.

Un récent rapport de SNS Insider a évalué le marché mondial des agents IA à 3,7 Md$ en 2023 et devraient atteindre les 103,6 Md$ d’ici 2032 avec un taux de croissance annuel de 44,9% pendant cette période. Cette progression indique un changement fondamental dans la façon dont l’informatique distribuée et l’automatisation vont être abordées. La récente publication du framework Multi-Agent Orchestrator d’AWS Lab sur GitHub représente une étape importante dans cette…

Il vous reste 93% de l’article à lireVous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte?

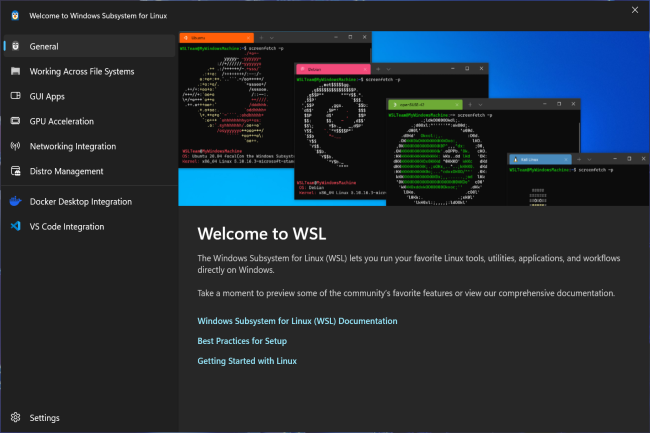

Microsoft enrôle WSL (Windows Subsystem for Linux) et WinGet dans Entra ID pour apporter un contrôle d’accès basé sur l’identité.

Windows Subsystem for Linux (WSL) et Windows Package Manager (WinGet) comprennent des fonctions supplémentaires de sécurité. Il s’agit notamment de l’intégration avec Entra ID (ex Azure Active Directory) pour le contrôle d’accès basé sur l’identité. Grâce à cette intégration, les administrateurs IT pourront gérer plus efficacement le déploiement et l’utilisation de ces outils dans les entreprises.

Dans le cas de WSL, l’intégration d’Entra ID est disponible en avant-première privée. Elle offrira une expérience de « zero trust » aux utilisateurs accédant aux ressources de l’entreprise à partir d’une distribution WSL. Selon Microsoft, « elle fournira en particulier une meilleure sécurité autour du passage des jetons Entra et une connexion automatique pour les processus Linux afin d’utiliser l’authentification Windows sous-jacente. » En outre, l’intégration de la conformité des appareils Intune avec WSL, désormais généralement disponible, donne aux administrateurs IT une interface pour contrôler la distribution WSL et l’utilisation des versions dans les entreprises via un accès conditionnel.

WinGet aussi intégré à Entra ID

Par ailleurs, la dernière architecture de distribution de WSL permettra aux développeurs, aux professionnels de l’IT et aux utilisateurs de mettre en place et de personnaliser les distributions tout en respectant les politiques de sécurité de l’entreprise. Les responsables IT peuvent créer des distributions personnalisées en regroupant les applications, les binaires et les outils nécessaires et les distribuer aux utilisateurs. Les distributions WSL peuvent à présent être installées à partir d’emplacements sources configurables, distincts du Microsoft Store. Ces fonctionnalités seront présentées en avant-première dans les mois à venir.

Concernant l’outil de ligne de commande WinGet utilisé pour installer des applications Windows, l’intégration à Entra ID est disponible en avant-première publique. Les professionnels de l’IT peuvent dorénavant gérer l’accès à WinGet afin que seuls les utilisateurs autorisés au sein d’une entreprise puissent installer des logiciels sur leurs appareils. De plus, les entreprises clientes pourront désormais utiliser WinGet pour télécharger des applications professionnelles à partir de n’importe quelle source WinGet en utilisant la commande WinGet Download. À noter aussi que WinGet Download est généralement disponible.

Afin de simplifier les opérations IT des entreprises, Red Hat Enterprise Linux 9.5 se dote de fonctions de sécurité, d’une gestion améliorée de la console web et de meilleures capacités de mise en réseau.

Présentée récemment et disponible depuis le 14 novembre, la distribution Red Hat Enterprise Linux 9.5 (RHEL) apporte de nombreuses mises à jour et améliorations qui impactent presque tous les aspects des opérations IT et des systèmes. Depuis son lancement en 2022, Red Hat Enterprise Linux 9.x a bénéficié de mises à jour incrémentielles tous les six mois, recevant chaque fois des fonctionnalités supplémentaires. La dernière version de la plateforme Linux d’entreprise la plus importante au monde présente plus de 70 améliorations, dont des capacités de mise en réseau avancées jusqu’à des outils de gestion de conteneurs améliorés. Ces udpates visent à répondre aux principaux défis auxquels sont confrontées les équipes IT des entreprises, notamment la complexité croissante des infrastructures modernes, le besoin d’une sécurité renforcée dans les charges de travail d’IA et la demande de flux de travail plus efficaces pour les développeurs.

Les principales mises à jour de RHEL 9.5 sont les suivantes :

– une prise en charge améliorée du calcul confidentiel, ou confidential computing, pour les charges de travail d’IA ;

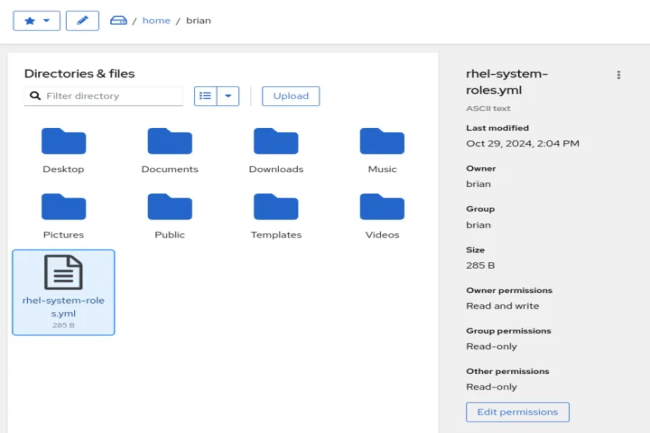

– de nouvelles fonctionnalités de gestion de fichiers dans la console web ;

– un nouveau rôle système pour la configuration automatisée à l’échelle ;

– des configurations d’images pré-durcies dans Image Builder ;

– la prise en charge de BIND 9.18 pour améliorer les capacités DNS.

Une console améliorée pour faciliter la gestion de RHEL

Pour gérer la distribution, nombreux sont les gestionnaires de Linux d’entreprise à s’appuyer encore sur l’interface de ligne de commande (CLI). Cependant, tous les utilisateurs ne souhaitent pas travailler avec ce type d’interface, certains lui préférant une interface utilisateur graphique. L’une des principales caractéristiques de RHEL 9.5 est l’extension significative des capacités de la console web. Cet ajout fournit une interface de gestion de fichiers complète à partir de laquelle les administrateurs peuvent effectuer des tâches quotidiennes de gestion de fichiers sans utiliser la ligne de commande. « La console web comprend désormais un composant de gestion de fichiers fourni par le paquet cockpit-files », a expliqué Scott McBrien, responsable du marketing des produits techniques, RHEL, chez Red Hat. « Ce composant propose aux utilisateurs de naviguer dans le système de fichiers, de télécharger de nouveaux fichiers sur la machine, et d’effectuer des opérations de fichiers régulières comme copier, déplacer et renommer des fichiers. »

Une infrastructure de réseau améliorée pour un meilleur accès à l’IPv6

Parce que RHEL est utilisée comme base pour les déploiements à l’échelle de l’entreprise, du cloud et même des télécommunications, la pile réseau de l’OS revêt une importance particulière pour les utilisateurs. La version 9.5 apporte des améliorations notables à la mise en réseau qui renforcent la connectivité et la sécurité dans les environnements hybrides. Elle prend dorénavant en charge l’utilisation simultanée des services firewalld et nftables, mettant fin ainsi aux limitations antérieures qui restreignaient les administrateurs à un seul service à la fois. Firewalld est un service de pare-feu Linux couramment utilisé, tandis que nftables assure le filtrage et la classification des paquets réseau. Il est également intéressant pour les professionnels des réseaux d’utiliser les services nftables pour filtrer et classer les paquets réseau.

Par ailleurs, le fait que NetworkManager RHEL prenne désormais en charge la connexion aux VPN IPsec qui utilisent l’adressage IPv6 est aussi particulièrement intéressant pour les administrateurs réseau. « Auparavant, NetworkManager ne prenait en charge que l’adressage IPv4 lors de l’utilisation du plugin NetworkManager-libreswan pour se connecter à un VPN IPsec (Internet Protocol Security) », indiquent les notes de mise à jour de la version 9.5 de RHEL. « Avec cette mise à jour, il est possible de se connecter à des VPN IPsec qui utilisent l’adressage IPv6. » NetworkManager supporte à présent le paramètre ‘leftsubnet’ pour les VPN IPsec, ce qui donne accès à des configurations plus sophistiquées de sous-réseau à sous-réseau. De plus, l’utilitaire nmstate supporte désormais l’option cwnd (congestion window clamp), offre ainsi un meilleur contrôle de la gestion du trafic TCP.

Des outils pour développeurs et innovation en matière de conteneurs

RHEL 9.5 marque un changement significatif dans les outils de développement avec le Java Developer Kit (JDK) 17 qui devient l’implémentation Java par défaut, en remplacement du JDK 11. Cette évolution améliore les performances des applications, accélère l’exécution du code et renforce les capacités de mise à l’échelle, tout en maintenant la rétrocompatibilité avec les applications existantes. La gestion des conteneurs fait l’objet d’une mise à jour majeure avec Podman 5.2, qui introduit la fonction de construction de fermes Podman.

Avec cette optimisation, les développeurs peuvent construire des images multiplateformes sur des machines distantes à l’aide d’une seule commande, rationalisant ainsi le processus de développement et de déploiement de conteneurs dans divers environnements. La plateforme de conteneurs Podman de Red Hat offre une bonne alternative à la technologie de conteneurs Docker.

Renforcement de la sécurité de l’informatique confidentielle

Les améliorations de la sécurité sont la pierre angulaire de RHEL 9.5, avec plusieurs évolutions stratégiques de l’architecture de sécurité de la distribution open source. Le nouveau rôle système sudo offre une configuration automatisée des privilèges sudo à l’échelle, et aux entreprises de déléguer des tâches administratives de manière plus sécurisée tout en maintenant des configurations cohérentes dans l’ensemble de leur environnement. RHEL 9.5 renforce également sa position dans l’informatique confidentielle, ou confidential computing, en particulier pour les charges de travail d’IA, en introduisant des mécanismes de protection améliorés qui sécurisent les données sensibles tout en permettant aux systèmes d’IA de traiter de grands ensembles de données.

Image Builder apporte désormais des configurations d’images pré-durcies, intégrant dès le départ les meilleures pratiques de sécurité directement dans les images système. « Red Hat Enterprise Linux Image Builder propose à présent des constructions conformes aux normes de sécurité communes, de sorte que l’image résultante comporte des choix d’installation pour répondre à la norme sélectionnée », a précisé M. McBrien. Par exemple : Il est difficile de modifier l’agencement des partitions d’une machine en marche pour avoir des systèmes de fichiers séparés, mais si ces choix sont faits lors de l’installation, cela devient beaucoup plus simple. Celui-ci a également indiqué que la prise en charge des technologies Intel SGX et AMD SEV était disponible en avant-première technique dans cette version. « Ces technologies cryptent la mémoire des machines virtuelles afin d’en dissimuler le contenu à l’hyperviseur du système. ».

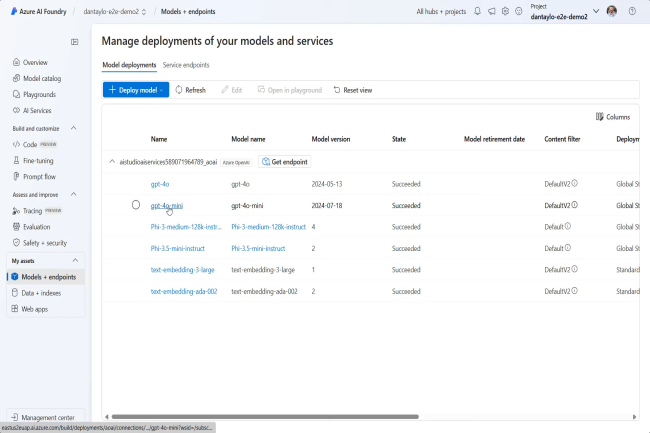

Microsoft a présenté Azure AI Foundry, une plateforme de développement d’agents IA. Elle va fédérer plusieurs outils existants pour aider les développeurs à créer des applications IA fonctionnelles et sûres.

La plupart des éditeurs sont passés à l’acte 2 des chatbots IA. Place aux agents, des applications plus complexes qui nécessitent plus de réflexion, de code, de tests et de garanties. Cette évolution entraîne par ailleurs un changement dans les outils de développement. Chez Microsoft, une grande partie des outils actuels d’Azure au-delà de ses API Cognitive Services, sont axés sur la construction de chatbots, utilisant le framework Prompt Flow pour ajouter des index vectoriels externes aux LLM pour le RAG. Le tout en rajoutant une couche de sécurité. Pour les agents, Microsoft mise sur une autre plateforme présentée à l’occasion de la conférence Ignite à Chicago : Azure AI Foundry.

Un hub pour développer des agents IA

L’éditeur définit ce dernier comme « une plateforme complète pour construire, évaluer et déployer des applications d’IA à grande échelle ». Au lieu de se concentrer sur des services comme Azure AI Studio, l’entreprise amène le développement d’Azure AI là où se trouvent les développeurs : leurs environnements de développement. AI Foundry se connectera aux IDE et aux éditeurs tels que Visual Studio et Visual Studio Code, ainsi qu’à des plateformes telles que GitHub.

Cela ne signifie pas la fin d’AI Studio. Au contraire, il va jouer un nouveau rôle en tant que portail où vous pouvez gérer vos modèles et les applications qui les utilisent. Il servira de pont entre l’entreprise et le développement, permettant aux propriétaires d’applications, aux parties prenantes et aux architectes de partager les mesures nécessaires concernant son code. AI Foundry aidera à gérer l’accès aux outils et aux services, en utilisant un abonnement Azure pour rassembler les informations clés dans une vue unique. Le service cloud sera capable de gérer aussi les ressources et les privilèges et de réduire le risque de failles de sécurité.

Azure AI Foundry est une portail réunissant plusieurs outils pour développer ses agents. (Crédit Photo: Microsoft)

Une plateforme commune entre les développeurs et les métiers

AI Foundry est aussi un lieu de bonnes pratiques avec un accès à la documentation sur Azure Essentials. Les développeurs peuvent ainsi consulter la plateforme pour connaître les règles de l’art en matière d’architecture et de conception développées par les partenaires de Microsoft et sa propre équipe de services. Ils ont accès également à Azure Migrate, le Cloud Adoption Framework et les directives Well Architected. La plateforme comprend de plus des outils pour comparer les modèles et choisir le meilleur pour l’application souhaitée. Ils analysent et proposent des mesures sur la performance, la cohérence et le coût d’exécution.

Le résultat devrait être une plateforme commune pour la collaboration entre les développeurs et les parties prenantes de l’entreprise. À mesure que l’IA moderne migre du chatbot à l’automatisation intelligente des processus via des agents, cette approche va devenir de plus en plus importante. Les équipes de développement doivent comprendre les problèmes métiers qu’elles tentent de résoudre, tandis que les analystes et les datascientists seront nécessaires pour aider à fournir les invites nécessaires pour guider les agents d’IA.

Une fusion entre AutoGen et Semantic Kernel

Le lancement d’AI Foundry est étroitement lié à la fusion prévue du framework pour les agents IA AutoGen de Microsoft Research avec Semantic Kernel. Cette combinaison permettra de développer et d’exploiter des processus métier sur le long terme, en hébergeant des composants dans Dapr et Orleans. AutoGen s’appuyant sur Orleans, il y a déjà suffisamment de convergence entre Semantic Kernel stable et le projet de recherche multi-agents d’AutoGen.

AutoGen restera une plateforme de recherche pour expérimenter des projets complexes d’informatique contextuelle. Les projets peuvent ensuite être portés sur Semantic Kernel, ce qui donne un runtime supporté pour les agents afin de les faire fonctionner en production. Microsoft donne un préavis suffisant pour cette transition, qui devrait avoir lieu au début de l’année 2025.

Azure AI Agent Service en rôle d’intégrateur

Parallèlement à AI Foundry, Microsoft déploie Azure AI Agent Service pour prendre en charge les intégrations nécessaires avec les applications métier. Il simplifie les connexions à la plateforme de données d’Azure, ainsi qu’à Microsoft 365. Si AI Foundry vise à amener l’IA là où se trouvent les développeurs, AI Agent Service l’amène là où se trouvent les données de l’entreprise, dans des outils tels que les datalake de Fabric et le contenu d’entreprise stocké dans SharePoint.

Azure Agent AI va jouer le rôle d’intégrateur et de contrôleur des agents IA. (Crédit Photo : Microsoft)

Le service s’appuie sur les capacités d’infrastructure d’Azure, en ajoutant la prise en charge des réseaux privés et du stockage. L’objectif est de tirer parti des certifications et des approbations réglementaires existantes dans Azure pour créer rapidement des outils d’IA afin de fournir des applications conformes. Cette évolution devrait aider les entreprises à adopter l’IA, en utilisant AI Foundry pour réunir les parties prenantes concernées et AI Agent Services pour appliquer les contrôles nécessaires – pour les approbations internes et externes.

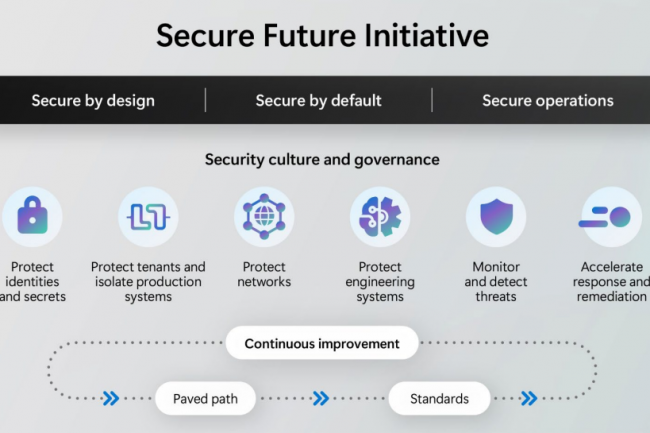

Les dernières recommandations de Microsoft dans le cadre de son initiative pour un avenir sûr comprennent l’obligation d’utiliser l’authentification multifacteur, l’isolation des terminaux et la sécurité des secrets.

Lors de sa conférence Ignite de mardi, Microsoft a fait le point sur l’état d’avancement de son initiative pour un avenir sûr (Secure Future Initiative ou SFI), lancée il y a un an, qui comprenait des mesures importantes telles que l’application de l’authentification multifacteur (MFA) par défaut pour les instances, l’isolation de près de 100 000 terminaux professionnels dans le cadre de politiques d’accès conditionnel et le blocage des secrets GitHub pour réduire leur exposition aux menaces. Le rapport d’étape, structuré autour des six piliers d’ingénierie habituels de Microsoft utilisés pour évaluer ses avancées, présente des perspectives plus prometteuses par rapport à une précédente mise à jour de septembre qui portait sur la rotation des informations d’identification, les contrôles d’accès JIT/JEA et la surveillance des menaces.

« En mai 2024, le CEO de Microsoft, Satya Nadella, a fait de la sécurité la priorité absolue de l’entreprise », a déclaré Microsoft dans son document. « Depuis lors, nous avons consacré l’équivalent de 34 000 ingénieurs à l’avancement des objectifs énoncés dans la SFI, ce qui en fait le plus grand projet d’ingénierie de cybersécurité de l’histoire. » Microsoft a également souligné les efforts déployés pour intégrer la sécurité dans sa culture, en menant à bien plusieurs initiatives en matière d’apprentissage et de gouvernance, notamment des formations obligatoires à la sécurité du personnel par l’intermédiaire de la Microsoft Security Academy, et en s’engageant à respecter l’engagement CISA « secure by design » (« sécurité dès la conception »).

Microsoft s’engage à protéger les identités, les secrets et les systèmes

Microsoft a souligné son engagement en faveur de la sécurité en intégrant une série de cadres « sécurisés dès la conception » dans ses processus. L’entreprise a défini quatre piliers d’ingénierie SFI clés pour soutenir cet effort : la protection des identités et des secrets, l’isolation des systèmes de production pour protéger les instances, la protection des réseaux et la sécurisation des systèmes d’ingénierie. À cette fin, le fournisseur, qui dispose d’outils d’identité tels que Azure AD, Entra, Defender et Authenticator, a mis en place le MFA par défaut pour tous ces nouvelles instances hôtes. En outre, il met en œuvre une MFA résistante à l’hameçonnage dans ses environnements de productivité. « Pour aider à sécuriser les clients, l’authentification multifacteur (MFA) est désormais activée par défaut pour les hôtes et sera appliquée pour le portail Azure, le centre d’administration Entra, celui d’Intune et celui de Microsoft 365 », indique l’éditeur. Azure Managed Identity for service-to-service (S2S) a également été mis en œuvre à grande échelle pour les applications Entra ID et les ressources Azure, afin de protéger les secrets tels que les mots de passe, les clés d’accès au stockage et les jetons SAS de stockage contre les fuites.

Afin d’atténuer les risques liés aux terminaux, Microsoft a indiqué avoir déployé 98 000 PC verrouillés prêts pour la production (fonctionnant uniquement avec des fonctionnalités sécurisées et limitées), et avoir transféré 28 000 « utilisateurs à haut risque » vers une solution de virtualisation de poste de travail (VDI) personnalisée et verrouillée. « Pour aider les clients à se protéger, nous avons introduit un modèle d’accès conditionnel Entra, actuellement en avant-première publique, qui exige la conformité des terminaux », a déclaré Microsoft. Dans le cadre du pilier « protéger les systèmes d’ingénierie », qui fait référence aux pratiques visant à réduire le risque de secrets et d’informations d’identification dans son code, l’entreprise a déployé GitHub Advanced Security pour bloquer l’exposition de nouveaux secrets dans les référentiels GitHub et Azure DevOps Git.

Une attention accrue à la gestion des menaces

Pour lutter contre les fuites de secrets, Microsoft s’efforce de « supprimer les secrets du code et d’autres méthodes de stockage et de transmission non sécurisées ». Il a mis en œuvre « des normes de protocoles d’authentification forte qui ne reposent pas sur des mécanismes faibles tels que les informations d’identification en clair et qui détectent, bloquent et suppriment activement les secrets et les informations d’identification exposés. » Concernant la protection des réseaux, Azure Virtual Network Encryption est disponible dans toutes les régions et la prise en charge des extensions de sécurité du système de noms de domaine est disponible en avant-première publique. En outre, pour favoriser « l’isolation et la segmentation » de la gestion et des services, plus de 99,3 % des actifs physiques ont été inventoriés et des listes de contrôle d’accès (ACL) obligatoires leur ont été appliquées, afin d’isoler leur gestion, explique Microsoft.

La société a attribué une poignée d’autres améliorations aux autres piliers de la SFI : surveiller et détecter les menaces, et accélérer la réponse et la remédiation. Pour faciliter l’amélioration de la surveillance des systèmes en vue de la détection des menaces, Microsoft a déclaré qu’il avait étendu les capacités de journalisation dans le cloud, qui comprennent des journaux détaillés de plus de 30 types de données et une conservation standard des logs pendant 180 jours. Ces fonctionnalités sont disponibles par défaut pour les clients de 365, sans coût supplémentaire, a ajouté Microsoft. En outre, l’entreprise a déclaré avoir mis en place une gestion centralisée et une période de conservation de deux ans pour les journaux d’audit de sécurité de l’infrastructure d’identité. Dans le cadre des initiatives de gestion des menaces, l’entreprise a déclaré avoir corrigé 90 % des vulnérabilités dans le délai imparti pour atténuer les effets des vulnérabilités les plus graves de l’informatique cloud. Elle a également déclaré avoir publié près de 800 vulnérabilités et expositions communes (CVE) dans le cadre d’un effort de communication transparent. « Microsoft continue de progresser dans la réalisation de ses objectifs en matière de SFI », a déclaré Vasu Jakkal, vice-président chargé de la sécurité chez Microsoft. « Dans ce rapport, nous soulignons les investissements que nous réalisons dans l’ensemble de l’entreprise pour identifier, hiérarchiser et traiter les risques de cybersécurité dans toute l’entreprise.

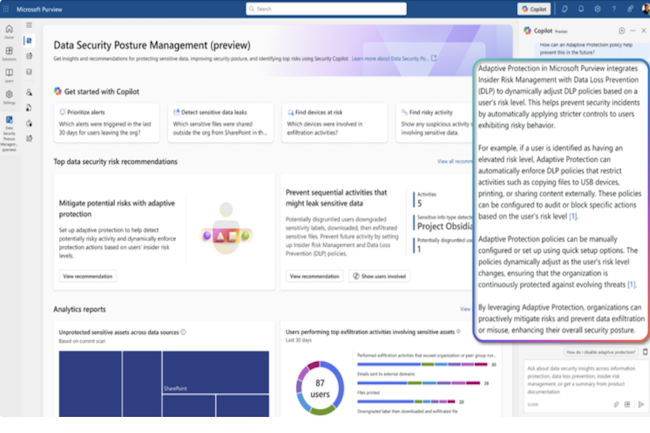

A l’occasion de sa conférence Ignite 2024, Microsoft a fait plusieurs annonces dans le domaine de la sécurité. Il a présenté un bug bounty pour l’IA et des fonctions de GenAI pour améliorer la protection des entreprises.

Les annonces ont été foisonnantes à la dernière conférence dédiée aux développeurs de Microsoft nommée Ignite qui se déroule en ce moment à Chicago (18-22 novembre). Plusieurs d’entre elles ont concerné la cybersécurité des entreprises. Elles visent à renforcer les capacités existantes de protection des données, de la sécurité des endpoints, et de la détection de réponse aux menaces étendues.

Un bug bounty dédié à l’IA et le cloud

En premier lieu, Microsoft a présenté un nouveau programme de recherche de vulnérabilité baptisé Zero Day Quest. Doté d’une enveloppe de 4 M$, il vise à trouver des failles de l’IA et du cloud. Certains analystes soulignent que ce montant de prime est relativement bas par rapport au programme d’Apple ou Zerodium qui promet 2 M$ pour un seul exploit.

Tom Gallagher vice-président de l’ingénierie au centre de réponse Microsoft Security se défend en soulignant que « l’année dernière, nous avons versé 16,6 M$ de la cadre de nos bug bounty aux chercheurs en sécurité qui ont signalé des failles ». Et d’ajouter, « c’es plus que n’importe quel acteur du secteur. » Il précise par ailleurs que « Microsoft accorde des paiements pour la recherche de vulnérabilités, alors que de nombreuses autres entreprises exigent un exploit fonctionnel pour recevoir un paiement, ce qui peut impliquer plusieurs vulnérabilités et peut nécessiter beaucoup plus de travail. »

La gestion des expositions aux menaces disponible

La firme de Redmond a également annoncé la disponibilité de Security Exposure Management. Il était en preview au début de l’année auprès de 70 000 clients. Cet outil vise à transformer la sécurité par une gestion de la posture basée sur un graphe plutôt que sur une protection reposant sur une liste. Il s’appuie ainsi sur la cartographie des relations changeantes entre les actifs sous-jacents tels que les identités, les informations d’identification, les autorisations, les fichiers, les terminaux et les autres connexions dans les entreprises. « La gestion traditionnelle des vulnérabilités ne suffit plus », a déclaré Brjann Brekkan directeur du marketing produit de Microsoft pour la gestion de la posture de sécurité et de l’exposition, dans un communiqué. « Bien que le fait de patcher toutes les faiblesses potentielles puisse sembler une solution, ce n’est ni pratique ni efficace. »

Il ajoute que « les stratégies de sécurité modernes doivent se concentrer sur les expositions qui sont les plus faciles à exploiter pour les attaquants, en donnant la priorité aux vulnérabilités qui présentent le plus grand risque. » Les principales fonctionnalités de l’outil comprennent la gestion de la surface d’attaque, l’analyse du chemin d’attaque et l’analyse unifiée de l’exposition. « La gestion de l’exposition aide les équipes de sécurité à comprendre la véritable topographie de leur surface d’attaque, ce qui leur permet de prévenir ou de minimiser les menaces. »

Plus de GenAI dans la sécurité

Security Copilot, l’assistant à base de GenAI de Microsoft développe des compétences supplémentaires dans le domaine de la cybersécurité. L’éditeur a ainsi débloqué des fonctionnalités pour les administrateurs IT dans Entra (ex Azure Active Directory), une offre de gestion des identités et des accès (IAM) et dans Intune (solution de gestion des terminaux). Pour mémoire, Security Copilot a vu le jour en avril dernier avec une version preview pour Intune uniquement. Il est maintenant étendu à Intune Suite et Windows Autopatch où il offre aux informaticiens des actions guidées par l’IA pour les aider à répondre aux incidents.

Toujours dans Copilot Security, l’assistant se renforce dans Purview et Defender. Pour le premier, il embarque la solution Insider Risk Management proposant des indicateurs d’utilisation et des modèles de politique conçus pour détecter les activités à risque intentionnelles et non intentionnelles de personnes au sein des entreprises impliquant des applications d’IA générative. Dans le même temps, Purview comprend une fonctionnalité en preview de DLP (prévention des pertes de données) afin d’empêcher le partage excessif de données dans les apps d’IA et détecter l’utilisation risquée de l’IA. Enfin, les analystes du centre d’opérations de sécurité (SOC) disposent désormais d’une intégration Security Copilot pour identifier et résoudre les problèmes liés à l’utilisation de l’IA.